1. ComfyUI Uni3C ワークフローとは?

Uni3Cワークフローは、先進的なUni3C(精密に3D強化されたカメラと人間のモーションコントロールを統合する)モデルをComfyUI環境に統合します。DAMO Academy (Alibaba Group)によって開発されたUni3Cは、カメラの軌道制御と人間のモーション制御を単一の3D強化フレームワーク内で統合することにより、制御可能なビデオ生成の基本的な課題に対処します。

FLUX拡散トランスフォーマーアーキテクチャに基づき、Wan2.1基礎モデルによって駆動されるUni3Cは、単眼深度推定から導出された未投影点群を利用するプラグアンドプレイの制御モジュールPCDControllerを導入します。このアプローチにより、Uni3C内での正確なカメラ制御を可能にし、大規模ビデオ拡散モデルの生成能力を維持します。Uni3CシステムはSMPL-Xキャラクターモデルとグローバル3Dワールドガイダンスを採用し、環境シーンと人間キャラクターの両方にわたる空間的一貫性のあるビデオ生成を実現します。

2. Uni3Cの利点:

- 統合された3D強化フレームワーク: Uni3Cは、カメラの軌道と人間のモーションを一貫した3Dワールドスペースで同時に処理します。

- PCDControllerアーキテクチャ: 軽量な0.95Bパラメーターコントローラーを使用して、単眼深度推定からの未投影点群を活用し、14Bパラメーターベースモデルを損なうことなく動作します。

- SMPL-X統合: Uni3Cは高度な3D人体モデルサポートを提供します。

- 幾何学的優先利用: Uni3Cの点群ベースの3D幾何学的理解は、単一の画像からの頑強なカメラ制御を提供します。

- グローバル3Dワールドガイダンス: Uni3Cは、環境の点群とSMPL-Xキャラクター間の剛性変換の整合を確保し、空間的一貫性のあるビデオ生成を実現します。

3. Uni3Cワークフローの使用方法

Uni3Cはビデオ参照抽出を通じて動作し、参照ビデオを分析してカメラの動きと人間のモーションの両方を理解し、パターンを入力画像から生成する新しいビデオに適用します。このアプローチにより、手動のパラメーター調整なしで、Uni3Cによる正確な制御が可能になります。

3.1 方法1: ビデオ参照のカメラ制御

最適な用途:

参照ビデオからカメラの動きを抽出し、それを新しいシーンに適用するためのUni3C。

セットアッププロセス:

- 参照ビデオを読み込む:

Load Video (Upload)ノードに興味深いカメラの動きがあるビデオをアップロードします- 良い例: 被写体にズームするビデオ、自然な頭の動きのある歩行映像、シネマティックなパン、軌道ショット

- キーポイント: 明確なカメラモーションがあるビデオは何でも機能します - 携帯電話の録画からプロの映画撮影までUni3Cで。

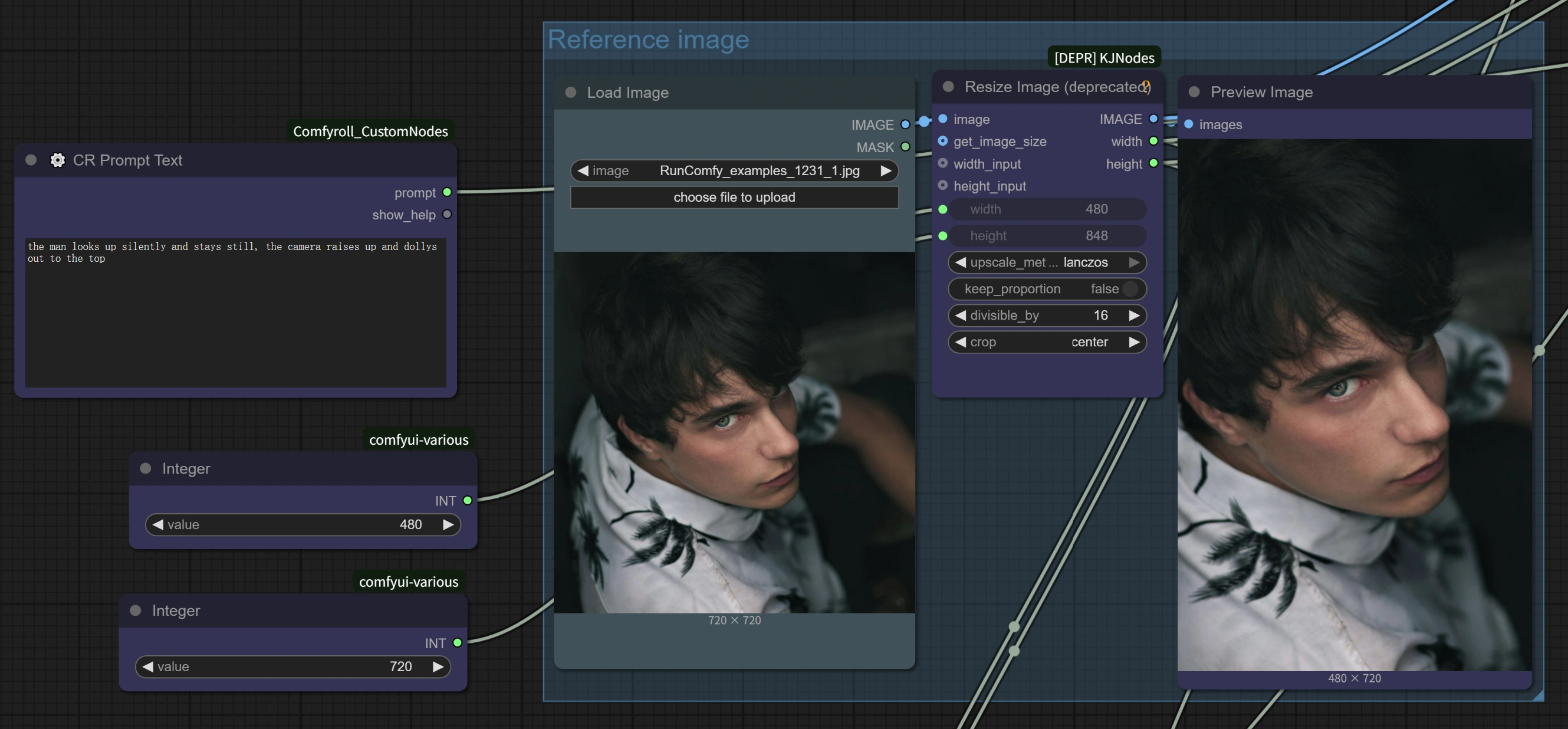

- ターゲット画像を読み込む:

Load Imageノードにベース画像をアップロードします(現実的、アニメ、アートワーク、AI生成スタイルのいずれでも機能します) - プロンプトを書く: Uni3Cのテキストプロンプトエリアで希望のシーンを説明します

- 設定を構成する: Uni3Cワークフローには、4倍の速度改善のための最適化されたパラメーターが含まれています

- 生成する: Uni3Cを使用して、参照ビデオのカメラの動きをシーンに転送するためのワークフローを実行します。

高度なヒント:

- モーション方向の一致: 最良の結果は、参照ビデオの動きの方向がUni3Cの意図したシーン構成と一致する場合に得られます。

- プロンプトの調整: カメラの動きスタイルを強化するためにプロンプトを記述し、Uni3Cとの整合性を高めます。

- 参照品質: 安定した明確なカメラの動きがある参照ビデオを選択し、Uni3Cで最適な結果を得ます。

3.2 方法2: 人間のモーション転送

最適な用途:

参照ビデオから異なるキャラクターに人間のモーションを転送するためのUni3C。

セットアッププロセス:

- 人間のモーションを含む参照ビデオ: 転送したい人間の動きが含まれるビデオをアップロードします

- ターゲットキャラクター画像: アニメートしたいキャラクターの画像を読み込みます

- プロンプトによるモーション制御:

- 元のモーションを保持: 一般的な説明を使用して、"a woman walking"のように参照モーションをUni3Cで維持します。

- アクションを変更: 動きを変えるために具体的に記述します: "a woman combing her hair"は、全体的なモーションフローを維持しつつ、手のジェスチャーを変更します。

主な利点:

- スケルトン不要: 従来のモーションキャプチャとは異なり、Uni3Cは複雑なリギングなしで人間の動きを理解します。

- ディテールの保持: Uni3Cはモーション転送中にアクセサリー、ヘアスタイル、衣装のディテールを保持します。

- 同時制御: カメラの動きと人間のモーションの両方が、同じ参照ビデオからUni3Cを使用して一緒に転送されます。

パフォーマンス最適化アーキテクチャ: Uni3Cワークフローは、PCDControllerで隠れサイズを5120から1024に削減し、ゼロ初期化された線形投影層を使用し、ベースモデルの最初の20層のみにカメラ制御機能を注入するなどの最適化戦略を実装しています。フロー一致の最適化により、サンプリングステップを削減(10対20以上)し、CFGガイダンススケールを調整することで、Uni3Cでの生成品質を維持しつつ、最大4倍の処理速度向上を実現しています。

3.3 最適化されたパフォーマンス設定

4倍の速度向上構成: Uni3Cの組み込みの最適化に基づき、次の設定は劇的に高速な処理を提供します:

WanVideo Sampler ノード設定:

Steps: 10 (デフォルトの20以上から削減)CFG: 1.0-1.5 (速度と品質のバランスを最適化)Shift: 5.0-7.0 (ベストな結果を得るために7を推奨、Uni3Cでの高速処理には5を使用)Scheduler: UniPC (Uni3C用に最適化されたスケジューラ)

主なパフォーマンス機能:

- AnimateDiff統合: Uni3Cは、元々テキストからビデオへの生成用に設計されたAnimateDiffの最適化を活用し、画像からビデオへの生成にも効果的です。

- スマートパラメーター削減: 画像からビデオへの生成は既存の視覚コンテンツから始まるため、Uni3Cでのテキストからビデオへの生成と比較して、必要なデノイズステップが少なくなります。

- 最適化された処理: Uni3Cは、70フレームのビデオを約4〜5分で完了することができます(元の設定では約27分)。

品質対速度オプション:

- 最大速度: Steps=10, CFG=1.0, Shift=5 → 70フレームをUni3Cで約4分間で生成

- バランス: Steps=10, CFG=1.5, Shift=7 → 70フレームをUni3Cで約5分間で生成

- 高品質: Steps=15, CFG=2.0, Shift=7 → 70フレームをUni3Cで約8〜10分間で生成

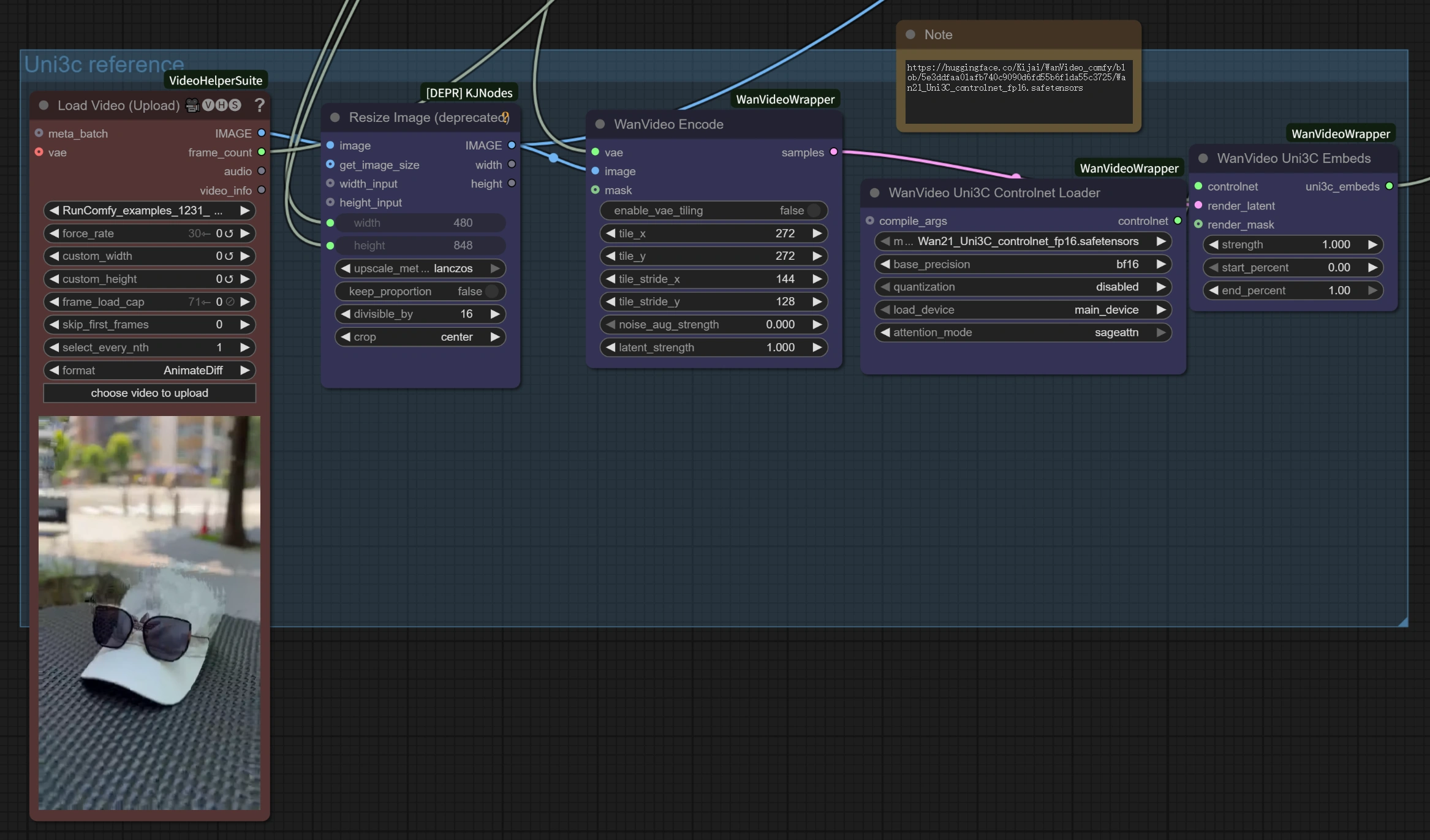

3.4 ワークフローコンポーネントの理解

参照ビデオ処理セクション:

Load Video (Upload): Uni3Cでのモーション参照用にMP4、AVIなどの標準ビデオフォーマットを受け入れます。WanVideo Encode: Uni3C用にカメラの軌道とモーションパターンを抽出するために参照ビデオを処理します。Uni3C ControlNet Loader: モーション理解のための特殊なUni3C制御モデルをロードします。

画像からビデオへの生成セクション:

Load Image: Uni3Cで参照モーションでアニメートするターゲット画像です。WanVideo Image/ToVideo Encode: 静止画像をUni3Cによるビデオ生成に適した形式に変換します。WanVideo Sampler: Uni3Cでの4倍速度向上のための最適化設定を備えたコア生成エンジンです。

出力処理:

WanVideo Decode: Uni3Cから生成された潜在ビデオを視聴可能な形式に戻します。Video Combine: Uni3Cから適切なフレームレートとエンコーディングで最終ビデオファイルを組み立てます。

4. 高度なヒントとベストプラクティス

Uni3Cのための参照素材の選択

- モーション転送用: Uni3Cのために、人物がほとんどフレーム内に留まる明確で視覚的な動きのあるビデオを選択します。

- カメラ制御用: Uni3Cのために、興味深い視点または望ましいカメラの動きのあるビデオを選択します。

- 最良の結果: Uni3Cでの参照モーションの方向が意図した出力方向と一致する場合に最適です。

Uni3Cのためのプロンプトエンジニアリングのベストプラクティス

- "邪魔しない"原則: キャラクターの変更なしで純粋なモーション転送を行うために、Uni3Cでシンプルで一般的なプロンプトを使用します。

- 具体的なアクション変更: Uni3Cでキャラクターの動きを変更したい場合は、詳細に記述します。

- キャラクターの一貫性: Uni3Cでキャラクターの外観を維持するためにプロンプトに焦点を当てます。

Uni3Cのための品質最適化

- モーションの一貫性: Uni3Cでよりスムーズな結果を得るために、参照ビデオでの突然の変化を避けます。

- フレームの安定性: Uni3Cのために参照素材が一貫した照明とフレーミングを持っていることを確認します。

5. 謝辞

このワークフローは、Uni3C、DAMO Academy (Alibaba Group)、Fudan University、Hupan Labによって開発されたもので、ComfyUI統合はkijai(ComfyUI-WanVideoWrapper)の優れた作業に基づいており、この強力なUni3C技術を世界中のクリエイターにアクセス可能にするために追加の最適化とワークフローデザインが施されています。