1. Flujo de Trabajo de ComfyUI: AnimateDiff + ControlNet | Estilo de Arte de Cerámica

Este flujo de trabajo utiliza AnimateDiff, ControlNet enfocándose en la profundidad, y Lora específicos para transformar hábilmente videos en un Estilo de Arte de Cerámica. Se te anima a usar diferentes prompts para lograr varios estilos de arte, convirtiendo tus ideas en realidad.

2. Cómo Usar AnimateDiff

AnimateDiff está diseñado para animar imágenes estáticas y prompts de texto en videos dinámicos, aprovechando modelos de Stable Diffusion y un módulo de movimiento especializado. Automatiza el proceso de animación prediciendo transiciones sin interrupciones entre fotogramas, haciéndolo accesible a usuarios sin habilidades de codificación.

2.1 Módulos de Movimiento de AnimateDiff

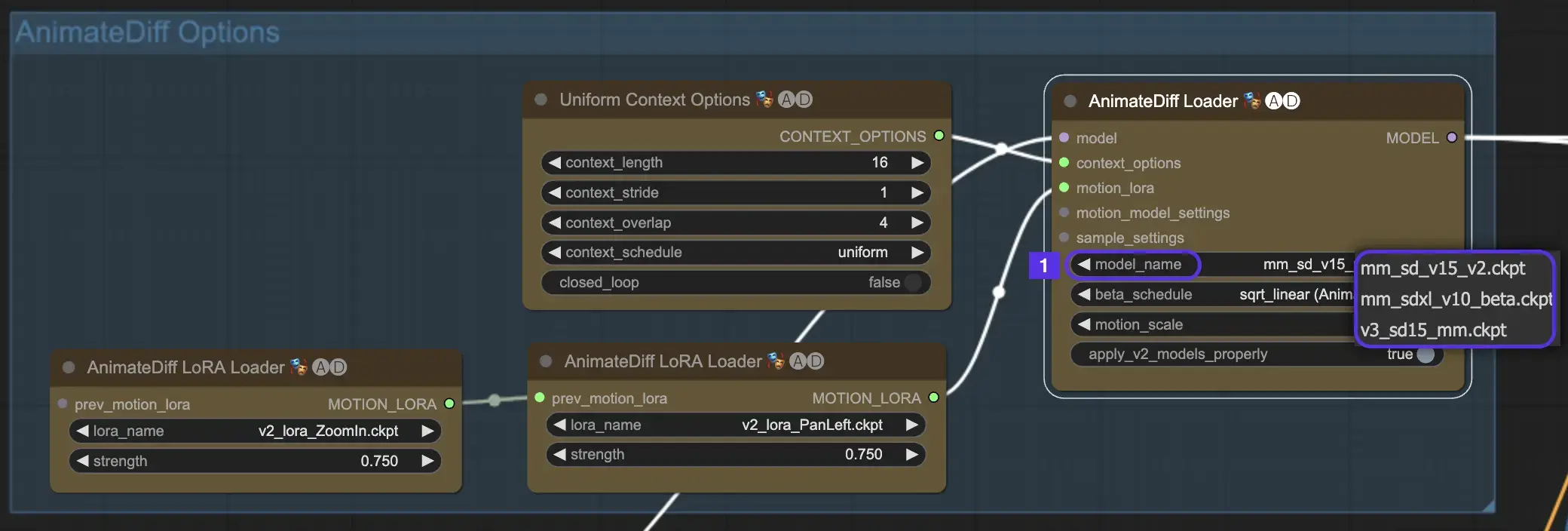

Para comenzar, selecciona el módulo de movimiento de AnimateDiff deseado del menú desplegable model_name:

- Usa v3_sd15_mm.ckpt para AnimateDiff V3

- Usa mm_sd_v15_v2.ckpt para AnimateDiff V2

- Usa mm_sdxl_v10_beta.ckpt para AnimateDiff SDXL

2.2 Beta Schedule

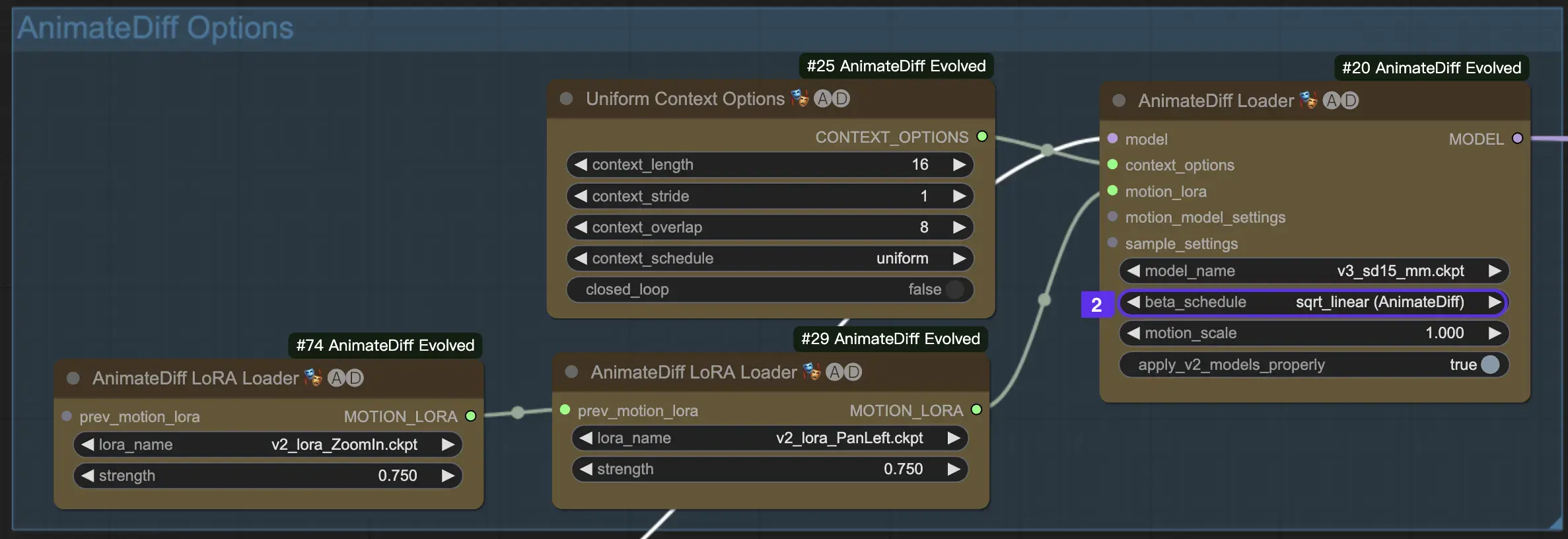

El Beta Schedule en AnimateDiff es crucial para ajustar el proceso de reducción de ruido durante la creación de la animación.

Para las versiones V3 y V2 de AnimateDiff, se recomienda la configuración sqrt_linear, aunque experimentar con la configuración linear puede producir efectos únicos.

Para AnimateDiff SDXL, se recomienda la configuración linear (AnimateDiff-SDXL).

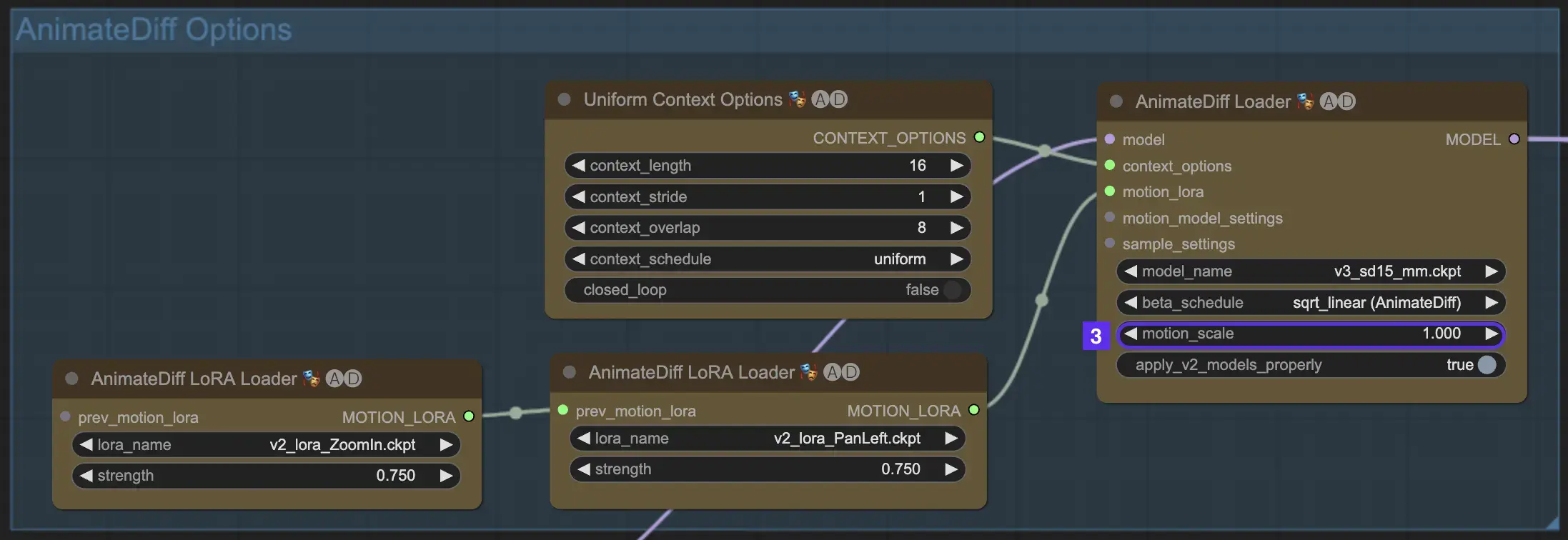

2.3 Motion Scale

La función Motion Scale en AnimateDiff permite ajustar la intensidad del movimiento en tus animaciones. Una Motion Scale menor a 1 resulta en un movimiento más sutil, mientras que una escala mayor a 1 amplifica el movimiento.

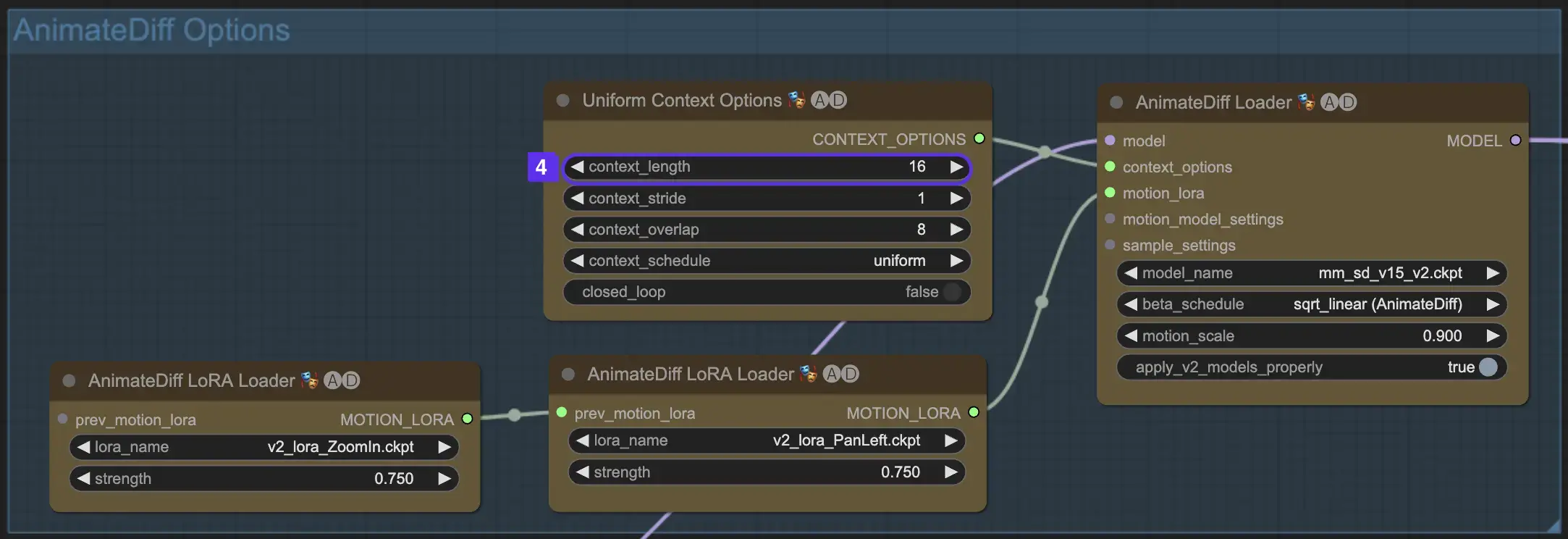

2.4 Context Length

El Uniform Context Length en AnimateDiff es esencial para asegurar transiciones sin interrupciones entre escenas definidas por tu Batch Size. Actúa como un editor experto, conectando escenas de manera fluida para una narración fluida. Establecer un Uniform Context Length más largo asegura transiciones más suaves, mientras que una longitud más corta ofrece cambios de escena más rápidos y distintos, beneficiosos para ciertos efectos. La longitud estándar del Uniform Context se establece en 16.

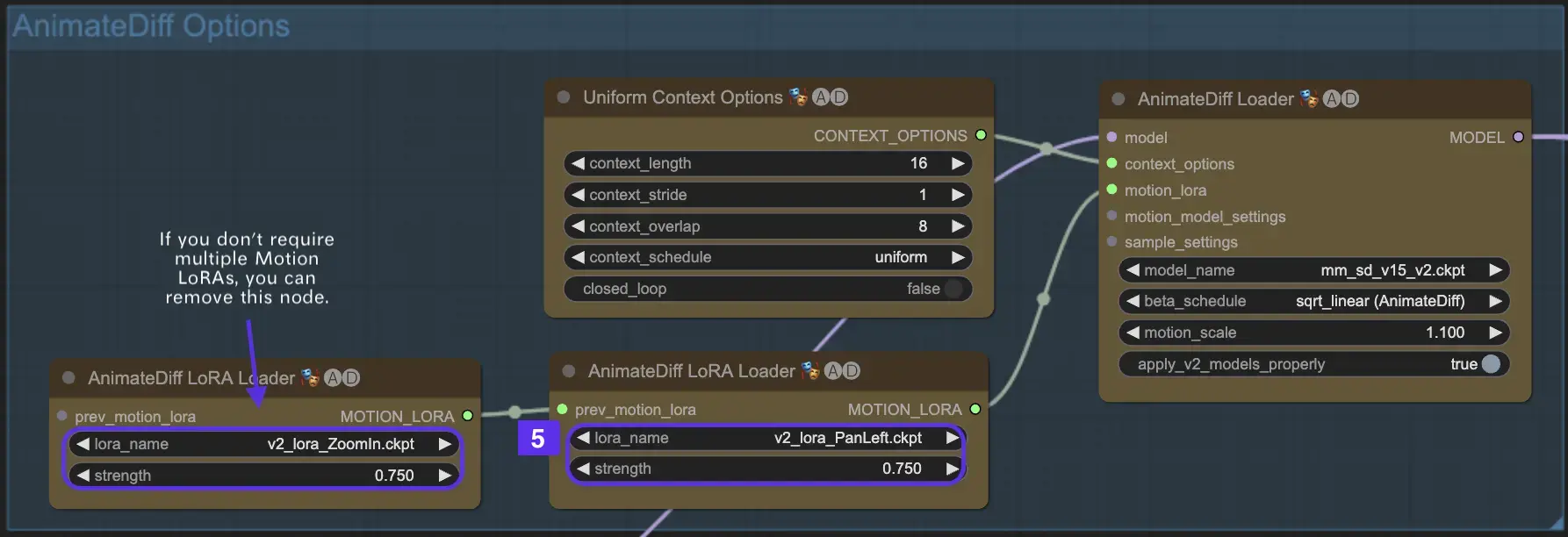

2.5 Utilizando Motion LoRA para Dinámica de Cámara Mejorada (Específico de AnimateDiff v2)

Los Motion LoRA, compatibles únicamente con AnimateDiff v2, introducen una capa adicional de movimiento dinámico de cámara. Lograr el equilibrio óptimo con el peso de LoRA, generalmente alrededor de 0.75, asegura un movimiento de cámara suave libre de distorsiones de fondo.

Además, encadenar varios modelos de Motion LoRA permite una dinámica de cámara compleja. Esto permite a los creadores experimentar y descubrir la combinación ideal para su animación, elevándola a un nivel cinematográfico.

3. Cómo Usar ControlNet

ControlNet mejora la generación de imágenes al introducir un control espacial preciso en los modelos de texto a imagen, permitiendo a los usuarios manipular imágenes de maneras sofisticadas más allá de simples prompts de texto, utilizando vastas bibliotecas de modelos como Stable Diffusion para tareas complejas como dibujar, mapear y segmentar imágenes.

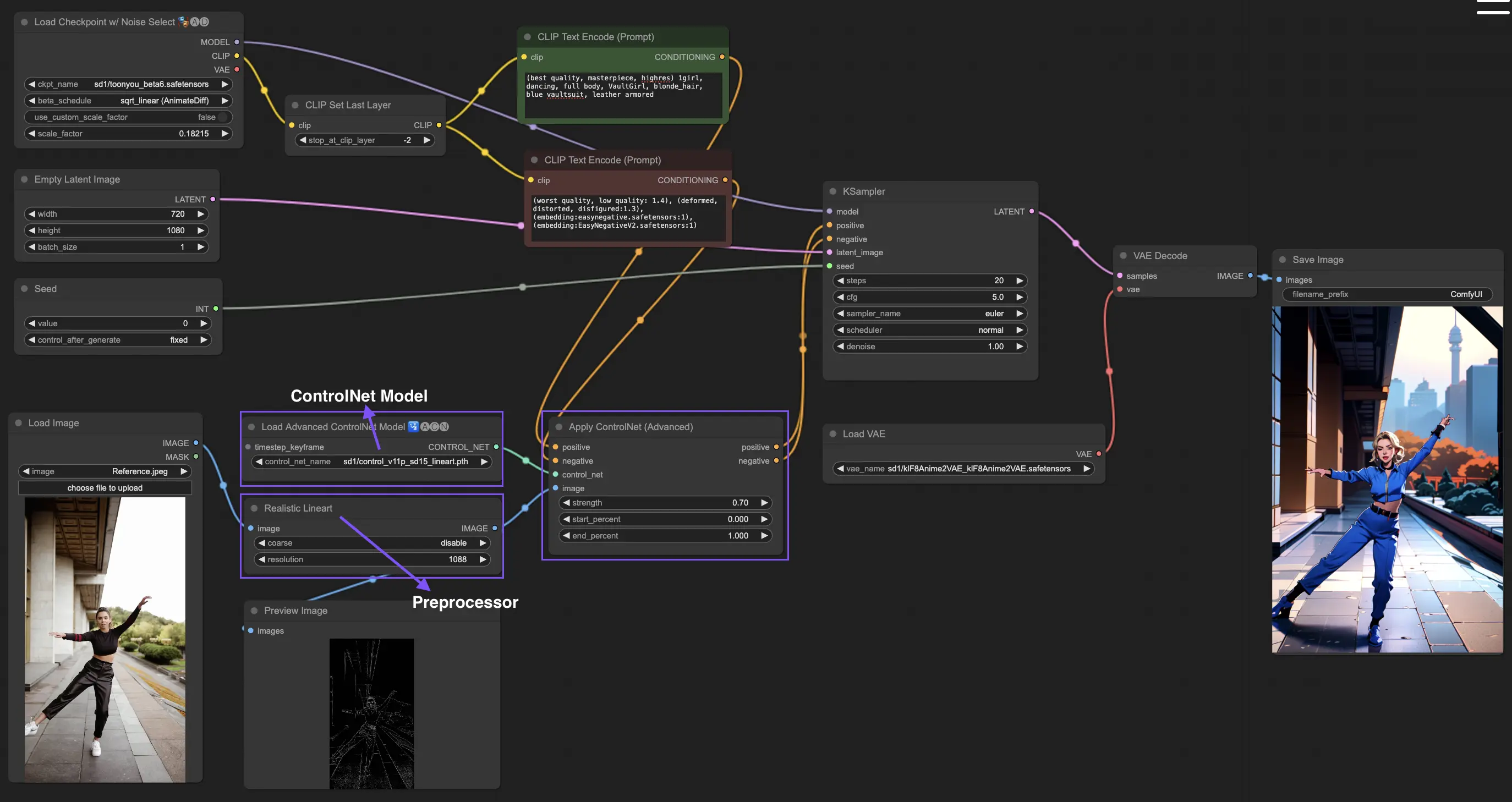

El siguiente es el flujo de trabajo más simple usando ControlNet.

3.1 Cargando el Nodo "Apply ControlNet"

Comienza tu creación de imágenes cargando el Nodo "Apply ControlNet" en ComfyUI, preparando el escenario para combinar elementos visuales y textuales en tu diseño.

3.2 Entradas del Nodo "Apply ControlNet"

Usa Conditioning Positivo y Negativo para dar forma a tu imagen, selecciona un modelo de ControlNet para definir rasgos de estilo, y preprocesa tu imagen para asegurarte de que coincida con los requisitos del modelo de ControlNet, preparándola así para la transformación.

3.3 Salidas del Nodo "Apply ControlNet"

Las salidas del nodo guían el modelo de difusión, ofreciendo la opción de refinar aún más la imagen o agregar más ControlNets para detalles mejorados y personalización basada en la interacción de ControlNet con tus entradas creativas.

3.4 Ajustando "Apply ControlNet" para Mejores Resultados

Controla la influencia de ControlNet en tu imagen a través de configuraciones como Determining Strength, Adjusting Start Percent y Setting End Percent para ajustar finamente el proceso creativo y el resultado de la imagen.

Para información más detallada, por favor consulta How to use ControlNet in ComfyUI

Este flujo de trabajo está inspirado por MDMZ con algunas modificaciones. Para más información, por favor visita su canal de YouTube.