¡Hola! En esta guía, nos sumergiremos en el fascinante mundo de ControlNet en ComfyUI. ¡Exploremos juntos lo que aporta y cómo puede potenciar tus proyectos!

Cubriremos:

1. ¿Qué es ControlNet?

2. Los Aspectos Técnicos Detrás de ControlNet

3. Cómo Usar ComfyUI ControlNet: Pasos Básicos

- 3.1. Cargar el Nodo "Aplicar ControlNet" en ComfyUI

- 3.2. Entradas del Nodo "Aplicar ControlNet"

- 3.3. Salidas del Nodo "Aplicar ControlNet"

- 3.4. Parámetros para ajustar "Aplicar ControlNet"

4. Cómo Usar ComfyUI ControlNet: Características Avanzadas - Fotogramas Clave de Pasos de Tiempo

5. Varios Modelos de ControlNet/T2IAdaptor: Descripción Detallada

- 5.1. ControlNet Openpose

- 5.2. ControlNet Tile

- 5.3. ControlNet Canny

- 5.4. ControlNet Depth

- 5.5. ControlNet Lineart

- 5.6. ControlNet Scribbles

- 5.7. ControlNet Segmentation

- 5.8. ControlNet Shuffle

- 5.9. ControlNet Inpainting

- 5.10. ControlNet MLSD

- 5.11. ControlNet Normalmaps

- 5.12. ControlNet Soft Edge

- 5.13. ControlNet IP2P (Instruct Pix2Pix)

- 5.14. T2I Adapter

- 5.15. Otros ControlNet Populares: QRCode Monster e IP-Adapter

6. Cómo Usar Múltiples ControlNets

7. ¡Experimenta ComfyUI ControlNet Ahora!

🌟🌟🌟 ComfyUI en Línea - Experimenta el Flujo de Trabajo de ControlNet Ahora 🌟🌟🌟

Si estás interesado en explorar el flujo de trabajo de ControlNet, utiliza la siguiente web de ComfyUI. Viene completamente equipada con todos los nodos y modelos esenciales, permitiendo una creatividad sin problemas sin necesidad de configuraciones manuales. Comienza a ganar experiencia práctica experimentando con las características de ControlNet de inmediato, o continúa con este tutorial para aprender a usar ControlNet de manera efectiva.

Para flujos de trabajo más avanzados y premium de ComfyUI, visita nuestra 🌟Lista de Flujos de Trabajo de ComfyUI🌟

1. ¿Qué es ControlNet?

ControlNet es una tecnología transformadora que mejora significativamente las capacidades de los modelos de difusión de texto a imagen, permitiendo un control espacial sin precedentes en la generación de imágenes. Como arquitectura de red neuronal, ControlNet se integra a la perfección con modelos preentrenados a gran escala como Stable Diffusion. Aprovecha el extenso entrenamiento de estos modelos, basado en miles de millones de imágenes, para introducir condiciones espaciales en el proceso de creación de imágenes. Estas condiciones pueden variar desde bordes y poses humanas hasta mapas de profundidad y segmentación, permitiendo a los usuarios guiar la generación de imágenes de maneras que antes no eran posibles solo con indicaciones de texto.

2. Los Aspectos Técnicos Detrás de ControlNet

La genialidad de ControlNet radica en su metodología distintiva. Inicialmente, asegura los parámetros del modelo original, garantizando que el entrenamiento fundamental permanezca inalterado. Posteriormente, ControlNet introduce un clon de las capas de codificación del modelo para el entrenamiento, utilizando "convoluciones cero". Estas capas convolucionales especialmente diseñadas comienzan con pesos cero, integrando cuidadosamente nuevas condiciones espaciales. Este enfoque evita que cualquier ruido disruptivo intervenga, preservando la competencia original del modelo al mismo tiempo que inicia nuevas trayectorias de aprendizaje.

3. Cómo Usar ComfyUI ControlNet: Pasos Básicos

Tradicionalm ente, los modelos de difusión estable emplean indicaciones de texto como mecanismo de condicionamiento para guiar la generación de imágenes, alineando la salida con los detalles de la indicación de texto. ControlNet introduce una forma adicional de condicionamiento a este proceso, mejorando la capacidad de dirigir las imágenes generadas de manera más precisa de acuerdo con entradas tanto textuales como visuales.

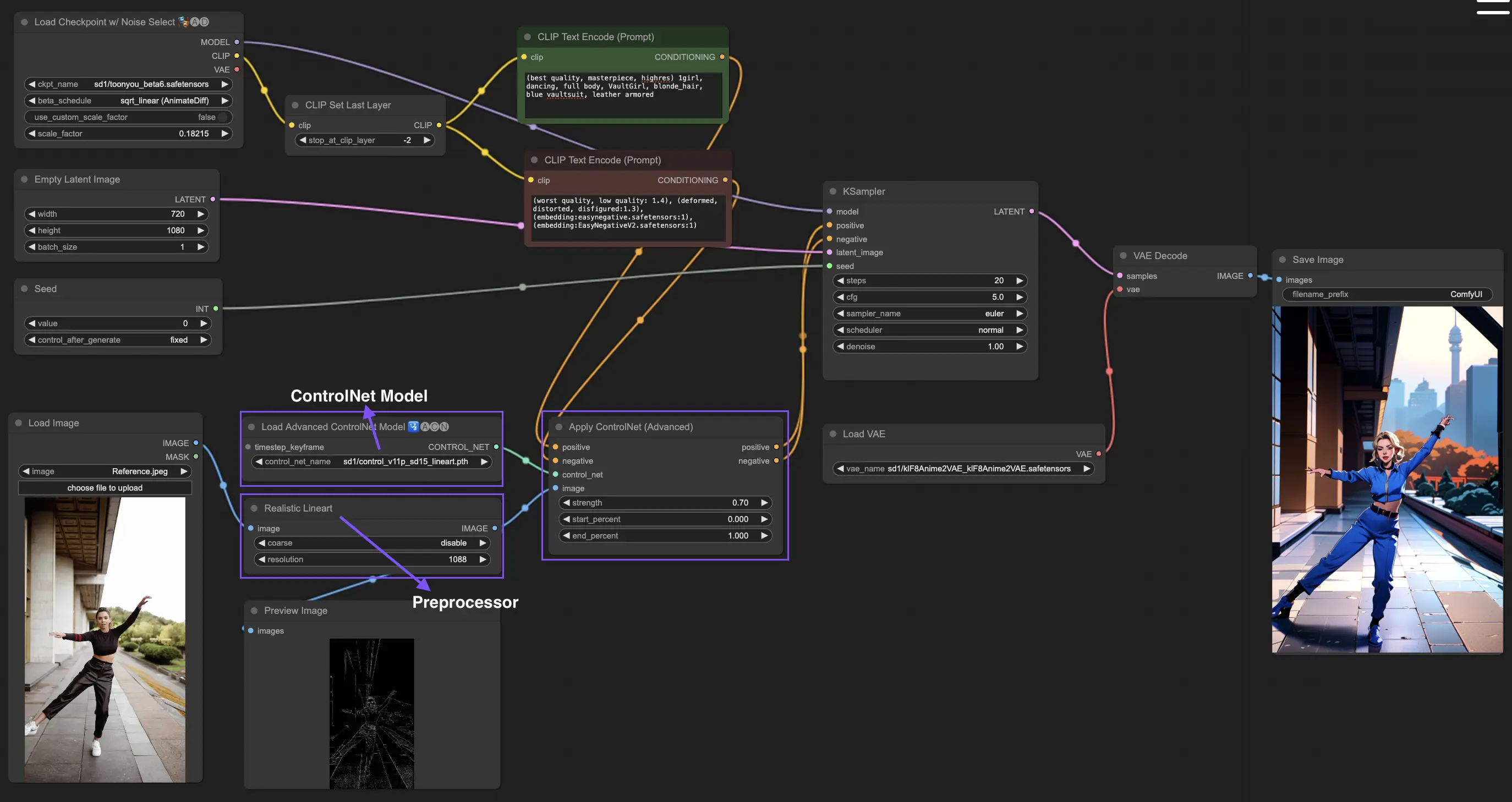

3.1. Cargar el Nodo "Aplicar ControlNet" en ComfyUI

Este paso integra ControlNet en tu flujo de trabajo de ComfyUI, permitiendo la aplicación de condicionamiento adicional a tu proceso de generación de imágenes. Sienta las bases para aplicar una guía visual junto con indicaciones de texto.

3.2. Entradas del Nodo "Aplicar ControlNet"

Condicionamiento Positivo y Negativo: Estas entradas son cruciales para definir los resultados deseados y los aspectos a evitar en la imagen generada. Deben estar vinculados a "Indicación positiva" e "Indicación negativa" respectivamente, alineándose con la parte de condicionamiento textual del proceso.

Modelo ControlNet: Esta entrada debe estar conectada a la salida del nodo "Cargar modelo ControlNet". Este paso es esencial para seleccionar e incorporar un modelo ControlNet o T2IAdaptor en tu flujo de trabajo, asegurando que el modelo de difusión se beneficie de la guía específica proporcionada por el modelo elegido. Cada modelo, ya sea un ControlNet o un T2IAdaptor, está rigurosamente entrenado para influir en el proceso de generación de imágenes según ciertos tipos de datos o preferencias estilísticas. Dado que las funcionalidades de muchos modelos T2IAdaptor se alinean estrechamente con las de los modelos ControlNet, nuestro enfoque se centrará predominantemente en los modelos ControlNet en nuestra discusión posterior. Sin embargo, también destacaremos algunos de los T2IAdaptors más populares para completar.

Preprocesador: La entrada "image" debe estar conectada a un nodo "Preprocesador ControlNet", que es crucial para adaptar tu imagen y cumplir con los requisitos específicos del modelo ControlNet que estás utilizando. Es imperativo utilizar el preprocesador correcto adaptado a tu modelo ControlNet seleccionado. Este paso asegura que la imagen original se someta a las modificaciones necesarias, como ajustes de formato, tamaño, color o la aplicación de filtros específicos, para optimizarla según las pautas de ControlNet. Después de esta fase de preprocesamiento, la imagen original se reemplaza por la versión modificada, que luego ControlNet utiliza. Este proceso garantiza que tus imágenes de entrada estén precisamente preparadas para el proceso de ControlNet.

3.3. Salidas del Nodo "Aplicar ControlNet"

El nodo "Aplicar ControlNet" genera dos salidas cruciales: Condicionamiento Positivo y Negativo. Estas salidas, imbuidas con los efectos matizados de ControlNet y la guía visual, desempeñan un papel fundamental en la dirección del comportamiento del modelo de difusión en ComfyUI. A continuación, se te presenta una opción: proceder al KSampler para la fase de muestreo para pulir aún más la imagen generada o, para aquellos que buscan un nivel aún más alto de detalle y personalización en su creación, continuar agregando ControlNets adicionales. Esta técnica avanzada de integrar más ControlNets permite una manipulación más granular de los atributos de la imagen, ofreciendo un conjunto de herramientas mejorado para los creadores que buscan lograr una precisión y control inigualables en sus salidas visuales.

3.4. Parámetros para ajustar "Aplicar ControlNet"

strength: Este parámetro determina la intensidad del efecto de ControlNet en la imagen generada en ComfyUI. Un valor de 1.0 implica máxima fuerza, lo que significa que la guía de ControlNet tendrá la máxima influencia en la salida del modelo de difusión. Por el contrario, un valor de 0.0 indica ninguna influencia, deshabilitando esencialmente el efecto de ControlNet en el proceso de generación de imágenes.

start_percent: Este parámetro especifica el punto de inicio, como porcentaje del proceso de difusión, donde ControlNet comienza a influir en la generación. Por ejemplo, establecer un porcentaje de inicio del 20% significa que la guía de ControlNet comenzará a afectar la generación de imágenes desde el punto del 20% en adelante del proceso de difusión.

end_percent: De manera análoga al "Porcentaje de Inicio", el parámetro "Porcentaje de Finalización" define el punto en el que cesa la influencia de ControlNet. Por ejemplo, un porcentaje de finalización del 80% significaría que la guía de ControlNet deja de influir en la generación de imágenes al alcanzar el 80% de finalización del proceso de difusión, dejando las fases finales sin afectar.

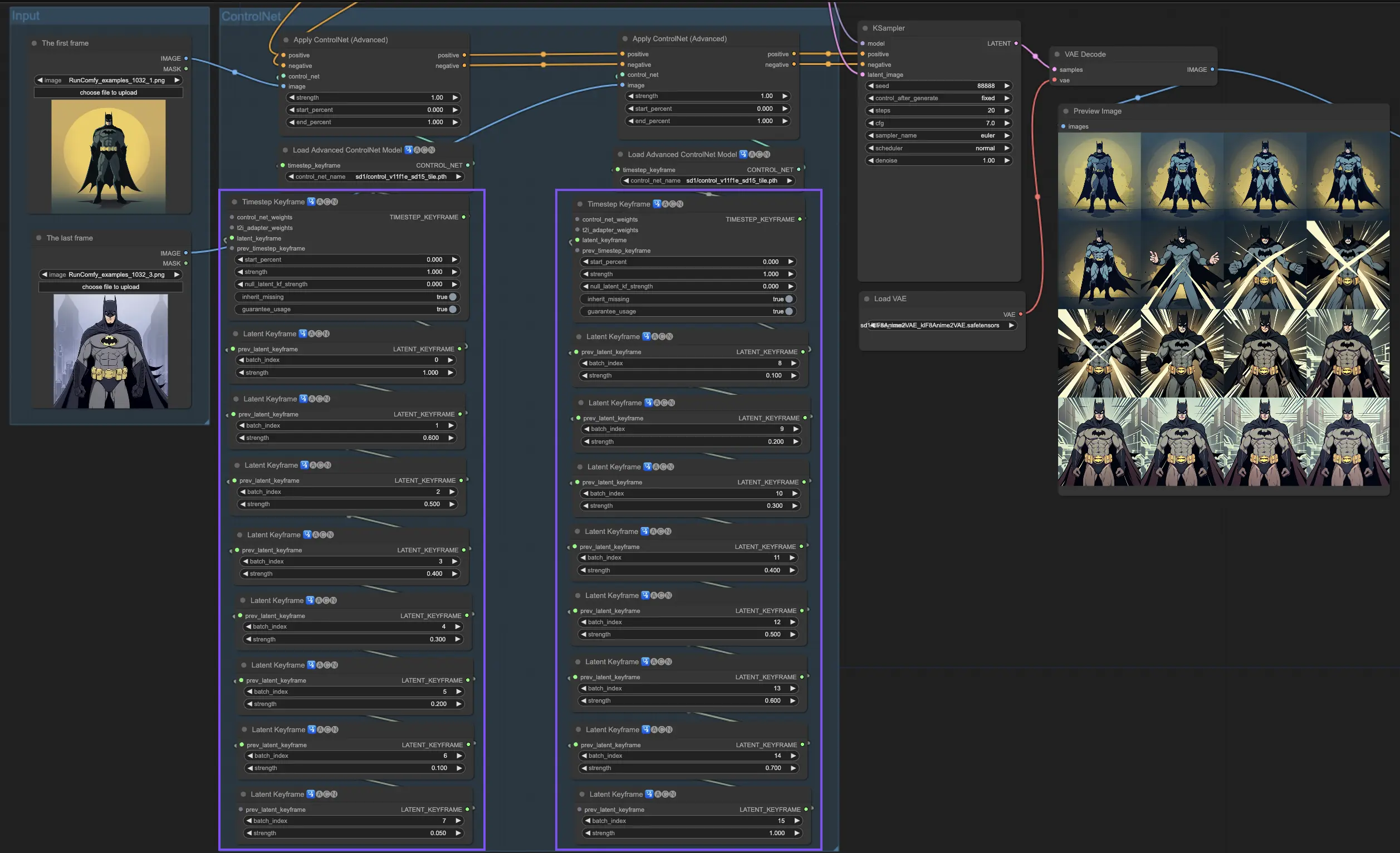

4. Cómo Usar ComfyUI ControlNet: Características Avanzadas - Fotogramas Clave de Pasos de Tiempo

Los Fotogramas Clave de Pasos de Tiempo en ControlNet ofrecen un control sofisticado sobre el comportamiento del contenido generado por IA, especialmente cuando el tiempo y la progresión son cruciales, como en animaciones o imágenes en evolución. Aquí hay un desglose detallado de los parámetros clave para ayudarte a utilizarlos de manera efectiva e intuitiva:

prev_timestep_kf: Piensa en prev_timestep_kf como unir las manos con el fotograma clave anterior en una secuencia. Al conectar fotogramas clave, creas una transición suave o un guión gráfico que guía a la IA a través del proceso de generación, paso a paso, asegurando que cada fase fluya lógicamente hacia la siguiente.

cn_weights: cn_weights son útiles para ajustar la salida ajustando características específicas dentro de ControlNet durante diferentes fases del proceso de generación.

latent_keyframe: latent_keyframe te permite ajustar qué tan fuertemente cada parte del modelo de IA influye en el resultado final durante una fase particular del proceso de generación. Por ejemplo, si estás generando una imagen donde el primer plano debería volverse más detallado a medida que el proceso evoluciona, puedes aumentar la fuerza para los aspectos (latentes) del modelo responsables de los detalles del primer plano en fotogramas clave posteriores. Por el contrario, si ciertas características deberían desvanecerse en el fondo con el tiempo, puedes reducir su fuerza en fotogramas clave subsiguientes. Este nivel de control es particularmente útil para crear imágenes dinámicas y en evolución o en proyectos donde el tiempo y la progresión precisos son cruciales.

mask_optional: Usa máscaras de atención como focos, enfocando la influencia de ControlNet en áreas específicas de tu imagen. Ya sea resaltando un personaje en una escena o enfatizando un elemento de fondo, estas máscaras pueden aplicarse uniformemente o variar en intensidad, dirigiendo la atención de la IA precisamente donde la deseas.

start_percent: start_percent marca la señal de cuándo tu fotograma clave entra en juego, medido como un porcentaje del proceso de generación general. Establecer esto es como programar la entrada de un actor en el escenario, asegurando que aparezca en el momento justo de la actuación.

strength: strength proporciona un control de alto nivel sobre la influencia general de ControlNet.

null_latent_kf_strength: Para cualquier actor (latente) que no hayas dirigido explícitamente en esta escena (fotograma clave), null_latent_kf_strength actúa como una instrucción predeterminada, diciéndoles cómo actuar en segundo plano. Asegura que ninguna parte de la generación se quede sin guía, manteniendo una salida coherente incluso en áreas que no has abordado específicamente.

inherit_missing: Activar inherit_missing permite que tu fotograma clave actual adopte cualquier configuración no especificada de su predecesor, como un hermano menor heredando ropa. Es un atajo útil que asegura continuidad y coherencia sin necesidad de repetir instrucciones.

guarantee_usage: guarantee_usage es tu garantía de que, pase lo que pase, el fotograma clave actual tendrá su momento para brillar en el proceso, aunque sea por un breve instante. Asegura que cada fotograma clave que hayas configurado tenga un impacto, honrando tu planificación detallada en la guía del proceso creativo de la IA.

Los Fotogramas Clave de Pasos de Tiempo ofrecen la precisión necesaria para guiar meticulosamente el proceso creativo de la IA, permitiéndote crear la narrativa o el viaje visual exactamente como lo imaginas. Sirven como una poderosa herramienta para orquestar la evolución de las imágenes, particularmente en animación, desde la escena inicial hasta la conclusión. Aquí hay una mirada más cercana a cómo los Fotogramas Clave de Pasos de Tiempo pueden aplicarse estratégicamente para gestionar la progresión de una animación, asegurando una transición perfecta desde el cuadro inicial hasta el final, alineándose perfectamente con tus objetivos artísticos.

5. Varios Modelos de ControlNet/T2IAdaptor: Descripción Detallada

Dado que las funcionalidades de muchos modelos T2IAdaptor se alinean estrechamente con las de los modelos ControlNet, nuestro enfoque se centrará predominantemente en los modelos ControlNet en nuestra discusión posterior. Sin embargo, también destacaremos algunos de los T2IAdaptors más populares para completar.

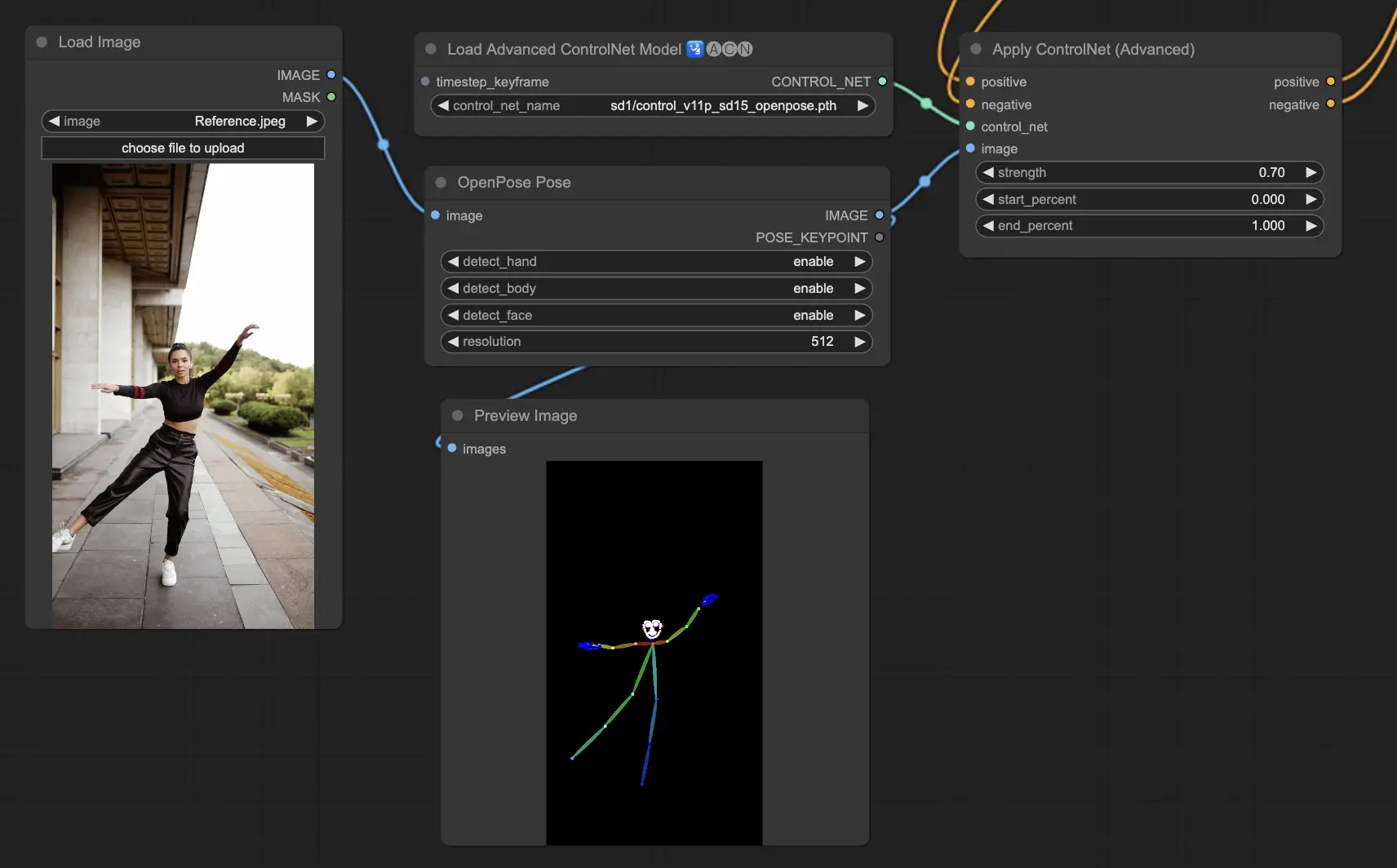

5.1. ComfyUI ControlNet Openpose

- Openpose (=Openpose body): El modelo fundamental dentro de ControlNet que identifica puntos clave básicos del cuerpo como ojos, nariz, cuello, hombros, codos, muñecas, rodillas y tobillos. Es ideal para la replicación básica de poses humanas.

- Openpose_face: Extiende el modelo OpenPose al agregar detección de puntos clave faciales, ofreciendo un análisis más detallado de las expresiones faciales y la orientación. Este modelo de ControlNet es esencial para proyectos centrados en expresiones faciales.

- Openpose_hand: Aumenta el modelo OpenPose con la capacidad de capturar detalles intrincados de manos y dedos, centrándose en gestos y posiciones detalladas de las manos. Esta adición mejora la versatilidad de OpenPose dentro de ControlNet.

- Openpose_faceonly: Un modelo especializado solo para detalles faciales, omitiendo los puntos clave del cuerpo para concentrarse en capturar expresiones y orientaciones faciales. Este modelo dentro de ControlNet se enfoca exclusivamente en las características faciales.

- Openpose_full: Una amalgama completa de los modelos OpenPose, OpenPose_face y OpenPose_hand, que ofrece una detección completa del cuerpo, la cara y las manos para una replicación total de la pose humana dentro de ControlNet.

- DW_Openpose_full: Una versión mejorada del modelo OpenPose_full, que incorpora refinamientos adicionales para una detección de pose aún más detallada y precisa. Esta versión representa el pináculo de la precisión en la detección de poses dentro del marco de ControlNet.

Preprocesador: Openpose o DWpose

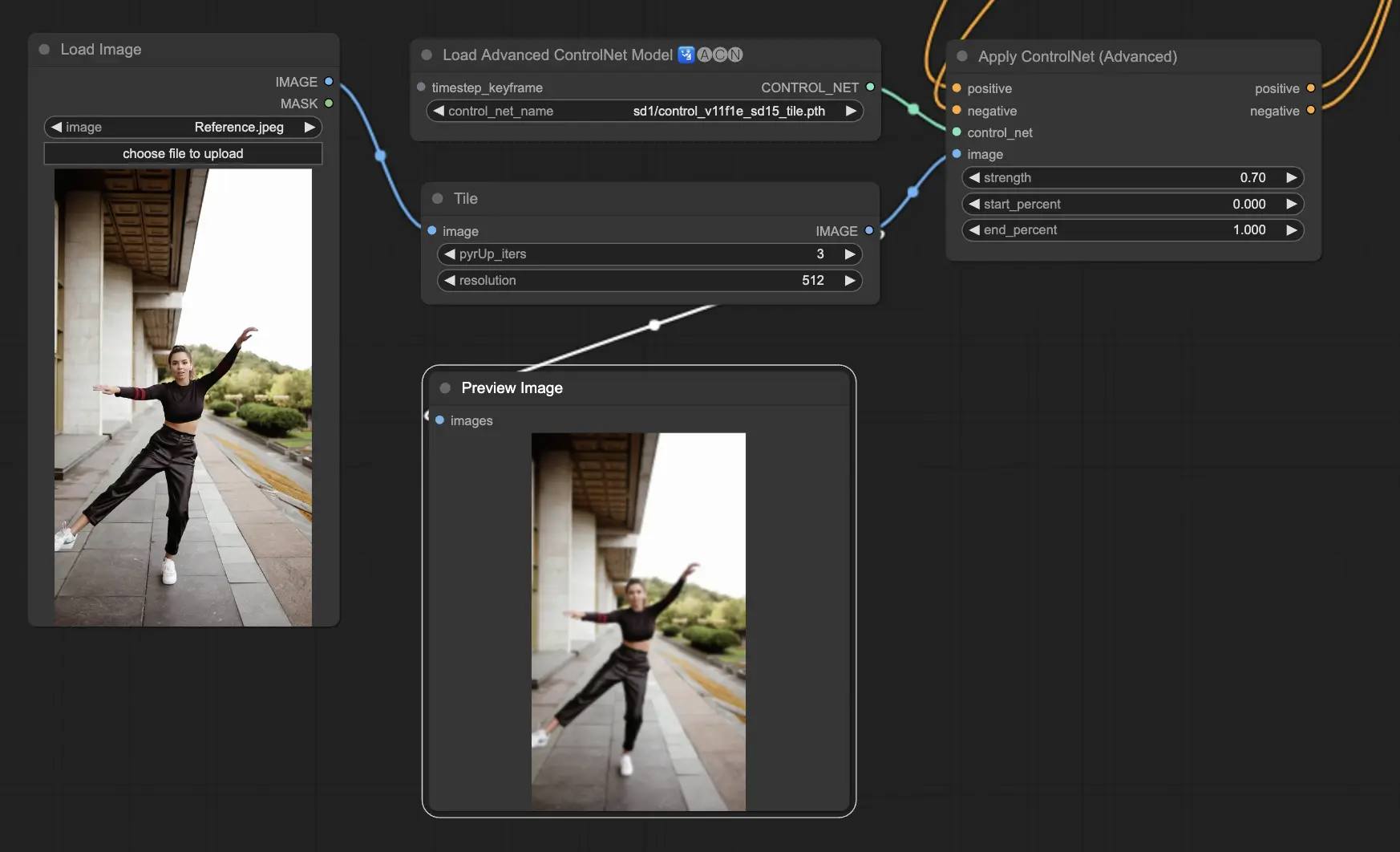

5.2. ComfyUI ControlNet Tile

El modelo Tile Resample se utiliza para mejorar los detalles en las imágenes. Es particularmente útil junto con un ampliador para mejorar la resolución de la imagen mientras agrega detalles más finos, a menudo utilizado para afilar y enriquecer texturas y elementos dentro de una imagen.

Preprocesador: Tile

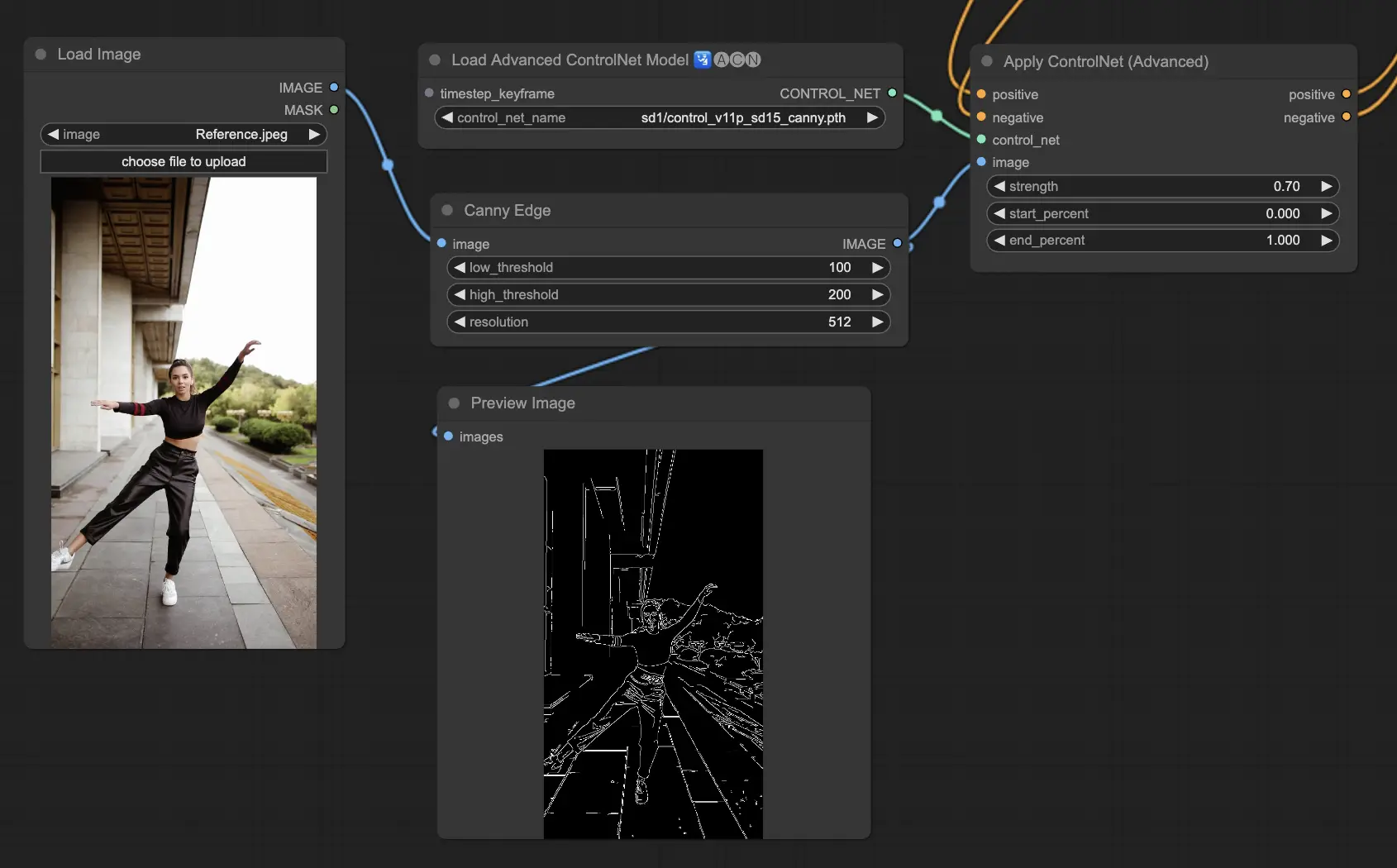

5.3. ComfyUI ControlNet Canny

El modelo Canny aplica el algoritmo de detección de bordes Canny, un proceso de varias etapas para detectar una amplia gama de bordes en imágenes. Este modelo es beneficioso para preservar los aspectos estructurales de una imagen mientras simplifica su composición visual, lo que lo hace útil para arte estilizado o preprocesamiento antes de una mayor manipulación de la imagen.

Preprocesadores: Canny

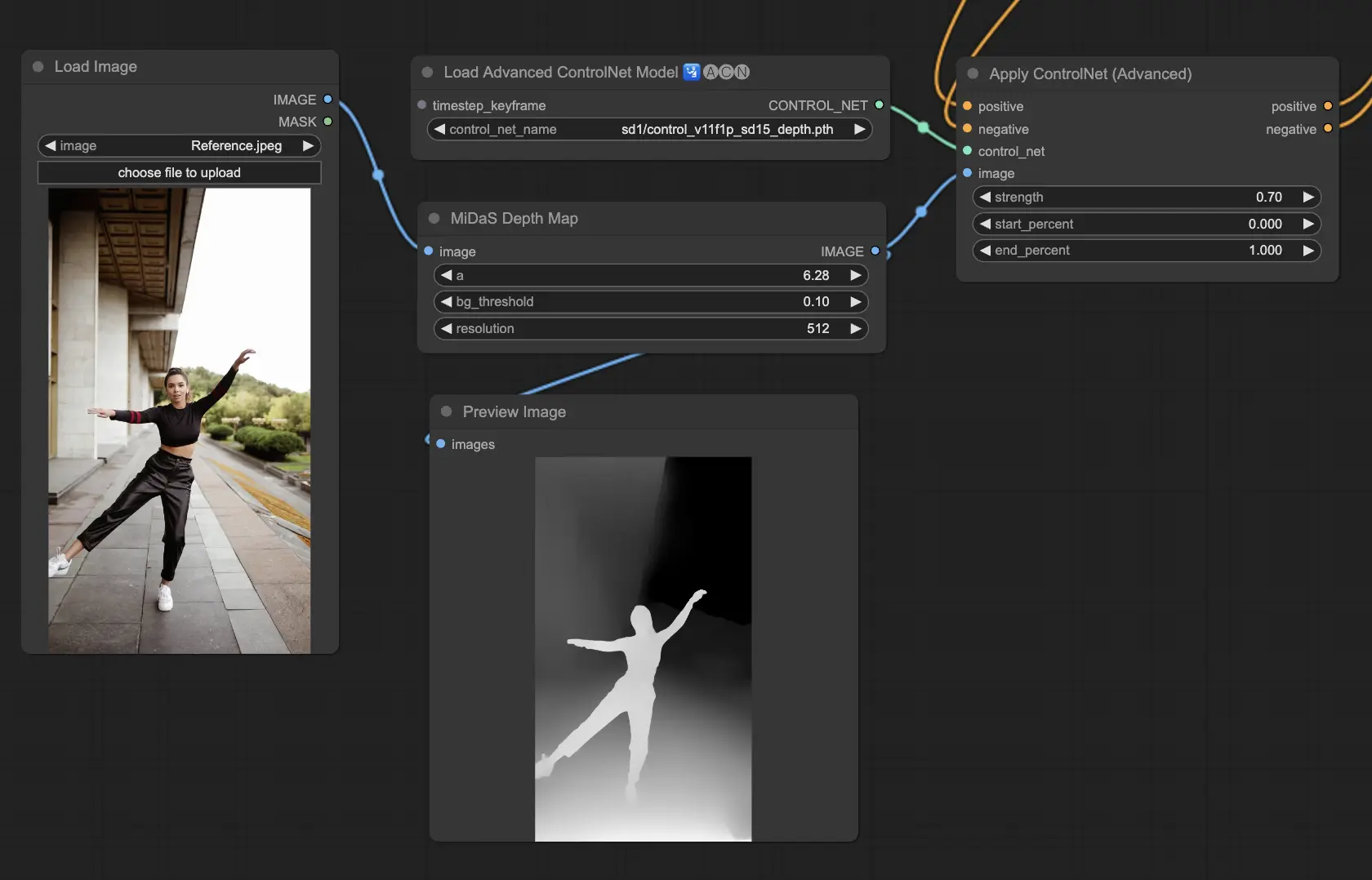

5.4. ComfyUI ControlNet Depth

Los modelos Depth infieren información de profundidad a partir de una imagen 2D, traduciendo la distancia percibida en un mapa de profundidad en escala de grises. Cada variante ofrece un equilibrio diferente entre la captura de detalles y el énfasis en el fondo:

- Depth Midas: Proporciona una estimación clásica de profundidad, equilibrando el detalle y la representación del fondo.

- Depth Leres: Se enfoca en mejorar los detalles con una tendencia a incluir más elementos de fondo.

- Depth Leres++: Ofrece un nivel avanzado de detalle para la información de profundidad, ideal para escenas complejas.

- Zoe: Logra un equilibrio entre los modelos Midas y Leres en términos de nivel de detalle.

- Depth Anything: Un modelo más nuevo y mejorado para la estimación de profundidad, diseñado para una amplia gama de escenas.

- Depth Hand Refiner: Diseñado específicamente para mejorar los detalles de las manos en los mapas de profundidad, útil para escenas donde el posicionamiento de las manos es crítico.

Preprocesadores: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Este modelo es altamente robusto y puede funcionar en mapas de profundidad reales de motores de renderizado.

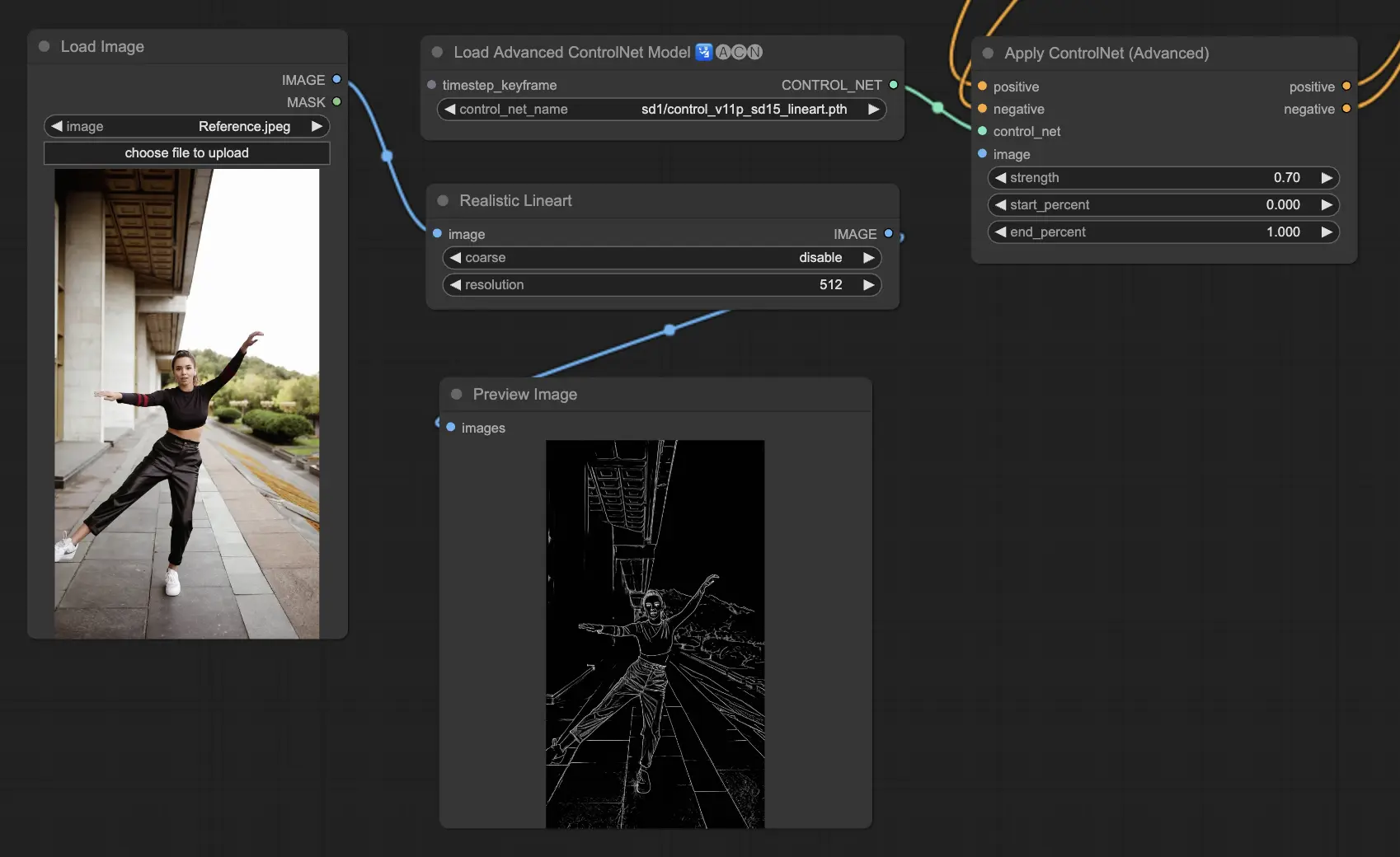

5.5. ComfyUI ControlNet Lineart

Los modelos Lineart convierten imágenes en dibujos de líneas estilizados, útiles para representaciones artísticas o como base para trabajos creativos adicionales:

- Lineart: Este modelo estándar convierte imágenes en dibujos de líneas estilizados, ofreciendo una base versátil para diversos proyectos artísticos o creativos.

- Lineart anime: Se enfoca en generar dibujos de líneas al estilo anime, caracterizados por líneas limpias y precisas, lo que lo hace adecuado para proyectos que apuntan a una estética anime.

- Lineart realistic: Produce dibujos lineales con un toque más realista, capturando la esencia del sujeto con mayor detalle, perfecto para proyectos que requieren una representación realista.

- Lineart coarse: Ofrece un dibujo lineal más pronunciado con líneas más pesadas y audaces, creando un efecto llamativo que se destaca, especialmente adecuado para expresiones artísticas audaces.

El preprocesador puede generar lineart detallado o grueso a partir de imágenes (Lineart y Lineart_Coarse)

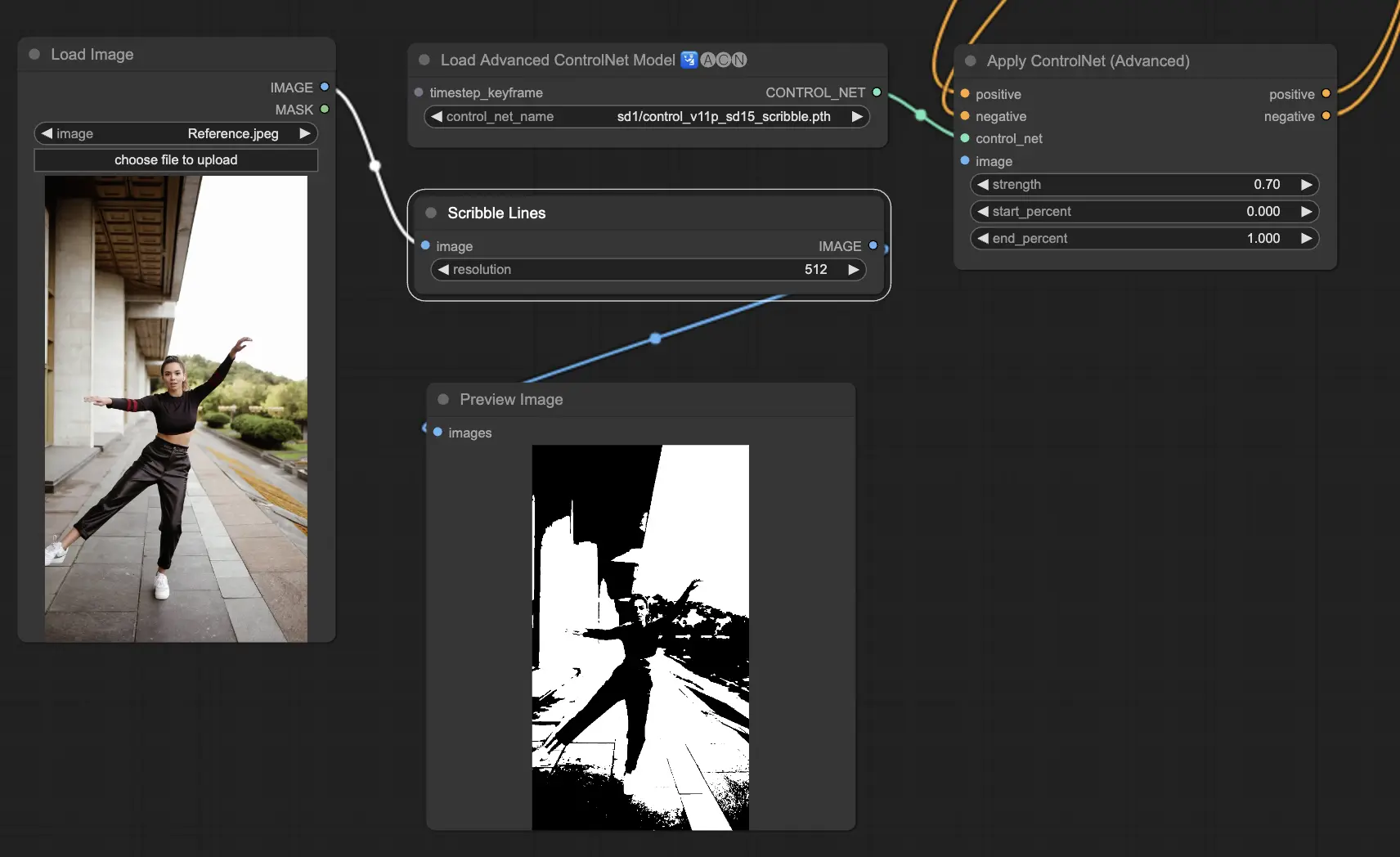

5.6. ComfyUI ControlNet Scribbles

Los modelos Scribble están diseñados para transformar imágenes en una apariencia similar a un garabato, simulando el aspecto de bocetos dibujados a mano. Son particularmente útiles para el reestilizado artístico o como paso preliminar en un flujo de trabajo de diseño más amplio:

- Scribble: Diseñado para convertir imágenes en obras de arte detalladas que simulan garabatos o bocetos dibujados a mano.

- Scribble HED: Utiliza la Detección de Bordes Holísticamente Anidados (HED) para crear contornos que se asemejan a bocetos dibujados a mano. Se recomienda para recolorear y reestilizar imágenes, agregando un toque artístico único a la obra de arte.

- Scribble Pidinet: Se enfoca en detectar diferencias de píxeles para producir líneas más limpias con detalles reducidos, lo que lo hace ideal para representaciones más claras y abstractas. Scribble Pidinet es perfecto para aquellos que buscan curvas nítidas y bordes rectos, ofreciendo un aspecto pulido mientras preserva los detalles esenciales.

- Scribble xdog: Emplea el método Extended Difference of Gaussian (xDoG) para la detección de bordes. Esto permite ajustar la configuración del umbral para afinar el efecto de garabato, lo que hace posible controlar el nivel de detalle en tu obra de arte. xDoG es versátil, permitiendo a los usuarios lograr el equilibrio perfecto en sus creaciones artísticas.

Preprocesadores: Scribble, Scribble_HED, Scribble_PIDI y Scribble_XDOG

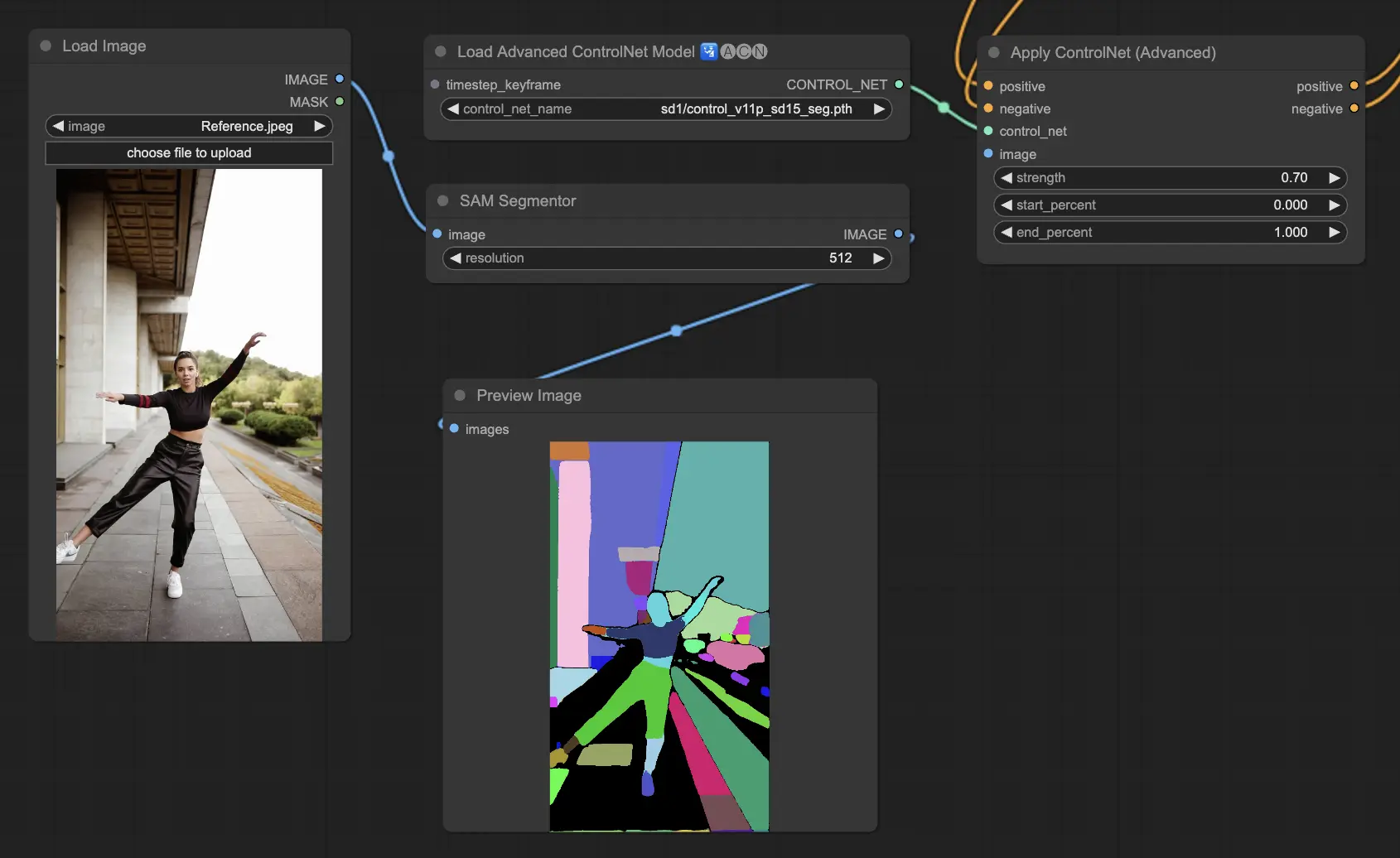

5.7. ComfyUI ControlNet Segmentation

Los modelos de segmentación categorizan los píxeles de la imagen en distintas clases de objetos, cada una representada por un color específico. Esto es invaluable para identificar y manipular elementos individuales dentro de una imagen, como separar el primer plano del fondo o diferenciar objetos para una edición detallada.

- Seg: Diseñado para diferenciar objetos dentro de una imagen por color, traduciendo efectivamente estas distinciones en elementos distintos en la salida. Por ejemplo, puede separar muebles en un diseño de habitación, lo que lo hace particularmente valioso para proyectos que requieren un control preciso sobre la composición y edición de imágenes.

- ufade20k: Utiliza el modelo de segmentación UniFormer entrenado en el conjunto de datos ADE20K, capaz de distinguir una amplia gama de tipos de objetos con alta precisión.

- ofade20k: Emplea el modelo de segmentación OneFormer, también entrenado en ADE20K, ofreciendo un enfoque alternativo para la diferenciación de objetos con sus capacidades únicas de segmentación.

- ofcoco: Aprovecha la segmentación OneFormer entrenada en el conjunto de datos COCO, adaptada para imágenes con objetos categorizados dentro de los parámetros del conjunto de datos COCO, facilitando la identificación y manipulación precisas de objetos.

Preprocesadores aceptables: Sam, Seg_OFADE20K (Oneformer ADE20K), Seg_UFADE20K (Uniformer ADE20K), Seg_OFCOCO (Oneformer COCO) o máscaras creadas manualmente.

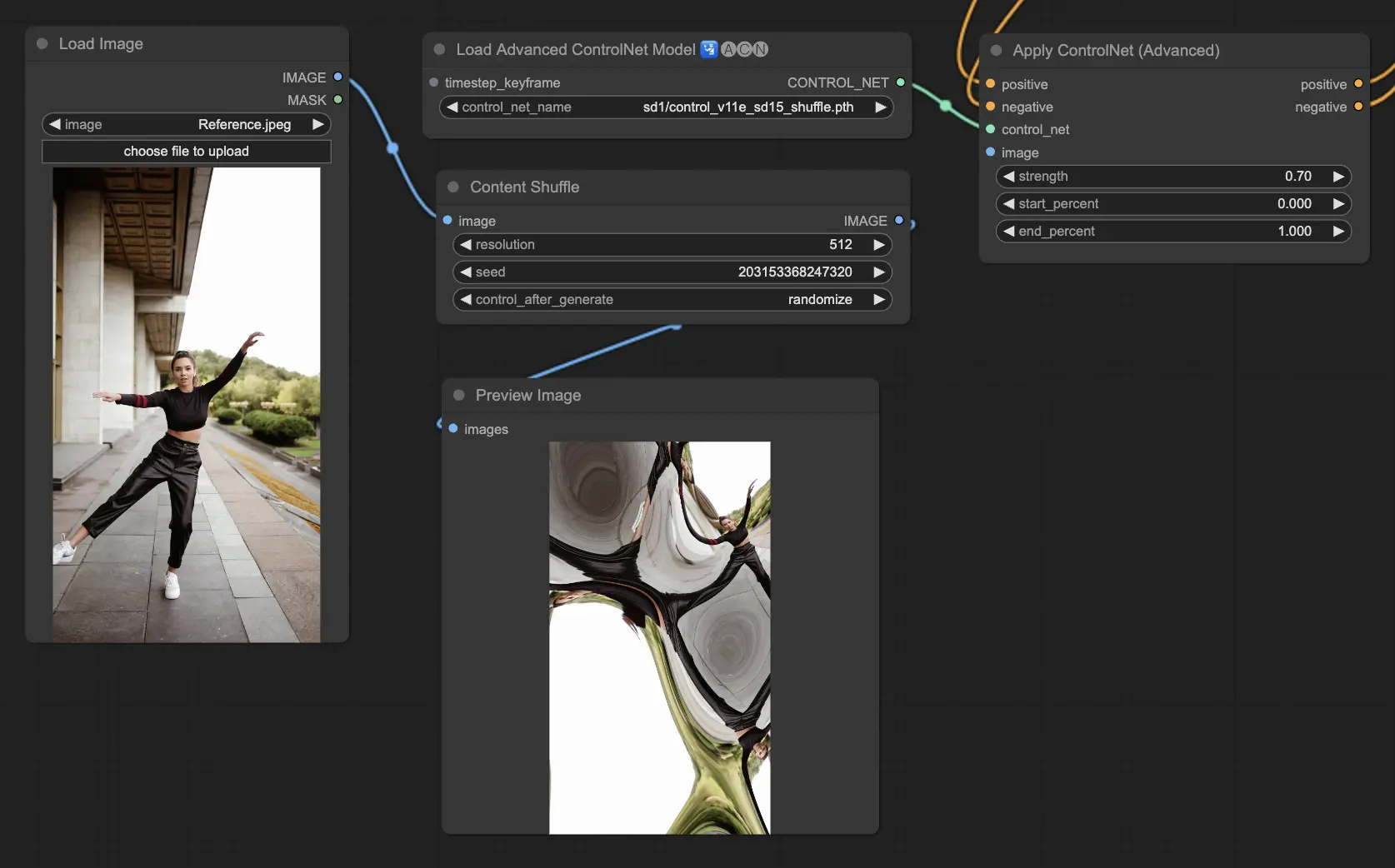

5.8. ComfyUI ControlNet Shuffle

El modelo Shuffle introduce un enfoque novedoso al aleatorizar los atributos de la imagen de entrada, como esquemas de color o texturas, sin alterar la composición. Este modelo es particularmente efectivo para exploraciones creativas y generar variaciones de una imagen con integridad estructural retenida pero estética visual alterada. Su naturaleza aleatoria significa que cada salida es única, influenciada por el valor de semilla utilizado en el proceso de generación.

Preprocesadores: Shuffle

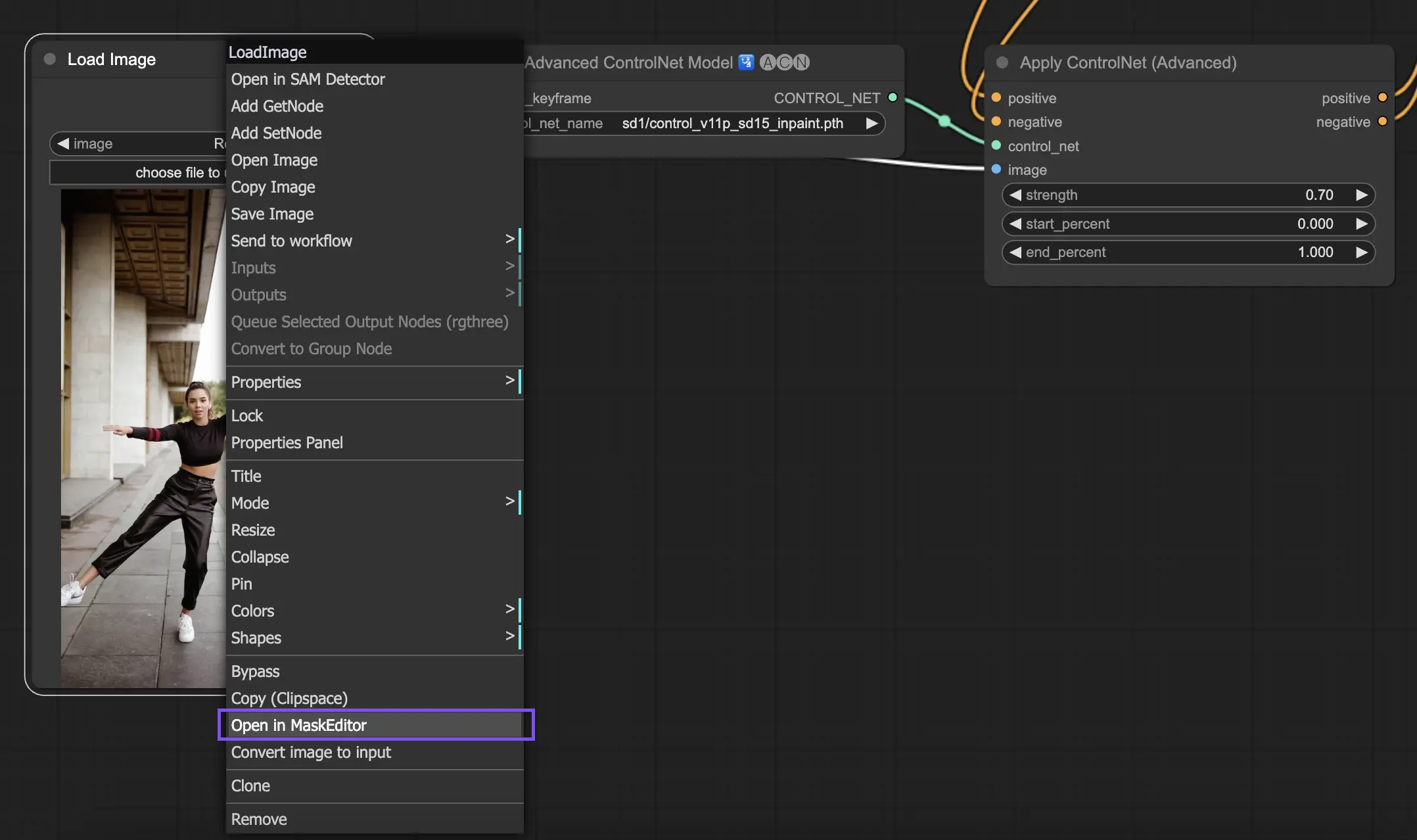

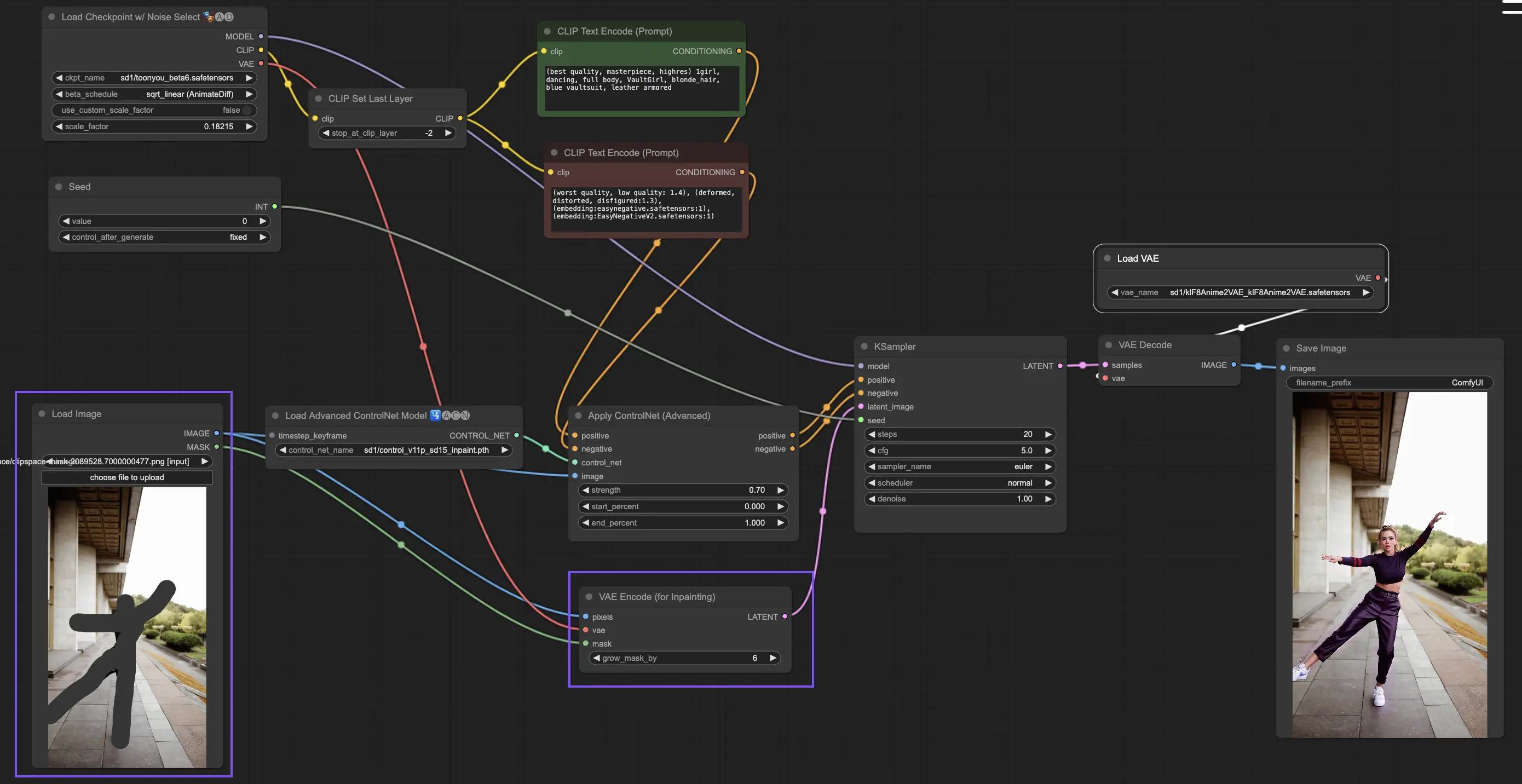

5.9. ComfyUI ControlNet Inpainting

Los modelos de Inpainting dentro de ControlNet permiten una edición refinada dentro de áreas específicas de una imagen, manteniendo la coherencia general al tiempo que introducen variaciones o correcciones significativas.

Para utilizar ControlNet Inpainting, comienza aislando el área que deseas regenerar mediante enmascaramiento. Esto se puede hacer haciendo clic derecho en la imagen deseada y seleccionando "Abrir en MaskEditor" para modificaciones.

A diferencia de otras implementaciones dentro de ControlNet, Inpainting omite la necesidad de un preprocesador debido a las modificaciones directas aplicadas a la imagen. Sin embargo, es crucial enviar la imagen editada al espacio latente a través del KSampler. Esto asegura que el modelo de difusión se enfoque únicamente en regenerar la región enmascarada, manteniendo la integridad de las áreas sin máscara.

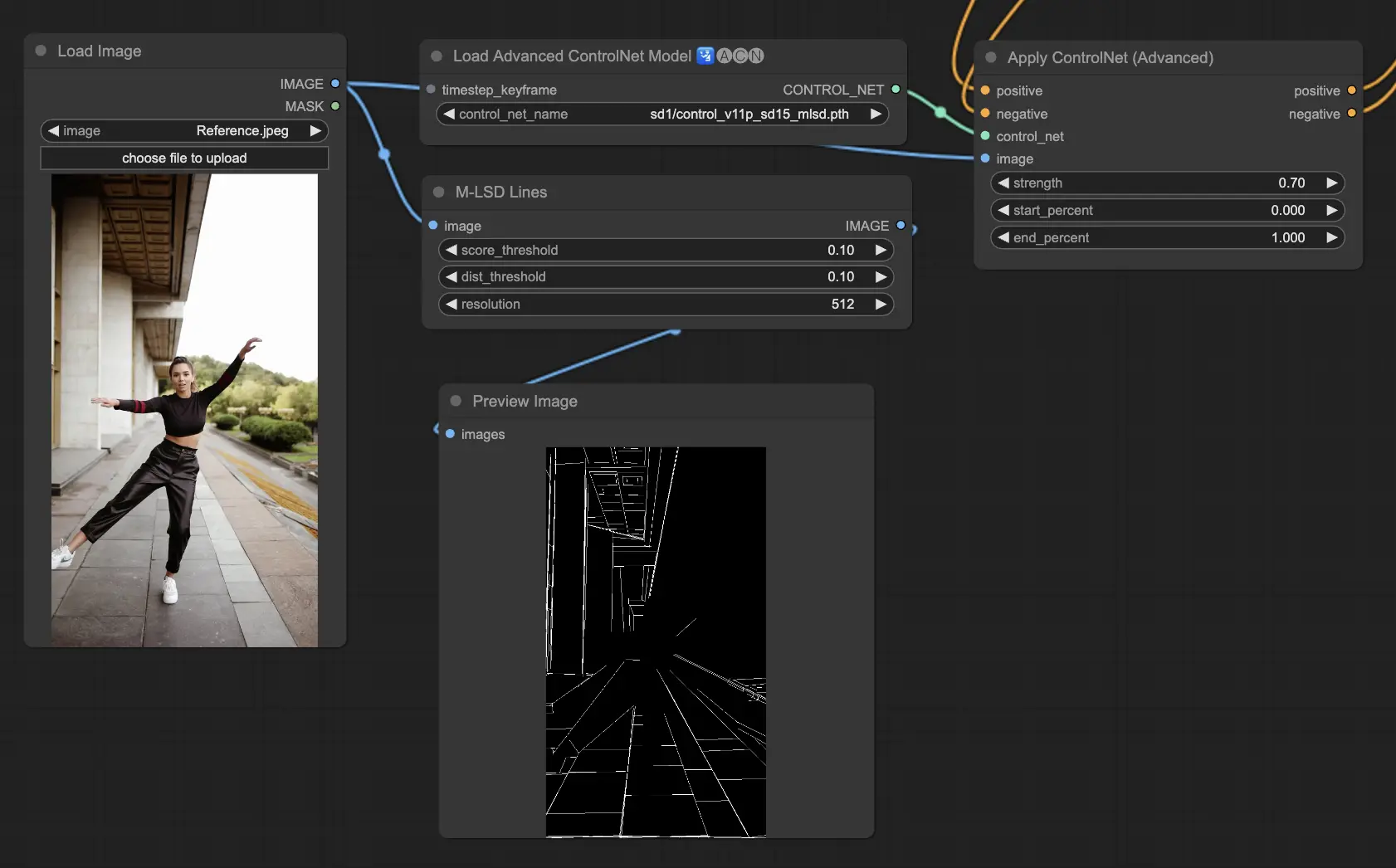

5.10. ComfyUI ControlNet MLSD

M-LSD (Mobile Line Segment Detection) se enfoca en detectar líneas rectas, ideal para imágenes con fuertes elementos arquitectónicos, interiores y formas geométricas. Simplifica las escenas a su esencia estructural, facilitando proyectos creativos que involucran entornos creados por el hombre.

Preprocesadores: MLSD.

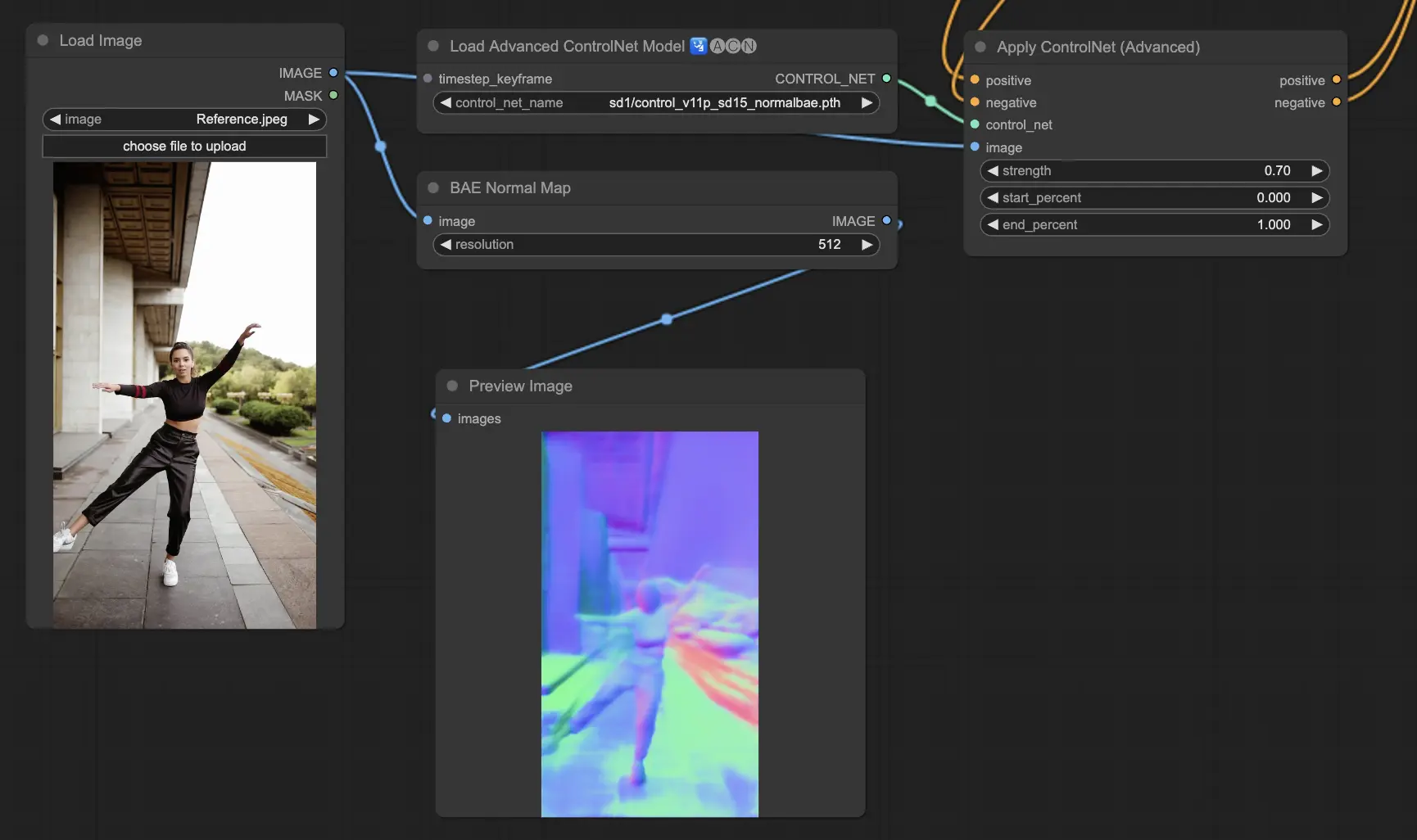

5.11. ComfyUI ControlNet Normalmaps

Normalmaps permite la simulación de efectos complejos de iluminación y textura al modelar la orientación de las superficies en una escena visual, en lugar de depender únicamente de los datos de color. Esto es fundamental para tareas de modelado y simulación 3D.

- Normal Bae: Este método genera mapas normales aprovechando el enfoque de incertidumbre normal. Proporciona una técnica innovadora para representar la orientación de las superficies, mejorando la simulación de efectos de iluminación basados en la geometría física de la escena modelada en lugar de los métodos convencionales basados en el color.

-Normal Midas: Utilizando mapas de profundidad producidos por el modelo Midas, Normal Midas estima con precisión los mapas normales. Este enfoque permite una simulación matizada de texturas y iluminación de superficies, basada en la información de profundidad de la escena, enriqueciendo así la complejidad visual de los modelos 3D.

Preprocesadores: Normal BAE, Normal Midas

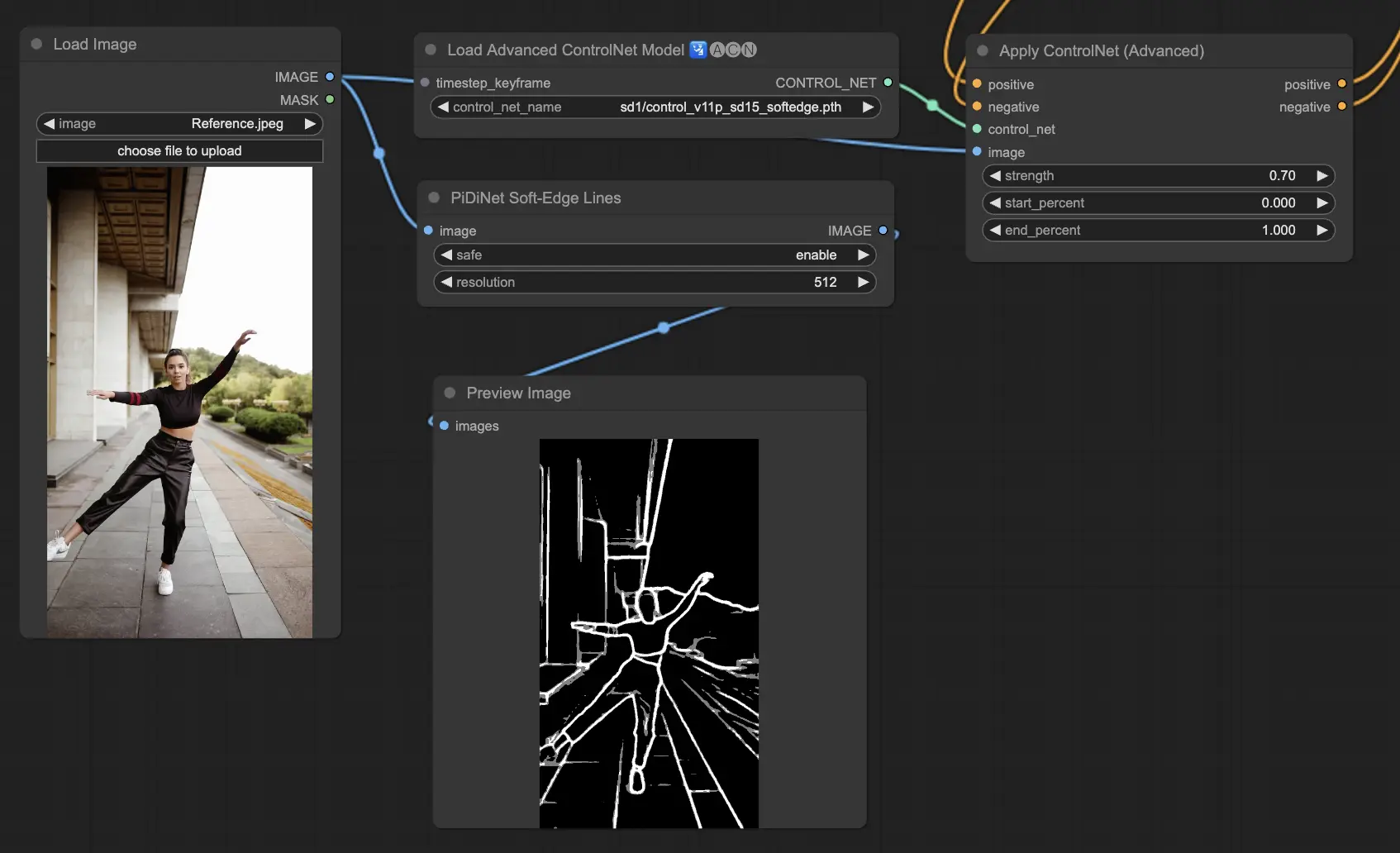

5.12. ComfyUI ControlNet Soft Edge

ControlNet Soft Edge está diseñado para generar imágenes con bordes más suaves, enfocándose en el control de detalles y la apariencia natural. Utiliza técnicas avanzadas de redes neuronales para la manipulación precisa de imágenes, ofreciendo mayor libertad creativa y capacidades de fusión perfectas.

Robustez: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Calidad máxima de resultados: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Considerando el equilibrio, recomendamos usar SoftEdge_PIDI por defecto. En la mayoría de los casos funciona muy bien.

Preprocesadores: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

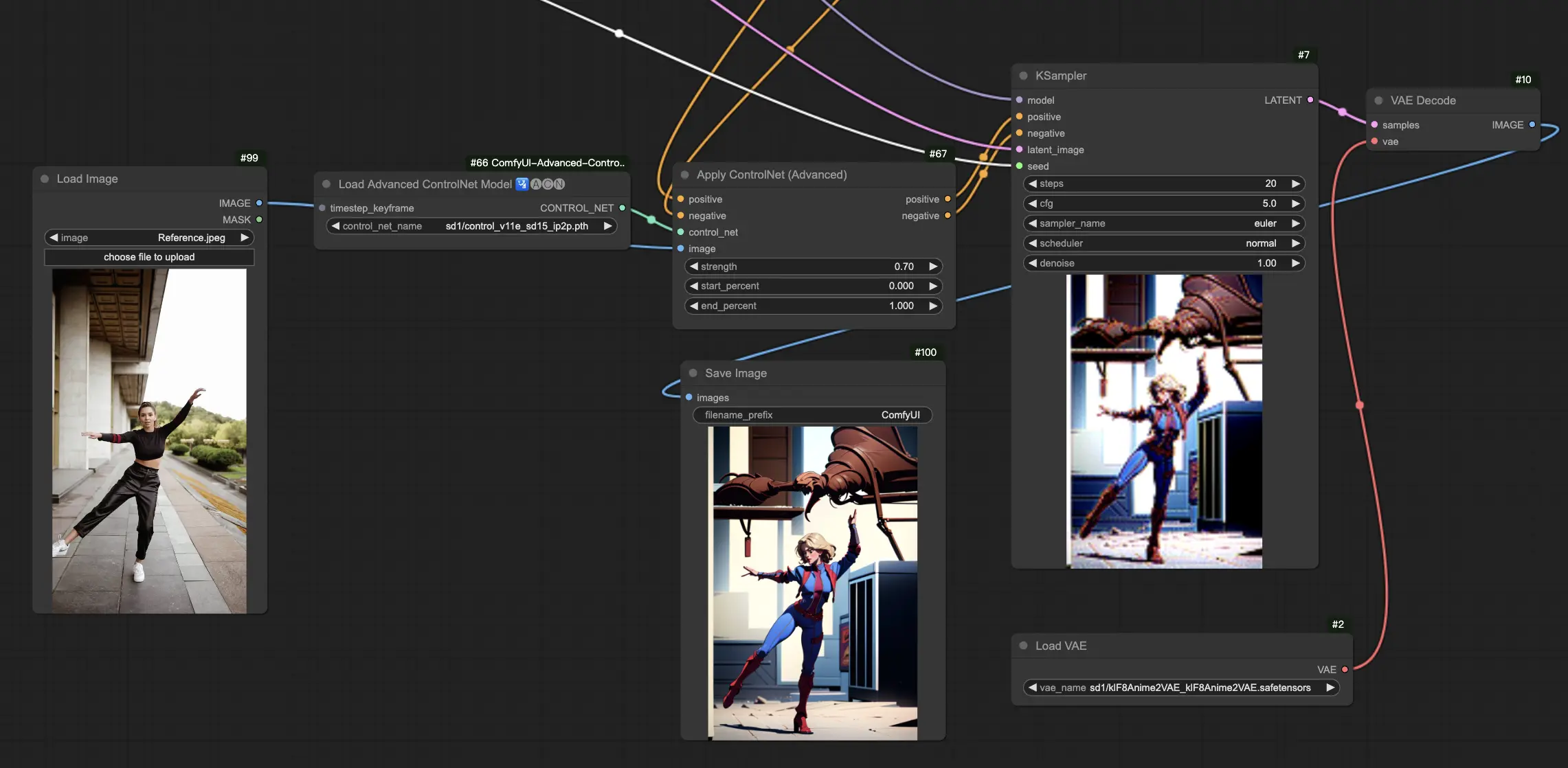

5.13. ComfyUI ControlNet IP2P (Instruct Pix2Pix)

El modelo ControlNet IP2P (Instruct Pix2Pix) se destaca como una adaptación única dentro del marco de ControlNet, adaptado para aprovechar el conjunto de datos Instruct Pix2Pix para transformaciones de imágenes. Esta variante de ControlNet se diferencia al equilibrar entre indicaciones de instrucciones e indicaciones de descripción durante su fase de entrenamiento. A diferencia del enfoque convencional en Instruct Pix2Pix oficial, ControlNet IP2P incorpora una mezcla 50/50 de estos tipos de indicaciones, mejorando su versatilidad y eficacia en la generación de resultados deseados.

5.14. ComfyUI T2I Adapter

t2iadapter color: El modelo t2iadapter_color está específicamente diseñado para mejorar la representación del color y la precisión en las imágenes generadas al utilizar modelos de difusión de texto a imagen. Al centrarse en la adaptación del color, este modelo permite una paleta de colores más precisa y vibrante, estrechamente alineada con las descripciones proporcionadas en las indicaciones de texto. Es particularmente útil para proyectos donde la fidelidad y especificidad del color son cruciales, agregando una nueva capa de realismo y detalle a las imágenes generadas.

t2iadapter style: El modelo t2iadapter_style se dirige a los aspectos estilísticos de la generación de imágenes, permitiendo la modificación y el control sobre el estilo artístico de las imágenes de salida. Este adaptador permite a los usuarios guiar el modelo de texto a imagen hacia la generación de imágenes que se adhieren a estilos o estéticas artísticas específicas descritas en las indicaciones de texto. Es una herramienta invaluable para proyectos creativos donde el estilo de la imagen juega un papel fundamental, ofreciendo una forma perfecta de combinar estilos artísticos tradicionales con capacidades modernas de IA.

5.15. Otros ControlNet Populares de ComfyUI: QRCode Monster e IP-Adapter

Para estos segmentos, dedicaremos artículos separados para proporcionar una introducción completa a cada uno, dado la cantidad sustancial de información que deseamos compartir.

6. Cómo Usar Múltiples ComfyUI ControlNets

Usar múltiples ComfyUI ControlNets en ComfyUI involucra un proceso de superposición o encadenamiento de modelos ControlNet para refinar la generación de imágenes con controles más precisos sobre varios aspectos como pose, forma, estilo y color.

Por lo tanto, puedes construir tu flujo de trabajo aplicando un ControlNet (por ejemplo, OpenPose) y luego alimentando su salida a otro ControlNet (por ejemplo, Canny). Esta aplicación en capas permite una personalización detallada de la imagen, donde cada ControlNet aplica sus transformaciones o controles específicos. El proceso permite un control refinado sobre la salida final, integrando múltiples aspectos guiados por diferentes ControlNets.

🌟🌟🌟 ComfyUI en Línea - Experimenta el Flujo de Trabajo de ControlNet Ahora 🌟🌟🌟

Si estás interesado en explorar el flujo de trabajo de ControlNet, utiliza la siguiente web de ComfyUI. Viene completamente equipada con todos los nodos y modelos esenciales del cliente, permitiendo una creatividad sin problemas sin necesidad de configuraciones manuales. ¡Obtén experiencia práctica y familiarízate con las características de ControlNet ahora!