此工作流程受到 enigmatic_e 的啟發,並進行了一些修改。如需詳細教程,請訪問他的 YouTube 頻道。

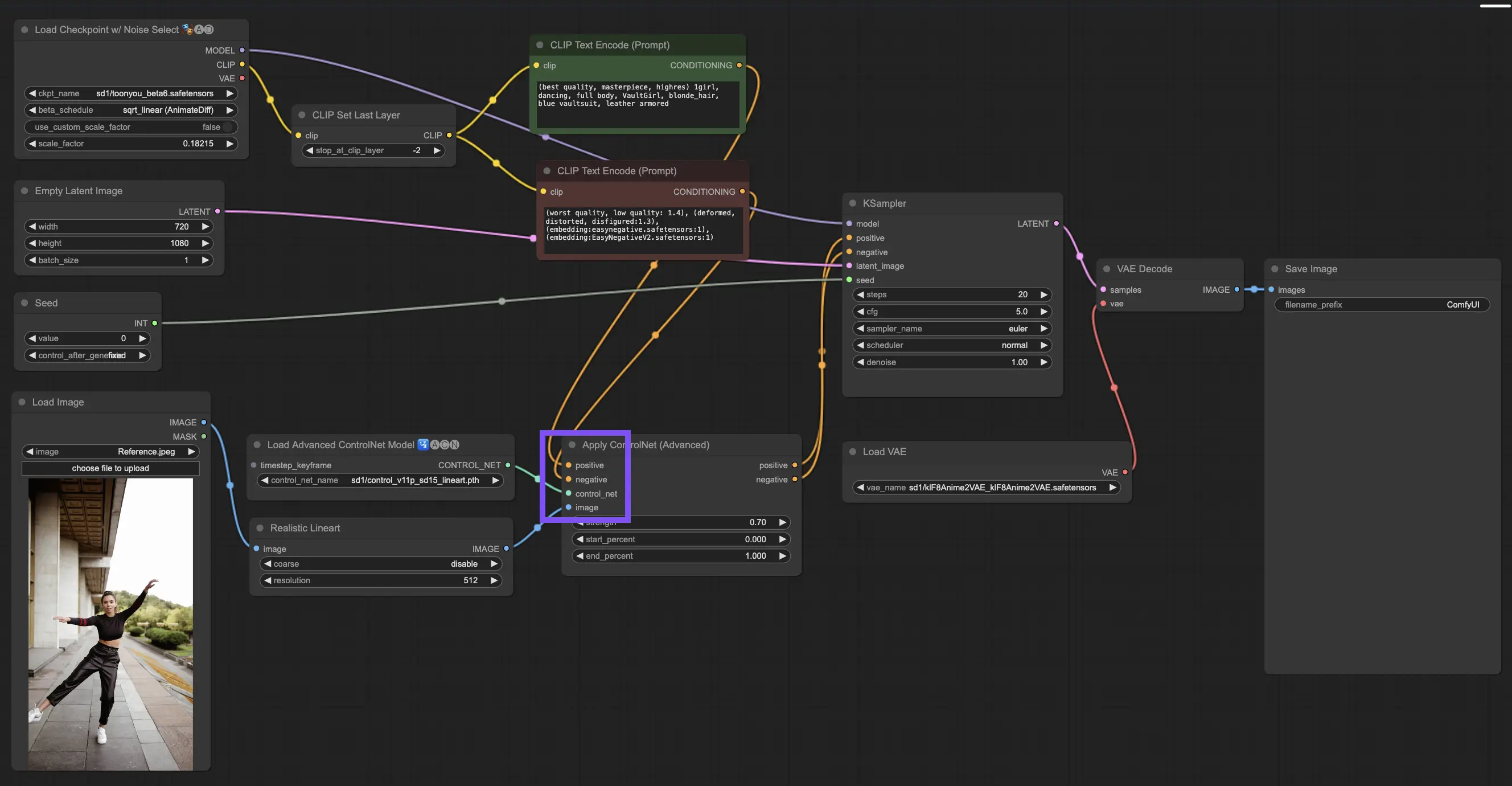

1. ComfyUI 工作流程:AnimateDiff + ControlNet + IPAdapter | 日本動漫風格

此工作流程讓您可以使用 AnimateDiff、ControlNet 和 IPAdapter 將標準影片轉換為迷人的日本動漫創作。請隨意嘗試各種檢查點、LoRA 設置和 IPAdapter 的參考圖像,以打造您獨特的風格。這是一種有趣且富有創意的方式,讓您的影片在動漫世界中煥發活力!

2. AnimateDiff 概覽

請查看 如何在 ComfyUI 中使用 AnimateDiff 的詳細信息。

3. 如何使用 ControlNet

3.1. 理解 ControlNet

ControlNet 革新了我們生成圖像的方式,為文本到圖像擴散模型帶來了新的空間控制層次。這種尖端的神經網絡架構與 Stable Diffusion 等巨頭完美搭配,利用其龐大的圖像庫——由數十億張圖像鍛造而成——將空間細微差別直接編織到圖像創建的結構中。從勾勒出邊緣到映射人體姿勢、深度感知或分割視覺內容,ControlNet 賦予您塑造圖像的能力,遠遠超出僅僅依賴文本提示的範疇。

3.2. ControlNet 的創新

在其核心,ControlNet 的設計巧妙而直接。它首先保護原始模型參數的完整性,保持基礎訓練不變。然後,ControlNet 引入了一組鏡像的模型編碼層,但帶有一個轉折點:它們使用 "零卷積" 進行訓練。這些零作為起點意味著這些層溫和地融入新的空間條件而不引起騷動,確保模型的原始才能在開啟新的學習路徑時仍然得以保留。

3.3. 理解 ControlNets 和 T2I-Adapters

ControlNets 和 T2I-Adapters 都在圖像生成的條件設定中發揮著關鍵作用,各自提供了獨特的優勢。T2I-Adapters 因其效率而著稱,特別是在加速圖像生成過程方面。儘管如此,ControlNets 在複雜地引導生成過程方面無可匹敵,使其成為創作者的強大工具。

考慮到許多 T2I-Adapter 和 ControlNet 模型功能的重疊,我們的討論將主要聚焦於 ControlNets。然而,值得注意的是,RunComfy 平台已預裝了多個 T2I-Adapter 模型以供方便使用。對於那些有興趣嘗試 T2I-Adapters 的人,您可以無縫地加載這些模型並將其整合到您的項目中。

在 ComfyUI 中選擇 ControlNet 和 T2I-Adapter 模型不會影響 ControlNet 節點的使用或工作流程的一致性。 這種一致性確保了流程的流暢性,允許您根據項目需求充分利用每種模型類型的獨特優勢。

3.4. 使用 ControlNet 節點

3.4.1. 加載 "Apply ControlNet" 節點

首先,您需要將 "Apply ControlNet" 節點加載到您的 ComfyUI 中。這是您邁向雙條件圖像創作之旅的第一步,將視覺元素與文本提示融合在一起。

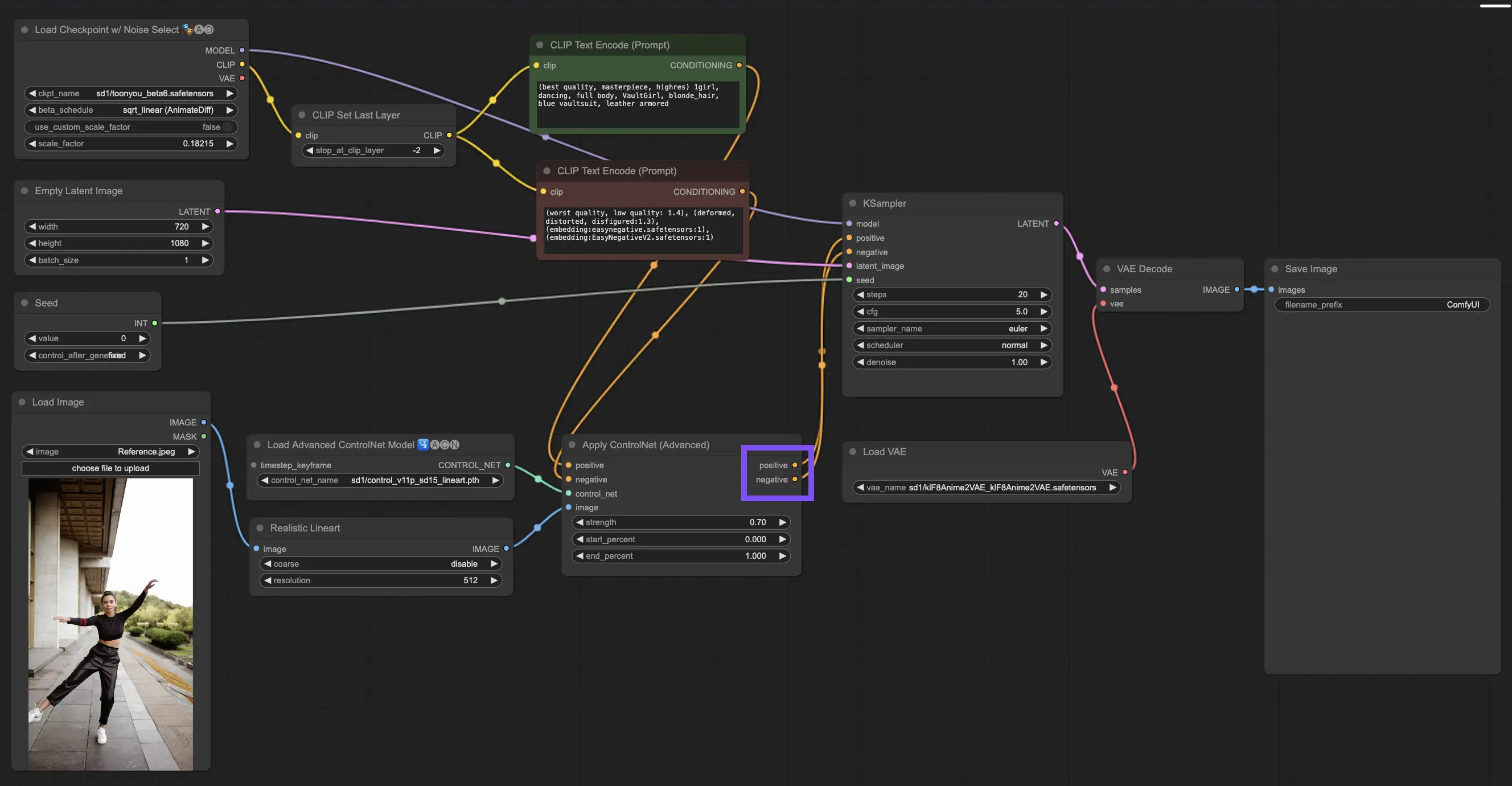

3.4.2. 理解 "Apply ControlNet" 節點的輸入

正向和負向條件設定:這些是您塑造最終圖像的工具——應該擁抱什麼,應該避免什麼。將這些連接到 "Positive prompt" 和 "Negative prompt" 插槽,以便與創作方向的文本部分同步。

選擇 ControlNet 模型:您需要將此輸入鏈接到 "Load ControlNet Model" 節點的輸出。這是您根據目標特徵或風格決定使用 ControlNet 或 T2IAdaptor 模型的地方。雖然我們專注於 ControlNet 模型,但提及一些受歡迎的 T2IAdaptors 也值得一提,以便全面了解。

預處理您的圖像:將您的圖像連接到 "ControlNet Preprocessor" 節點,這對於確保您的圖像能夠適應 ControlNet 至關重要。必須使預處理器與您的 ControlNet 模型匹配。這一步調整您的原始圖像以完美適應模型的需求——調整大小、重新上色或應用必要的濾鏡——為 ControlNet 的使用做好準備。

3.4.3. 理解 "Apply ControlNet" 節點的輸出

處理後,"Apply ControlNet" 節點為您提供兩個輸出,反映了 ControlNet 與您的創作輸入之間的精妙互動:正向和負向條件設定。這些輸出引導 ComfyUI 中的擴散模型,接下來您要做出選擇:使用 KSampler 精煉圖像,或深入堆疊更多 ControlNets 以追求無與倫比的細節和定制化。

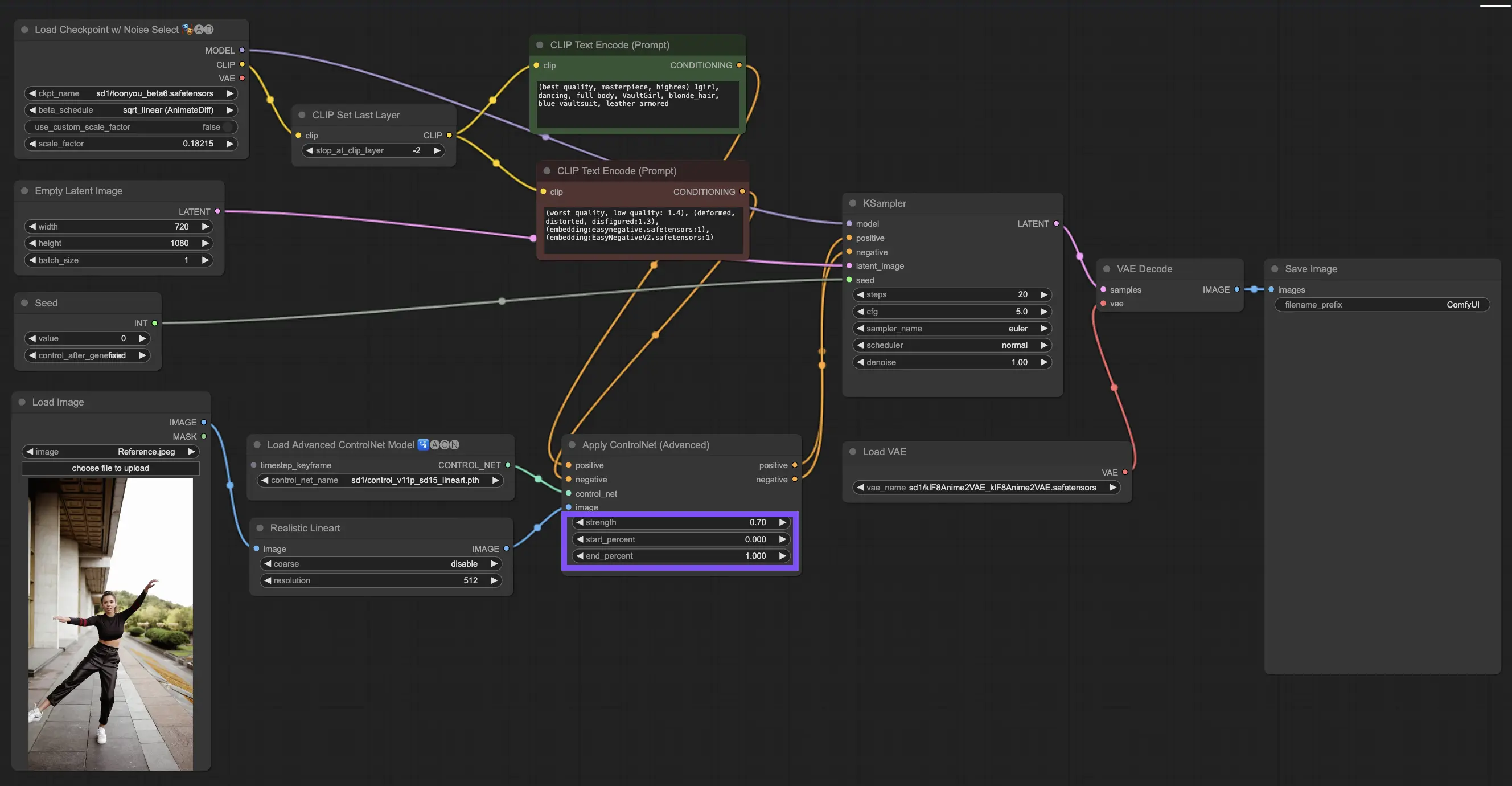

3.4.4. 調整 "Apply ControlNet" 以獲得最佳結果

確定強度:此設置控制 ControlNet 在最終圖像中影響力的大小。完全的 1.0 意味著 ControlNet 的輸入掌握了主導權,而將其調低到 0.0 則讓模型在沒有 ControlNet 影響的情況下運行。

調整開始百分比:這告訴您 ControlNet 在擴散過程中何時開始發揮作用。例如,設置為 20% 表示從五分之一的過程開始,ControlNet 開始發揮作用。

設置結束百分比:這是開始百分比的對應面,標誌著 ControlNet 退出時的點。如果您將其設置為 80%,ControlNet 的影響會在圖像接近最終階段時逐漸消失,最後一段不受 ControlNet 的影響。

3.5. ControlNet 模型指南:Openpose、Depth、SoftEdge、Canny、Lineart、Tile

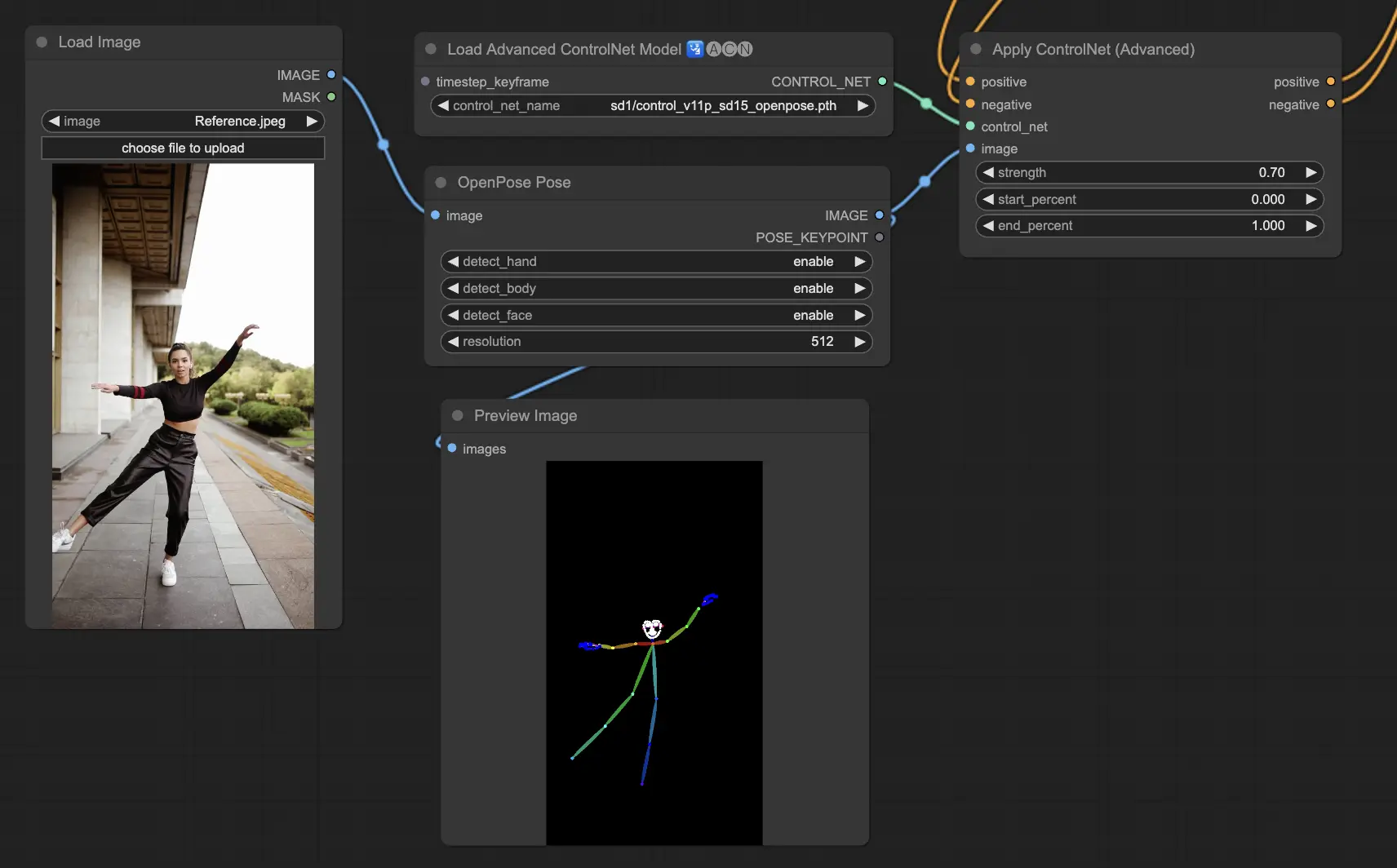

3.5.1. ControlNet 模型:Openpose

- Openpose(也稱為 Openpose body):此模型是 ControlNet 的基石,用於識別人體的關鍵點,例如眼睛、鼻子、頸部、肩膀、肘部、手腕、膝蓋和腳踝。它非常適合重現簡單的人體姿勢。

- Openpose_face:此版本的 Openpose 更進一步,檢測面部關鍵點,允許對面部表情和面部方向進行細緻分析。如果您的項目以面部表情為中心,這個模型至關重要。

- Openpose_hand:此增強版 Openpose 模型專注於手和手指動作的細節,這對於詳細理解手勢和姿勢至關重要。它擴展了 Openpose 在 ControlNet 中的功能範圍。

- Openpose_faceonly:專為面部細節分析而設計,此模型忽略身體關鍵點,專注於面部表情和方向。當面部特徵才是重點時,這是要選擇的模型。

- Openpose_full:此一體化模型整合了 Openpose、Openpose_face 和 Openpose_hand 的功能,用於完整的身體、面部和手部關鍵點檢測,是 ControlNet 中全面分析人體姿勢的首選。

- DW_Openpose_full:在 Openpose_full 的基礎上,此模型進一步增強了姿勢檢測的細節和準確性。它是 ControlNet 套件中最先進的版本。

預處理器選項包括:Openpose 或 DWpose

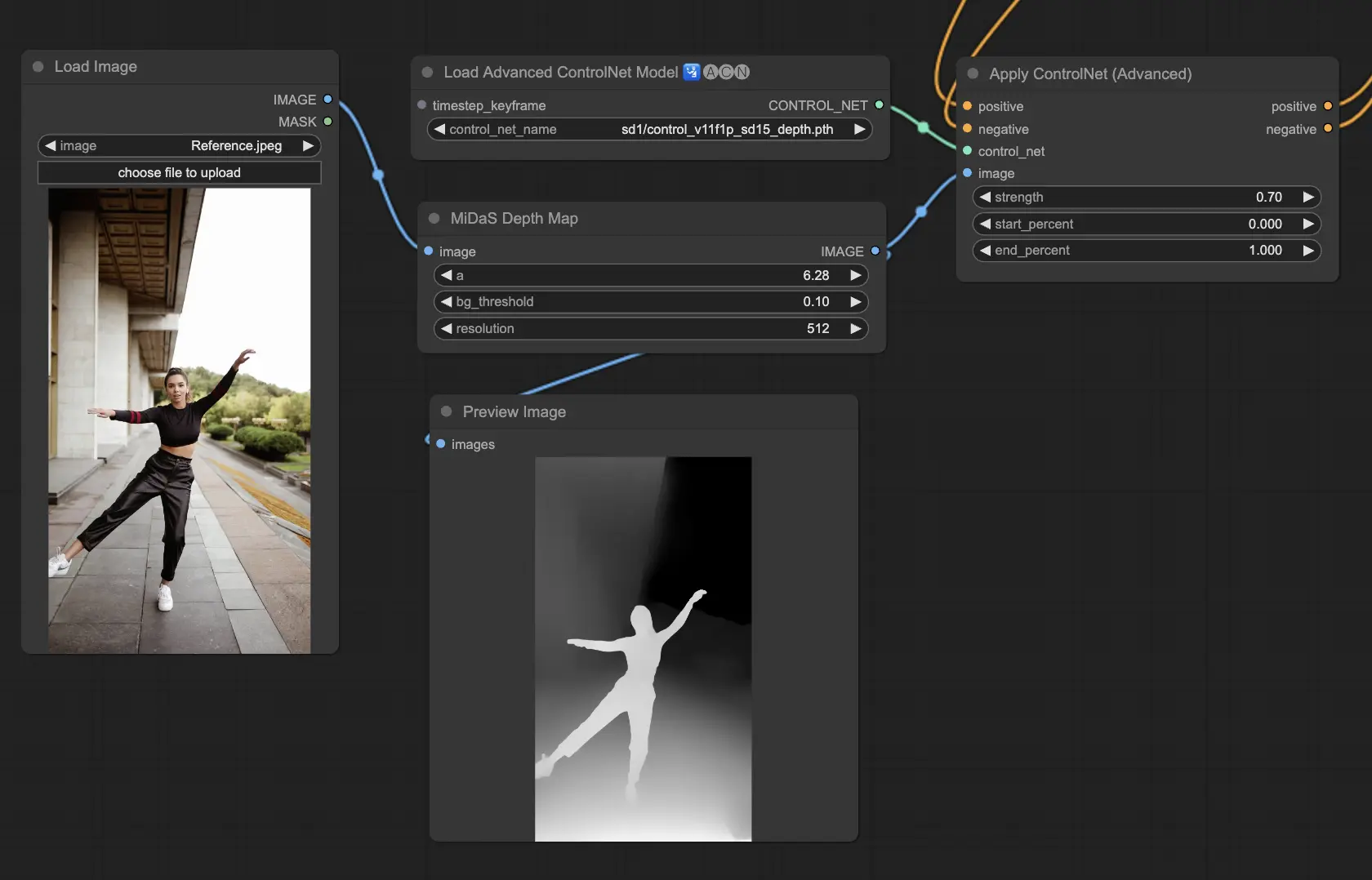

3.5.2. ControlNet 模型:Depth

深度模型使用 2D 圖像推斷深度,並將其表示為灰度圖。每個模型在細節或背景專注方面都有其優勢:

- Depth Midas:深度估計的平衡方法,Depth Midas 提供了細節和背景描繪的中間立場。

- Depth Leres:強調細節,同時仍然更突出地捕捉背景元素。

- Depth Leres++:在深度信息的細節方面推進了極限,特別適用於複雜場景。

- Zoe:在 Midas 和 Leres 模型的細節水平之間找到平衡。

- Depth Anything:改進的模型,適用於各種場景的多用途深度估計。

- Depth Hand Refiner:專門微調深度圖中的手部細節,對於需要精確手部位置的場景非常寶貴。

考慮的預處理器:Depth_Midas、Depth_Leres、Depth_Zoe、Depth_Anything、MeshGraphormer_Hand_Refiner。此模型在穩健性和與渲染引擎實際深度圖的兼容性方面表現出色。

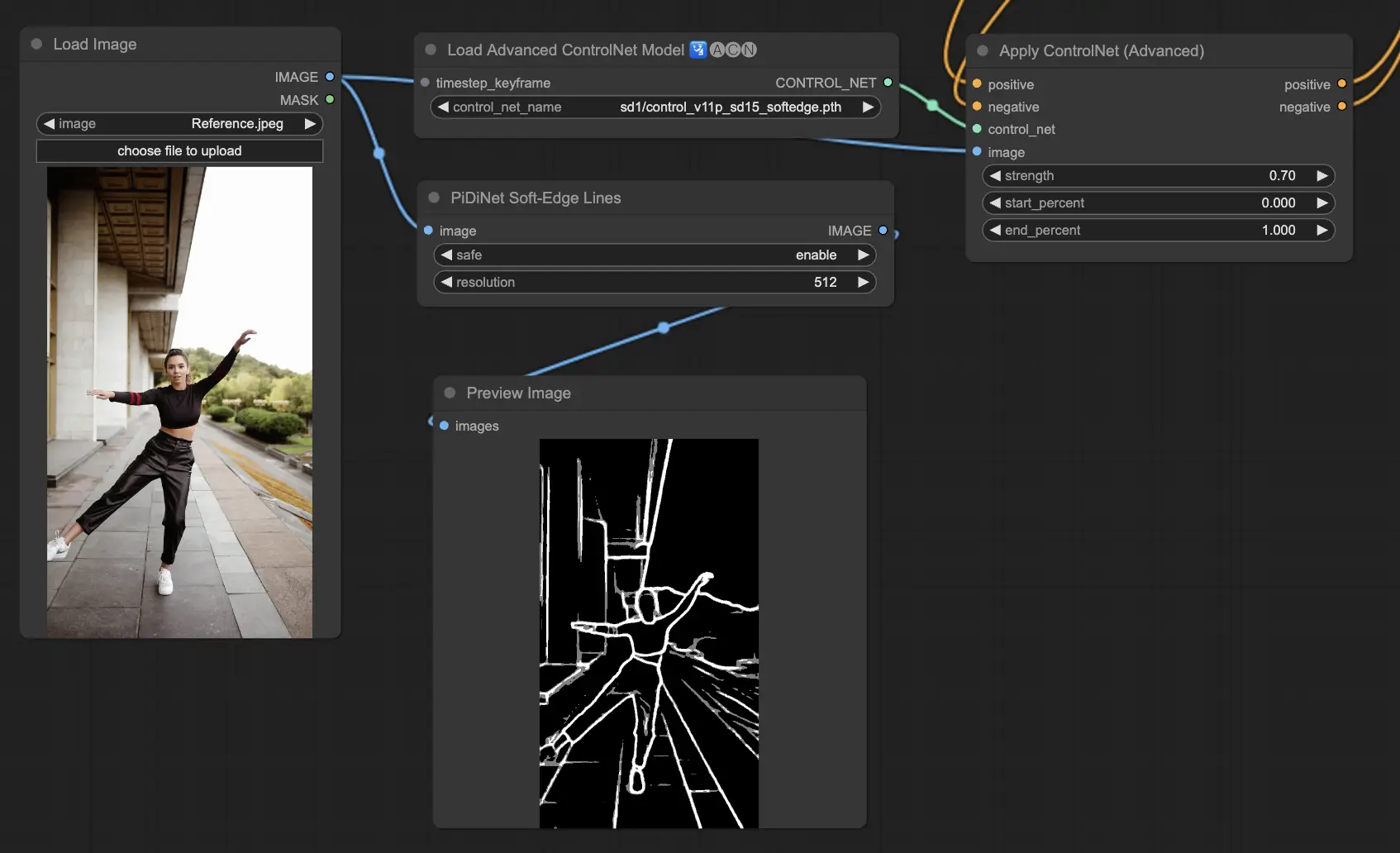

3.5.3. ControlNet 模型:SoftEdge

ControlNet Soft Edge 被設計用來生成邊緣更柔和的圖像,在保持自然外觀的同時增強細節。它利用尖端的神經網絡進行精細的圖像操控,提供廣泛的創意控制和完美的整合。

在穩健性方面:SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

為了獲得最高質量的結果:SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

作為一般建議,SoftEdge_PIDI 是首選選項,因為它通常能夠提供出色的結果。

預處理器包括:SoftEdge_PIDI、SoftEdge_PIDI_safe、SoftEdge_HED、SoftEdge_HED_safe。

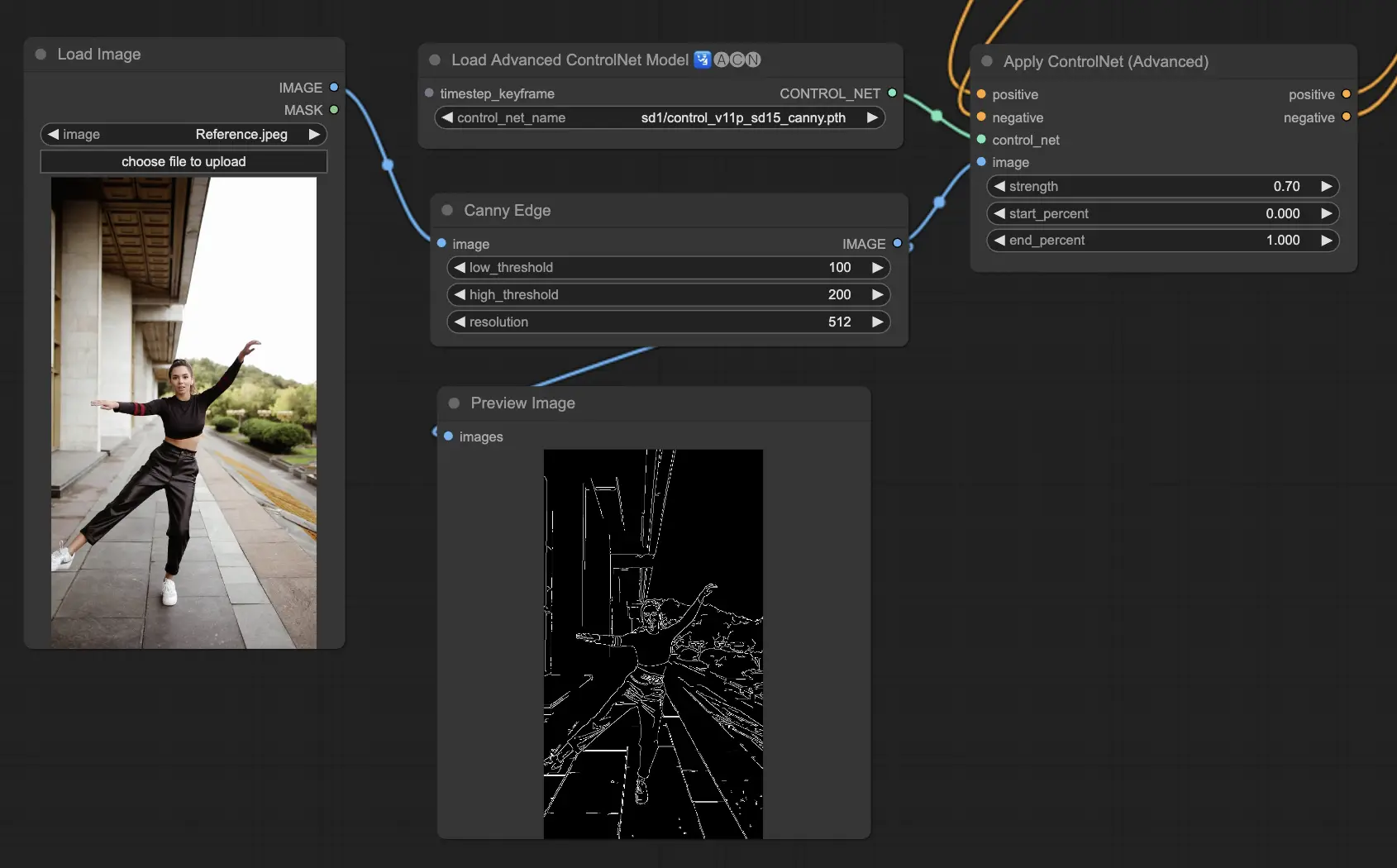

3.5.4. ControlNet 模型:Canny

Canny 模型實施了 Canny 邊緣檢測,以突出圖像中的廣泛邊緣範圍。此模型非常適合在簡化圖像整體外觀的同時保持結構元素的完整性,有助於創造風格化藝術或為進一步操作準備圖像。

可用的預處理器:Canny

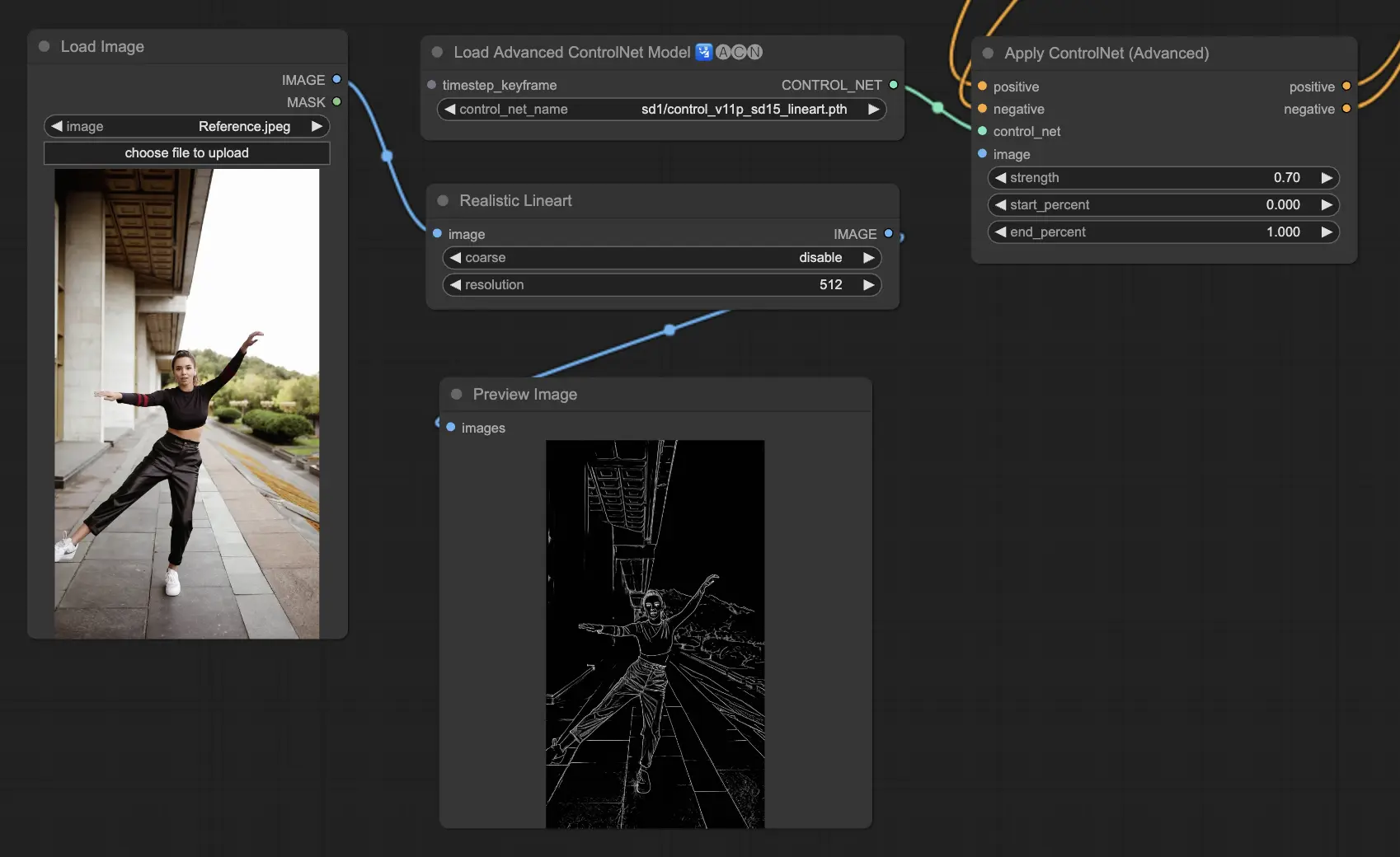

3.5.5. ControlNet 模型:Lineart

Lineart 模型是將圖像轉化為風格化線條畫的工具,適合各種藝術應用:

- Lineart:將圖像轉化為線條畫的標準選擇,為不同的藝術或創意活動提供了多功能的起點。

- Lineart anime:專為創建乾淨、精確的動漫風格線條畫而設計,適合旨在達到動漫風格的項目。

- Lineart realistic:旨在捕捉線條畫中的更逼真的表現,為需要現實主義的項目提供更多細節。

- Lineart coarse:強調更粗獷、更顯著的線條,具有強烈的視覺衝擊力,適合大膽的圖形表達。

可用的預處理器可以產生詳細或更顯著的線條畫(Lineart 和 Lineart_Coarse)。

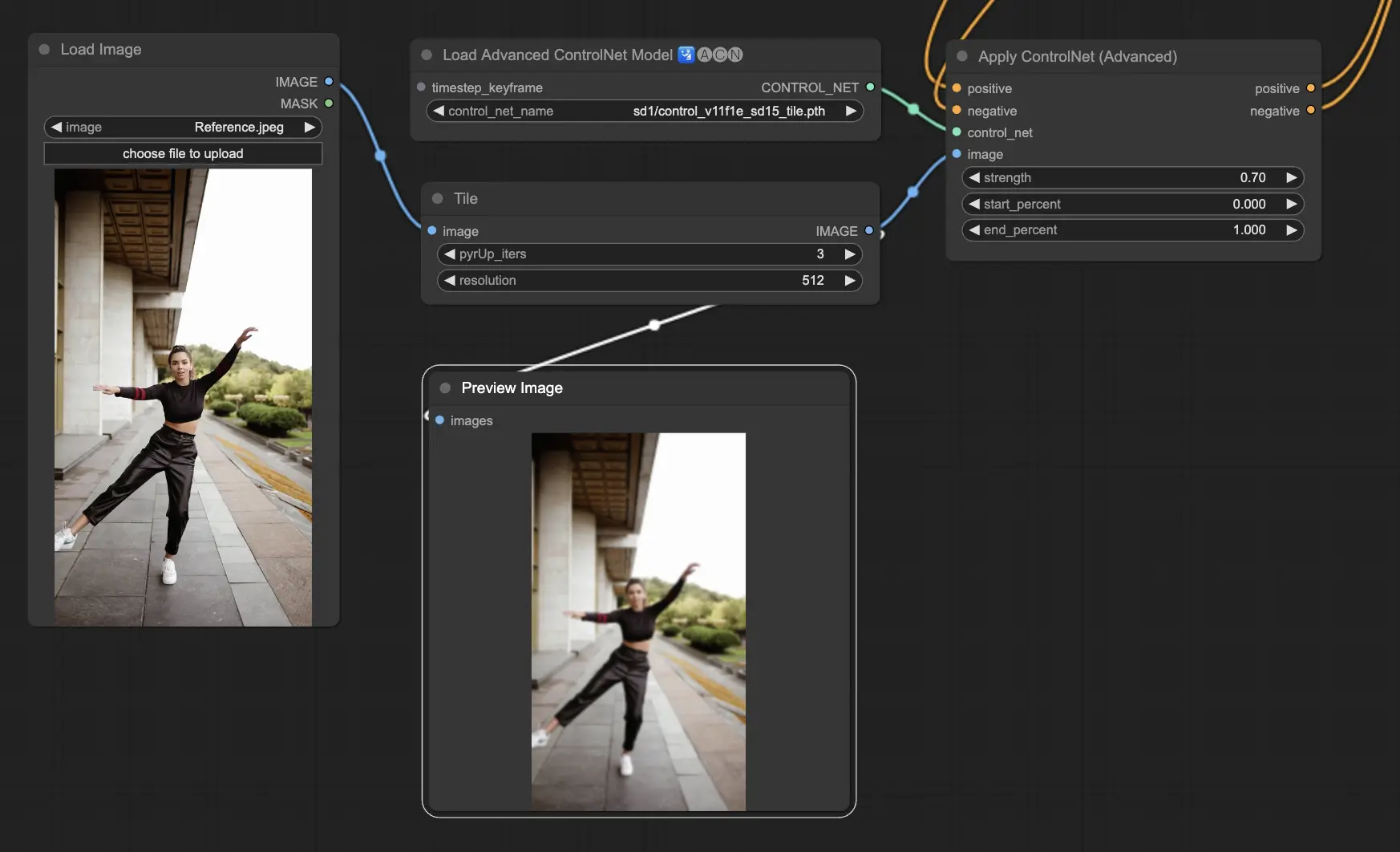

3.5.6. ControlNet 模型:Tile

Tile Resample 模型擅長突出圖像中的細節。它特別有效,當與升級器搭配使用時,可以增強圖像的分辨率和細節,通常用於銳化和豐富圖像的紋理和元素。

推薦的預處理器:Tile

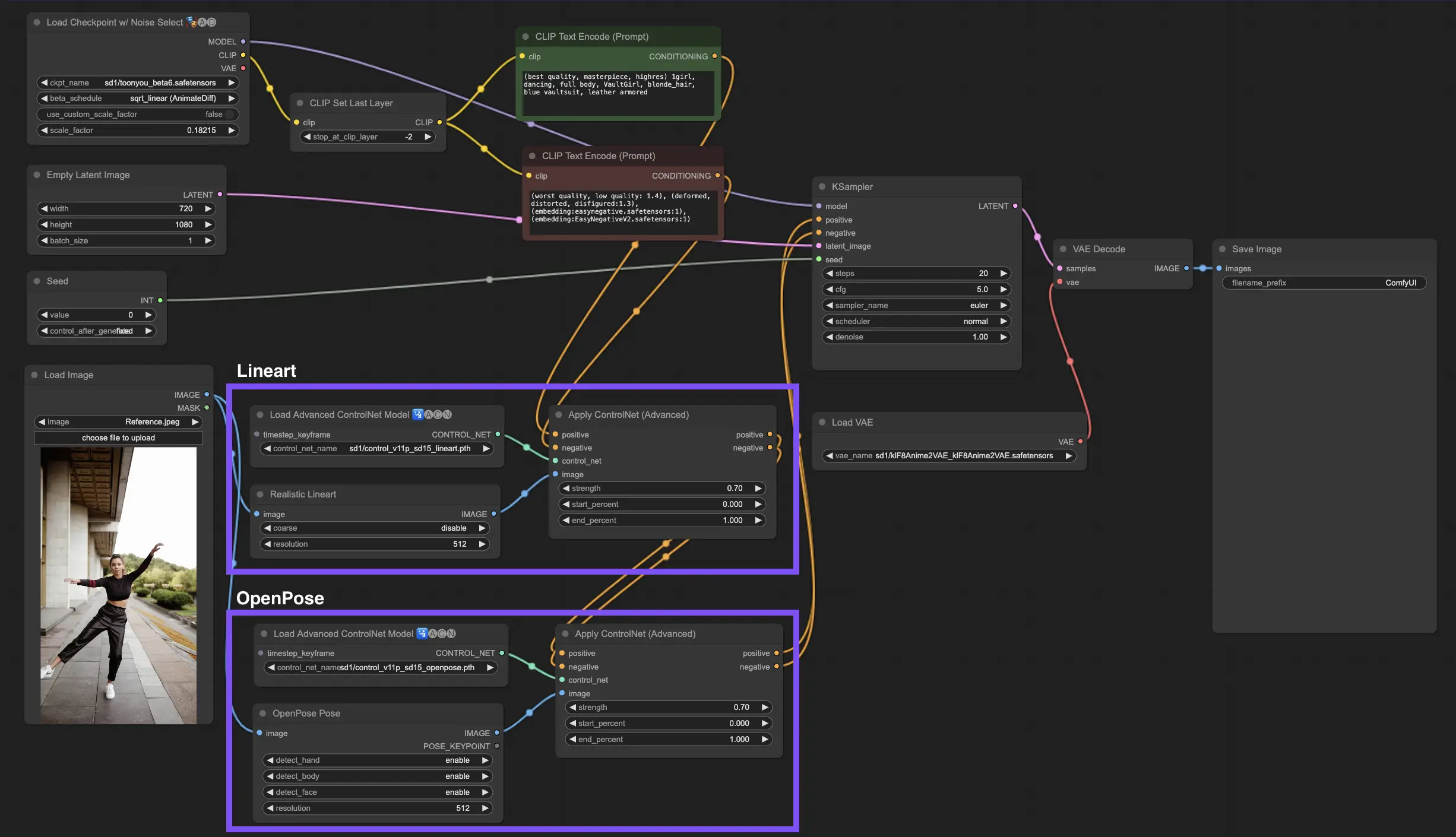

3.6. 使用多個 ControlNet 的指南

合併多個 ControlNets 或 T2I-Adapters 可以在圖像生成過程中順序應用不同的條件類型。例如,您可以結合 Lineart 和 OpenPose ControlNets 以增強細節。

Lineart 用於物體形狀:首先整合 Lineart ControlNet 以為圖像中的物體或元素增添深度和細節。此過程涉及為您希望包含的物體準備線條畫或 canny 圖。

OpenPose 用於姿勢控制:在線條畫細節之後,利用 OpenPose ControlNet 來決定圖像中人物的姿勢。您需要生成或獲得捕捉所需姿勢的 OpenPose 圖。

順序應用:為了有效地結合這些效果,將 Lineart ControlNet 的輸出鏈接到 OpenPose ControlNet。此方法確保在生成過程中,同時引導圖像中主體的姿勢和物體的形狀,創造出與所有輸入規範和諧一致的結果。

4. IPAdapter 概覽

請查看 如何在 ComfyUI 中使用 IPAdapter 的詳細信息。