1. 什么是 ComfyUI Uni3C 工作流程?

Uni3C 工作流程将先进的 Uni3C(精确统一 3D 增强摄像机和人物运动控制)模型集成到 ComfyUI 环境中。由 DAMO Academy (Alibaba Group) 开发,Uni3C 通过在单个 3D 增强框架中统一摄像机轨迹控制和人物运动控制,解决了可控视频生成的根本挑战。

基于 FLUX 扩散变换器架构并由 Wan2.1 基础模型提供支持,Uni3C 引入了 PCDController——一个即插即用的控制模块,利用从单目深度估计中得出的未投影点云。这种方法在保持大规模视频扩散模型生成能力的同时,实现了 Uni3C 内的精确摄像机控制。Uni3C 系统采用 SMPL-X 角色模型和全球 3D 世界指导,实现了环境场景和人物角色间空间一致的视频生成。

2. Uni3C 的优势:

- 统一的 3D 增强框架: Uni3C 在统一的 3D 世界空间中同时处理摄像机轨迹和人物运动。

- PCDController 架构: 具有轻量级的 0.95B 参数控制器,Uni3C 利用单目深度估计的未投影点云,而不影响包含 14B 参数的基础模型。

- SMPL-X 集成: Uni3C 提供先进的 3D 人体模型支持。

- 几何先验利用: 基于点云的 3D 几何理解为 Uni3C 提供了稳健的摄像机控制能力。

- 全球 3D 世界指导: Uni3C 确保环境点云和 SMPL-X 角色之间的刚性变换对齐,实现空间一致的视频生成。

3. 如何使用 Uni3C 工作流程

Uni3C 通过 视频参考提取 进行操作,分析参考视频以理解摄像机运动和人物动作,然后应用这些模式从输入图像生成新视频。这种方法使得 Uni3C 能够在无需手动参数调整的情况下实现精确控制。

3.1 方法 1:视频参考的摄像机控制

最适合:

从参考视频中提取摄像机运动并将其应用于新场景,使用 Uni3C。

设置过程:

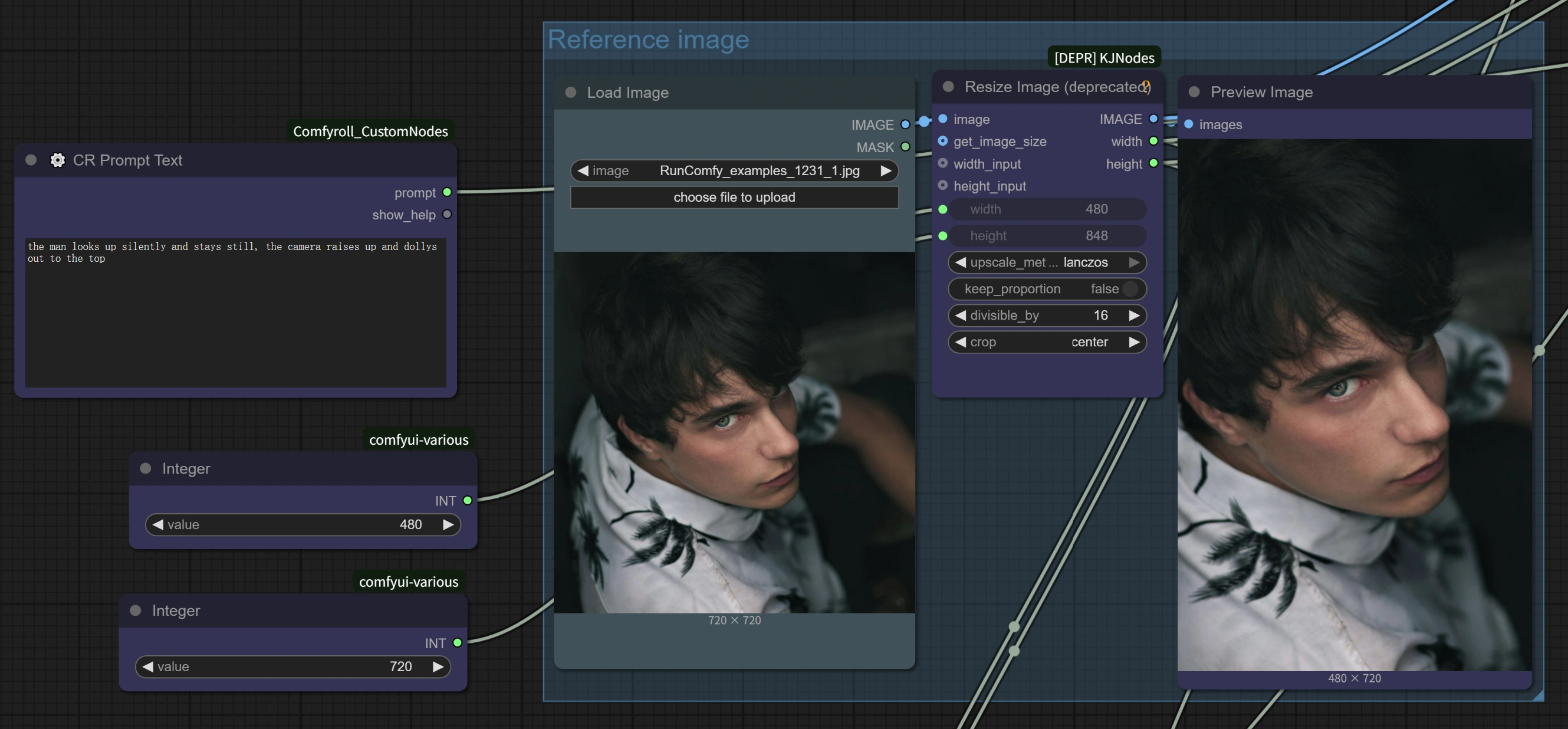

- 加载参考视频: 在

Load Video (Upload)节点上传任何具有有趣摄像机运动的视频- 好的示例: 摄像机放大主体的视频、带有自然头部运动的行走画面、电影般的平移镜头、环绕镜头

- 关键点: 任何具有清晰摄像机运动的视频都可以使用 - 从手机录制到专业电影摄影,均可使用 Uni3C。

- 加载目标图像: 在

Load Image节点上传您的基础图像(适用于任何风格:真实、动漫、艺术作品、AI 生成) - 编写您的提示: 在 Uni3C 的文本提示区域描述您想要的场景

- 配置设置: Uni3C 工作流程 包含优化参数以实现4倍速度提升

- 生成: 运行工作流程以将参考视频的摄像机运动转移到您的场景中,使用 Uni3C。

高级技巧:

- 动作方向匹配: 当参考视频的运动方向与您的预期场景构图一致时,效果最佳,适用于 Uni3C。

- 提示协调: 编写与摄像机运动风格相辅相成的提示,以增强与 Uni3C 的一致性。

- 参考质量: 选择具有稳定、清晰摄像机运动的参考视频,以获得 Uni3C 的最佳效果。

3.2 方法 2:人物动作转移

最适合:

使用 Uni3C 将参考视频中的人物动作转移到不同角色。

设置过程:

- 含有人物动作的参考视频: 上传包含您要转移的人物动作的视频

- 目标角色图像: 加载您想要动画化的角色图像

- 通过提示进行动作控制:

- 保留原始动作: 使用 "a woman walking" 这样的通用描述,以 Uni3C 保持参考动作。

- 修改动作: 具体说明以改变动作:"a woman combing her hair" 将改变手部动作,同时保持整体动作流畅,使用 Uni3C。

关键优势:

- 无需骨架: 与传统动作捕捉不同,Uni3C 无需复杂的绑定即可理解人物运动。

- 细节保留: Uni3C 在动作转移过程中保持配饰、发型和服装细节。

- 同时控制: 摄像机运动和人物动作同时从同一参考视频转移,使用 Uni3C。

性能优化架构: Uni3C 工作流程 实施了多种优化策略,包括将 PCDController 的隐藏尺寸从 5120 减少到 1024,零初始化的线性投影层,以及仅在基础模型的前 20 层注入摄像机控制特性。通过减少的采样步骤(10 vs 20+)和调整的 CFG 引导比例,提供了高达 4 倍的处理速度提升,同时保持 Uni3C 的生成质量。

3.3 优化性能设置

4倍速度提升配置: 基于 Uni3C 的内置优化,以下设置显著提高处理速度:

WanVideo 采样器节点设置:

Steps: 10(从默认的 20+ 减少)CFG: 1.0-1.5(优化速度与质量的平衡)Shift: 5.0-7.0(作者推荐 7 以获得最佳效果,5 以更快的处理速度使用 Uni3C)Scheduler: UniPC(优化的调度器用于 Uni3C)

关键性能特性:

- AnimateDiff 集成: Uni3C 利用最初为文本到视频设计的 AnimateDiff 优化,但在图像到视频生成中同样有效。

- 智能参数减少: 由于图像到视频从现有视觉内容开始,与文本到视频生成相比,所需的去噪步骤较少,适用于 Uni3C。

- 优化处理: Uni3C 使 70 帧视频在 ~4-5 分钟内完成(与原始设置相比约 27 分钟)。

质量与速度选项:

- 最大速度:Steps=10, CFG=1.0, Shift=5 → ~4 分钟 70 帧,使用 Uni3C

- 平衡:Steps=10, CFG=1.5, Shift=7 → ~5 分钟 70 帧,使用 Uni3C

- 更高质量:Steps=15, CFG=2.0, Shift=7 → ~8-10 分钟 70 帧,使用 Uni3C

3.4 工作流程组件理解

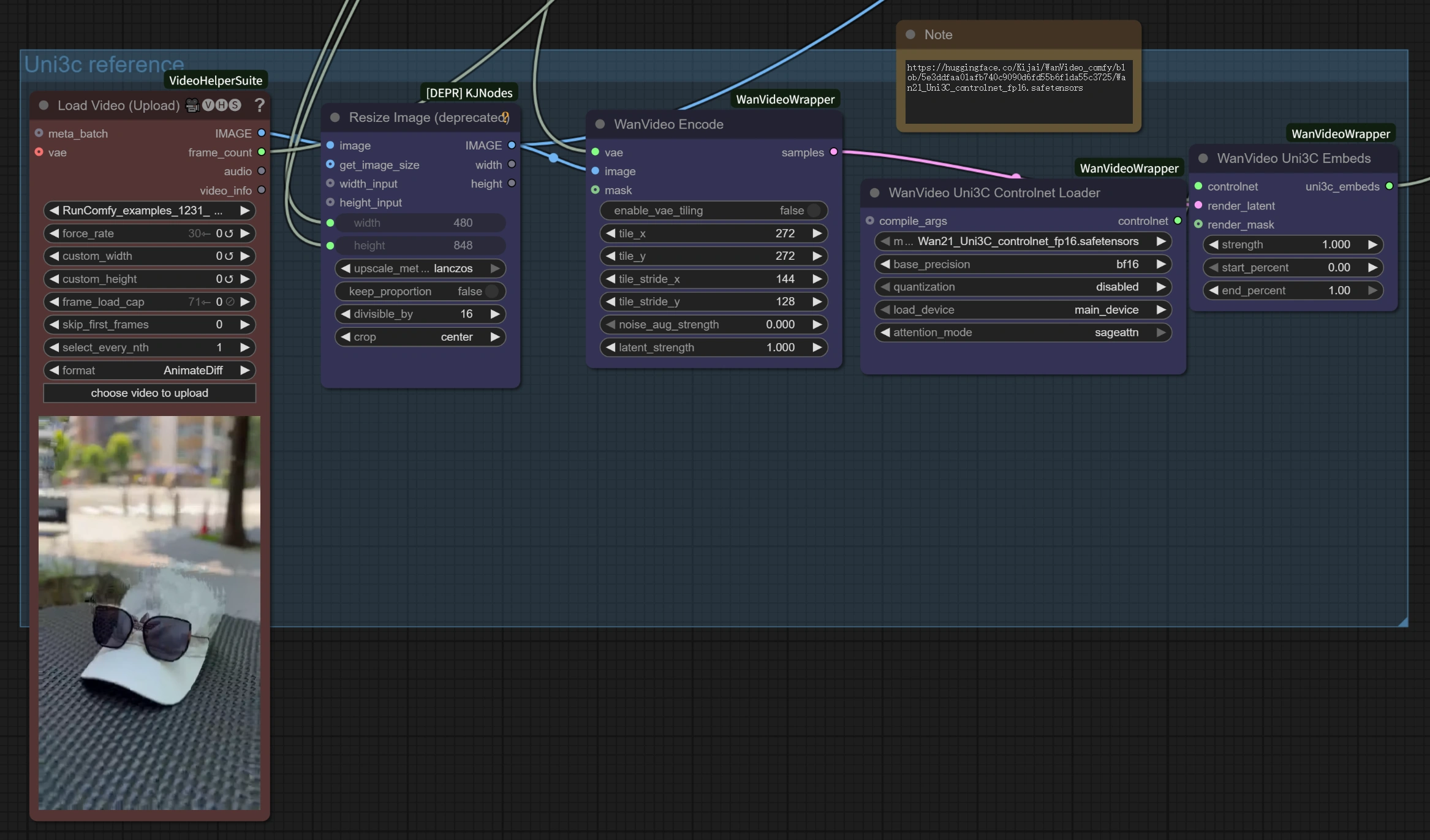

参考视频处理部分:

Load Video (Upload): 接受 MP4、AVI 和其他标准视频格式,供 Uni3C 用于动作参考。WanVideo Encode: 处理参考视频以提取摄像机轨迹和动作模式,供 Uni3C 使用。Uni3C ControlNet Loader: 加载专门的 Uni3C 控制模型以理解动作。

图像到视频生成部分:

Load Image: 您的目标图像,将由 Uni3C 使用参考动作进行动画化。WanVideo Image/ToVideo Encode: 将您的静态图像转换为适合 Uni3C 视频生成的格式。WanVideo Sampler: 核心生成引擎,具有 Uni3C 的 4 倍速度提升优化设置。

输出处理:

WanVideo Decode: 将生成的潜在视频从 Uni3C 转换回可查看格式。Video Combine: 将最终视频文件与适当的帧速率和编码从 Uni3C 组装。

4. 高级技巧和最佳实践

为 Uni3C 选择参考材料

- 对于动作转移: 选择具有清晰、可见动作且人物大部分在画面内的视频,供 Uni3C 使用。

- 对于摄像机控制: 任何具有有趣视角或期望摄像机运动的视频,适用于 Uni3C。

- 最佳效果: 当参考运动方向与您的预期输出方向一致时,使用 Uni3C。

Uni3C 提示工程最佳实践

- "不干扰" 原则: 为纯动作转移而不改变角色,使用简单、通用的提示,适用于 Uni3C。

- 具体动作变化: 当您想修改角色的动作时,请详细说明,适用于 Uni3C。

- 角色一致性: 使用 Uni3C 聚焦提示以保持角色外观。

Uni3C 的质量优化

- 动作一致性: 避免参考视频中的突然变化,以获得更平滑的 Uni3C 结果。

- 帧稳定性: 确保参考材料具有一致的照明和构图,适用于 Uni3C。

5. 鸣谢

此工作流程由 Uni3C 提供支持,由 DAMO Academy (Alibaba Group)、Fudan University 和 Hupan Lab 开发。ComfyUI 集成基于 kijai 的出色工作(ComfyUI-WanVideoWrapper),并进行了额外的优化和工作流程设计,使这一强大的 Uni3C 技术在全球创作者中更易于访问。