RunComfyのクラウドは、Reallusion AI RenderのためのFLUX.1-dev ControlNetに限定されません。チェックポイント、ControlNets、LoRAs、VAEs、および関連ノードを交換して、以下に示す追加のReallusionワークフローとモデルを実行できます。

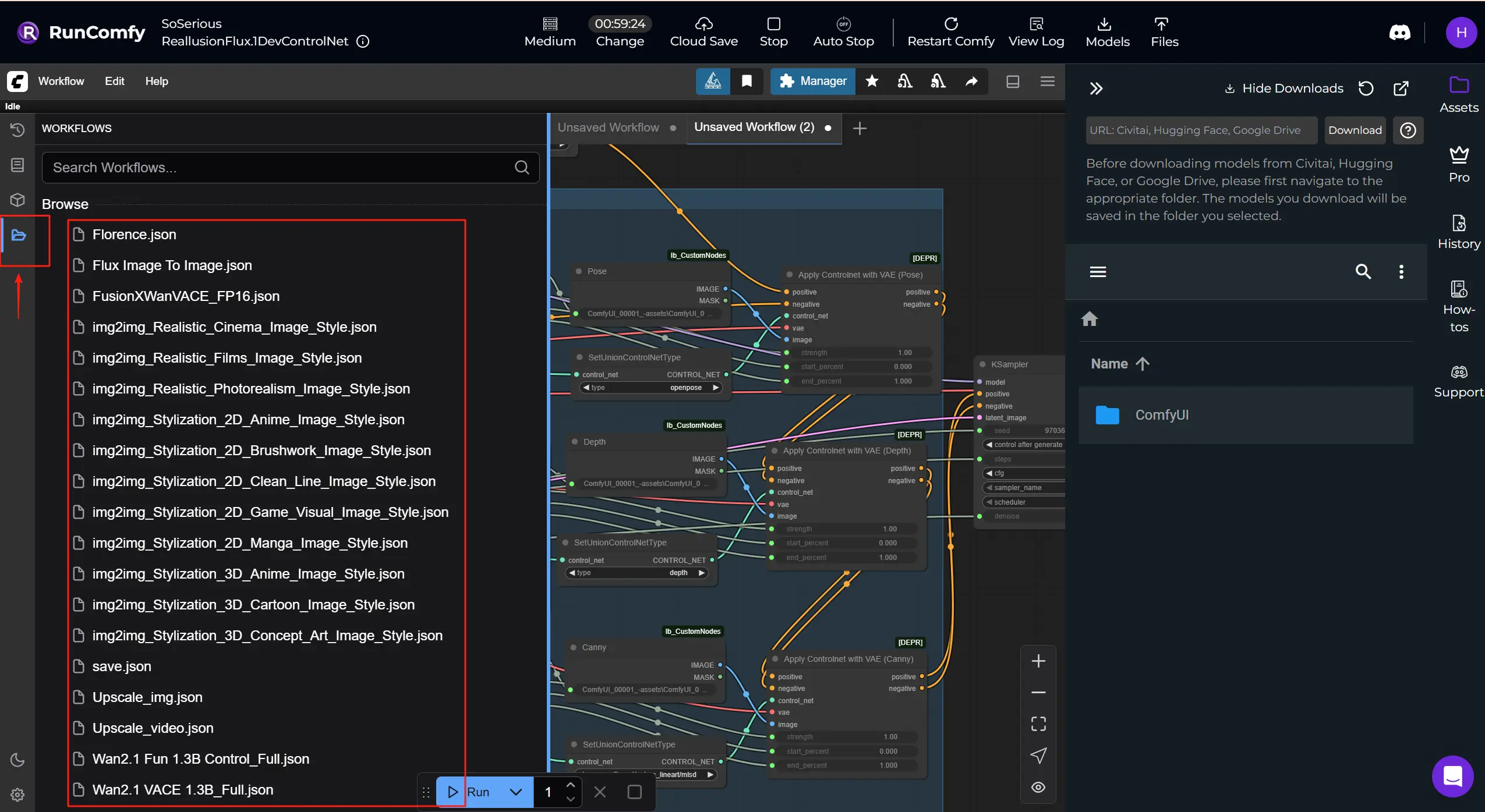

さらに多くのReallusion ComfyUIワークフローを入手: RunComfyでダウンロードして実行できるさらに多くのワークフローテンプレートを入手してください。「Workflows」ボタンをクリックして、もっと試してみてください。

Reallusionは、リアルタイムの2D/3Dキャラクター作成とアニメーションソフトウェアの開発者であり、iCloneとCharacter Creatorで最もよく知られ、映画/テレビ、ゲーム、アーキビジョン、デジタルツイン、AIシミュレーションで使用されています。

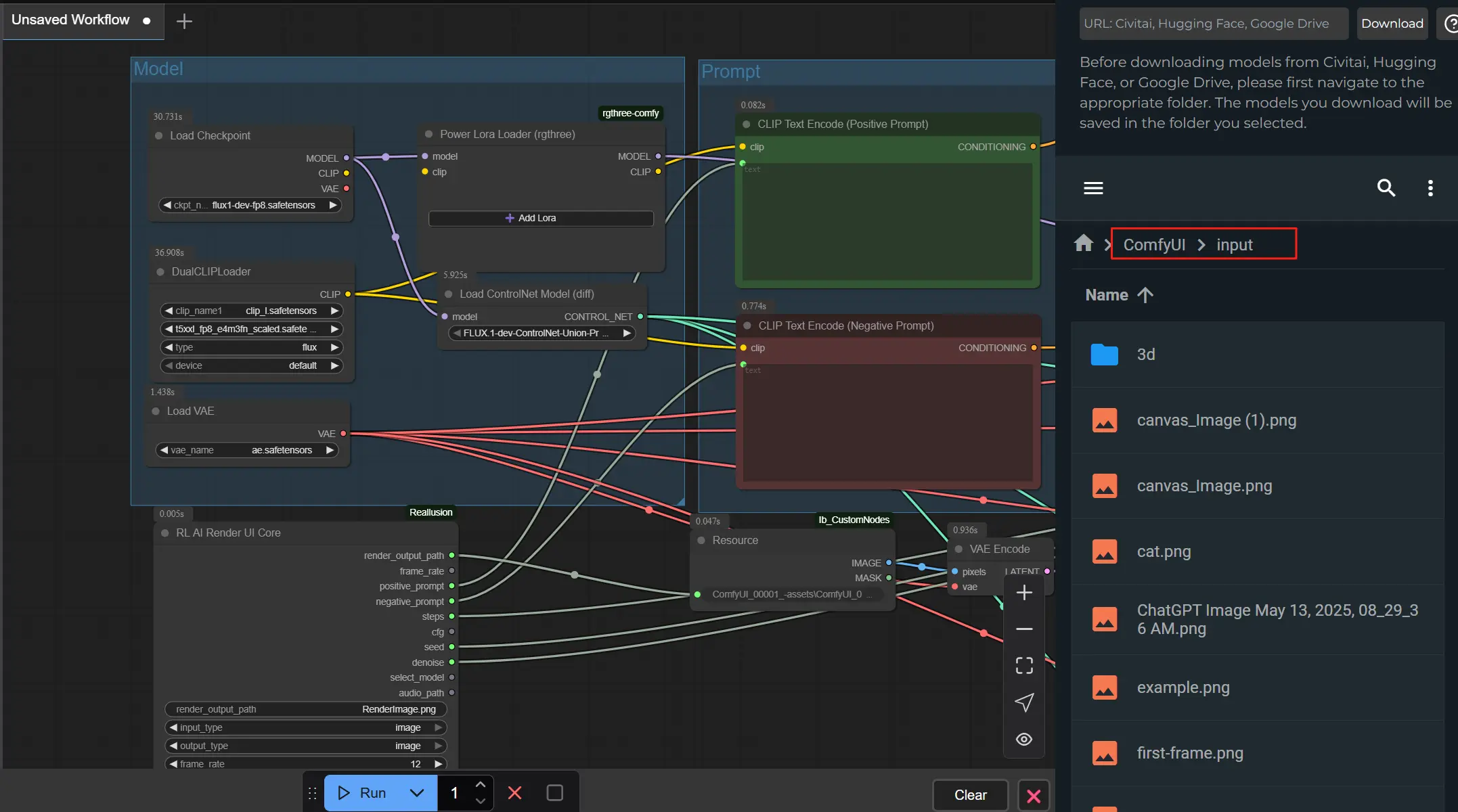

Reallusion AI Render は、3DアニメーションソフトウェアとAI駆動のコンテンツ生成ワークフローの間のシームレスな橋渡しです。 これは、iCloneまたはCharacter Creatorから直接レイアウト、ポーズ、カメラ、照明データを受け取り、そのコンテキストを使用してComfyUI内で豊かに詳細な画像やビデオを自動的に作成するAIレンダーアシスタントと考えてください。この統合は、Reallusionのリアルタイム3D作成ツールとComfyUIの柔軟なノードベースのAI処理アーキテクチャを組み合わせ、画像やビデオベースのストーリーテリングをアーティスト主導で、3Dデータによって厳密にガイドされるものにします。Reallusion AI Renderは、IPAdapterを介して深度マップ、法線マップ、エッジ検出(Canny)、3Dポーズデータ、スタイル画像などのマルチモーダル入力をサポートします。また、カスタムCore、ControlNet、Additional Image、Upscaleノードのおかげで、アニメーターや開発者は、ComfyUIを手動で操作することなく、プラグインの制御下で一貫したスタイライズされた高品質の出力をレンダリングできます。

構造化された指示を解釈し、それを内部パラメータプリセットと組み合わせることで、Reallusion AI Renderはプロンプトベースの生成を正確で再現可能なプロダクションプロセスに変換します。 これは、映画、ゲーム、商業ストーリーテリングで一貫したキャラクター、細かいスタイルコントロール、フレーム正確なAI支援シーケンスレンダリングを必要とするクリエーターに最適です。

直接プラグイン統合: Reallusion AI Renderは、専用プラグインを介してiCloneとCharacter Creatorとネイティブに連携し、制作ツールを離れることなくリアルタイムのフィードバックとコントロールを可能にします。

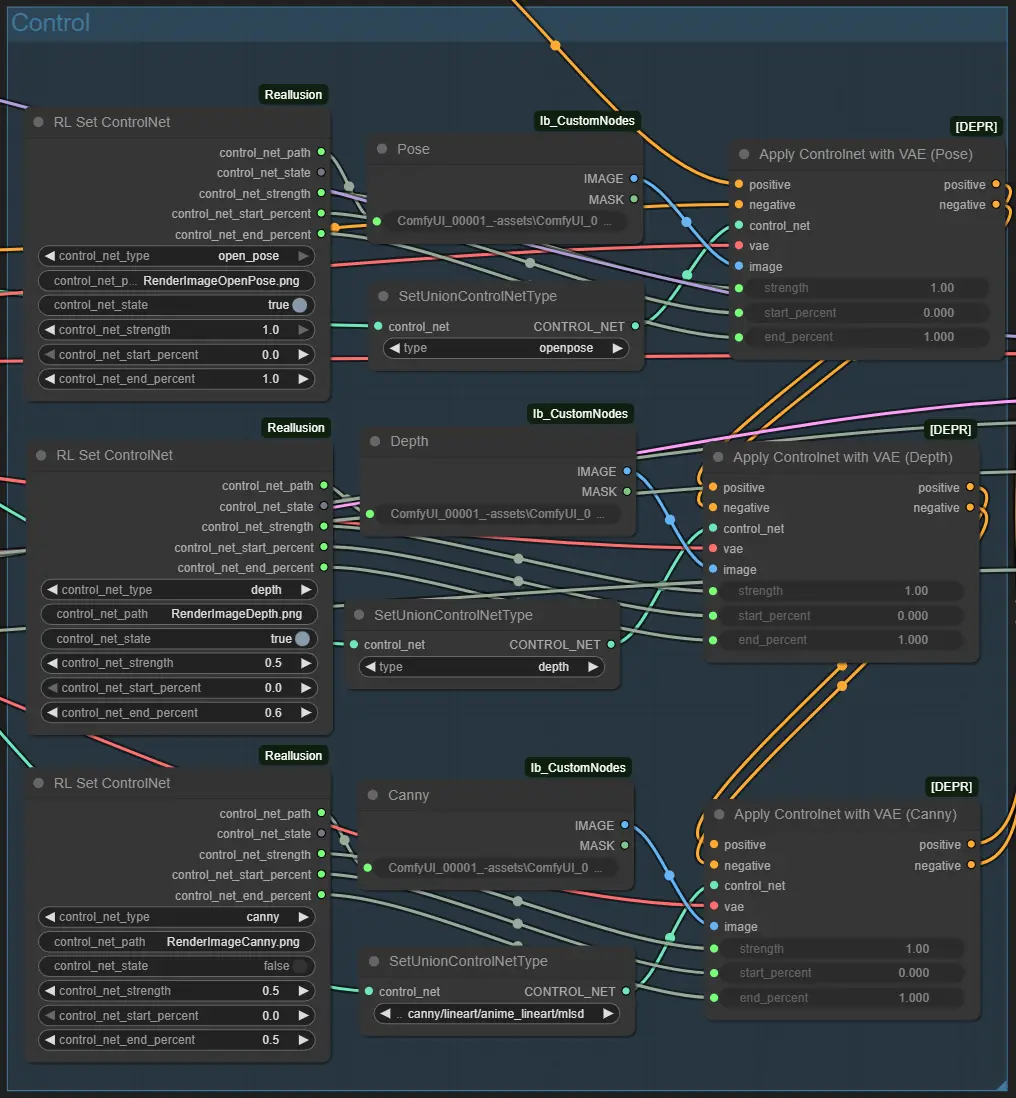

3Dガイド付きControlNet: Reallusion AI RenderのControlNetノードを使用して、3Dシーンから深さ、ポーズ、法線、エッジデータをComfyUIにシームレスにマッピングし、映画的な一貫性とショットレベルのコントロールを実現します。

マルチイメージスタイリングサポート: Reallusion AI Renderワークフローには、柔軟なスタイルブレンドとリファレンスベースの方向性をサポートするAdditional Imageノードが含まれており、ルックを再利用したり、IPアダプティブレンダリングを実行するのが簡単です。

スマートアップスケールワークフロー: 専用のUpscaleDataノードにより、クリエーターはReallusion AI Renderプラグイン内で出力解像度を定義でき、最終レンダーがプロジェクト仕様に一致するようにします。

フルワークフロー自動化: 一般的なComfyUIワークフローとは異なり、Reallusion AI Renderは自動化を目的として設計されており、モデル、サンプリングステップ、CFG、オーディオ同期などのパラメータがプログラム的に渡され、バッチレンダリングやカスタムプリセットに準備されています。

プロダクション対応のキャラクター一貫性: LoRAトレーニングとIP作成ツールと組み合わせることで、Reallusion AI Renderはビデオシーケンス全体で顔の一貫性と視覚的忠実度を保持し、AI駆動のストーリーテリングに最適です。

Reallusion AI Render基本ワークフロー

1.画像を準備する

AI Renderプラグインを使用してReallusion iCloneまたはCharacter Creatorから任意の画像をエクスポートします。画像がデフォルトのプラグインパス構造を使用して保存されていることを確認してください。これにより、すべてのガイダンス/コントロール画像(例:ポーズ、深度)が自動的に生成され、正しくリンクされます。

画像をComfyUI -> inputフォルダーにアップロードしてください。ファイル名がNodeで指定されたrender_output_pathと一致していることを確認してください。

2.プロンプトとスタイルを設定する

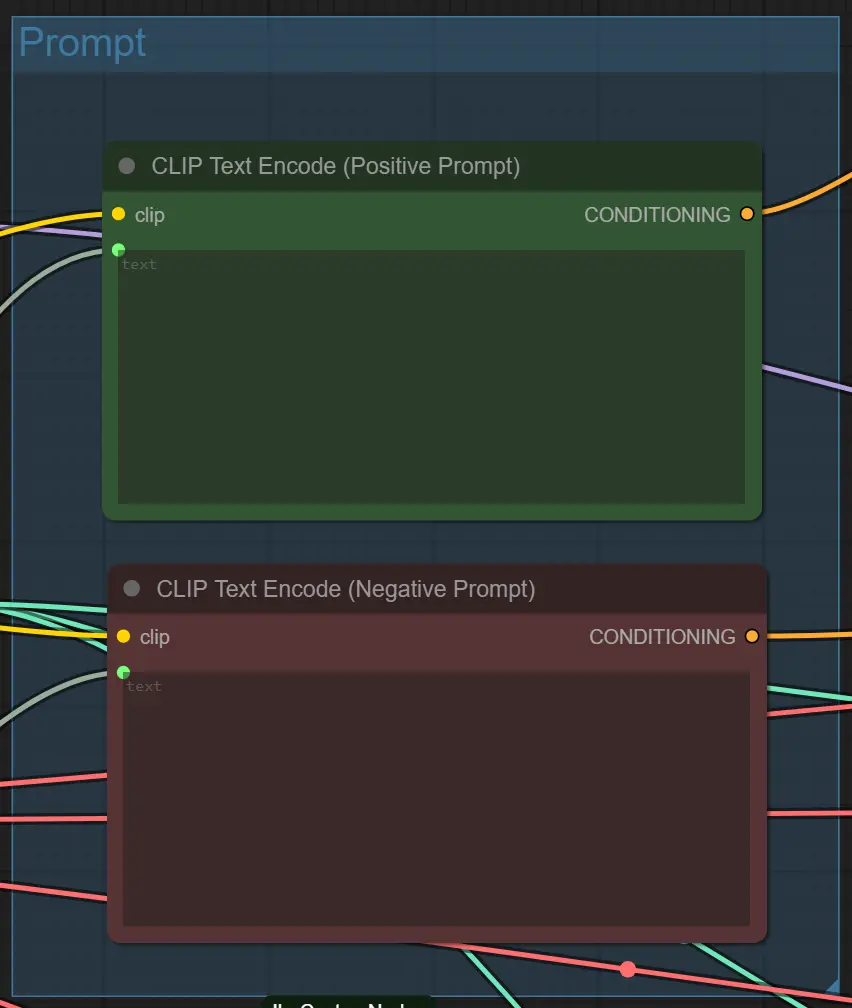

iCloneまたはCharacter Creator AI RenderプラグインUI内に、明確なポジティブプロンプト(望むもの)とネガティブプロンプト(避けたいもの)を書き込みます。このワークフローは、これらを使用して出力の外観と詳細をガイドします。

3.マシンを接続してAI Renderを使用する-⭐重要

まず、iCloneまたはCharacter Creator内でAI Renderプラグインを起動し、RunComfy URLからidをコピーしてAI RenderにComfyUI Cloudを接続します。接続されると、プラグインはComfyUIパイプラインからプレビューされた画像やビデオを自動的に送信します。

このセットアップにより、AI Renderがマシンとシームレスに通信し、リアルタイムで結果をプレビュー、調整、改善できるようになります。接続を安定させることで、ポーズ、深度、スタイルガイダンスがすべてのレンダリングで正確に保たれます。

👉 フルステップバイステップビデオガイドはこちらでご覧ください: YouTube Tutorial

ノードの基本設定

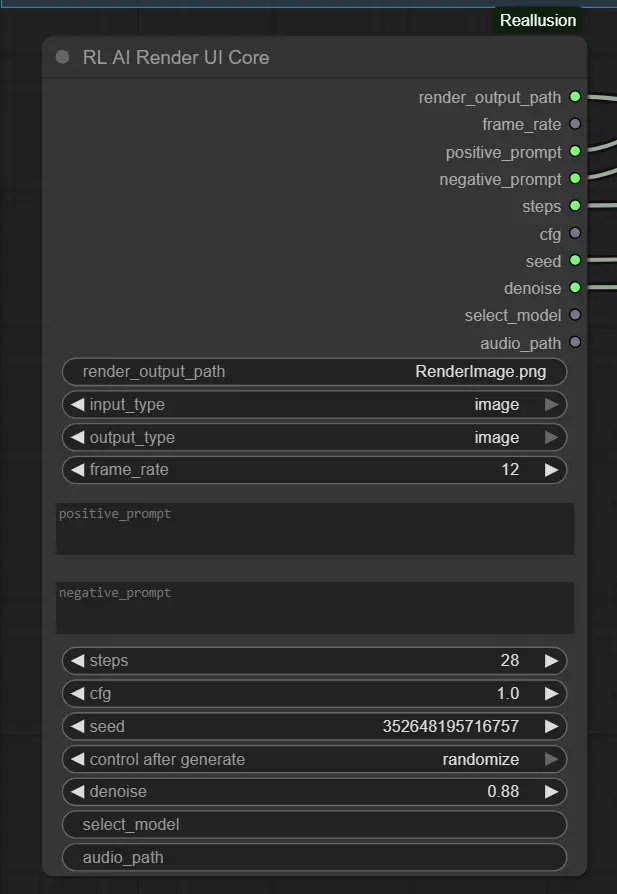

1.プロンプトと品質設定 – RL AI Render UI Core Node このノードは、AI Renderプラグインから主要なパラメータを収集します。

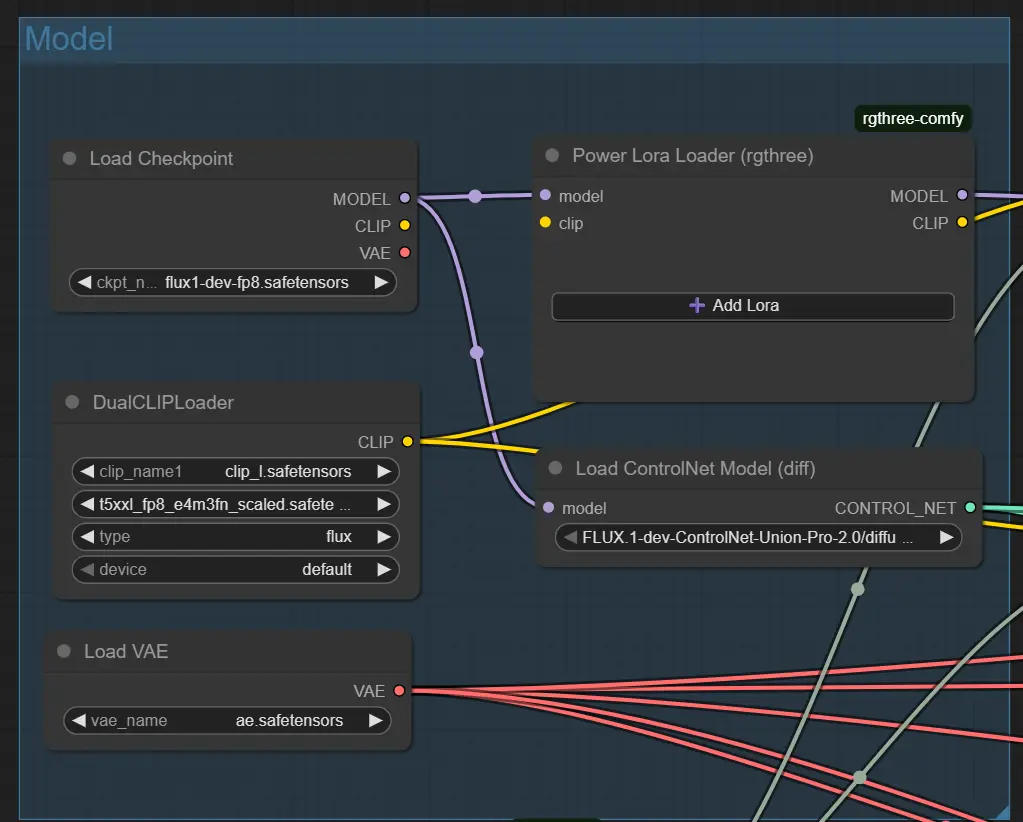

2.ベースモデル設定 – Load Checkpoint Node

これは選択したモデル(例:Flux 1 Dev ControlNet)をロードします。

ckpt_name: スタイルで期待されるモデルに一致する必要があります(デフォルト:flux1-dev-fp8.safetensors)。

IPAdapterまたはControlNetをサポートするモデルを使用すると、最良の結果が得られます。

3.構造ガイダンス – ControlNet Nodes (Pose, Depth, Canny) 各ControlNetノードは特定の入力ファイルを読み込みます(例:ポーズ画像);コントロールが有効な場合にのみアクティブです。

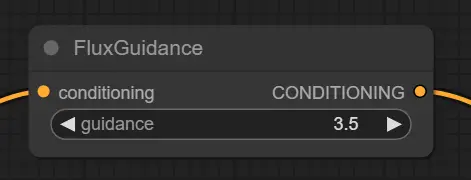

4.プロンプトコンディショニング – Flux Guidance Node プロンプトが画像生成にどのように影響するかを調整します。

5.テキストプロンプトエンコーディング – CLIP Text Encode Nodes プロンプトからベクトルガイダンスを生成します。

ノードの高度なヒント

プロンプトの明確さ

過度に複雑または曖昧なプロンプトを避けてください。cinematic lighting、anime、cyberpunk alleyのような直接的なスタイルを使用します。より制御された結果を得るために具体的にしてください。

デノイズと構造のバランス ControlNetが有効な場合(例:Depth + Pose)、0.88の高いデノイズは構造を乱す可能性があります。レイアウトを優先する場合は0.6–0.75を試してください。

ControlNetと入力を一致させる

一致するガイダンス画像が存在する場合にのみControlNetを有効にします(例:RenderImageDepth.png for Depth)。不一致はプロンプトの失敗や空の結果を引き起こす可能性があります。

このワークフローは、Kijaiによって開発されたFlux-FP8モデルと、Reallusionチームによって公式AIレンダリングワークフローガイドで概説されたパフォーマンス最適化技術を統合しています。モデル開発への貢献に対してKijaiに特別な感謝を送り、ComfyUIワークフローでAIレンダリング効率を高める貴重な洞察を共有してくれたReallusionに感謝します。

Reallusion AI Renderに関連する技術リソースとドキュメントを探索します。

RunComfyは最高の ComfyUI プラットフォームです。次のものを提供しています: ComfyUIオンライン 環境とサービス、および ComfyUIワークフロー 魅力的なビジュアルが特徴です。 RunComfyはまた提供します AI Playground, アーティストが最新のAIツールを活用して素晴らしいアートを作成できるようにする。