FLUX.1 Dev LoRA Inferenza: Allinea le anteprime di addestramento dell'AI Toolkit in ComfyUI

FLUX.1 Dev LoRA Inferenza: generazione a passi minimi allineata all'addestramento in ComfyUI FLUX.1 Dev LoRA Inferenza è un workflow pronto all'uso di RunComfy per applicare FLUX.1 Dev LoRA addestrati con AI Toolkit in ComfyUI con risultati che rimangono vicini alle tue anteprime di addestramento. È costruito attorno a RC FLUX.1 Dev (RCFluxDev)—un nodo personalizzato open-source costruito da RunComfy che instrada la generazione attraverso una pipeline di inferenza specifica di FLUX.1 Dev (invece di un grafico campionatore generico) mentre inietta il tuo adattatore attraverso lora_path e lora_scale. Puoi esplorare i lavori correlati nei repository dell'organizzazione runcomfy-com GitHub.

Usa questo workflow quando i campioni dell'AI Toolkit sembrano "giusti", ma passando a un grafico ComfyUI tipico lo stesso LoRA + prompt derivano in stile, forza o composizione.

Perché FLUX.1 Dev LoRA Inferenza spesso appare diversa in ComfyUI

Le anteprime dell'AI Toolkit sono generate da una pipeline di inferenza specifica del modello. Molti grafici di ComfyUI ricostruiscono FLUX da componenti generici, quindi "abbinare i numeri" (prompt/passi/guida/seed) può comunque produrre valori predefiniti diversi e un comportamento applicativo LoRA diverso. Questo divario "anteprima di addestramento vs inferenza ComfyUI" è solitamente a livello di pipeline, non un singolo parametro errato.

Cosa fa il nodo personalizzato RCFluxDev

RCFluxDev incapsula la pipeline di inferenza FLUX.1 Dev utilizzata per il campionamento in stile AI Toolkit e applica il tuo LoRA all'interno di quella pipeline in modo che il comportamento dell'adattatore rimanga coerente per questa famiglia di modelli. Fonte della pipeline: `src/pipelines/flux_dev.py`

Come utilizzare il workflow FLUX.1 Dev LoRA Inferenza

Passo 1: Importa il tuo LoRA (2 modi)

- Opzione 1 (risultato di addestramento RunComfy): RunComfy → Trainer → LoRA Assets → trova il tuo LoRA → ⋮ → Copia il link LoRA

- Opzione 2 (AI Toolkit LoRA addestrato fuori da RunComfy):

Copia un link diretto di download .safetensors per il tuo LoRA e incolla quell'URL in lora_path.

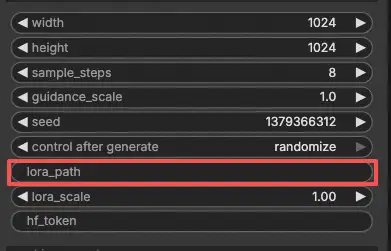

Passo 2: Configura il nodo personalizzato RCFluxDev per FLUX.1 Dev LoRA Inferenza

- Nel workflow, seleziona RC FLUX.1 Dev (RCFluxDev) e incolla il tuo URL LoRA (o percorso del file) in

lora_path.

Importante (richiesto per la prima esecuzione): per eseguire questo nodo personalizzato devi (1) avere accesso a Hugging Face al repo FLUX.1 Dev che stai utilizzando, e (2) incollare il tuo token Hugging Face in hf_token:

- Sulla pagina del modello Hugging Face, accedi e clicca Richiedi accesso / Accetta (una volta per repo).

- Crea un Token di Accesso Utente Hugging Face con permesso Lettura su huggingface.co/settings/tokens.

- Incolla il token in

hf_tokensu RCFluxDev, quindi riesegui il workflow.

Guida passo-passo: FLUX Hugging Face Token - Setup & Troubleshooting

- Quindi configura il resto delle impostazioni per FLUX.1 Dev LoRA Inferenza (tutte nell'interfaccia utente del nodo):

Suggerimento per l'allineamento dell'addestramento: quando cerchi una corrispondenza 1:1, non "regolare a sensazione"—rifletti i valori di campionamento dall'YAML di addestramento AI Toolkit che hai utilizzato per le anteprime (specialmente width, height, sample_steps, guidance_scale, seed). Se hai addestrato su RunComfy, apri Trainer → LoRA Assets → Config e riutilizza le impostazioni di anteprima.

prompt: il tuo testo prompt (includi i token di attivazione che hai usato durante l'addestramento, se presenti)negative_prompt: opzionale; lascialo vuoto se non hai campionato con negativiwidth/height: risoluzione in output (abbina le anteprime di addestramento quando confronti)sample_steps: numero di passi di inferenzaguidance_scale: valore di guida utilizzato dalla pipeline FLUX.1 Devseed: imposta un seed fisso per riprodurre; cambialo per esplorare variazionilora_scale: forza del LoRA (inizia vicino al tuo valore di anteprima, quindi regola)hf_token: il tuo token di accesso Hugging Face (richiesto per i repo FLUX riservati)

Passo 3: Esegui FLUX.1 Dev LoRA Inferenza

- Clicca Queue/Run → SaveImage salva automaticamente i risultati nella cartella di output di ComfyUI

Risoluzione dei problemi FLUX.1 Dev LoRA Inferenza

La maggior parte dei problemi "anteprima vs ComfyUI" di FLUX.1 Dev sono causati da incongruenze di pipeline (come viene caricato il modello, come viene costruito il conditioning e dove/come viene iniettato l'adattatore), non solo un singolo parametro errato.

Per i FLUX.1 Dev LoRA addestrati con l'AI Toolkit, il modo più affidabile per recuperare un comportamento allineato all'addestramento in ComfyUI è eseguire la generazione attraverso RC FLUX.1 Dev (RCFluxDev), che mantiene l'inferenza allineata a livello di pipeline e applica il tuo adattatore in modo coerente tramite lora_path / lora_scale. Se stai risolvendo un problema persistente, inizia dal workflow di riferimento minimo e aggiungi complessità solo dopo aver confermato che la base funziona.

(1)Alto utilizzo di vram lora dopo l'aggiornamento

Perché accade

Con FLUX.1 Dev, alcune configurazioni vedono un grande aumento di VRAM quando si applicano certi LoRA (inclusi LoRA addestrati con AI Toolkit). Questo di solito si verifica quando i LoRA sono iniettati attraverso percorsi di caricamento generici o quando il grafico causa copie extra del modello / comportamento di ricarica.

Come risolvere (raccomandato)

- Esegui l'inferenza attraverso RCFluxDev e carica il tuo adattatore solo tramite

lora_pathnel nodo (evita di mescolare più nodi di caricamento LoRA per lo stesso modello). - Mantieni il confronto equo: abbina i valori di campionamento dell'anteprima di addestramento (

width,height,sample_steps,guidance_scale,seed) prima di giudicare "non sembra giusto". - Se continui a incontrare OOM: riduci prima

width/height(questo è di solito il fattore più grande per FLUX), quindi riduci batch/nodi extra e riavvia la sessione per cancellare eventuali cache obsolete. Inoltre, puoi lanciare una macchina GPU più potente su RunComfy per eseguire.

(2)VAEDecode Dato groups=1, peso di dimensioni [4, 4, 1, 1], input previsto[1, 16, 144, 112] per avere 4 canali, ma ne ha ottenuti 16 invece

Perché accade

I latenti FLUX e i latenti "classici SD" non sono intercambiabili. Questo errore è il sintomo usuale della decodifica di latenti FLUX con un non-FLUX VAE (un VAE che si aspetta latenti a 4 canali, mentre i latenti FLUX possono essere a 16 canali).

Come risolvere

- Non decodificare i latenti FLUX con un percorso VAE SD/SDXL.

- Usa il workflow RCFluxDev in modo che il percorso di decodifica FLUX corretto sia utilizzato end-to-end (caricamento del modello → campionamento → decodifica), invece di mescolare nodi VAE generici da altre pipeline.

- Se stai ricostruendo grafici manualmente, verifica di utilizzare i corretti asset di autoencoder FLUX e non un VAE SD/SDXL rimasto.

(3)Il modello flux non funziona, flux1-dev-fp8.safetensors

Perché accade

Questo di solito accade quando un UNet FLUX .safetensors è caricato usando il tipo di caricatore sbagliato (per esempio, trattandolo come un "checkpoint" che ComfyUI dovrebbe rilevare automaticamente come SD/SDXL).

Come risolvere

- Usa il workflow FLUX.1 Dev (RCFluxDev) e lascia che il workflow/nodo gestisca il caricamento del modello; passa solo il tuo LoRA tramite

lora_path. - Non caricare UNet FLUX usando caricatori di checkpoint SD/SDXL.

- Se il file è stato scaricato da un link, ricontrolla che sia un

.safetensorscompleto e valido (download parziali possono scatenare errori di rilevamento confusi).

Esegui ora FLUX.1 Dev LoRA Inferenza

Apri il workflow FLUX.1 Dev LoRA Inferenza su RunComfy, imposta lora_path, e genera con RCFluxDev per mantenere i risultati di ComfyUI allineati con le tue anteprime di addestramento AI Toolkit.