FLUX.2 LoRA ComfyUI Inferencia: salida de LoRA de AI Toolkit coincidente con el entrenamiento con la pipeline FLUX.2 Dev

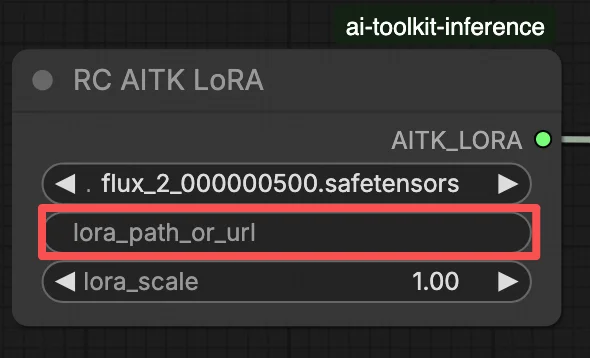

Este flujo de trabajo RunComfy listo para producción ejecuta la inferencia de FLUX.2 Dev LoRA en ComfyUI a través de RC FLUX.2 Dev (Flux2Pipeline) (alineación a nivel de pipeline, no un gráfico de muestreador genérico). RunComfy construyó y liberó este nodo personalizado—vea los repositorios runcomfy-com—y usted controla la aplicación del adaptador con lora_path y lora_scale.

Nota: Este flujo de trabajo requiere una máquina 3XL para ejecutarse.

Por qué FLUX.2 LoRA ComfyUI Inferencia a menudo se ve diferente en ComfyUI

Las vistas previas de entrenamiento de AI Toolkit se renderizan a través de una pipeline FLUX.2 específica del modelo, donde la codificación de texto, la programación y la inyección de LoRA están diseñadas para trabajar juntas. En ComfyUI, reconstruir FLUX.2 con un gráfico diferente (o una ruta de cargador de LoRA diferente) puede cambiar esas interacciones, por lo que copiar el mismo prompt, pasos, CFG y semilla aún produce un desplazamiento visible. Los nodos de la pipeline RC RunComfy cierran esa brecha ejecutando FLUX.2 de principio a fin en Flux2Pipeline y aplicando su LoRA dentro de esa pipeline, manteniendo la inferencia alineada con el comportamiento de vista previa. Fuente: repositorios de código abierto RunComfy.

Cómo usar el flujo de trabajo FLUX.2 LoRA ComfyUI Inferencia

Paso 1: Obtenga la ruta de LoRA y cárguela en el flujo de trabajo (2 opciones)

⚠️ Importante · Se requiere acceso a FLUX.2 y token de Hugging Face

Los modelos FLUX.2 Dev requieren autorización de acceso explícita en Hugging Face.

Antes de ejecutar este flujo de trabajo:

- Asegúrese de que su cuenta de Hugging Face haya sido autorizada para acceder a FLUX.2 (Dev)

- Cree un token de acceso de Hugging Face

- Pegue su token en el campo

hf_tokenen el nodo Load Pipeline

Sin un token válido y acceso al modelo adecuado, el flujo de trabajo no se ejecutará. Para obtener instrucciones paso a paso, consulte Hugging Face token for FLUX.2.

Opción A — Resultado de entrenamiento RunComfy → descargar a ComfyUI local:

- Vaya a Trainer → LoRA Assets

- Encuentre el LoRA que desea usar

- Haga clic en el menú ⋮ (tres puntos) a la derecha → seleccione Copiar enlace LoRA

- En la página del flujo de trabajo de ComfyUI, pegue el enlace copiado en el campo de entrada Download en la esquina superior derecha de la interfaz de usuario

- Antes de hacer clic en Descargar, asegúrese de que la carpeta de destino esté configurada en ComfyUI > models > loras (esta carpeta debe seleccionarse como el destino de descarga)

- Haga clic en Descargar — esto asegura que el archivo LoRA se guarde en el directorio

models/lorascorrecto - Después de que la descarga termine, actualice la página

- El LoRA ahora aparece en el desplegable de selección de LoRA en el flujo de trabajo — selecciónelo

Opción B — URL directa de LoRA (anula la Opción A):

- Pegue la URL de descarga directa

.safetensorsen el campo de entradapath / urldel nodo LoRA - Cuando se proporciona una URL aquí, anula la Opción A — el flujo de trabajo carga el LoRA directamente desde la URL en tiempo de ejecución

- No se requiere descarga local ni colocación de archivos

Consejo: confirme que la URL resuelve al archivo .safetensors real (no una página de destino o redirección).

Paso 2: Haga coincidir los parámetros de inferencia con los ajustes de muestra de su entrenamiento

En el nodo LoRA, seleccione su adaptador en lora_path (Opción A), o pegue un enlace .safetensors directo en path / url (Opción B anula el desplegable). Luego configure lora_scale a la misma fuerza que usó durante las vistas previas de entrenamiento y ajuste desde allí.

Los parámetros restantes están en el nodo Generate (y, dependiendo del gráfico, el nodo Load Pipeline):

prompt: su texto de prompt (incluya palabras de activación si entrenó con ellas)width/height: resolución de salida; haga coincidir su tamaño de vista previa de entrenamiento para la comparación más limpia (se recomiendan múltiplos de 16 para FLUX.2)sample_steps: número de pasos de inferencia (25 es un valor predeterminado común)guidance_scale: valor de CFG/guía (4.0 es un valor predeterminado común)seed: semilla fija para reproducir; cámbiela para explorar variacionesseed_mode(solo si está presente): elijafixedorandomizenegative_prompt(solo si está presente): FLUX.2 está destilado en guía en este flujo de trabajo, por lo que se ignoran los prompts negativoshf_token: token de acceso de Hugging Face; requerido para la descarga del modelo FLUX.2 Dev (péguelo en el nodo Load Pipeline)

Consejo de alineación de entrenamiento: si personalizó los valores de muestreo durante el entrenamiento (seed, guidance_scale, sample_steps, palabras de activación, resolución), refleje esos valores exactos aquí. Si entrenó en RunComfy, abra Trainer → LoRA Assets > Config para ver el YAML resuelto y copie los ajustes de vista previa/muestra en los nodos del flujo de trabajo.

Paso 3: Ejecute FLUX.2 LoRA ComfyUI Inferencia

Haga clic en Queue/Run — el nodo SaveImage escribe los resultados en su carpeta de salida de ComfyUI.

Lista de verificación rápida:

- ✓ LoRA está: descargado en

ComfyUI/models/loras(Opción A), o cargado a través de una URL directa.safetensors(Opción B) - ✓ Página actualizada después de la descarga local (solo Opción A)

- ✓ Los parámetros de inferencia coinciden con la configuración de

samplede entrenamiento (si está personalizada)

Si todo lo anterior es correcto, los resultados de inferencia aquí deberían coincidir estrechamente con sus vistas previas de entrenamiento.

Solución de problemas de FLUX.2 LoRA ComfyUI Inferencia

La mayoría de las diferencias entre “vista previa de entrenamiento vs inferencia de ComfyUI” de FLUX.2 provienen de diferencias a nivel de pipeline (cómo se carga el modelo, se programa y cómo se fusiona el LoRA), no de un único ajuste incorrecto. Este flujo de trabajo RunComfy restaura la base “coincidente con el entrenamiento” más cercana al ejecutar la inferencia a través de RC FLUX.2 Dev (Flux2Pipeline) de principio a fin y aplicando su LoRA dentro de esa pipeline a través de lora_path / lora_scale (en lugar de apilar nodos genéricos de cargador/muestreador).

(1) Flux.2 con error de Lora: "mul_cuda" no implementado para 'Float8_e4m3fn'

Por qué sucede esto Esto típicamente ocurre cuando FLUX.2 se carga con pesos Float8/FP8 (o cuantización de precisión mixta) y el LoRA se aplica a través de una ruta genérica de LoRA de ComfyUI. La fusión de LoRA puede forzar operaciones Float8 no compatibles (o promociones mixtas Float8 + BF16), lo que desencadena el error de tiempo de ejecución mul_cuda Float8.

Cómo solucionarlo (recomendado)

- Ejecute la inferencia a través de RC FLUX.2 Dev (Flux2Pipeline) y cargue el adaptador solo a través de

lora_path/lora_scalepara que la fusión de LoRA ocurra en la pipeline alineada con AI Toolkit, no a través de un cargador LoRA genérico apilado encima. - Si está depurando en un gráfico no RC: evite aplicar un LoRA encima de pesos de difusión Float8/FP8. Use una ruta de carga compatible con BF16/FP16 para FLUX.2 antes de agregar el LoRA.

(2) Las discrepancias de forma de LoRA deberían fallar rápidamente en lugar de corromper el estado de la GPU y causar inestabilidad del sistema/OOM

Por qué sucede esto Esto es casi siempre un desajuste base: el LoRA fue entrenado para una familia de modelos diferente (por ejemplo, FLUX.1) pero se está aplicando a FLUX.2 Dev. A menudo verá muchas líneas de lora key not loaded y luego desajustes de forma; en el peor de los casos, la sesión puede volverse inestable y terminar en OOMs.

Cómo solucionarlo (recomendado)

- Asegúrese de que el LoRA fue entrenado específicamente para

black-forest-labs/FLUX.2-devcon AI Toolkit (las variantes FLUX.1 / FLUX.2 / Klein no son intercambiables). - Mantenga el gráfico “de un solo camino” para LoRA: cargue el adaptador solo a través de la entrada

lora_pathdel flujo de trabajo y deje que Flux2Pipeline maneje la fusión. No apile un cargador LoRA genérico adicional en paralelo. - Si ya tuvo un desajuste y ComfyUI comienza a producir errores CUDA/OOM no relacionados después, reinicie el proceso de ComfyUI para restablecer completamente el estado de la GPU + modelo, luego intente de nuevo con un LoRA compatible.

(3) Flux.2 Dev - Usar LoRAs más que duplica el tiempo de inferencia

Por qué sucede esto Un LoRA puede hacer que FLUX.2 Dev sea mucho más lento cuando la ruta de LoRA fuerza trabajo adicional de parcheo/descuantización o aplica pesos en una ruta de código más lenta que el modelo base solo.

Cómo solucionarlo (recomendado)

- Use la ruta RC FLUX.2 Dev (Flux2Pipeline) de este flujo de trabajo y pase su adaptador a través de

lora_path/lora_scale. En esta configuración, el LoRA se fusiona una vez durante la carga de la pipeline (estilo AI Toolkit), por lo que el costo de muestreo por paso se mantiene cerca del modelo base. - Cuando esté buscando un comportamiento coincidente con la vista previa, evite apilar múltiples cargadores LoRA o mezclar rutas de cargador. Manténgalo en uno

lora_path+ unolora_scalehasta que la base coincida.

Nota En este flujo de trabajo FLUX.2 Dev, FLUX.2 está destilado en guía, por lo que negative_prompt puede ser ignorado por la pipeline incluso si existe un campo de interfaz de usuario—coincida las vistas previas usando la redacción del prompt + guidance_scale + lora_scale primero.

Ejecute FLUX.2 LoRA ComfyUI Inferencia ahora

Abra el flujo de trabajo, configure lora_path y haga clic en Queue/Run para obtener resultados de FLUX.2 Dev LoRA que se mantengan cerca de sus vistas previas de entrenamiento de AI Toolkit.