FLUX.1 Dev LoRA Inferencia: Coincide con las Vistas Previas de Entrenamiento del AI Toolkit en ComfyUI

FLUX.1 Dev LoRA Inferencia: generación coincidente con el entrenamiento y de pasos mínimos en ComfyUI La Inferencia FLUX.1 Dev LoRA es un flujo de trabajo listo para ejecutar de RunComfy para aplicar AI Toolkit–entrenado FLUX.1 Dev LoRAs en ComfyUI con resultados que se mantienen cercanos a tus vistas previas de entrenamiento. Está construido alrededor de RC FLUX.1 Dev (RCFluxDev)—un nodo personalizado de código abierto construido por RunComfy que dirige la generación a través de una tubería de inferencia específica de FLUX.1 Dev (en lugar de un gráfico de muestreo genérico) mientras inyecta tu adaptador a través de lora_path y lora_scale. Puedes navegar por el trabajo fuente relacionado en los repositorios de la organización runcomfy-com en GitHub.

Usa este flujo de trabajo cuando tus muestras de AI Toolkit se sientan "correctas", pero cambiar a un gráfico típico de ComfyUI hace que el mismo LoRA + prompt se desvíe en estilo, fuerza o composición.

Por qué la Inferencia FLUX.1 Dev LoRA a menudo se ve diferente en ComfyUI

Las vistas previas del AI Toolkit son generadas por una tubería de inferencia específica del modelo. Muchos gráficos de ComfyUI reconstruyen FLUX a partir de componentes genéricos, por lo que "coincidir los números" (prompt/pasos/guía/semilla) aún puede producir diferentes valores predeterminados y comportamiento de aplicación de LoRA. Esta "brecha de vista previa de entrenamiento vs inferencia de ComfyUI" suele ser a nivel de tubería, no un solo ajuste incorrecto.

Qué hace el nodo personalizado RCFluxDev

RCFluxDev encapsula la tubería de inferencia FLUX.1 Dev utilizada para el muestreo al estilo AI Toolkit y aplica tu LoRA dentro de esa tubería para que el comportamiento del adaptador se mantenga consistente para esta familia de modelos. Fuente de la tubería: `src/pipelines/flux_dev.py`

Cómo usar el flujo de trabajo de Inferencia FLUX.1 Dev LoRA

Paso 1: Importa tu LoRA (2 maneras)

- Opción 1 (resultado de entrenamiento de RunComfy): RunComfy → Entrenador → Activos LoRA → encuentra tu LoRA → ⋮ → Copiar Enlace LoRA

- Opción 2 (LoRA entrenado con AI Toolkit fuera de RunComfy):

Copia un enlace de descarga directa .safetensors para tu LoRA y pega esa URL en lora_path.

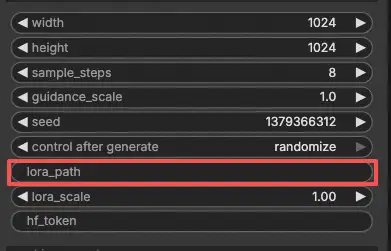

Paso 2: Configura el nodo personalizado RCFluxDev para la Inferencia FLUX.1 Dev LoRA

- En el flujo de trabajo, selecciona RC FLUX.1 Dev (RCFluxDev) y pega tu URL de LoRA (o ruta de archivo) en

lora_path.

Importante (requerido para la primera ejecución): para ejecutar este nodo personalizado debes (1) tener acceso a Hugging Face al repositorio FLUX.1 Dev que estás usando, y (2) pegar tu token de Hugging Face en hf_token:

- En la página del modelo de Hugging Face, inicia sesión y haz clic en Solicitar acceso / Aceptar (una vez por repositorio).

- Crea un Token de Acceso de Usuario de Hugging Face con permiso de Lectura en huggingface.co/settings/tokens.

- Pega el token en

hf_tokenen RCFluxDev, luego vuelve a ejecutar el flujo de trabajo.

Guía paso a paso: FLUX Hugging Face Token - Configuración y Solución de Problemas

- Luego configura el resto de los ajustes para Inferencia FLUX.1 Dev LoRA (todo en la interfaz del nodo):

Consejo de alineación de entrenamiento: cuando estás buscando una coincidencia 1:1, no "ajustes por intuición"—refleja los valores de muestreo del YAML de entrenamiento de AI Toolkit que usaste para las vistas previas (especialmente width, height, sample_steps, guidance_scale, seed). Si entrenaste en RunComfy, abre Entrenador → Activos LoRA → Configuración y reutiliza los ajustes de vista previa.

prompt: tu texto prompt (incluye los tokens de activación que usaste durante el entrenamiento, si hay)negative_prompt: opcional; déjalo vacío si no muestreamos con negativoswidth/height: resolución de salida (coincide con las vistas previas de entrenamiento al comparar)sample_steps: número de pasos de inferenciaguidance_scale: valor de guía utilizado por la tubería FLUX.1 Devseed: establece una semilla fija para reproducir; cámbiala para explorar variacioneslora_scale: fuerza de LoRA (comienza cerca de tu valor de vista previa, luego ajusta)hf_token: tu token de acceso de Hugging Face (requerido para repositorios FLUX bloqueados)

Paso 3: Ejecuta la Inferencia FLUX.1 Dev LoRA

- Haz clic en Queue/Run → SaveImage escribe resultados en tu carpeta de salida de ComfyUI automáticamente

Solución de Problemas de la Inferencia FLUX.1 Dev LoRA

La mayoría de los problemas de "vista previa vs ComfyUI" de FLUX.1 Dev son causados por desajustes de tubería (cómo se carga el modelo, cómo se construye el acondicionamiento y dónde/cómo se inyecta el adaptador), no solo un parámetro incorrecto.

Para FLUX.1 Dev LoRAs entrenados con AI Toolkit, la forma más confiable de recuperar comportamiento coincidente con el entrenamiento en ComfyUI es ejecutar la generación a través de RC FLUX.1 Dev (RCFluxDev), que mantiene la inferencia alineada a nivel de tubería y aplica tu adaptador de manera consistente a través de lora_path / lora_scale. Si estás depurando un problema persistente, comienza desde el flujo de trabajo de referencia mínimo y agrega complejidad solo después de confirmar que la base funciona.

(1)Alto uso de vram de lora después de la actualización

Por qué sucede esto

Con FLUX.1 Dev, algunas configuraciones ven un gran salto de VRAM al aplicar ciertos LoRAs (incluyendo LoRAs entrenados con AI Toolkit). Esto a menudo aparece cuando los LoRAs se inyectan a través de rutas de cargador genéricas o cuando el gráfico causa copias de modelo adicionales / comportamiento de recarga.

Cómo solucionarlo (recomendado)

- Ejecuta la inferencia a través de RCFluxDev y carga tu adaptador solo a través de

lora_pathen el nodo (evita mezclar múltiples nodos de cargador de LoRA para el mismo modelo). - Mantén tu comparación justa: coincide con los valores de muestreo de vista previa de entrenamiento (

width,height,sample_steps,guidance_scale,seed) antes de juzgar "parece incorrecto". - Si aún encuentras OOM: reduce

width/heightprimero (eso suele ser la palanca más grande para FLUX), luego reduce el lote/nodos extra, y reinicia la sesión para limpiar cualquier caché obsoleto. Además, puedes lanzar una máquina GPU más alta en RunComfy para ejecutar.

(2)VAEDecode Dado groups=1, peso de tamaño [4, 4, 1, 1], se esperaba input[1, 16, 144, 112] para tener 4 canales, pero en su lugar obtuvo 16 canales

Por qué sucede esto

Los latentes FLUX y los latentes "SD clásico" no son intercambiables. Este error es el síntoma usual de decodificar latentes FLUX con un VAE no-FLUX (un VAE que espera latentes de 4 canales, mientras que los latentes FLUX pueden ser de 16 canales).

Cómo solucionarlo

- No decodifiques latentes FLUX con una ruta VAE SD/SDXL.

- Usa el flujo de trabajo RCFluxDev para que la ruta de decodificación FLUX correcta se use de extremo a extremo (carga del modelo → muestreo → decodificación), en lugar de mezclar nodos VAE genéricos de otras tuberías.

- Si estás reconstruyendo gráficos manualmente, verifica que estás usando los activos de auto codificación FLUX correctos y no un VAE SD/SDXL restante.

(3)el modelo flux no funciona, flux1-dev-fp8.safetensors

Por qué sucede esto

Esto generalmente ocurre cuando un UNet .safetensors de FLUX se carga usando el tipo de cargador incorrecto (por ejemplo, tratándolo como un "checkpoint" que ComfyUI debería detectar automáticamente como SD/SDXL).

Cómo solucionarlo

- Usa el flujo de trabajo FLUX.1 Dev (RCFluxDev) y deja que el flujo de trabajo/nodo maneje la carga del modelo; solo pasa tu LoRA a través de

lora_path. - No cargues UNets FLUX usando cargadores de checkpoints SD/SDXL.

- Si el archivo se descargó de un enlace, verifica de nuevo que es un

.safetensorscompleto y válido (las descargas parciales pueden desencadenar errores de detección confusos).

Ejecuta la Inferencia FLUX.1 Dev LoRA ahora

Abre el flujo de trabajo de FLUX.1 Dev LoRA Inferencia de RunComfy, establece lora_path, y genera con RCFluxDev para mantener los resultados de ComfyUI alineados con tus vistas previas de entrenamiento del AI Toolkit.