ComfyUI Vid2Vid Dance Transfer es un poderoso flujo de trabajo ComfyUI Vid2Vid que permite a los usuarios estilizar y transformar videos reales en varios objetos o elementos. Con este flujo de trabajo, puedes crear animaciones de video impresionantes transfiriendo el movimiento y el estilo de un video fuente a una imagen u objeto objetivo. Este tutorial te guiará a través de los componentes y configuraciones clave necesarios para lograr los mejores resultados.

Crédito

Gracias a MDMZ y DP por sus increíbles contribuciones en la creación de este flujo de trabajo. MDMZ compartió su flujo de trabajo ComfyUI Vid2Vid Dance Transfer a través de su tutorial de YouTube Transform Videos with AI: Dancing Noodles Step-by-Step Tutorial, que se basa en el flujo de trabajo original de DP DP's - Vid2Vid AniamteDiff LCM dance transfer.

1. ¿Qué hace el flujo de trabajo ComfyUI Vid2Vid Dance Transfer?

El flujo de trabajo ComfyUI Vid2Vid Dance Transfer te permite tomar un video real y transformarlo en una animación estilizada. Transfiere el movimiento y los pasos de baile del video fuente a una imagen u objeto objetivo de tu elección.

2. Componentes clave del flujo de trabajo ComfyUI Vid2Vid

2.1 Cargar video y crear máscara

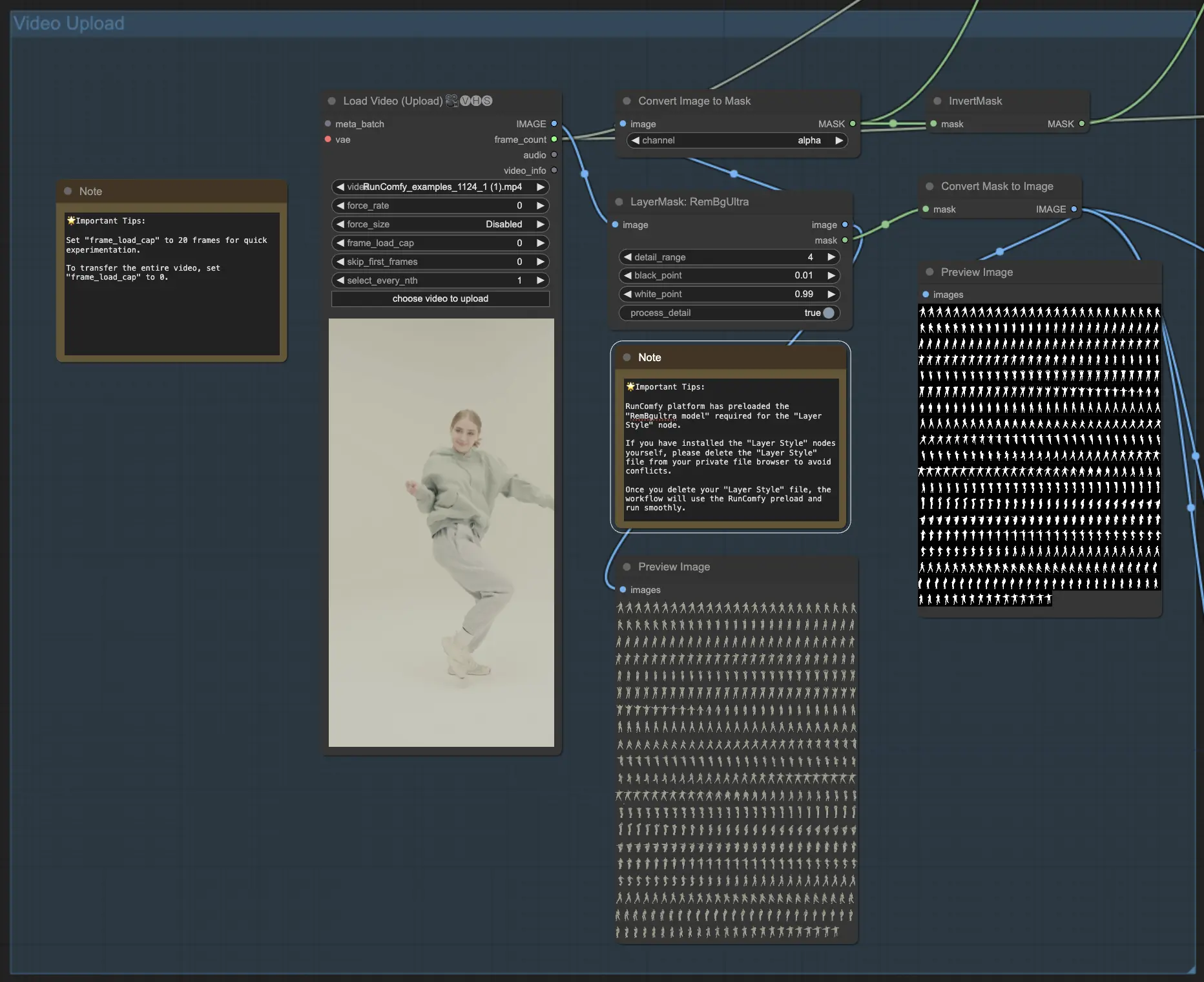

- El flujo de trabajo ComfyUI Vid2Vid comienza con el componente VHS_LoadVideo, donde cargas el video fuente que contiene los pasos de baile que deseas transferir.

- El componente LayerMask: RemBgUltra se utiliza para eliminar el fondo de los fotogramas del video y crear una máscara en blanco y negro del sujeto. Esta máscara es crucial para identificar y transferir correctamente el movimiento.

- Los componentes ImageToMask y MaskToImage convierten entre formatos de imagen y máscara según sea necesario en el flujo de trabajo ComfyUI Vid2Vid.

- 🌟 Consejos importantes: La plataforma RunComfy ha precargado el "modelo RemBgultra" requerido para el nodo "Layer Style". Si has instalado los nodos "Layer Style" tú mismo, por favor elimina el archivo "Layer Style" de tu navegador de archivos privado para evitar conflictos. Una vez que elimines tu archivo "Layer Style", el flujo de trabajo utilizará la precarga de RunComfy y funcionará sin problemas.

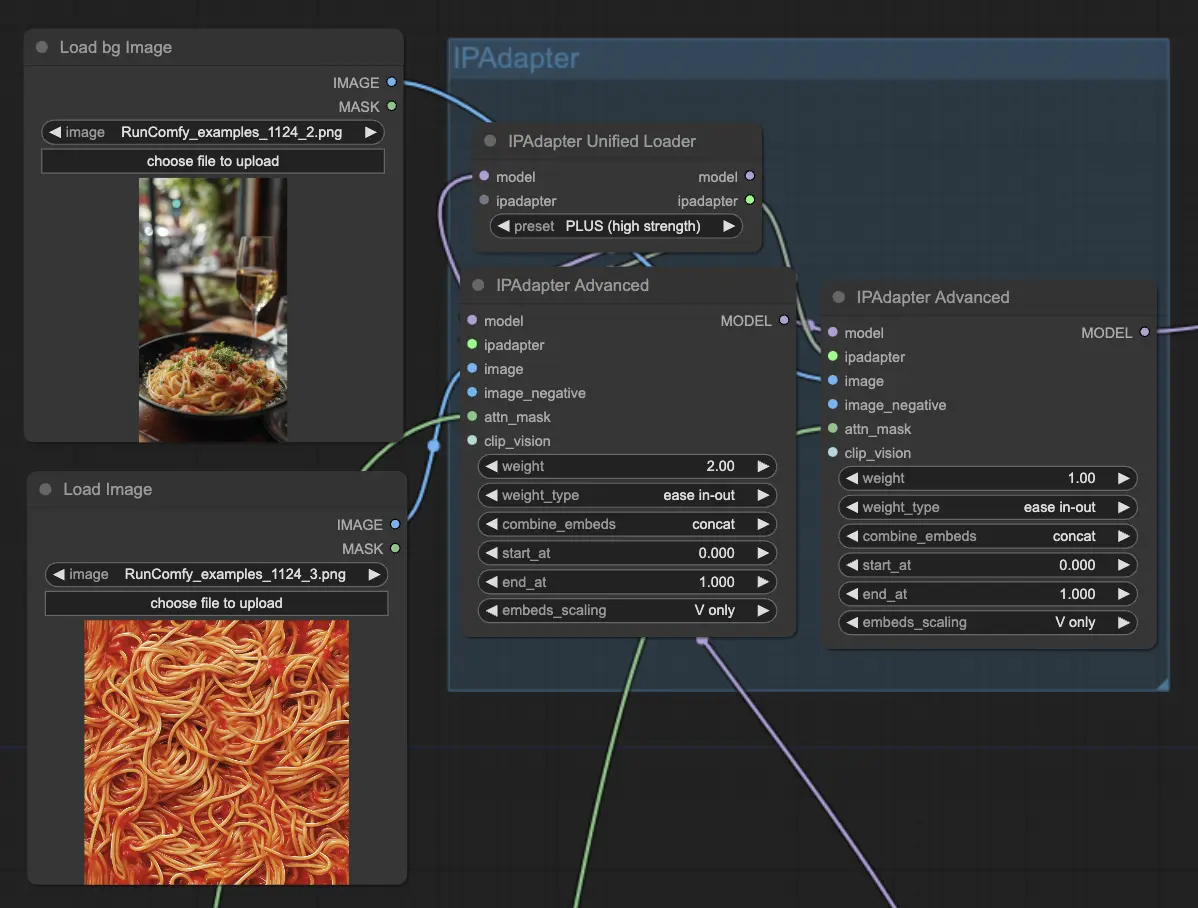

2.2 Configuración de la imagen objetivo con IPAdapter

- Los componentes IPAdapterAdvanced se utilizan para cargar y configurar la imagen u objeto objetivo que recibirá la transferencia de baile ComfyUI Vid2Vid. Puedes cargar la imagen objetivo usando el nodo LoadImage, y cargar la imagen de fondo objetivo usando el nodo LoadBgImage.

- El IPAdapterUnifiedLoader se utiliza para cargar el IPAdapter, que determina la fuerza de la influencia de la imagen objetivo en la salida.

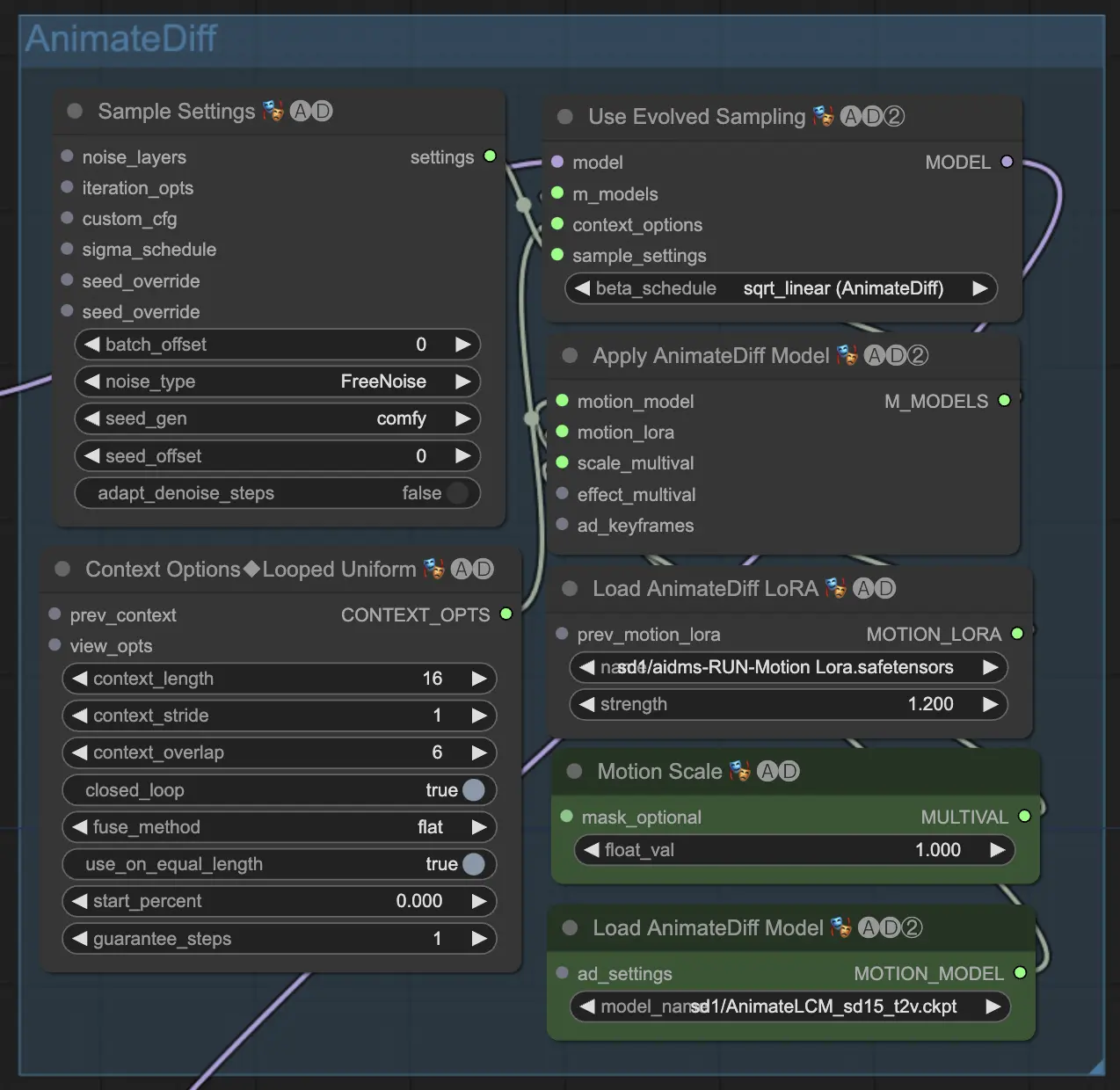

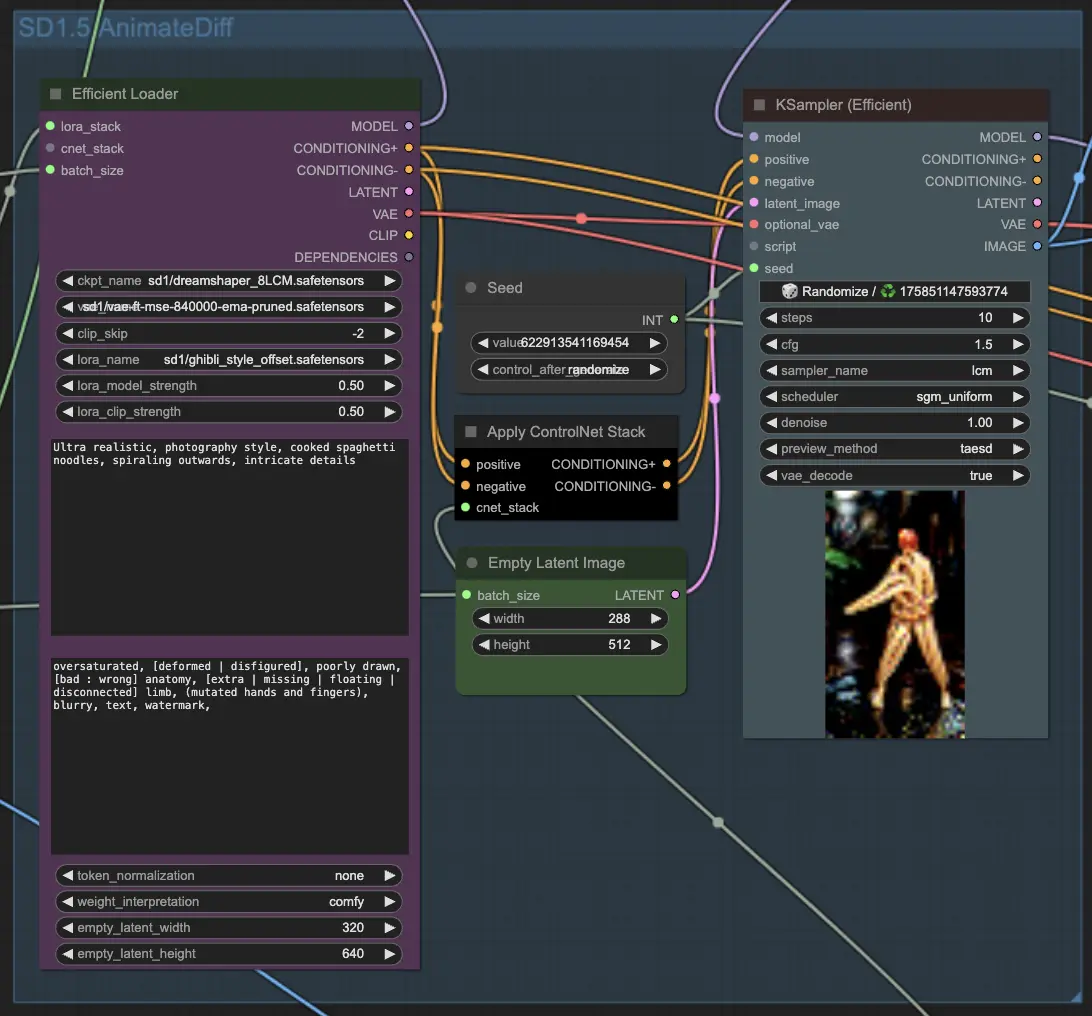

2.3 Aplicación de AnimateDiff para la transferencia de movimiento

- El núcleo de la transferencia de baile ComfyUI Vid2Vid está impulsado por el AnimateDiff Latent Condition Model (LCM). Esto se carga usando el componente ADE_LoadAnimateDiffModel en ComfyUI Vid2Vid.

- Componentes adicionales como ADE_AnimateDiffSamplingSettings, ADE_LoopedUniformContextOptions y ADE_ApplyAnimateDiffModelSimple se utilizan para configurar los ajustes de muestreo, opciones de contexto y aplicar el modelo AnimateDiff respectivamente en ComfyUI Vid2Vid.

- El componente ADE_UseEvolvedSampling se utiliza para seleccionar el método de muestreo apropiado para el modelo AnimateDiff en ComfyUI Vid2Vid.

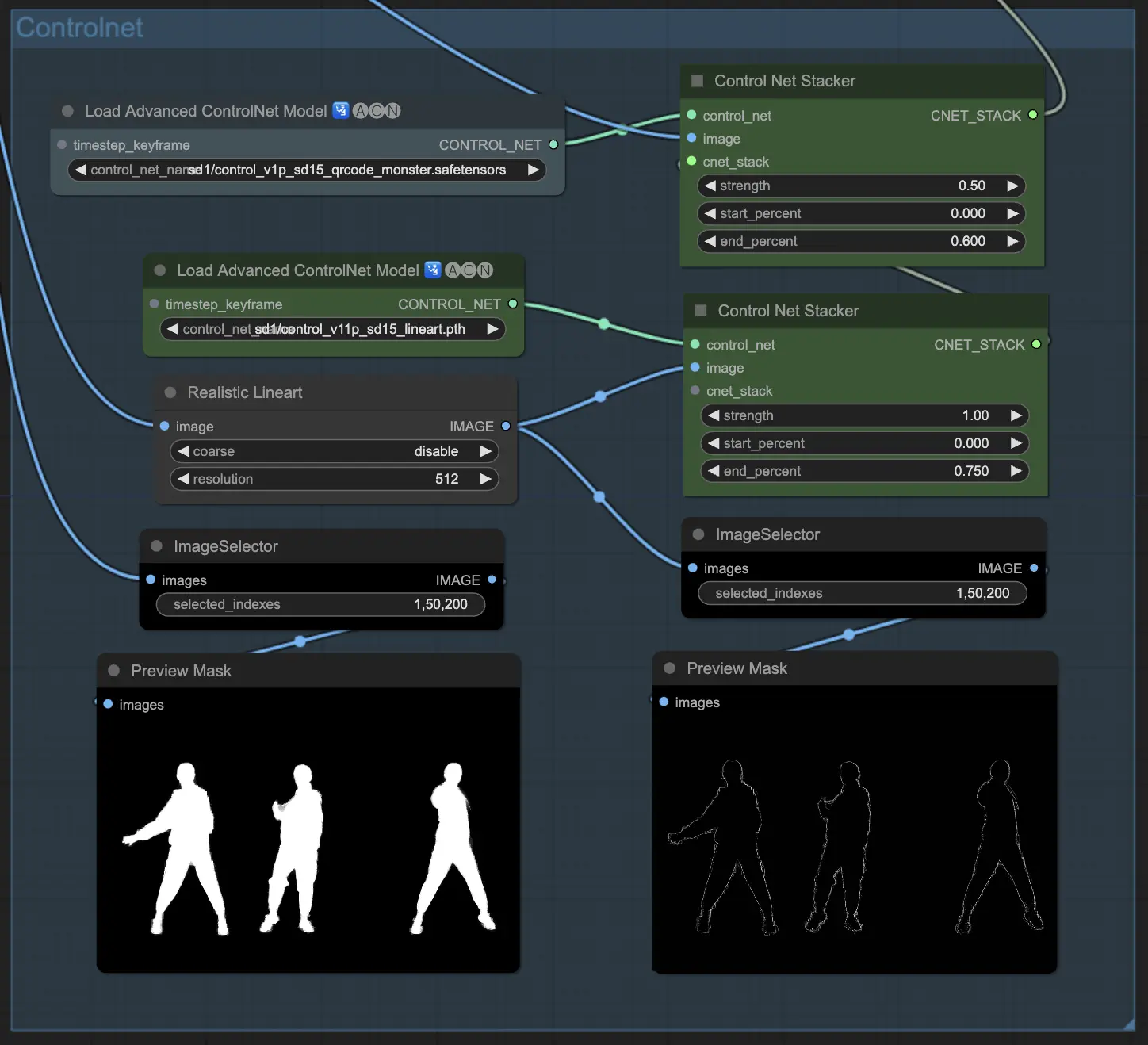

2.4 Guiar la salida con ControlNet

- ControlNet se utiliza para guiar y definir la forma y el contorno del sujeto en la animación de salida.

- Los componentes ControlNetLoaderAdvanced se utilizan para cargar los modelos ControlNet. Este flujo de trabajo utiliza dos modelos ControlNet: QR Code Monster y Lineart.

- Los componentes ControlNet Stacker se utilizan para apilar y combinar las salidas de ControlNet con fortalezas ajustables en ComfyUI Vid2Vid Transfer.

2.5 Generación de fotogramas de salida con KSampler

- Los componentes KSampler (Efficient) en ComfyUI Vid2Vid son responsables de generar los fotogramas de salida basados en todas las configuraciones e insumos proporcionados.

- El componente principal KSampler procesa los fotogramas del video para crear la vista previa de la animación. Toma el modelo AnimateDiff, las salidas de IPAdapter, la pila de ControlNet y otras configuraciones como insumos.

- El segundo componente KSampler se utiliza para escalar y reducir el ruido de los fotogramas de salida de ComfyUI Vid2Vid.

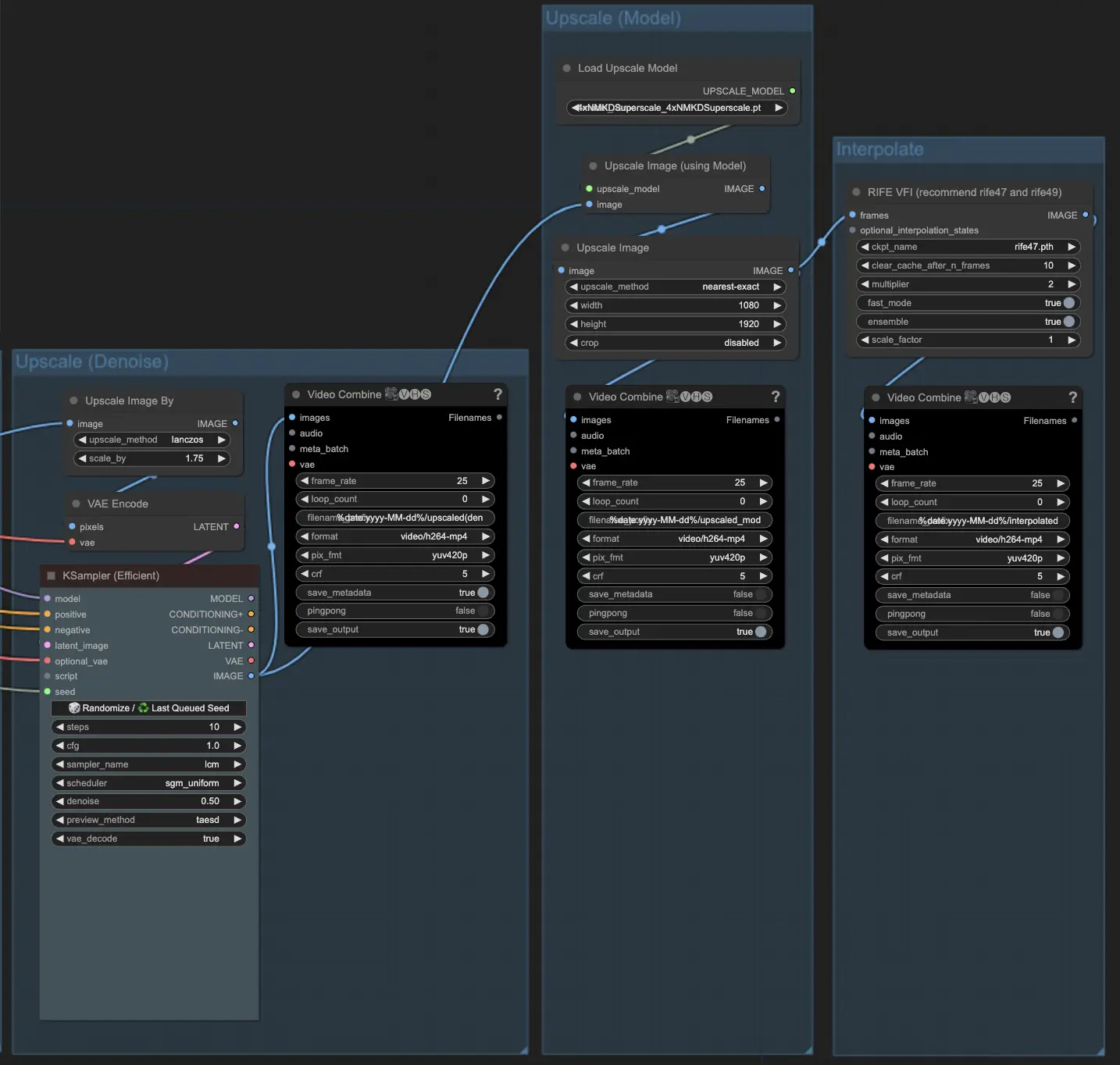

2.6 Escalar si es necesario

- El componente ImageScaleBy se utiliza para aumentar la resolución de los fotogramas de salida. El componente ImageUpscaleWithModel se utiliza para escalar aún más los fotogramas usando un modelo de escalado elegido. El flujo de trabajo predetermina la desactivación de los componentes de escalado. Si lo necesitas, habilita estos componentes para obtener un mejor resultado.