SDXL LoRA Inferenz: Führen Sie AI Toolkit LoRA in ComfyUI für Training-Übereinstimmende Ergebnisse aus

SDXL LoRA Inferenz: training-übereinstimmende Ergebnisse mit weniger Schritten in ComfyUI. Dieser Workflow führt Stable Diffusion XL (SDXL) mit AI Toolkit-trainierten LoRAs über RunComfy’s RC SDXL (RCSDXL) Benutzerdefinierten Knoten aus (open-sourced in den runcomfy-com GitHub organization repositories). Indem eine SDXL-spezifische Pipeline (anstatt eines generischen Sampler-Diagramms) umhüllt wird und das Laden und Skalieren von LoRA (lora_path / lora_scale) mit SDXL-korrekten Standardeinstellungen standardisiert wird, bleiben Ihre ComfyUI-Ausgaben viel näher an dem, was Sie in den Trainingsvorschauen gesehen haben.

Wenn Sie ein SDXL LoRA im AI Toolkit (RunComfy Trainer oder anderswo) trainiert haben und Ihre ComfyUI-Ergebnisse im Vergleich zu den Trainingsvorschauen „abweichen“, ist dieser Workflow der schnellste Weg, um zum training-übereinstimmenden Verhalten zurückzukehren.

So verwenden Sie den SDXL LoRA Inferenz-Workflow

Schritt 1: Öffnen Sie den Workflow

Öffnen Sie den RunComfy SDXL LoRA Inferenz-Workflow

Schritt 2: Importieren Sie Ihr LoRA (2 Optionen)

- Option A (RunComfy Trainingsergebnis): RunComfy → Trainer → LoRA Assets → Finden Sie Ihr LoRA → ⋮ → LoRA-Link kopieren

- Option B (AI Toolkit LoRA außerhalb von RunComfy trainiert): Kopieren Sie einen direkten

.safetensorsDownload-Link für Ihr LoRA und fügen Sie diese URL inlora_pathein.

Schritt 3: Konfigurieren Sie RCSDXL für SDXL LoRA Inferenz

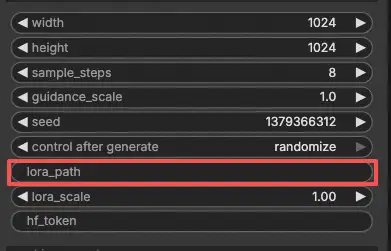

Stellen Sie im RCSDXL SDXL LoRA Inferenz Knoten-UI die verbleibenden Parameter ein:

prompt: Ihr primärer Text-Prompt (einschließlich aller Trigger-Tokens, die Sie während des Trainings verwendet haben)negative_prompt: optional; lassen Sie es leer, wenn Sie keines in den Trainingsvorschauen verwendet habenwidth/height: Ausgabeauflösungsample_steps: Sampling-Schritte (passen Sie Ihre Trainingsvorschau-Einstellungen an, wenn Sie Ergebnisse vergleichen)guidance_scale: CFG / Leitung (entspricht dem Trainingsvorschau-CFG)seed: Verwenden Sie einen festen Seed für die Reproduzierbarkeit; ändern Sie ihn, um Variationen zu erkundenlora_scale: LoRA Stärke/Intensität

Wenn Sie das Sampling während des Trainings angepasst haben, öffnen Sie die AI Toolkit Trainings-YAML und kopieren Sie die gleichen Werte hierher—insbesondere width, height, sample_steps, guidance_scale und seed. Wenn Sie auf RunComfy trainiert haben, können Sie auch die LoRA Config in Trainer → LoRA Assets öffnen und die Vorschau-/Sample-Werte kopieren.

Schritt 4: Führen Sie SDXL LoRA Inferenz aus

- Klicken Sie Queue/Run → Die Ausgabe wird automatisch über SaveImage gespeichert

Warum SDXL LoRA Inferenz in ComfyUI oft anders aussieht & Was der RCSDXL Benutzerdefinierte Knoten tut

Die meisten SDXL LoRA-Abweichungen werden nicht durch einen falschen Schalter verursacht—sie treten auf, weil sich die Inferenz-Pipeline ändert. AI Toolkit Trainingsvorschauen werden durch eine modellspezifische SDXL Inferenz-Implementierung generiert, während viele ComfyUI-Diagramme aus generischen Komponenten rekonstruiert werden. Selbst mit dem gleichen Prompt, Schritten, CFG und Seed kann eine andere Pipeline (und LoRA-Injektionsweg) deutlich unterschiedliche Ergebnisse liefern.

Der RC SDXL (RCSDXL) Knoten umhüllt eine SDXL-spezifische Inferenz-Pipeline, sodass SDXL LoRA Inferenz an die AI Toolkit Trainingsvorschau-Pipeline angepasst bleibt und konsistente LoRA-Injektionsverhalten für SDXL verwendet. Referenzimplementierung: `src/pipelines/sdxl.py`

Fehlerbehebung bei SDXL LoRA Inferenz

Die meisten „Trainingsvorschau vs ComfyUI Inferenz“ Probleme entstehen durch Pipeline-Abweichungen, nicht durch einen einzigen falschen Parameter. Wenn Ihr LoRA mit AI Toolkit (SDXL) trainiert wurde, ist der zuverlässigste Weg, training-übereinstimmendes Verhalten in ComfyUI wiederherzustellen, die Inferenz über RunComfy’s RCSDXL Benutzerdefinierten Knoten auszuführen, der SDXL Sampling + LoRA Injektion auf Pipeline-Ebene angleicht.

(1) Inferenz auf lora .safetensor Dateien sdxl Modell stimmt nicht mit Proben im Training überein

Warum das passiert

Selbst wenn das LoRA geladen wird, können die Ergebnisse immer noch abweichen, wenn Ihr ComfyUI-Diagramm nicht mit der Trainingsvorschau-Pipeline übereinstimmt (andere SDXL-Standardeinstellungen, andere LoRA-Injektionswege, andere Verfeinerungshandhabung).

Wie man es behebt (empfohlen)

- Verwenden Sie RCSDXL und fügen Sie Ihren direkten

.safetensorsLink inlora_pathein. - Kopieren Sie die Sampling-Werte aus Ihrer AI Toolkit Trainingskonfiguration (oder RunComfy Trainer → LoRA Assets Config):

width,height,sample_steps,guidance_scale,seed. - Halten Sie „extra Geschwindigkeit Stapel“ (LCM/Lightning/Turbo) aus dem Vergleich heraus, es sei denn, Sie haben mit ihnen trainiert/gesampelt.

(2) SDXL lora Schlüssel nicht geladen "lora_te2_text_projection.*"

Warum das passiert

Ihr LoRA enthält SDXL Text Encoder 2 Projektionsschlüssel, die Ihr aktueller Ladepfad nicht anwendet (leicht zu treffen, wenn Injektions-/Schlüsselzuordnung nicht mit SDXLs Dual-Encoder-Setup übereinstimmt).

Wie man es behebt (am zuverlässigsten)

- Verwenden Sie RCSDXL und laden Sie das LoRA über

lora_pathinnerhalb des Knotens (Pipeline-Ebenen-Injektion). - Halten Sie

lora_scalekonsistent und inkludieren Sie die gleichen Trigger-Tokens, die während des Trainings verwendet wurden. - Wenn Warnungen bestehen bleiben, versuchen Sie den genauen Basis-Checkpoint, der im Training verwendet wurde (nicht übereinstimmende SDXL-Varianten können fehlende/ignorierte Schlüssel erzeugen).

(3) Kann LoRAs mit SDXL nicht mehr verwenden

Warum das passiert

Nach dem Aktualisieren von ComfyUI / Benutzerdefinierten Knoten kann sich die SDXL LoRA-Anwendung ändern (Ladeverhalten, Caching, Speicherverhalten), wodurch zuvor funktionierende Diagramme fehlschlagen oder abweichen.

Wie man es behebt (empfohlen)

- Verwenden Sie RCSDXL um den SDXL Inferenzpfad stabil und trainingsangepasst zu halten.

- Leeren Sie das Modell/Knoten-Cache oder starten Sie die Sitzung nach Updates neu (besonders wenn sich das Verhalten nur ändert, nachdem Sie LoRA/Ladeeinstellungen angepasst haben).

- Zum Debuggen führen Sie zuerst einen minimalen Basis-Only SDXL Workflow aus, dann fügen Sie die Komplexität wieder hinzu.

(4) Scheduling Hook LoRA falscher CLIP-Cache beim nächsten Lauf nach Wertänderung

Warum das passiert

Hook/Scheduling-Workflows können zwischengespeicherten CLIP-Zustand nach Parameteränderungen wiederverwenden, was die Reproduzierbarkeit bricht und das LoRA-Verhalten von Lauf zu Lauf inkonsistent erscheinen lässt.

Wie man es behebt (empfohlen)

- Für training-übereinstimmende Inferenz bevorzugen Sie RCSDXL mit einfachem

lora_path/lora_scalezuerst (vermeiden Sie Hook/Scheduling-Schichten, bis die Basis übereinstimmt). - Wenn Sie Hook/Scheduling-Knoten verwenden müssen, leeren Sie den Cache (oder starten Sie neu) nach dem Ändern von Hook-Parametern und führen Sie dann mit dem gleichen Seed erneut aus.

(5) Ksampler-Fehler beim Versuch, LORA in Inpainting SDXL zu verwenden

Warum das passiert

Inpainting-Stapel patchen das Modell während des Samplings. Einige Benutzerdefinierte Knoten / Helper-Wrapper können mit LoRA-Patching in Konflikt geraten, wenn Sie Einstellungen während der Sitzung ändern, was KSampler/Inpaint-Arbeiter-Fehler auslöst.

Wie man es behebt (empfohlen)

- Bestätigen Sie, dass das LoRA in RCSDXL in einem einfachen txt2img Workflow funktioniert (Pipeline-Ebenen-Basis).

- Fügen Sie Inpainting zurück, eine Komponente nach der anderen. Wenn der Fehler nur nach Änderungen auftritt, starten Sie neu/leeren Sie den Cache, bevor Sie erneut ausführen.

- Wenn das Problem nur mit einem bestimmten Hilfsknoten auftritt, versuchen Sie den Vanilla-Inpaint-Pfad oder aktualisieren/deaktivieren Sie den konflikterzeugenden Benutzerdefinierten Knoten.

(6) Ich bekomme diesen Fehler clip fehlt: ['clip_l.logit_scale', 'clip_l.transformer.text_projection.weight']

Warum das passiert

Dies bedeutet normalerweise, dass die geladenen CLIP/Text-Encoder-Assets nicht mit dem SDXL-Checkpoint übereinstimmen, den Sie ausführen (fehlende erwartete SDXL CLIP-Gewichte), was auch das LoRA-Verhalten „abweichen“ lassen kann.

Wie man es behebt (empfohlen)

- Stellen Sie sicher, dass Sie ein korrektes SDXL-Checkpoint-Setup mit korrekten SDXL Text-Encodern/CLIP-Komponenten verwenden.

- Führen Sie dann LoRA-Inferenz über RCSDXL aus, sodass der SDXL-Konditionierungspfad durchgängig konsistent bleibt.

Führen Sie jetzt SDXL LoRA Inferenz aus

Öffnen Sie den RunComfy SDXL LoRA Inferenz Workflow, fügen Sie Ihr LoRA in lora_path ein und führen Sie RCSDXL für training-übereinstimmende SDXL LoRA Inferenz in ComfyUI aus.