FLUX.1 Dev LoRA Inferenz: AI Toolkit Trainingsvorschauen in ComfyUI abgleichen

FLUX.1 Dev LoRA Inferenz: training-übereinstimmende, minimal-schrittige Generierung in ComfyUI FLUX.1 Dev LoRA Inferenz ist ein einsatzbereiter RunComfy-Workflow zur Anwendung von AI Toolkit-trainierten FLUX.1 Dev LoRAs in ComfyUI mit Ergebnissen, die nahe an Ihren Trainingsvorschauen bleiben. Es basiert auf RC FLUX.1 Dev (RCFluxDev)—einem von RunComfy entwickelten, quelloffenen benutzerdefinierten Knoten, der die Generierung durch eine FLUX.1 Dev-spezifische Inferenz-Pipeline leitet (anstatt eines generischen Sampler-Diagramms) und dabei Ihren Adapter durch lora_path und lora_scale einfügt. Sie können verwandte Quellarbeiten in den runcomfy-com GitHub-Organisations-Repositories durchsuchen.

Verwenden Sie diesen Workflow, wenn sich Ihre AI Toolkit-Samples „richtig“ anfühlen, aber der Wechsel zu einem typischen ComfyUI-Diagramm dazu führt, dass dieselbe LoRA + Eingabeaufforderung im Stil, in der Stärke oder in der Komposition abweicht.

Warum FLUX.1 Dev LoRA Inferenz in ComfyUI oft anders aussieht

AI Toolkit Vorschauen werden durch eine modellspezifische Inferenz-Pipeline generiert. Viele ComfyUI-Diagramme rekonstruieren FLUX aus generischen Komponenten, sodass „die Zahlen abgleichen“ (Eingabeaufforderung/Schritte/Leitfaden/Samen) immer noch unterschiedliche Standardeinstellungen und LoRA-Anwendungsverhalten erzeugen kann. Diese „Trainingsvorschau vs. ComfyUI Inferenz“-Lücke ist normalerweise auf Pipeline-Ebene und nicht nur ein einzelner falscher Knopf.

Was der RCFluxDev benutzerdefinierte Knoten tut

RCFluxDev kapselt die FLUX.1 Dev Inferenz-Pipeline, die für AI Toolkit-Stil-Sampling verwendet wird, und wendet Ihre LoRA innerhalb dieser Pipeline an, sodass das Adapterverhalten für diese Modellfamilie konsistent bleibt. Pipeline-Quelle: `src/pipelines/flux_dev.py`

So verwenden Sie den FLUX.1 Dev LoRA Inferenz-Workflow

Schritt 1: Importieren Sie Ihre LoRA (2 Möglichkeiten)

- Option 1 (RunComfy Trainingsergebnis): RunComfy → Trainer → LoRA Assets → finden Sie Ihre LoRA → ⋮ → LoRA-Link kopieren

- Option 2 (AI Toolkit LoRA außerhalb von RunComfy trainiert):

Kopieren Sie einen direkten .safetensors Download-Link für Ihre LoRA und fügen Sie diese URL in lora_path ein.

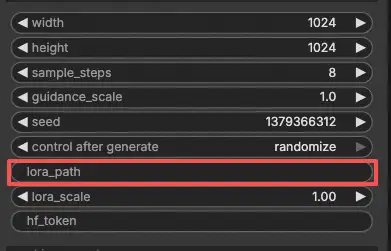

Schritt 2: Konfigurieren Sie den RCFluxDev benutzerdefinierten Knoten für FLUX.1 Dev LoRA Inferenz

- Wählen Sie im Workflow RC FLUX.1 Dev (RCFluxDev) aus und fügen Sie Ihre LoRA-URL (oder den Dateipfad) in

lora_pathein.

Wichtig (erforderlich für den ersten Lauf): Um diesen benutzerdefinierten Knoten auszuführen, müssen Sie (1) Zugang zu dem geschützten FLUX.1 Dev-Repo von Hugging Face haben, das Sie verwenden, und (2) Ihr Hugging Face-Token in hf_token einfügen:

- Gehen Sie auf die Hugging Face Modellseite, melden Sie sich an und klicken Sie auf Zugang anfordern / Zustimmen (einmal pro Repo).

- Erstellen Sie ein Hugging Face Benutzerzugangstoken mit Lese-Berechtigung unter huggingface.co/settings/tokens.

- Fügen Sie das Token in

hf_tokenauf RCFluxDev ein und führen Sie den Workflow erneut aus.

Schritt-für-Schritt-Anleitung: FLUX Hugging Face Token - Einrichtung & Fehlerbehebung

- Konfigurieren Sie dann den Rest der Einstellungen für FLUX.1 Dev LoRA Inferenz (alles in der Knoten-UI):

Tipp zur Trainingsausrichtung: Wenn Sie eine 1:1-Übereinstimmung anstreben, „stimmen Sie nicht nach Gefühl ab“—spiegeln Sie die Sampling-Werte aus dem AI Toolkit Trainings-YAML wider, das Sie für Vorschauen verwendet haben (insbesondere width, height, sample_steps, guidance_scale, seed). Wenn Sie auf RunComfy trainiert haben, öffnen Sie Trainer → LoRA Assets → Konfiguration und verwenden Sie die Vorschau-Einstellungen erneut.

prompt: Ihre Texteingabeaufforderung (einschließlich der Trigger-Tokens, die Sie während des Trainings verwendet haben, falls vorhanden)negative_prompt: optional; lassen Sie es leer, wenn Sie nicht mit negativen Werten gesampelt habenwidth/height: Ausgabeauflösung (übereinstimmend mit den Trainingsvorschauen beim Vergleich)sample_steps: Anzahl der Inferenzschritteguidance_scale: Leitwert, der von der FLUX.1 Dev-Pipeline verwendet wirdseed: Setzen Sie einen festen Samen, um zu reproduzieren; ändern Sie ihn, um Variationen zu erkundenlora_scale: LoRA-Stärke (beginnen Sie in der Nähe Ihres Vorschauwerts und passen Sie dann an)hf_token: Ihr Hugging Face Zugangstoken (erforderlich für geschützte FLUX-Repos)

Schritt 3: Führen Sie FLUX.1 Dev LoRA Inferenz aus

- Klicken Sie auf Queue/Run → SaveImage schreibt die Ergebnisse automatisch in Ihren ComfyUI-Ausgabeordner

Fehlerbehebung bei FLUX.1 Dev LoRA Inferenz

Die meisten FLUX.1 Dev „Vorschau vs. ComfyUI“ Probleme werden durch Pipeline-Unstimmigkeiten verursacht (wie das Modell geladen wird, wie die Konditionierung aufgebaut ist und wo/wie der Adapter injiziert wird), nicht nur durch einen einzigen falschen Parameter.

Für AI Toolkit-trainierte FLUX.1 Dev LoRAs ist der zuverlässigste Weg, training-übereinstimmendes Verhalten in ComfyUI wiederherzustellen, die Generierung über RC FLUX.1 Dev (RCFluxDev) auszuführen, was die Inferenz auf Pipeline-Ebene ausrichtet und Ihren Adapter konsistent über lora_path / lora_scale anwendet. Wenn Sie ein hartnäckiges Problem debuggen, beginnen Sie mit dem minimalen Referenzworkflow und fügen Sie Komplexität erst hinzu, nachdem Sie bestätigen, dass die Basis funktioniert.

(1)Hoher LoRA VRAM-Verbrauch nach dem Update

Warum das passiert

Mit FLUX.1 Dev sehen einige Setups einen großen VRAM-Anstieg, wenn bestimmte LoRAs angewendet werden (einschließlich LoRAs, die mit AI Toolkit trainiert wurden). Dies zeigt sich oft, wenn LoRAs durch generische Ladepfade injiziert werden oder wenn das Diagramm zusätzliches Modellkopieren / Neuladen verursacht.

Wie man es behebt (empfohlen)

- Führen Sie die Inferenz über RCFluxDev aus und laden Sie Ihren Adapter nur über

lora_pathim Knoten (vermeiden Sie das Mischen mehrerer LoRA-Ladeknoten für dasselbe Modell). - Halten Sie Ihren Vergleich fair: Stimmen Sie die Trainingsvorschau-Sampling-Werte (

width,height,sample_steps,guidance_scale,seed) ab, bevor Sie „es sieht komisch aus“ beurteilen. - Wenn Sie immer noch OOM erreichen: Reduzieren Sie zuerst

width/height(das ist normalerweise der größte Hebel für FLUX), dann reduzieren Sie Batch/zusätzliche Knoten und starten Sie die Sitzung neu, um alte Caches zu löschen. Außerdem können Sie eine leistungsstärkere GPU-Maschine auf RunComfy starten, um auszuführen.

(2)VAEDecode Gegeben groups=1, Gewicht der Größe [4, 4, 1, 1], erwarteter input[1, 16, 144, 112] soll 4 Kanäle haben, hat stattdessen 16 Kanäle

Warum das passiert

FLUX-Latenten und „klassische SD“-Latenten sind nicht austauschbar. Dieser Fehler ist das übliche Symptom für die Dekodierung von FLUX-Latenten mit einem nicht-FLUX VAE (ein VAE, das 4-Kanal-Latenten erwartet, während FLUX-Latenten 16-Kanal sein können).

Wie man es behebt

- Dekodieren Sie FLUX-Latenten nicht mit einem SD/SDXL VAE-Pfad.

- Verwenden Sie den RCFluxDev-Workflow, sodass der korrekte FLUX-Dekodierungspfad von Anfang bis Ende verwendet wird (Modellladen → Sampling → Dekodierung), anstatt generische VAE-Knoten aus anderen Pipelines zu mischen.

- Wenn Sie Diagramme manuell neu erstellen, überprüfen Sie doppelt, ob Sie die richtigen FLUX-Autoencoder-Assets verwenden und nicht einen übriggebliebenen SD/SDXL VAE.

(3)flux Modell funktioniert nicht, flux1-dev-fp8.safetensors

Warum das passiert

Dies tritt typischerweise auf, wenn ein FLUX .safetensors UNet mit dem falschen Ladetyp geladen wird (zum Beispiel, wenn es wie ein „Checkpoint“ behandelt wird, das ComfyUI wie SD/SDXL automatisch erkennen sollte).

Wie man es behebt

- Verwenden Sie den FLUX.1 Dev-Workflow (RCFluxDev) und lassen Sie den Workflow/Knoten die Modellladung übernehmen; übergeben Sie nur Ihre LoRA über

lora_path. - Laden Sie FLUX UNets nicht mit SD/SDXL-Checkpoint-Ladern.

- Wenn die Datei von einem Link heruntergeladen wurde, überprüfen Sie, ob es sich um ein vollständiges, gültiges

.safetensorshandelt (teilweise Downloads können verwirrende Erkennungsfehler auslösen).

Führen Sie jetzt FLUX.1 Dev LoRA Inferenz aus

Öffnen Sie den RunComfy FLUX.1 Dev LoRA Inferenz Workflow, setzen Sie lora_path, und generieren Sie mit RCFluxDev, um ComfyUI-Ergebnisse mit Ihren AI Toolkit Trainingsvorschauen abzustimmen.