1. 什麼是 ComfyUI Uni3C 工作流程?

Uni3C 工作流程將先進的 Uni3C (統一精確3D增強攝影機和人類動作控制)模型整合到 ComfyUI 環境中。由 DAMO Academy (Alibaba Group) 開發,Uni3C 解決了可控影片生成的根本挑戰,通過在單一3D增強框架中統一攝影機軌跡控制和人類動作控制。

基於 FLUX 擴散變壓器架構並由 Wan2.1 基礎模型驅動,Uni3C 引入了 PCDController - 一個即插即用的控制模組,利用從單眼深度估計衍生的未投影點雲。這種方法使 Uni3C 能在保持大規模影片擴散模型生成能力的同時,實現精確的攝影機控制。Uni3C 系統使用 SMPL-X 角色模型和全球3D世界指導,以實現環境場景和人類角色的空間一致影片生成。

2. Uni3C 的優勢:

- 統一3D增強框架: Uni3C 同時在一致的3D世界空間中處理攝影機軌跡和人類動作。

- PCDController 架構: 使用輕量級的0.95B參數控制器,Uni3C 利用單眼深度估計的未投影點雲,而不影響14B參數基礎模型。

- SMPL-X 整合: Uni3C 提供先進的3D人體模型支持。

- 幾何先驗利用: Uni3C 基於點雲的3D幾何理解提供了從單一圖像中獲得穩健的攝影機控制。

- 全球3D世界指導: Uni3C 確保環境點雲與 SMPL-X 角色之間的剛性變換對齊,以實現空間一致的影片生成。

3. 如何使用 Uni3C 工作流程

Uni3C 通過 影片參考提取 運作,該方法分析參考影片以理解攝影機移動和人類動作,然後將這些模式應用於從輸入圖像生成新影片。這種方法使得 Uni3C 能夠在不需要手動參數調整的情況下進行精確控制。

3.1 方法1:影片參考的攝影機控制

最適合:

從參考影片中提取攝影機移動並將其應用於新場景使用 Uni3C。

設置過程:

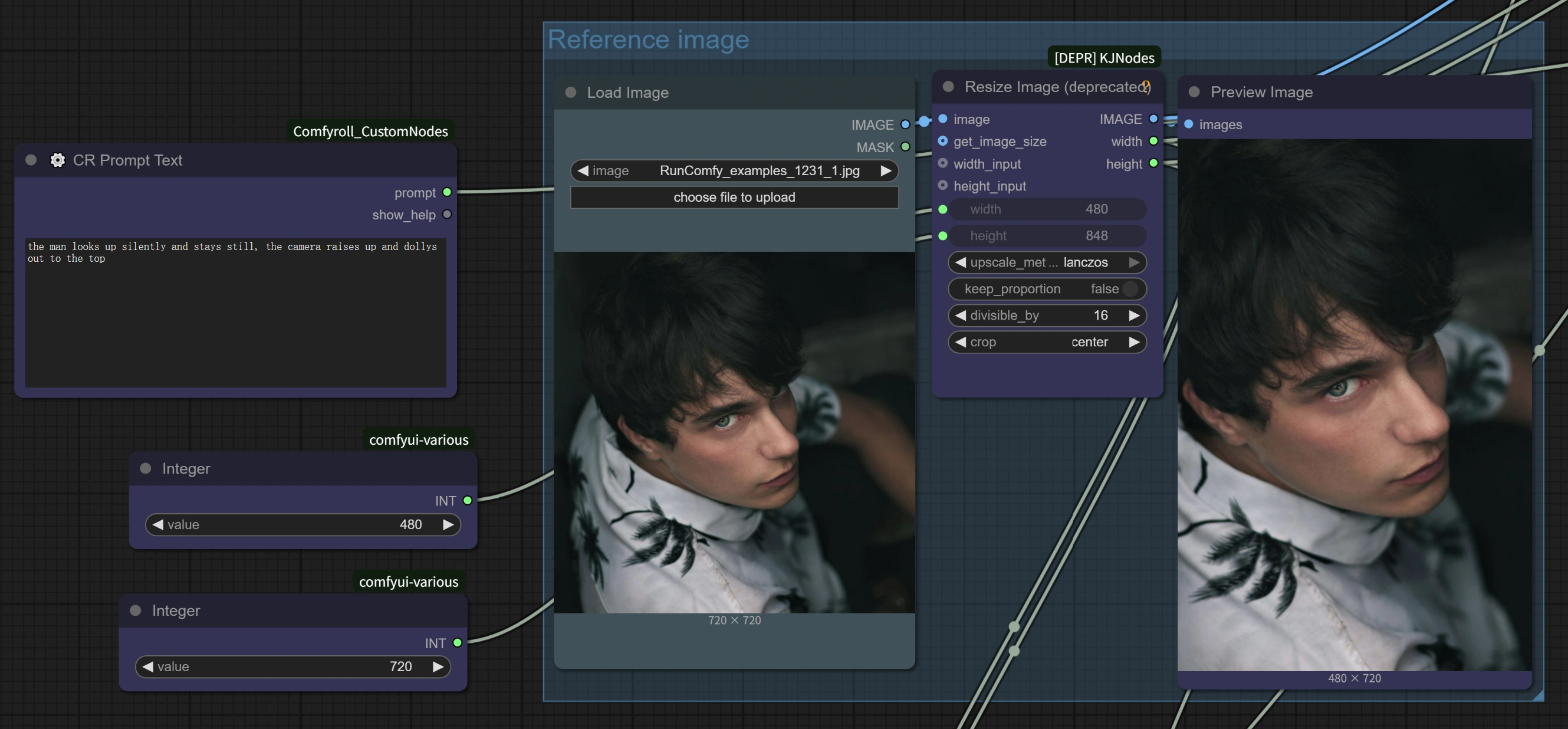

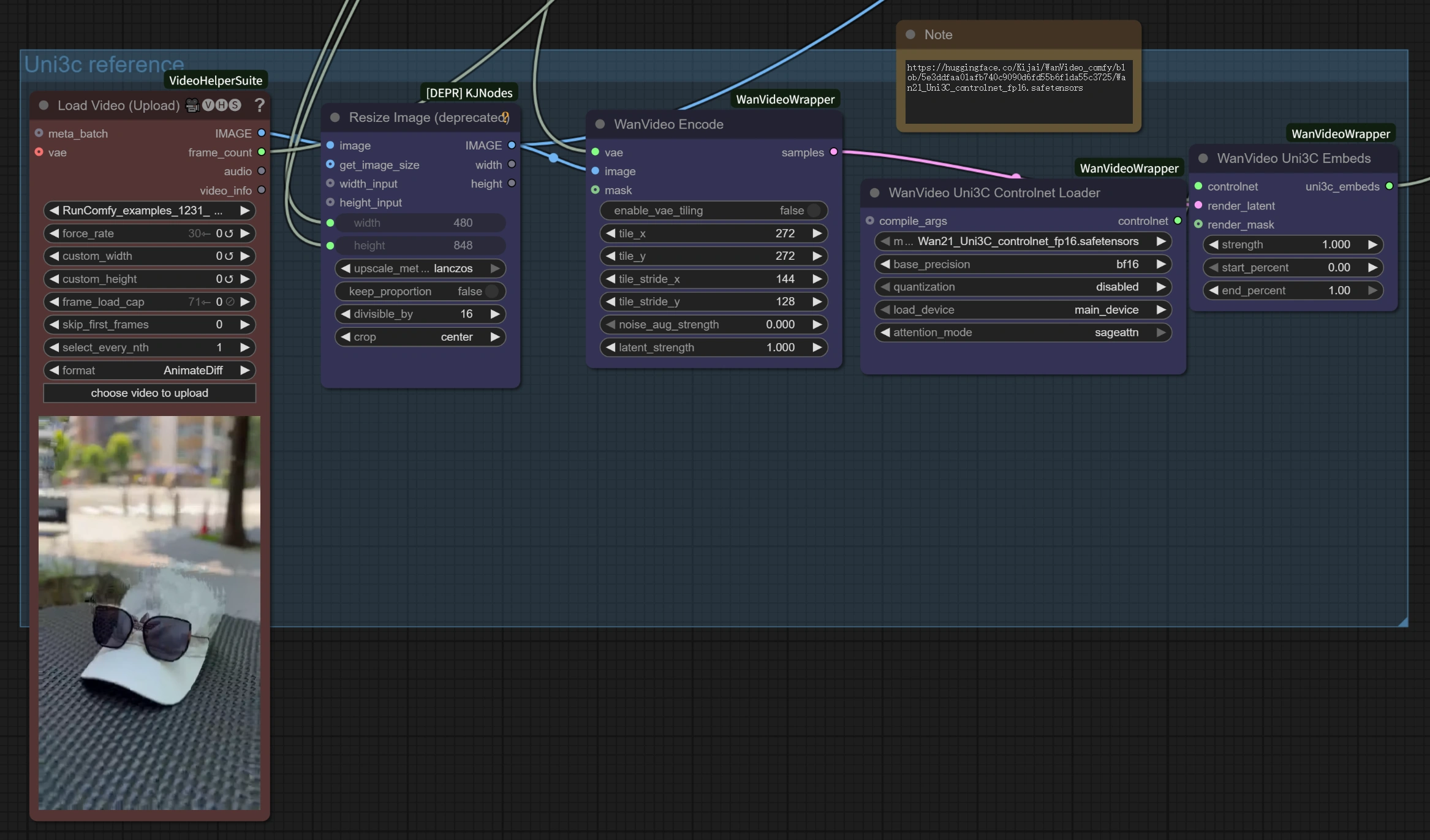

- 載入參考影片: 在

Load Video (Upload)節點上傳任何具有有趣攝影機移動的影片- 良好示例: 攝影機縮放到主題的影片,具有自然頭部移動的行走畫面,電影平移,軌道拍攝

- 關鍵點: 任何具有清晰攝影機移動的影片都適用 - 從手機錄像到專業電影攝影使用 Uni3C。

- 載入目標圖像: 在

Load Image節點上傳您的基礎圖像(適用於任何風格:寫實、動畫、藝術作品、AI生成) - 撰寫您的提示: 在 Uni3C 的文本提示區描述您所需的場景

- 配置設置: Uni3C 工作流程 包含4倍速度改進的優化參數

- 生成: 運行工作流程以將參考影片的攝影機移動轉移到您的場景中使用 Uni3C。

高級提示:

- 運動方向匹配: 當參考影片的運動方向與您打算的場景構圖對齊時,效果最佳使用 Uni3C。

- 提示協調: 撰寫與攝影機運動風格相輔相成的提示,以增強與 Uni3C 的一致性。

- 參考質量: 選擇具有穩定、清晰攝影機移動的參考影片,以獲得 Uni3C 的最佳效果。

3.2 方法2:人類動作轉移

最適合:

使用 Uni3C 將參考影片中的人類動作轉移到不同角色。

設置過程:

- 具有人體動作的參考影片: 上傳包含您想要轉移的人類動作的影片

- 目標角色圖像: 載入您想要動畫化的角色圖像

- 通過提示進行動作控制:

- 保留原始動作: 使用一般描述如 "一位女人走路" 來保持參考動作使用 Uni3C。

- 修改動作: 具體說明以改變動作:"一位女人梳頭" 將改變手勢,同時保留整體運動流暢使用 Uni3C。

主要優勢:

- 無需骨架: 與傳統動作捕捉不同,Uni3C 無需複雜的裝配即可理解人類運動。

- 細節保留: Uni3C 在動作轉移期間保留配件、髮型和服裝細節。

- 同步控制: 使用 Uni3C 從同一參考影片中同時轉移攝影機移動和人類動作。

性能優化架構: Uni3C 工作流程 實施了多種優化策略,包括將 PCDController 的隱藏大小從5120減少到1024,零初始化線性投影層,以及僅將攝影機控制特徵注入基礎模型的前20層。通過減少採樣步驟(10對比20+)和調整 CFG 指導比例進行流匹配優化,提供高達4倍的處理速度改進,並保持 Uni3C 的生成質量。

3.3 優化性能設置

4倍速度提升配置: 基於 Uni3C 的內置優化,以下設置提供顯著更快的處理速度:

WanVideo 取樣器節點設置:

Steps: 10(從默認20+減少)CFG: 1.0-1.5(速度-質量平衡優化)Shift: 5.0-7.0(作者推薦最佳結果為7,更快處理為5使用 Uni3C)Scheduler: UniPC(Uni3C 的優化調度器)

主要性能特徵:

- AnimateDiff 整合: Uni3C 利用最初為文本到影片設計的 AnimateDiff 優化,但對圖像到影片生成同樣有效。

- 智能參數減少: 由於圖像到影片從現有視覺內容開始,與文本到影片生成相比,所需的去噪步驟更少使用 Uni3C。

- 優化處理: Uni3C 使得70幀影片能在約4-5分鐘內完成(與原始設置的約27分鐘相比)。

質量與速度選項:

- 最大速度:Steps=10,CFG=1.0,Shift=5 → 約4分鐘完成70幀使用 Uni3C

- 平衡:Steps=10,CFG=1.5,Shift=7 → 約5分鐘完成70幀使用 Uni3C

- 更高質量:Steps=15,CFG=2.0,Shift=7 → 約8-10分鐘完成70幀使用 Uni3C

3.4 工作流程組件理解

參考影片處理部分:

Load Video (Upload): 接受 MP4、AVI 和其他標準影片格式作為 Uni3C 的運動參考。WanVideo Encode: 處理參考影片以提取攝影機軌跡和運動模式使用 Uni3C。Uni3C ControlNet Loader: 載入專門的 Uni3C 控制模型以理解運動。

圖像到影片生成部分:

Load Image: 您的目標圖像將由 Uni3C 動畫化為參考運動。WanVideo Image/ToVideo Encode: 將您的靜態圖像轉換為適合 Uni3C 影片生成的格式。WanVideo Sampler: 核心生成引擎,具有 Uni3C 的4倍速度改進設置。

輸出處理:

WanVideo Decode: 將生成的潛在影片從 Uni3C 轉換回可查看格式。Video Combine: 使用 Uni3C 正確的幀率和編碼組合最終影片文件。

4. 高級提示和最佳實踐

為 Uni3C 選擇參考材料

- 對於動作轉移: 選擇具有清晰、可見動作的影片,其中人物大部分在畫面內使用 Uni3C。

- 對於攝影機控制: 任何具有有趣視角或所需攝影機移動的影片使用 Uni3C。

- 最佳結果: 當參考運動方向與您預期的輸出方向匹配時使用 Uni3C。

Uni3C 的提示工程最佳實踐

- "不干擾" 原則: 對於純粹的動作轉移而不改變角色,使用簡單、一般的提示使用 Uni3C。

- 具體動作改變: 當您想要修改角色正在做的事情時,請詳細說明使用 Uni3C。

- 角色一致性: 集中提示以保持角色外觀使用 Uni3C。

Uni3C 的質量優化

- 運動一致性: 避免參考影片中的突然變化,以獲得更平滑的結果使用 Uni3C。

- 幀穩定性: 確保參考材料具有一致的照明和構圖使用 Uni3C。

5. 致謝

此工作流程由 Uni3C 驅動,由 DAMO Academy (Alibaba Group)、復旦大學 和 湖畔實驗室 開發。ComfyUI 的整合基於 kijai 的卓越工作(ComfyUI-WanVideoWrapper),並附加優化和工作流程設計,使這強大的 Uni3C 技術能夠被全球創作者使用。