Hunyuan video, модель ИИ с открытым исходным кодом, разработанная Tencent, позволяет легко создавать потрясающие и динамичные визуальные материалы. Модель Hunyuan использует передовую архитектуру и методы обучения для понимания и создания контента высокого качества, разнообразия движений и стабильности.

О рабочем процессе Hunyuan Video to Video

Этот рабочий процесс Hunyuan в ComfyUI использует модель Hunyuan для создания нового визуального контента путем объединения входных текстовых подсказок с существующим видео. Используя возможности модели Hunyuan, вы можете создавать впечатляющие видео переводы, которые плавно включают движение и ключевые элементы из исходного видео, при этом выравнивая выходной результат с вашим желаемым текстовым запросом.

Как использовать рабочий процесс Hunyuan Video to Video

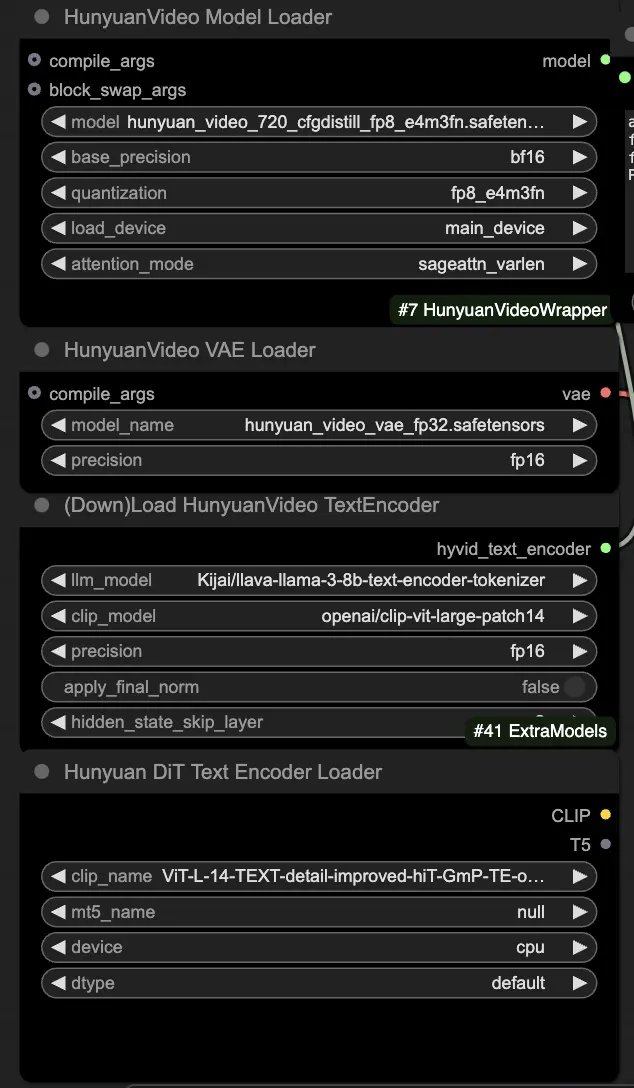

🟥 Шаг 1: Загрузка моделей Hunyuan

- Загрузите модель Hunyuan, выбрав файл "hunyuan_video_720_cfgdistill_fp8_e4m3fn.safetensors" в узле HyVideoModelLoader. Это основная трансформерная модель.

- Модель HunyuanVideo VAE будет автоматически загружена в узле HunyuanVideoVAELoader. Она используется для кодирования/декодирования кадров видео.

- Загрузите текстовый энкодер в узле DownloadAndLoadHyVideoTextEncoder. По умолчанию рабочий процесс использует LLM энкодер "Kijai/llava-llama-3-8b-text-encoder-tokenizer" и CLIP энкодер "openai/clip-vit-large-patch14", которые будут автоматически загружены. Вы также можете использовать другие CLIP или T5 энкодеры, которые работали с предыдущими моделями.

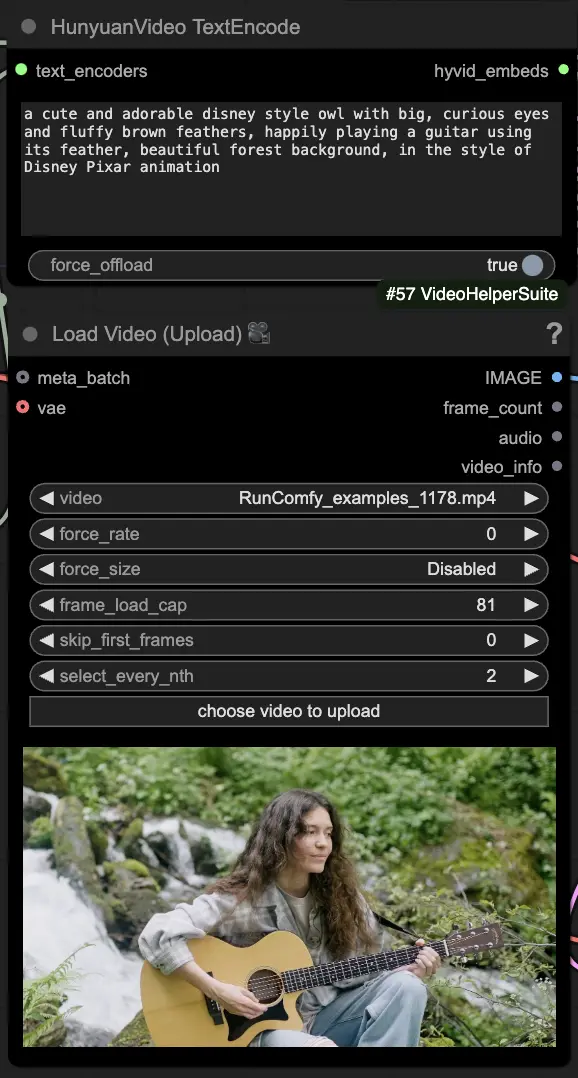

🟨 Шаг 2: Введите запрос и загрузите исходное видео

- Введите ваш текстовый запрос, описывающий визуальный материал, который вы хотите создать, в узле HyVideoTextEncode.

- Загрузите исходное видео, которое вы хотите использовать в качестве эталона движения, в узле VHS_LoadVideo.

- frame_load_cap: Количество кадров для генерации. При установке числа необходимо убедиться, что число минус один делится на 4; в противном случае будет вызвано ValueError, указывающее, что длина видео недопустима.

- skip_first_frames: Настройте этот параметр, чтобы контролировать, какая часть видео используется.

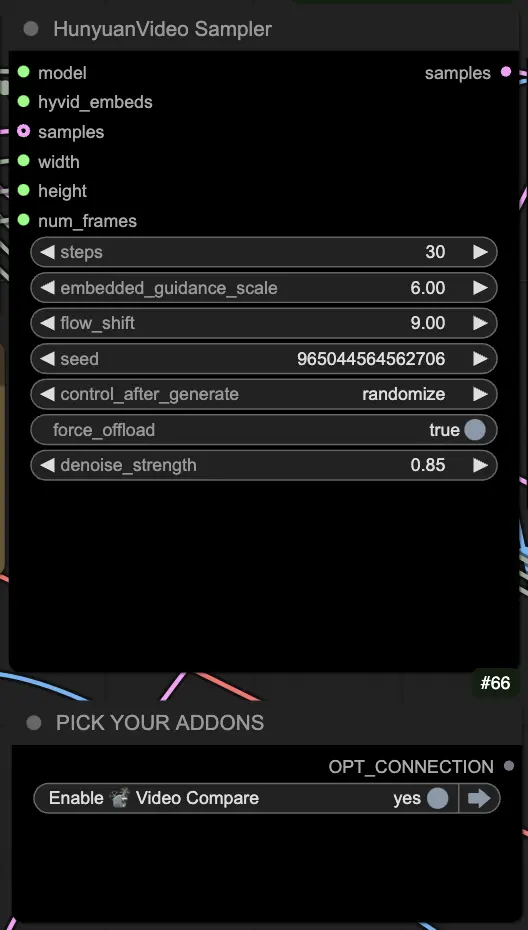

🟦 Шаг 3: Настройки генерации Hunyuan

- В узле HyVideoSampler настройте гиперпараметры генерации видео:

- Steps: Количество шагов диффузии на кадр, большее значение означает лучшее качество, но более медленную генерацию. По умолчанию 30.

- Embedded_guidance_scale: Насколько придерживаться запроса, более высокие значения ближе к запросу.

- Denoise_strength: Контролирует силу использования начального видео. Более низкие значения (например, 0.6) делают выход более похожим на начальное.

- Выберите дополнения и переключатели в узле "Fast Groups Bypasser", чтобы включить/отключить дополнительные функции, такие как сравнительное видео.

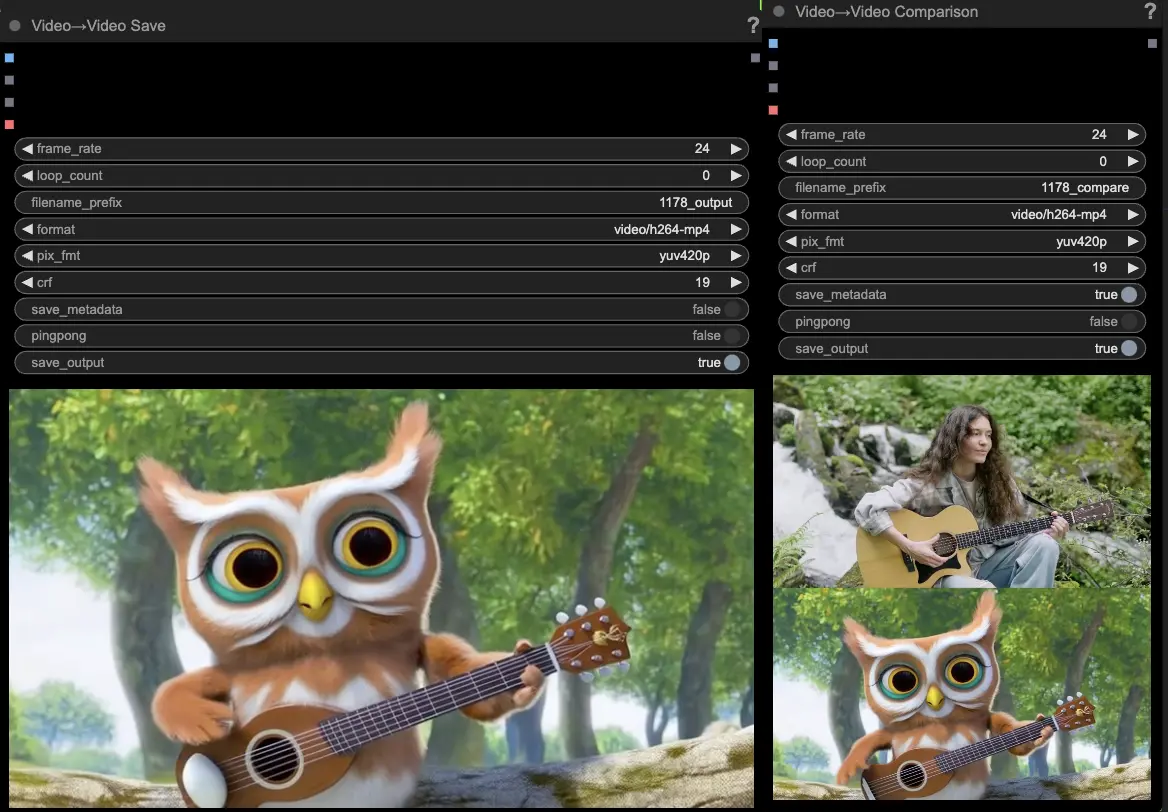

🟩 Шаг 4: Генерация видео Huanyuan

- Узлы VideoCombine по умолчанию сгенерируют и сохранят два выхода:

- Переведенное видео

- Сравнительное видео, показывающее исходное видео и сгенерированный результат

Настройка запроса и параметров генерации позволяет достичь впечатляющей гибкости в создании новых видео, движимых движением существующего видео, с использованием модели Hunyuan. Наслаждайтесь исследованием творческих возможностей этого рабочего процесса Hunyuan!

Этот рабочий процесс Hunyuan был разработан Black Mixture. Пожалуйста, посетите канал Black Mixture на YouTube для получения дополнительной информации. Особая благодарность Kijai за обертки Hunyuan узлы и примеры рабочих процессов.