Wan 2.1 Fun | 画像から動画、テキストから動画へのAI生成

Wan 2.1 Fun 画像から動画、テキストから動画は、静止ビジュアルと純粋な想像力を生き生きとさせる非常に多用途なAIビデオ生成ワークフローを提供します。Wan 2.1 Funモデルファミリーによって駆動されるこのワークフローは、ユーザーが単一の画像をアニメーション化して完全なビデオにしたり、テキストプロンプトから直接モーションシーケンス全体を生成したりすることを可能にします—初期の映像は必要ありません。

数語から超現実的な夢の風景を作り上げたり、コンセプトアートを生きた瞬間に変えたりする場合でも、このWan 2.1 Funセットアップは、一貫性のあるスタイライズされたビデオ出力を簡単に生成できます。スムーズなトランジション、柔軟な期間設定、多言語プロンプトをサポートし、Wan 2.1 Funはストーリーテラー、デジタルアーティスト、視覚的な限界を押し広げるクリエイターに最適です。

なぜWan 2.1 Fun 画像から動画、テキストから動画を使用するのか?

Wan 2.1 Fun 画像から動画、テキストから動画ワークフローは、画像または単純なテキストプロンプトから高品質のビデオを生成するための簡単で表現力豊かな方法を提供します:

- 自動トランジションとエフェクトで単一の画像をモーションに変換

- スマートフレーム予測を使用してテキストプロンプトから直接ビデオを生成

- 視覚的な物語を制御するためのInP(開始/終了フレーム予測)を含む

- スケーラブルな品質と速度のための1.3Bおよび14Bモデルバリアントと連携

- クリエイティブなアイデア創出、ストーリーテリング、アニメーションシーン、映画的シーケンスに最適

シーンをゼロから視覚化する場合でも、静止画像をアニメーション化する場合でも、このWan 2.1 Funワークフローは、Wan 2.1 Funモデルを使用して迅速でアクセス可能、かつ視覚的に印象的な結果を提供します。

Wan 2.1 Fun 画像から動画、テキストから動画の使用方法

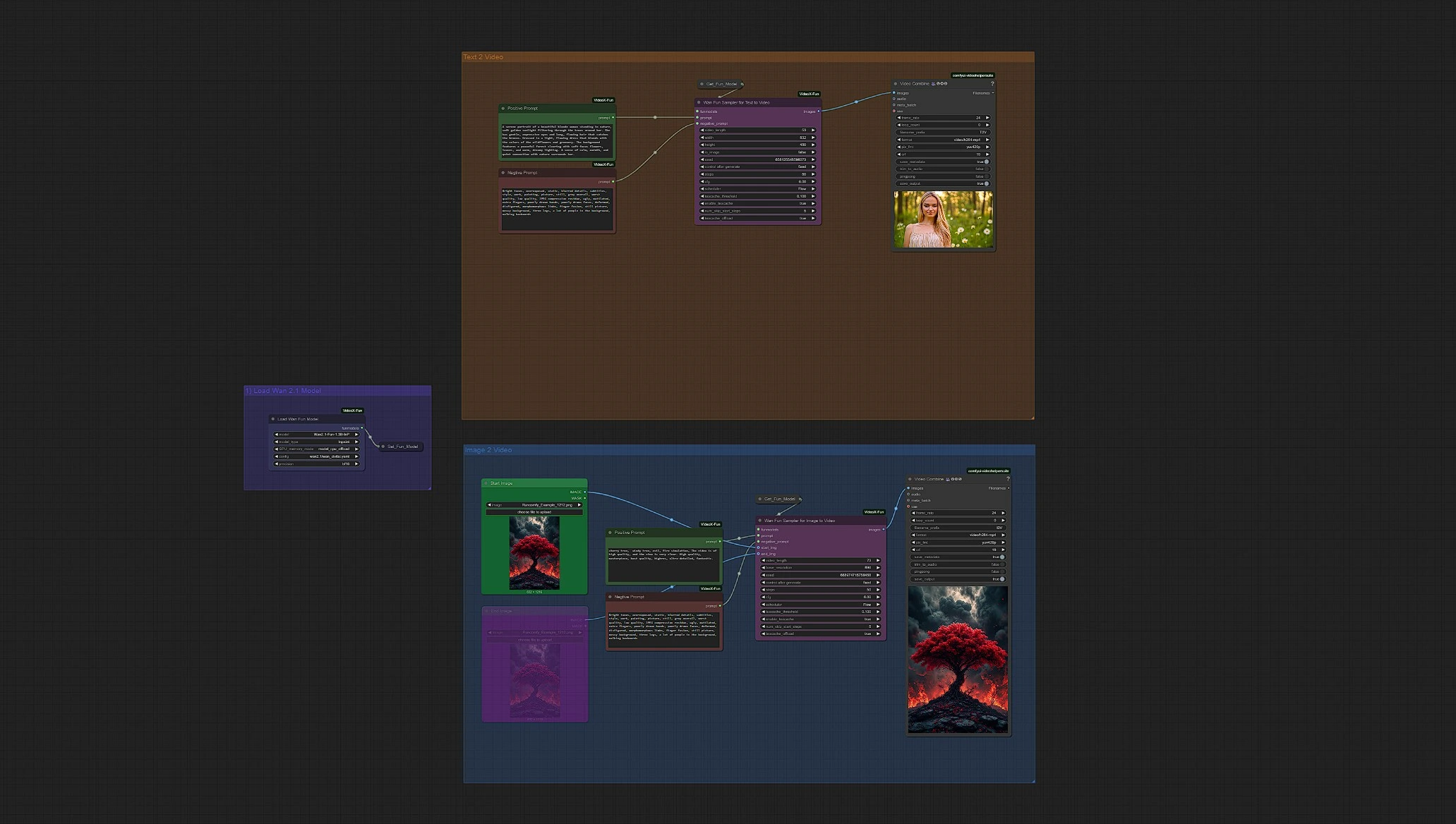

Wan 2.1 Fun 画像から動画、テキストから動画の概要

Load WanFun Model: 適切なWan 2.1 Funモデルバリアント(1.3Bまたは14B)をロードEnter Prompts or Upload Image: テキストプロンプトと画像入力の両方をサポートし、それぞれのグループを使用Set Inference Settings: フレーム、期間、解像度、モーションオプションを調整Wan Fun Sampler: WanFunを使用して開始/終了予測と時間的一貫性を維持Save Video: サンプリング後にビデオが自動的にレンダリングされ保存されます

クイックスタートステップ:

- Load Model Groupで

Wan 2.1 Funモデルを選択 - 生成をガイドするためにポジティブおよびネガティブプロンプトを入力

- 入力モードを選択:

- 画像から動画グループに画像をアップロード

- またはテキストから動画グループでテキストプロンプトのみを使用

Wan Fun Samplerノードで設定を調整(フレーム、解像度、モーションオプション)Queue Promptボタンをクリックしてワークフローを実行- Video Saveノード(

Outputsフォルダ)から最終的なWan 2.1 Funビデオを表示およびダウンロード

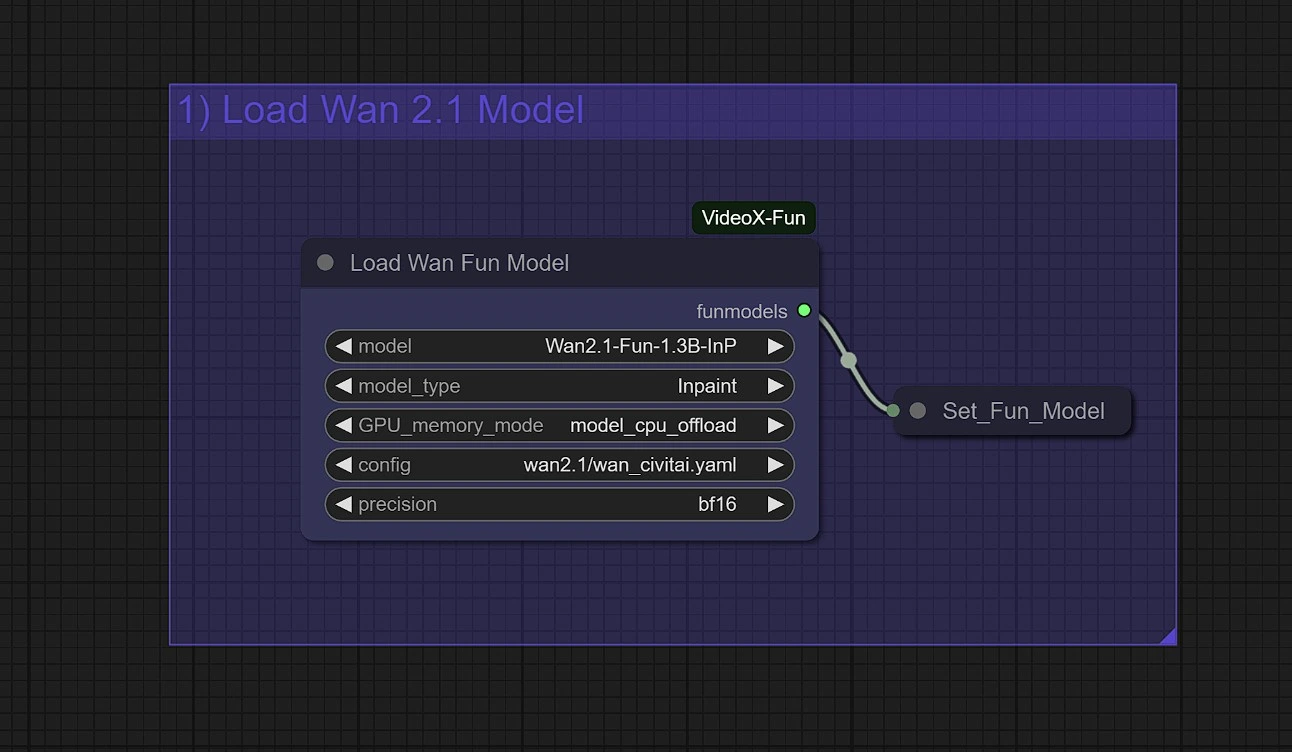

1 - WanFunモデルをロード

タスクに適したモデルバリアントを選択します:

Wan2.1-Fun-Control (1.3B / 14B): 深度、Canny、OpenPose、軌道制御を伴うガイド付きビデオ生成用Wan2.1-Fun-InP (1.3B / 14B): 開始および終了フレーム予測でテキストから動画用

Wan 2.1 Fun用メモリーチップス:

- 1.3B Wan 2.1 Funで高速生成するには

model_cpu_offloadを使用 - 14B Wan 2.1 FunでGPUメモリ使用量を削減するには

sequential_cpu_offloadを使用

2 - プロンプトを入力

選択した適切なグループ、画像から動画グループまたはテキストから動画グループで、ポジティブおよびネガティブプロンプトを入力します。

- ポジティブプロンプト:

- ビデオの動き、ディテール、および深さを駆動

- 記述的で芸術的な言語を使用すると最終的なWan 2.1 Fun出力を向上させることができます

- ネガティブプロンプト:

- "ぼかし、変異、変形、歪み、暗くて固体、コミック。" のような長いネガティブプロンプトを使用すると、Wan 2.1 Funの安定性が向上します

- "静か、固体" のような単語を追加すると、Wan 2.1 Funビデオの動的性が向上します

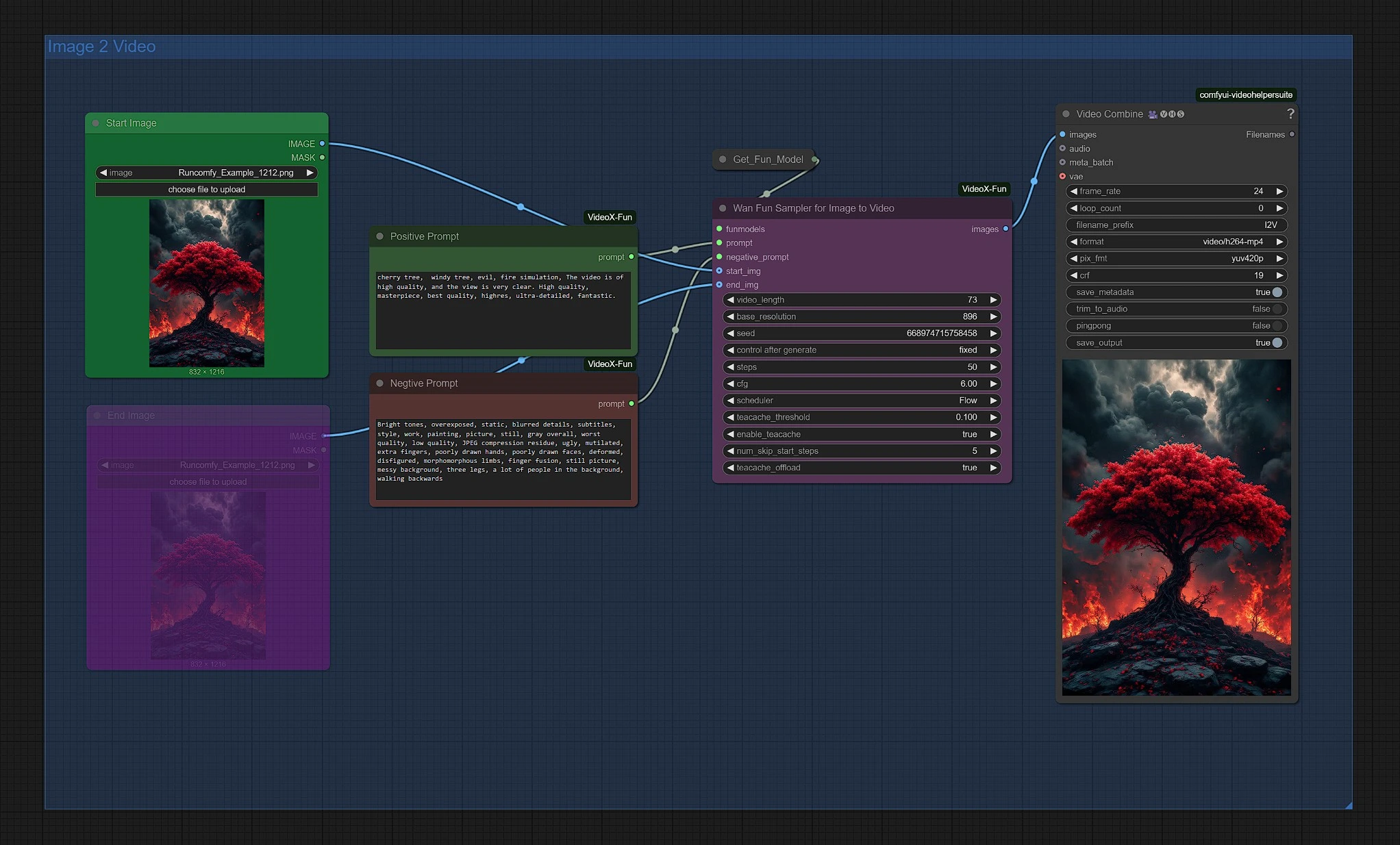

3 - Wan 2.1 Funによる画像から動画グループ

開始画像をアップロードしてWan 2.1 Fun生成を開始します。Wan Fun Samplerノードで解像度と期間を調整できます。

[オプション] 終了画像ノードのミュートを解除します。この画像は最終画像として機能し、間の画像はWan 2.1サンプラーを通じてレンダリングされます。

最終的なWan 2.1 Funビデオは、Video SaveノードのOutputsフォルダにあります。

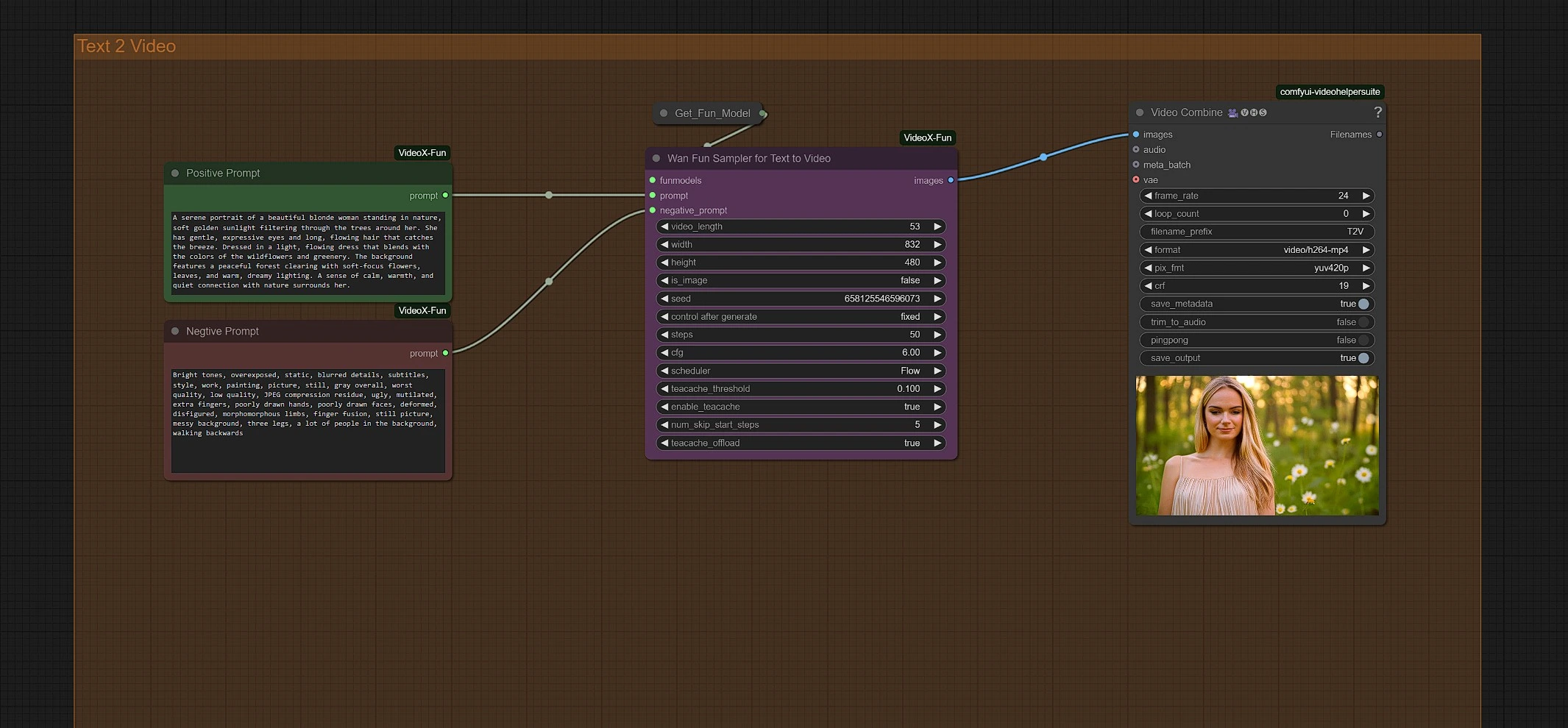

4 - Wan 2.1 Funによるテキストから動画グループ

プロンプトを入力して生成を開始します。Wan Fun Samplerノードで解像度と期間を調整できます。

最終的なWan 2.1 Funビデオは、Video SaveノードのOutputsフォルダにあります。

Acknowledgement

Wan 2.1 Fun 画像から動画、テキストから動画ワークフローは、bubbliiiingとhkunzheによって開発され、プロンプトベースのビデオ生成をよりアクセスしやすく柔軟にしました。彼らの貢献により、静止画像と純粋なテキストの両方を使用して、最小限のセットアップで最大のクリエイティブな自由を持つ動的でスタイライズされたビデオを作成できます。AIビデオ生成分野における彼らの革新と継続的な影響に心より感謝します。