重要な注意: サポートされているワークフローとモデル

RunComfy のクラウドは、Reallusion AI Render 用の FLUX.1-dev ControlNet に限定されていません。チェックポイント、ControlNets、LoRAs、VAEs、および関連ノードを交換して、以下にリストされた追加の Reallusion ワークフロー および モデル を実行できます。

- FusionX WanVACE

- Wan2.1 Fun 1.3B Control

- Wan2.1 VACE 1.3B

- Wan2.1 VACE FusionX 14B

- Flux.1 Dev ControlNet

...

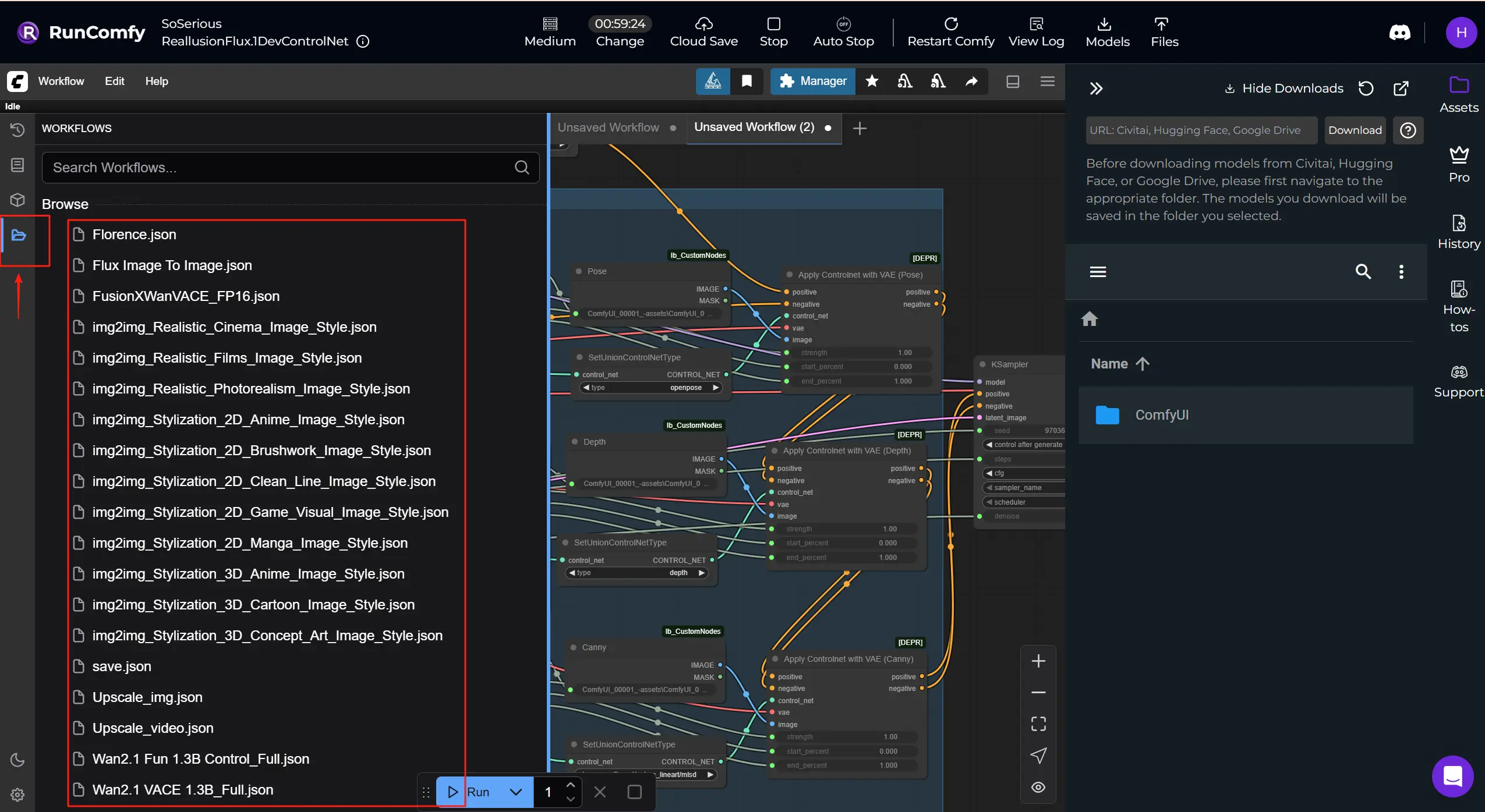

より多くの Reallusion ComfyUI ワークフローを取得する: RunComfy でダウンロードして実行できるワークフローテンプレートをさらに入手してください。「Workflows」ボタンをクリックして、さらに試してください。

1. Reallusion AI Render とは

Reallusion は、映画/TV、ゲーム、アーキビズ、デジタルツイン、AI シミュレーションで使用される、iClone や Character Creator で知られるリアルタイム 2D/3D キャラクター作成およびアニメーションソフトウェアの開発者です。

Reallusion AI Render は、3D アニメーションソフトウェアと AI によるコンテンツ生成ワークフローのシームレスな橋渡しです。 iClone または Character Creator から直接レイアウト、ポーズ、カメラ、または照明データを受け取り、そのコンテキストを使用して ComfyUI 内でリッチな詳細画像やビデオを自動的に作成する AI レンダーアシスタントと考えてください。この統合は、Reallusion のリアルタイム 3D 作成ツールと ComfyUI の柔軟でノードベースの AI 処理アーキテクチャを組み合わせ、画像およびビデオベースのストーリーテリングをアーティスト主導で 3D データによって厳密にガイドされるものにします。Reallusion AI Render は、深度マップ、ノーマルマップ、エッジ検出 (Canny)、3D ポーズデータ、スタイル画像を IPAdapter 経由でマルチモーダル入力としてサポートします。また、カスタム Core、ControlNet、Additional Image、Upscale ノードのおかげで、アニメーターや開発者は、ComfyUI を手動で操作することなく、プラグイン制御下で一貫性のあるスタイライズされた高品質の出力をレンダリングできます。

構造化された指示を解釈し、それを内部パラメータプリセットと組み合わせることで、Reallusion AI Render はプロンプトベースの生成を正確で再現可能な生産プロセスに変えます。 一貫性のあるキャラクター、きめ細かいスタイル制御、フレーム正確な AI 支援シーケンスレンダリングを必要とする映画、ゲーム、または商業ストーリーテリングに最適です。

2. Reallusion AI Render ワークフローの主な機能と利点

直接プラグイン統合: Reallusion AI Render は、専用プラグインを介して iClone および Character Creator とネイティブに連携し、プロダクションツールを離れることなくリアルタイムのフィードバックと制御を可能にします。

3D ガイドコントロールネット: Reallusion AI Render の ControlNet ノードを使用して、3D シーンから深度、ポーズ、ノーマル、およびエッジデータを ComfyUI にシームレスにマッピングし、映画のような一貫性とショットレベルのコントロールを達成します。

マルチイメージスタイリングサポート: Reallusion AI Render ワークフローには、柔軟なスタイルブレンドとリファレンスベースのディレクションをサポートする Additional Image ノードが含まれており、ルックスを再利用したり、高度な IP 適応レンダリングを実行したりするのが簡単です。

スマートアップスケールワークフロー: 専用の UpscaleData ノードにより、クリエイターは Reallusion AI Render プラグイン内で出力解像度を定義でき、最終レンダリングがプロジェクト仕様と一致するようにします。

フルワークフロー自動化: 一般的な ComfyUI ワークフローとは異なり、Reallusion AI Render は自動化のために設計されており、モデル、サンプリングステップ、CFG、オーディオ同期などのパラメータがプログラムで渡され、バッチレンダリングまたはカスタムプリセットの準備ができています。

プロダクション対応のキャラクターの一貫性: LoRA トレーニングおよび IP 作成ツールと組み合わせることで、Reallusion AI Render は、ビデオシーケンス全体での顔の一貫性と視覚的忠実度を保持し、AI によるストーリーテリングに最適です。

3. ComfyUI で Reallusion AI Render を使用する方法

AI Render を RunComfy マシンに接続する方法: ⭐重要

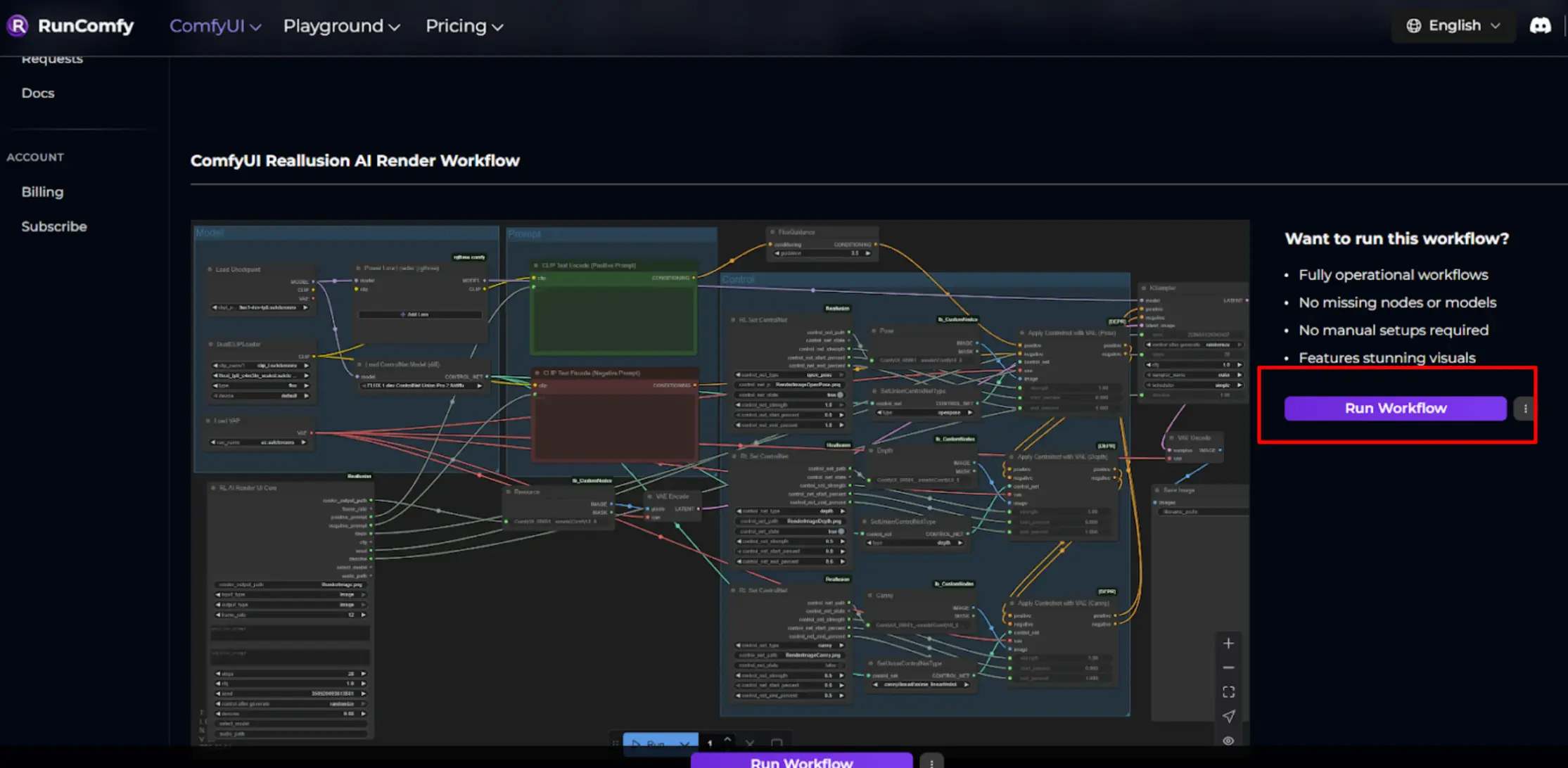

ステップ 1. _Run Workflow_ をクリックしてマシンを開始します。

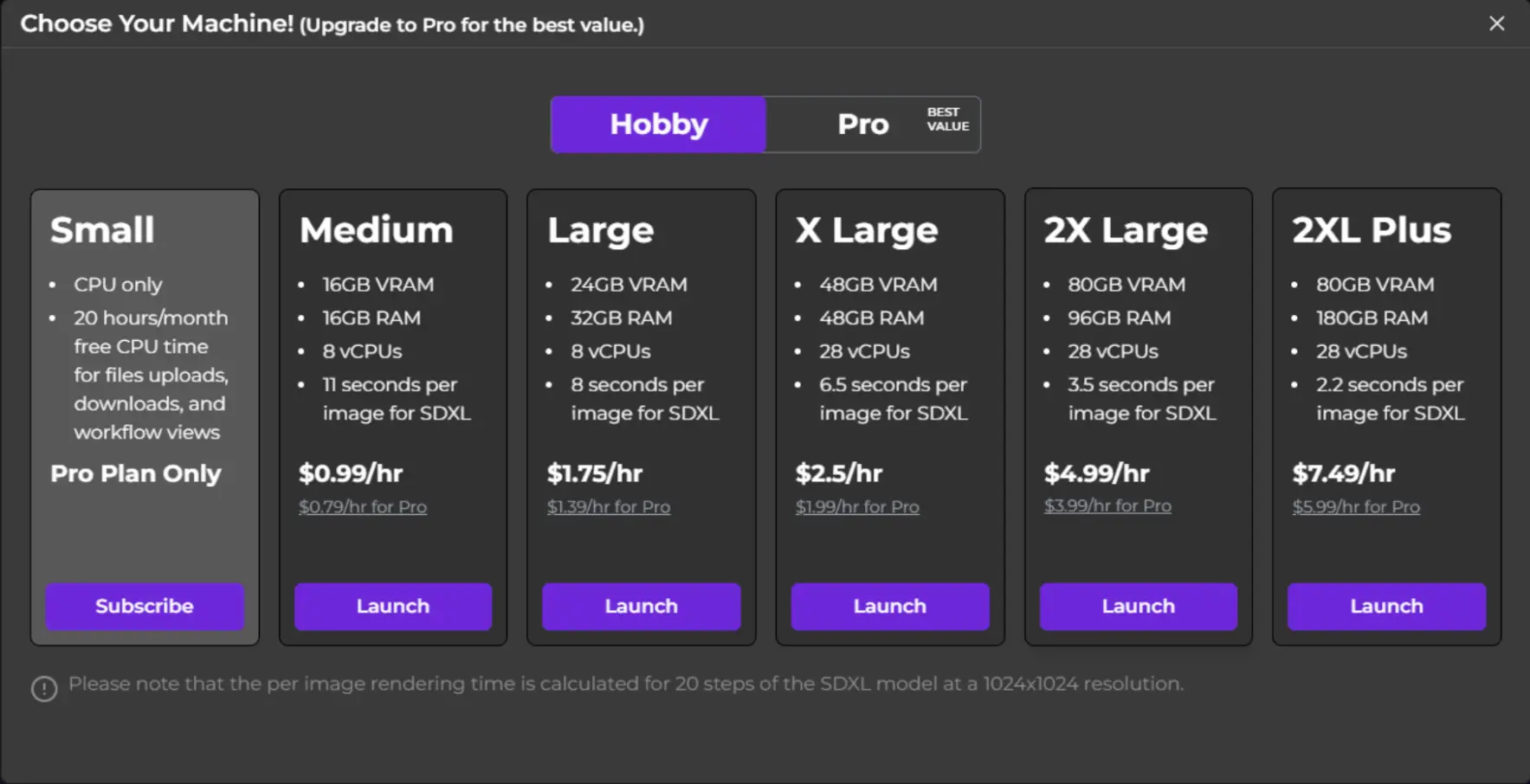

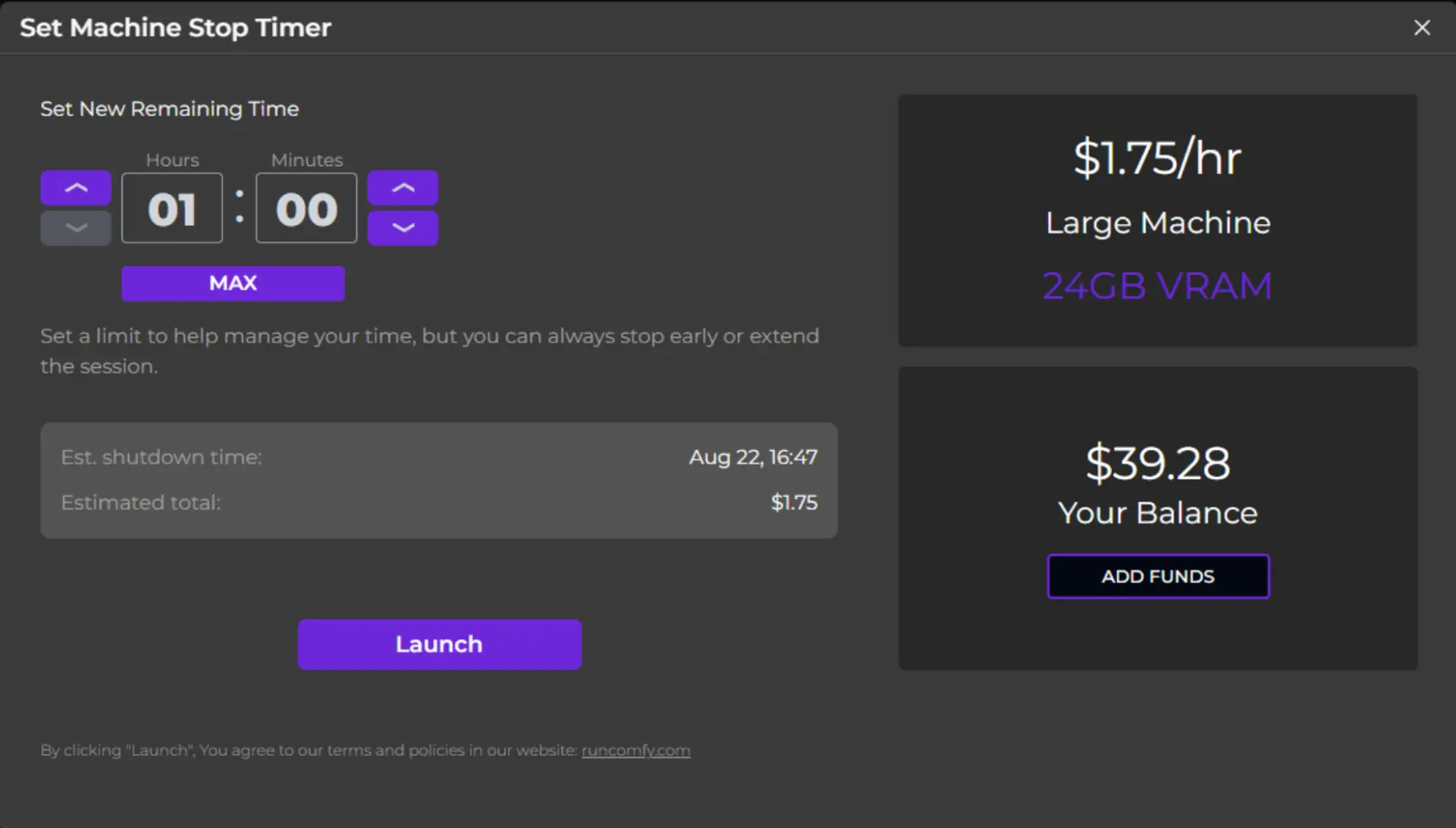

ステップ 2. マシンのティアを選択し、使用時間を設定します。

ステップ 3. ComfyUI が完全に読み込まれるのを待って、マシンが初期化されるのを待ちます。

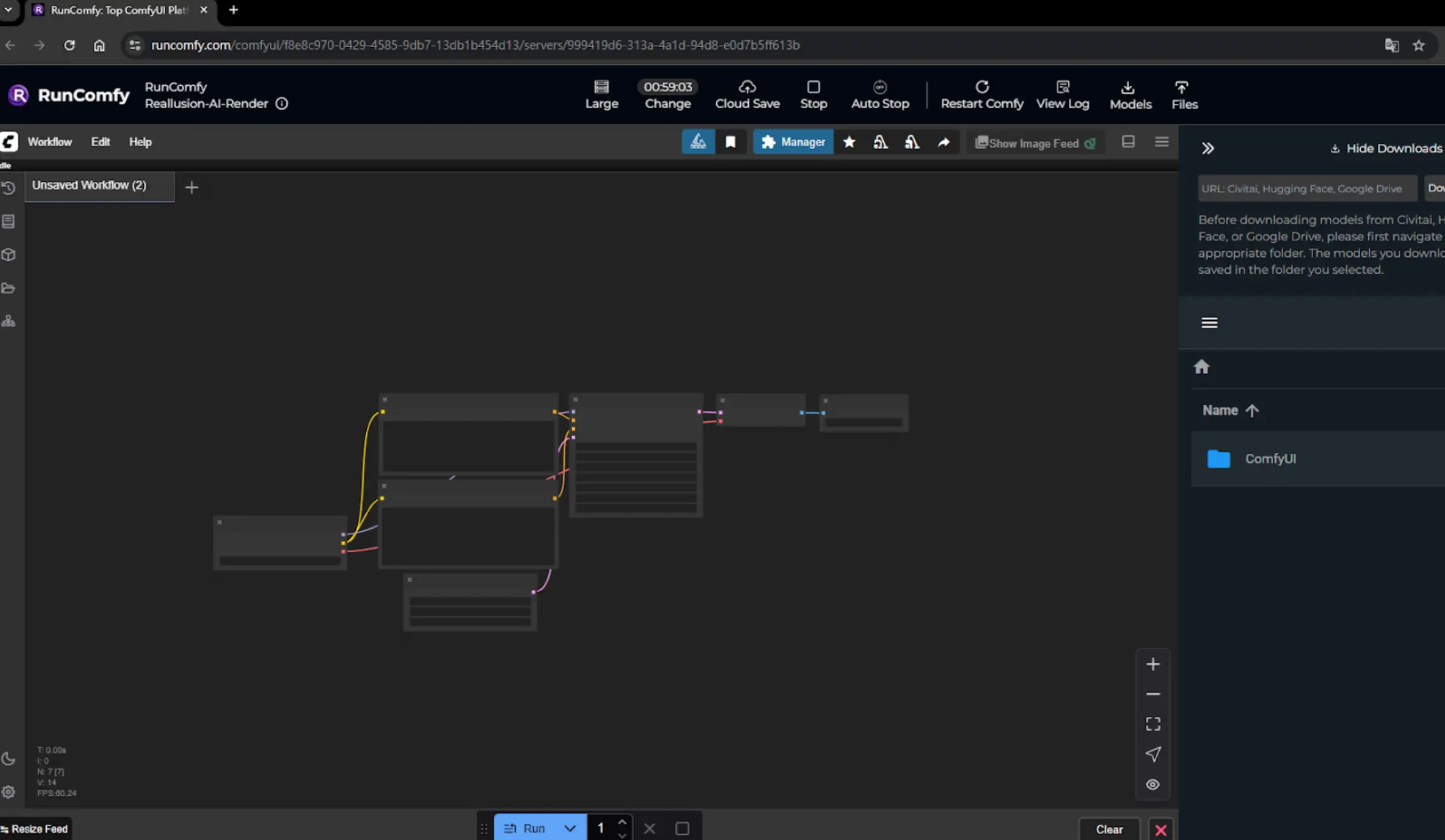

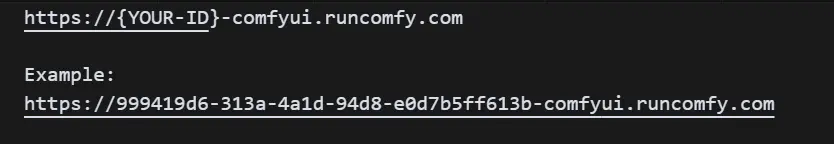

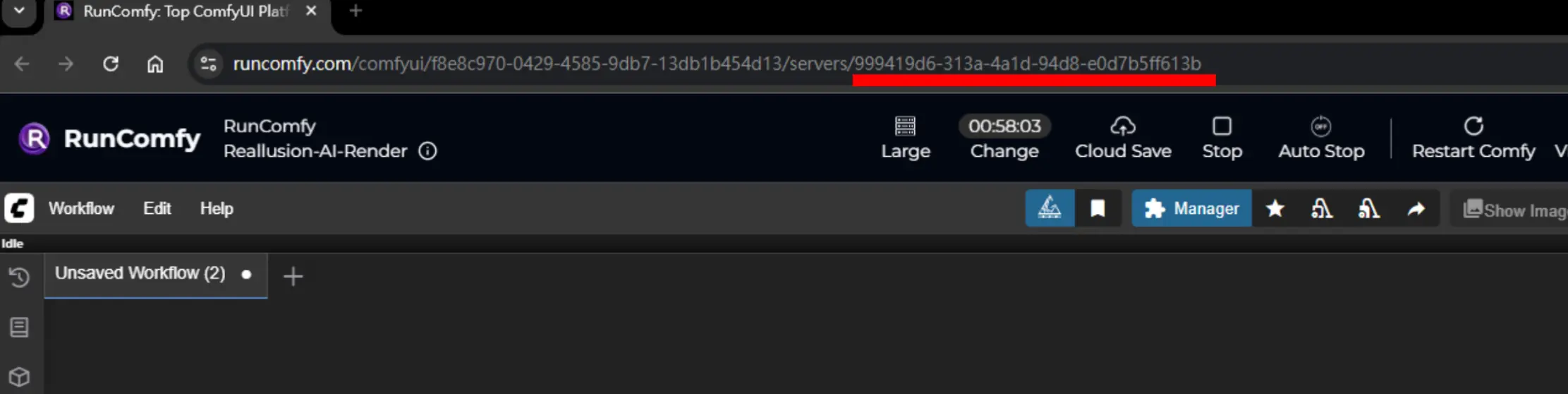

ステップ 4. AI Render を RunComfy マシンに接続します。

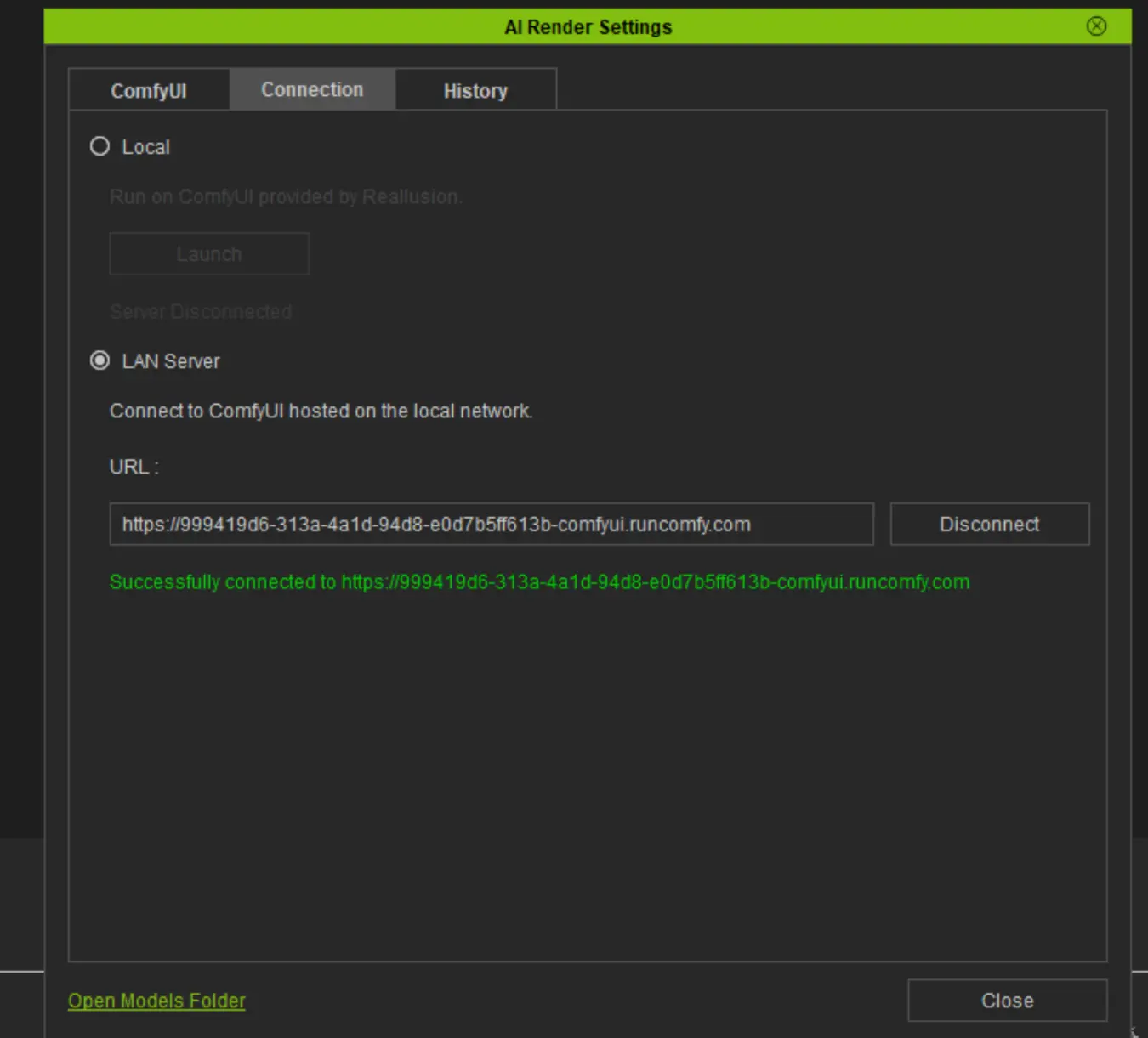

表示された RunComfy URL の最後の部分をコピーし、AI Render 設定 -> サーバーモードに移動し、次の形式で URL を入力します:

⚠️ 注意: この ID は新しいマシンを開始するたびに変わります。

"Successfully connected" と表示されたら、接続が完了し、使用を開始できます。

ノード必須設定

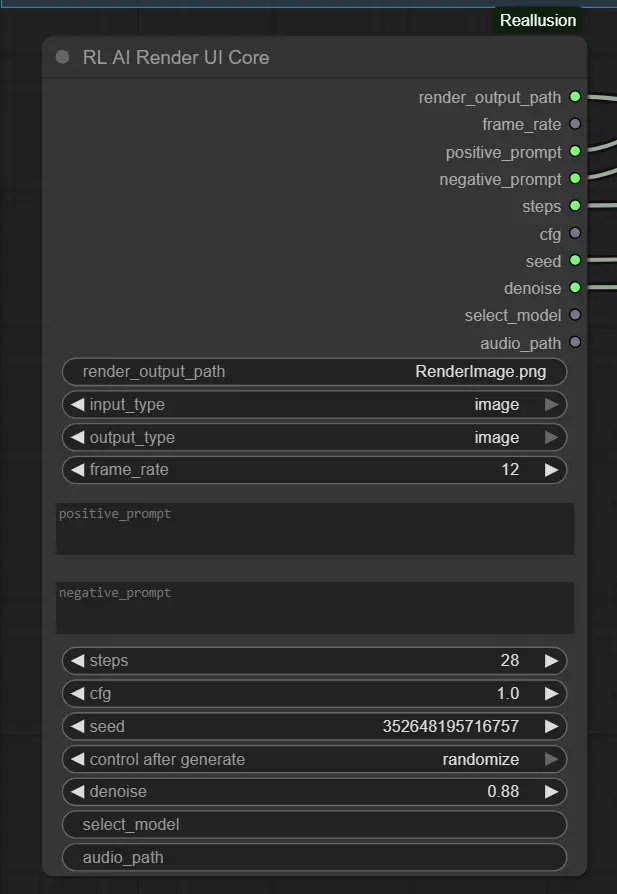

1. プロンプト & クオリティ設定 – RL AI Render UI Core Node このノードは、AI Render プラグインからの主なパラメータを収集します。

- positive_prompt / negative_prompt: 欲しい特徴と欲しくない特徴を記述します(デフォルト: 空)。

- steps: 画像を洗練するための反復回数。バランスの取れた品質/速度のために 28 から始めます。

- cfg: スタイルの遵守。柔軟性のために 1.0 を使用し、プロンプトの影響を強くしたい場合はわずかに増やします。

- denoise: 画像をどれだけ変更するかを制御します。スタイライズされた更新には 0.88 を使用し、微妙な変更には低くします。

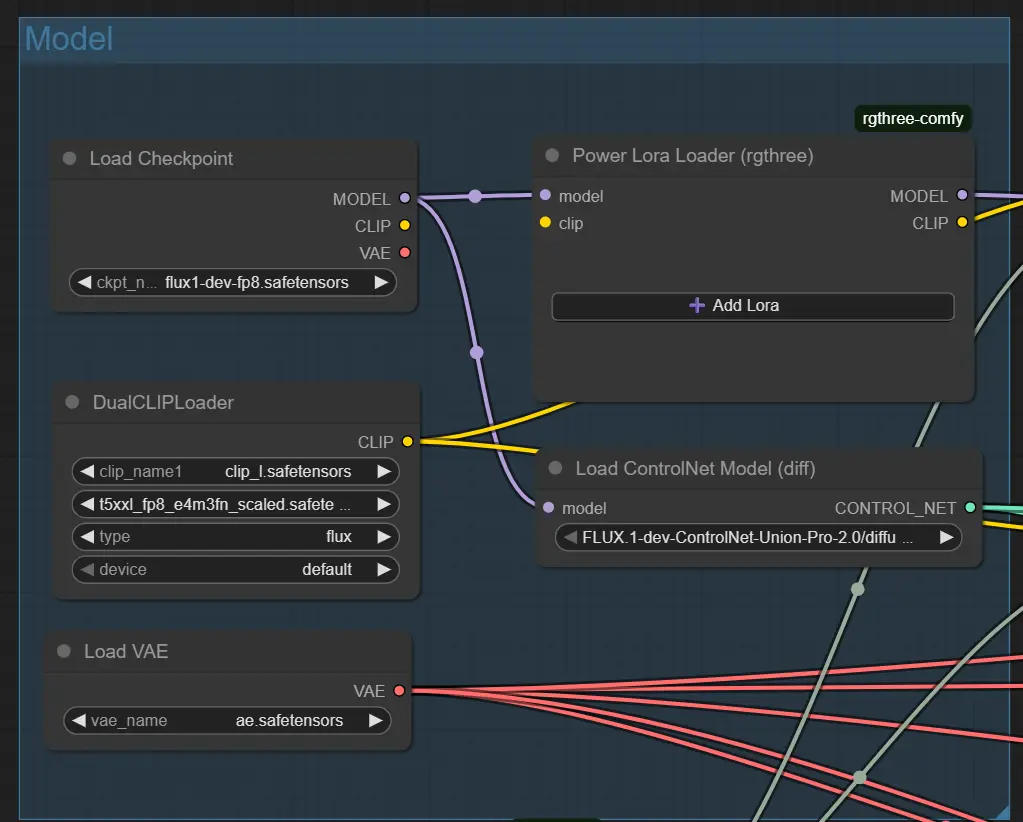

2. ベースモデル設定 – Load Checkpoint Node

これは、選択したモデル(例: Flux 1 Dev ControlNet)をロードします。

ckpt_name: スタイルが期待するモデルに一致する必要があります(デフォルト: flux1-dev-fp8.safetensors)。

IPAdapter または ControlNet をサポートするモデルを使用すると、最良の結果が得られます。

3. 構造ガイダンス – ControlNet Nodes (Pose, Depth, Canny) 各 ControlNet ノードは特定の入力ファイル(例: ポーズ画像)をロードします。コントロールが有効な場合にのみアクティブです。

- control_net_strength: 影響のレベル(ポーズは通常 1.0、深度は通常 0.5 を使用します)。

- ガイダンスが生成中にフェードインするタイミングを制御するために start_percent と end_percent を調整します。 <img src="https://cdn.runcomfy.net/workflow_assets/1270/readme03.webp" alt="Reallusion AI Render - Workflow ControlNet" width="350"/>

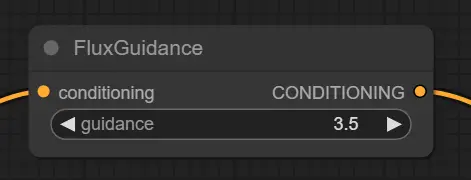

4. プロンプトコンディショニング – Flux Guidance Node プロンプトが画像生成をどのように形作るかを調整します。

- guidance: プロンプトに対して厳密であるほど高くなります。良いバランスのために 3.5 を推奨します。

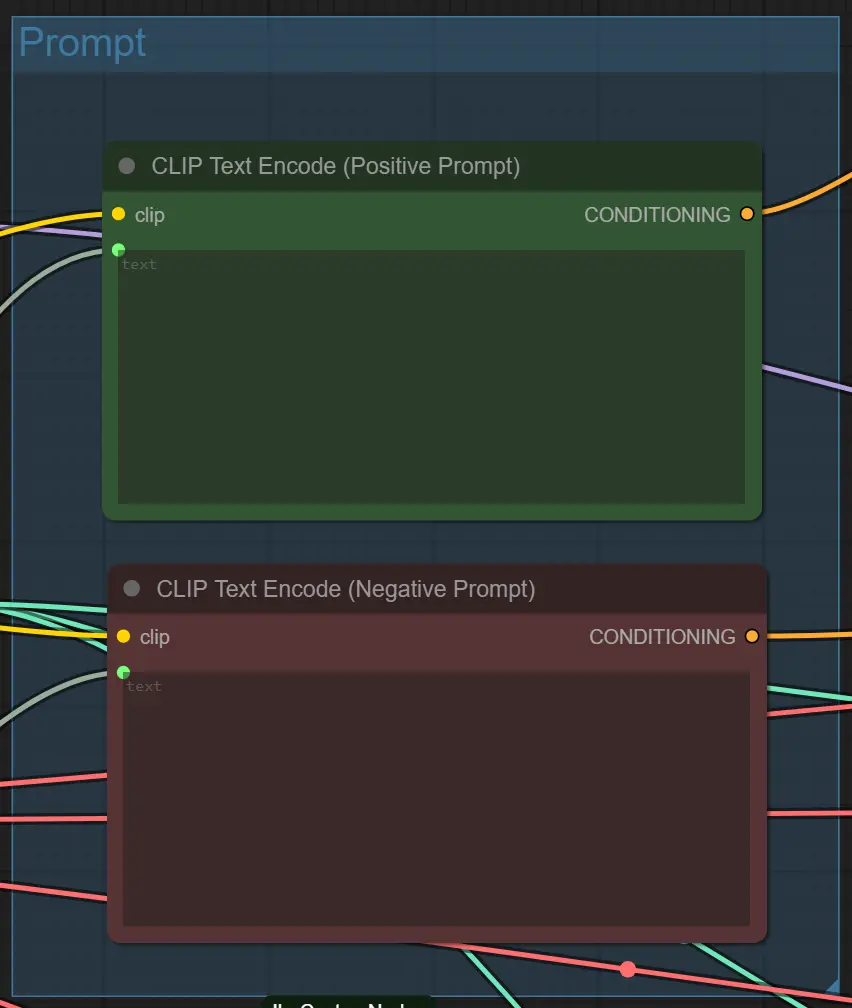

5. テキストプロンプトエンコーディング – CLIP Text Encode Nodes プロンプトからベクトルガイダンスを生成します。

- 手動で変更する必要はありません。プラグインからのテキストを受け入れます。

ノードの高度なヒント

プロンプトの明確さ 過度に複雑または曖昧なプロンプトを避けてください。cinematic lighting、anime、cyberpunk alley のような直接的なスタイルを使用してください。より制御された結果を得るには具体的にしてください。

デノイズと構造のバランス ControlNet が有効な場合(例: Depth + Pose)、高いデノイズ(0.88)は構造を乱す可能性があります。レイアウトの保持が優先される場合は 0.6–0.75 を試してください。

ControlNet と入力を一致させる 一致するガイダンス画像が存在する場合のみ ControlNet を有効にします(例: Depth に RenderImageDepth.png)。不一致はプロンプトの失敗や空の結果を引き起こす可能性があります。

4. 謝辞

このワークフローは、Kijai によって開発された Flux-FP8 モデルと、Reallusion チームによって公式 AI レンダリング ワークフローガイド に記載されたパフォーマンス最適化技術を統合しています。モデル開発に対する Kijai の貢献と、ComfyUI ワークフローにおける AI レンダリングの効率を高める貴重な洞察を共有してくれた Reallusion に特別な感謝を捧げます。

5. Reallusion AI Render に関するさらなるリソース

Reallusion AI Render に関連する技術リソースとドキュメントを探索してください。

- セットアップ / クイックスタートドキュメント – ComfyUI での AI Render ワークフローの構成手順ガイド。 プレゼンテーションスライド

- 技術概要 – AI Render のオープンベータにおける統合と機能の概要。 製品発表

- ワークフロー最適化ガイド – パフォーマンスを最大化し、AI Render をプロダクション環境でカスタマイズするためのヒント。 パフォーマンステップス

- iClone – iClone ソフトウェアの公式ページ。 iClone ウェブサイト

- キャラクタークリエーター – Reallusion Character Creator の公式ページ。 キャラクタークリエーターウェブサイト

- AI Render オープンベータフォーラム – 公式 Reallusion フォーラムでのディスカッションと更新。 フォーラムリンク

- AI Render インストールチュートリアル – AI Render のセットアップに関するビデオガイド。 YouTube チュートリアル

- **AI Render イメージからイメージへのjson

ワークフローチュートリアル** – イメージからイメージへのワークフローのビデオウォークスルー。 YouTube チュートリアル

- AI Render ビデオからビデオへのワークフローチュートリアル – ビデオからビデオへのワークフローのビデオウォークスルー。 YouTube チュートリアル