1. Cos'è il Workflow ComfyUI Uni3C?

Il workflow Uni3C integra il modello avanzato Uni3C (Unifying Precisely 3D-Enhanced Camera and Human Motion Controls) nell'ambiente ComfyUI. Sviluppato da DAMO Academy (Alibaba Group), Uni3C affronta la sfida fondamentale della generazione video controllabile unificando il controllo della traiettoria della telecamera e il controllo del movimento umano all'interno di un unico framework potenziato in 3D.

Costruito sull'architettura del trasformatore di diffusione FLUX e alimentato dal modello di base Wan2.1, Uni3C introduce PCDController - un modulo di controllo plug-and-play che utilizza nuvole di punti non proiettate derivate dalla stima della profondità monoculare. Questo approccio consente un controllo preciso della telecamera all'interno di Uni3C mantenendo le capacità generative dei modelli di diffusione video su larga scala. Il sistema Uni3C impiega modelli di personaggi SMPL-X e guida globale del mondo 3D per ottenere una generazione video spazialmente coerente attraverso scene ambientali e personaggi umani.

2. Vantaggi di Uni3C:

- Framework Unificato Potenziato in 3D: Uni3C elabora simultaneamente traiettorie della telecamera e movimenti umani in uno spazio mondiale 3D coerente.

- Architettura PCDController: Con il controller leggero da 0.95B parametri, Uni3C sfrutta nuvole di punti non proiettate dalla stima della profondità monoculare, senza compromettere il modello di base da 14B parametri.

- Integrazione SMPL-X: Uni3C fornisce supporto avanzato per modelli di corpo umano in 3D.

- Utilizzo del Prior Geometrico: La comprensione geometrica 3D basata su nuvole di punti di Uni3C offre un controllo robusto della telecamera da immagini singole.

- Guida Globale del Mondo 3D: Uni3C assicura l'allineamento della trasformazione rigida tra nuvole di punti ambientali e personaggi SMPL-X per una generazione video spazialmente coerente.

3. Come Usare il Workflow Uni3C

Uni3C opera attraverso estrazione di riferimenti video, che analizza video di riferimento per comprendere sia i movimenti della telecamera che i movimenti umani, quindi applica i modelli per generare nuovi video dalle immagini di input. Questo approccio consente un controllo preciso con Uni3C senza regolazione manuale dei parametri.

3.1 Metodo 1: Controllo della Telecamera Riferito da Video

Ideale per:

Estrarre movimenti della telecamera da video di riferimento e applicarli a nuove scene usando Uni3C.

Processo di Configurazione:

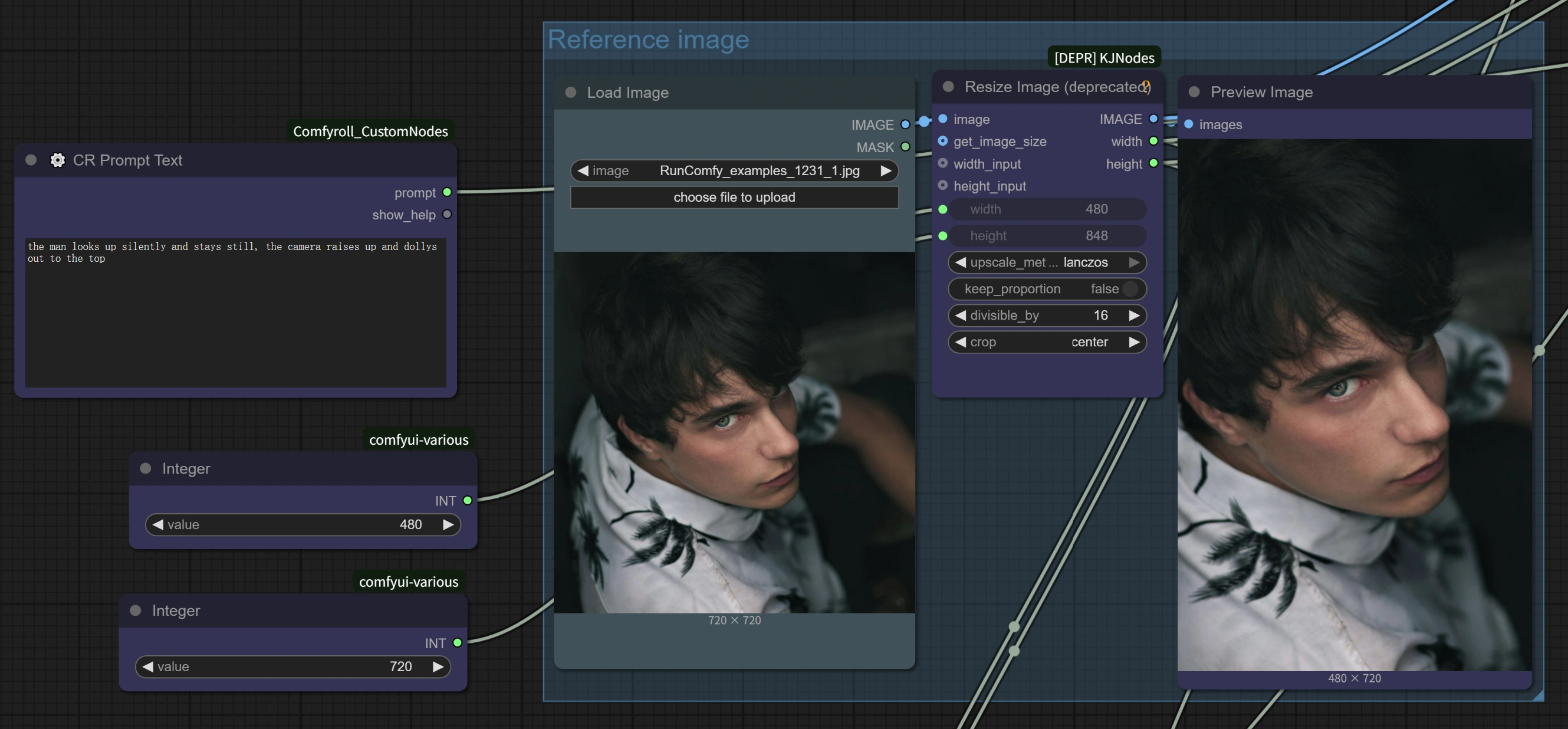

- Carica Video di Riferimento: Carica qualsiasi video con movimento interessante della telecamera nel nodo

Load Video (Upload)- Buoni Esempi: Video con zoom della telecamera sui soggetti, filmati di camminata con movimento naturale della testa, panoramiche cinematografiche, riprese orbitali

- Punto Chiave: Qualsiasi video con un chiaro movimento della telecamera funziona - dalle registrazioni da telefono alla cinematografia professionale con Uni3C.

- Carica Immagine Target: Carica la tua immagine di base nel nodo

Load Image(funziona con qualsiasi stile: realistico, anime, opera d'arte, generato da AI) - Scrivi il Tuo Prompt: Descrivi la scena desiderata nell'area del prompt di testo per Uni3C

- Configura Impostazioni: Il workflow Uni3C include parametri ottimizzati per un miglioramento della velocità 4x

- Genera: Esegui il workflow per trasferire il movimento della telecamera del video di riferimento alla tua scena con Uni3C.

Suggerimenti Avanzati:

- Corrispondenza della Direzione del Movimento: I migliori risultati si ottengono quando la direzione del movimento del video di riferimento si allinea con la composizione della scena desiderata per **Uni3C.

- Coordinamento del Prompt: Scrivi prompt che completino lo stile del movimento della telecamera per una coerenza migliorata con Uni3C.

- Qualità del Riferimento: Scegli video di riferimento con movimenti della telecamera stabili e chiari per risultati ottimali con Uni3C.

3.2 Metodo 2: Trasferimento del Movimento Umano

Ideale per:

Trasferire movimenti umani da video di riferimento a diversi personaggi usando Uni3C.

Processo di Configurazione:

- Video di Riferimento con Movimento Umano: Carica un video contenente i movimenti umani che desideri trasferire

- Immagine del Personaggio Target: Carica un'immagine del personaggio che desideri animare

- Controllo del Movimento tramite Prompt:

- Preserva il Movimento Originale: Usa descrizioni generali come "una donna che cammina" per mantenere il movimento di riferimento con Uni3C.

- Modifica Azioni: Sii specifico per cambiare i movimenti: "una donna che si pettina i capelli" modificherà i gesti delle mani preservando il flusso generale del movimento con Uni3C.

Vantaggi Chiave:

- Nessuno Scheletro Richiesto: A differenza della cattura del movimento tradizionale, Uni3C comprende il movimento umano senza rigging complesso.

- Preservazione dei Dettagli: Uni3C mantiene accessori, acconciature e dettagli degli abiti durante il trasferimento del movimento.

- Controllo Simultaneo: Sia il movimento della telecamera che il movimento umano vengono trasferiti insieme dallo stesso video di riferimento usando Uni3C.

Architettura di Ottimizzazione delle Prestazioni: Il workflow Uni3C implementa diverse strategie di ottimizzazione, tra cui riduzione della dimensione nascosta da 5120 a 1024 in PCDController, strati di proiezione lineare inizializzati a zero e iniezione di caratteristiche di controllo della telecamera solo nei primi 20 strati del modello di base. L'ottimizzazione del matching del flusso con passaggi di campionamento ridotti (10 vs 20+) e scale di guida CFG regolate fornisce fino a 4x miglioramento della velocità di elaborazione in Uni3C mantenendo la qualità della generazione.

3.3 Impostazioni di Prestazioni Ottimizzate

Configurazione di Aumento della Velocità 4x: Basato sulle ottimizzazioni integrate di Uni3C, le seguenti impostazioni forniscono un'elaborazione notevolmente più veloce:

Impostazioni del Nodo WanVideo Sampler:

Steps: 10 (ridotto dal default 20+)CFG: 1.0-1.5 (ottimizzato per l'equilibrio velocità-qualità)Shift: 5.0-7.0 (l'autore raccomanda 7 per i migliori risultati, 5 per un'elaborazione più veloce con Uni3C)Scheduler: UniPC (scheduler ottimizzato per Uni3C)

Caratteristiche Chiave delle Prestazioni:

- Integrazione AnimateDiff: Uni3C sfrutta le ottimizzazioni AnimateDiff originariamente progettate per il testo-a-video ma efficaci per la generazione immagine-a-video.

- Riduzione Intelligente dei Parametri: Poiché l'immagine-a-video inizia con contenuti visivi esistenti, sono necessari meno passaggi di denoising rispetto alla generazione testo-a-video con Uni3C.

- Elaborazione Ottimizzata: Uni3C consente di completare video di 70 fotogrammi in ~4-5 minuti (vs ~27 minuti con le impostazioni originali).

Opzioni Qualità vs Velocità:

- Velocità Massima: Steps=10, CFG=1.0, Shift=5 → ~4 minuti per 70 fotogrammi con Uni3C

- Bilanciato: Steps=10, CFG=1.5, Shift=7 → ~5 minuti per 70 fotogrammi con Uni3C

- Qualità Superiore: Steps=15, CFG=2.0, Shift=7 → ~8-10 minuti per 70 fotogrammi con Uni3C

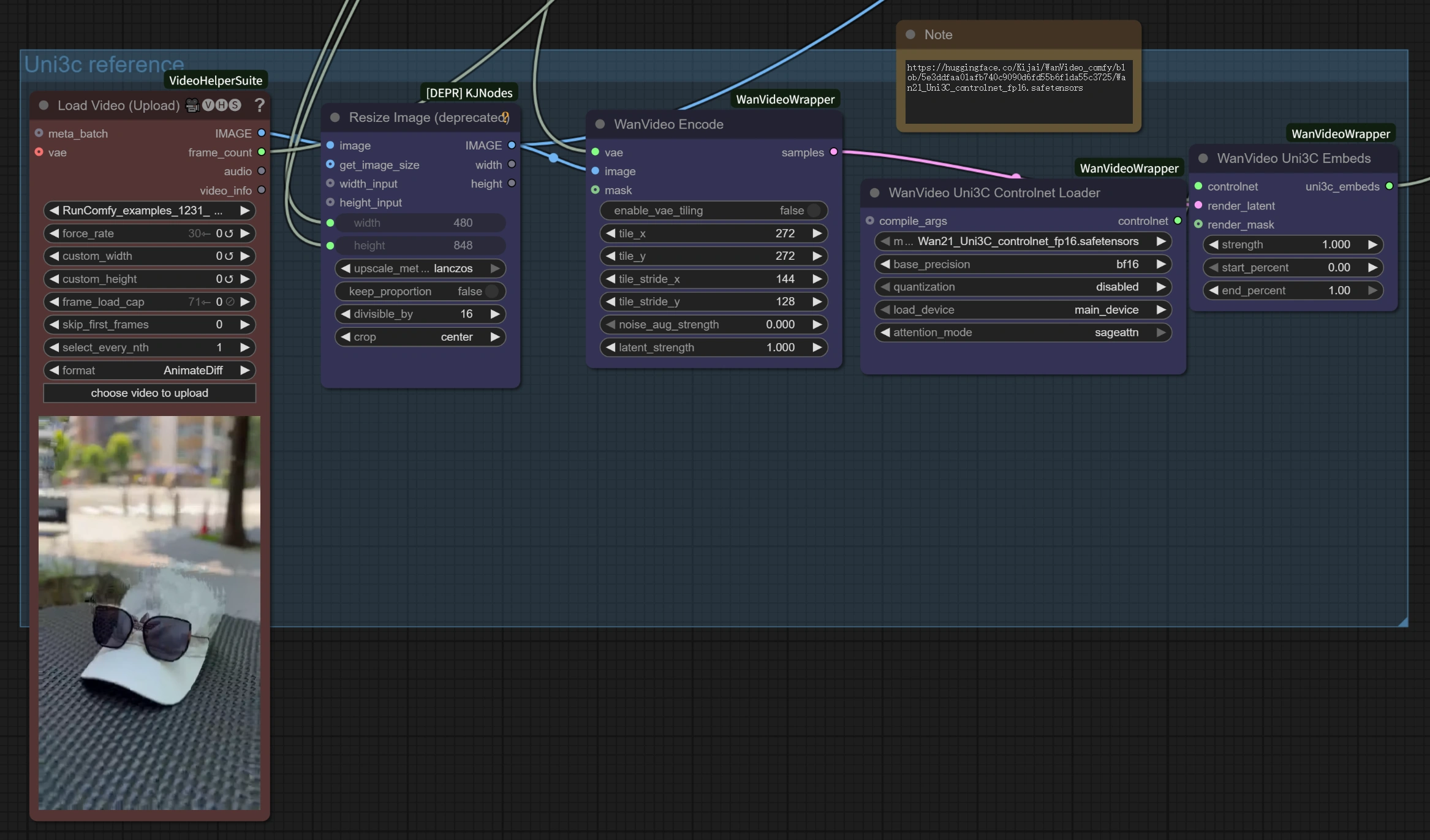

3.4 Comprensione dei Componenti del Workflow

Sezione di Elaborazione del Video di Riferimento:

Load Video (Upload): Accetta formati video standard come MP4, AVI per riferimento di movimento in Uni3C.WanVideo Encode: Elabora il video di riferimento per estrarre traiettorie della telecamera e modelli di movimento per Uni3C.Uni3C ControlNet Loader: Carica il modello di controllo specializzato Uni3C per la comprensione del movimento.

Sezione di Generazione Immagine-a-Video:

Load Image: La tua immagine target che verrà animata con il movimento di riferimento da Uni3C.WanVideo Image/ToVideo Encode: Converte la tua immagine statica in un formato adatto alla generazione video da Uni3C.WanVideo Sampler: Motore di generazione principale con impostazioni ottimizzate per un miglioramento della velocità 4x in Uni3C.

Elaborazione dell'Uscita:

WanVideo Decode: Converte il video latente generato in un formato visualizzabile da Uni3C.Video Combine: Assembla il file video finale con frame rate e codifica corretti da Uni3C.

4. Suggerimenti Avanzati e Migliori Pratiche

Scelta dei Materiali di Riferimento per Uni3C

- Per il Trasferimento del Movimento: Seleziona video con movimenti chiari e visibili dove la persona rimane principalmente nel frame per Uni3C.

- Per il Controllo della Telecamera: Qualsiasi video con prospettiva interessante o movimento della telecamera desiderato per Uni3C.

- Migliori Risultati: Quando la direzione del movimento di riferimento corrisponde alla direzione di output desiderata con Uni3C.

Migliori Pratiche di Ingegneria del Prompt per Uni3C

- Principio "Non Disturbare": Per il puro trasferimento del movimento senza cambiamenti del personaggio, usa prompt semplici e generali con Uni3C.

- Modifiche Specifiche delle Azioni: Sii dettagliato quando vuoi modificare ciò che il personaggio sta facendo con Uni3C.

- Coerenza del Personaggio: Focalizza i prompt sul mantenimento dell'aspetto del personaggio con Uni3C.

Ottimizzazione della Qualità per Uni3C

- Coerenza del Movimento: Evita cambiamenti improvvisi nei video di riferimento per risultati più fluidi con Uni3C.

- Stabilità dei Fotogrammi: Assicurati che i materiali di riferimento abbiano illuminazione e inquadratura coerenti per Uni3C.

5. Ringraziamenti

Questo workflow è alimentato da Uni3C, sviluppato da DAMO Academy (Alibaba Group), Fudan University, e Hupan Lab. L'integrazione ComfyUI si basa sull'eccellente lavoro di kijai (ComfyUI-WanVideoWrapper), con ulteriori ottimizzazioni e design del workflow per rendere questa potente tecnologia Uni3C accessibile ai creatori di tutto il mondo.