Qwen Edit 2511 LoRA Inferenza: modifiche AI Toolkit coerenti con l'addestramento in ComfyUI

Qwen Edit 2511 LoRA Inferenza è un workflow RunComfy pronto all'uso per applicare un AI Toolkit–addestrato LoRA su Qwen Image Edit Plus 2511 all'interno di ComfyUI con un comportamento abbinato all'addestramento. È costruito attorno a RC Qwen Image Edit Plus 2511 (RCQwenImageEditPlus2511)—un nodo personalizzato open-source costruito da RunComfy (source) che instrada la modifica attraverso una pipeline di inferenza specifica per Qwen (anziché un grafico di campionamento generico), mentre carica il tuo adattatore tramite lora_path e lora_scale.

Perché Qwen Edit 2511 LoRA Inferenza spesso appare diverso in ComfyUI

Le immagini di anteprima di AI Toolkit provengono da una pipeline di modifica specifica per Qwen Image Edit Plus 2511, incluso come il prompt viene codificato rispetto all'immagine di controllo e come viene applicata la guida. Se ricostruisci lo stesso compito come un grafico di campionamento generico di ComfyUI, i valori predefiniti possono cambiare e la LoRA può finire per modificare una parte diversa dello stack—quindi abbinare prompt/passaggi/seed non garantisce ancora modifiche corrispondenti. Quando i risultati si discostano, di solito è un disallineamento a livello di pipeline piuttosto che un singolo parametro che hai perso.

Cosa fa il nodo personalizzato RCQwenImageEditPlus2511

RCQwenImageEditPlus2511 instrada la modifica di Qwen Image Edit Plus 2511 attraverso una pipeline di inferenza allineata all'anteprima e applica il tuo adattatore AI Toolkit tramite lora_path / lora_scale all'interno di quella pipeline per mantenere l'inferenza coerente con le anteprime di addestramento. Implementazione di riferimento: `src/pipelines/qwen_image.py`.

Come utilizzare il workflow Qwen Edit 2511 LoRA Inferenza

Passo 1: Importa il tuo LoRA (2 opzioni)

- Opzione A (Risultato di addestramento RunComfy): RunComfy → Trainer → LoRA Assets → trova il tuo LoRA → ⋮ → Copia Link LoRA

- Opzione B (AI Toolkit LoRA addestrato al di fuori di RunComfy): Copia un link di download diretto

.safetensorsper il tuo LoRA e incolla quell'URL inlora_path(non c'è bisogno di scaricarlo inComfyUI/models/loras).

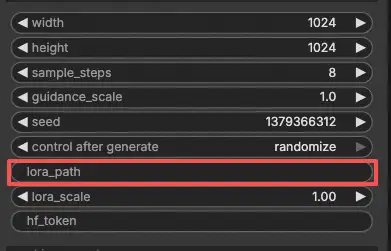

Passo 2: Configura il nodo personalizzato RCQwenImageEditPlus2511 per Qwen Edit 2511 LoRA Inferenza

Incolla il tuo link LoRA in lora_path su RCQwenImageEditPlus2511 (sia il link LoRA di RunComfy dall'Opzione A, sia un URL diretto .safetensors dall'Opzione B).

Quindi imposta il resto dei parametri del nodo (abbina i valori di anteprima/campione del tuo AI Toolkit quando confronti i risultati):

prompt: l'istruzione di modifica (includi i token di attivazione dell'addestramento se il tuo LoRA li utilizza)negative_prompt: opzionale; lascialo vuoto se non hai utilizzato negativi nelle anteprimewidth/height: dimensione di output (si consigliano multipli di 32 per questa pipeline)sample_steps: passaggi di inferenza (inizia rispecchiando il conteggio dei passaggi di anteprima; 25 è una base comune)guidance_scale: intensità della guida (Qwen utilizza una scala "true CFG"; valida il valore corrispondente all'anteprima prima di sintonizzare)seed: seed fisso per modifiche ripetibili mentre diagnostichi l'allineamento impostando control_after_generate su 'fixed'lora_scale: intensità LoRA (inizia con la forza di anteprima, quindi regola gradualmente)

Questo workflow è una configurazione di modifica dell'immagine, quindi richiede anche un'immagine di input:

control_image(input richiesto): collega un nodo LoadImage acontrol_image, e sostituisci l'immagine di esempio con la foto che vuoi modificare.

Nota sull'allineamento dell'addestramento: se hai cambiato le impostazioni di campionamento durante l'addestramento, apri il tuo YAML di addestramento AI Toolkit e rispecchia width, height, sample_steps, guidance_scale, seed, e lora_scale. Se hai addestrato su RunComfy, vai su Trainer → LoRA Assets → Configura e copia i valori di anteprima in RCQwenImageEditPlus2511.

Passo 3: Esegui Qwen Edit 2511 LoRA Inferenza

Fai clic su Queue/Run. Il nodo SaveImage scrive il risultato modificato nella tua directory di output standard di ComfyUI.

Risoluzione dei problemi di Qwen Edit 2511 LoRA Inferenza

La maggior parte dei problemi che le persone incontrano dopo aver addestrato un Qwen-Image-Edit-2511 LoRA in Ostris AI Toolkit si manifestano al momento dell'inferenza a causa di disallineamento della pipeline—il campionatore di anteprima di AI Toolkit è specifico per il modello/pipeline, mentre molti grafici di ComfyUI (o backend accelerati) non lo sono.

Il nodo personalizzato RC Qwen Image Edit Plus 2511 (RCQwenImageEditPlus2511) di RunComfy è costruito per mantenere l'inferenza allineata alla pipeline con il campionamento in anteprima stile AI Toolkit.

(1)qwen image edit non supporta il caricamento di Lora

Perché succede

Alcuni percorsi accelerati di Qwen Image Edit (ad esempio, il percorso Qwen Image Edit di Nunchaku) attualmente non applicano i pesi LoRA nello stesso modo in cui si aspetta la pipeline di modifica ufficiale di Qwen. Il sintomo abituale è caricamento dei pesi fallito / chiave lora non caricata e l'adattatore ha poco o nessun effetto visibile.

Come risolvere (approccio coerente con l'addestramento)

- Se stai eseguendo Qwen Image Edit tramite Nunchaku, passa a un flusso di lavoro Qwen Image Edit 2511 non‑Nunchaku per la convalida LoRA (questo è stato segnalato come non supportato per il caricamento LoRA nel problema).

- In RunComfy, convalida il tuo adattatore tramite RCQwenImageEditPlus2511 prima e inietta il LoRA solo tramite

lora_path+lora_scale(evita di impilare un percorso di caricamento LoRA aggiuntivo sopra il nodo RC). - Mantieni la stessa immagine di controllo,

seed,sample_steps,guidance_scale, ewidth/heightfissi mentre confronti con le anteprime di AI Toolkit.

(2)Domanda su avviso di caricamento qwen-image-edit-2511

Perché succede

Qwen-Image-Edit-2511 introduce nuovi campi di configurazione (in particolare zero_cond_t). Se il tuo runtime locale è indietro rispetto al supporto della libreria previsto dal modello, puoi vedere avvisi come: config attribute zero_cond_t was passed ... but is ignored Questo è un forte segnale che i valori predefiniti della tua pipeline non corrispondono al campionatore di anteprima contro cui hai addestrato/convalidato.

Come risolvere (percorso di aggiornamento noto funzionante)

- Aggiorna a una build Diffusers/stack che includa il supporto per Qwen-Image-Edit-2511. Una soluzione comunemente condivisa nell'ecosistema AI Toolkit è installare Diffusers da GitHub main per la compatibilità con Qwen Edit 2511 (vedi il PR di supporto): https://github.com/ostris/ai-toolkit/pull/611

- Quindi ritesta tramite RCQwenImageEditPlus2511 (allineato alla pipeline) mentre rispecchi i tuoi valori di anteprima (

sample_steps,guidance_scale,seed,lora_scale,width/height).

(3)--zero_cond_t # Questo è un parametro speciale introdotto da Qwen-Image-Edit-2511. Si prega di abilitarlo per questo modello.

Perché succede

Alcuni stack di addestramento/inferenza di Qwen Edit 2511 richiedono che zero_cond_t sia abilitato per abbinare il comportamento di condizionamento/guida previsto. Se le tue anteprime di addestramento sono state prodotte con una configurazione e le tue inferenze ComfyUI funzionano con un'altra, le modifiche possono sembrare "sbagliate" anche se prompt/seed/passaggi corrispondono.

Come risolvere (comportamento abbinato all'addestramento)

- Assicurati che il tuo campionatore di anteprima di addestramento e la tua pipeline di inferenza utilizzino la stessa configurazione di Qwen Edit 2511 (incluso

zero_cond_tquando il tuo stack lo espone). - Per l'inferenza ComfyUI, preferisci RCQwenImageEditPlus2511 in modo che la pipeline di modifica rimanga allineata alla pipeline, e il LoRA venga iniettato dove la pipeline in stile anteprima se lo aspetta (tramite

lora_path/lora_scale).

(4)Qwen Image Edit 2511 - Degradazione dell'output quadrato su modifica di singola immagine

Perché succede

Gli utenti segnalano che Qwen-Image-Edit-2511 può perdere coerenza su output quadrati (ad esempio, 1024×1024) per alcune modifiche, mentre rapporti di aspetto non quadrati producono risultati visibilmente più puliti e fedeli—anche con lo stesso seed/prompt/impostazioni.

Come risolvere (soluzione alternativa segnalata dagli utenti)

- Quando convalidi il tuo LoRA, testa un output non quadrato (ad esempio, 832×1216 o 1216×832) mantenendo lo stesso

seed,sample_steps,guidance_scale, e immagine di controllo. - Una volta trovato un rapporto di aspetto che corrisponde alle tue aspettative di anteprima, mantieni fisso quel rapporto e solo allora inizia a sintonizzare

lora_scale.

Esegui Qwen Edit 2511 LoRA Inferenza ora

Apri il workflow, imposta lora_path, collega la tua control_image, ed esegui RCQwenImageEditPlus2511 per mantenere le modifiche ComfyUI allineate con le tue anteprime di addestramento AI Toolkit.