IDM-VTON, abréviation de "Amélioration des Modèles de Diffusion pour un Essayage Virtuel Authentique en Extérieur," est un modèle de diffusion innovant qui vous permet d'essayer virtuellement des vêtements de manière réaliste en utilisant seulement quelques entrées. Ce qui distingue IDM-VTON, c'est sa capacité à préserver les détails uniques et l'identité des vêtements tout en générant des résultats d'essayage virtuel qui semblent incroyablement authentiques.

1. Comprendre IDM-VTON

Au cœur de IDM-VTON se trouve un modèle de diffusion spécialement conçu pour l'essayage virtuel. Pour l'utiliser, vous avez simplement besoin d'une représentation d'une personne et d'un vêtement que vous souhaitez essayer. IDM-VTON fait ensuite sa magie, en rendant un résultat qui semble que la personne porte réellement le vêtement. Il atteint un niveau de fidélité et d'authenticité du vêtement qui dépasse les méthodes d'essayage virtuel basées sur la diffusion précédentes.

2. Le Fonctionnement Interne de IDM-VTON

Alors, comment IDM-VTON parvient-il à un essayage virtuel aussi réaliste ? Le secret réside dans ses deux modules principaux qui travaillent ensemble pour encoder les sémantiques de l'entrée du vêtement :

- Le premier est un adaptateur de prompt d'image, ou IP-Adapter pour faire court. Ce composant ingénieux extrait les sémantiques de haut niveau du vêtement - essentiellement, les caractéristiques clés qui définissent son apparence. Il fusionne ensuite ces informations dans la couche d'attention croisée du modèle de diffusion principal UNet.

- Le second module est un UNet parallèle appelé GarmentNet. Son rôle est d'encoder les caractéristiques de bas niveau du vêtement - les détails précis qui le rendent unique. Ces caractéristiques sont ensuite fusionnées dans la couche d'auto-attention du UNet principal.

Mais ce n'est pas tout ! IDM-VTON utilise également des prompts textuels détaillés pour les entrées du vêtement et de la personne. Ces prompts fournissent un contexte supplémentaire qui améliore l'authenticité du résultat final de l'essayage virtuel.

3. Mettre IDM-VTON en Action dans ComfyUI

3.1 La Vedette : Le Nœud IDM-VTON

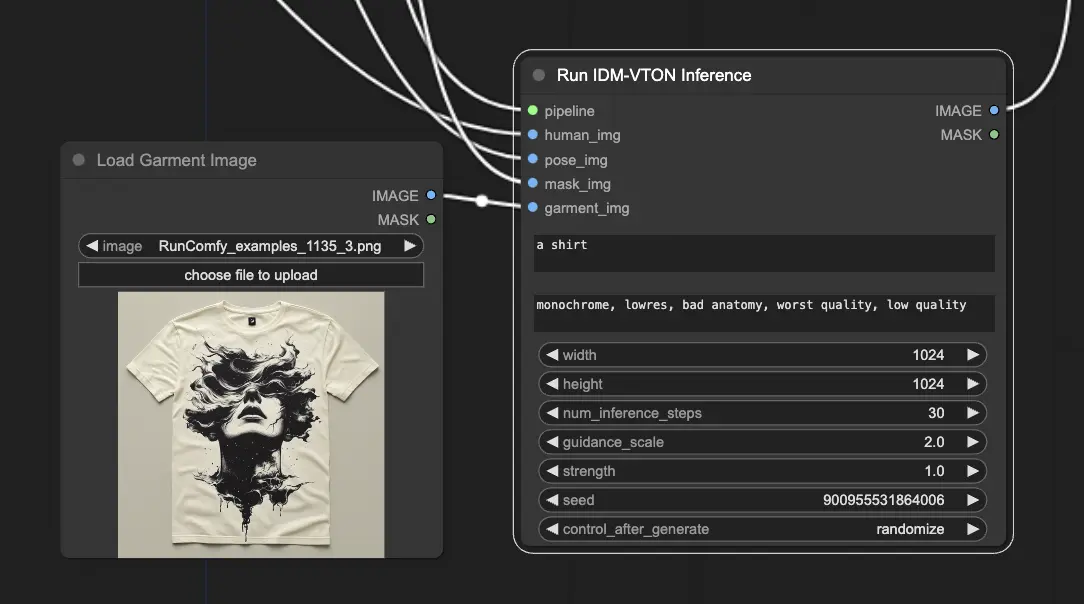

Dans ComfyUI, le "nœud IDM-VTON" est la centrale qui exécute le modèle de diffusion IDM-VTON et génère la sortie de l'essayage virtuel.

Pour que le nœud IDM-VTON fasse sa magie, il a besoin de quelques entrées clés :

- Pipeline : Il s'agit du pipeline de diffusion IDM-VTON chargé qui alimente l'ensemble du processus d'essayage virtuel.

- Entrée Humaine : Une image de la personne qui va essayer virtuellement le vêtement.

- Entrée de Pose : Une représentation DensePose prétraitée de l'entrée humaine, qui aide IDM-VTON à comprendre la pose et la forme du corps de la personne.

- Entrée de Masque : Un masque binaire qui indique quelles parties de l'entrée humaine sont des vêtements. Ce masque doit être converti dans un format approprié.

- Entrée de Vêtement : Une image du vêtement à essayer virtuellement.

3.2 Tout Préparer

Pour mettre le nœud IDM-VTON en marche, il y a quelques étapes de préparation :

- Chargement de l'Image Humaine : Un nœud LoadImage est utilisé pour charger l'image de la personne. <img src="https://cdn.runcomfy.net/workflow_assets/1135/readme01.webp" alt="IDM-VTON" width="500" />

- Génération de l'Image de Pose : L'image humaine est passée à travers un nœud DensePosePreprocessor, qui calcule la représentation DensePose dont IDM-VTON a besoin. <img src="https://cdn.runcomfy.net/workflow_assets/1135/readme02.webp" alt="IDM-VTON" width="500" />

- Obtention de l'Image de Masque : Il y a deux façons d'obtenir le masque de vêtement : <img src="https://cdn.runcomfy.net/workflow_assets/1135/readme03.webp" alt="IDM-VTON" width="500" />

a. Masquage Manuel (Recommandé)

- Faites un clic droit sur l'image humaine chargée et choisissez "Ouvrir dans l'Éditeur de Masque."

- Dans l'interface de l'éditeur de masque, masquez manuellement les régions de vêtements.

b. Masquage Automatique

- Utilisez un nœud GroundingDinoSAMSegment pour segmenter automatiquement le vêtement.

- Proposez au nœud une description textuelle du vêtement (comme "t-shirt").

Quelle que soit la méthode choisie, le masque obtenu doit être converti en image à l'aide d'un nœud MaskToImage, qui est ensuite connecté à l'entrée "Image de Masque" du nœud IDM-VTON.

- Chargement de l'Image de Vêtement : Elle est utilisée pour charger l'image du vêtement.

Pour une exploration plus approfondie du modèle IDM-VTON, ne manquez pas l'article original, "Improving Diffusion Models for Authentic Virtual Try-on in the Wild". Et si vous êtes intéressé par l'utilisation de IDM-VTON dans ComfyUI, assurez-vous de consulter les nœuds dédiés ici. Un immense merci aux chercheurs et développeurs derrière ces ressources incroyables.