FLUX.2 LoRA ComfyUI Inférence : sortie LoRA AI Toolkit correspondant à l'entraînement avec le pipeline FLUX.2 Dev

Ce workflow RunComfy prêt à la production exécute l'inférence FLUX.2 Dev LoRA dans ComfyUI via RC FLUX.2 Dev (Flux2Pipeline) (alignement au niveau du pipeline, pas un graphique d'échantillonneur générique). RunComfy a construit et open-sourcé ce nœud personnalisé—voir les dépôts runcomfy-com—et vous contrôlez l'application de l'adaptateur avec lora_path et lora_scale.

Remarque : Ce workflow nécessite une machine 3XL pour fonctionner.

Pourquoi l'inférence FLUX.2 LoRA ComfyUI semble souvent différente dans ComfyUI

Les aperçus d'entraînement AI Toolkit sont rendus via un pipeline FLUX.2 spécifique au modèle, où l'encodage de texte, la planification et l'injection LoRA sont conçus pour fonctionner ensemble. Dans ComfyUI, reconstruire FLUX.2 avec un graphique différent (ou un chemin de chargeur LoRA différent) peut changer ces interactions, donc copier le même prompt, les étapes, CFG, et graine produit toujours une dérive visible. Les nœuds de pipeline RC RunComfy comblent cet écart en exécutant FLUX.2 de bout en bout dans Flux2Pipeline et en appliquant votre LoRA à l'intérieur de ce pipeline, maintenant l'inférence alignée avec le comportement de prévisualisation. Source : Dépôts open-source RunComfy.

Comment utiliser le workflow FLUX.2 LoRA ComfyUI Inférence

Étape 1 : Obtenez le chemin LoRA et chargez-le dans le workflow (2 options)

⚠️ Important · Accès FLUX.2 & jeton Hugging Face requis

Les modèles FLUX.2 Dev nécessitent une autorisation d'accès explicite sur Hugging Face.

Avant d'exécuter ce workflow :

- Assurez-vous que votre compte Hugging Face a été autorisé à accéder à FLUX.2 (Dev)

- Créez un jeton d'accès Hugging Face

- Collez votre jeton dans le champ

hf_tokensur le nœud Load Pipeline

Sans un jeton valide et un accès au modèle, le workflow ne fonctionnera pas. Pour des instructions détaillées, voir Jeton Hugging Face pour FLUX.2.

Option A — Résultat d'entraînement RunComfy → téléchargement vers ComfyUI local :

- Allez à Trainer → LoRA Assets

- Trouvez le LoRA que vous souhaitez utiliser

- Cliquez sur le menu ⋮ (trois points) à droite → sélectionnez Copier le lien LoRA

- Dans la page de workflow ComfyUI, collez le lien copié dans le champ de saisie Télécharger dans le coin supérieur droit de l'interface utilisateur

- Avant de cliquer sur Télécharger, assurez-vous que le dossier cible est défini sur ComfyUI > models > loras (ce dossier doit être sélectionné comme cible de téléchargement)

- Cliquez sur Télécharger — cela garantit que le fichier LoRA est enregistré dans le bon répertoire

models/loras - Après la fin du téléchargement, rafraîchissez la page

- Le LoRA apparaît maintenant dans le menu déroulant de sélection LoRA dans le workflow — sélectionnez-le

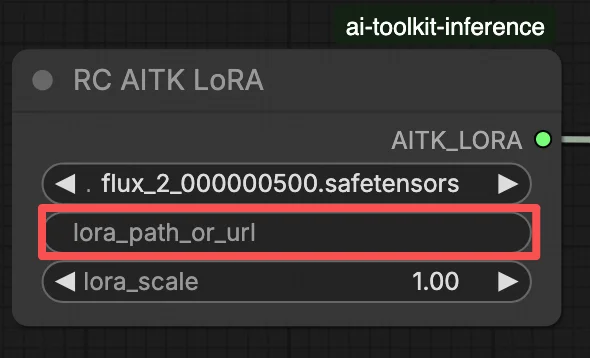

Option B — URL LoRA directe (remplace l'Option A) :

- Collez l'URL de téléchargement directe

.safetensorsdans le champ d'entréepath / urldu nœud LoRA - Lorsqu'une URL est fournie ici, elle remplace l'Option A — le workflow charge le LoRA directement depuis l'URL à l'exécution

- Aucun téléchargement local ou placement de fichier n'est requis

Astuce : confirmez que l'URL résout le fichier .safetensors réel (pas une page d'atterrissage ou une redirection).

Étape 2 : Adaptez les paramètres d'inférence avec vos paramètres d'échantillon d'entraînement

Dans le nœud LoRA, sélectionnez votre adaptateur dans lora_path (Option A), ou collez un lien direct .safetensors dans path / url (Option B remplace le menu déroulant). Ensuite, réglez lora_scale à la même force que vous avez utilisée pendant les aperçus d'entraînement et ajustez à partir de là.

Les paramètres restants sont sur le nœud Generate (et, selon le graphique, le nœud Load Pipeline) :

prompt: votre prompt textuel (incluez des mots déclencheurs si vous les avez utilisés pendant l'entraînement)width/height: résolution de sortie ; adaptez la taille de votre aperçu d'entraînement pour la comparaison la plus nette (des multiples de 16 sont recommandés pour FLUX.2)sample_steps: nombre d'étapes d'inférence (25 est une valeur par défaut courante)guidance_scale: valeur de CFG/guidance (4.0 est une valeur par défaut courante)seed: graine fixe pour reproduire ; changez-la pour explorer des variationsseed_mode(seulement si présent) : choisissezfixedourandomizenegative_prompt(seulement si présent) : FLUX.2 est distillé par guidance dans ce workflow, donc les prompts négatifs sont ignoréshf_token: jeton d'accès Hugging Face ; requis pour le téléchargement du modèle FLUX.2 Dev (collez-le sur le nœud Load Pipeline)

Astuce d'alignement d'entraînement : si vous avez personnalisé les valeurs d'échantillonnage pendant l'entraînement (seed, guidance_scale, sample_steps, mots déclencheurs, résolution), reflétez ces valeurs exactes ici. Si vous vous êtes entraîné sur RunComfy, ouvrez Trainer → LoRA Assets > Config pour voir le YAML résolu et copier les paramètres d'aperçu/échantillon dans les nœuds du workflow.

Étape 3 : Exécutez l'inférence FLUX.2 LoRA ComfyUI

Cliquez sur Queue/Run — le nœud SaveImage écrit les résultats dans votre dossier de sortie ComfyUI.

Liste de contrôle rapide :

- ✓ LoRA est soit : téléchargé dans

ComfyUI/models/loras(Option A), ou chargé via une URL directe.safetensors(Option B) - ✓ Page rafraîchie après le téléchargement local (Option A seulement)

- ✓ Paramètres d'inférence correspondant à la configuration

sampled'entraînement (si personnalisée)

Si tout ce qui précède est correct, les résultats d'inférence ici devraient correspondre de près à vos aperçus d'entraînement.

Dépannage de l'inférence FLUX.2 LoRA ComfyUI

La plupart des écarts “aperçu d'entraînement vs inférence ComfyUI” de FLUX.2 viennent de différences au niveau du pipeline (comment le modèle est chargé, planifié, et comment le LoRA est fusionné), pas d'un seul mauvais réglage. Ce workflow RunComfy restaure la base la plus proche “correspondant à l'entraînement” en exécutant l'inférence via RC FLUX.2 Dev (Flux2Pipeline) de bout en bout et en appliquant votre LoRA à l'intérieur de ce pipeline via lora_path / lora_scale (au lieu d'empiler des nœuds de chargeur/échantillonneur génériques).

(1) Flux.2 avec Lora erreur : "mul_cuda" non implémenté pour 'Float8_e4m3fn'

Pourquoi cela se produit Cela se produit généralement lorsque FLUX.2 est chargé avec des poids Float8/FP8 (ou quantification à précision mixte) et que le LoRA est appliqué via un chemin LoRA générique ComfyUI. La fusion LoRA peut forcer des opérations Float8 non prises en charge (ou des promotions Float8 + BF16 mixtes), ce qui déclenche l'erreur d'exécution mul_cuda Float8.

Comment réparer (recommandé)

- Exécutez l'inférence via RC FLUX.2 Dev (Flux2Pipeline) et chargez l'adaptateur uniquement via

lora_path/lora_scalepour que la fusion LoRA se produise dans le pipeline aligné AI Toolkit, pas via un chargeur LoRA générique empilé. - Si vous déboguez dans un graphique non-RC : évitez d'appliquer un LoRA sur des poids de diffusion Float8/FP8. Utilisez un chemin de chargement compatible BF16/FP16 pour FLUX.2 avant d'ajouter le LoRA.

(2) Les incompatibilités de forme LoRA devraient échouer rapidement au lieu de corrompre l'état du GPU et de causer des OOM/instabilités système

Pourquoi cela se produit C'est presque toujours un mauvais appariement de base : le LoRA a été formé pour une famille de modèles différente (par exemple FLUX.1) mais est appliqué à FLUX.2 Dev. Vous verrez souvent de nombreuses lignes lora key not loaded puis des incompatibilités de forme ; dans le pire des cas, la session peut devenir instable et se terminer par des OOM.

Comment réparer (recommandé)

- Assurez-vous que le LoRA a été formé spécifiquement pour

black-forest-labs/FLUX.2-devavec AI Toolkit (les variantes FLUX.1 / FLUX.2 / Klein ne sont pas interchangeables). - Gardez le graphique “à chemin unique” pour LoRA : chargez l'adaptateur uniquement via l'entrée

lora_pathdu workflow et laissez Flux2Pipeline gérer la fusion. Ne superposez pas un chargeur LoRA générique supplémentaire en parallèle. - Si vous avez déjà rencontré un mauvais appariement et que ComfyUI commence à produire des erreurs CUDA/OOM non liées par la suite, redémarrez le processus ComfyUI pour réinitialiser complètement l'état du GPU + modèle, puis réessayez avec un LoRA compatible.

(3) Flux.2 Dev - L'utilisation de LoRAs double le temps d'inférence

Pourquoi cela se produit Un LoRA peut rendre FLUX.2 Dev beaucoup plus lent lorsque le chemin LoRA force un travail de patch/déquantification supplémentaire ou applique des poids dans un chemin de code plus lent que le modèle de base seul.

Comment réparer (recommandé)

- Utilisez le chemin RC FLUX.2 Dev (Flux2Pipeline) de ce workflow et passez votre adaptateur via

lora_path/lora_scale. Dans cette configuration, le LoRA est fusionné une fois lors du chargement du pipeline (style AI Toolkit), donc le coût d'échantillonnage par étape reste proche du modèle de base. - Lorsque vous poursuivez un comportement correspondant à l'aperçu, évitez d'empiler plusieurs chargeurs LoRA ou de mélanger des chemins de chargeur. Limitez-vous à un

lora_path+ unlora_scalejusqu'à ce que la base corresponde.

Remarque Dans ce workflow FLUX.2 Dev, FLUX.2 est distillé par guidance, donc negative_prompt peut être ignoré par le pipeline même si un champ UI existe—correspondez aux aperçus en utilisant le libellé du prompt + guidance_scale + lora_scale d'abord.

Exécutez maintenant l'inférence FLUX.2 LoRA ComfyUI

Ouvrez le workflow, définissez lora_path, et cliquez sur Queue/Run pour obtenir des résultats FLUX.2 Dev LoRA qui restent proches de vos aperçus d'entraînement AI Toolkit.