1. ¿Qué es el Flujo de Trabajo ComfyUI Uni3C?

El flujo de trabajo Uni3C integra el modelo avanzado Uni3C (Control Unificado de Cámara y Movimiento Humano Mejorado en 3D) en el entorno ComfyUI. Desarrollado por DAMO Academy (Alibaba Group), Uni3C aborda el desafío fundamental de la generación de video controlable unificando el control de trayectoria de cámara y el control de movimiento humano dentro de un marco mejorado en 3D.

Basado en la arquitectura de transformador de difusión FLUX y potenciado por el modelo base Wan2.1, Uni3C introduce PCDController - un módulo de control plug-and-play que utiliza nubes de puntos no proyectadas derivadas de la estimación de profundidad monocular. Este enfoque permite un control preciso de cámara dentro de Uni3C mientras mantiene las capacidades generativas de modelos de difusión de video a gran escala. El sistema Uni3C emplea modelos de personajes SMPL-X y guía global del mundo 3D para lograr generación de video espacialmente consistente en escenas ambientales y personajes humanos.

2. Beneficios de Uni3C:

- Marco Unificado Mejorado en 3D: Uni3C procesa simultáneamente trayectorias de cámara y movimiento humano en un espacio mundial 3D coherente.

- Arquitectura PCDController: Con el controlador liviano de 0.95B parámetros, Uni3C aprovecha nubes de puntos no proyectadas de la estimación de profundidad monocular, sin comprometer el modelo base de 14B parámetros.

- Integración SMPL-X: Uni3C proporciona soporte avanzado para modelos de cuerpo humano en 3D.

- Utilización de Prior Geométrico: La comprensión geométrica basada en nubes de puntos 3D de Uni3C proporciona un control robusto de cámara desde imágenes únicas.

- Guía Global del Mundo 3D: Uni3C asegura la alineación de transformación rígida entre nubes de puntos ambientales y personajes SMPL-X para generación de video espacialmente consistente.

3. Cómo Usar el Flujo de Trabajo Uni3C

Uni3C opera mediante extracción de referencia de video, que analiza videos de referencia para entender tanto movimientos de cámara como movimientos humanos, luego aplica los patrones para generar nuevos videos a partir de las imágenes de entrada. Este enfoque permite un control preciso con Uni3C sin ajuste manual de parámetros.

3.1 Método 1: Control de Cámara Referenciado en Video

Mejor para:

Extraer movimientos de cámara de videos de referencia y aplicarlos a nuevas escenas usando Uni3C.

Proceso de Configuración:

- Cargar Video de Referencia: Sube cualquier video con movimiento de cámara interesante en el nodo

Load Video (Upload)- Buenos Ejemplos: Videos con zoom de cámara en sujetos, grabaciones caminando con movimiento natural de cabeza, paneos cinematográficos, tomas orbitales

- Punto Clave: Cualquier video con movimiento de cámara claro funciona - desde grabaciones de teléfono hasta cinematografía profesional con Uni3C.

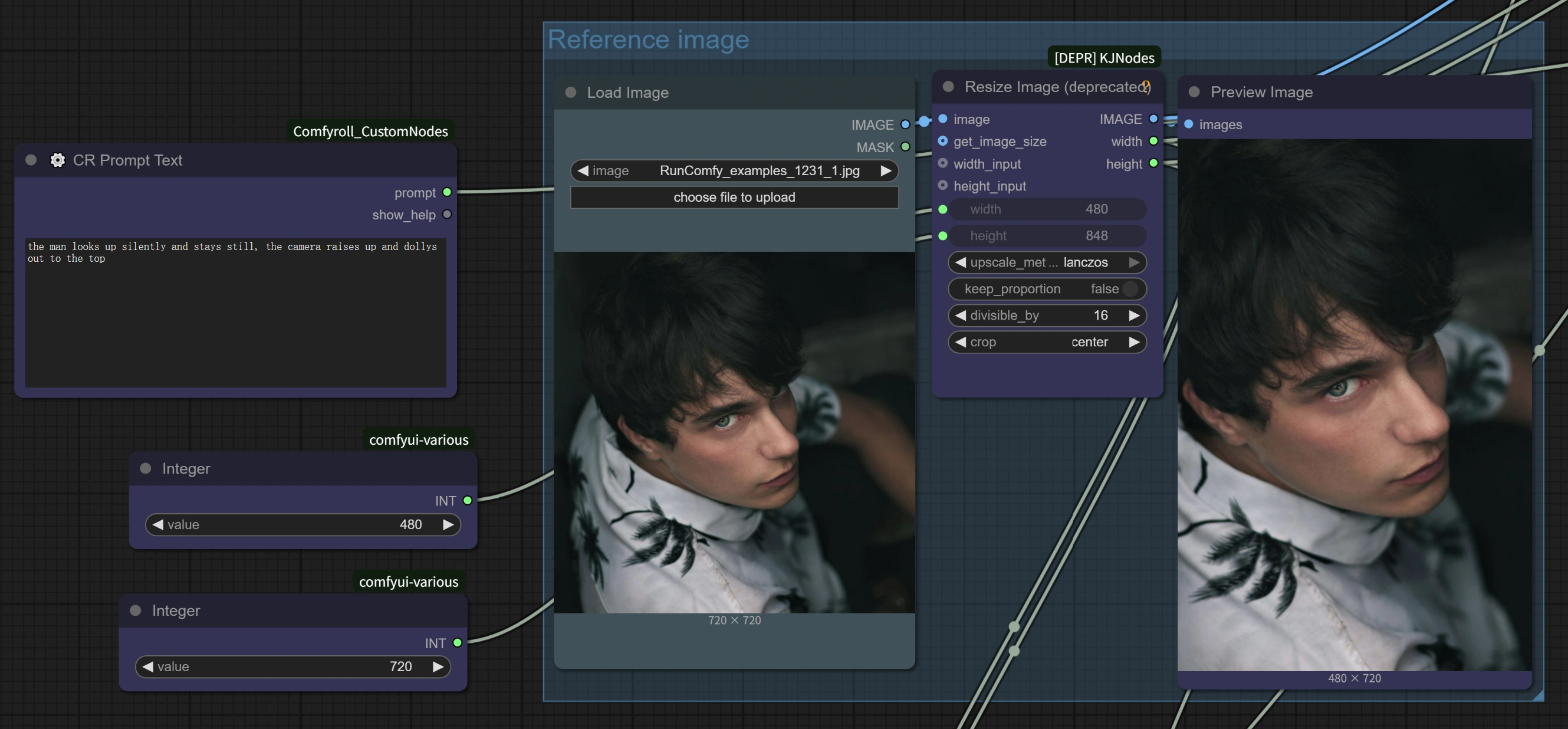

- Cargar Imagen Objetivo: Sube tu imagen base en el nodo

Load Image(funciona con cualquier estilo: realista, anime, arte, generado por IA) - Escribe Tu Prompt: Describe tu escena deseada en el área de texto para Uni3C

- Configurar Ajustes: El flujo de trabajo Uni3C incluye parámetros optimizados para una mejora de velocidad 4x

- Generar: Ejecuta el flujo de trabajo para transferir el movimiento de cámara del video de referencia a tu escena con Uni3C.

Consejos Avanzados:

- Coincidencia de Dirección de Movimiento: Los mejores resultados ocurren cuando la dirección del movimiento del video de referencia se alinea con la composición de tu escena prevista para **Uni3C.

- Coordinación de Prompts: Escribe prompts que complementen el estilo de movimiento de cámara para mejorar la coherencia con Uni3C.

- Calidad de Referencia: Elige videos de referencia con movimientos de cámara estables y claros para resultados óptimos con Uni3C.

3.2 Método 2: Transferencia de Movimiento Humano

Mejor para:

Transferir movimientos humanos de videos de referencia a diferentes personajes usando Uni3C.

Proceso de Configuración:

- Video de Referencia con Movimiento Humano: Sube un video que contenga los movimientos humanos que deseas transferir

- Imagen de Personaje Objetivo: Carga una imagen del personaje que deseas animar

- Control de Movimiento mediante Prompts:

- Preservar Movimiento Original: Usa descripciones generales como "una mujer caminando" para mantener el movimiento de referencia con Uni3C.

- Modificar Acciones: Sé específico para cambiar movimientos: "una mujer peinándose" alterará los gestos de las manos mientras preserva el flujo general del movimiento con Uni3C.

Ventajas Clave:

- No se Requiere Esqueleto: A diferencia de la captura de movimiento tradicional, Uni3C entiende el movimiento humano sin rigging complejo.

- Preservación de Detalles: Uni3C mantiene accesorios, peinados y detalles de vestimenta durante la transferencia de movimiento.

- Control Simultáneo: Tanto el movimiento de cámara como el movimiento humano se transfieren juntos desde el mismo video de referencia usando Uni3C.

Arquitectura de Optimización de Rendimiento: El flujo de trabajo Uni3C implementa varias estrategias de optimización incluyendo tamaño oculto reducido de 5120 a 1024 en PCDController, capas de proyección lineal inicializadas en cero, e inyección de características de control de cámara solo en las primeras 20 capas del modelo base. La optimización de coincidencia de flujo con pasos de muestreo reducidos (10 vs 20+) y escalas de guía CFG ajustadas proporciona hasta 4x de mejora en la velocidad de procesamiento en Uni3C mientras se mantiene la calidad de generación.

3.3 Configuraciones de Rendimiento Optimizado

Configuración de Impulso de Velocidad 4x: Basado en las optimizaciones integradas de Uni3C, las siguientes configuraciones proporcionan un procesamiento dramáticamente más rápido:

Configuraciones del Nodo WanVideo Sampler:

Steps: 10 (reducido del predeterminado 20+)CFG: 1.0-1.5 (optimizado para equilibrio velocidad-calidad)Shift: 5.0-7.0 (el autor recomienda 7 para mejores resultados, 5 para un procesamiento más rápido con Uni3C)Scheduler: UniPC (programador optimizado para Uni3C)

Características Clave de Rendimiento:

- Integración AnimateDiff: Uni3C aprovecha las optimizaciones AnimateDiff diseñadas originalmente para texto a video pero efectivas para generación de imagen a video.

- Reducción Inteligente de Parámetros: Dado que la imagen a video comienza con contenido visual existente, se requieren menos pasos de desruido en comparación con la generación de texto a video con Uni3C.

- Procesamiento Optimizado: Uni3C permite completar videos de 70 cuadros en ~4-5 minutos (vs ~27 minutos con configuraciones originales).

Opciones de Calidad vs Velocidad:

- Máxima Velocidad: Steps=10, CFG=1.0, Shift=5 → ~4 minutos para 70 cuadros con Uni3C

- Equilibrado: Steps=10, CFG=1.5, Shift=7 → ~5 minutos para 70 cuadros con Uni3C

- Mayor Calidad: Steps=15, CFG=2.0, Shift=7 → ~8-10 minutos para 70 cuadros con Uni3C

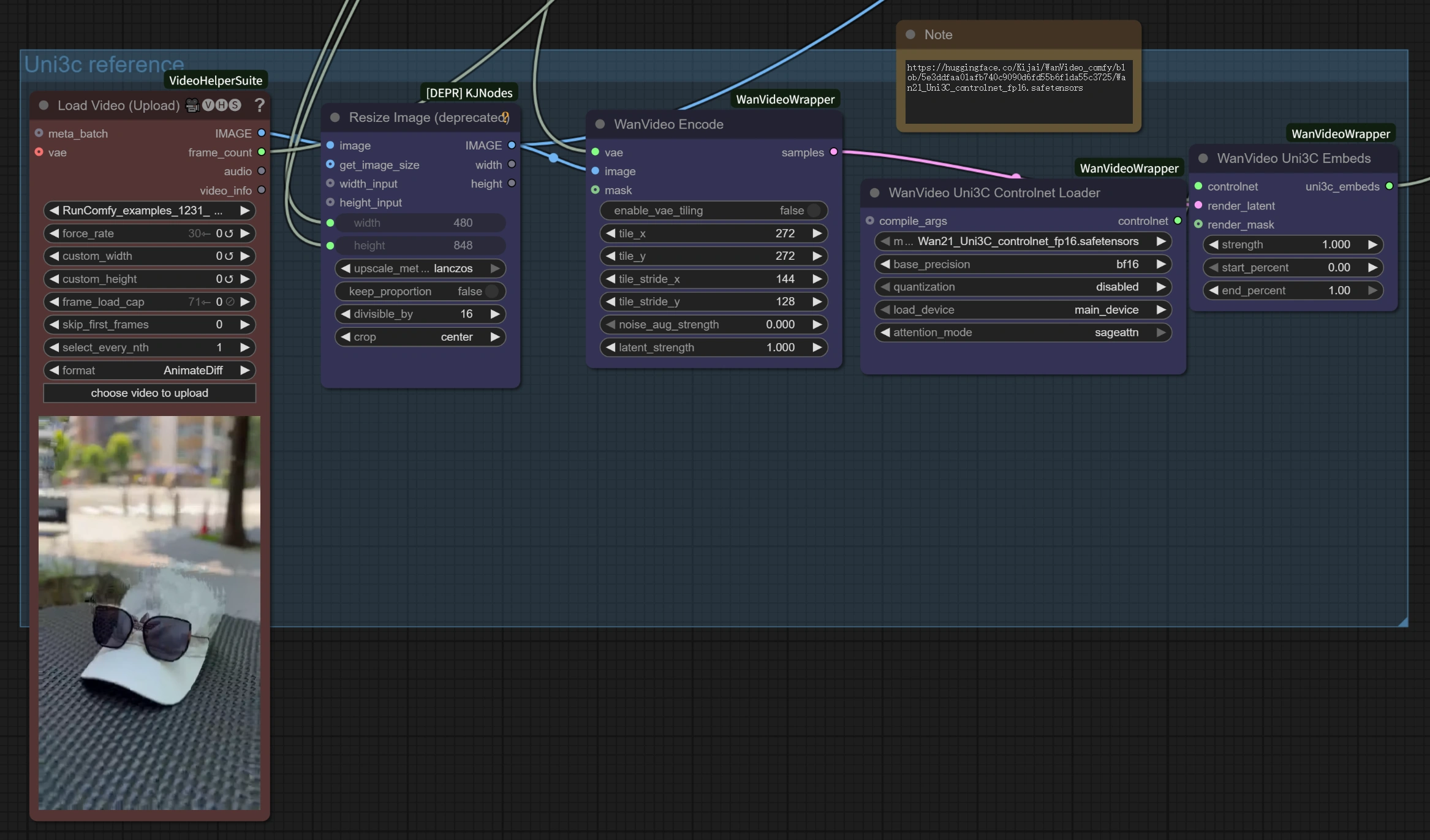

3.4 Comprensión de Componentes del Flujo de Trabajo

Sección de Procesamiento de Video de Referencia:

Load Video (Upload): Acepta formatos de video estándar como MP4, AVI para referencia de movimiento en Uni3C.WanVideo Encode: Procesa el video de referencia para extraer trayectorias de cámara y patrones de movimiento para Uni3C.Uni3C ControlNet Loader: Carga el modelo de control especializado de Uni3C para comprensión de movimiento.

Sección de Generación de Imagen a Video:

Load Image: Tu imagen objetivo que será animada con el movimiento de referencia por Uni3C.WanVideo Image/ToVideo Encode: Convierte tu imagen estática en un formato adecuado para generación de video por Uni3C.WanVideo Sampler: Motor de generación central con configuraciones optimizadas para mejora de velocidad 4x en Uni3C.

Procesamiento de Salida:

WanVideo Decode: Convierte el video latente generado de nuevo a un formato visible desde Uni3C.Video Combine: Ensambla el archivo de video final con la tasa de cuadros y codificación adecuada desde Uni3C.

4. Consejos Avanzados y Mejores Prácticas

Elegir Materiales de Referencia para Uni3C

- Para Transferencia de Movimiento: Selecciona videos con movimientos claros y visibles donde la persona se mantenga mayormente en cuadro para Uni3C.

- Para Control de Cámara: Cualquier video con perspectiva interesante o movimiento de cámara deseado para Uni3C.

- Mejores Resultados: Cuando la dirección del movimiento de referencia coincide con tu dirección de salida prevista con Uni3C.

Mejores Prácticas de Ingeniería de Prompts para Uni3C

- Principio "No Molestar": Para transferencia de movimiento puro sin cambios de personaje, usa prompts simples y generales con Uni3C.

- Cambios Específicos de Acción: Sé detallado cuando desees modificar lo que el personaje está haciendo con Uni3C.

- Consistencia de Personaje: Enfoca los prompts en mantener la apariencia del personaje con Uni3C.

Optimización de Calidad para Uni3C

- Consistencia de Movimiento: Evita cambios bruscos en los videos de referencia para resultados más suaves con Uni3C.

- Estabilidad de Cuadros: Asegúrate de que los materiales de referencia tengan iluminación y encuadre consistentes para Uni3C.

5. Agradecimientos

Este flujo de trabajo está potenciado por Uni3C, desarrollado por DAMO Academy (Alibaba Group), Fudan University, y Hupan Lab. La integración ComfyUI se basa en el excelente trabajo de kijai (ComfyUI-WanVideoWrapper), con optimizaciones adicionales y diseño de flujo de trabajo para hacer esta poderosa tecnología Uni3C accesible a creadores en todo el mundo.