Z-Image Basis LoRA ComfyUI Inferenz: training-angepasste Generierung mit AI Toolkit LoRAs

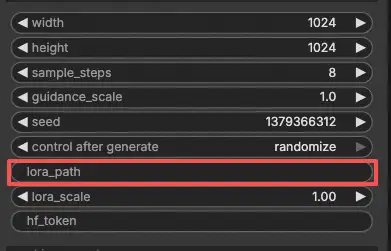

Dieser produktionsbereite RunComfy-Workflow ermöglicht Ihnen das Ausführen von AI Toolkit–trainierten Z-Image LoRA-Adaptern in ComfyUI mit training-übereinstimmenden Ergebnissen. Er basiert auf RC Z-Image (RCZimage)—einem benutzerdefinierten Knoten auf Pipeline-Ebene, der von RunComfy als Open Source zur Verfügung gestellt wird (source)—und umschließt die Tongyi-MAI/Z-Image Inferenzpipeline, anstatt sich auf einen generischen Sampler-Graphen zu verlassen. Ihr Adapter wird über lora_path und lora_scale innerhalb dieser Pipeline eingespeist, was die Anwendung der LoRA konsistent mit der Art und Weise hält, wie das AI Toolkit Trainingsvorschauen erzeugt.

Warum die Z-Image Basis LoRA ComfyUI Inferenz in ComfyUI oft anders aussieht

AI Toolkit Trainingsvorschauen werden von einer modellspezifischen Inferenzpipeline gerendert—Scheduler-Konfiguration, Konditionierungsfluss und LoRA-Einspeisung erfolgen alle innerhalb dieser Pipeline. Ein Standard-ComfyUI-Sampler-Graph fügt diese Teile anders zusammen, sodass selbst identische Prompts, Seeds und Schrittzahlen merklich unterschiedliche Ausgaben erzeugen können. Die Diskrepanz wird nicht durch einen einzigen falschen Parameter verursacht; es handelt sich um eine Pipeline-Fehlanpassung. RCZimage stellt das training-übereinstimmende Verhalten wieder her, indem es die Z-Image-Pipeline direkt umschließt und Ihre LoRA darin anwendet. Implementierungsreferenz: `src/pipelines/z_image.py`.

So verwenden Sie den Z-Image Basis LoRA ComfyUI Inferenz-Workflow

Schritt 1: Holen Sie sich den LoRA-Pfad und laden Sie ihn in den Workflow (2 Optionen)

Option A — RunComfy Trainingsergebnis → Download auf lokales ComfyUI:

- Gehen Sie zu Trainer → LoRA Assets

- Finden Sie die LoRA, die Sie verwenden möchten

- Klicken Sie auf das ⋮ (Dreipunktmenü) rechts → wählen Sie LoRA-Link kopieren

- Fügen Sie auf der ComfyUI-Workflow-Seite den kopierten Link in das Download-Eingabefeld in der oberen rechten Ecke der Benutzeroberfläche ein

- Bevor Sie auf Download klicken, stellen Sie sicher, dass der Zielordner auf ComfyUI → models → loras eingestellt ist (dieser Ordner muss als Download-Ziel ausgewählt sein)

- Klicken Sie auf Download — dies speichert die LoRA-Datei im richtigen

models/lorasVerzeichnis - Nach Abschluss des Downloads, aktualisieren Sie die Seite

- Die LoRA erscheint nun im LoRA-Auswahl-Dropdown im Workflow — wählen Sie sie aus

Option B — Direkte LoRA URL (überschreibt Option A):

- Fügen Sie die direkte

.safetensorsDownload-URL in daspath / urlEingabefeld des LoRA-Knotens ein - Wenn hier eine URL angegeben wird, überschreibt sie Option A — der Workflow lädt die LoRA direkt von der URL zur Laufzeit

- Kein lokaler Download oder Dateiplatzierung erforderlich

Tipp: Die URL muss auf die tatsächliche .safetensors Datei zeigen, nicht auf eine Webseite oder Weiterleitung.

Schritt 2: Passen Sie die Inferenzparameter an Ihre Trainingsbeispiel-Einstellungen an

Stellen Sie lora_scale am LoRA-Knoten ein — beginnen Sie mit der gleichen Stärke, die Sie während der Trainingsvorschauen verwendet haben, und passen Sie sie bei Bedarf an.

Die verbleibenden Parameter befinden sich auf dem Generate-Knoten:

prompt— Ihr Textprompt; fügen Sie alle Triggerwörter hinzu, die Sie während des Trainings verwendet habennegative_prompt— leer lassen, es sei denn, Ihr Trainings-YAML enthielt Negativeswidth/height— Ausgabeauflösung; passen Sie Ihre Vorschaugröße für einen direkten Vergleich an (Vielfache von 32)sample_steps— Anzahl der Inferenzschritte; Z-Image Basis standardmäßig 30 (verwenden Sie die gleiche Anzahl aus Ihrer Vorschaukonfiguration)guidance_scale— CFG-Stärke; Standard ist 4.0 (spiegeln Sie zunächst Ihren Trainingsvorschauwert)seed— fixieren Sie einen Seed, um spezifische Ausgaben zu reproduzieren; ändern Sie ihn, um Variationen zu erkundenseed_mode— wählen Siefixedoderrandomizehf_token— Hugging Face Token; nur erforderlich, wenn das Basismodell oder das LoRA-Repo gesperrt/privat ist

Training-Alignment-Tipp: Wenn Sie während des Trainings Sampling-Werte angepasst haben, kopieren Sie diese genauen Werte in die entsprechenden Felder. Wenn Sie auf RunComfy trainiert haben, öffnen Sie Trainer → LoRA Assets → Config, um das aufgelöste YAML zu sehen und Vorschau-/Beispieleinstellungen in den Knoten zu kopieren.

Schritt 3: Führen Sie die Z-Image Basis LoRA ComfyUI Inferenz aus

Klicken Sie auf Queue/Run — der SaveImage-Knoten schreibt Ergebnisse automatisch in Ihren ComfyUI-Ausgabeordner.

Kurze Checkliste:

- ✅ LoRA ist entweder: in

ComfyUI/models/lorasheruntergeladen (Option A) oder über eine direkte.safetensorsURL geladen (Option B) - ✅ Seite nach lokalem Download aktualisiert (nur Option A)

- ✅ Inferenzparameter stimmen mit der Trainings-

sample-Konfiguration überein (falls angepasst)

Wenn alles oben korrekt ist, sollten die Inferenzresultate hier Ihren Trainingsvorschauen nahekommen.

Fehlerbehebung bei der Z-Image Basis LoRA ComfyUI Inferenz

Die meisten Unterschiede zwischen “Trainingsvorschau und ComfyUI Inferenz” für Z-Image Basis (Tongyi-MAI/Z-Image) entstehen durch Pipeline-Ebene Unterschiede (wie das Modell geladen wird, welche Standard-/Scheduler verwendet werden und wo/wie die LoRA eingespeist wird). Für AI Toolkit–trainierte Z-Image Basis LoRAs ist der zuverlässigste Weg, um zurück zu training-angepasstem Verhalten in ComfyUI zu gelangen, die Generierung über RCZimage (den RunComfy-Pipeline-Wrapper) auszuführen und die LoRA über lora_path / lora_scale innerhalb dieser Pipeline einzuspeisen.

(1) Beim Verwenden von Z-Image LoRA mit ComfyUI erscheint die Nachricht "lora key not loaded".

Warum dies passiert Dies bedeutet normalerweise, dass Ihre LoRA gegen ein anderes Modul/Schlüssel-Layout trainiert wurde, als das, was Ihr aktueller ComfyUI Z-Image Loader erwartet. Bei Z-Image kann der „gleiche Modellname“ immer noch unterschiedliche Schlüsselkonventionen beinhalten (z.B. original/diffusers-artig vs Comfy-spezifische Benennung), und das reicht aus, um „key not loaded“ auszulösen.

Wie man das behebt (empfohlen)

- Führen Sie die Inferenz über RCZimage (den Pipeline-Wrapper des Workflows) aus und laden Sie Ihren Adapter über

lora_pathauf dem RCAITKLoRA / RCZimage-Pfad, anstatt ihn über einen separaten generischen Z-Image LoRA Loader einzuspeisen. - Halten Sie den Workflow format-konsistent: Z-Image Basis LoRA mit AI Toolkit trainiert → mit der AI Toolkit-angepassten RCZimage-Pipeline inferieren, sodass Sie nicht auf ComfyUI-seitige Schlüssel-Neuzuordnungen/Konverter angewiesen sind.

(2) Fehler traten während der VAE-Phase auf, wenn der ZIMAGE LORA Loader (nur Modell) verwendet wurde.

Warum dies passiert Einige Benutzer berichten, dass das Hinzufügen des ZIMAGE LoRA Loaders (nur Modell) zu erheblichen Verlangsamungen und späteren Fehlern in der endgültigen VAE-Dekodierungsphase führen kann, selbst wenn der Standard-Z-Image-Workflow ohne den Loader einwandfrei läuft.

Wie man das behebt (benutzerbestätigt)

- Entfernen Sie den ZIMAGE LORA Loader (nur Modell) und führen Sie den Standard-Z-Image-Workflow-Pfad erneut aus.

- In diesem RunComfy-Workflow ist das äquivalente „sichere Baseline“: Verwenden Sie RCZimage +

lora_path/lora_scale, sodass die LoRA-Anwendung innerhalb der Pipeline bleibt, um den problematischen „nur Modell LoRA Loader“-Pfad zu vermeiden.

(3) Z-Image Comfy-Format stimmt nicht mit dem ursprünglichen Code überein

Warum dies passiert Z-Image in ComfyUI kann ein Comfy-spezifisches Format beinhalten (einschließlich Schlüsselbenennungsunterschiede zu „ursprünglichen“ Konventionen). Wenn Ihre LoRA mit AI Toolkit auf einer Namens-/Layout-Konvention trainiert wurde und Sie versuchen, sie in ComfyUI mit einer anderen zu verwenden, werden Sie eine teilweise/fehlgeschlagene Anwendung und „Es läuft, sieht aber falsch aus“-Verhalten sehen.

Wie man das behebt (empfohlen)

- Mischen Sie keine Formate, wenn Sie versuchen, Trainingsvorschauen zu erreichen. Verwenden Sie RCZimage, sodass die Inferenz die Z-Image-Pipeline in der gleichen „Familie“ ausführt, die AI Toolkit-Vorschauen verwenden, und injizieren Sie die LoRA darin über

lora_path/lora_scale. - Wenn Sie unbedingt einen Comfy-format Z-Image-Stack verwenden müssen, stellen Sie sicher, dass Ihre LoRA im gleichen Format vorliegt, das von diesem Stack erwartet wird (ansonsten stimmen die Schlüssel nicht überein).

(4) Z-Image oom unter Verwendung von lora

Warum dies passiert Z-Image + LoRA kann je nach Präzision/Quantisierung, Auflösung und Loader-Pfad den VRAM überlasten. Einige Berichte erwähnen OOM auf 12GB VRAM-Setups, wenn LoRA mit niedrigpräzisen Modi kombiniert wird.

Wie man das behebt (sichere Baseline)

- Validieren Sie zuerst Ihre Baseline: Führen Sie Z-Image Basis ohne LoRA bei Ihrer Zielauflösung aus.

- Fügen Sie dann die LoRA über RCZimage (

lora_path/lora_scale) hinzu und halten Sie die Vergleiche kontrolliert (gleichewidth/height,sample_steps,guidance_scale,seed). - Wenn Sie immer noch OOM erreichen, reduzieren Sie zuerst die Auflösung (Z-Image ist empfindlich gegenüber der Pixelanzahl), dann ziehen Sie in Betracht,

sample_stepszu reduzieren, und führen Sie erst dann höhere Einstellungen wieder ein, nachdem die Stabilität bestätigt wurde. In RunComfy können Sie auch auf eine größere Maschine wechseln.

Führen Sie jetzt die Z-Image Basis LoRA ComfyUI Inferenz aus

Öffnen Sie den RunComfy Z-Image Basis LoRA ComfyUI Inference Workflow, setzen Sie Ihren lora_path, und lassen Sie RCZimage die ComfyUI-Ausgabe mit Ihren AI Toolkit-Trainingsvorschauen abstimmen.