Segment Anything V2,又稱 SAM2,是由 Meta AI 開發的突破性 AI 模型,革新了影像與影片中的物件分割。

Segment Anything V2 (SAM2) 是什麼?

Segment Anything V2 是一款最先進的 AI 模型,能夠在影像與影片中無縫分割物件。這是首個能夠處理影像和影片分割任務的統一模型,具備卓越的準確性與效率。Segment Anything V2 (SAM2) 建立在其前身 Segment Anything Model (SAM) 的成功基礎上,將其可提示能力擴展至影片領域。

使用 Segment Anything V2 (SAM2),用戶可以透過各種輸入方法選擇影像或影片框架中的物件,例如點擊、邊界框或遮罩。然後模型會智能地分割所選物件,允許在視覺內容中精確地提取和操作特定元素。

Segment Anything V2 (SAM2) 的亮點

- 最先進的性能:SAM2 在影像和影片的物件分割領域超越現有模型。它在準確性和精確度方面設立了新標準,超越了其前身 SAM 在影像分割任務中的表現。

- 影像與影片的統一模型:SAM2 是首個提供影像和影片物件分割統一解決方案的模型。這一整合簡化了 AI 藝術家的工作流程,因為他們可以使用單一模型處理多種分割任務。

- 增強的影片分割能力:SAM2 在影片物件分割中表現出色,特別是在追蹤物件部分方面。它超越了現有的影片分割模型,提供了更好的準確性和一致性,在多幀中分割物件。

- Segment A 的亮點。縮短的互動時間:與現有的互動式影片分割方法相比,SAM2 需要的用戶互動時間更少。這種效率允許 AI 藝術家專注於他們的創意願景,減少在手動分割任務上花費的時間。

- 簡單的設計和快速的推理:儘管具備先進的功能,SAM2 仍保持簡單的架構設計並提供快速的推理速度。這確保 AI 藝術家可以無縫地將 SAM2 整合到他們的工作流程中,而不影響性能或效率。

Segment Anything V2 (SAM2) 的運作方式

SAM2 透過引入每次會話記憶模組將 SAM 的可提示能力擴展至影片,該模組捕捉目標物件信息,允許在多幀中追蹤物件,即使在暫時消失時也能實現。流式架構一次處理一個影片幀,當記憶模組為空時,行為類似於影像的 SAM。這允許實時影片處理和 SAM 能力的自然泛化。SAM2 還支持基於用戶提示的互動式遮罩預測修正。該模型利用流記憶的變壓器架構,並在 SA-V 數據集上進行訓練,這是使用模型內循環數據引擎收集的最大影片分割數據集,通過用戶互動改進模型和數據。

如何在 ComfyUI 中使用 Segment Anything V2 (SAM2)

這個 ComfyUI 工作流程支持使用點擊/點選在影片框架中選擇物件。

1. 加載影片(上傳)

影片加載:選擇並上傳您希望處理的影片。

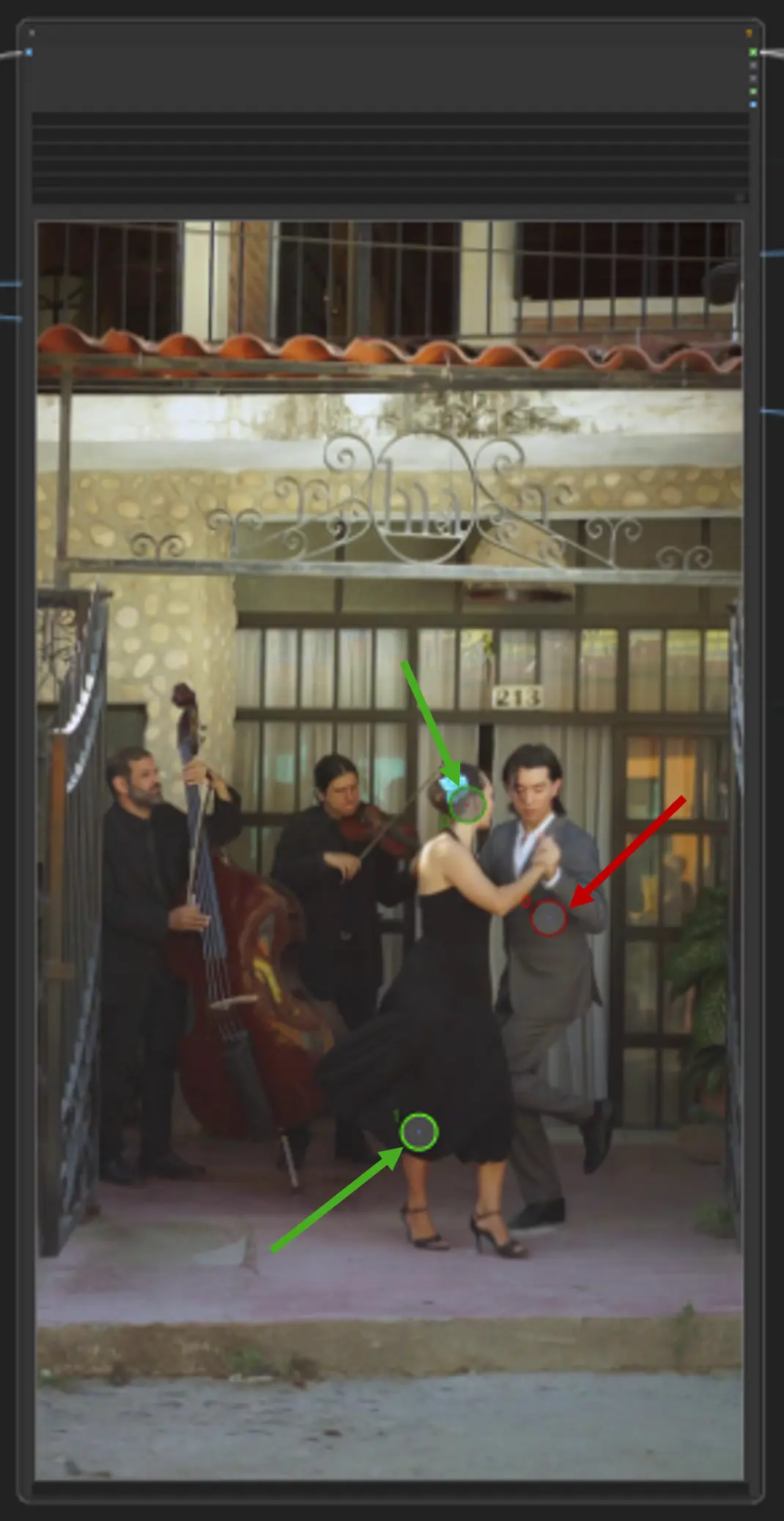

2. 點編輯器

關鍵點:在畫布上放置三個關鍵點—positive0、positive1 和 negative0:

positive0 和 positive1 標記您要分割的區域或物件。

negative0 幫助排除不需要的區域或干擾。

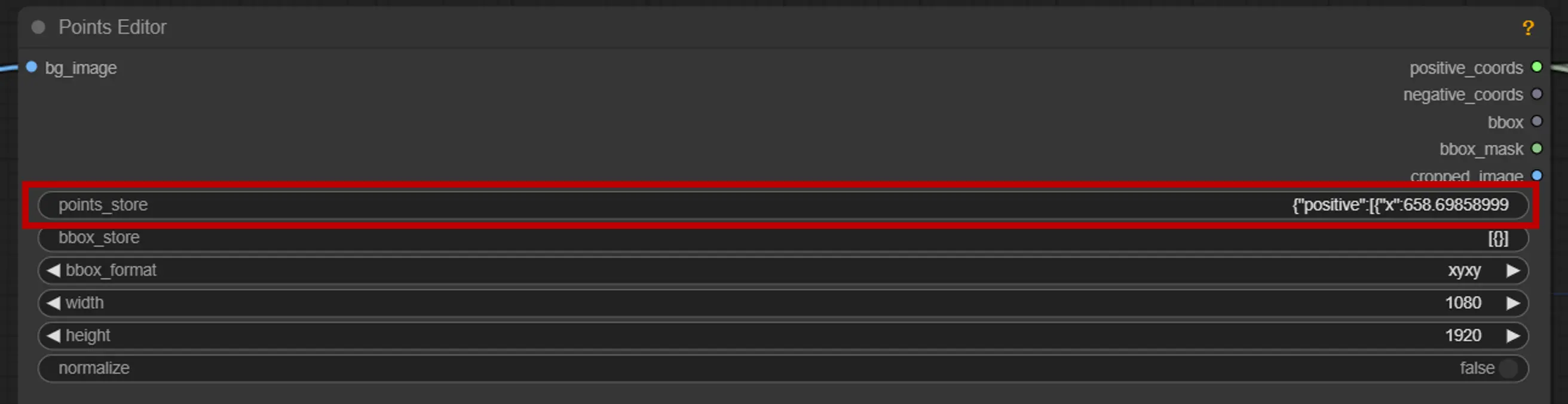

points_store:允許您根據需要添加或移除點以優化分割過程。

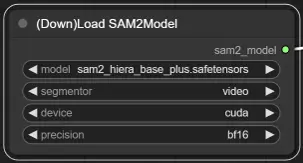

3. SAM2 模型選擇

模型選項:從可用的 SAM2 模型中選擇:tiny、small、large 或 base_plus。較大的模型提供更好的結果,但需要更多加載時間。

更多信息,請訪問 Kijai ComfyUI-segment-anything-2。