重要说明:支持的工作流程和模型

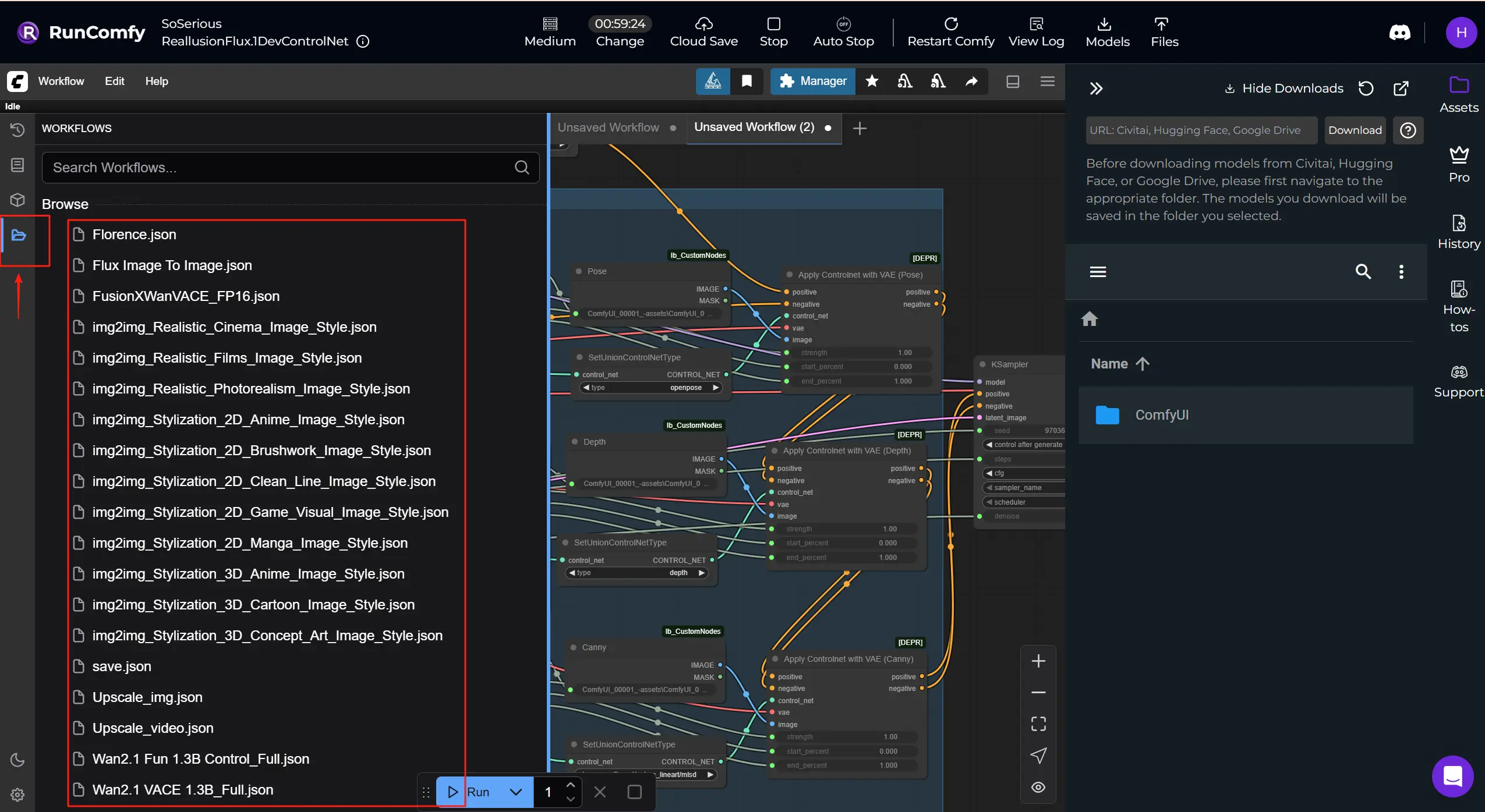

RunComfy 的云端不仅限于 FLUX.1-dev ControlNet 用于 Reallusion AI 渲染。您可以交换检查点、ControlNets、LoRAs、VAEs 和相关节点,以运行下列其他 Reallusion 工作流程 和 模型。

- FusionX WanVACE

- Wan2.1 Fun 1.3B Control

- Wan2.1 VACE 1.3B

- Wan2.1 VACE FusionX 14B

- Flux.1 Dev ControlNet

...

获取更多 Reallusion ComfyUI 工作流程:获取更多可以在 RunComfy 下载和运行的工作流程模板。点击 "Workflows" 按钮,尝试更多。

1. 什么是 Reallusion AI 渲染

Reallusion 是实时 2D/3D 角色创建和动画软件的开发者,以 iClone 和 Character Creator 而闻名,广泛用于电影/电视、游戏、建筑可视化、数字孪生和 AI 模拟。

Reallusion AI 渲染 是 3D 动画软件与 AI 驱动的内容生成工作流程之间的无缝桥梁。 可以将其视为一个 AI 渲染助手,从 iClone 或 Character Creator 直接接收布局、姿势、相机或照明数据,然后利用这些上下文在 ComfyUI 中自动生成细致的图像或视频。此集成将 Reallusion 的实时 3D 创建工具与 ComfyUI 的灵活、基于节点的 AI 处理架构结合起来,使基于图像和视频的叙事既由艺术家驱动,又由 3D 数据紧密引导。Reallusion AI 渲染支持多模态输入,如深度图、法线图、边缘检测(Canny)、3D 姿势数据和通过 IPAdapter 的风格图像。凭借其自定义的 Core、ControlNet、Additional Image 和 Upscale 节点,动画师和开发者可以在完全插件控制下渲染一致、风格化、高质量的输出,而无需手动操作 ComfyUI。

通过解释结构化指令并将其与内部参数预设结合,Reallusion AI 渲染将基于提示的生成转变为精确、可复制的生产过程。 它专为需要一致角色、细粒度风格控制和帧精确 AI 辅助序列渲染的电影、游戏或商业叙事创作者量身定制。

2. Reallusion AI 渲染工作流程的关键特性和优势

直接插件集成:Reallusion AI 渲染通过专用插件与 iClone 和 Character Creator 本地工作,实现实时反馈和控制,无需离开您的生产工具。

3D 引导的 ControlNet:通过 Reallusion AI 渲染的 ControlNet 节点,将深度、姿势、法线和边缘数据从 3D 场景无缝映射到 ComfyUI,实现电影级一致性和镜头级控制。

多图像风格支持:Reallusion AI 渲染工作流程包括支持灵活风格混合和基于参考方向的 Additional Image 节点,使其易于重用外观或执行高级 IP 自适应渲染。

智能放大工作流程:专用的 UpscaleData 节点使创作者能够在 Reallusion AI 渲染插件中定义输出分辨率,确保最终渲染符合项目规格,无需猜测。

完整的工作流程自动化:与通用的 ComfyUI 工作流程不同,Reallusion AI 渲染专为自动化而设计,模型、采样步骤、CFG 和音频同步等参数以编程方式传递,准备好批量渲染或自定义预设。

生产就绪的角色一致性:结合 LoRA 训练和 IP 创建工具,Reallusion AI 渲染在视频序列中保留面部完整性和视觉保真度,使其成为 AI 驱动叙事的理想选择。

3. 如何在 ComfyUI 中使用 Reallusion AI 渲染

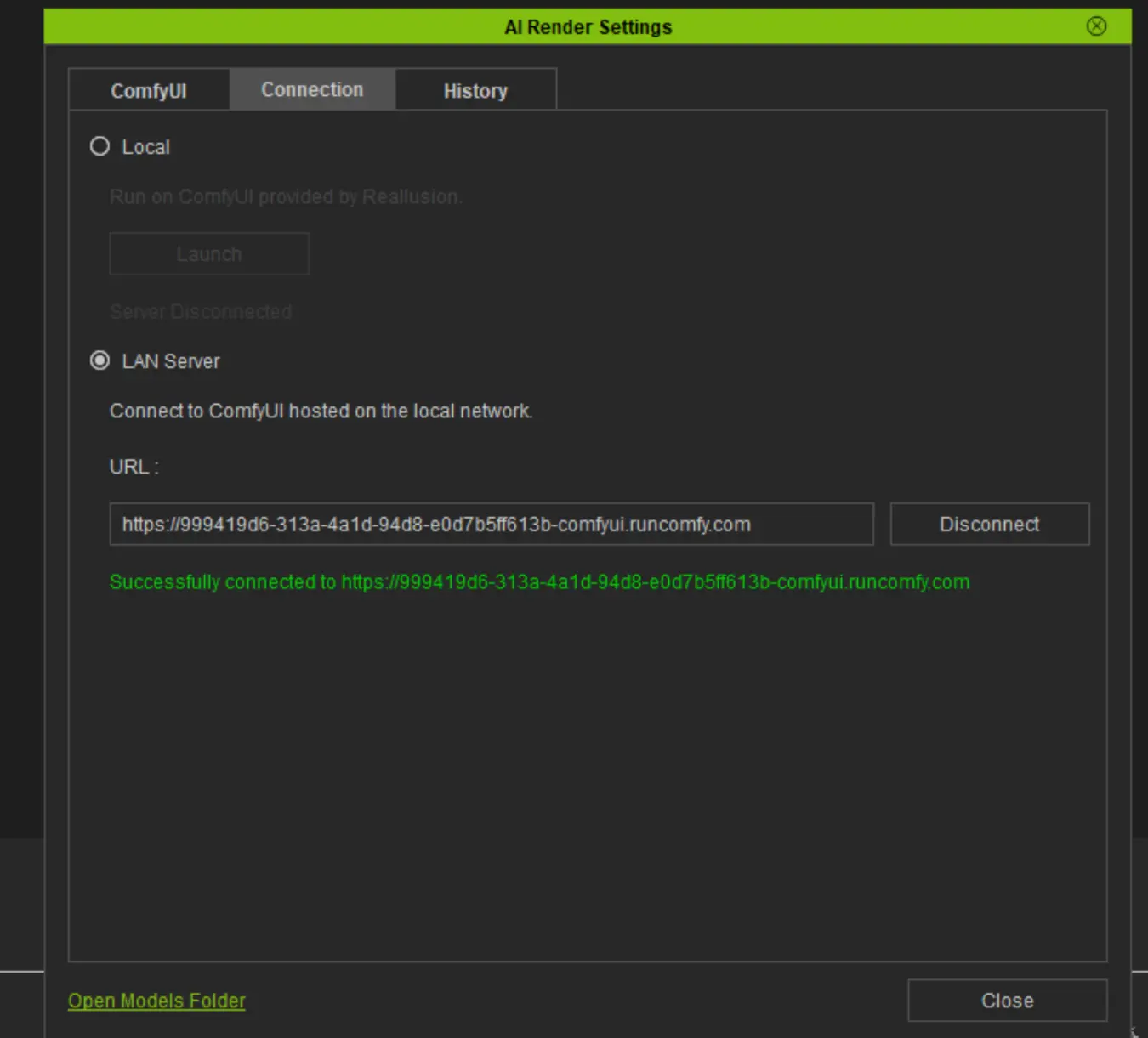

如何连接 AI Render 到 RunComfy 机器:⭐重要

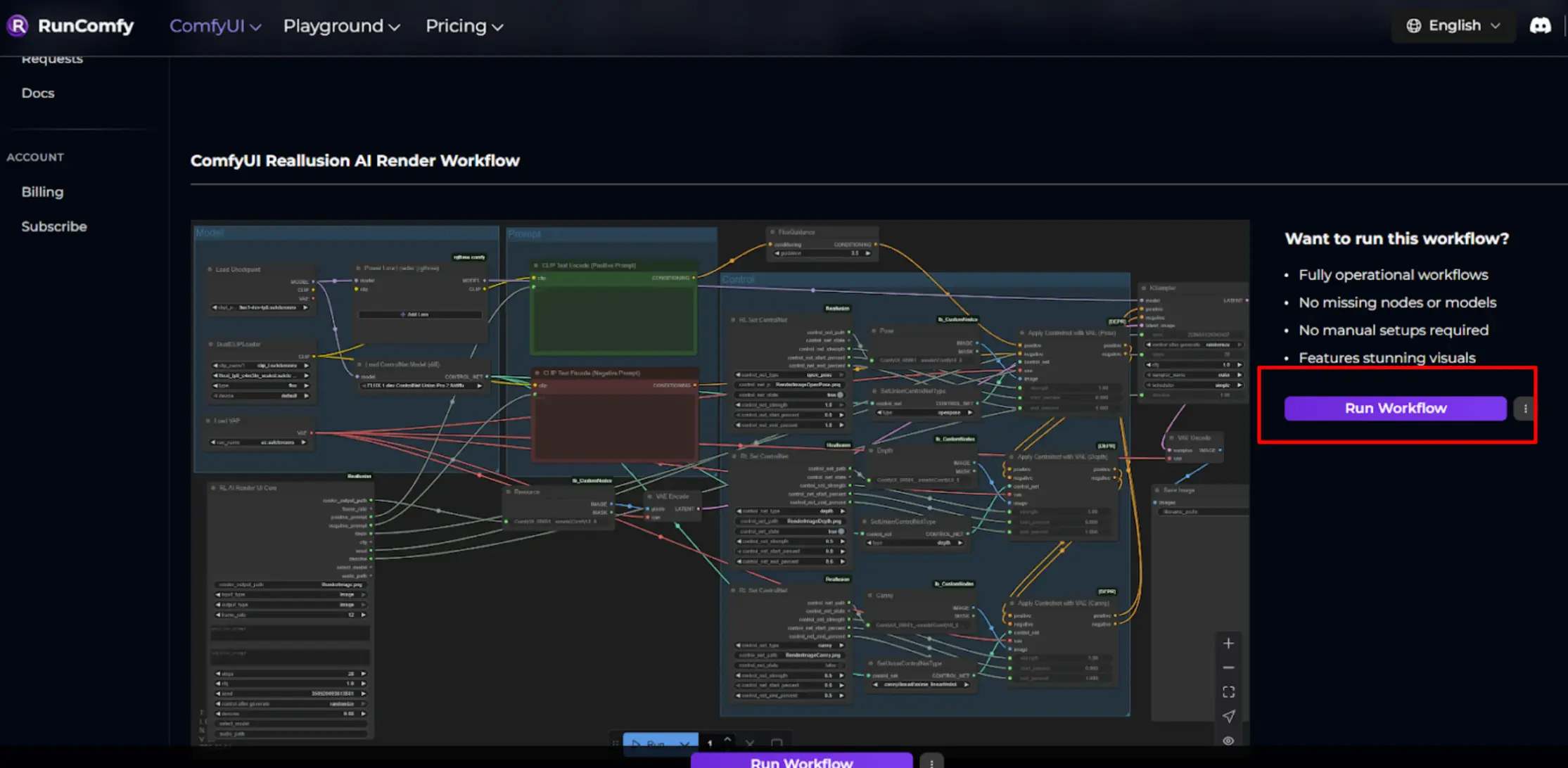

步骤 1. 点击 _Run Workflow_ 启动机器。

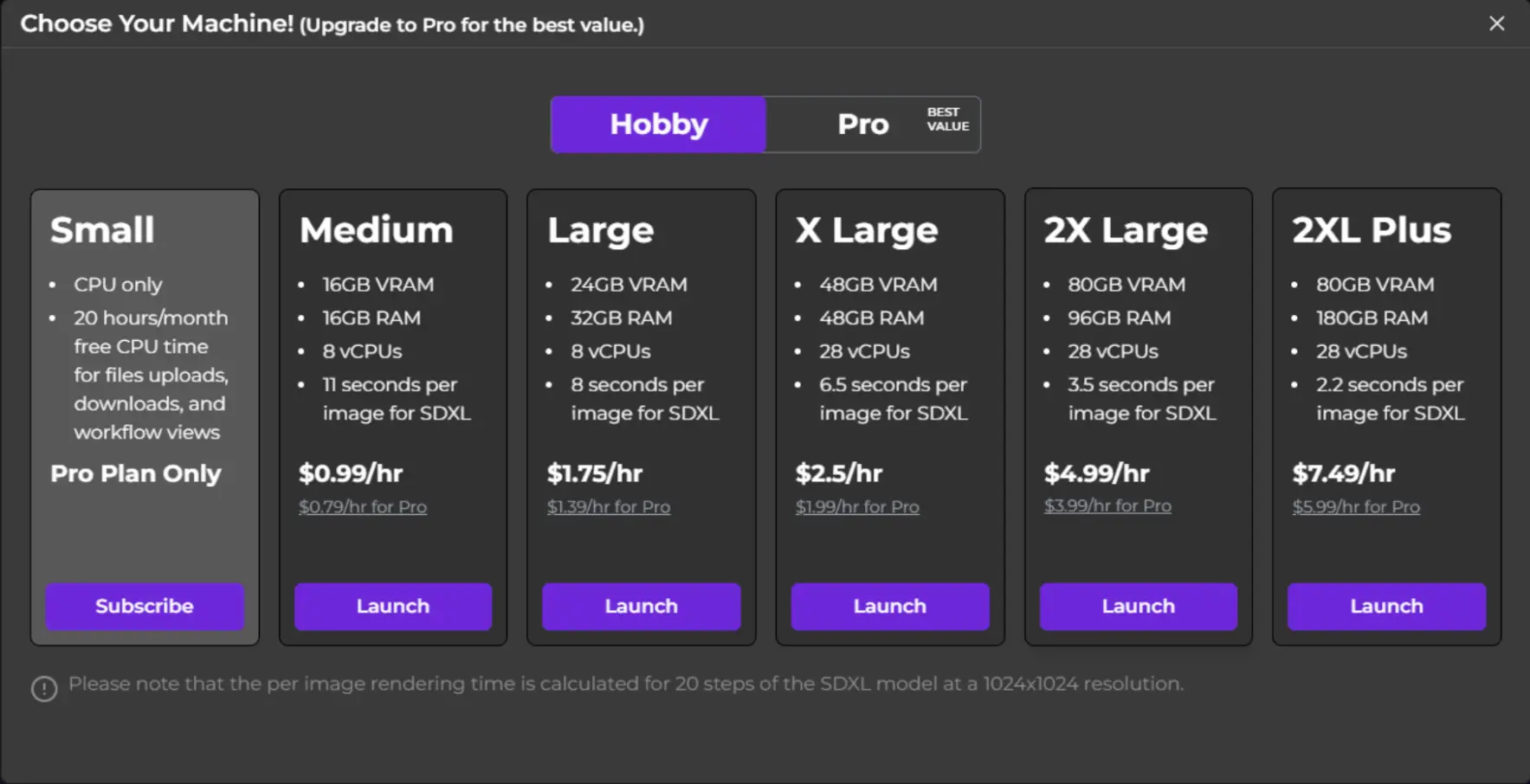

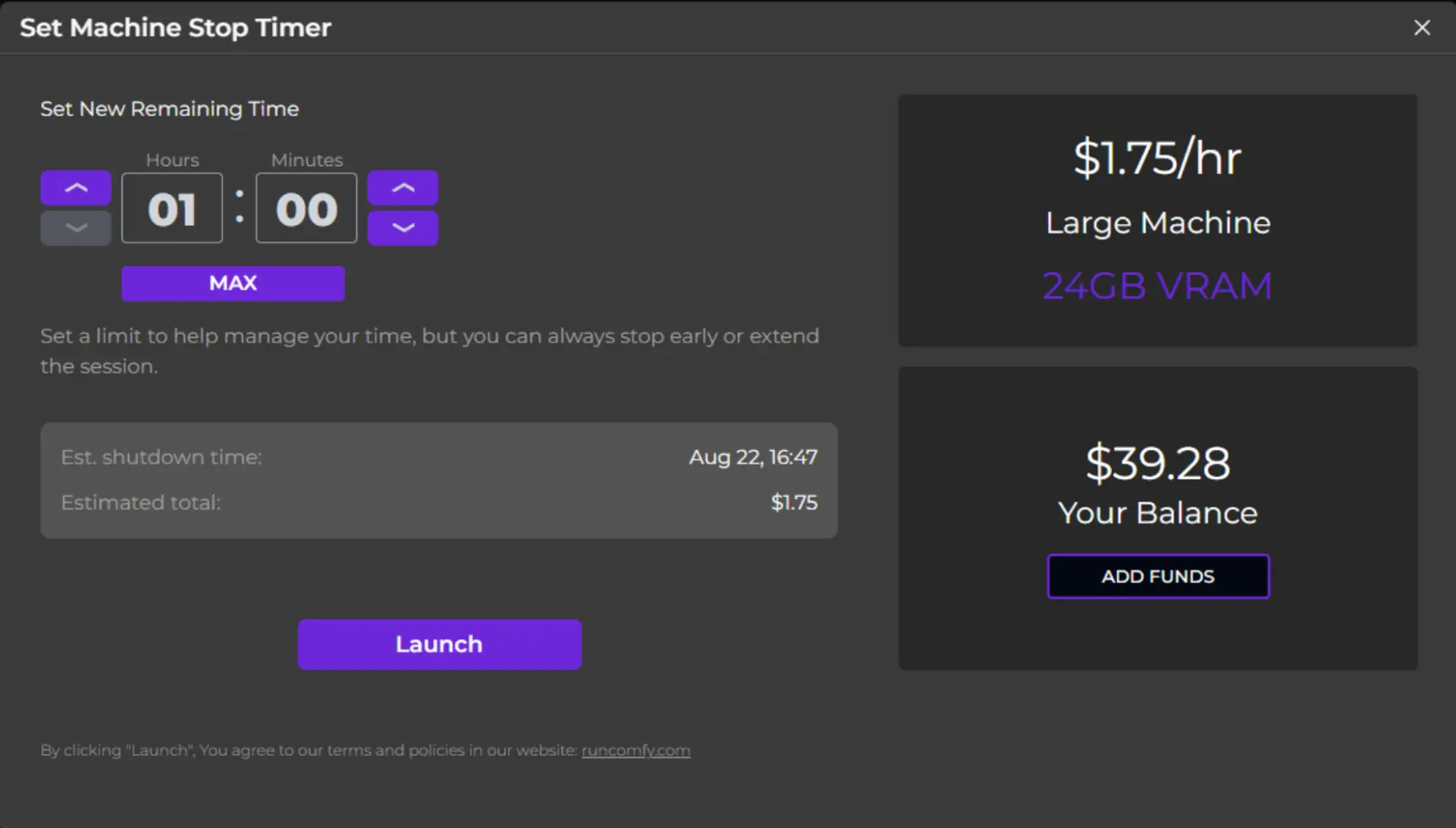

步骤 2. 选择机器层级并设置使用时间。

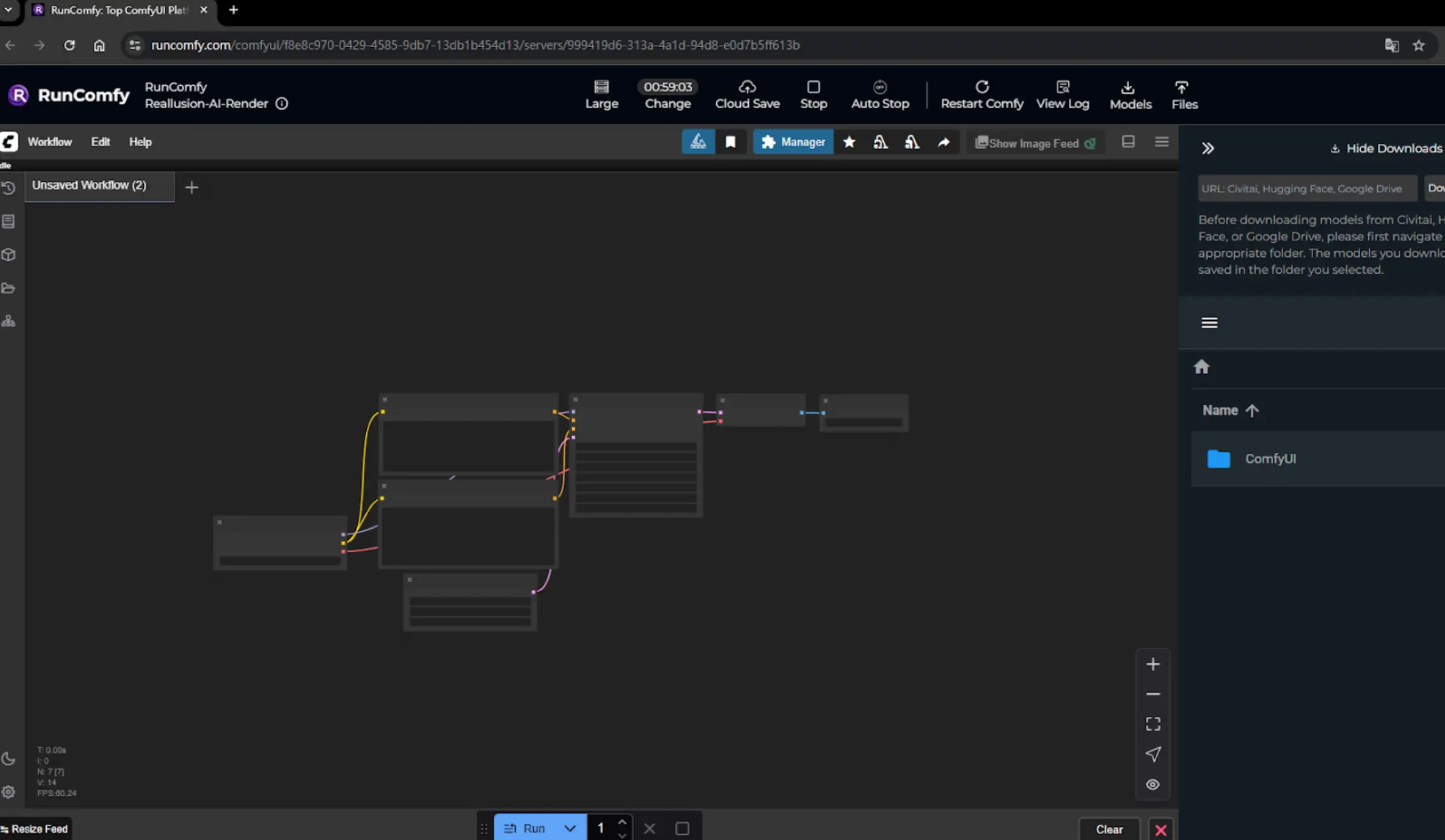

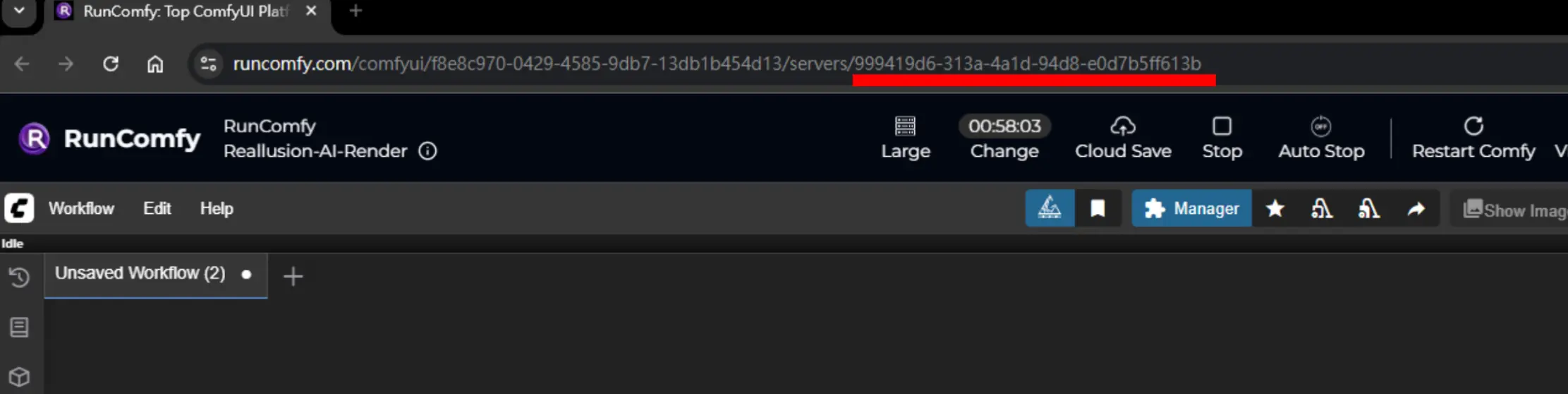

步骤 3. 等待机器初始化,直到您看到 ComfyUI fully loaded。

步骤 4. 将 AI Render 连接到 RunComfy 机器。

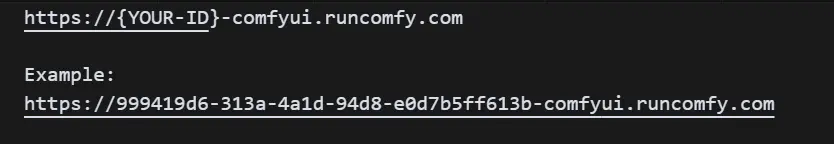

复制 显示的 RunComfy URL 的最后一部分,然后转到 AI Render Settings -> Server Mode,并以此格式输入 URL:

⚠️ 注意:每次启动新机器时,此 ID 会更改。

一旦您看到 "Successfully connected",连接完成,您可以开始使用。

节点基本设置

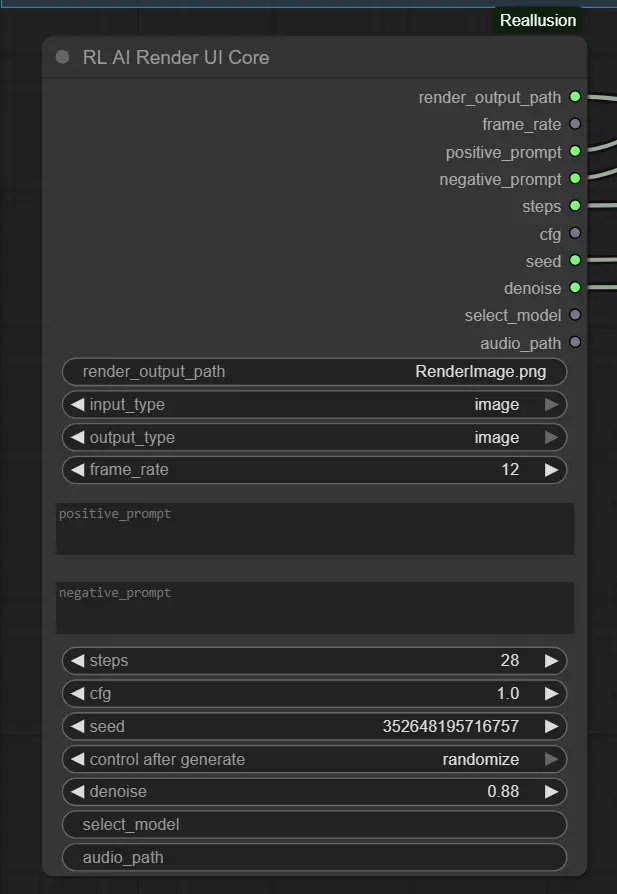

1. 提示和质量设置 – RL AI Render UI Core Node 此节点收集来自 AI Render 插件的主要参数。

- positive_prompt / negative_prompt:描述您期望和不期望的特征(默认:空)。

- steps:迭代多少次以优化图像。开始时使用 28 以平衡质量/速度。

- cfg:风格一致性。使用 1.0 以获得灵活性,稍微增加以增强提示影响。

- denoise:控制图像变化程度。使用 0.88 以进行风格化更新,较低值用于细微更改。

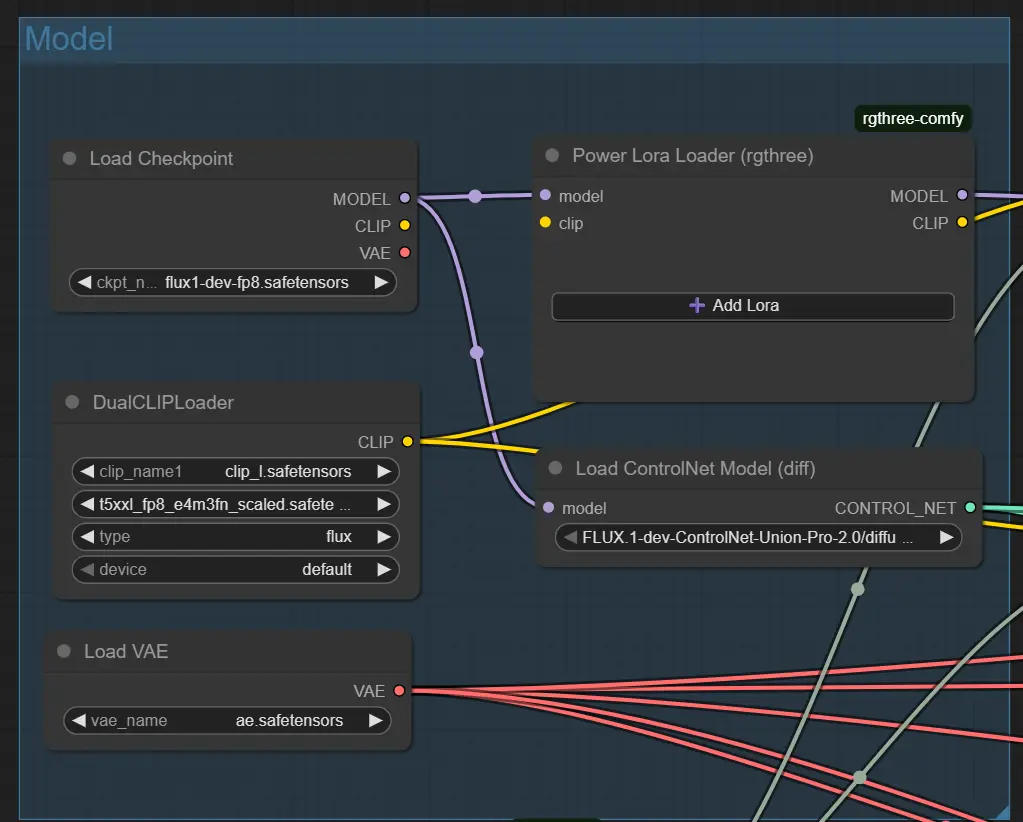

2. 基础模型设置 – Load Checkpoint Node

这会加载您选择的模型(例如,Flux 1 Dev ControlNet)。

ckpt_name:必须与您风格所期望的模型匹配(默认:flux1-dev-fp8.safetensors)。

使用支持 IPAdapter 或 ControlNet 的模型以获得最佳效果。

3. 结构指导 – ControlNet Nodes (Pose, Depth, Canny) 每个 ControlNet 节点加载一个特定的输入文件(例如,姿势图像);仅在控制启用时有效。

- control_net_strength:影响程度(姿势通常使用 1.0,深度通常使用 0.5)。

- 调整 start_percent 和 end_percent 以控制指导在生成中的淡入时间。 <img src="https://cdn.runcomfy.net/workflow_assets/1270/readme03.webp" alt="Reallusion AI Render - Workflow ControlNet" width="350"/>

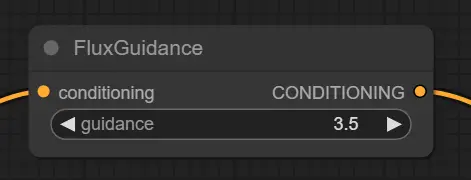

4. 提示条件 – Flux Guidance Node 调整提示如何塑造图像生成。

- guidance:值越高=越紧贴提示。推荐 3.5 以获得良好平衡。

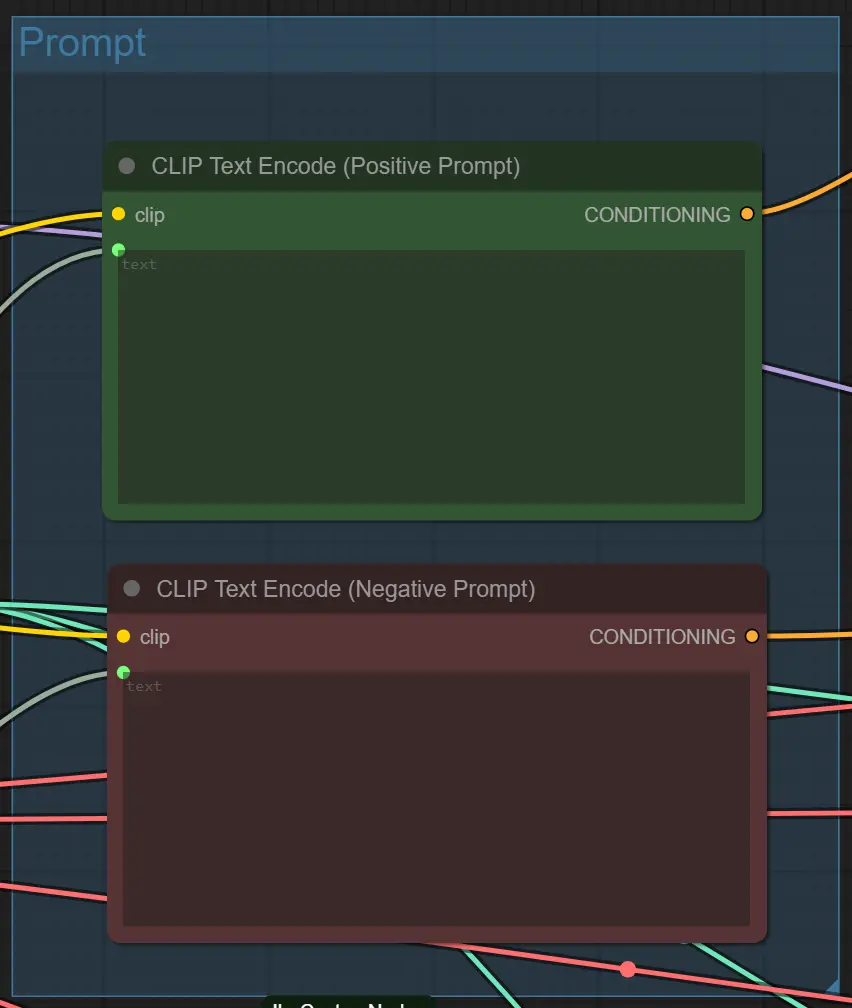

5. 文本提示编码 – CLIP Text Encode Nodes 从您的提示生成向量指导。

- 无需手动更改。接受来自插件的文本。

节点高级提示

提示清晰度 避免过于复杂或模糊的提示。使用直接风格,如 cinematic lighting、anime 或 cyberpunk alley。具体化以获得更受控的结果。

平衡去噪和结构 如果启用了 ControlNet(例如,深度 + 姿势),高去噪如 0.88 可能会破坏结构。尝试 0.6–0.75 当优先保留布局时。

匹配输入与 ControlNet 仅当存在匹配的指导图像时启用 ControlNet(例如,RenderImageDepth.png 用于深度)。不匹配可能导致提示失败或结果为空。

4. 致谢

此工作流程集成了 Kijai 开发的 Flux-FP8 模型,以及 Reallusion 团队在其官方 AI 渲染工作流程指南中概述的性能优化技术。特别感谢 Kijai 对模型开发的贡献,以及 Reallusion 分享的宝贵见解,提升了 ComfyUI 工作流程中的 AI 渲染效率。

5. 更多关于 Reallusion AI 渲染的资源

探索与 Reallusion AI 渲染相关的技术资源和文档。

- 设置 / 快速入门文档 – 在 ComfyUI 中配置 AI 渲染工作流程的分步指南。演示幻灯片

- 技术概述 – AI 渲染开放测试版的集成和功能概述。产品公告

- 工作流程优化指南 – 优化性能和自定义 AI 渲染在生产环境中的提示。性能提示

- iClone – iClone 软件的官方页面。iClone 网站

- Character Creator – Reallusion Character Creator 的官方页面。Character Creator 网站

- AI 渲染开放测试版论坛 – 官方 Reallusion 论坛上的讨论和更新。论坛链接

- AI 渲染安装教程 – 设置 AI 渲染的视频指南。YouTube 教程

- AI 渲染图像到图像工作流程教程 – 图像到图像工作流程的视频演练。YouTube 教程

- AI 渲染视频到视频工作流程教程 – 视频到视频工作流程的视频演练。YouTube 教程