Создайте потрясающие видео-анимации, преобразуя вашего субъекта (например, танцора) с помощью динамичной ауры, которая ритмично расширяется и сжимается в такт музыке. Используйте этот workflow для одиночных субъектов или нескольких субъектов, как показано в примерах.

Как использовать Audioreactive Mask Dilation Workflow:

- Загрузите видео субъекта в разделе Input

- Выберите желаемую ширину и высоту для финального видео, а также сколько кадров из входящего видео следует пропустить с помощью 'every_nth'. Вы также можете ограничить общее количество кадров для рендеринга с помощью 'frame_load_cap'.

- Заполните положительный и отрицательный промпт. Установите временные интервалы групповых кадров, чтобы соответствовать моментам переходов сцен.

- Загрузите изображения для каждой из масок по умолчанию IP Adapter:

- Красный = субъект (танцор)

- Черный = Фон

- Белый = Белая аудиореактивная маска расширения

- Загрузите хороший LCM checkpoint (я использую ParadigmLCM от Machine Delusions) в разделе 'Models'.

- Добавьте любые loras, используя Lora stacker ниже загрузчика модели

- Нажмите Queue Prompt

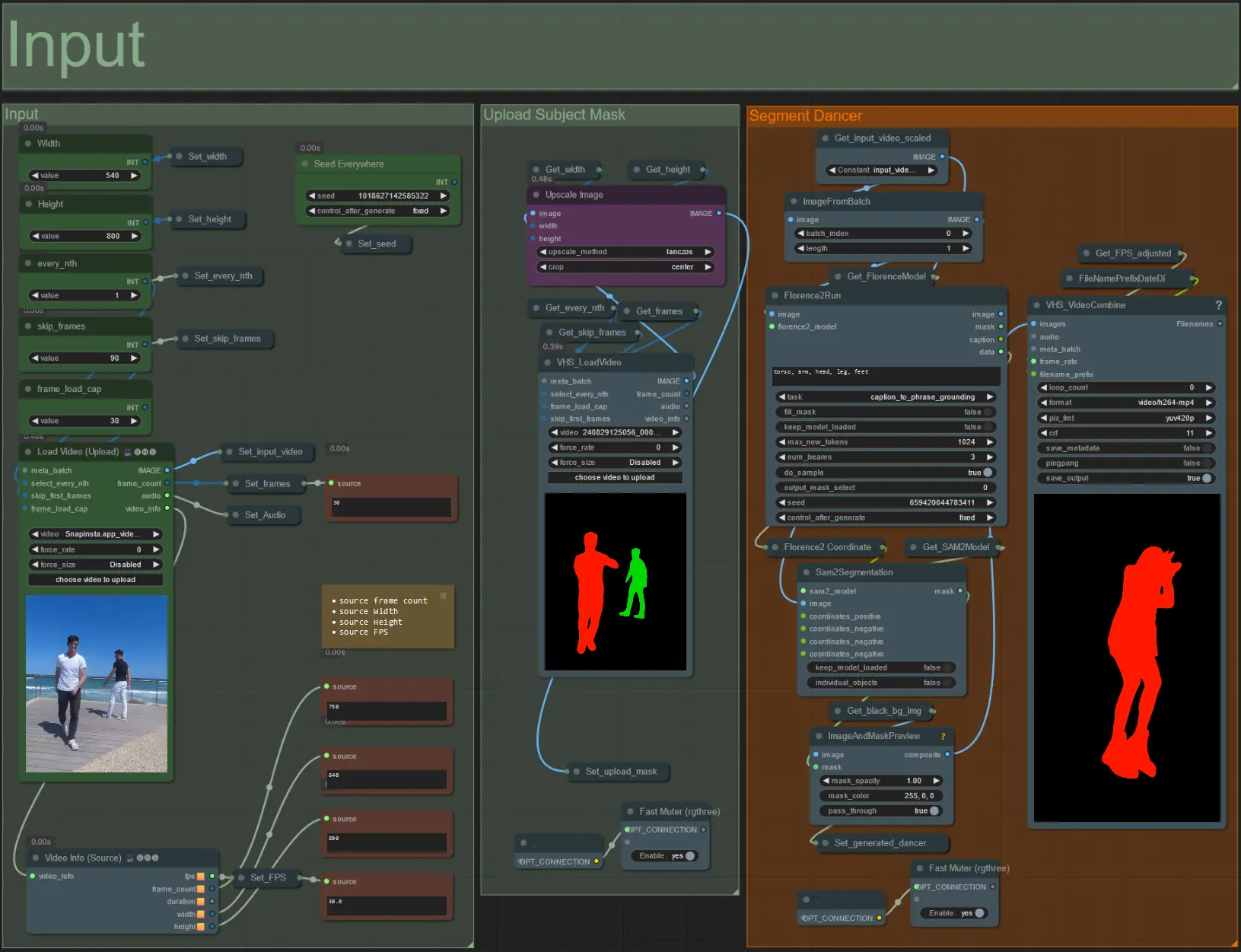

Input

- Загрузите нужное видео субъекта в узел Load Video (Upload).

- Настройте выходную ширину и высоту, используя два верхних левых ввода.

- every_nth устанавливает, использовать ли каждый второй кадр, каждый третий кадр и так далее (2 = каждый второй кадр). По умолчанию установлено на 1.

- skip_frames используется для пропуска кадров в начале видео. (100 = пропустить первые 100 кадров из входящего видео). По умолчанию установлено на 0.

- frame_load_cap используется для указания, сколько всего кадров из входящего видео должно быть загружено. Лучше держать низким при тестировании настроек (например, 30 - 60) и затем увеличить или установить на 0 (без ограничения кадров) при рендеринге финального видео.

- Поля с числами в правом нижнем углу отображают информацию о загруженном входном видео: общее количество кадров, ширину, высоту и FPS сверху вниз.

- Если у вас уже есть видео маски субъекта, сгенерированное ранее, размутируйте раздел 'Upload Subject Mask' и загрузите видео маски. При необходимости можно замутировать раздел 'Segment Dancer', чтобы сэкономить время обработки.

- Иногда сегментированный субъект не будет идеален, тогда проверьте качество маски, используя окно предварительного просмотра в правом нижнем углу, как показано выше. В этом случае можно поиграть с промптом в узле 'Florence2Run', чтобы нацелиться на разные части тела, такие как 'голова', 'грудь', 'ноги' и т.д., и посмотреть, получите ли вы лучший результат.

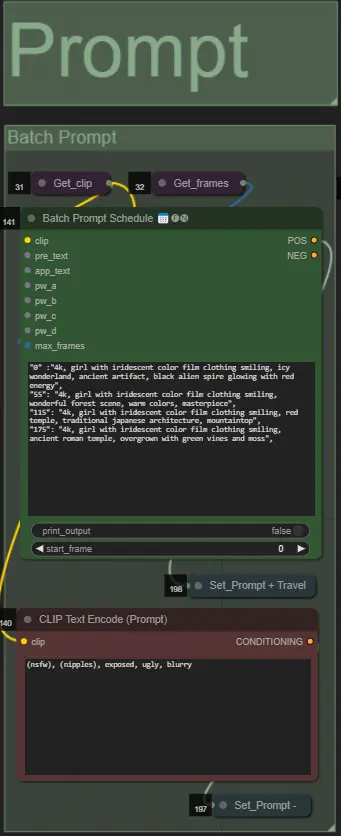

Prompt

- Установите положительный промпт, используя форматирование по партиям:

- например, '0': '4k, шедевр, 1girl стоящая на пляже, absurdres', '25': 'HDR, закат, 1girl с черными волосами и белой курткой, absurdres', …

- Отрицательный промпт в обычном формате, добавьте встраивания, если нужно.

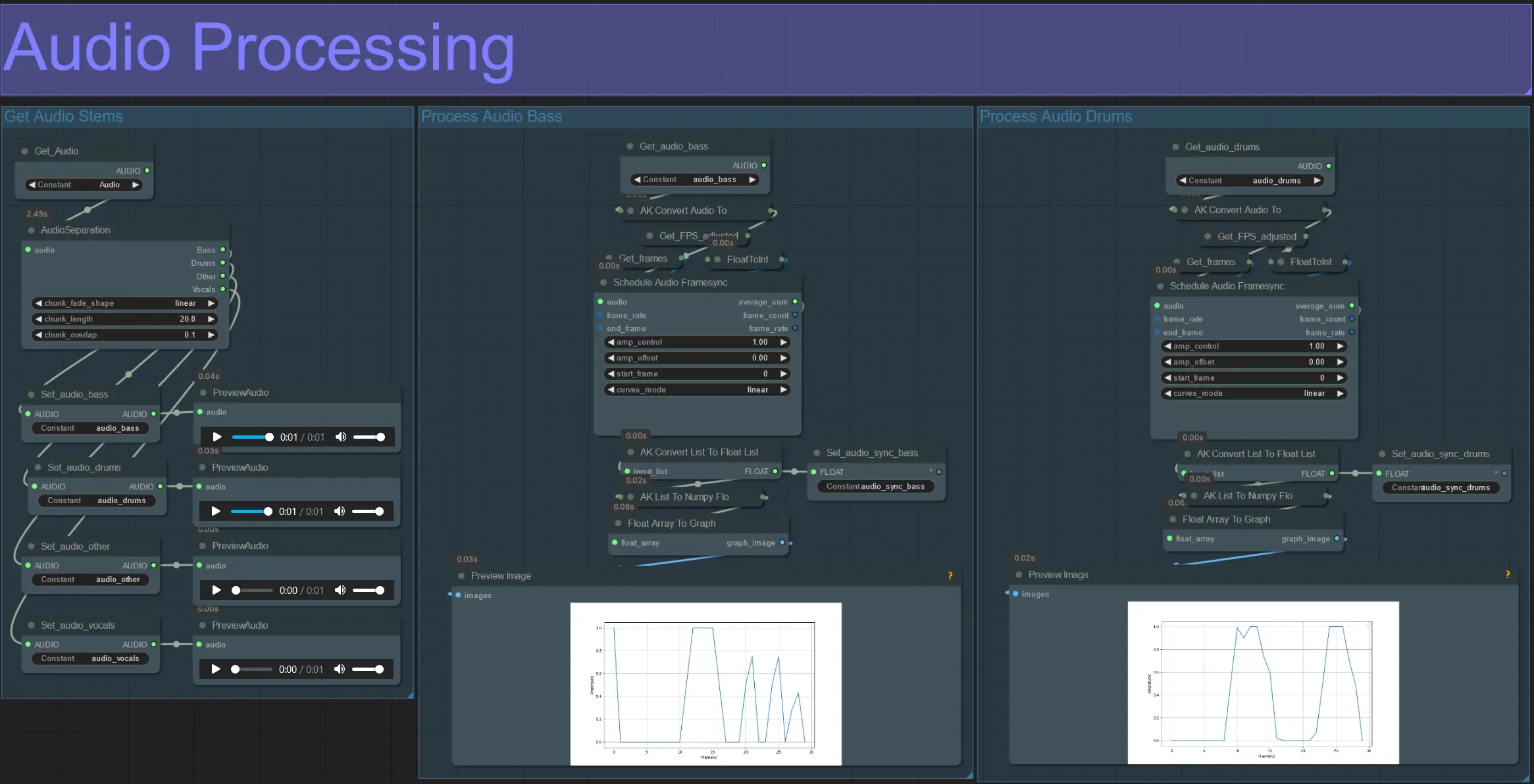

Обработка Аудио

- Этот раздел принимает аудио из входящего видео, извлекает стемы (бас, барабаны, вокал и т.д.) и затем преобразует его в нормализованную амплитуду, синхронизированную с кадрами входящего видео.

- amp_control = общий диапазон, по которому может двигаться амплитуда.

- amp_offset = минимальное значение, которое может принимать амплитуда.

- Пример: amp_control = 0.8 и amp_offset = 0.2 означает, что сигнал будет двигаться между 0.2 и 1.0.

- Иногда стем Drums содержит настоящие басовые ноты из песни; прослушайте каждый, чтобы определить, какой лучше подходит для ваших масок.

- Используйте графики, чтобы получить четкое представление о том, как сигнал для этого стема изменяется на протяжении всего видео.

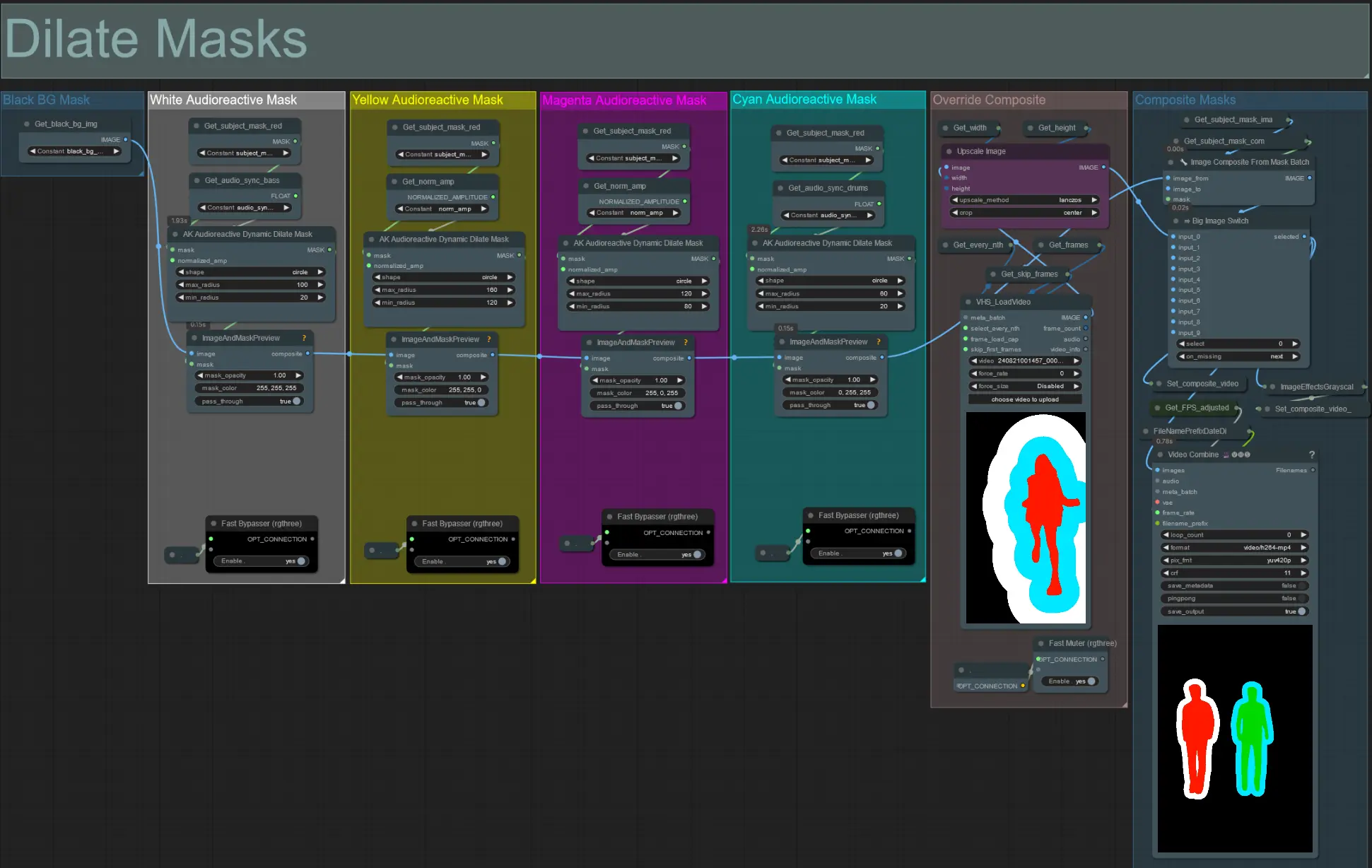

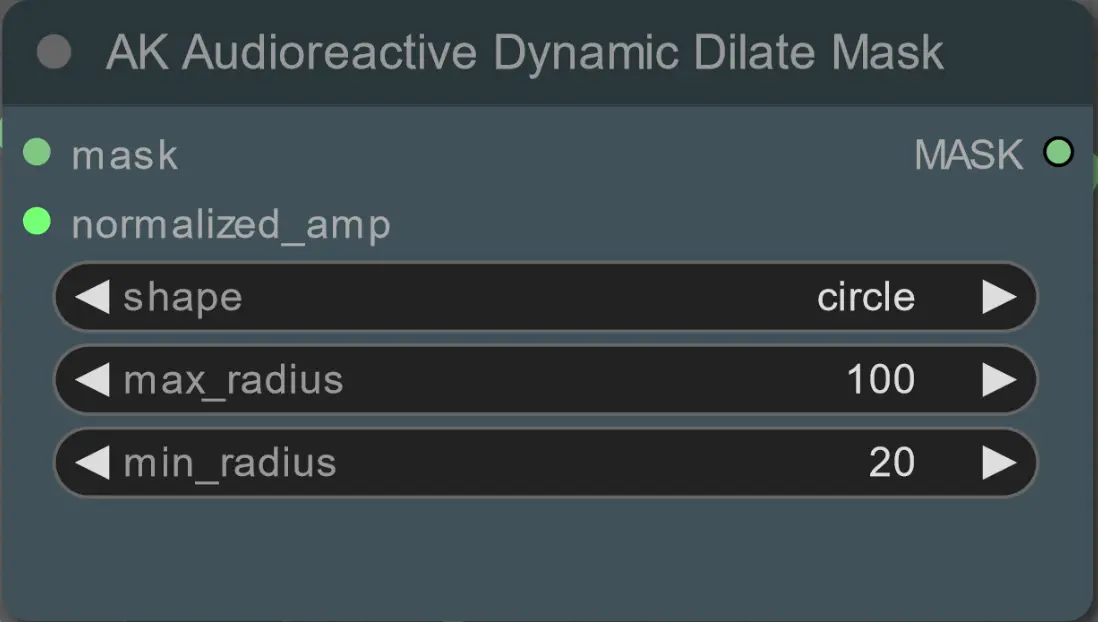

Расширение Масок

- Каждая цветная группа соответствует цвету маски расширения, которая будет сгенерирована.

- Установите минимальный и максимальный радиус для маски расширения, а также её форму, используя следующий узел:

- shape: 'circle' является самым точным, но требует больше времени на генерацию. Установите это, когда будете готовы к финальному рендерингу. 'square' быстро вычисляется, но менее точен, лучше для тестирования workflow и выбора изображений IP adapter.

- max_radius: Радиус маски в пикселях, когда значение амплитуды максимально (1.0).

- min_radius: Радиус маски в пикселях, когда значение амплитуды минимально (0.0).

- Если у вас уже есть сгенерированное видео составной маски, можно размутировать группу 'Override Composite Mask' и загрузить его. Рекомендуется обойти группы масок расширения, если используется замена, чтобы сэкономить время обработки.

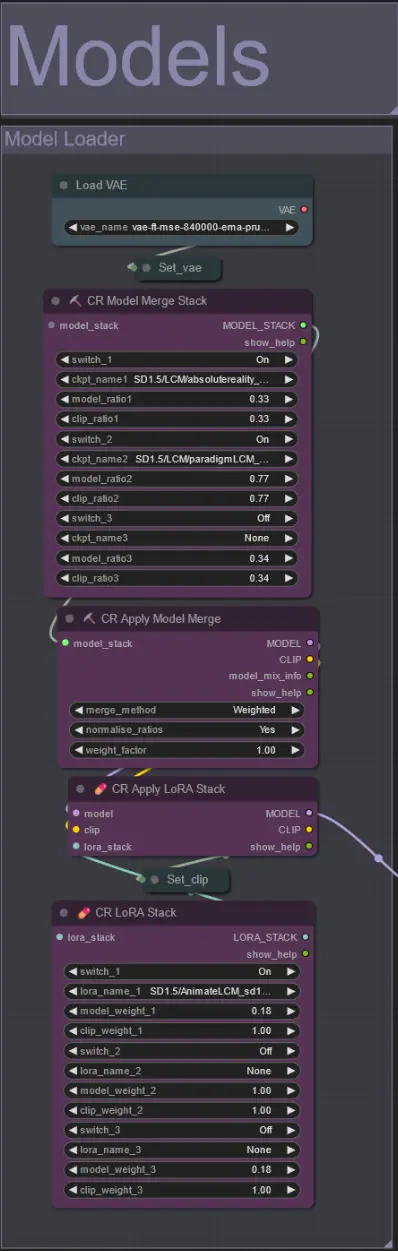

Модели

- Используйте хорошую LCM модель для чекпоинта. Я рекомендую ParadigmLCM от Machine Delusions.

- Объедините несколько моделей вместе, используя Model Merge Stack, чтобы получить различные интересные эффекты. Убедитесь, что веса суммируются до 1.0 для включенных моделей.

- Опционально укажите AnimateLCM_sd15_t2v_lora.safetensors с низким весом 0.18 для дальнейшего улучшения конечного результата.

- Добавьте любые дополнительные Loras к модели, используя Lora stacker ниже загрузчика модели.

AnimateDiff

- Установите другую Motion Lora вместо той, которую я использовал (LiquidAF-0-1.safetensors)

- Увеличьте/уменьшите значения Scale и Effect, чтобы увеличить/уменьшить количество движения в выходном видео.

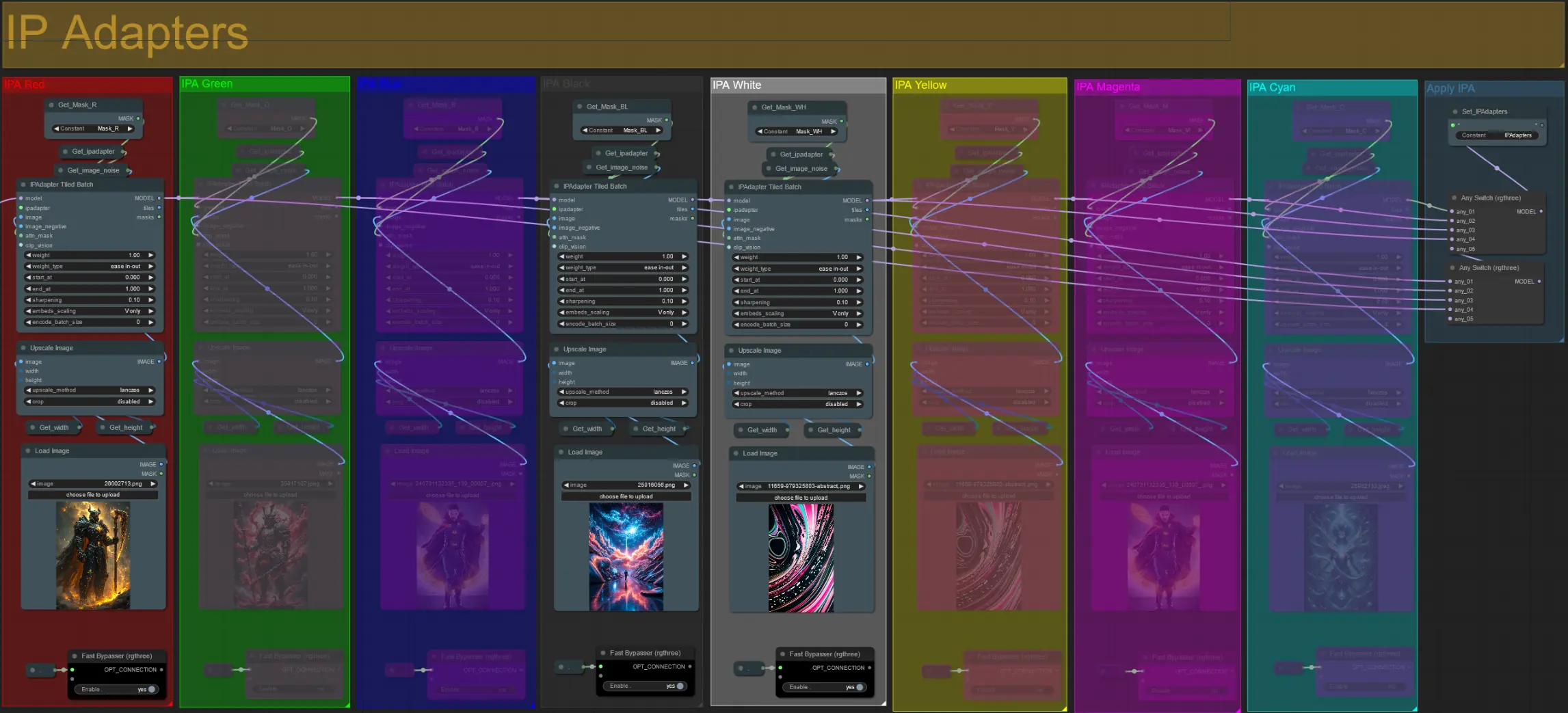

IP Adapters

- Здесь вы можете указать эталонные изображения, которые будут использоваться для рендеринга фонов для каждой из масок расширения, а также для ваших видео-субъектов.

- Цвет каждой группы представляет маску, на которую она нацелена:

Красный, Зеленый, Синий:

- Эталонные изображения маски субъекта.

Черный:

- Изображение фона маски, загрузите эталонное изображение для фона.

Белый, Желтый, Магента, Циан:

- Эталонные изображения масок расширения, загрузите эталонное изображение для каждой цветной маски расширения в использовании.

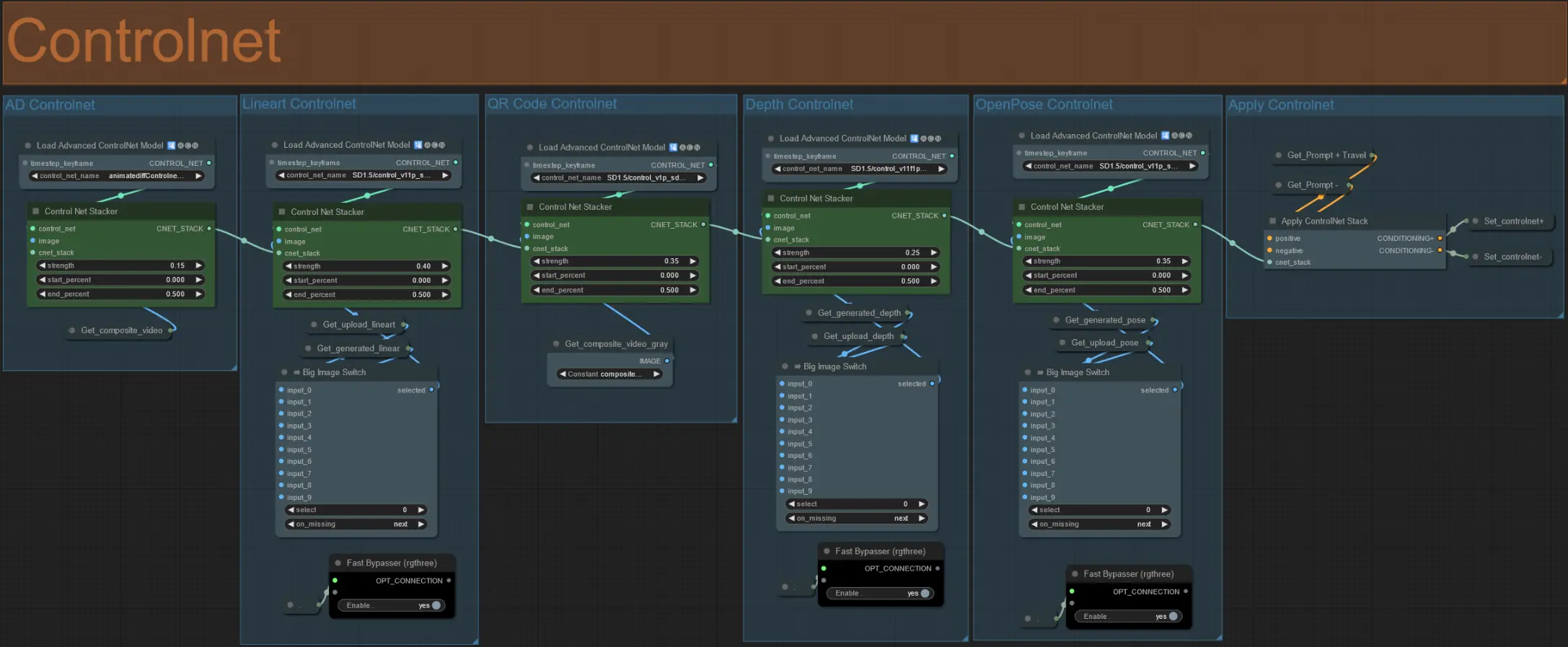

ControlNet

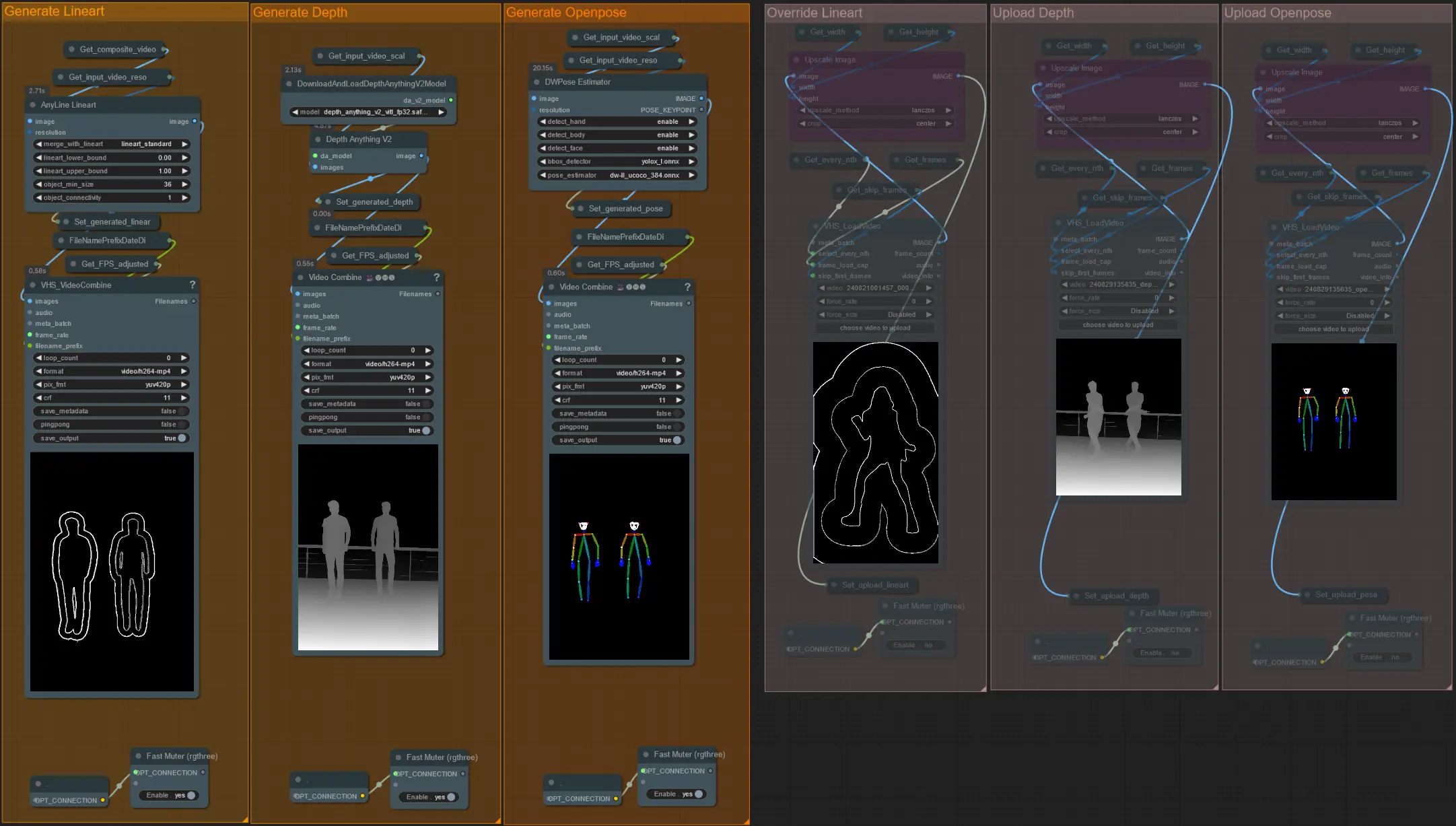

- Этот workflow использует 5 различных controlnets, включая AD, Lineart, QR Code, Depth и OpenPose.

- Все входные данные для controlnets генерируются автоматически

- Вы можете выбрать замену входного видео для controlnets Lineart, Depth и Openpose, если нужно, размутировав группы 'Override', как показано ниже:

- Рекомендуется также замутировать группы 'Generate', если используется замена, чтобы сэкономить время обработки.

Совет:

- Обойдите Ksampler и начните рендеринг с полным входным видео. После того как все видео препроцессоров будут сгенерированы, сохраните их и загрузите в соответствующие замены. С этого момента, при тестировании workflow, вам не придется ждать, пока каждое видео препроцессора будет сгенерировано отдельно.

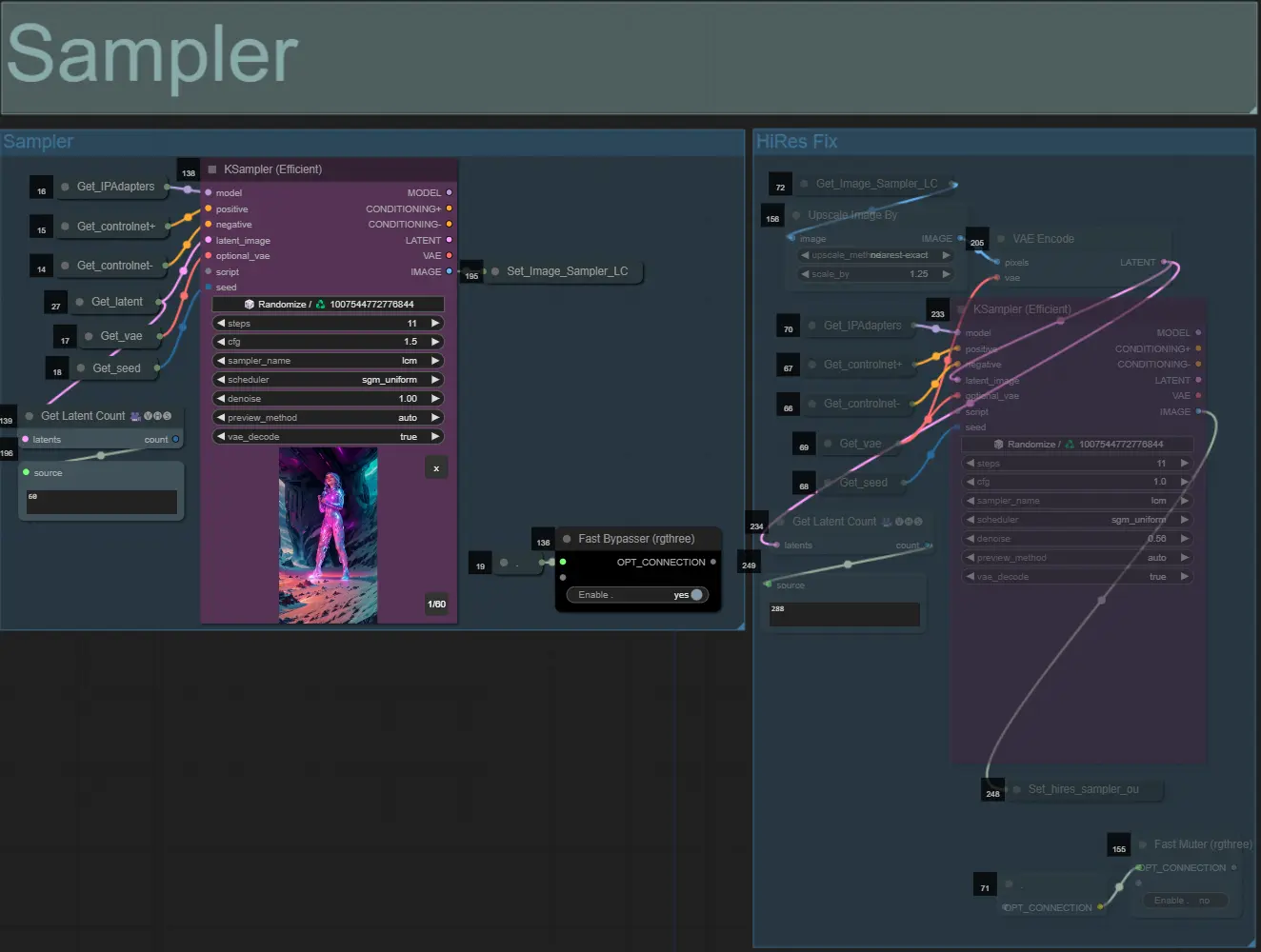

Sampler

- По умолчанию группа HiRes Fix sampler будет замутирована, чтобы сэкономить время при тестировании

- Я рекомендую обойти группу Sampler также при попытке экспериментировать с настройками маски расширения, чтобы сэкономить время.

- При финальном рендеринге можно размутировать группу HiRes Fix, которая будет повышать разрешение и добавлять детали к финальному результату.

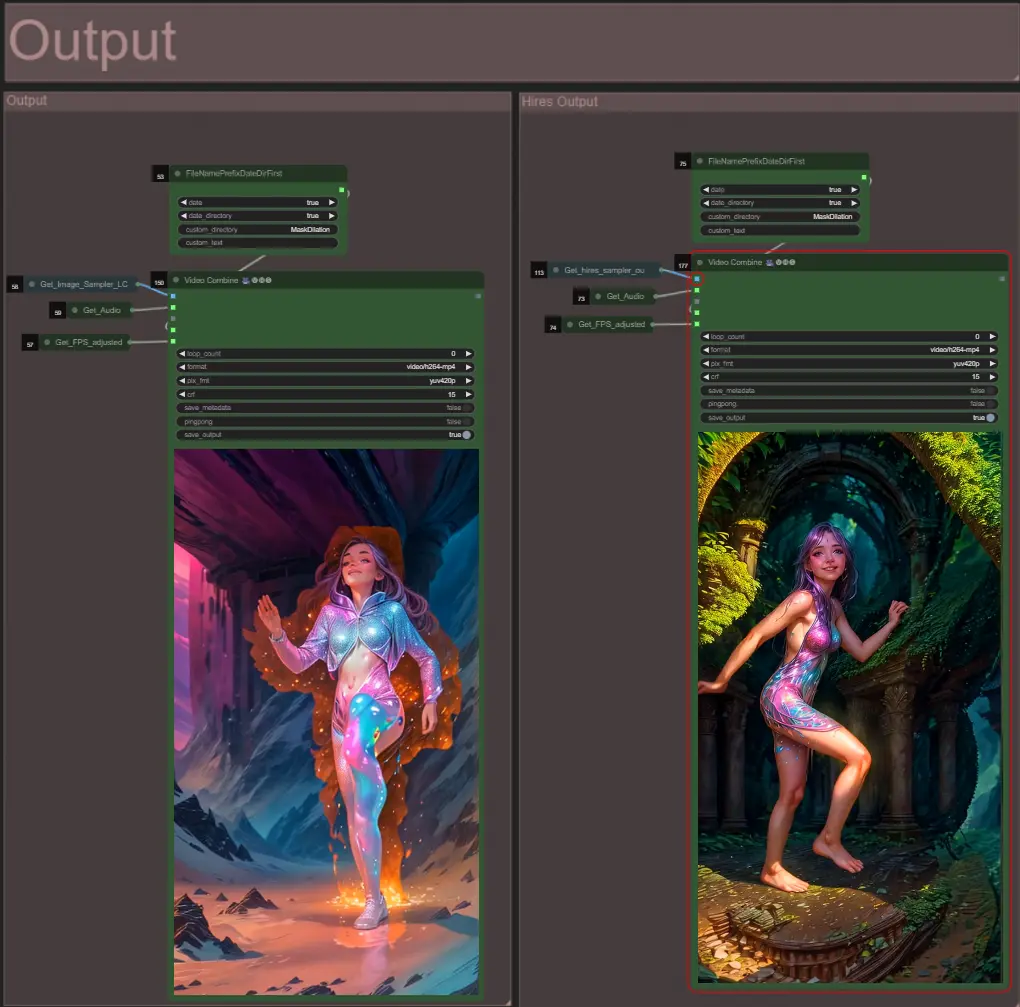

Выход

- Есть две группы выходов: левая для стандартного вывода sampler, правая для вывода HiRes Fix sampler.

Об авторе

Akatz AI:

- Вебсайт: https://akatz.ai

- http://patreon.com/Akatz

- https://civitai.com/user/akatz

- https://www.youtube.com/@akatz_ai

- https://www.instagram.com/akatz.ai/

- https://www.tiktok.com/@akatz_ai

- https://x.com/akatz_ai

- https://github.com/akatz-ai

Контакты:

- Email: akatz.hello@gmail.com