1. ComfyUI AnimateLCM Workflow

Рабочий процесс ComfyUI AnimateLCM предназначен для повышения скорости AI-анимации. Основываясь на ComfyUI-AnimateDiff-Evolved, этот рабочий процесс включает AnimateLCM для ускорения создания анимации текста в видео (t2v). Вы можете экспериментировать с различными подсказками и шагами для достижения желаемых результатов.

2. Обзор AnimateLCM

Появление таких технологий, как SDXL, LCM и SDXL Turbo, значительно ускорило процесс генерации изображений. AnimateLCM ещё больше продвигает прогресс в AI-анимации. Он поддерживает быструю генерацию видео из изображений и предназначен для повышения скорости и эффективности создания анимационных видео из статических изображений или текстовых описаний, что особенно полезно для быстрого создания персонализированных анимационных эффектов.

2.1. Введение в AnimateLCM

AnimateLCM предназначен для ускорения анимации персонализированных моделей диффузии и адаптеров через раздельное обучение согласованности. Он вдохновлён Consistency Model (CM), которая дистиллирует предварительно обученные модели диффузии изображений для ускорения процесса выборки, и её расширением, Latent Consistency Model (LCM), которая фокусируется на условной генерации изображений. AnimateLCM использует эти основы для создания видео с высокой точностью за несколько шагов, основываясь на успехе технологий диффузии и генерации изображений и расширяя их возможности в видео-домен.

2.2. Как использовать AnimateLCM в вашем рабочем процессе ComfyUI

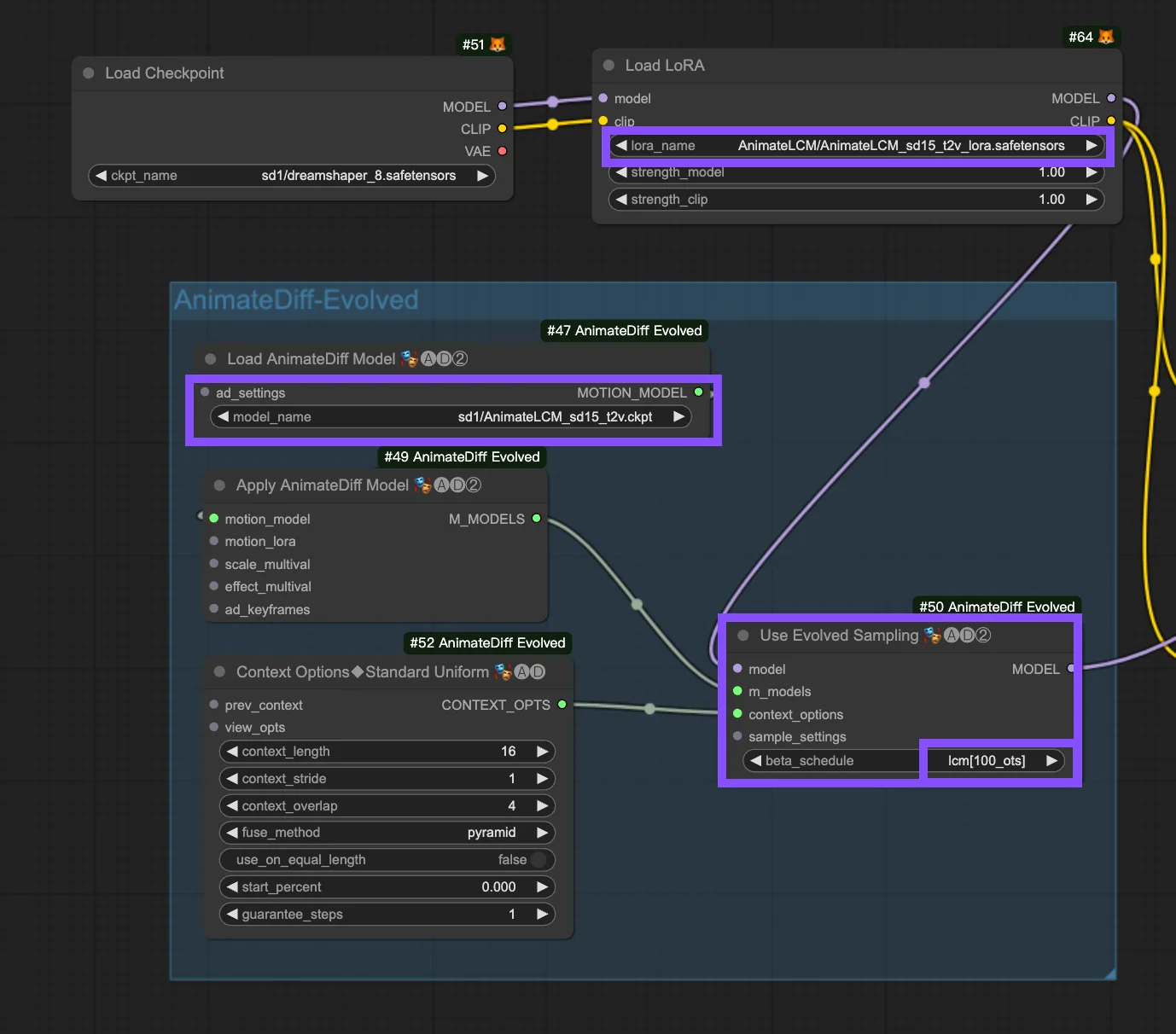

Этот рабочий процесс основывается на ComfyUI-AnimateDiff-Evolved Workflow. Следующие параметры настраиваются в узле "Use Evolved Sampling".

Models: Установите модель контрольной точки и модель LoRA.

- Checkpoint: Это относится к входным данным модели StableDiffusion (SD), используемым для создания анимации. В зависимости от выбранных моделей движения совместимость может варьироваться между версиями SD, такими как SD1.5 или SDXL.

- LoRA: Включение AnimateLCM LoRA model для бесшовной интеграции существующих адаптеров для различных функций, повышения эффективности и качества вывода с акцентом на обучение согласованности без ущерба для скорости выборки.

Motion Models (M Models): Это выходные данные из процесса Apply AnimateDiff Model, позволяющие использовать AnimateLCM Motion Model.

Context Options: Эти настройки регулируют работу AnimateDiff во время создания анимации, позволяя создавать анимации любой длины с помощью скользящих контекстных окон по всему Unet или внутри модуля движения. Они также позволяют настраивать время для сложных анимационных последовательностей. См. здесь подробное руководство по AnimateDiff

Beta Schedule in Sample Settings: Выберите LCM. В настройках выборки AnimateDiff в ComfyUI выбор "beta schedule", включая такие опции, как "lcm", "lineart" и т.д., корректирует значения бета, регулирующие уровни шума в процессе диффузии. Эта настройка влияет на визуальный стиль и плавность анимации. Каждая настройка предназначена для конкретных потребностей анимации или модели движения.

- LCM (Latent Consistency Module): Настройка "lcm" предназначена для LCM LoRAs, улучшая согласованность анимации и сокращая время создания. Она достигает быстрой сходимости с меньшим количеством шагов, требуя уменьшения количества шагов (до минимума ~4 шагов) и других параметров для оптимального сохранения деталей.

- Linear (AnimateDiff-SDXL): Рекомендуется для AnimateDiff с модулями движения SDXL, эта опция балансирует между сохранением деталей и плавностью движения, указывая на совместимость с конкретными версиями моделей движения.

- Sqrt_lineart (AnimateDiff): Подобно "lineart", этот вариант предназначен для процессов AnimateDiff, особенно с модулями движения V2, изменяя уровни шума для дополнения вывода модели движения для более плавных переходов или движений.