FLUX.2 LoRA ComfyUI 추론: FLUX.2 Dev 파이프라인과 함께 훈련과 일치하는 AI Toolkit LoRA 출력

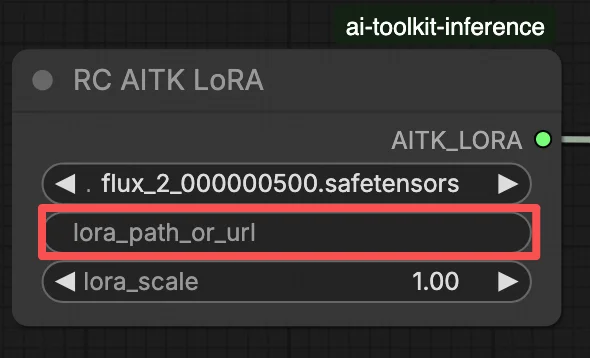

이 생산 준비 완료 RunComfy 워크플로우는 RC FLUX.2 Dev (Flux2Pipeline)를 통해 ComfyUI에서 FLUX.2 Dev LoRA 추론을 실행합니다 (파이프라인 수준의 정렬, 일반적인 샘플러 그래프가 아님). RunComfy는 이 사용자 정의 노드를 빌드하고 오픈 소스로 공개하였습니다—runcomfy-com repositories를 참조하십시오—그리고 lora_path 및 lora_scale로 어댑터 적용을 제어합니다.

참고: 이 워크플로우는 3XL 머신이 필요합니다.

왜 FLUX.2 LoRA ComfyUI 추론이 ComfyUI에서 다르게 보일 수 있는가

AI Toolkit 훈련 미리보기는 텍스트 인코딩, 스케줄링 및 LoRA 주입이 함께 작동하도록 설계된 모델 특정 FLUX.2 파이프라인을 통해 렌더링됩니다. ComfyUI에서 FLUX.2를 다른 그래프(또는 다른 LoRA 로더 경로)로 재구성하면 이러한 상호작용이 변경될 수 있으며, 동일한 프롬프트, 단계, CFG 및 시드를 복사해도 눈에 띄는 차이가 발생할 수 있습니다. RunComfy RC 파이프라인 노드는 Flux2Pipeline을 통해 FLUX.2를 처음부터 끝까지 실행하고 그 파이프라인 내에서 LoRA를 적용하여 추론을 미리보기 행동과 일치시킵니다. 출처: RunComfy 오픈 소스 리포지토리.

FLUX.2 LoRA ComfyUI 추론 워크플로우 사용 방법

1단계: LoRA 경로를 얻고 워크플로우에 로드하기 (2가지 옵션)

⚠️ 중요 · FLUX.2 접근 & Hugging Face 토큰 필요

FLUX.2 Dev 모델은 Hugging Face에서 명시적 접근 권한이 필요합니다.

이 워크플로우를 실행하기 전에:

- Hugging Face 계정이 FLUX.2 (Dev)에 대한 접근 권한을 받았는지 확인하십시오

- Hugging Face 접근 토큰을 생성하십시오

- Load Pipeline 노드의

hf_token필드에 토큰을 붙여넣으십시오

유효한 토큰과 적절한 모델 접근이 없으면 워크플로우가 실행되지 않습니다. 단계별 지침은 Hugging Face token for FLUX.2를 참조하십시오.

옵션 A — RunComfy 훈련 결과 → 로컬 ComfyUI로 다운로드:

- Trainer → LoRA Assets로 이동하십시오

- 사용하고자 하는 LoRA를 찾으십시오

- 오른쪽의 ⋮ (세 점) 메뉴를 클릭 → Copy LoRA Link 선택

- ComfyUI 워크플로우 페이지에서, 복사한 링크를 UI의 오른쪽 상단 모서리에 있는 Download 입력 필드에 붙여넣으십시오

- 다운로드를 클릭하기 전, 대상 폴더가 ComfyUI > models > loras로 설정되어 있는지 확인하십시오 (이 폴더가 다운로드 대상으로 선택되어야 합니다)

- Download를 클릭하십시오 — 이것은 LoRA 파일이 올바른

models/loras디렉토리에 저장되도록 합니다 - 다운로드가 완료되면, 페이지를 새로 고침하십시오

- 이제 LoRA가 워크플로우의 LoRA 선택 드롭다운에 나타납니다 — 선택하십시오

옵션 B — 직접 LoRA URL (옵션 A 무시):

- 직접

.safetensors다운로드 URL을 LoRA 노드의path / url입력 필드에 붙여넣으십시오 - URL이 여기에 제공되면, 옵션 A를 무시합니다 — 워크플로우는 런타임에 URL에서 직접 LoRA를 로드합니다

- 로컬 다운로드나 파일 배치는 필요하지 않습니다

팁: URL이 실제 .safetensors 파일로 연결되는지 확인하십시오 (랜딩 페이지나 리디렉션이 아님).

2단계: 추론 매개변수를 훈련 샘플 설정과 맞추기

LoRA 노드에서 lora_path에서 어댑터를 선택하거나 (옵션 A), 직접 .safetensors 링크를 path / url에 붙여넣으십시오 (옵션 B는 드롭다운을 무시합니다). 그런 다음 훈련 미리보기 시 사용한 강도로 lora_scale을 설정하고 거기서 조정하십시오.

나머지 매개변수는 Generate 노드 (그래프에 따라 Load Pipeline 노드 포함)에 있습니다:

prompt: 텍스트 프롬프트 (훈련 시 트리거 워드를 사용했다면 포함)width/height: 출력 해상도; 훈련 미리보기 크기와 일치시켜 가장 깔끔한 비교를 위해 (FLUX.2의 경우 16의 배수가 권장됨)sample_steps: 추론 단계 수 (25가 일반적인 기본값)guidance_scale: CFG/가이드 값 (4.0이 일반적인 기본값)seed: 재현을 위한 고정 시드; 변형을 탐색하려면 변경seed_mode(존재하는 경우에만):fixed또는randomize선택negative_prompt(존재하는 경우에만): 이 워크플로우에서 FLUX.2는 가이드 증류됨, 따라서 부정적 프롬프트는 무시됨hf_token: Hugging Face 접근 토큰; FLUX.2 Dev 모델 다운로드에 필요 (Load Pipeline 노드에 붙여넣기)

훈련 정렬 팁: 훈련 중 샘플링 값을 사용자 정의했다면 (seed, guidance_scale, sample_steps, 트리거 워드, 해상도), 여기서 정확히 동일한 값을 반영하십시오. RunComfy에서 훈련했다면, Trainer → LoRA Assets > Config를 열어 해결된 YAML을 보고 미리보기/샘플 설정을 워크플로우 노드에 복사하십시오.

3단계: FLUX.2 LoRA ComfyUI 추론 실행

Queue/Run을 클릭하십시오 — SaveImage 노드는 결과를 ComfyUI 출력 폴더에 기록합니다.

빠른 체크리스트:

- ✓ LoRA는 다음 중 하나입니다:

ComfyUI/models/loras에 다운로드됨 (옵션 A), 또는 직접.safetensorsURL을 통해 로드됨 (옵션 B) - ✓ 로컬 다운로드 후 페이지 새로 고침 (옵션 A만 해당)

- ✓ 추론 매개변수가 훈련

sample구성과 일치 (사용자 정의한 경우)

위의 모든 것이 정확하면, 여기의 추론 결과는 훈련 미리보기와 매우 일치해야 합니다.

FLUX.2 LoRA ComfyUI 추론 문제 해결

대부분의 FLUX.2 “훈련 미리보기 vs ComfyUI 추론” 차이는 파이프라인 수준의 차이에서 발생합니다 (모델이 로드되고, 스케줄링되며, LoRA가 병합되는 방식), 단일 잘못된 조정에서 오는 것이 아닙니다. 이 RunComfy 워크플로우는 RC FLUX.2 Dev (Flux2Pipeline)를 통해 추론을 처음부터 끝까지 실행하고 lora_path / lora_scale을 통해 LoRA를 그 파이프라인 내에서 적용하여 가장 가까운 “훈련 일치” 기준을 복원합니다.

(1) Flux.2와 Lora 오류: "mul_cuda"가 'Float8_e4m3fn'에 대해 구현되지 않음

이유 이는 일반적으로 FLUX.2가 Float8/FP8 가중치 (또는 혼합 정밀도 양자화)로 로드되고 LoRA가 일반적인 ComfyUI LoRA 경로를 통해 적용될 때 발생합니다. LoRA 병합은 지원되지 않는 Float8 작업 (또는 혼합 Float8 + BF16 승격)을 강제할 수 있으며, 이는 mul_cuda Float8 런타임 오류를 유발합니다.

해결 방법 (권장)

- RC FLUX.2 Dev (Flux2Pipeline)를 통해 추론을 실행하고 어댑터를

lora_path/lora_scale을 통해서만 로드하여 LoRA 병합이 AI Toolkit-정렬된 파이프라인에서 발생하도록 하십시오, 일반적인 LoRA 로더를 쌓지 마십시오. - 비-RC 그래프에서 디버깅 중이라면: Float8/FP8 확산 가중치 위에 LoRA를 적용하지 마십시오. FLUX.2를 추가하기 전에 BF16/FP16-호환 로딩 경로를 사용하십시오.

(2) LoRA 모양 불일치가 GPU 상태를 손상시키고 OOM/시스템 불안정을 초래하기 전에 빠르게 실패해야 함

이유 이것은 거의 항상 기본 불일치입니다: LoRA는 다른 모델 계열 (예: FLUX.1)용으로 훈련되었지만 FLUX.2 Dev에 적용되고 있습니다. 종종 많은 lora key not loaded 라인을 보고 그 후 모양 불일치가 발생하며, 최악의 경우 세션이 불안정해지고 OOM으로 끝날 수 있습니다.

해결 방법 (권장)

- LoRA가 AI Toolkit으로

black-forest-labs/FLUX.2-dev에 대해 구체적으로 훈련되었는지 확인하십시오 (FLUX.1 / FLUX.2 / Klein 변형은 교환할 수 없습니다). - LoRA에 대해 “단일 경로” 그래프를 유지하십시오: 어댑터를 워크플로우의

lora_path입력을 통해서만 로드하고 Flux2Pipeline이 병합을 처리하도록 하십시오. 병렬로 추가 일반 LoRA 로더를 쌓지 마십시오. - 이미 불일치를 겪었고 ComfyUI가 그 후 관련 없는 CUDA/OOM 오류를 생성하기 시작했다면, ComfyUI 프로세스를 재시작하여 GPU + 모델 상태를 완전히 재설정한 후 호환 가능한 LoRA로 다시 시도하십시오.

(3) Flux.2 Dev - LoRAs를 사용하는 것이 추론 시간을 두 배 이상 증가시킴

이유 LoRA는 LoRA 경로가 추가 패칭/디퀀타이제이션 작업을 강제하거나 기본 모델 단독보다 느린 코드 경로에서 가중치를 적용할 때 FLUX.2 Dev를 훨씬 느리게 만들 수 있습니다.

해결 방법 (권장)

- 이 워크플로우의 RC FLUX.2 Dev (Flux2Pipeline) 경로를 사용하고 어댑터를

lora_path/lora_scale을 통해 전달하십시오. 이 설정에서는 LoRA가 파이프라인 로드 중에 한 번 병합되므로 단계별 샘플링 비용이 기본 모델에 가깝게 유지됩니다. - 미리보기와 일치하는 동작을 추구할 때, 여러 LoRA 로더를 쌓거나 로더 경로를 혼합하지 마십시오. 하나의

lora_path+ 하나의lora_scale로 유지하여 기준선을 맞출 때까지 유지하십시오.

참고 이 FLUX.2 Dev 워크플로우에서는 FLUX.2가 가이드 증류되므로 negative_prompt는 파이프라인에 의해 무시될 수 있습니다—프롬프트 워딩 + guidance_scale + lora_scale로 미리보기를 맞추십시오.

지금 FLUX.2 LoRA ComfyUI 추론 실행

워크플로우를 열고 lora_path를 설정한 후 Queue/Run을 클릭하여 AI Toolkit 훈련 미리보기와 가까운 FLUX.2 Dev LoRA 결과를 얻으십시오.