FLUX.1 Dev LoRA Inference : Correspondance des aperçus d'entraînement AI Toolkit dans ComfyUI

FLUX.1 Dev LoRA Inference : génération à étapes minimales, correspondant à l'entraînement dans ComfyUI FLUX.1 Dev LoRA Inference est un flux de travail prêt à l'emploi pour appliquer des FLUX.1 Dev LoRAs formés avec AI Toolkit dans ComfyUI avec des résultats proches de vos aperçus d'entraînement. Il est construit autour de RC FLUX.1 Dev (RCFluxDev)—un nœud personnalisé open-source construit par RunComfy qui dirige la génération à travers un pipeline d'inférence spécifique à FLUX.1 Dev (au lieu d'un graphe d'échantillonneur générique) tout en injectant votre adaptateur via lora_path et lora_scale. Vous pouvez parcourir le travail source associé dans les dépôts de l'organisation GitHub runcomfy-com.

Utilisez ce flux de travail lorsque vos échantillons AI Toolkit semblent "corrects", mais que le passage à un graphe ComfyUI typique fait dériver le même LoRA + prompt en style, force ou composition.

Pourquoi l'inférence FLUX.1 Dev LoRA semble souvent différente dans ComfyUI

Les aperçus AI Toolkit sont générés par un pipeline d'inférence spécifique au modèle. De nombreux graphes ComfyUI reconstruisent FLUX à partir de composants génériques, donc "faire correspondre les chiffres" (prompt/étapes/guidance/seed) peut toujours produire des paramètres par défaut différents et un comportement d'application LoRA différent. Cet écart "aperçu d'entraînement vs inférence ComfyUI" est généralement au niveau du pipeline, pas un simple mauvais réglage.

Ce que fait le nœud personnalisé RCFluxDev

RCFluxDev encapsule le pipeline d'inférence FLUX.1 Dev utilisé pour l'échantillonnage de style AI Toolkit et applique votre LoRA à l'intérieur de ce pipeline pour que le comportement de l'adaptateur reste cohérent pour cette famille de modèles. Source du pipeline : `src/pipelines/flux_dev.py`

Comment utiliser le flux de travail FLUX.1 Dev LoRA Inference

Étape 1 : Importez votre LoRA (2 façons)

- Option 1 (résultat de l'entraînement RunComfy): RunComfy → Trainer → LoRA Assets → trouvez votre LoRA → ⋮ → Copier le lien LoRA

- Option 2 (LoRA AI Toolkit formé en dehors de RunComfy):

Copiez un lien de téléchargement direct .safetensors pour votre LoRA et collez cette URL dans lora_path.

Étape 2 : Configurez le nœud personnalisé RCFluxDev pour l'inférence FLUX.1 Dev LoRA

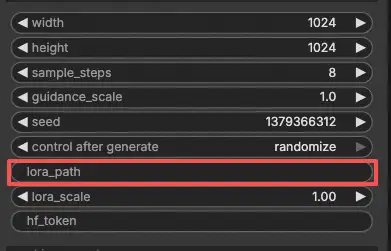

- Dans le flux de travail, sélectionnez RC FLUX.1 Dev (RCFluxDev) et collez votre URL LoRA (ou chemin de fichier) dans

lora_path.

Important (nécessaire pour la première exécution) : pour exécuter ce nœud personnalisé, vous devez (1) avoir accès à Hugging Face au dépôt FLUX.1 Dev que vous utilisez, et (2) coller votre jeton Hugging Face dans hf_token :

- Sur la page du modèle Hugging Face, connectez-vous et cliquez sur Demander l'accès / Accepter (une fois par dépôt).

- Créez un Jeton d'Accès Utilisateur Hugging Face avec la permission Lecture sur huggingface.co/settings/tokens.

- Collez le jeton dans

hf_tokensur RCFluxDev, puis relancez le flux de travail.

Guide étape par étape : FLUX Hugging Face Token - Configuration & Dépannage

- Configurez ensuite le reste des paramètres pour FLUX.1 Dev LoRA Inference (tout dans l'interface utilisateur du nœud):

Astuce d'alignement de l'entraînement : lorsque vous recherchez une correspondance 1:1, ne "réglez pas par intuition"—reflétez les valeurs d'échantillonnage du YAML d'entraînement AI Toolkit que vous avez utilisé pour les aperçus (surtout width, height, sample_steps, guidance_scale, seed). Si vous vous êtes entraîné sur RunComfy, ouvrez Trainer → LoRA Assets → Config et réutilisez les paramètres d'aperçu.

prompt: votre prompt texte (incluez les tokens déclencheurs que vous avez utilisés pendant l'entraînement, le cas échéant)negative_prompt: optionnel ; laissez vide si vous n'avez pas échantillonné avec des négatifswidth/height: résolution de sortie (correspondre aux aperçus d'entraînement lors de la comparaison)sample_steps: nombre d'étapes d'inférenceguidance_scale: valeur de guidance utilisée par le pipeline FLUX.1 Devseed: définissez une seed fixe pour reproduire ; changez-la pour explorer les variationslora_scale: force LoRA (commencez près de votre valeur d'aperçu, puis ajustez)hf_token: votre jeton d'accès Hugging Face (nécessaire pour les dépôts FLUX protégés)

Étape 3 : Exécutez l'inférence FLUX.1 Dev LoRA

- Cliquez sur Queue/Run → SaveImage écrit automatiquement les résultats dans votre dossier de sortie ComfyUI

Dépannage de l'inférence FLUX.1 Dev LoRA

La plupart des problèmes "aperçu vs ComfyUI" de FLUX.1 Dev sont causés par des incompatibilités de pipeline (comment le modèle est chargé, comment le conditionnement est construit, et où/comment l'adaptateur est injecté), pas seulement un mauvais paramètre.

Pour les FLUX.1 Dev LoRAs formés avec AI Toolkit, la façon la plus fiable de retrouver un comportement correspondant à l'entraînement dans ComfyUI est d'exécuter la génération via RC FLUX.1 Dev (RCFluxDev), qui maintient l'inférence alignée au niveau du pipeline et applique votre adaptateur de manière cohérente via lora_path / lora_scale. Si vous déboguez un problème tenace, partez du flux de référence minimal et ajoutez de la complexité seulement après avoir confirmé que la base fonctionne.

(1)Utilisation élevée de la vram lora après mise à jour

Pourquoi cela arrive

Avec FLUX.1 Dev, certaines configurations voient un saut important de VRAM lors de l'application de certains LoRAs (y compris les LoRAs formés avec AI Toolkit). Cela apparaît souvent lorsque les LoRAs sont injectés via des chemins de chargeurs génériques ou lorsque le graphe entraîne des copies supplémentaires du modèle / un comportement de rechargement.

Comment résoudre (recommandé)

- Exécutez l'inférence via RCFluxDev et chargez votre adaptateur uniquement via

lora_pathdans le nœud (évitez de mélanger plusieurs nœuds de chargeur LoRA pour le même modèle). - Gardez votre comparaison équitable : faites correspondre les valeurs d'échantillonnage d'aperçu de l'entraînement (

width,height,sample_steps,guidance_scale,seed) avant de juger "ça a l'air décalé". - Si vous rencontrez toujours OOM : réduisez d'abord

width/height(c'est généralement le plus grand levier pour FLUX), puis réduisez le batch/les nœuds supplémentaires, et redémarrez la session pour vider les caches obsolètes. De plus, vous pouvez lancer une machine GPU plus élevée sur RunComfy pour exécuter.

(2)VAEDecode Donne groups=1, poids de taille [4, 4, 1, 1], entrée attendue[1, 16, 144, 112] pour avoir 4 canaux, mais en a obtenu 16

Pourquoi cela arrive

Les latents FLUX et les latents "classic SD" ne sont pas interchangeables. Cette erreur est le symptôme habituel du décodage des latents FLUX avec un VAE non-FLUX (un VAE qui attend des latents à 4 canaux, tandis que les latents FLUX peuvent être à 16 canaux).

Comment résoudre

- Ne décodez pas les latents FLUX avec un chemin VAE SD/SDXL.

- Utilisez le flux de travail RCFluxDev pour que le bon chemin de décodage FLUX soit utilisé de bout en bout (chargement du modèle → échantillonnage → décodage), au lieu de mélanger des nœuds VAE génériques d'autres pipelines.

- Si vous reconstruisez des graphes manuellement, vérifiez que vous utilisez les bons actifs d'autoencodeur FLUX et non un VAE SD/SDXL restant.

(3)le modèle flux ne fonctionne pas, flux1-dev-fp8.safetensors

Pourquoi cela arrive

Cela se produit généralement lorsqu'un UNet FLUX .safetensors est chargé en utilisant le mauvais type de chargeur (par exemple, le traiter comme un "checkpoint" que ComfyUI devrait auto-détecter comme SD/SDXL).

Comment résoudre

- Utilisez le flux de travail FLUX.1 Dev (RCFluxDev) et laissez le flux de travail/nœud gérer le chargement du modèle ; passez uniquement votre LoRA via

lora_path. - Ne chargez pas les UNets FLUX en utilisant les chargeurs de checkpoint SD/SDXL.

- Si le fichier a été téléchargé à partir d'un lien, vérifiez qu'il s'agit d'un

.safetensorscomplet et valide (les téléchargements partiels peuvent déclencher des erreurs de détection déroutantes).

Exécutez l'inférence FLUX.1 Dev LoRA maintenant

Ouvrez le flux de travail RunComfy FLUX.1 Dev LoRA Inference, définissez lora_path, et générez avec RCFluxDev pour que les résultats ComfyUI restent alignés avec vos aperçus d'entraînement AI Toolkit.