1. Was ist der ComfyUI Uni3C Workflow?

Der Uni3C-Workflow integriert das fortschrittliche Uni3C (Unifying Precisely 3D-Enhanced Camera and Human Motion Controls) Modell in die ComfyUI Umgebung. Entwickelt von der DAMO Academy (Alibaba Group), adressiert Uni3C die grundlegende Herausforderung der kontrollierbaren Videogenerierung, indem es die Steuerung von Kameraverläufen und menschlichen Bewegungen in einem einzigen 3D-erweiterten Rahmen vereint.

Basierend auf der FLUX Diffusion Transformer Architektur und angetrieben vom Wan2.1 Grundmodell, führt Uni3C den PCDController ein - ein Plug-and-Play-Steuermodul, das nicht projizierte Punktwolken aus monokularer Tiefenschätzung nutzt. Dieser Ansatz ermöglicht präzise Kamerasteuerung innerhalb von Uni3C, während die generativen Fähigkeiten von groß angelegten Videodiffusionsmodellen erhalten bleiben. Das Uni3C-System verwendet SMPL-X-Charaktermodelle und globale 3D-Weltführung, um räumlich konsistente Videogenerierung sowohl in Umweltszenen als auch bei menschlichen Charakteren zu erreichen.

2. Vorteile von Uni3C:

- Vereinheitlichtes 3D-erweitertes Framework: Uni3C verarbeitet gleichzeitig Kameraverläufe und menschliche Bewegung in einem kohärenten 3D-Weltraum.

- PCDController-Architektur: Mit dem leichten 0.95B Parameter-Controller nutzt Uni3C nicht projizierte Punktwolken aus monokularer Tiefenschätzung, ohne das 14B Parameter-Basismodell zu beeinträchtigen.

- SMPL-X-Integration: Uni3C bietet Unterstützung für fortschrittliche 3D-Menschkörpermodelle.

- Geometrische Vorwissen-Nutzung: Uni3C punktwolkenbasierte 3D-geometrische Verständnis bietet robuste Kamerasteuerung aus Einzelbildern.

- Globale 3D-Weltführung: Uni3C sorgt für rigide Transformationsausrichtung zwischen Umwelt-Punktwolken und SMPL-X-Charakteren für räumlich konsistente Videogenerierung.

3. Wie verwendet man den Uni3C Workflow

Uni3C arbeitet durch Video-Referenzextraktion, die Referenzvideos analysiert, um sowohl Kamerabewegungen als auch menschliche Bewegungen zu verstehen, und dann die Muster anwendet, um neue Videos aus den Eingabebildern zu generieren. Dieser Ansatz ermöglicht präzise Kontrolle mit Uni3C ohne manuelle Parameteranpassung.

3.1 Methode 1: Video-Referenzierte Kamerasteuerung

Am besten geeignet für:

Extrahieren von Kamerabewegungen aus Referenzvideos und Anwenden auf neue Szenen mit Uni3C.

Einrichtungsprozess:

- Referenzvideo laden: Laden Sie ein beliebiges Video mit interessanten Kamerabewegungen im

Load Video (Upload)-Knoten hoch- Gute Beispiele: Videos mit Kamerazoom auf Subjekte, Gehaufnahmen mit natürlicher Kopfbewegung, filmische Schwenks, Orbitalaufnahmen

- Wichtiger Punkt: Jedes Video mit klarer Kamerabewegung funktioniert - von Handyaufnahmen bis zu professioneller Kinematografie mit Uni3C.

- Zielbild laden: Laden Sie Ihr Basisbild im

Load Image-Knoten hoch (funktioniert mit jedem Stil: realistisch, Anime, Kunstwerk, KI-generiert) - Ihr Prompt schreiben: Beschreiben Sie Ihre gewünschte Szene im Text-Prompt-Bereich für Uni3C

- Einstellungen konfigurieren: Der Uni3C-Workflow enthält optimierte Parameter für 4-fache Geschwindigkeitsverbesserung

- Generieren: Führen Sie den Workflow aus, um die Kamerabewegung des Referenzvideos auf Ihre Szene mit Uni3C zu übertragen.

Erweiterte Tipps:

- Richtungsabgleich der Bewegung: Die besten Ergebnisse erzielen Sie, wenn die Bewegungsrichtung des Referenzvideos mit Ihrer beabsichtigten Szenenkomposition für Uni3C übereinstimmt.

- Prompt-Koordination: Schreiben Sie Prompts, die den Kamerabewegungsstil ergänzen, um die Kohärenz mit Uni3C zu verbessern.

- Referenzqualität: Wählen Sie Referenzvideos mit stabilen, klaren Kamerabewegungen für optimale Ergebnisse mit Uni3C.

3.2 Methode 2: Übertragung menschlicher Bewegungen

Am besten geeignet für:

Übertragen von menschlichen Bewegungen aus Referenzvideos auf verschiedene Charaktere mit Uni3C.

Einrichtungsprozess:

- Referenzvideo mit menschlicher Bewegung: Laden Sie ein Video hoch, das die menschlichen Bewegungen enthält, die Sie übertragen möchten

- Zielcharakterbild: Laden Sie ein Bild des Charakters hoch, den Sie animieren möchten

- Bewegungssteuerung über Prompts:

- Originalbewegung bewahren: Verwenden Sie allgemeine Beschreibungen wie "eine Frau, die geht", um die Referenzbewegung mit Uni3C beizubehalten.

- Aktionen ändern: Seien Sie spezifisch, um Bewegungen zu ändern: "eine Frau, die sich die Haare kämmt" wird Handgesten verändern, während der allgemeine Bewegungsfluss mit Uni3C erhalten bleibt.

Hauptvorteile:

- Kein Skelett erforderlich: Im Gegensatz zu traditionellen Motion-Capture-Verfahren versteht Uni3C menschliche Bewegungen ohne komplexes Rigging.

- Detailerhaltung: Uni3C bewahrt Accessoires, Frisuren und Kleidungsdetails während des Bewegungstransfers.

- Gleichzeitige Steuerung: Sowohl Kamerabewegung als auch menschliche Bewegung werden gemeinsam aus demselben Referenzvideo mit Uni3C übertragen.

Performance-Optimierungsarchitektur: Der Uni3C-Workflow implementiert mehrere Optimierungsstrategien, einschließlich der Reduzierung der versteckten Größe von 5120 auf 1024 im PCDController, nullinitialisierte lineare Projektionsebenen und die Einspeisung von kamerasteuernden Merkmalen nur in die ersten 20 Schichten des Basismodells. Die Flussanpassungsoptimierung mit reduzierten Abtastschritten (10 gegen 20+) und angepassten CFG-Leitwaagen bietet bis zu 4-fache Geschwindigkeitsverbesserung in Uni3C, während die Generationsqualität erhalten bleibt.

3.3 Optimierte Leistungseinstellungen

4-fache Geschwindigkeitssteigerungskonfiguration: Basierend auf den integrierten Optimierungen von Uni3C bieten die folgenden Einstellungen dramatisch schnellere Verarbeitung:

WanVideo Sampler Node Settings:

Steps: 10 (reduziert von Standard 20+)CFG: 1.0-1.5 (optimiert für Geschwindigkeits-Qualitäts-Balance)Shift: 5.0-7.0 (Autor empfiehlt 7 für beste Ergebnisse, 5 für schnellere Verarbeitung mit Uni3C)Scheduler: UniPC (optimierter Scheduler für Uni3C)

Hauptleistungsmerkmale:

- AnimateDiff-Integration: Uni3C nutzt AnimateDiff-Optimierungen, die ursprünglich für Text-zu-Video entwickelt wurden, aber effektiv für Bild-zu-Video-Generierung sind.

- Intelligente Parameterreduzierung: Da Bild-zu-Video mit vorhandenem visuellem Inhalt beginnt, sind weniger Rauschunterdrückungsschritte erforderlich im Vergleich zur Text-zu-Video-Generierung mit Uni3C.

- Optimierte Verarbeitung: Uni3C ermöglicht es, 70-Frame-Videos in ~4-5 Minuten zu vervollständigen (vs ~27 Minuten mit ursprünglichen Einstellungen).

Optionen für Qualität vs Geschwindigkeit:

- Maximale Geschwindigkeit: Steps=10, CFG=1.0, Shift=5 → ~4 Minuten für 70 Frames mit Uni3C

- Ausgewogen: Steps=10, CFG=1.5, Shift=7 → ~5 Minuten für 70 Frames mit Uni3C

- Höhere Qualität: Steps=15, CFG=2.0, Shift=7 → ~8-10 Minuten für 70 Frames mit Uni3C

3.4 Verständnis der Workflow-Komponenten

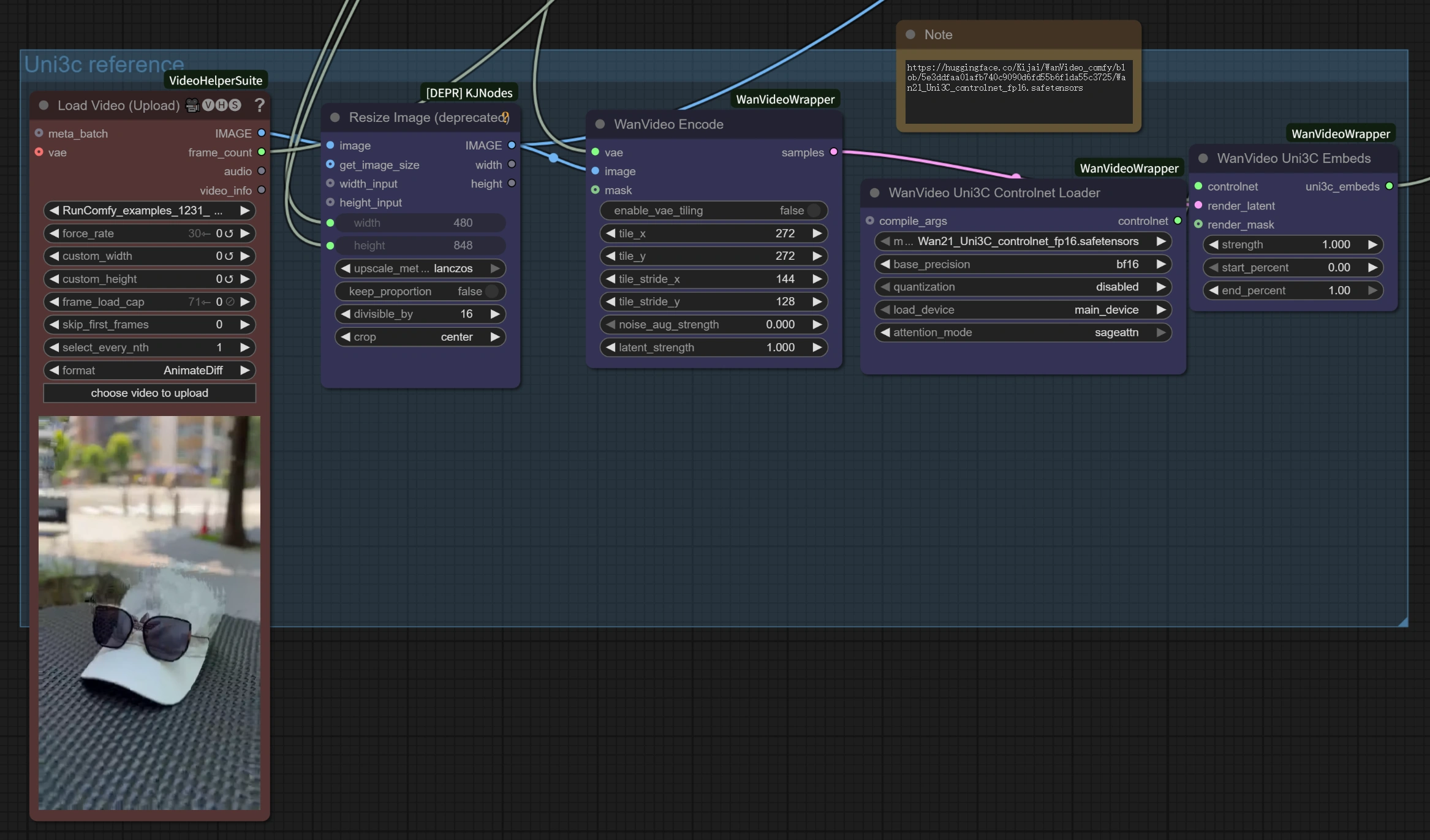

Referenzvideobearbeitungssektion:

Load Video (Upload): Akzeptiert MP4, AVI und andere Standardvideoformate für Bewegungsreferenz in Uni3C.WanVideo Encode: Verarbeitet das Referenzvideo, um Kameraverläufe und Bewegungsmuster für Uni3C zu extrahieren.Uni3C ControlNet Loader: Lädt das spezialisierte Uni3C-Kontrollmodell für Bewegungsverständnis.

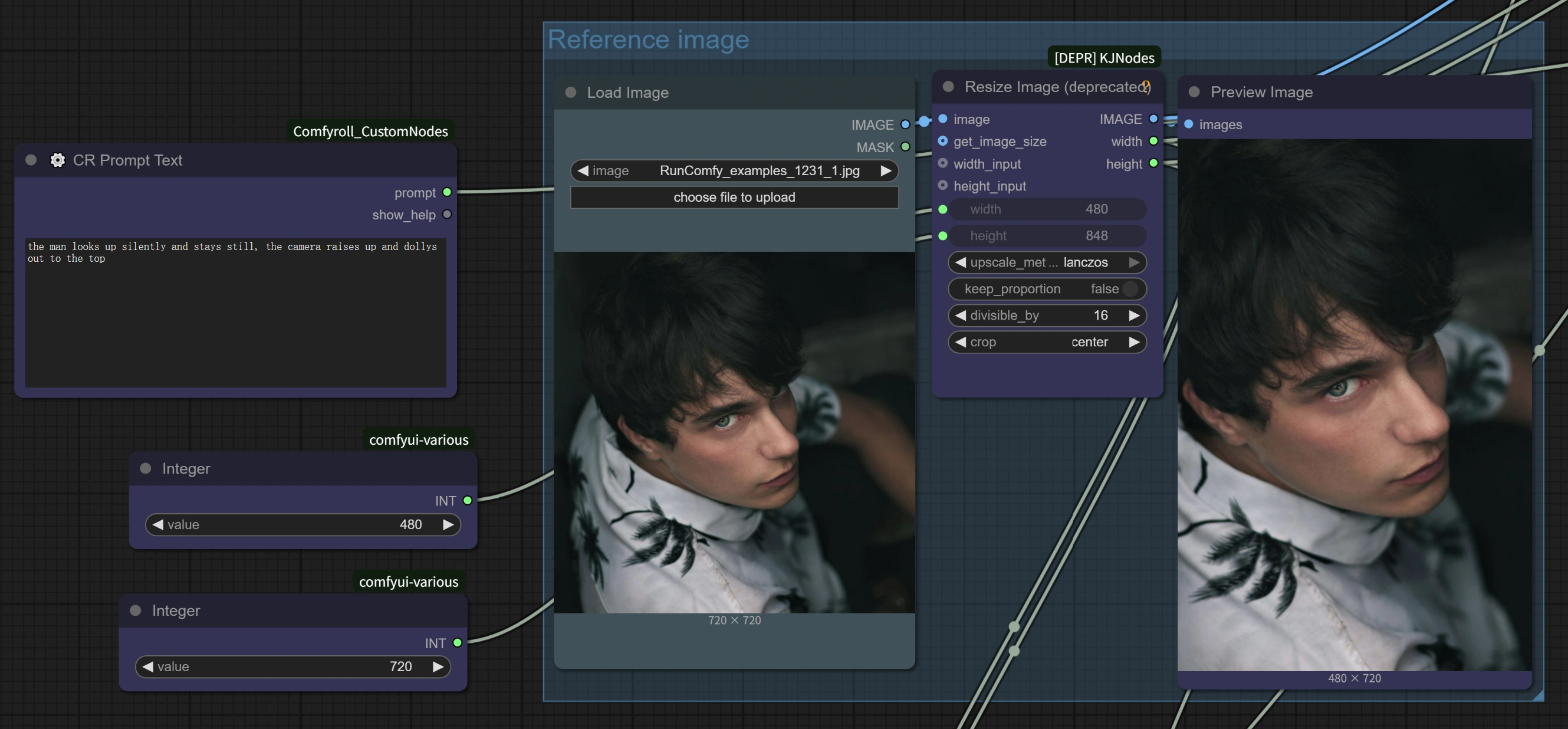

Bild-zu-Video-Generierungssektion:

Load Image: Ihr Zielbild, das mit der Referenzbewegung von Uni3C animiert wird.WanVideo Image/ToVideo Encode: Konvertiert Ihr statisches Bild in ein Format, das für die Videogenerierung durch Uni3C geeignet ist.WanVideo Sampler: Kern-Generationsmotor mit optimierten Einstellungen für 4-fache Geschwindigkeitsverbesserung in Uni3C.

Ausgabeverarbeitung:

WanVideo Decode: Konvertiert das generierte latente Video zurück in ein anschaubares Format von Uni3C.Video Combine: Setzt die endgültige Videodatei mit korrekter Bildrate und Kodierung von Uni3C zusammen.

4. Erweiterte Tipps und Best Practices

Auswahl von Referenzmaterialien für Uni3C

- Für Bewegungstransfer: Wählen Sie Videos mit klaren, sichtbaren Bewegungen, bei denen die Person hauptsächlich im Bild bleibt für Uni3C.

- Für Kamerasteuerung: Jedes Video mit interessanter Perspektive oder gewünschter Kamerabewegung für Uni3C.

- Beste Ergebnisse: Wenn die Bewegungsrichtung des Referenzvideos mit Ihrer beabsichtigten Ausgaberichtung bei Uni3C übereinstimmt.

Best Practices für Prompt-Engineering bei Uni3C

- "Nicht stören"-Prinzip: Für reinen Bewegungstransfer ohne Charakteränderungen verwenden Sie einfache, allgemeine Prompts mit Uni3C.

- Spezifische Aktionsänderungen: Seien Sie detailliert, wenn Sie ändern möchten, was der Charakter mit Uni3C macht.

- Charakterkonsistenz: Konzentrieren Sie sich auf Prompts, die das Erscheinungsbild des Charakters mit Uni3C beibehalten.

Qualitätsoptimierung für Uni3C

- Bewegungskonsistenz: Vermeiden Sie plötzliche Änderungen in Referenzvideos für glattere Ergebnisse mit Uni3C.

- Bildstabilität: Stellen Sie sicher, dass Referenzmaterialien konsistente Beleuchtung und Bildkomposition für Uni3C aufweisen.

5. Danksagungen

Dieser Workflow wird von Uni3C betrieben, entwickelt von DAMO Academy (Alibaba Group), Fudan University und Hupan Lab. Die ComfyUI Integration basiert auf der hervorragenden Arbeit von kijai (ComfyUI-WanVideoWrapper), mit zusätzlichen Optimierungen und Workflow-Design, um diese leistungsstarke Uni3C Technologie für Kreative weltweit zugänglich zu machen.