O vídeo Hunyuan, um modelo de IA de código aberto desenvolvido pela Tencent, permite gerar visuais impressionantes e dinâmicos com facilidade. O modelo Hunyuan aproveita uma arquitetura avançada e técnicas de treinamento para entender e gerar conteúdo de alta qualidade, diversidade de movimento e estabilidade.

Sobre o Workflow de Vídeo para Vídeo Hunyuan

Este Workflow Hunyuan no ComfyUI utiliza o modelo Hunyuan para criar novo conteúdo visual combinando prompts de texto de entrada com um vídeo de condução existente. Aproveitando as capacidades do modelo Hunyuan, você pode gerar traduções de vídeo impressionantes que incorporam perfeitamente o movimento e os elementos-chave do vídeo de condução enquanto alinha a saída com o seu prompt de texto desejado.

Como Usar o Workflow de Vídeo para Vídeo Hunyuan

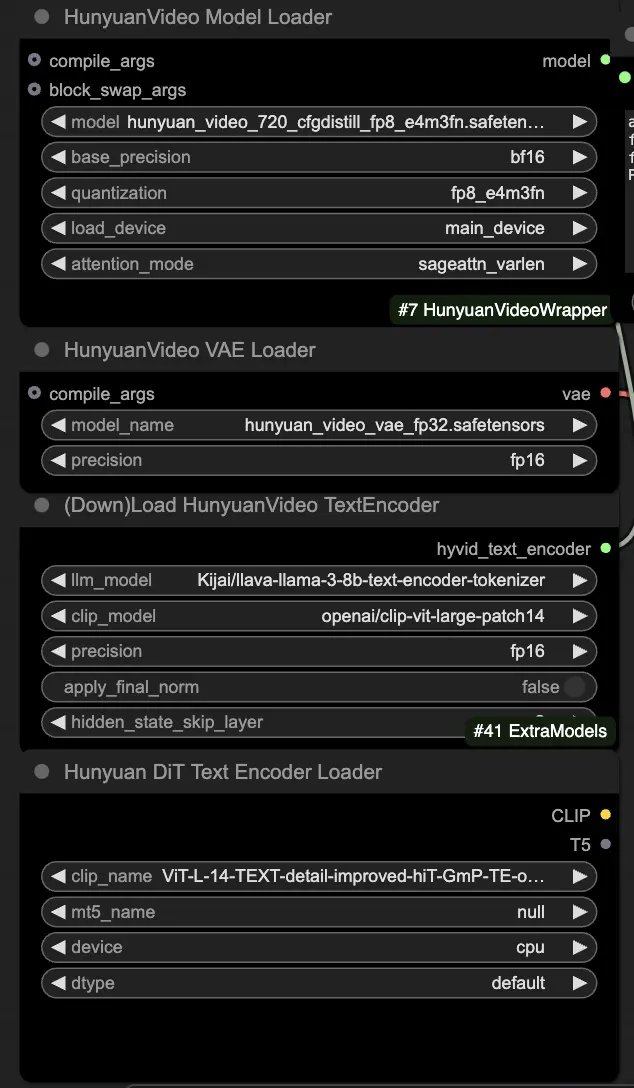

🟥 Passo 1: Carregar Modelos Hunyuan

- Carregue o modelo Hunyuan selecionando o arquivo "hunyuan_video_720_cfgdistill_fp8_e4m3fn.safetensors" no nó HyVideoModelLoader. Este é o modelo transformer principal.

- O modelo HunyuanVideo VAE será baixado automaticamente no nó HunyuanVideoVAELoader. Ele é usado para codificar/decodificar quadros de vídeo.

- Carregue um codificador de texto no nó DownloadAndLoadHyVideoTextEncoder. O workflow usa por padrão o codificador LLM "Kijai/llava-llama-3-8b-text-encoder-tokenizer" e o codificador CLIP "openai/clip-vit-large-patch14", que serão baixados automaticamente. Você também pode usar outros codificadores CLIP ou T5 que funcionaram com modelos anteriores.

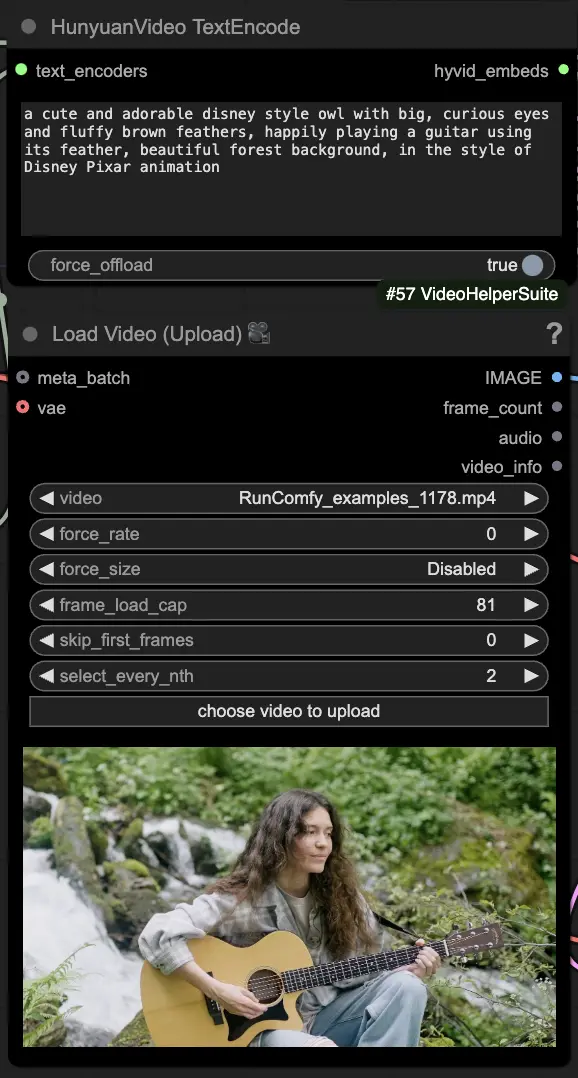

🟨 Passo 2: Inserir Prompt & Carregar Vídeo de Condução

- Insira seu prompt de texto descrevendo o visual que você deseja gerar no nó HyVideoTextEncode.

- Carregue o vídeo de condução que você deseja usar como referência de movimento no nó VHS_LoadVideo.

- frame_load_cap: Número de quadros a gerar. Ao definir o número, você precisa garantir que o número menos um seja divisível por 4; caso contrário, um ValueError será acionado, indicando que o comprimento do vídeo é inválido.

- skip_first_frames: Ajuste este parâmetro para controlar qual parte do vídeo será usada.

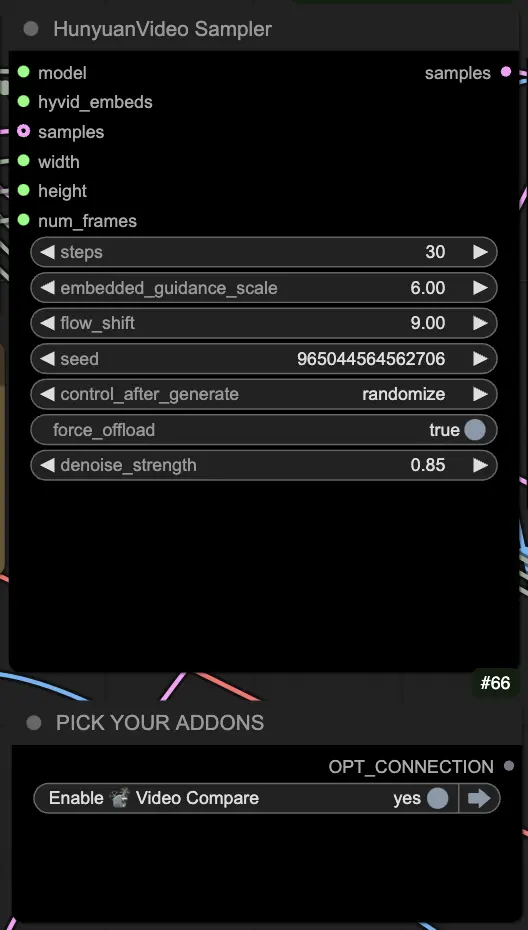

🟦 Passo 3: Configurações de Geração Hunyuan

- No nó HyVideoSampler, configure os hiperparâmetros de geração de vídeo:

- Steps: Número de etapas de difusão por quadro, quanto maior, melhor a qualidade, mas mais lenta a geração. Padrão 30.

- Embedded_guidance_scale: Quanto aderir ao prompt, valores mais altos aderem mais ao prompt.

- Denoise_strength: Controla a força de uso do vídeo de condução inicial. Valores mais baixos (por exemplo, 0.6) fazem a saída parecer mais com o inicial.

- Escolha complementos e alternâncias no nó "Fast Groups Bypasser" para habilitar/desabilitar recursos extras como o vídeo de comparação.

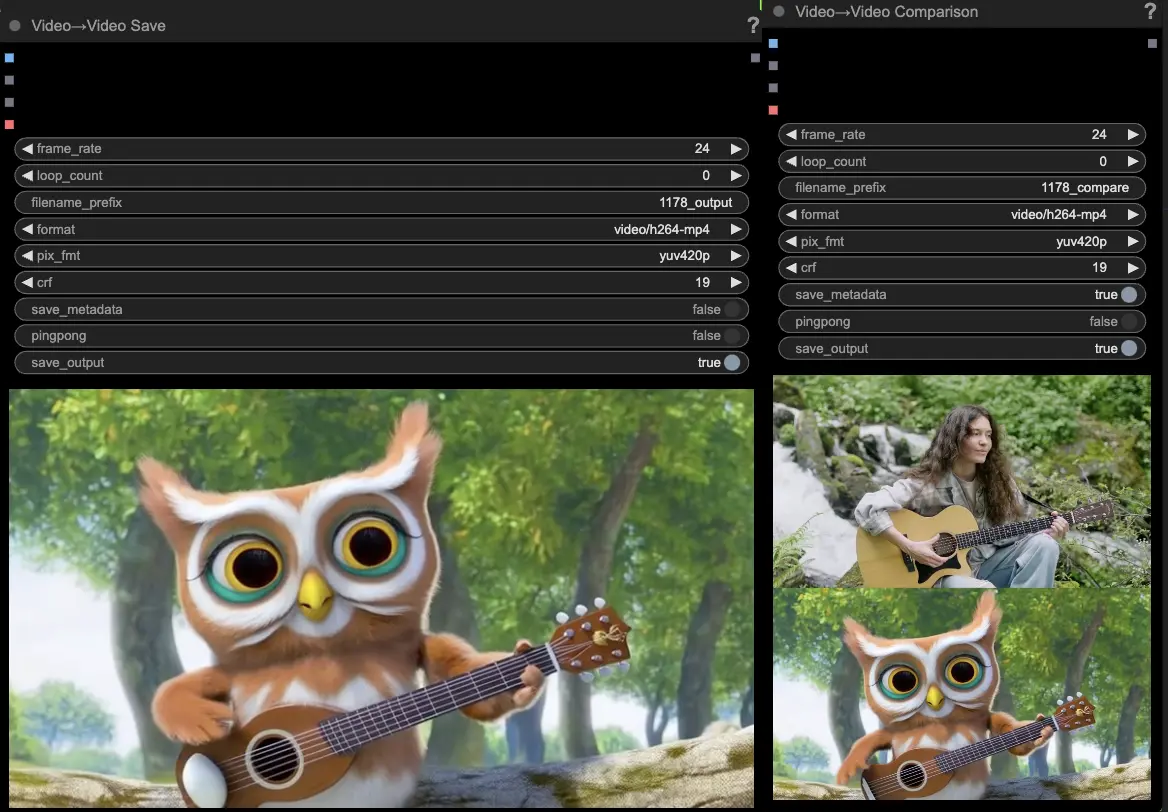

🟩 Passo 4: Gerar Vídeo Huanyuan

- Os nós VideoCombine irão gerar e salvar duas saídas por padrão:

- O resultado do vídeo traduzido

- Um vídeo de comparação mostrando o vídeo de condução e o resultado gerado

Ajustar o prompt e as configurações de geração permite uma flexibilidade impressionante na criação de novos vídeos impulsionados pelo movimento de um vídeo existente usando o modelo Hunyuan. Divirta-se explorando as possibilidades criativas deste workflow Hunyuan!

Este workflow Hunyuan foi projetado por Black Mixture. Por favor, visite o canal do Youtube do Black Mixture para mais informações. Também agradecimentos especiais ao Kijai pelos wrappers Hunyuan nós e exemplos de workflow.