Inferência FLUX.1 Dev LoRA: Corresponda as Pré-visualizações de Treinamento do AI Toolkit no ComfyUI

Inferência FLUX.1 Dev LoRA: geração correspondente ao treinamento, em etapas mínimas no ComfyUI A Inferência FLUX.1 Dev LoRA é um fluxo de trabalho RunComfy pronto para uso para aplicar FLUX.1 Dev LoRAs treinados com o AI Toolkit no ComfyUI, com resultados que permanecem próximos às suas pré-visualizações de treinamento. É construído em torno do RC FLUX.1 Dev (RCFluxDev)—um nó personalizado de código aberto, desenvolvido pelo RunComfy, que direciona a geração através de um pipeline de inferência específico do FLUX.1 Dev (em vez de um gráfico de amostrador genérico), enquanto injeta seu adaptador através de lora_path e lora_scale. Você pode navegar por trabalhos relacionados na organização de repositórios GitHub do runcomfy-com.

Use este fluxo de trabalho quando suas amostras do AI Toolkit parecerem “corretas”, mas mudar para um gráfico típico do ComfyUI faz com que o mesmo LoRA + prompt mude em estilo, força ou composição.

Por que a Inferência FLUX.1 Dev LoRA muitas vezes parece diferente no ComfyUI

As pré-visualizações do AI Toolkit são geradas por um pipeline de inferência específico do modelo. Muitos gráficos do ComfyUI reconstroem FLUX a partir de componentes genéricos, então “igualar os números” (prompt/etapas/orientação/seed) pode ainda produzir padrões e comportamento de aplicação de LoRA diferentes. Essa diferença “pré-visualização de treinamento vs inferência ComfyUI” é geralmente de nível de pipeline, não apenas um único parâmetro errado.

O que o nó personalizado RCFluxDev faz

RCFluxDev encapsula o pipeline de inferência FLUX.1 Dev usado para amostragem no estilo AI Toolkit e aplica seu LoRA dentro desse pipeline para que o comportamento do adaptador permaneça consistente para esta família de modelos. Fonte do pipeline: `src/pipelines/flux_dev.py`

Como usar o fluxo de trabalho de Inferência FLUX.1 Dev LoRA

Etapa 1: Importe seu LoRA (2 maneiras)

- Opção 1 (resultado de treinamento RunComfy): RunComfy → Trainer → LoRA Assets → encontre seu LoRA → ⋮ → Copy LoRA Link

- Opção 2 (LoRA do AI Toolkit treinado fora do RunComfy):

Copie um link direto de download .safetensors para seu LoRA e cole esse URL em lora_path.

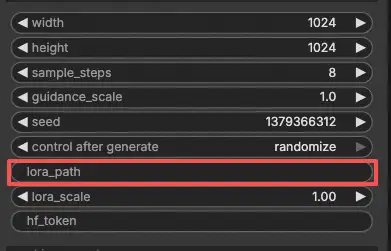

Etapa 2: Configure o nó personalizado RCFluxDev para Inferência FLUX.1 Dev LoRA

- No fluxo de trabalho, selecione RC FLUX.1 Dev (RCFluxDev) e cole seu URL de LoRA (ou caminho do arquivo) em

lora_path.

Importante (necessário para a primeira execução): para executar este nó personalizado, você deve (1) ter acesso ao Hugging Face para o repositório FLUX.1 Dev que você está usando, e (2) colar seu token do Hugging Face em hf_token:

- Na página do modelo Hugging Face, faça login e clique em Solicitar acesso / Concordar (uma vez por repositório).

- Crie um Token de Acesso de Usuário do Hugging Face com permissão de Leitura em huggingface.co/settings/tokens.

- Cole o token em

hf_tokenno RCFluxDev, então execute o fluxo de trabalho novamente.

Guia passo a passo: FLUX Hugging Face Token - Configuração e Solução de Problemas

- Em seguida, configure o restante das configurações para Inferência FLUX.1 Dev LoRA (tudo na interface do nó):

Dica de alinhamento de treinamento: quando você está buscando uma correspondência 1:1, não “ajuste por vibrações”—espelhe os valores de amostragem do YAML de treinamento do AI Toolkit que você usou para as pré-visualizações (especialmente width, height, sample_steps, guidance_scale, seed). Se você treinou no RunComfy, abra Trainer → LoRA Assets → Config e reutilize as configurações de pré-visualização.

prompt: seu prompt de texto (inclua os tokens de gatilho que você usou durante o treinamento, se houver)negative_prompt: opcional; mantenha vazio se você não amostrou com negativoswidth/height: resolução de saída (corresponda às pré-visualizações de treinamento ao comparar)sample_steps: número de etapas de inferênciaguidance_scale: valor de orientação usado pelo pipeline FLUX.1 Devseed: defina uma seed fixa para reproduzir; mude para explorar variaçõeslora_scale: força do LoRA (comece próximo ao valor de pré-visualização e depois ajuste)hf_token: seu token de acesso do Hugging Face (necessário para repositórios FLUX restritos)

Etapa 3: Execute a Inferência FLUX.1 Dev LoRA

- Clique em Queue/Run → SaveImage grava resultados na sua pasta de saída do ComfyUI automaticamente

Solução de Problemas de Inferência FLUX.1 Dev LoRA

A maioria dos problemas de “pré-visualização vs ComfyUI” do FLUX.1 Dev são causados por incompatibilidades de pipeline (como o modelo é carregado, como o condicionamento é construído e onde/como o adaptador é injetado), não apenas por um único parâmetro errado.

Para FLUX.1 Dev LoRAs treinados com o AI Toolkit, a maneira mais confiável de recuperar o comportamento correspondente ao treinamento no ComfyUI é executar a geração através do RC FLUX.1 Dev (RCFluxDev), que mantém a inferência alinhada no nível de pipeline e aplica seu adaptador consistentemente via lora_path / lora_scale. Se você estiver depurando um problema persistente, comece pelo fluxo de trabalho de referência mínima e adicione complexidade apenas depois de confirmar que a base funciona.

(1)Alto uso de vram de lora após atualização

Por que isso acontece

Com o FLUX.1 Dev, algumas configurações veem um grande salto de VRAM ao aplicar certos LoRAs (incluindo LoRAs treinados com o AI Toolkit). Isso geralmente aparece quando LoRAs são injetados através de caminhos de carregadores genéricos ou quando o gráfico causa cópias/recarregamentos extras do modelo.

Como corrigir (recomendado)

- Execute a inferência através do RCFluxDev e carregue seu adaptador apenas via

lora_pathno nó (evite misturar múltiplos nós de carregadores de LoRA para o mesmo modelo). - Mantenha sua comparação justa: corresponda aos valores de amostragem de pré-visualização de treinamento (

width,height,sample_steps,guidance_scale,seed) antes de julgar “parece errado”. - Se você ainda atingir OOM: reduza

width/heightprimeiro (isso geralmente é a maior alavanca para FLUX), depois reduza lote/nós extras e reinicie a sessão para limpar caches antigos. Além disso, você pode lançar uma máquina GPU mais potente no RunComfy para executar.

(2)VAEDecode Dado groups=1, peso de tamanho [4, 4, 1, 1], entrada esperada [1, 16, 144, 112] para ter 4 canais, mas recebeu 16 canais em vez disso

Por que isso acontece

Latentes FLUX e latentes “SD clássicos” não são intercambiáveis. Este erro é o sintoma usual de decodificação de latentes FLUX com um VAE não-FLUX (um VAE que espera latentes de 4 canais, enquanto latentes FLUX podem ser de 16 canais).

Como corrigir

- Não decodifique latentes FLUX com um caminho de VAE SD/SDXL.

- Use o fluxo de trabalho RCFluxDev para que o caminho de decodificação FLUX correto seja usado de ponta a ponta (carregamento do modelo → amostragem → decodificação), em vez de misturar nós VAE genéricos de outros pipelines.

- Se você estiver reconstruindo gráficos manualmente, verifique novamente se está usando os ativos de autoencoder FLUX corretos e não um VAE SD/SDXL restante.

(3)o modelo flux não funciona, flux1-dev-fp8.safetensors

Por que isso acontece

Isso geralmente ocorre quando um UNet FLUX .safetensors é carregado usando o tipo errado de carregador (por exemplo, tratando-o como um “checkpoint” que o ComfyUI deve detectar automaticamente como SD/SDXL).

Como corrigir

- Use o fluxo de trabalho FLUX.1 Dev (RCFluxDev) e deixe o fluxo de trabalho/nó lidar com o carregamento do modelo; apenas passe seu LoRA através de

lora_path. - Não carregue UNets FLUX usando carregadores de checkpoint SD/SDXL.

- Se o arquivo foi baixado de um link, verifique novamente se é um

.safetensorscompleto e válido (downloads parciais podem desencadear erros de detecção confusos).

Execute a Inferência FLUX.1 Dev LoRA agora

Abra o fluxo de trabalho FLUX.1 Dev LoRA Inference no RunComfy, defina lora_path, e gere com RCFluxDev para manter os resultados do ComfyUI alinhados com suas pré-visualizações de treinamento do AI Toolkit.