1. Flusso di lavoro ComfyUI AnimateLCM

Il flusso di lavoro ComfyUI AnimateLCM è progettato per migliorare le velocità di animazione AI. Basandosi sulle fondamenta di ComfyUI-AnimateDiff-Evolved, questo flusso di lavoro incorpora AnimateLCM per accelerare specificamente la creazione di animazioni da testo a video (t2v). Puoi sperimentare con vari prompt e passaggi per ottenere i risultati desiderati.

2. Panoramica di AnimateLCM

L'avvento di tecnologie come SDXL, LCM e SDXL Turbo ha notevolmente aumentato il ritmo della generazione di immagini. AnimateLCM spinge ulteriormente il progresso nell'animazione AI. Supporta la generazione rapida da immagine a video ed è finalizzato a migliorare la velocità e l'efficienza della produzione di video animati da immagini statiche o descrizioni testuali, rendendolo particolarmente utile per creare rapidamente effetti di animazione personalizzati.

2.1. Introduzione ad AnimateLCM

AnimateLCM è progettato per accelerare l'animazione di modelli di diffusione personalizzati e adattatori attraverso l'apprendimento di consistenza disaccoppiata. È ispirato al Consistency Model (CM), che distilla i modelli di diffusione di immagini preaddestrati per accelerare il processo di campionamento, e alla sua estensione, il Latent Consistency Model (LCM), che si concentra sulla generazione di immagini condizionate. AnimateLCM sfrutta queste fondamenta per consentire la creazione di video ad alta fedeltà in pochi passaggi, basandosi sul successo delle tecniche di diffusione e generazione di immagini per espandere le loro capacità nel dominio video.

2.2. Come utilizzare AnimateLCM nel tuo flusso di lavoro ComfyUI

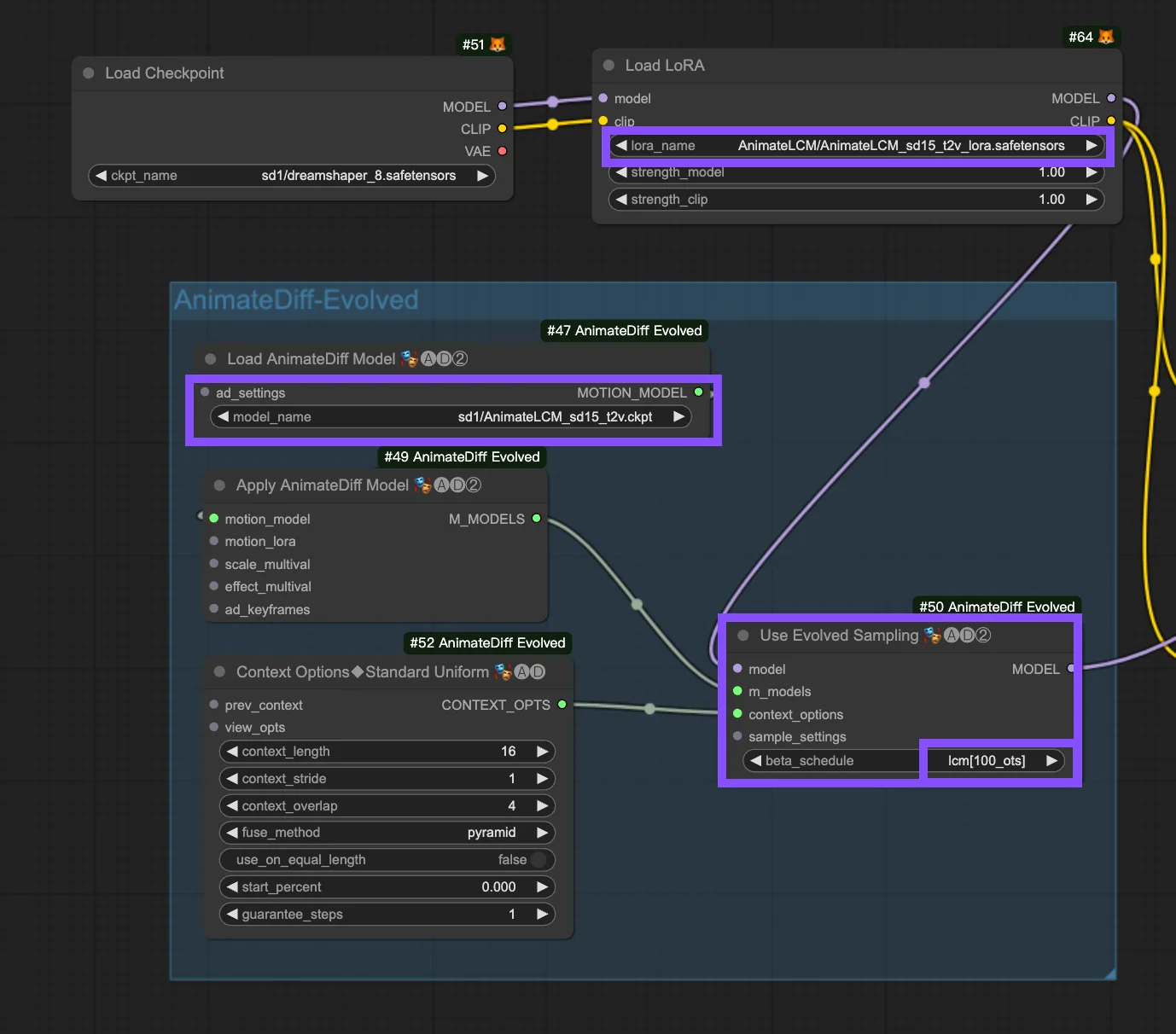

Questo flusso di lavoro si basa sul flusso di lavoro ComfyUI-AnimateDiff-Evolved. I seguenti sono i parametri di configurazione nel nodo "Usa campionamento evoluto".

Modelli: Imposta il modello checkpoint e il modello LoRA.

- Checkpoint: Si riferisce agli input del modello StableDiffusion (SD) utilizzati per la creazione dell'animazione. A seconda dei modelli di movimento scelti, la compatibilità può variare tra le versioni di SD, come SD1.5 o SDXL.

- LoRA: Incorpora il modello AnimateLCM LoRA per integrare senza problemi gli adattatori esistenti per una varietà di funzioni, migliorando l'efficienza e la qualità dell'output con un focus sull'apprendimento di consistenza senza sacrificare la velocità di campionamento.

Modelli di movimento (Modelli M): Questi sono gli output dal processo Apply AnimateDiff Model, che consentono l'uso del modello di movimento AnimateLCM.

Opzioni di contesto: Queste impostazioni regolano il funzionamento di AnimateDiff durante la produzione di animazioni, consentendo animazioni di qualsiasi lunghezza tramite finestre di contesto scorrevoli sull'intero Unet o specificamente all'interno del modulo di movimento. Consentono anche regolazioni temporali per sequenze di animazione complesse. Fai riferimento qui per una guida completa su AnimateDiff

Pianificazione Beta nelle impostazioni di campionamento: Opta per LCM. All'interno delle impostazioni di campionamento di AnimateDiff in ComfyUI, la selezione "pianificazione beta", incluse opzioni come "lcm", "lineart", ecc., regola i valori beta che regolano i livelli di rumore durante il processo di diffusione. Questa personalizzazione influisce sullo stile visivo e sulla fluidità dell'animazione. Ogni impostazione è adatta a specifiche esigenze di animazione o di modello di movimento.

- LCM (Latent Consistency Module): L'impostazione "lcm" è personalizzata per LoRA LCM, migliorando l'uniformità dell'animazione e riducendo il tempo di creazione. Raggiunge una convergenza più rapida con meno passaggi, richiedendo la riduzione dei passaggi (fino a un minimo di ~4 passaggi) e altre regolazioni dei parametri per una conservazione ottimale dei dettagli.

- Lineare (AnimateDiff-SDXL): Consigliato per AnimateDiff con moduli di movimento SDXL, questa opzione raggiunge un equilibrio tra conservazione dei dettagli e fluidità del movimento, indicando la compatibilità con versioni specifiche di modelli di movimento.

- Sqrt_lineart (AnimateDiff): Simile a "lineart", questa variante è progettata per i processi AnimateDiff, specialmente con i moduli di movimento V2, modificando i livelli di rumore per complementare l'output del modello di movimento per transizioni o movimenti più fluidi.