UNO ByteDance | Konsistente Subjekt- & Objektgenerierung

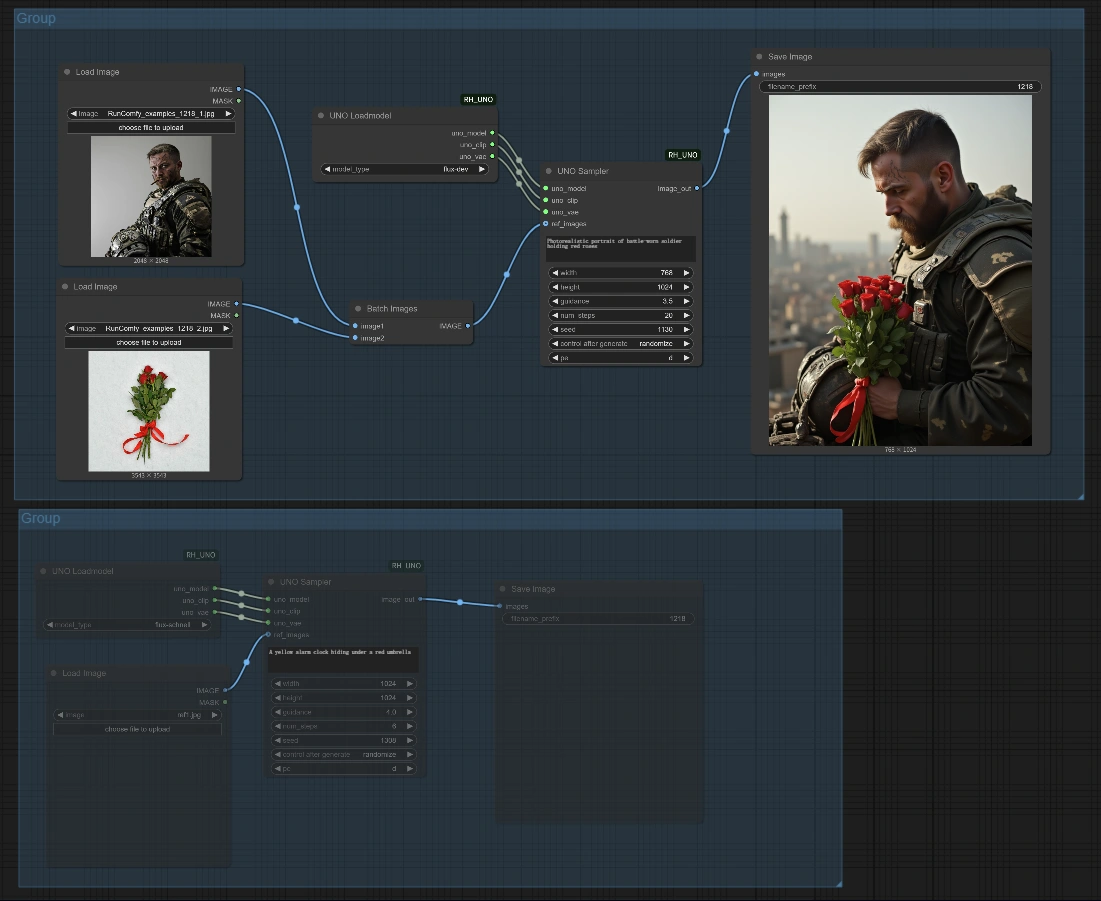

Der UNO-Workflow für ComfyUI bringt ByteDance's fortschrittliche Bildgenerierungstechnologie zu RunComfy. Dieses leistungsstarke Modell zeichnet sich durch die Erstellung hochkonsistenter Bilder aus, wenn Referenzobjekte bereitgestellt werden. Ob Sie eine Einzelobjektgenerierung (eine Figur in verschiedenen Szenen) oder Subjekt-Objekt-Kompositionen (Kombinierung eines Subjekts mit einem bestimmten Objekt in einem Bild) benötigen, UNO ByteDance liefert außergewöhnliche Treue und Qualität. Das Modell arbeitet effektiv, selbst auf kleineren Cloud-Maschinen, und macht die UNO-Bildanpassung von ByteDance für jedermann zugänglich. Perfekt für Produktvisualisierungen, Charakterillustrationen, kreative Kompositionen und vieles mehr.ComfyUI UNO ByteDance Subject-Object Generation Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

ComfyUI UNO ByteDance Subject-Object Generation Beispiele

ComfyUI UNO ByteDance Subject-Object Generation Beschreibung

ComfyUI UNO Beschreibung

1. Was ist ByteDance's ComfyUI UNO?

Der ComfyUI UNO-Workflow integriert ByteDance's Universal aNd cOntrollable (UNO) Modell in die ComfyUI-Umgebung. Entwickelt vom Intelligent Creation Team von ByteDance, stellt UNO einen bedeutenden Fortschritt in der subjektgesteuerten Bildgenerierungstechnologie dar, basierend auf dem innovativen "Less-to-More"-Generalizationsparadigma. UNO ermöglicht flexible und hochpräzise Bildgenerierung, während es Identitätsmerkmale von Referenzobjekten mit bemerkenswerter Konsistenz über verschiedene Kontexte und Szenarien hinweg bewahrt.

2. Vorteile von ByteDance's ComfyUI UNO:

- Überlegene Subjektkonsistenz: UNO bewahrt außergewöhnliche Subjektähnlichkeit über unterschiedliche Kontexte hinweg.

- Subjekt-Objekt-Kontrolle: Im Gegensatz zu vielen Alternativen glänzt UNO darin, sowohl Subjektreferenzen als auch Objektreferenzen gleichzeitig ohne Identitätsverwirrung zu handhaben.

- Universelle Kompatibilität: UNO arbeitet mit verschiedenen Arten von Subjekten - Menschen, Objekte, Spielzeuge, Logos und mehr.

- Ressourceneffizienz: UNO liefert Ergebnisse in professioneller Qualität, selbst mit begrenzten VRAM-Ressourcen (funktioniert gut mit 24GB).

- Flexible Implementierung: UNO umfasst Workflows für sowohl Einzelobjekt- als auch Subjekt-Objekt-Generierung.

3. Nutzung von ByteDance's ComfyUI UNO

3.1 Workflow-Einrichtung

Der UNO-Workflow hat zwei Hauptkonfigurationen:

Obergruppe - Subjekt-Objekt-Generierung:

- Diese Konfiguration ermöglicht es Ihnen, ein Referenzsubjektbild und ein Referenzobjektbild einzugeben, die in einer generierten Szene gemäß Ihrem Textprompt kombiniert werden.

Untergruppe - Einzelobjekt-Generierung:

- Diese Konfiguration verwendet ein einzelnes Referenzbild und generiert neue Bilder dieses Subjekts in verschiedenen Kontexten.

3.2 Generierungsprozess mit ByteDance's UNO

Grundlegende Einrichtung:

- Laden von Referenzbildern:

- Für den Subjekt-Objekt-Workflow (Obergruppe): Laden Sie ein Subjektreferenzbild und ein Objektreferenzbild hoch

- Für den Einzelobjekt-Workflow (Untergruppe): Laden Sie ein Referenzbild hoch

- Text-Prompt für ByteDance's UNO festlegen:

- Schreiben Sie einen beschreibenden Prompt für Ihre gewünschte Szene, einschließlich wie das Referenzsubjekt/-objekt erscheinen soll

- Parameter von ByteDance's UNO anpassen:

Width/Height: Bestimmen Sie die Ausgabeauflösung (empfohlen 768×1024 oder 1024×1024)Guidance: Kontrolliert, wie genau ByteDance's UNO der Textaufforderung folgt (3.5-4.0 empfohlen)Num_steps: Höhere Werte (20+) erzeugen konsistentere Ergebnisse mit ByteDance's UNO, insbesondere für menschliche GesichterSeed: Setzen Sie einen spezifischen Seed für die Reproduzierbarkeit oder randomisieren Sie für Vielfalt in ByteDance's UNO-Ausgaben

- Bild mit ByteDance's UNO generieren:

- Klicken Sie "Queue Prompt", um den ByteDance UNO-Workflow auszuführen

- Überprüfen Sie das Ergebnis im "Save Image"-Knoten

3.3 Parameterreferenz für ByteDance's UNO

UNO Loadmodel Node:

model_type: Bestimmt, welche ByteDance UNO Modellvariante verwendet wirdflux-dev: Standard ByteDance UNO Modell mit guter Balance zwischen Qualität und Leistungflux-schnell: Schnelleres ByteDance UNO Modellvariante mit etwas geringerer Qualität

3.4 Tipps für beste Ergebnisse mit ByteDance's UNO

Subjektauswahl für UNO:

- Wählen Sie klare, gut beleuchtete Referenzbilder, bei denen das Subjekt prominent ist

- Für Gesichter/Menschen funktionieren frontale Bilder mit neutralen Ausdrücken am besten mit ByteDance's UNO

- Für Objekte sind klare Bilder mit minimaler Hintergrundablenkung ideal für die Verarbeitung durch ByteDance's UNO

Prompt Engineering für UNO:

- Seien Sie spezifisch in Bezug auf Subjektbeschreibungen, die zu Ihren Referenzbildern passen

- Beschreiben Sie die gewünschte Szene, Beleuchtung und Komposition, die ByteDance's UNO generieren soll

- Beziehen Sie sich auf die spezifischen Subjekte (z.B. "ein junger Mann", "ein Vintage-Fahrrad")

- Halten Sie Prompts prägnant, aber detailliert für optimale ByteDance UNO-Ergebnisse

4. Technische Informationen über ByteDance's UNO

Die ByteDance UNO-Technologie basiert auf FLUX-Modellen und nutzt die DiT (Diffusion Transformer) Architektur mit mehreren entscheidenden Verbesserungen:

- Universal Rotary Position Embedding (UnoPE): Ein spezieller Mechanismus in ByteDance's UNO, der dem Modell hilft, zwischen Referenzsubjekten und -objekten zu unterscheiden und die Attributverwirrung erheblich zu reduzieren.

- Progressive Cross-Modal Alignment: Trainingsmethodik, die es ByteDance's UNO ermöglicht, zunehmend komplexe Multi-Bedingungssteuerungen zu handhaben.

- Universelle Anpassung: ByteDance's UNO ist in der Lage, verschiedene Subjekttypen ohne spezialisiertes Training zu handhaben.

5. Danksagungen

Dieser Workflow wird von UNO angetrieben, entwickelt vom Intelligent Creation Team bei ByteDance (Shaojin Wu, Mengqi Huang, Wenxu Wu, Yufeng Cheng, Fei Ding, und Qian He). Die ComfyUI-Integration von ByteDance's UNO wird von Community-Beiträgen bereitgestellt, die ByteDance's bahnbrechende Forschung in einen zugänglichen Workflow adaptieren.

Für weitere Informationen über ByteDance's UNO, besuchen Sie das .