1. Was ist IC-Light?

IC-Light ist ein auf KI basierendes Bildbearbeitungstool, das sich mit Stable Diffusion-Modellen integriert, um lokalisierte Bearbeitungen an generierten Bildern durchzuführen. Es funktioniert, indem es das Bild in eine latente Raumrepräsentation kodiert, Bearbeitungen auf bestimmte Regionen anwendet und dann die modifizierte latente Repräsentation wieder in ein Bild dekodiert. Dieser Ansatz ermöglicht eine präzise Kontrolle über den Bearbeitungsprozess und bewahrt gleichzeitig den Gesamtstil und die Kohärenz des Originalbildes.

Es gibt nun zwei veröffentlichte Modelle: ein textgesteuertes Neubeleuchtungsmodell und ein hintergrundgesteuertes Modell. Beide Typen nehmen Vordergrundbilder als Eingabe.

2. Wie funktioniert IC-Light?

Unter der Haube nutzt IC-Light die Leistung von Stable Diffusion-Modellen, um Bilder zu kodieren und zu dekodieren. Der Prozess kann in die folgenden Schritte unterteilt werden:

2.1. Kodierung: Das Eingabebild wird durch den Stable Diffusion VAE (Variational Autoencoder) geleitet, um eine komprimierte latente Raumrepräsentation zu erhalten. 2.2. Bearbeitung: Die gewünschten Bearbeitungen werden auf bestimmte Regionen der latenten Repräsentation angewendet. Dies geschieht typischerweise durch Verkettung der ursprünglichen Latenz mit einer Maske, die die zu modifizierenden Bereiche angibt, zusammen mit den entsprechenden Bearbeitungsprompts. 2.3. Dekodierung: Die modifizierte latente Repräsentation wird durch den Stable Diffusion-Decoder geleitet, um das bearbeitete Bild zu rekonstruieren. Durch die Arbeit im latenten Raum kann IC-Light lokalisierte Bearbeitungen vornehmen und gleichzeitig die Gesamtkohärenz und den Stil des Bildes beibehalten.

3. Wie verwendet man ComfyUI IC-Light?

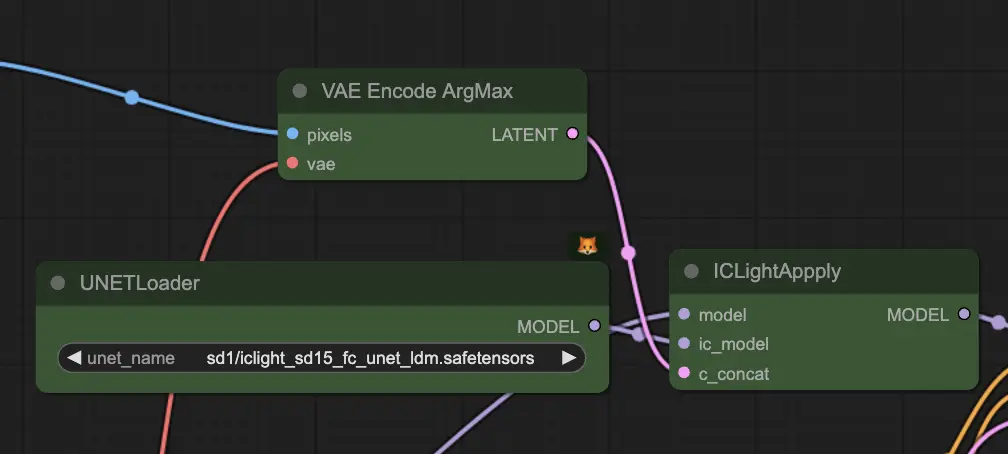

Der Hauptknoten, mit dem Sie arbeiten werden, ist der "IC-Light Apply"-Knoten, der den gesamten Prozess der Kodierung, Bearbeitung und Dekodierung Ihres Bildes übernimmt.

3.1. "IC-Light Apply" Eingabeparameter:

Der "IC-Light Apply"-Knoten benötigt drei Haupteingaben:

- model: Dies ist das Stable Diffusion-Basismodell, das für die Kodierung und Dekodierung Ihres Bildes verwendet wird.

- ic_model: Dies ist das vortrainierte IC-Light-Modell, das die notwendigen Gewichte für den Bearbeitungsprozess enthält.

- c_concat: Dies ist eine spezielle Eingabe, die Ihr Originalbild, die Maske, die angibt, welche Bereiche bearbeitet werden sollen, und die Bearbeitungsprompts, die definieren, wie diese Bereiche modifiziert werden sollen, kombiniert.

Um die c_concat-Eingabe zu erstellen:

- Verwenden Sie den VAEEncodeArgMax-Knoten, um Ihr Originalbild zu kodieren. Dieser Knoten stellt sicher, dass die wahrscheinlichste latente Repräsentation Ihres Bildes erhalten wird.

- Verwenden Sie den ICLightApplyMaskGrey-Knoten, um eine maskierte Version Ihres Bildes zu erstellen. Dieser Knoten nimmt Ihr Originalbild und eine Maske als Eingabe und gibt eine Version des Bildes aus, bei der die nicht maskierten Bereiche ausgegraut sind.

- Erstellen Sie latente Repräsentationen Ihrer Bearbeitungsprompts. Diese Prompts leiten die Änderungen, die an den ausgewählten Regionen Ihres Bildes vorgenommen werden.

- Kombinieren Sie die latenten Repräsentationen Ihres Originalbildes, der Maske und der Bearbeitungsprompts zu einer einzigen Eingabe für den "IC-Light Apply"-Knoten.

3.2. "IC-Light Apply" Ausgabeparameter:

Nach der Verarbeitung Ihrer Eingaben gibt der "IC-Light Apply"-Knoten einen einzigen Parameter aus:

- model: Dies ist das gepatchte Stable Diffusion-Modell mit den angewendeten IC-Light-Modifikationen.

Um Ihr endgültiges bearbeitetes Bild zu generieren, verbinden Sie einfach das Ausgabemodell mit den entsprechenden Knoten in Ihrem ComfyUI-Workflow, wie z. B. den KSampler- und VAEDecode-Knoten.

3.3. Tipps für beste Ergebnisse:

- Verwenden Sie hochwertige Masken: Um sicherzustellen, dass Ihre Bearbeitungen präzise und effektiv sind, stellen Sie sicher, dass Ihre Masken die Regionen, die Sie modifizieren möchten, genau umreißen.

- Experimentieren Sie mit verschiedenen Bearbeitungsprompts: Die Bearbeitungsprompts leiten die Änderungen, die an den ausgewählten Regionen Ihres Bildes vorgenommen werden. Probieren Sie verschiedene Prompts aus, um den gewünschten Effekt zu erzielen, und zögern Sie nicht, Ihre Prompts basierend auf den erzielten Ergebnissen zu verfeinern.

- Balancieren Sie globale und lokale Bearbeitungen: Während IC-Light hervorragend für lokalisierte Bearbeitungen geeignet ist, ist es wichtig, die Gesamtkomposition und Kohärenz Ihres Bildes zu berücksichtigen. Versuchen Sie, ein Gleichgewicht zwischen fokussierten Bearbeitungen und globalen Anpassungen zu finden, um die Integrität Ihres generierten Kunstwerks zu erhalten.

Weitere Informationen finden Sie auf github