AI-Renderings von 3D-Animationen: Blender + ComfyUI

Dieser innovative Workflow, entwickelt vom talentierten Mickmumpitz, kombiniert Blender und ComfyUI, um atemberaubende 3D-Animationen mit AI zu rendern. Wir empfehlen dringend, seinen YouTube-Kanal für weitere Inspirationen zu besuchen.

Im Folgenden haben wir verschiedene Materialien verwendet, um seinen Ansatz nachzustellen. Hier sind die Schritte:

🌟 Laden Sie alle unsere Blender-Materialien für Experimente über diesen Link herunter.

Teil 1: Verwendung von Blender zur Erstellung von 3D-Animationen und Render-Pässen

1. Einrichten einer 3D-Szene in Blender

- Beginnen Sie mit dem Importieren oder Modellieren der notwendigen 3D-Assets, wie Charaktere, Umgebungen und Requisiten. Ordnen Sie diese Assets in der Szene an, positionieren Sie die Kameras und richten Sie die erforderlichen Animationen ein. Entfernen Sie vorhandene Materialien, Texturen und Lichter, da ComfyUI diese während des Rendering-Prozesses generieren wird.

2. Rendern des Tiefenpasses

- Der Tiefenpass liefert wesentliche Entfernungsinformationen, um die Tiefenwahrnehmung zu verbessern, die in ComfyUI genutzt wird.

- Gehen Sie in Blender zu

View Layer Properties, aktivieren Sie denZ-Pass und rendern Sie das Bild. Verbinden Sie imCompositing-Tab einen Viewer-Knoten mit dem Tiefenausgang. Normalisieren Sie die Tiefenwerte mit einemMap Range-Knoten, um ein schwarz-weißes Gradient zu erstellen, das die Tiefe der Szene darstellt.

3. Rendern des Umrisspasses

- Der Umrisspass erzeugt Linienkunstkanten, die die Formen und Silhouetten von Objekten für die Verwendung in ComfyUI definieren.

- Verwenden Sie in Blender das Freestyle-Tool, um Umrisse basierend auf der 3D-Geometrie zu erstellen. Stellen Sie die Farbe auf Weiß ein und passen Sie die Linienstärke an. Rendern Sie das Bild und verarbeiten Sie es im

Compositing-Tab.

4. Rendern des Maskenpasses

- Der Maskenpass weist verschiedenen Objekten einzigartige Farben zu. Notieren Sie sich die Hex-Codes für diese Farben, da sie für spezifische AI-Prompts in ComfyUI verwendet werden.

- Weisen Sie in Blender jedem Objekt einfache Emissionsshader mit unterschiedlichen Farben zu. Rendern Sie das Bild und speichern Sie es.

Für detaillierte Anweisungen zu diesen Schritten, sehen Sie sich das YouTube-Tutorial von Mickmumpitz an, wenn Sie mit Blender nicht vertraut sind.

Nach Abschluss von Teil 1 haben Sie drei Arten von Bildsequenzen erstellt: Maskenbilder, Tiefenbilder und Umrissbilder. Diese werden im nächsten Schritt mit ComfyUI verwendet.

Teil 2: Verwendung von ComfyUI zum Rendern von AI-Animationen

Der ComfyUI-Workflow von Mickmumpitz besteht aus mehreren Schlüsselkomponenten:

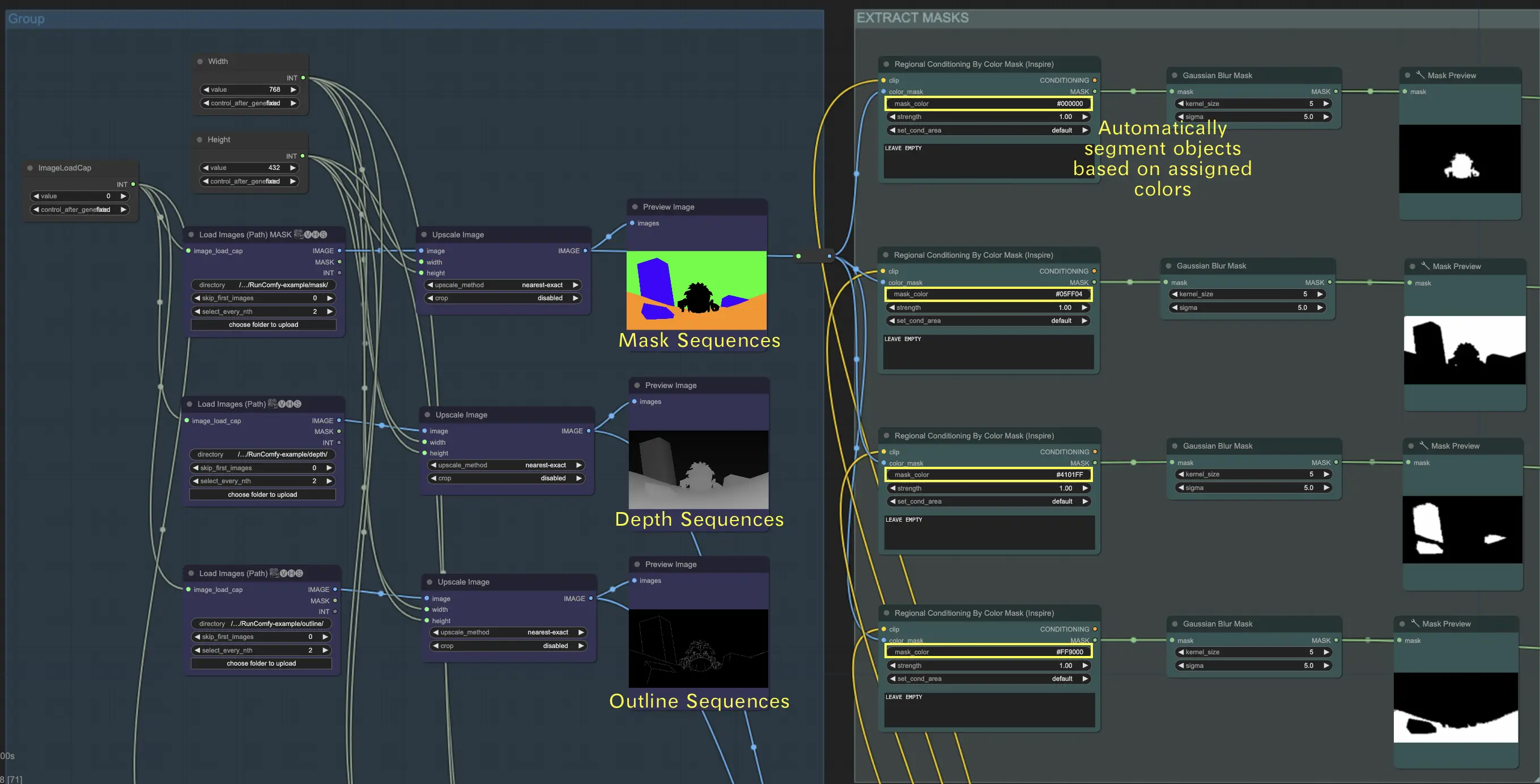

1. Laden von Bildsequenzen

- Laden von Maskensequenzen: Laden Sie die Maskensequenz und verwenden Sie dann den "regional conditioning by color mask"-Knoten, um die Objekte im Maskenbild zu trennen. Geben Sie den im Schritt 1 erhaltenen Hex-Code in das Feld "mask_color" ein. Dieser Knoten segmentiert dann automatisch Objekte basierend auf den zugewiesenen Farben. 🌟 Hinweis: Wir verwenden spezifische Hex-Codes für unsere Materialien in diesem Workflow. Wenn Sie ein anderes Maskenbild verwenden, geben Sie sicher den entsprechenden Hex-Code in das Feld "mask_color" ein. Dies stellt sicher, dass der "regional conditioning by color mask"-Knoten die Objekte korrekt segmentiert.

- Laden von Tiefensequenzen: Laden Sie die Tiefensequenzen, um Informationen über die Entfernung von Objekten in der Szene bereitzustellen.

- Laden von Umrisssequenzen: Laden Sie die Umrisssequenzen, um die Formen und Kanten von Objekten in der Szene zu definieren.

🌟 So laden Sie Bildsequenzen nach Pfad

Organisieren Sie Ihre Sequenzen

- Platzieren Sie Ihre Maskensequenzen in einem Ordner, beispielsweise

{mask}. - Platzieren Sie Ihre Tiefensequenzen in einem separaten Ordner, beispielsweise

{depth}. - Platzieren Sie Ihre Umrisssequenzen in einem anderen Ordner, beispielsweise

{outline}.

Ordner hochladen

- Verwenden Sie unseren Dateibrowser, um diese Ordner in das Verzeichnis

ComfyUI/inputhochzuladen.

Verzeichnispfad

- Der vollständige Verzeichnispfad sollte sein:

/home/user/ComfyUI/input/{folder_name}. - Zum Beispiel:

/home/user/ComfyUI/input/{mask}.

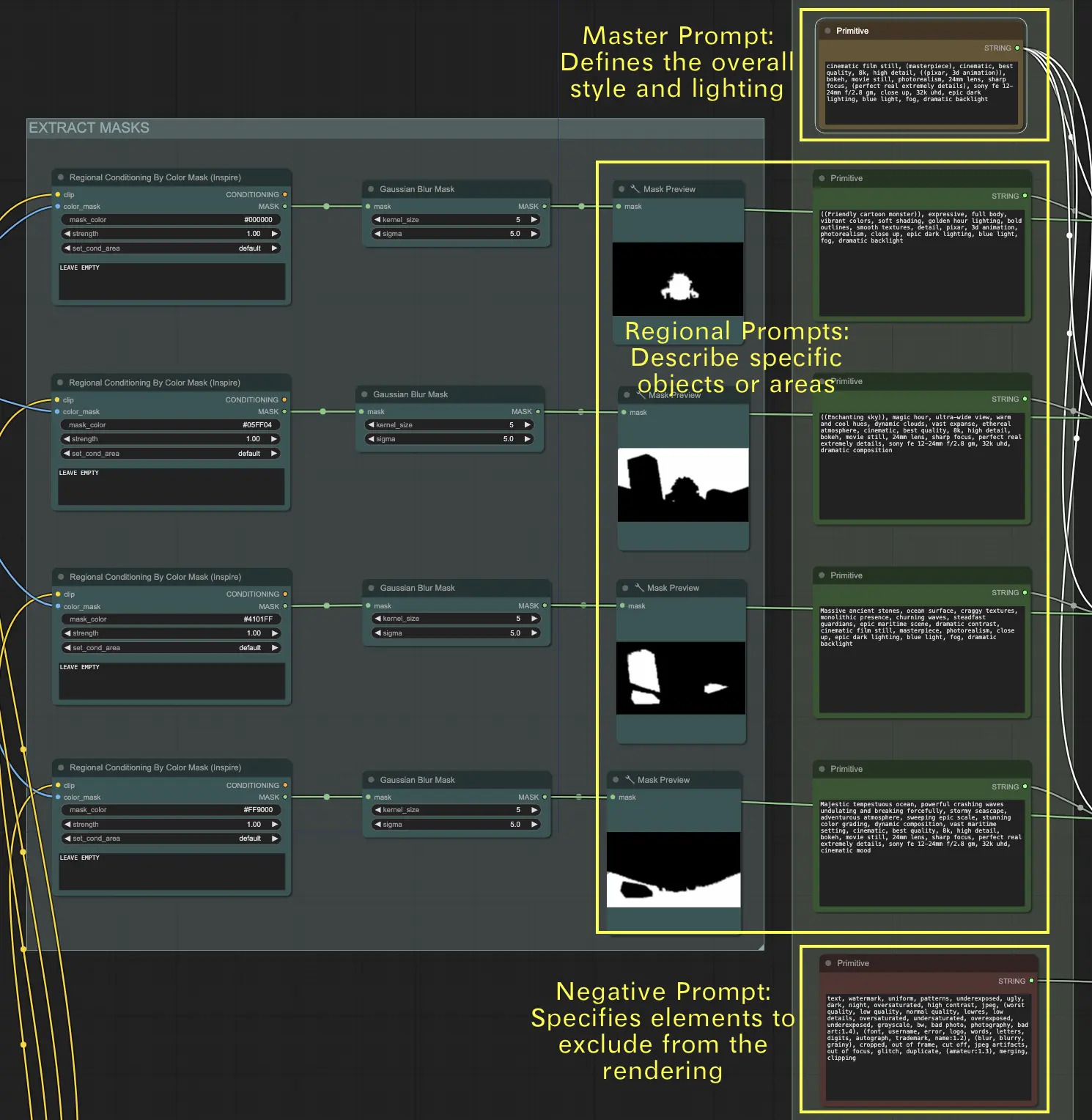

2. Verwenden Sie Text-Prompts, um visuelle Effekte zu definieren

Für Maskensequenzen verwenden Sie Text-Prompts, um die gewünschten visuellen Effekte für jedes Objekt in der Szene anzugeben.

- Master-Prompt: Dieser Prompt legt den allgemeinen Stil und die Beleuchtung für die gesamte Szene fest. Er bestimmt die allgemeine Stimmung, Atmosphäre und den visuellen Ton, den das endgültige Rendering erreichen soll.

- Regionale Prompts: Diese Prompts bieten detaillierte Beschreibungen für spezifische Objekte oder Bereiche innerhalb der Szene. Jeder Prompt sollte einem bestimmten Objekt oder Bereich entsprechen, um sicherzustellen, dass jedes Element genau wie beabsichtigt dargestellt wird.

- Negativer Prompt: Dieser Prompt listet die Elemente auf, die vom Rendering ausgeschlossen werden sollen. Er hilft, bestimmte Merkmale oder Objekte im endgültigen Ergebnis zu vermeiden, um sicherzustellen, dass die Szene fokussiert und frei von unerwünschten Details bleibt.

3. ControlNet-Modul

- Geben Sie die Tiefensequenzen in das ControlNet Depth-Modell ein.

- Geben Sie die Umrisssequenzen in das ControlNet Canny-Modell ein.

4. AnimateDiff-Modul

- Verwenden Sie dieses Modul, um fließende Animationen aus den verarbeiteten Sequenzen zu rendern.

5. Optionale IPAdapter-Nutzung

- Verwenden Sie den IPAdapter für zusätzliche Konditionierungsanweisungen, um die Konsistenz und Qualität der generierten Bilder zu verbessern.

Durch die Nutzung der präzisen 3D-Daten von Blender in Kombination mit den leistungsstarken Bildsynthesefähigkeiten von Stable Diffusion über ComfyUI können Sie unglaublich fotorealistische oder stilisierte 3D-Animationen mit voller kreativer Kontrolle erstellen.