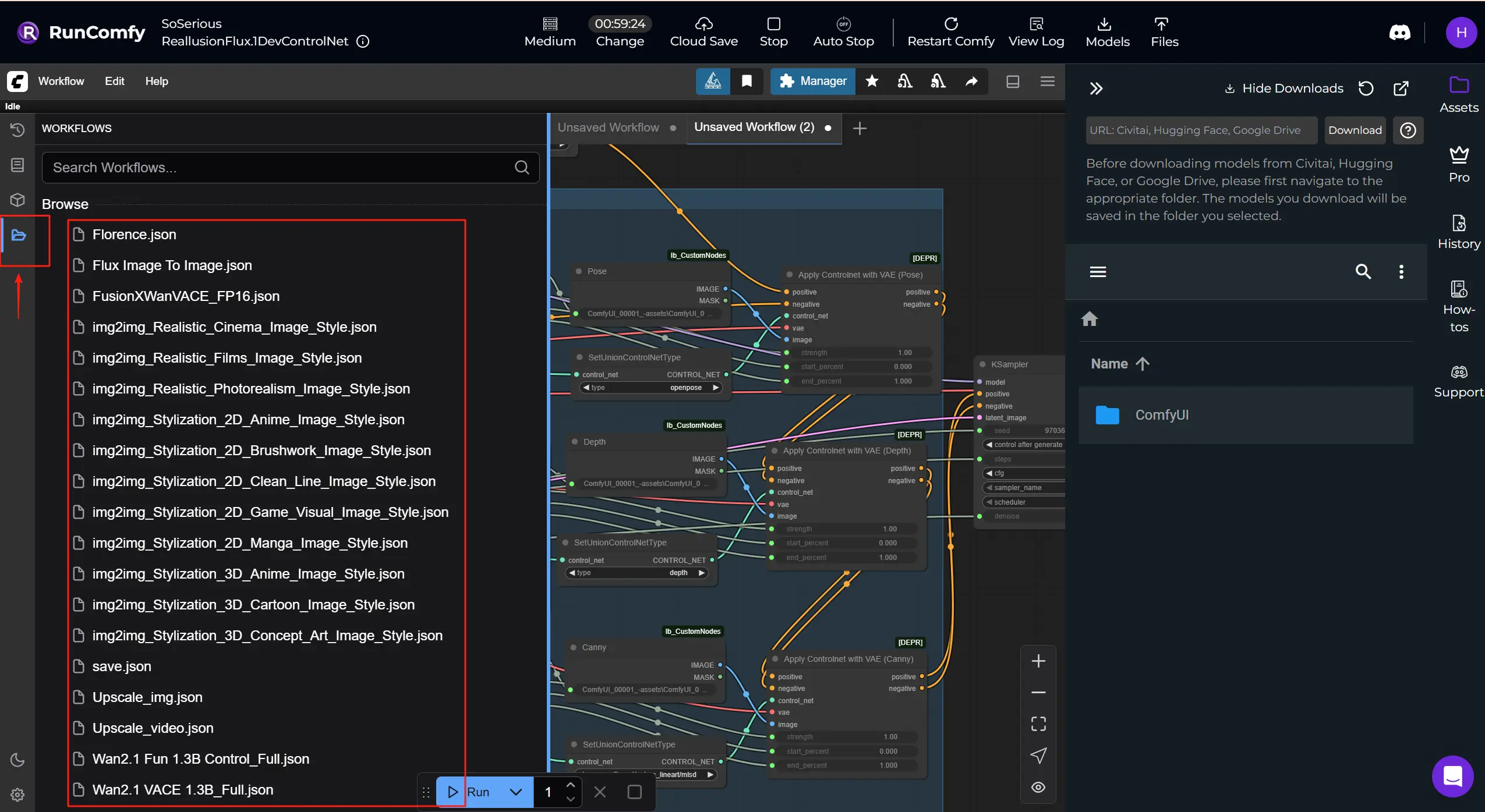

RunComfy's Cloud ist nicht auf FLUX.1-dev ControlNet für Reallusion AI Render beschränkt. Sie können Checkpoints, ControlNets, LoRAs, VAEs und verwandte Knoten austauschen, um zusätzliche Reallusion-Workflows und Modelle aus der folgenden Liste auszuführen.

Erhalten Sie mehr Reallusion ComfyUI Workflows: Holen Sie sich mehr Workflow-Vorlagen, die Sie herunterladen und in RunComfy ausführen können. Klicken Sie auf die Schaltfläche "Workflows" und probieren Sie mehr aus.

Reallusion ist ein Entwickler von Echtzeit-2D/3D-Charaktererstellungs- und Animationssoftware, bekannt für iClone und Character Creator, die in Film/TV, Spielen, Archviz, digitalen Zwillingen und AI-Simulationen eingesetzt werden.

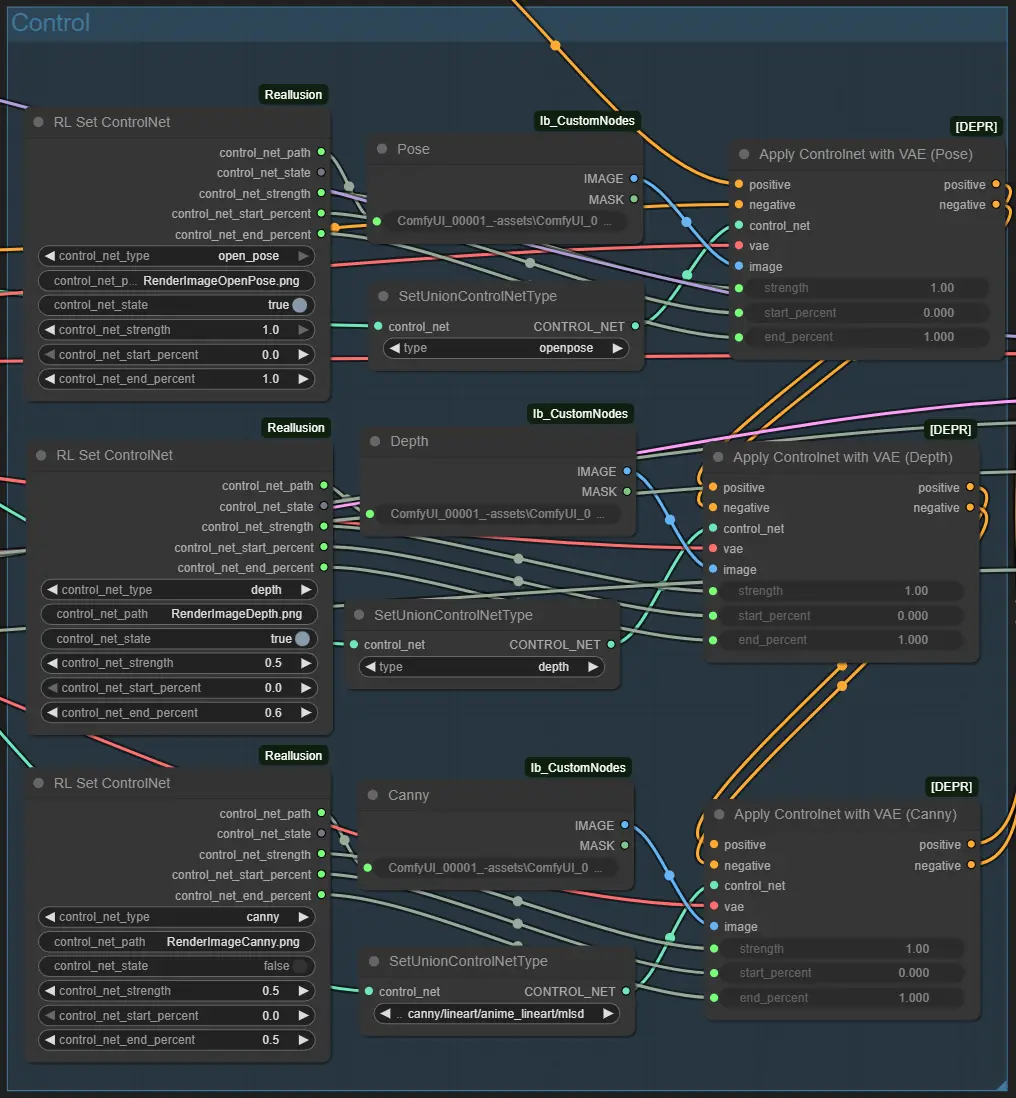

Reallusion AI Render ist eine nahtlose Brücke zwischen 3D-Animationssoftware und KI-gestützten Inhaltsgenerierungs-Workflows. Stellen Sie es sich als AI-Render-Assistenten vor, der Layout-, Pose-, Kamera- oder Beleuchtungsdaten direkt von iClone oder Character Creator empfängt und dann diesen Kontext verwendet, um reichhaltig detaillierte Bilder oder Videos in ComfyUI automatisch zu erstellen. Diese Integration vereint Reallusions Echtzeit-3D-Erstellungstools mit ComfyUIs flexiblem, knotenbasiertem KI-Verarbeitungsarchitektur, wodurch bild- und videobasierte Erzählungen sowohl künstlerisch gesteuert als auch eng von 3D-Daten geleitet werden. Reallusion AI Render unterstützt multimodale Eingaben wie Tiefenkarten, Normalenkarten, Kantenerkennung (Canny), 3D-Pose-Daten und Stilbilder über IPAdapter. Und dank seiner benutzerdefinierten Core-, ControlNet-, Additional Image- und Upscale-Knoten können Animatoren und Entwickler konsistente, stilisierte, hochwertige Ausgaben vollständig unter Plugin-Kontrolle rendern, ohne ComfyUI manuell navigieren zu müssen.

Indem strukturierte Anweisungen interpretiert und mit internen Parameter-Voreinstellungen kombiniert werden, verwandelt Reallusion AI Render die eingabebasierte Generierung in einen präzisen, reproduzierbaren Produktionsprozess. Es ist maßgeschneidert für Kreative in Film, Spielen oder kommerziellen Erzählungen, die konsistente Charaktere, feinkörnige Stilkontrolle und bildgenaue KI-unterstützte Sequenz-Rendering benötigen.

Direkte Plugin-Integration: Reallusion AI Render arbeitet nativ mit iClone und Character Creator über ein dediziertes Plugin, das Echtzeit-Feedback und -Steuerung ermöglicht, ohne Ihre Produktionstools zu verlassen.

3D-geführtes ControlNet: Übertragen Sie nahtlos Tiefen-, Pose-, Normalen- und Kantendaten direkt aus Ihrer 3D-Szene in ComfyUI mit den ControlNet-Knoten von Reallusion AI Render und erzielen Sie filmische Konsistenz und shot-genaue Kontrolle.

Unterstützung für Multi-Image-Styling: Der Reallusion AI Render Workflow umfasst Additional Image-Knoten, die flexibles Stil-Blending und richtungsbezogene Referenzen unterstützen, was es einfach macht, Looks wiederzuverwenden oder fortgeschrittenes IP-Adaptive-Rendering durchzuführen.

Intelligenter Upscale-Workflow: Ein dedizierter UpscaleData-Knoten ermöglicht es Kreativen, die Ausgaberesolution innerhalb des Reallusion AI Render Plugins zu definieren, wodurch sichergestellt wird, dass die finalen Renderings den Projektspezifikationen entsprechen, ohne raten zu müssen.

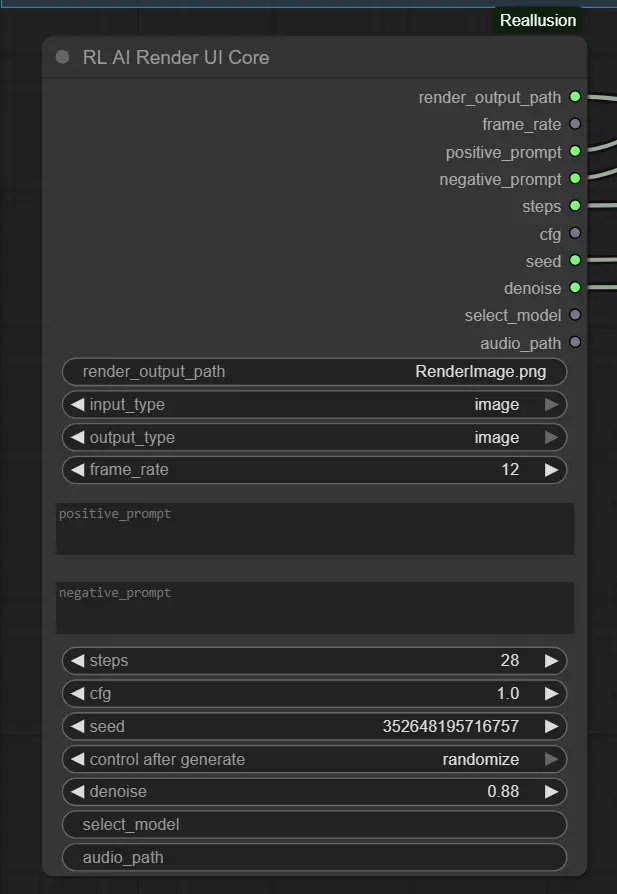

Vollständige Workflow-Automatisierung: Im Gegensatz zu generischen ComfyUI-Workflows ist Reallusion AI Render für die Automatisierung ausgelegt. Parameter wie Modell, Sampling-Schritte, CFG und Audiosynchronisierung werden programmatisch übergeben und sind bereit für Batch-Rendering oder benutzerdefinierte Voreinstellungen.

Produktionsfertige Charakterkonsistenz: In Kombination mit LoRA-Training und IP-Erstellungstools bewahrt Reallusion AI Render die Gesichtsintegrität und visuelle Treue über Videosequenzen hinweg, was es ideal für KI-gestützte Erzählungen macht.

Reallusion AI Render Basis-Workflow

1.Bereiten Sie Ihr Bild vor

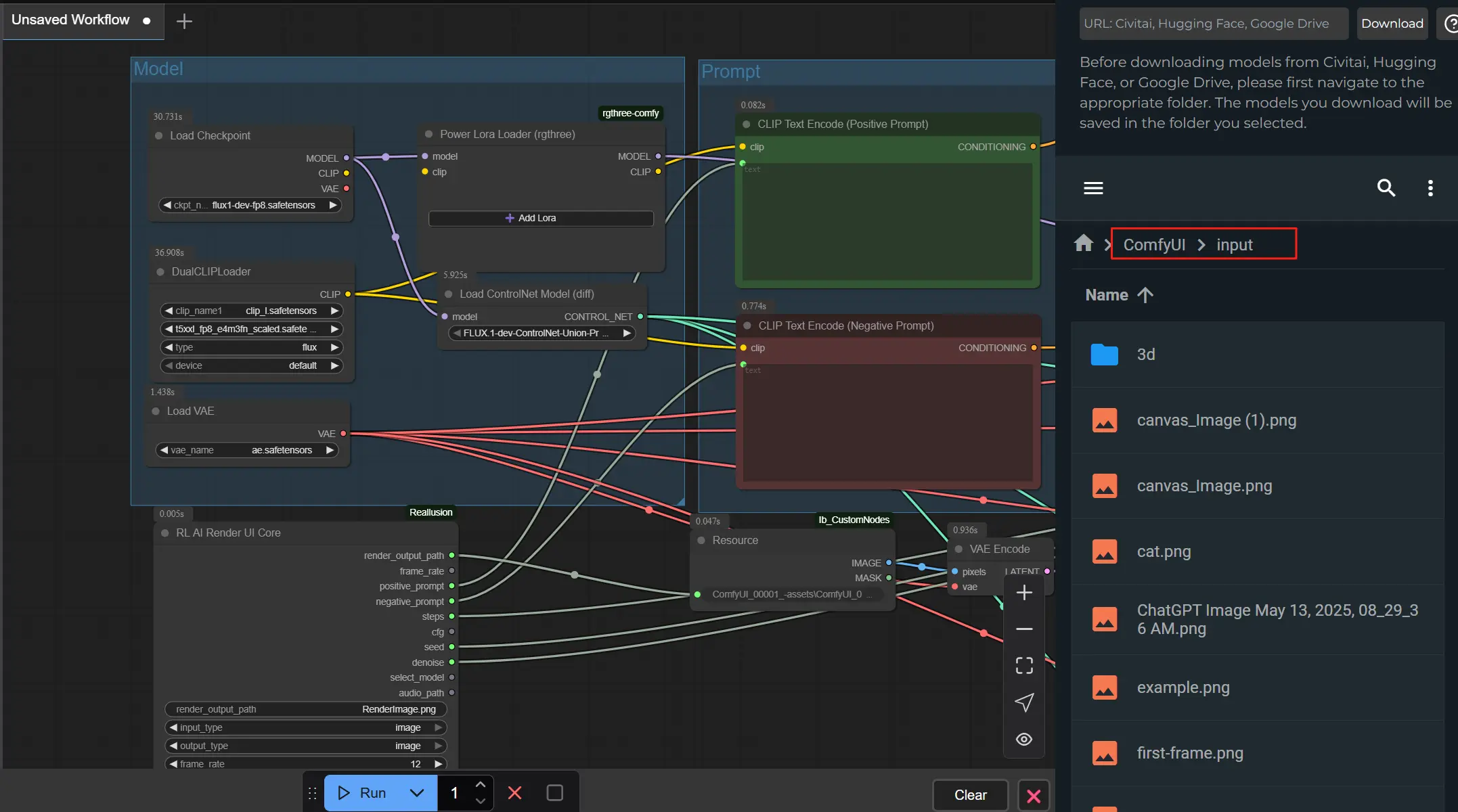

Exportieren Sie ein beliebiges Bild aus Reallusion iClone oder Character Creator mit ihrem AI Render Plugin. Stellen Sie sicher, dass das Bild unter Verwendung der Standard-Plugin-Pfadstruktur gespeichert wird. Dies stellt sicher, dass alle Leitbilder/Steuerbilder (z.B. Pose, Tiefe) automatisch generiert und korrekt verknüpft werden.

Laden Sie die Bilder in den ComfyUI -> input-Ordner hoch. Stellen Sie sicher, dass die Dateinamen mit dem im Node angegebenen render_output_path übereinstimmen.

2.Setzen Sie Eingabeaufforderungen und Stil

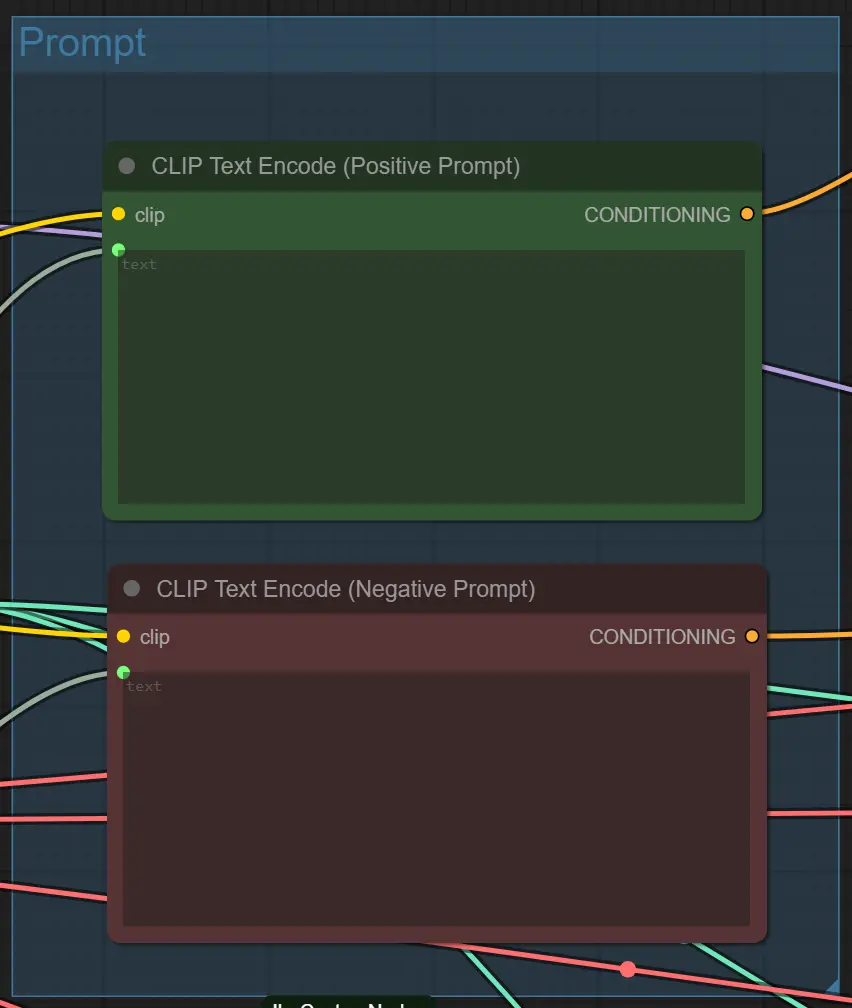

Schreiben Sie eine klare positive Eingabeaufforderung (was Sie wollen) und eine negative Eingabeaufforderung (was zu vermeiden ist) in die iClone oder Character Creator AI Render Plugin UI. Der Workflow wird diese verwenden, um das Aussehen und die Details des Outputs zu steuern.

3.Verbinden Sie die Maschine und verwenden Sie AI Render-⭐WICHTIG

Um zu beginnen, starten Sie das AI Render Plugin in iClone oder Character Creator und verbinden Sie ComfyUI Cloud mit AI Render, indem Sie die ID aus der RunComfy URL kopieren und einfügen. Sobald verbunden, sendet das Plugin automatisch Ihre Vorschau-Bilder oder -Videos aus der ComfyUI-Pipeline.

Diese Einrichtung stellt sicher, dass AI Render nahtlos mit Ihrer Maschine kommuniziert, sodass Sie Ergebnisse in Echtzeit überprüfen, anpassen und verfeinern können. Indem die Verbindung stabil gehalten wird, bleiben Ihre Pose-, Tiefen- und Stilrichtlinien über jeden Render hinweg genau.

👉 Sehen Sie sich die vollständige Schritt-für-Schritt-Videoanleitung hier an: YouTube Tutorial

Wichtige Einstellungen der Knoten

1. Eingabeaufforderung & Qualitätseinstellungen – RL AI Render UI Core Node Dieser Knoten sammelt die Hauptparameter aus dem AI Render Plugin.

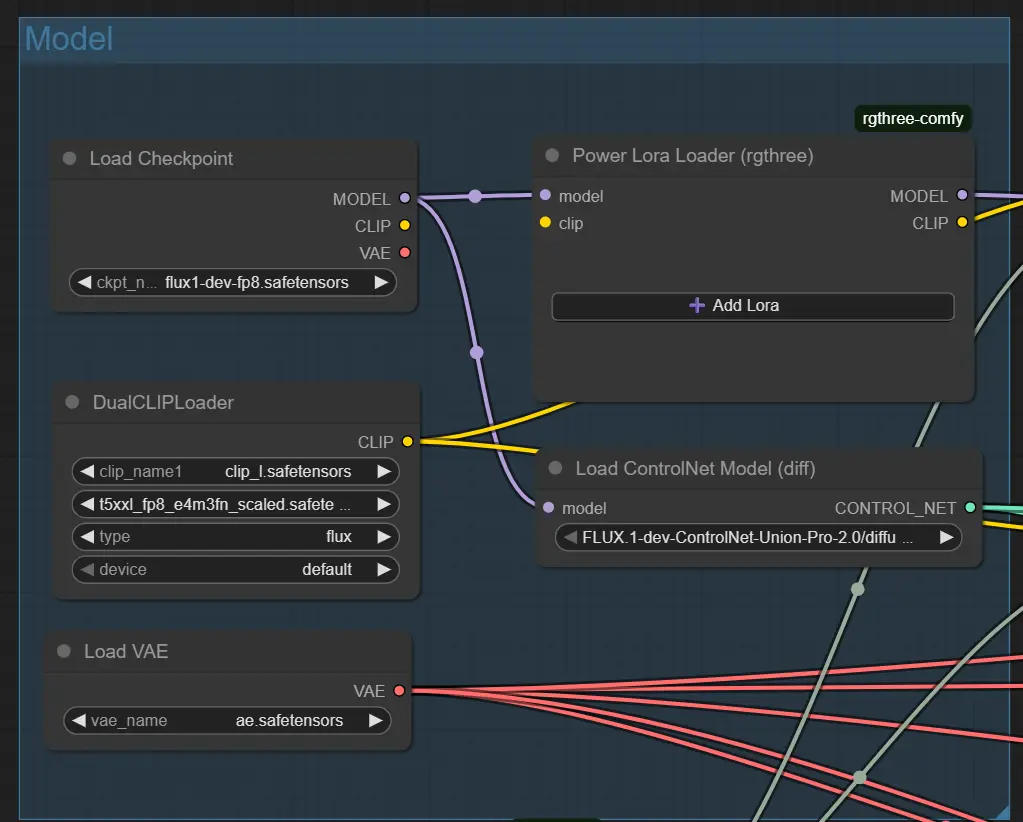

2. Basismodell-Einstellungen – Load Checkpoint Node

Lädt Ihr gewähltes Modell (z.B. Flux 1 Dev ControlNet).

ckpt_name: Muss dem Modell entsprechen, das von Ihrem Stil erwartet wird (Standard: flux1-dev-fp8.safetensors).

Verwenden Sie Modelle, die IPAdapter oder ControlNet unterstützen, für beste Ergebnisse.

3. Strukturleitfaden – ControlNet-Knoten (Pose, Tiefe, Canny) Jeder ControlNet-Knoten lädt eine spezifische Eingabedatei (z.B. Pose-Bild); nur aktiv, wenn Steuerung aktiviert ist.

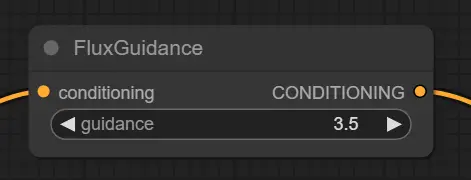

4. Eingabeaufforderungskonditionierung – Flux Guidance Node Passt an, wie die Eingabeaufforderung die Bildgenerierung formt.

5. Text-Eingabeaufforderungscodierung – CLIP Text Encode Nodes Erzeugt Vektorleitlinien aus Ihren Eingabeaufforderungen.

Erweiterte Tipps für Knoten

Klarheit der Eingabeaufforderung

Vermeiden Sie übermäßig komplexe oder vage Eingabeaufforderungen. Verwenden Sie direkte Stile wie cinematic lighting, anime oder cyberpunk alley. Seien Sie spezifisch für kontrolliertere Ergebnisse.

Balance von Denoise und Struktur Wenn ControlNet aktiviert ist (z.B. Tiefe + Pose), kann ein hoher Denoise-Wert wie 0.88 die Struktur stören. Versuchen Sie 0.6–0.75, wenn die Erhaltung des Layouts Priorität hat.

Abgleich von Eingaben mit ControlNet

Aktivieren Sie nur ein ControlNet, wenn ein passendes Leitbild existiert (z.B. RenderImageDepth.png für Tiefe). Eine Fehlanpassung kann zu fehlgeschlagenen Eingabeaufforderungen oder leeren Ergebnissen führen.

Dieser Workflow integriert das Flux-FP8-Modell, das von Kijai entwickelt wurde, mit Leistungsoptimierungstechniken, die vom Reallusion-Team in ihrem offiziellen AI-Rendering Workflow-Leitfaden beschrieben werden. Besonderer Dank gilt Kijai für ihren Beitrag zur Modellentwicklung und Reallusion für das Teilen wertvoller Erkenntnisse, die die Effizienz des AI-Renderings in ComfyUI-Workflows verbessern.

Erkunden Sie technische Ressourcen und Dokumentationen zu Reallusion AI Render.

RunComfy ist die führende ComfyUI Plattform, die ComfyUI online Umgebung und Services bietet, zusammen mit ComfyUI Workflows mit atemberaubenden Visualisierungen. RunComfy bietet auch AI-Spielplatz, Künstlern ermöglichen, die neuesten AI-Tools zu nutzen, um unglaubliche Kunst zu schaffen.