Hunyuan Video, ein Open-Source-AI-Modell entwickelt von Tencent, ermöglicht es Ihnen, atemberaubende und dynamische visuelle Inhalte mühelos zu erzeugen. Das Hunyuan-Modell nutzt fortschrittliche Architektur und Trainingstechniken, um Inhalte von hoher Qualität, Bewegungsvielfalt und Stabilität zu verstehen und zu generieren.

Über den Hunyuan Video zu Video Workflow

Dieser Hunyuan-Workflow in ComfyUI verwendet das Hunyuan-Modell, um neue visuelle Inhalte zu erstellen, indem Eingabetextprompts mit einem vorhandenen Ausgangsvideo kombiniert werden. Durch die Nutzung der Fähigkeiten des Hunyuan-Modells können Sie beeindruckende Videotransformationen erzeugen, die nahtlos die Bewegung und Schlüsselelemente des Ausgangsvideos integrieren und das Ergebnis mit Ihrem gewünschten Textprompt abstimmen.

So verwenden Sie den Hunyuan Video zu Video Workflow

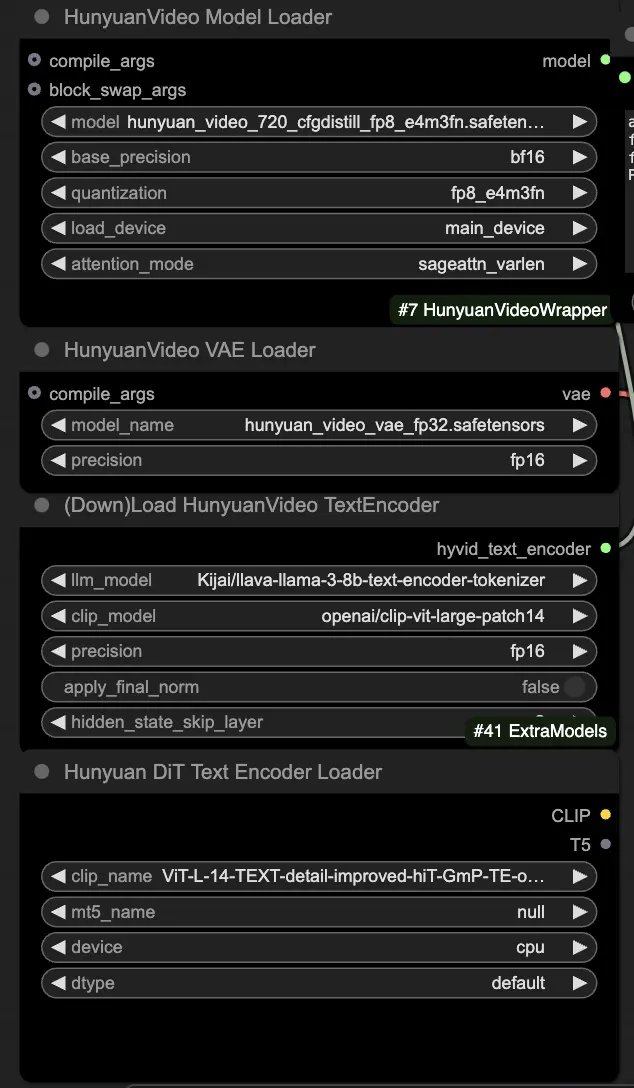

🟥 Schritt 1: Laden Sie Hunyuan-Modelle

- Laden Sie das Hunyuan-Modell, indem Sie die Datei "hunyuan_video_720_cfgdistill_fp8_e4m3fn.safetensors" im HyVideoModelLoader-Knoten auswählen. Dies ist das Haupttransformator-Modell.

- Das HunyuanVideo VAE-Modell wird automatisch im HunyuanVideoVAELoader-Knoten heruntergeladen. Es wird zum Codieren/Decodieren von Videoframes verwendet.

- Laden Sie einen Text-Encoder im DownloadAndLoadHyVideoTextEncoder-Knoten. Der Workflow verwendet standardmäßig den "Kijai/llava-llama-3-8b-text-encoder-tokenizer" LLM-Encoder und den "openai/clip-vit-large-patch14" CLIP-Encoder, die automatisch heruntergeladen werden. Sie können auch andere CLIP- oder T5-Encoder verwenden, die mit früheren Modellen funktioniert haben.

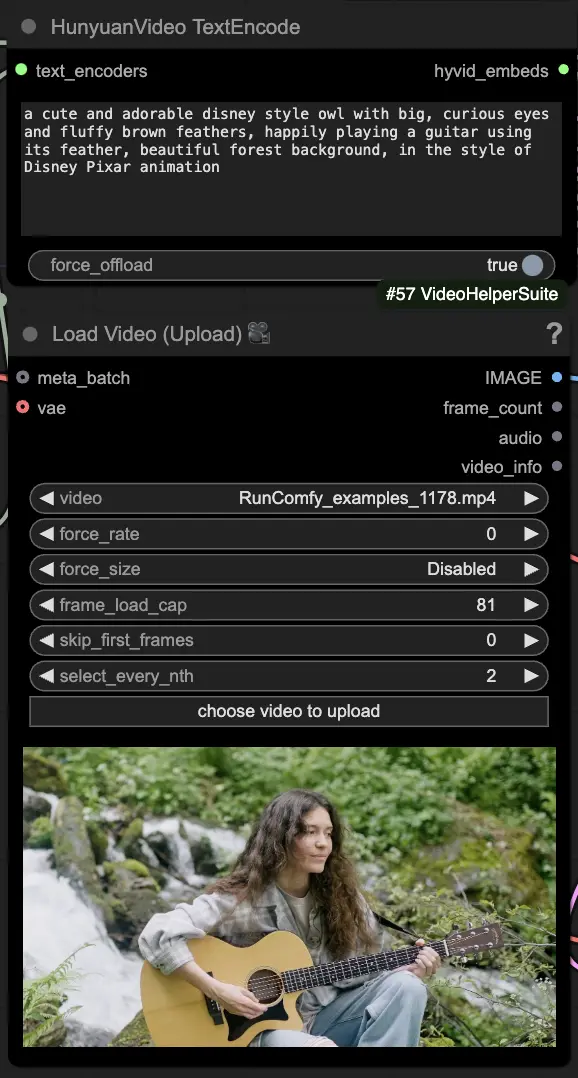

🟨 Schritt 2: Eingabeaufforderung eingeben & Ausgangsvideo laden

- Geben Sie Ihren Textprompt ein, der das visuelle beschreibt, das Sie im HyVideoTextEncode-Knoten erzeugen möchten.

- Laden Sie das Ausgangsvideo, das Sie als Bewegungsreferenz im VHS_LoadVideo-Knoten verwenden möchten.

- frame_load_cap: Anzahl der zu generierenden Frames. Beim Festlegen der Zahl müssen Sie sicherstellen, dass die Zahl minus eins durch 4 teilbar ist; andernfalls wird ein ValueError ausgelöst, der anzeigt, dass die Videolänge ungültig ist.

- skip_first_frames: Passen Sie diesen Parameter an, um zu steuern, welcher Teil des Videos verwendet wird.

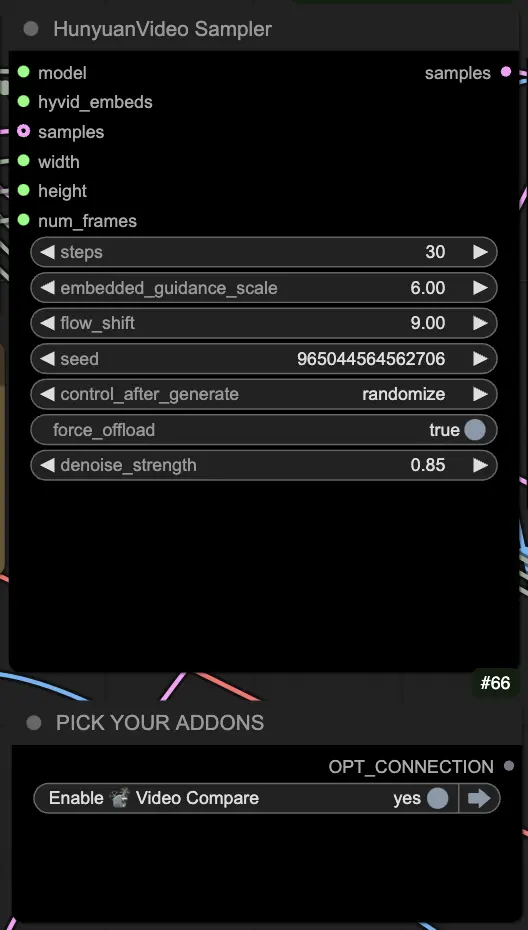

🟦 Schritt 3: Hunyuan-Generierungseinstellungen

- Konfigurieren Sie die Videoerzeugungs-Hyperparameter im HyVideoSampler-Knoten:

- Steps: Anzahl der Diffusionsschritte pro Frame, höhere bedeutet bessere Qualität, aber langsamere Erzeugung. Standard 30.

- Embedded_guidance_scale: Wie stark soll am Prompt festgehalten werden, höhere Werte halten sich näher am Prompt.

- Denoise_strength: Steuert die Stärke der Verwendung des ursprünglichen Ausgangsvideos. Niedrigere Werte (z.B. 0,6) lassen das Ergebnis mehr wie das Original aussehen.

- Wählen Sie Add-ons und Umschalter im "Fast Groups Bypasser"-Knoten, um zusätzliche Funktionen wie das Vergleichsvideo zu aktivieren/deaktivieren.

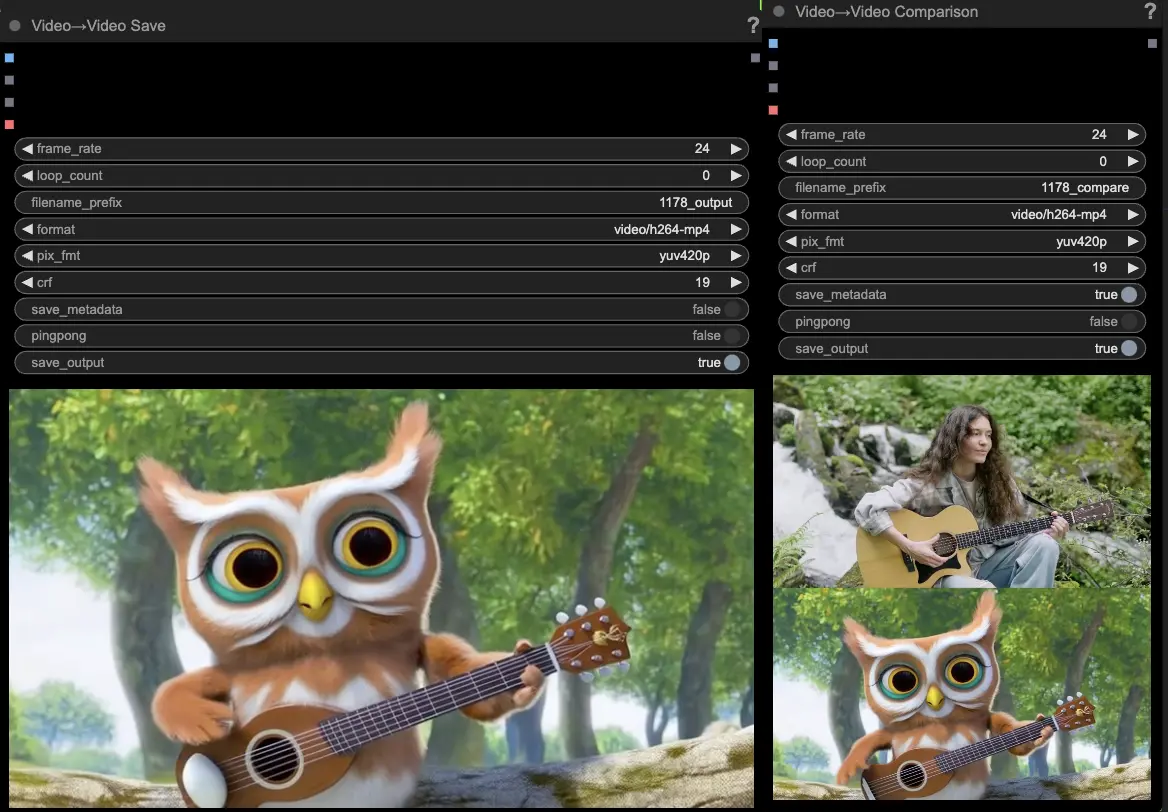

🟩 Schritt 4: Hunyuan-Video erzeugen

- Die VideoCombine-Knoten generieren und speichern standardmäßig zwei Ausgaben:

- Das übersetzte Videoergebnis

- Ein Vergleichsvideo, das das Ausgangsvideo und das erzeugte Ergebnis zeigt

Das Anpassen des Prompts und der Erzeugungseinstellungen ermöglicht beeindruckende Flexibilität bei der Erstellung neuer Videos, die durch die Bewegung eines bestehenden Videos mit dem Hunyuan-Modell angetrieben werden. Viel Spaß beim Erkunden der kreativen Möglichkeiten dieses Hunyuan-Workflows!

Dieser Hunyuan-Workflow wurde von Black Mixture entworfen. Bitte besuchen Sie Black Mixture's Youtube-Kanal für weitere Informationen. Ein besonderer Dank geht auch an Kijai für die Hunyuan-Wrappers Knoten und Workflow-Beispiele.