Segment Anything V2, auch bekannt als SAM2, ist ein bahnbrechendes AI-Modell, das die Objekterkennung in sowohl Bildern als auch Videos revolutioniert.

Was ist Segment Anything V2 (SAM2)?

Segment Anything V2 ist ein hochmodernes AI-Modell, das die nahtlose Segmentierung von Objekten in Bildern und Videos ermöglicht. Es ist das erste einheitliche Modell, das sowohl Bild- als auch Video-Segmentierungsaufgaben mit außergewöhnlicher Genauigkeit und Effizienz bewältigt. Segment Anything V2 (SAM2) baut auf dem Erfolg seines Vorgängers, dem Segment Anything Model (SAM), auf, indem es seine promptfähigen Fähigkeiten auf den Videobereich erweitert.

Mit Segment Anything V2 (SAM2) können Benutzer ein Objekt in einem Bild oder Video-Frame mit verschiedenen Eingabemethoden wie einem Klick, einem Begrenzungsrahmen oder einer Maske auswählen. Das Modell segmentiert dann intelligent das ausgewählte Objekt, sodass spezifische Elemente innerhalb des visuellen Inhalts präzise extrahiert und manipuliert werden können.

Höhepunkte von Segment Anything V2 (SAM2)

- Hochmoderne Leistung: SAM2 übertrifft bestehende Modelle im Bereich der Objekterkennung sowohl in Bildern als auch in Videos. Es setzt einen neuen Maßstab für Genauigkeit und Präzision und übertrifft die Leistung seines Vorgängers SAM bei Bildsegmentierungsaufgaben.

- Einheitliches Modell für Bilder und Videos: SAM2 ist das erste Modell, das eine einheitliche Lösung für die Segmentierung von Objekten in sowohl Bildern als auch Videos bietet. Diese Integration vereinfacht den Workflow für AI-Künstler, da sie ein einziges Modell für verschiedene Segmentierungsaufgaben verwenden können.

- Verbesserte Video-Segmentierungsfähigkeiten: SAM2 glänzt in der Video-Objekterkennung, insbesondere beim Verfolgen von Objektteilen. Es übertrifft bestehende Video-Segmentierungsmodelle und bietet verbesserte Genauigkeit und Konsistenz bei der Segmentierung von Objekten über mehrere Frames hinweg.

- Höhepunkte von Segment A. Reduzierte Interaktionszeit: Im Vergleich zu bestehenden interaktiven Video-Segmentierungsmethoden benötigt SAM2 weniger Interaktionszeit von Benutzern. Diese Effizienz ermöglicht es AI-Künstlern, sich mehr auf ihre kreative Vision zu konzentrieren und weniger Zeit mit manuellen Segmentierungsaufgaben zu verbringen.

- Einfaches Design und schnelle Inferenz: Trotz seiner fortschrittlichen Fähigkeiten behält SAM2 ein einfaches architektonisches Design bei und bietet schnelle Inferenzgeschwindigkeiten. Dies stellt sicher, dass AI-Künstler SAM2 nahtlos in ihre Workflows integrieren können, ohne Kompromisse bei Leistung oder Effizienz einzugehen.

Wie Segment Anything V2 (SAM2) funktioniert

SAM2 erweitert SAM's promptfähige Fähigkeit auf Videos, indem es ein per-Session-Speichermodul einführt, das Informationen über Zielobjekte erfasst und so die Verfolgung von Objekten über mehrere Frames hinweg ermöglicht, auch bei temporären Verschwindungen. Die Streaming-Architektur verarbeitet Video-Frames einzeln und verhält sich wie SAM für Bilder, wenn das Speichermodul leer ist. Dies ermöglicht eine Echtzeit-Videoverarbeitung und eine natürliche Generalisierung der Fähigkeiten von SAM. SAM2 unterstützt auch interaktive Maskenvorhersagekorrekturen basierend auf Benutzereingaben. Das Modell verwendet eine Transformer-Architektur mit Streaming-Speicher und wurde auf dem SA-V-Datensatz trainiert, dem größten Video-Segmentierungsdatensatz, der mit einem model-in-the-loop-Datenengine gesammelt wurde, die sowohl das Modell als auch die Daten durch Benutzerinteraktion verbessert.

Wie man Segment Anything V2 (SAM2) in ComfyUI verwendet

Dieser ComfyUI-Workflow unterstützt das Auswählen eines Objekts in einem Video-Frame mit einem Klick/Punkt.

1. Video laden (Hochladen)

Video laden: Wählen und laden Sie das Video hoch, das Sie verarbeiten möchten.

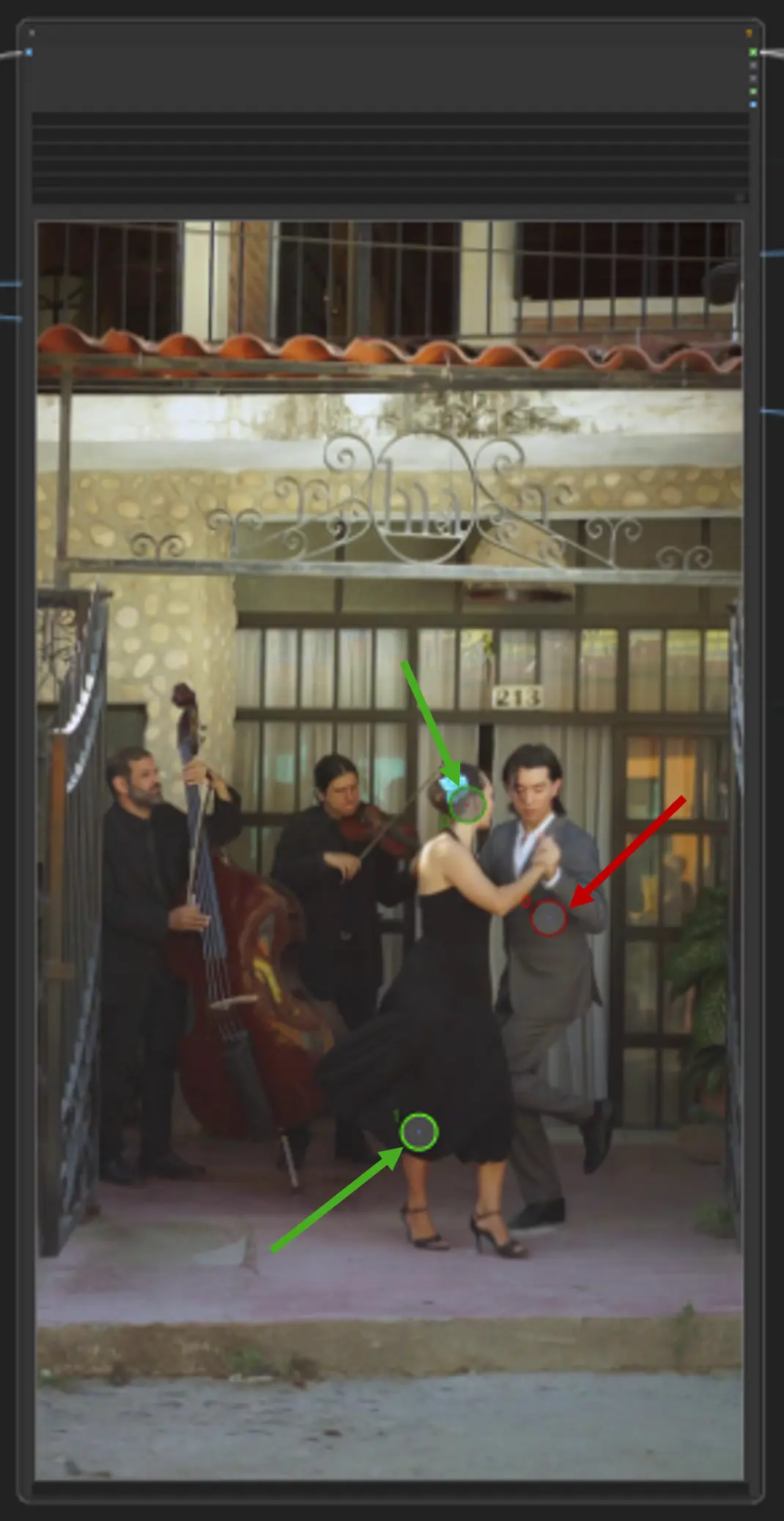

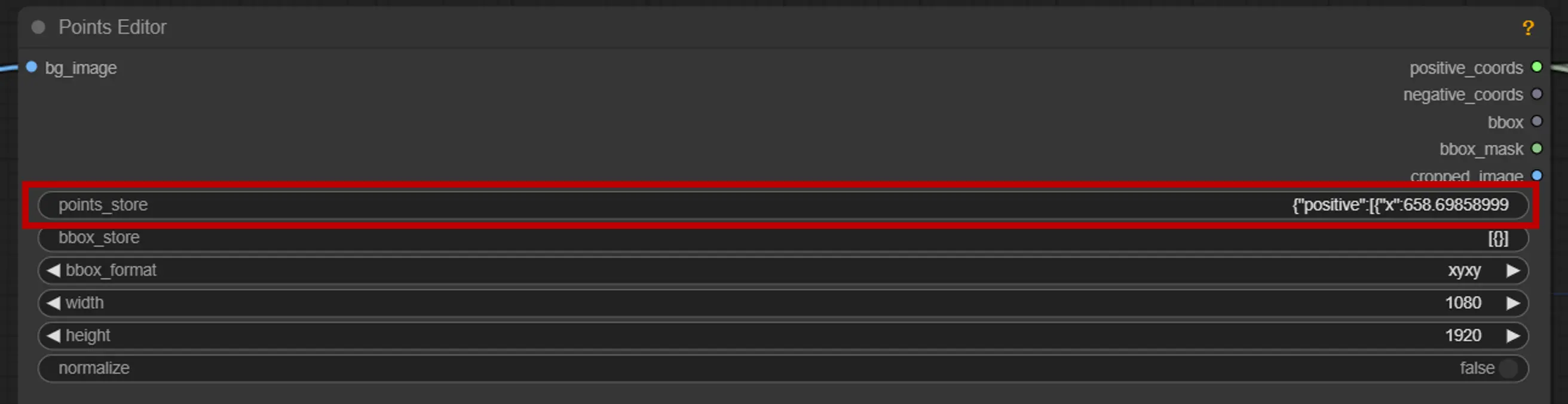

2. Punkte-Editor

Schlüsselpunkt: Setzen Sie drei Schlüsselpunkte auf die Leinwand—positive0, positive1 und negative0:

positive0 und positive1 markieren die Regionen oder Objekte, die Sie segmentieren möchten.

negative0 hilft, unerwünschte Bereiche oder Ablenkungen auszuschließen.

points_store: Ermöglicht das Hinzufügen oder Entfernen von Punkten nach Bedarf, um den Segmentierungsprozess zu verfeinern.

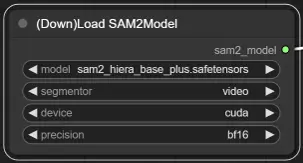

3. Modellauswahl von SAM2

Modelloptionen: Wählen Sie aus den verfügbaren SAM2-Modellen: tiny, small, large oder base_plus. Größere Modelle liefern bessere Ergebnisse, benötigen jedoch mehr Ladezeit.

Für weitere Informationen besuchen Sie bitte Kijai ComfyUI-segment-anything-2.