UNO ByteDance | Generación Consistente de Sujetos y Objetos

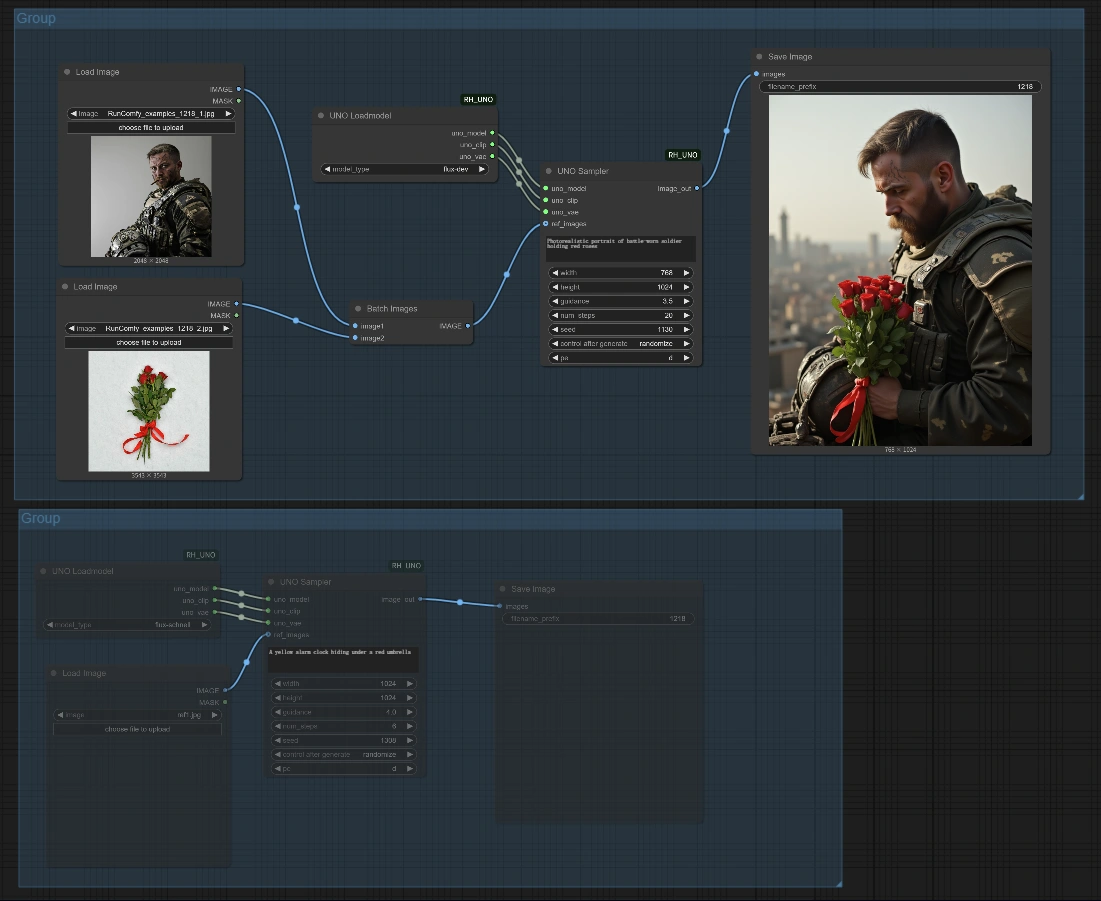

El flujo de trabajo de UNO para ComfyUI trae la tecnología avanzada de generación de imágenes de ByteDance a RunComfy. Este poderoso modelo sobresale en la creación de imágenes altamente consistentes cuando se proporcionan sujetos de referencia. Ya sea que necesites generación de un solo sujeto (un personaje en diferentes escenas) o composiciones de sujeto-objeto (combinando un sujeto con un objeto específico en una imagen), UNO ByteDance ofrece una fidelidad y calidad excepcionales. El modelo funciona efectivamente incluso en máquinas en la nube más pequeñas, haciendo que la personalización de imágenes UNO de ByteDance sea accesible para todos. Perfecto para visualizaciones de productos, ilustraciones de personajes, composiciones creativas y mucho más.ComfyUI UNO ByteDance Subject-Object Generation Flujo de trabajo

- Flujos de trabajo completamente operativos

- Sin nodos ni modelos faltantes

- No se requiere configuración manual

- Presenta visuales impresionantes

ComfyUI UNO ByteDance Subject-Object Generation Ejemplos

ComfyUI UNO ByteDance Subject-Object Generation Descripción

Descripción de ComfyUI UNO

1. ¿Qué es ComfyUI UNO de ByteDance?

El flujo de trabajo de ComfyUI UNO integra el modelo Universal y cOntrolable (UNO) de ByteDance en el entorno ComfyUI. Desarrollado por el Equipo de Creación Inteligente de ByteDance, UNO representa un avance significativo en la tecnología de generación de imágenes centrada en sujetos, basada en el innovador paradigma de generalización "Less-to-More". UNO permite una generación de imágenes flexible y de alta fidelidad mientras preserva las características de identidad de los sujetos de referencia con una consistencia notable a través de varios contextos y escenarios.

2. Beneficios de ComfyUI UNO de ByteDance:

- Consistencia Superior de Sujetos: UNO mantiene una similitud excepcional de sujetos en diferentes contextos.

- Control de Sujeto-Objeto: A diferencia de muchas alternativas, UNO sobresale en manejar referencias de sujetos y objetos simultáneamente sin confusión de identidad.

- Compatibilidad Universal: UNO funciona con diversos tipos de sujetos - personas, objetos, juguetes, logos, y más.

- Eficiencia de Recursos: UNO ofrece resultados de calidad profesional incluso con recursos limitados de VRAM (funciona bien con 24GB).

- Implementación Flexible: UNO incluye flujos de trabajo tanto para generación de sujeto único como de sujeto-objeto.

3. Cómo Usar ComfyUI UNO de ByteDance

3.1 Configuración del Flujo de Trabajo

El flujo de trabajo de UNO tiene dos configuraciones principales:

Grupo Superior - Generación de Sujeto-Objeto:

- Esta configuración te permite ingresar una imagen de sujeto de referencia y una imagen de objeto de referencia que se combinarán en una escena generada según tu texto de indicación.

Grupo Inferior - Generación de Sujeto Único:

- Esta configuración utiliza una sola imagen de referencia y genera nuevas imágenes de ese sujeto en diferentes contextos.

3.2 Proceso de Generación con UNO de ByteDance

Configuración Básica:

- Cargar Imágenes de Referencia:

- Para el flujo de trabajo de sujeto-objeto (grupo superior): Sube una imagen de referencia de sujeto y una imagen de referencia de objeto

- Para el flujo de trabajo de sujeto único (grupo inferior): Sube una imagen de referencia

- Configurar Texto de Indicación para UNO de ByteDance:

- Escribe una indicación descriptiva para tu escena deseada, incluyendo cómo debería aparecer el sujeto/objeto de referencia

- Ajustar Parámetros de UNO de ByteDance:

Width/Height: Determina la resolución de salida (se recomienda 768×1024 o 1024×1024)Guidance: Controla qué tan de cerca sigue la generación de UNO de ByteDance tu texto de indicación (se recomienda 3.5-4.0)Num_steps: Valores más altos (20+) producen resultados más consistentes con UNO de ByteDance, especialmente para rostros humanosSeed: Establece una semilla específica para reproducibilidad o aleatoriza para variedad en las salidas de UNO de ByteDance

- Generar Imagen con UNO de ByteDance:

- Haz clic en "Queue Prompt" para ejecutar el flujo de trabajo de UNO de ByteDance

- Revisa el resultado en el nodo "Save Image"

3.3 Referencia de Parámetros para UNO de ByteDance

Nodo UNO Loadmodel:

model_type: Determina qué variante del modelo UNO de ByteDance usarflux-dev: Modelo estándar de UNO de ByteDance con buen equilibrio de calidad y rendimientoflux-schnell: Variante más rápida del modelo UNO de ByteDance con calidad ligeramente inferior

3.4 Consejos para Mejores Resultados con UNO de ByteDance

Selección de Sujetos para UNO:

- Elige imágenes de referencia claras y bien iluminadas donde el sujeto sea prominente

- Para rostros/personas, las imágenes frontales con expresiones neutrales funcionan mejor con UNO de ByteDance

- Para objetos, las imágenes claras con mínima distracción de fondo son ideales para el procesamiento de UNO de ByteDance

Ingeniería de Indicaciones para UNO:

- Sé específico sobre las descripciones de sujetos que coincidan con tus imágenes de referencia

- Describe la escena deseada, iluminación y composición para que UNO de ByteDance genere

- Incluye referencia a los sujetos específicos (por ejemplo, "un hombre joven", "una bicicleta vintage")

- Mantén las indicaciones concisas pero detalladas para resultados óptimos de UNO de ByteDance

4. Información Técnica sobre UNO de ByteDance

La tecnología UNO de ByteDance está construida sobre modelos FLUX y aprovecha la arquitectura DiT (Diffusion Transformer) con varias mejoras clave:

- Universal Rotary Position Embedding (UnoPE): Un mecanismo especializado en UNO de ByteDance que ayuda al modelo a diferenciar entre sujetos y objetos de referencia, reduciendo significativamente la confusión de atributos.

- Alineación Progresiva Multimodal: Metodología de entrenamiento que permite a UNO de ByteDance manejar controles multicondición cada vez más complejos.

- Personalización Universal: UNO de ByteDance es capaz de manejar diversos tipos de sujetos sin entrenamiento especializado.

5. Reconocimientos

Este flujo de trabajo está impulsado por UNO, desarrollado por el Equipo de Creación Inteligente de ByteDance (Shaojin Wu, Mengqi Huang, Wenxu Wu, Yufeng Cheng, Fei Ding, y Qian He). La integración de ComfyUI de UNO de ByteDance es proporcionada por colaboradores de la comunidad, adaptando la innovadora investigación de ByteDance en un flujo de trabajo accesible.

Para información adicional sobre UNO de ByteDance, visita el .