Se você treinou uma LoRA com o Ostris AI Toolkit (para FLUX / FLUX.2, Wan 2.2/2.1, Qwen Image, Z‑Image, LTX‑2, SDXL, etc.), provavelmente já viu isso: os training samples do AI Toolkit ficam ótimos, mas ao fazer inferência em Diffusers / ComfyUI / outro stack, o resultado deriva.

Este guia mostra um caminho rápido e confiável para obter inferência que bate com os previews de treino do AI Toolkit, para que o que você entrega se pareça com o que você treinou.

Por que os previews do AI Toolkit não costumam bater com a inferência

Os “Samples” do AI Toolkit são gerados com um setup de inferência específico:

- variante exata do modelo base

- semântica de scheduler/steps específica do modelo

- modo de aplicar LoRA específico do modelo (adapter vs fuse/merge)

- regras de snapping de resolução (múltiplos de largura/altura)

- inputs exigidos por certas pipelines (ex.: control image em edit / I2V)

Se o seu stack de inferência muda qualquer um desses pontos, mesmo com o mesmo prompt + seed, o output pode mudar. Em resumo: para bater com o preview, você precisa bater com o pipeline inteiro, não só com alguns settings.

Por que a RunComfy consegue fazer a inferência bater com seus training samples

A RunComfy roda um pipeline Diffusers específico por modelo base, alinhado ao pipeline usado pelo AI Toolkit para gerar os previews daquele modelo. Em seguida, ela lê o seu Training config file (YAML) para travar a mesma variante do base model e os defaults críticos de inferência, permitindo que Run LoRA inference bata 1:1 com seus training samples. Como tudo roda em um runtime cloud gerenciado, você também evita drift silencioso de versões CUDA/PyTorch/Diffusers que...

Exemplo do nosso teste de paridade:

| AI Toolkit training sample | RunComfy inference (Playground/API) | ||

|---|---|---|---|

|

|

|

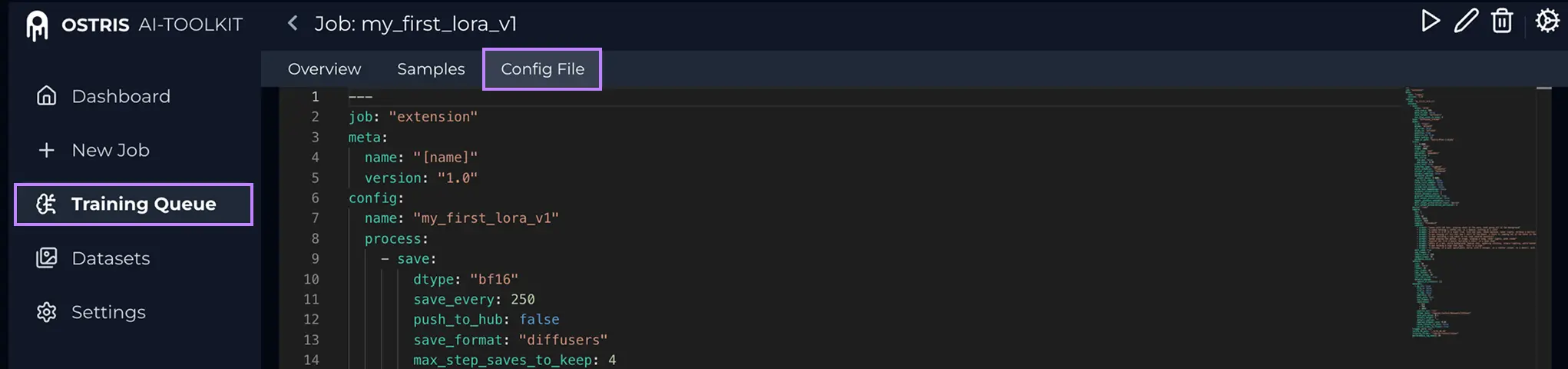

Step 0 — Prepare dois arquivos do seu job AI ToolkitVocê normalmente precisa: 1) LoRA weights: 2) Training config file (YAML) (geralmente O que é o Config File (YAML)? No AI Toolkit, abra seu Training Job e clique em Config File para ver o YAML exato. Copie tudo e salve como .yaml para fazer upload aqui.

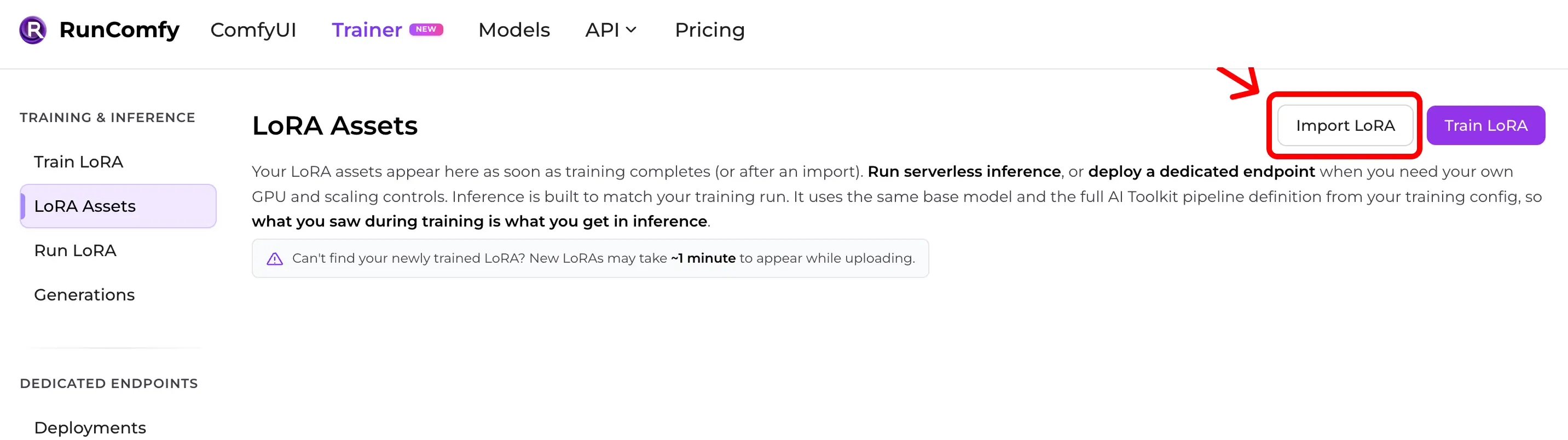

Por que o YAML importa: ele permite à RunComfy bater o base model exato e os defaults de inferência que geraram seus samples. Step 1 — Importe sua LoRA do AI Toolkit para a RunComfyCaminho: Trainer → LoRA Assets → Import LoRA Faça upload:

Sem YAML, você pode importar escolhendo o Base Model, mas a paridade pode piorar se os defaults forem diferentes.

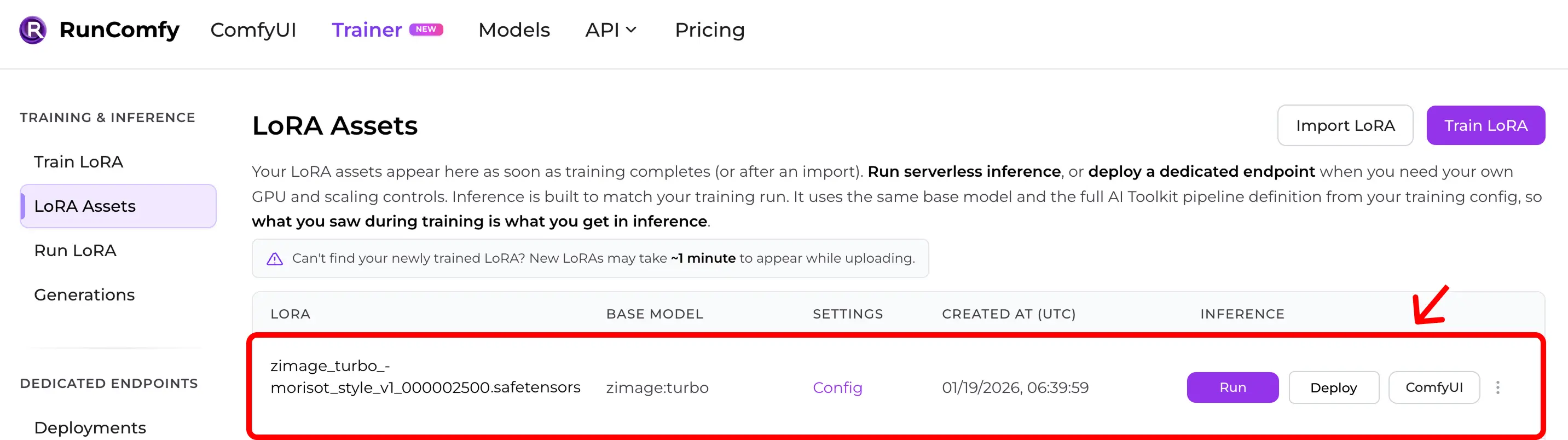

Step 2 — Confirme que aparece em LoRA AssetsApós o import (ou após um treino cloud terminar), a LoRA aparece em LoRA Assets. De lá, clique Run (Run LoRA) para iniciar inferência (Playground + API).

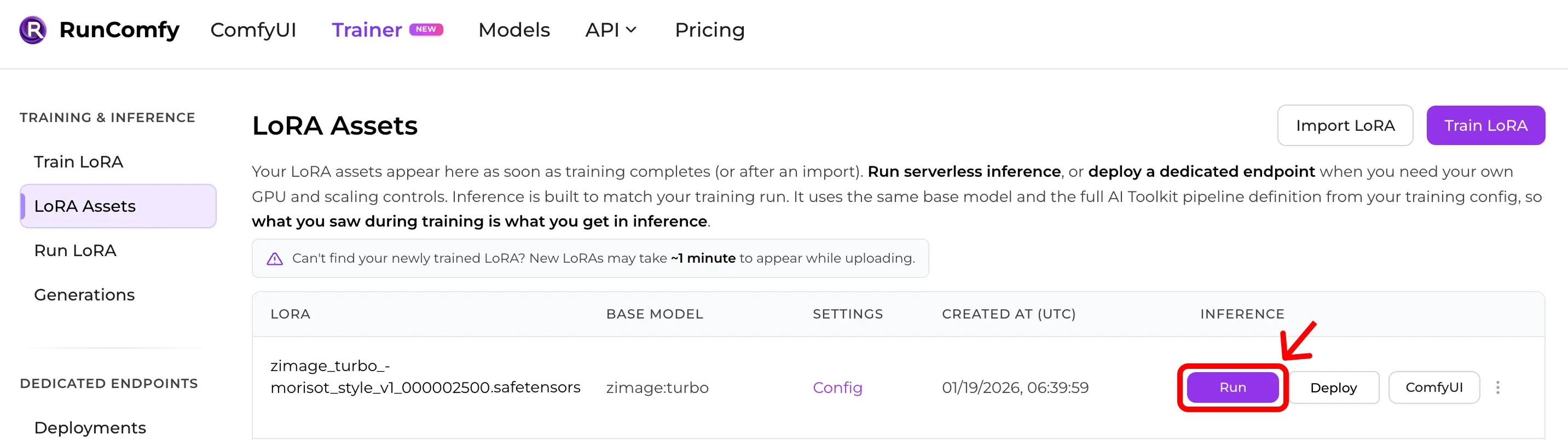

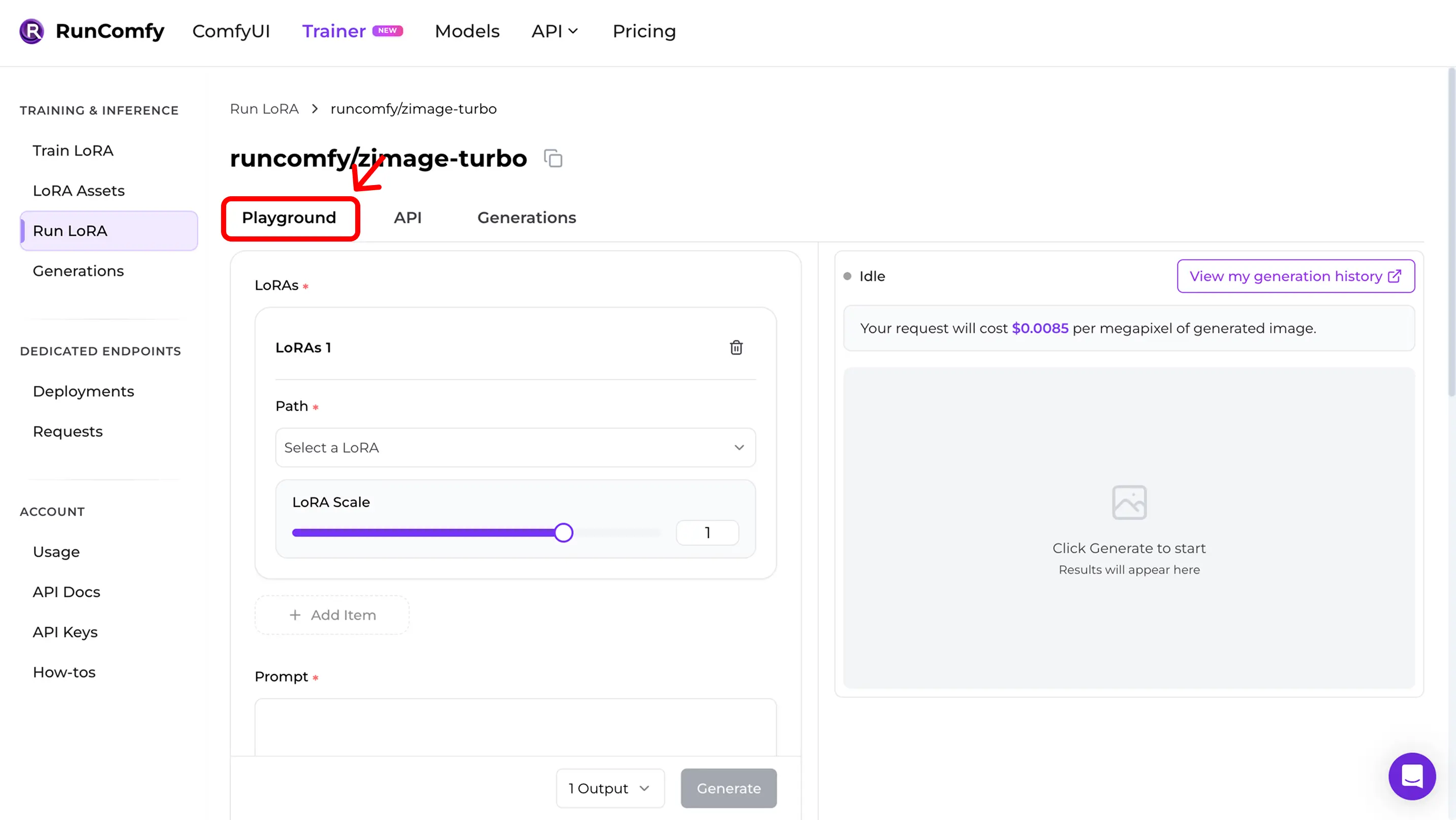

Step 3 — Rode inferência instantaneamente (Run LoRA)Em LoRA Assets, encontre a LoRA e clique Run. Isso inicia Run LoRA: inferência on‑demand que usa o mesmo base model e a mesma definição de pipeline do YAML, para bater com o preview sem reconstruir tudo manualmente. Você pode testar no Playground ou usar a mesma configuração via API.

Step 4 — Reproduza training samples no PlaygroundDepois de Run, você vai para o Run LoRA Playground. Valide a paridade:

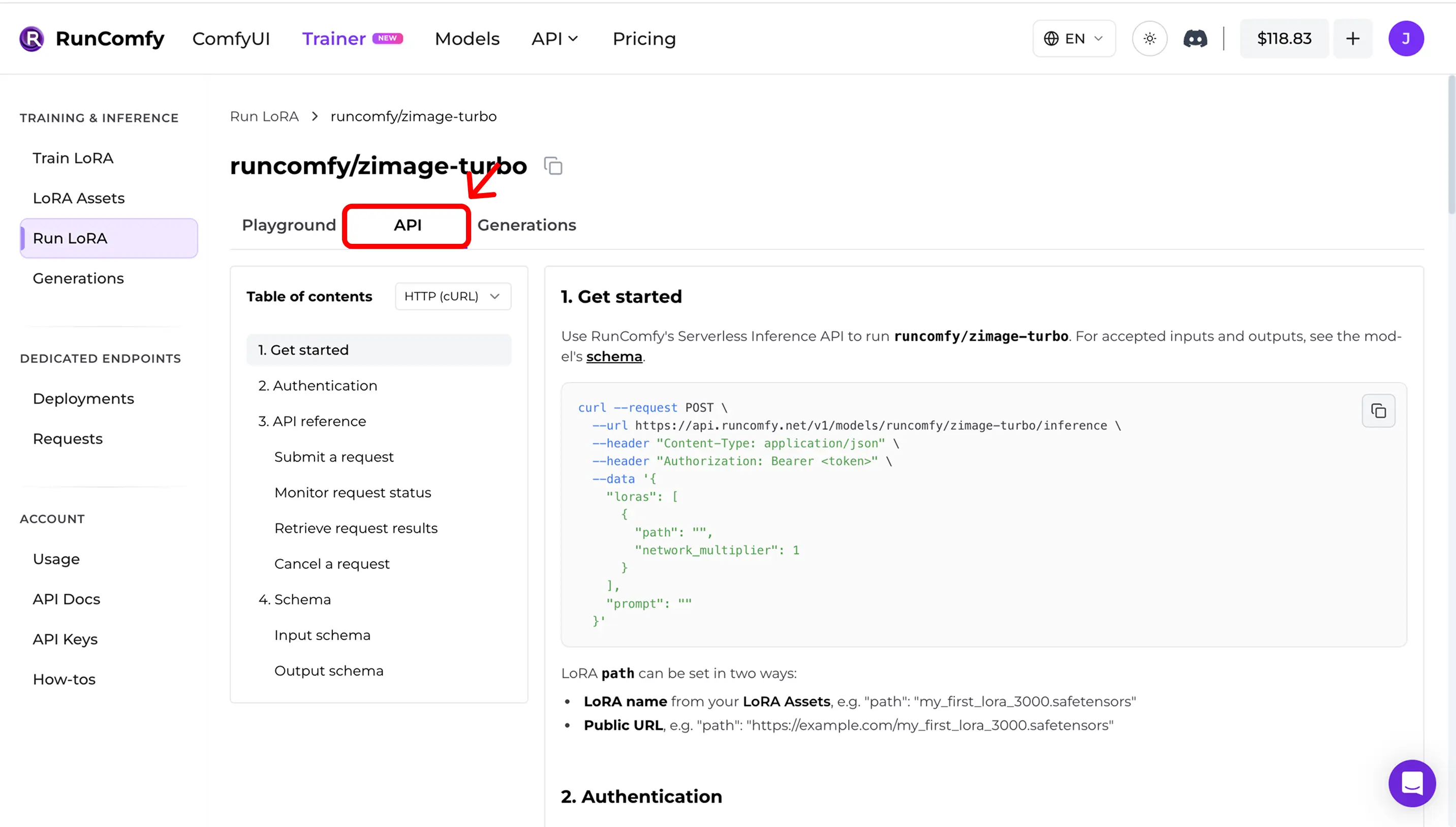

Step 5 — Use a API em produção (async inference)No Run LoRA, abra a aba API. A API é assíncrona:

Copie URLs e o request schema do dashboard. Exemplo (ilustrativo — use API docs: RunComfy Model API (see also LoRA inputs (Trainer)) Quick mismatch checklistSe não bate, confira: 1) Exact base model (repo + variant) 2) Width/height after snapping para o divisor do modelo 3) Steps + guidance + scheduler semantics 4) LoRA application mode (adapter vs fuse/merge) 5) Para edit / I2V: corretos control image inputs 6) Runtime drift (Diffusers / ComfyUI versions) Implementação open source de referênciaQuer inferência no ComfyUI e resultados coerentes com training samples / previews? Veja: AI Toolkit LoRA in ComfyUI: Parity Workflows Para auditar/self‑host: Open-source AI Toolkit inference code → runcomfy-com/ai-toolkit-inference FAQPreciso do YAML para importar?É fortemente recomendado. Sem YAML dá para escolher o base model manualmente, mas você perde o matching automático de defaults específicos do modelo. Posso importar uma LoRA treinada fora da RunComfy?Sim. Se foi treinada com AI Toolkit, importe O que significa “Run LoRA” aqui?Run LoRA é inferência on‑demand (Playground + API) que roda uma LoRA no seu base model sem deployar um endpoint dedicado. Cobrança por request. Ready to start training? |