Ostris AI Toolkit で LoRA を学習(FLUX / FLUX.2、Wan 2.2/2.1、Qwen Image、Z‑Image、LTX‑2、SDXL など)していると、よくこうなります:AI Toolkit の training samples は良いのに、Diffusers / ComfyUI / 別のスタックで推論すると結果が ドリフトする。

このガイドでは、AI Toolkit の学習プレビュー(samples)に一致する推論を、素早く・安定して得る方法を説明します。

なぜ AI Toolkit のプレビューが推論と一致しないのか

AI Toolkit の “Samples” は、特定の推論セットアップで生成されます:

- ベースモデルの正確なバリアント

- モデル固有の scheduler / steps の意味

- モデル固有の LoRA 適用(adapter vs fuse/merge)

- 解像度スナップ(幅/高さの倍数ルール)

- 一部パイプラインで必要な入力(例:edit / I2V の control image)

推論側がこれらのどれかを変えると、同じ prompt + seed でも結果がズレます。つまり、プレビューに合わせるには 推論パイプライン全体 を合わせる必要があります。

RunComfy で training samples と推論を一致させられる理由

RunComfy は、AI Toolkit がそのモデルのプレビュー生成に使うものと一致する ベースモデル別の Diffusers 推論パイプラインを実行します。さらに Training config file (YAML) を読み取り、同じベースモデルバリアントと推論デフォルトを固定するため、Run LoRA inference は training samples と 1:1 に近い一致を狙えます。加えて推論は 管理されたクラウドランタイムで行われるので、CUDA/PyTorch/Diffusers のバージョン差による “...

パリティ実験の例(AI Toolkit training samples vs Run LoRA inference、同一設定):

| AI Toolkit training sample | RunComfy inference (Playground/API) | ||

|---|---|---|---|

|

|

|

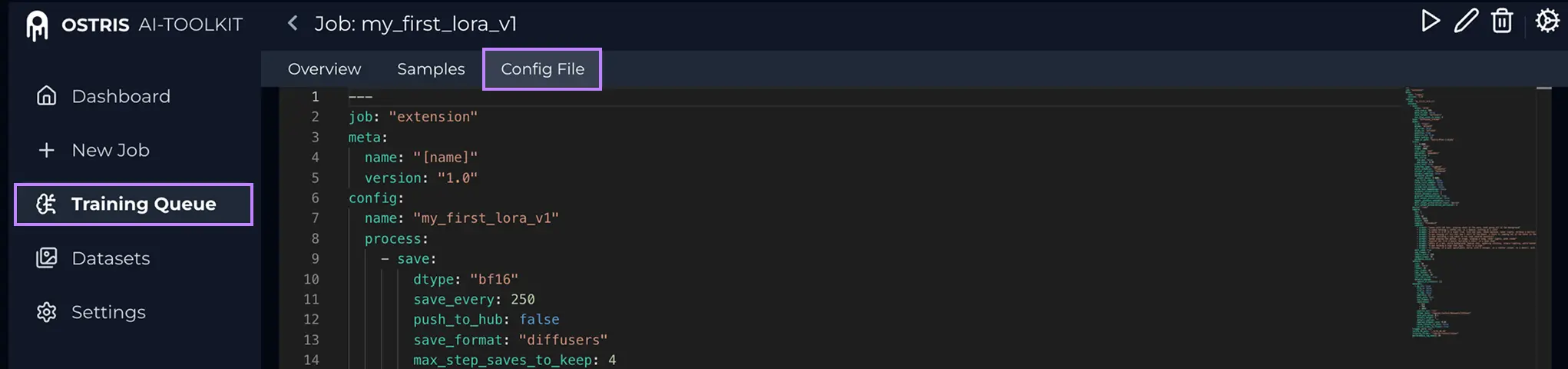

Step 0 — AI Toolkit job から 2 つのファイルを用意通常必要: 1) LoRA weights: 2) Training config file (YAML)( Config File (YAML) とは? AI Toolkit の Training Job を開き、上部の Config File から YAML を確認します。内容をすべてコピーし、.yaml として保存してからアップロードしてください。

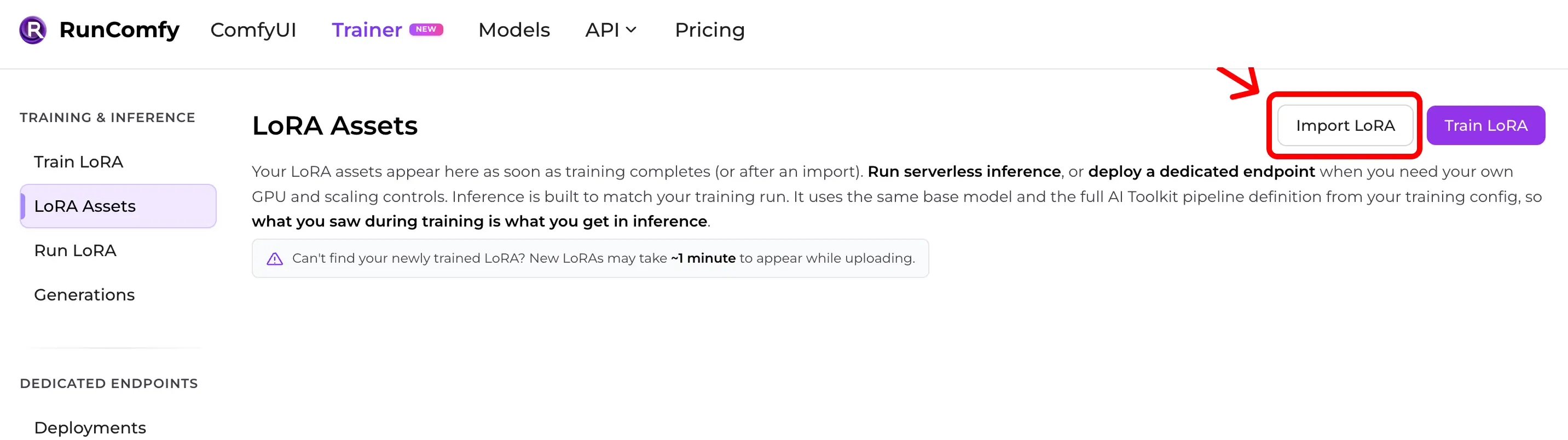

YAML が重要な理由:training samples を生成した ベースモデルと推論デフォルトを RunComfy が再現できるためです。 Step 1 — AI Toolkit LoRA を RunComfy にインポート経路:Trainer → LoRA Assets → Import LoRA アップロード:

YAML がない場合も Base Model を選んでインポートできますが、defaults がズレるとパリティが崩れやすくなります。

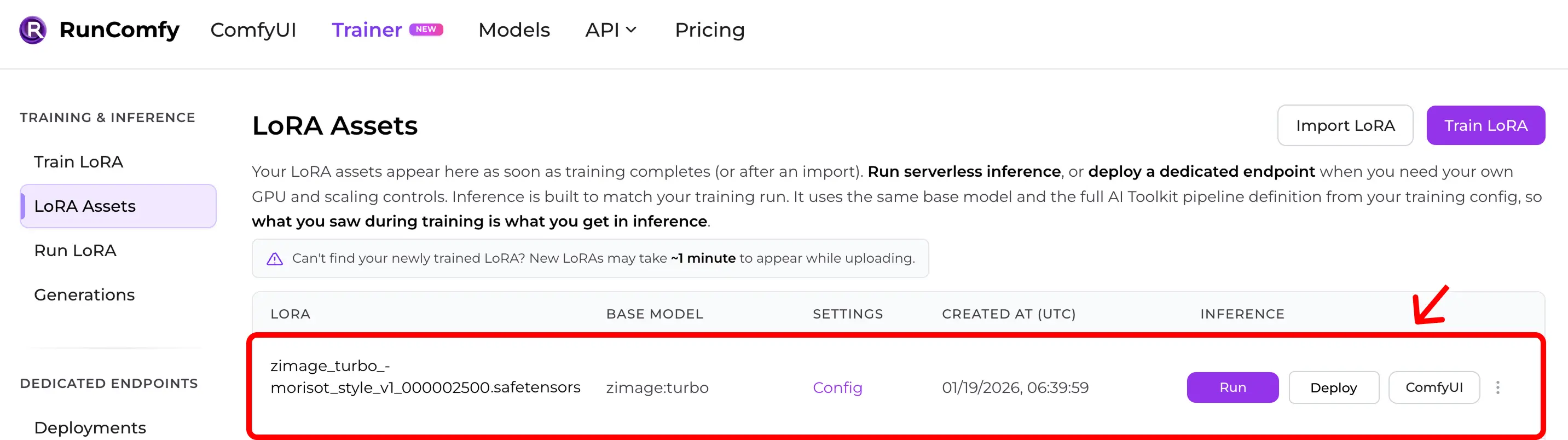

Step 2 — LoRA Assets に表示されることを確認インポート後(またはクラウド学習完了後)、LoRA は LoRA Assets に表示されます。 ここから Run (Run LoRA) で推論(Playground + API)を開始できます。

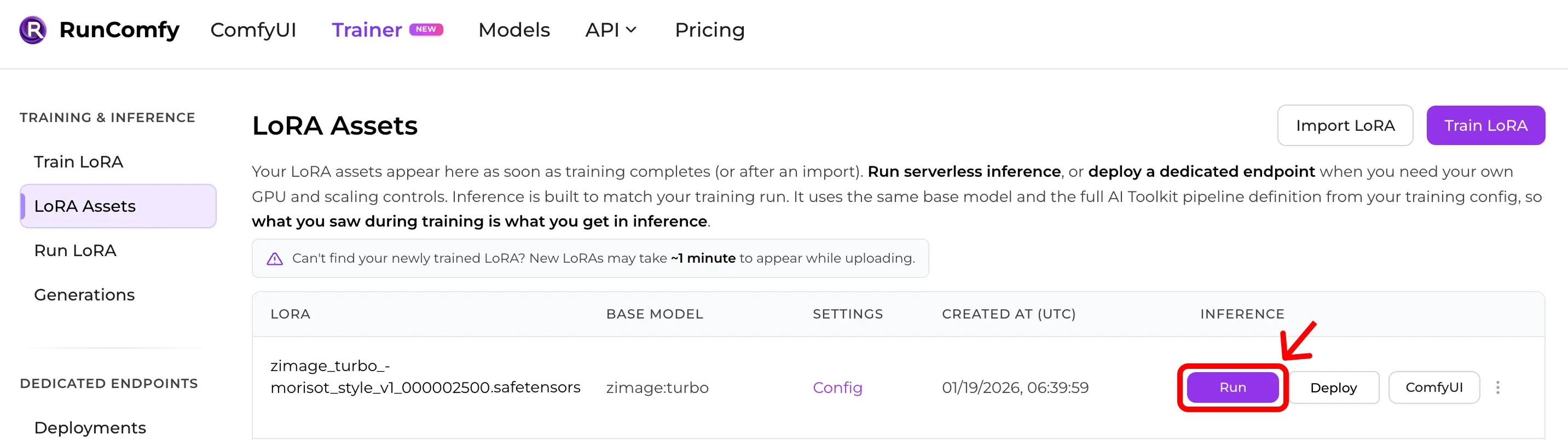

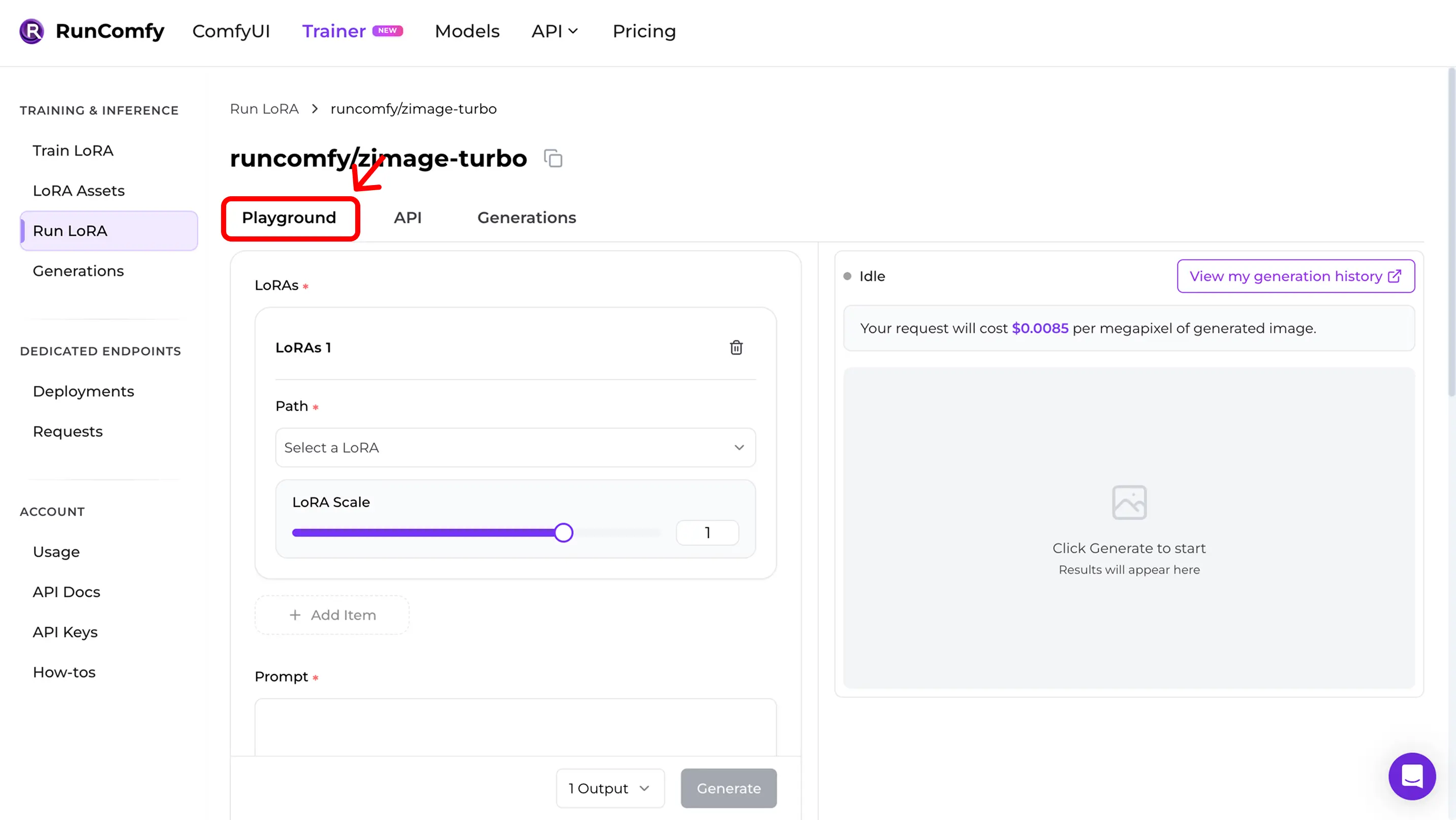

Step 3 — Run LoRA で即推論LoRA Assets で対象 LoRA を見つけて Run をクリック。 Run LoRA は、同じ base model と training YAML の pipeline 定義を使う on‑demand 推論です。手作業で再構築せずに preview‑parity を狙えます。 Playground で即テストも、API 統合も可能です。

Step 4 — Playground で training samples を再現Run 後は Run LoRA Playground に入ります。 ここで paritiy を確認:

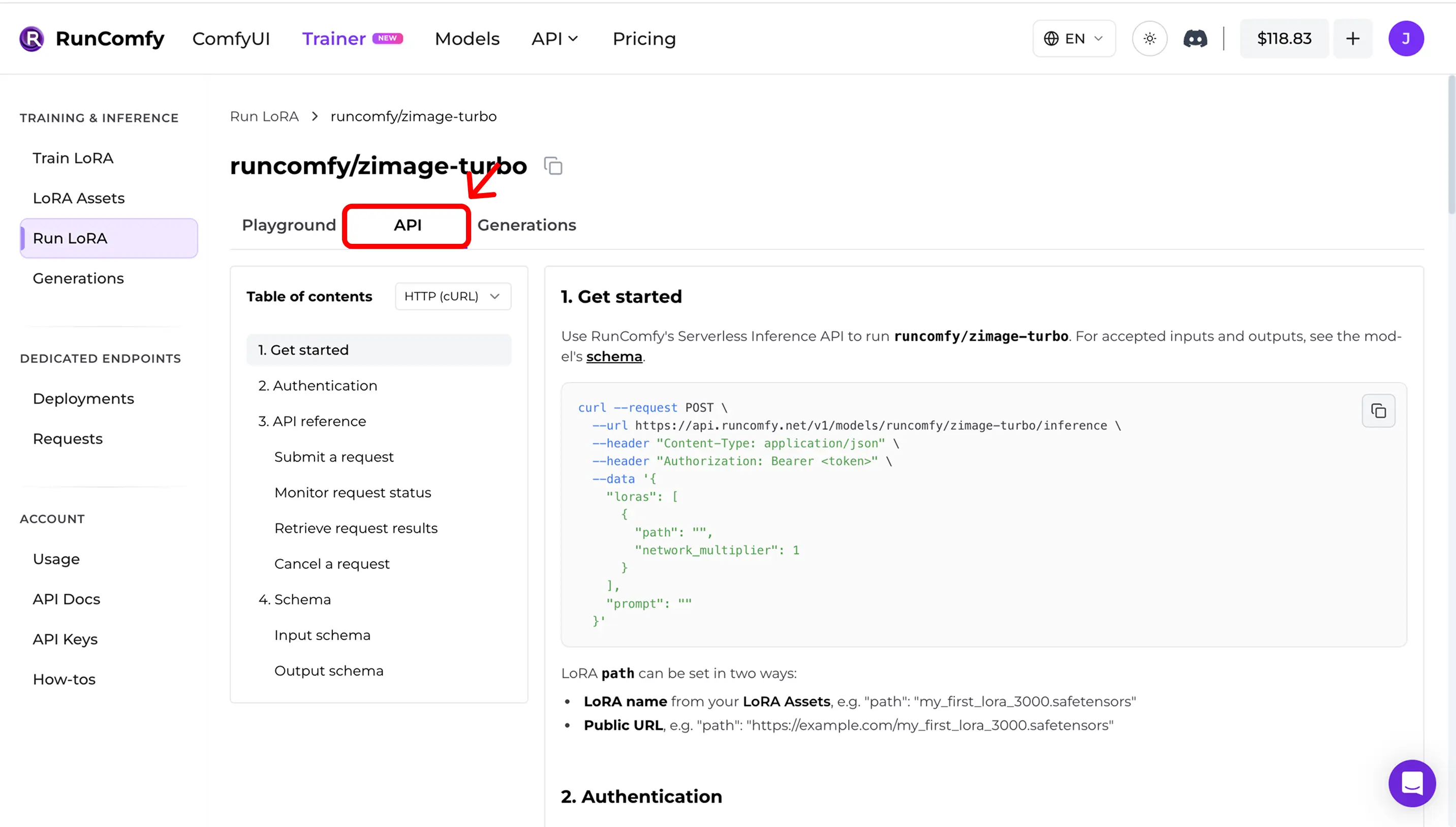

Step 5 — 本番で API を使う(async inference)Run LoRA の API タブを開きます。API は非同期:

ダッシュボードから URL と request schema をコピーしてください。 例(説明用): API docs: RunComfy Model API (see also LoRA inputs (Trainer)) Quick mismatch checklist一致しないときは次を確認: 1) Exact base model (repo + variant) 2) Width/height after snapping to the model’s divisor 3) Steps + guidance + scheduler semantics 4) LoRA application mode (adapter vs fuse/merge) 5) For edit / I2V: correct control image inputs 6) Runtime drift (Diffusers / ComfyUI versions) Open-source reference implementationComfyUI で推論しつつ training samples / previews に合わせたい? こちら: AI Toolkit LoRA in ComfyUI: Parity Workflows 監査/セルフホスト用: Open-source AI Toolkit inference code → runcomfy-com/ai-toolkit-inference FAQインポートに YAML は必須?強く推奨です。YAML がないと base model を手動選択できますが、モデル固有 defaults の一致が崩れやすくなります。 RunComfy 以外で学習した LoRA もインポートできる?はい。AI Toolkit で学習したなら “Run LoRA” とは?専用エンドポイントをデプロイせずに、LoRA を base model 上で動かす on‑demand 推論(Playground + API)です。課金はリクエスト単位です。 トレーニングを開始する準備はできましたか? |