Crea immagini realistiche dai tuoi testi con Wan 2.2 Flash.

Crea immagini realistiche dai tuoi testi con Wan 2.2 Flash.

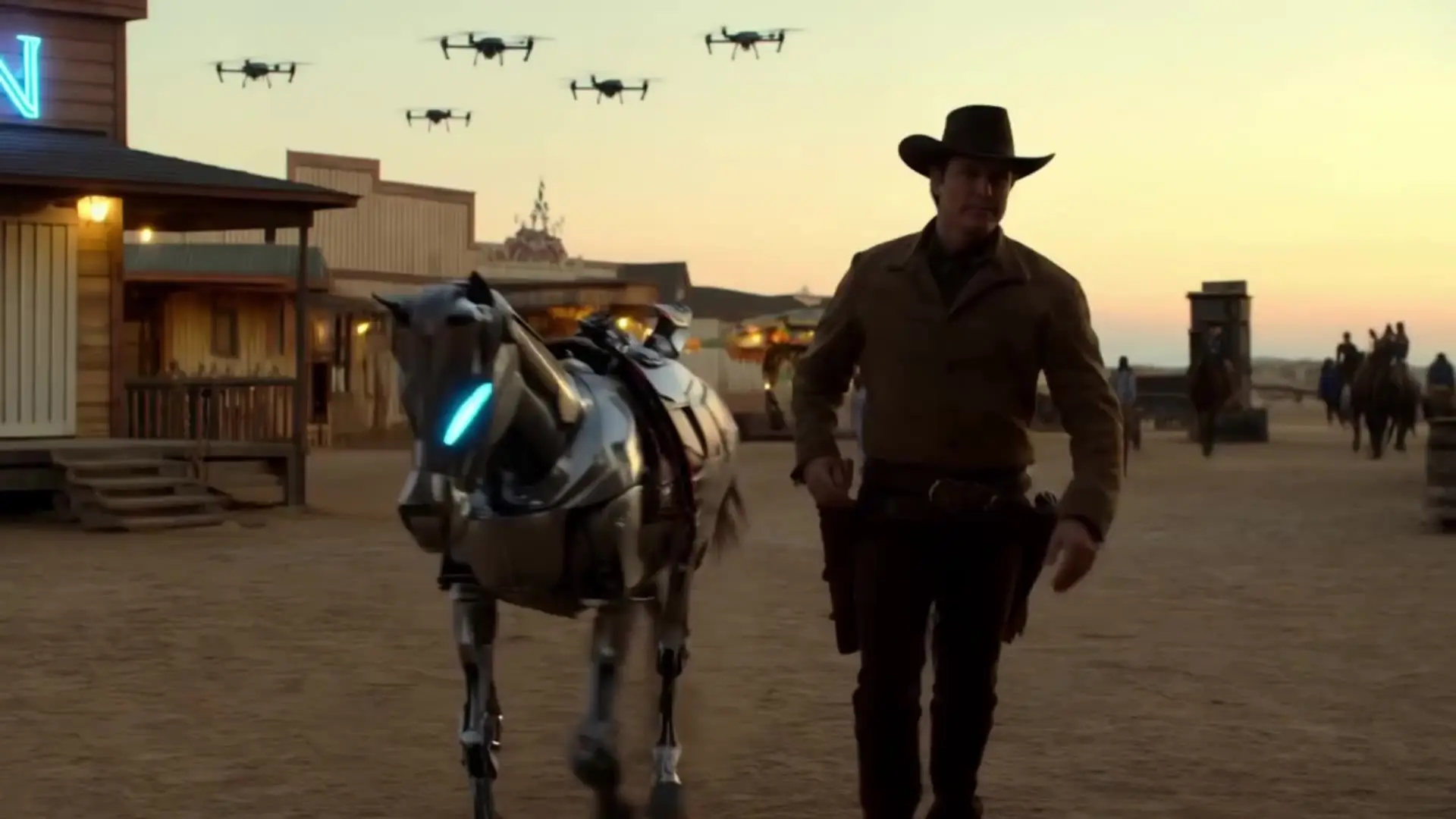

Crea video AI da testo con movimenti realistici e dettagli sorprendenti.

Trasforma immagini in video fluidi con scene naturali e movimento coerente.

Crea video di alta qualità da testo con audio realistico grazie a Sora 2.

Strumento AI per creare video 1080p realistici da testo, ideale per designer e artisti digitali.

Crea immagini di alta qualità da descrizioni testuali con Wan 2.2.

Wan 2.1 è il modello AI per video sviluppato da Alibaba, open-source e avanzato, progettato per creare contenuti video di alta qualità. Sfrutta tecniche di diffusione all'avanguardia per generare movimenti realistici e supporta la generazione di testo bilingue (inglese e cinese). La famiglia Wan 2.1 include diversi modelli: T2V-14B (testo in video, ad alta risoluzione), T2V-1.3B (versione più leggera per GPU consumer), I2V-14B-720P (da immagine a video in 720p), e I2V-14B-480P (ottimizzata per 480p con meno carico hardware).

Puoi utilizzare Wan 2.1 in diversi modi:

Puoi eseguire Wan 2.1 così:

LoRA ti consente di personalizzare Wan 2.1 modificando stile e movimento senza riaddestrare l'intero modello.

Per allenare un modello LoRA per Wan 2.1:

Modelli LoRA creati dalla community per Wan 2.1 sono disponibili su Hugging Face. Ad esempio, puoi consultare questi: Wan2.1 14B 480p I2V LoRAs.

I modelli Wan 2.1 con 14B parametri richiedono GPU potenti, come la RTX 4090, per generare video fluidi a 720p. Normalmente servono circa 12 GB di VRAM per produrre video di 8 secondi a 480p con ottimizzazioni. La versione T2V-1.3B di Wan 2.1 è molto più leggera e adatta a GPU consumer, usando circa 8.19 GB di VRAM per creare video 480p di 5 secondi in 4 minuti.

La RTX 3090 (24 GB di VRAM) è perfetta per usare Wan 2.1 T2V-1.3B, che ne consuma solamente circa 8.19 GB. Anche il modello T2V-14B di Wan 2.1 può teoricamente funzionare, ma richiede molta memoria e ottimizzazioni, e le prestazioni potrebbero risultare instabili o rallentate.

Wan 2.1 funziona in base al modello usato. Il modello T2V-1.3B è efficiente e funziona bene anche su GPU da 8 GB (480p). Il modello T2V-14B offre video 720p di qualità superiore ma richiede più VRAM. Se vuoi provare Wan 2.1 senza un hardware potente, puoi usare il RunComfy AI Playground, che offre crediti gratuiti per iniziare subito online.

Wan 2.1 può essere eseguito nel cloud con costi ridotti usando:

Wan 2.1 supporta la generazione da immagine a video (I2V). Basta fornire un'immagine statica con un prompt testuale per descrivere l’animazione desiderata. Il modello Wan 2.1 genera un video fluido con dinamiche realistiche.

Wan 2.1 genera video fino a un massimo di 81 frame, equivalenti a circa 5 secondi a 16 FPS. Il numero di frame deve seguire la formula 4n+1. Alcuni utenti hanno testato durate maggiori, ma 81 frame è la configurazione ottimale per mantenere coerenza temporale e qualità visiva nel video generato da Wan 2.1.

Wan 2.1 è ideale per creare video dinamici da testi o immagini. È particolarmente utile per clip social, contenuti educativi, progetti promozionali e anche editing video. Grazie alla sua capacità di generare movimento realistico e testo leggibile, Wan 2.1 è una scelta solida per content creator e marketer che desiderano produrre video con strumenti AI avanzati ma facili da usare.

Puoi usare Wan 2.1 in ComfyUI per progetti sia testo-in-video che immagine-in-video. Ecco i link utili:

RunComfy è la piattaforma principale ComfyUI che offre ComfyUI online ambiente e servizi, insieme a workflow di ComfyUI con visuali mozzafiato. RunComfy offre anche AI Models, consentire agli artisti di sfruttare gli ultimi strumenti di AI per creare arte incredibile.