Si entrenaste una LoRA con Ostris AI Toolkit (para FLUX / FLUX.2, Wan 2.2/2.1, Qwen Image, Z‑Image, LTX‑2, SDXL, etc.), seguramente viste este problema: los training samples de AI Toolkit se ven genial, pero al hacer inferencia en Diffusers / ComfyUI / otro stack, el resultado deriva.

Este guía te muestra una forma rápida y fiable de obtener inferencia que coincide con los previews de entrenamiento de AI Toolkit, para que lo que despliegas se parezca a lo que entrenaste.

Por qué los previews de AI Toolkit no suelen coincidir con la inferencia

Los “Samples” de AI Toolkit se generan con una configuración de inferencia específica:

- variante exacta del modelo base

- semántica de scheduler/steps específica por modelo

- forma de aplicar LoRA específica por modelo (adapter vs fuse/merge)

- reglas de snapping de resolución (múltiplos de ancho/alto)

- inputs requeridos por ciertas pipelines (p. ej. control image para edit / I2V)

Si tu stack de inferencia cambia cualquiera de estos puntos, incluso con el mismo prompt + seed, el output puede derivar. En resumen: para igualar el preview, tienes que igualar todo el pipeline de inferencia (no solo un par de settings).

Por qué RunComfy puede hacer que la inferencia coincida con tus training samples

RunComfy ejecuta una pipeline Diffusers específica por modelo base que coincide con la pipeline usada por AI Toolkit para generar los previews de ese modelo. Además, RunComfy lee tu Training config file (YAML) para fijar la misma variante del modelo base y los defaults críticos de inferencia, permitiendo que Run LoRA inference coincida 1:1 con tus training samples. Y como la inferencia corre en un runtime cloud gestionado, evitas drift silencioso de versiones CUDA/PyTorch/Diffusers que cambian outputs.

Ejemplo de nuestro experimento de paridad (training samples de AI Toolkit vs Run LoRA inference, mismos settings):

| AI Toolkit training sample | RunComfy inference (Playground/API) |

|---|---|

|

|

|

|

|

|

Paso a paso: Import → Run LoRA → Inference (Playground + API)

En pocos minutos puedes completar el flujo end‑to‑end y obtener inferencia que coincide con los training samples de AI Toolkit.

Si ya entrenaste con RunComfy’s AI Toolkit, tu LoRA aparece automáticamente en LoRA Assets cuando termina el job, así que puedes saltar al Step 3 (Run LoRA). Aquí: AI Toolkit on RunComfy.

Step 0 — Prepara dos archivos de tu job de AI Toolkit

Normalmente necesitas:

1) LoRA weights: *.safetensors

2) Training config file (YAML) del job (a menudo config.yml o *.yaml)

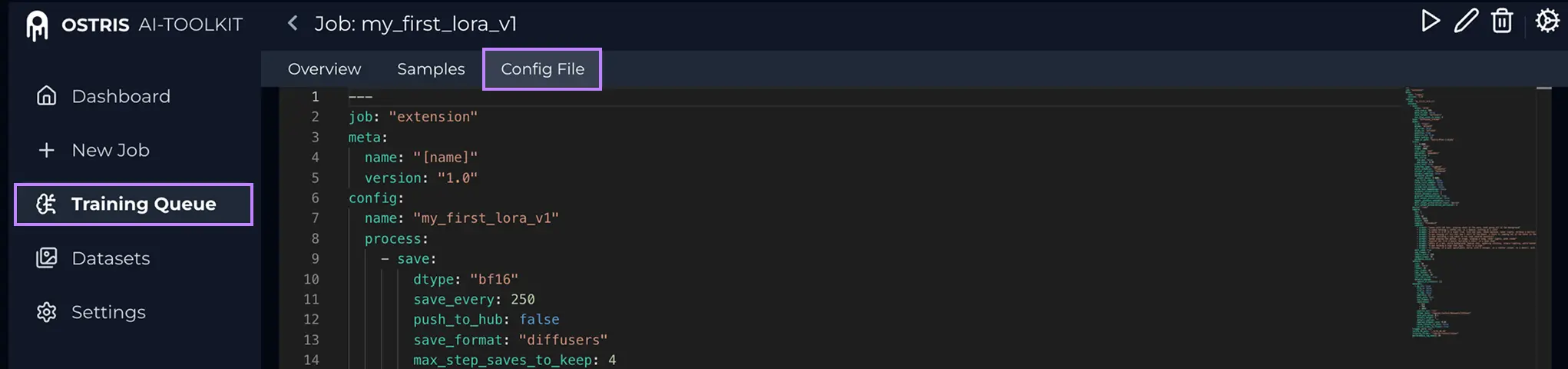

¿Qué es el Config File (YAML)?

En AI Toolkit, abre tu Training Job y pulsa Config File para ver el YAML exacto. Copia todo el contenido y guárdalo como .yaml para subirlo aquí.

Por qué el YAML es importante: permite a RunComfy fijar el base model y los defaults de inferencia que generaron tus samples.

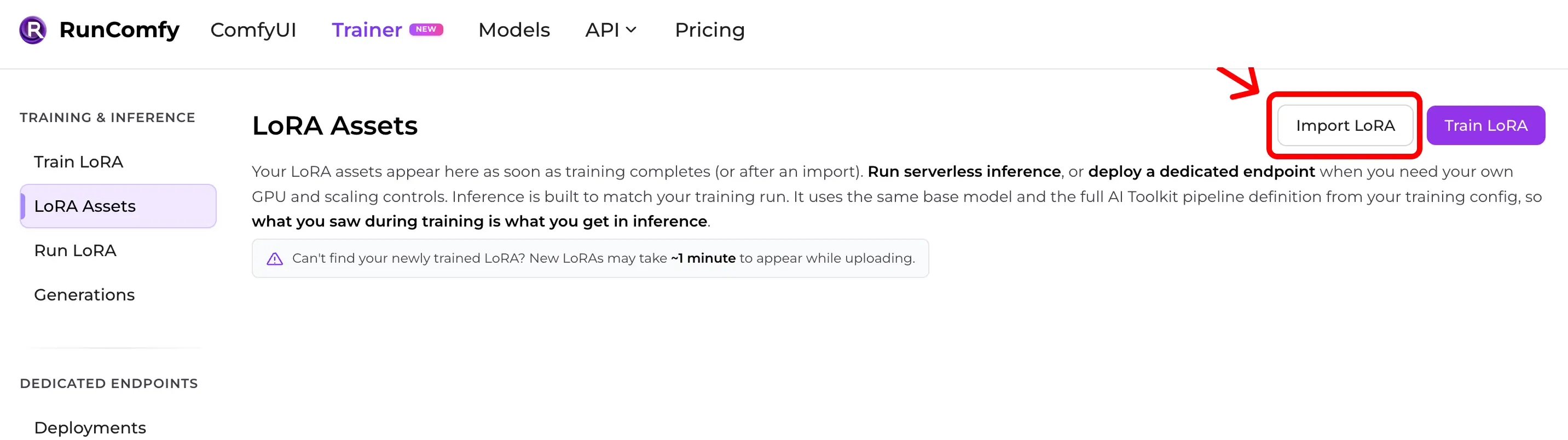

Step 1 — Importa tu LoRA de AI Toolkit en RunComfy

Ruta: Trainer → LoRA Assets → Import LoRA

Sube:

- tus

*.safetensorsLoRA weights - tu training config file (YAML) (recomendado)

Si no tienes el YAML, puedes importar seleccionando el Base Model, pero puedes perder paridad si los defaults difieren.

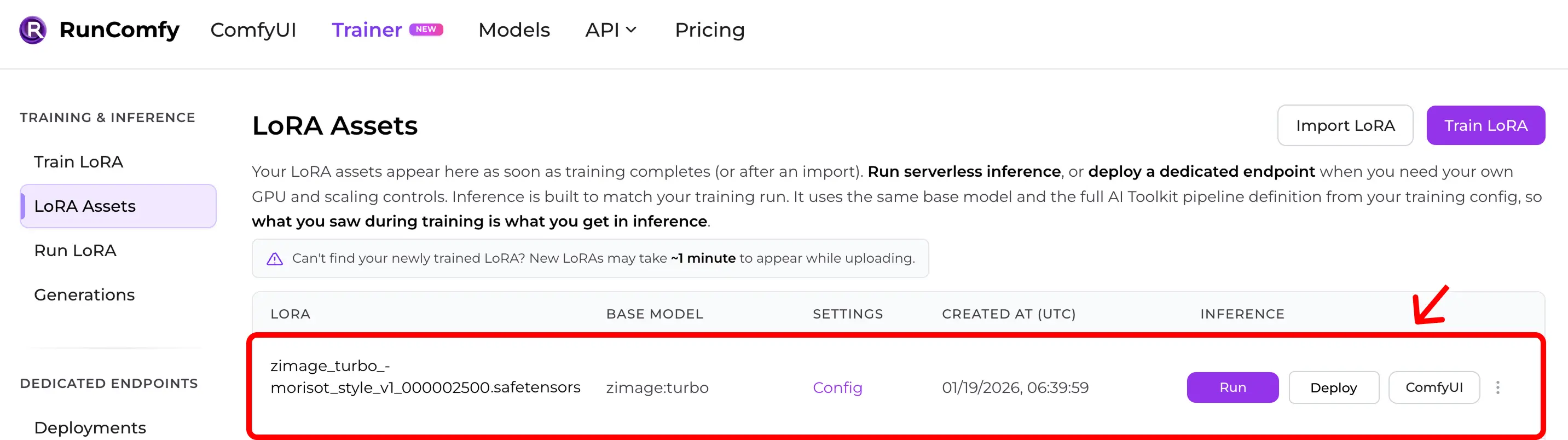

Step 2 — Confirma que aparece en LoRA Assets

Después del import (o tras un entrenamiento en la nube), tu LoRA aparece en LoRA Assets.

Desde ahí puedes hacer clic en Run (Run LoRA) para iniciar inferencia (Playground + API).

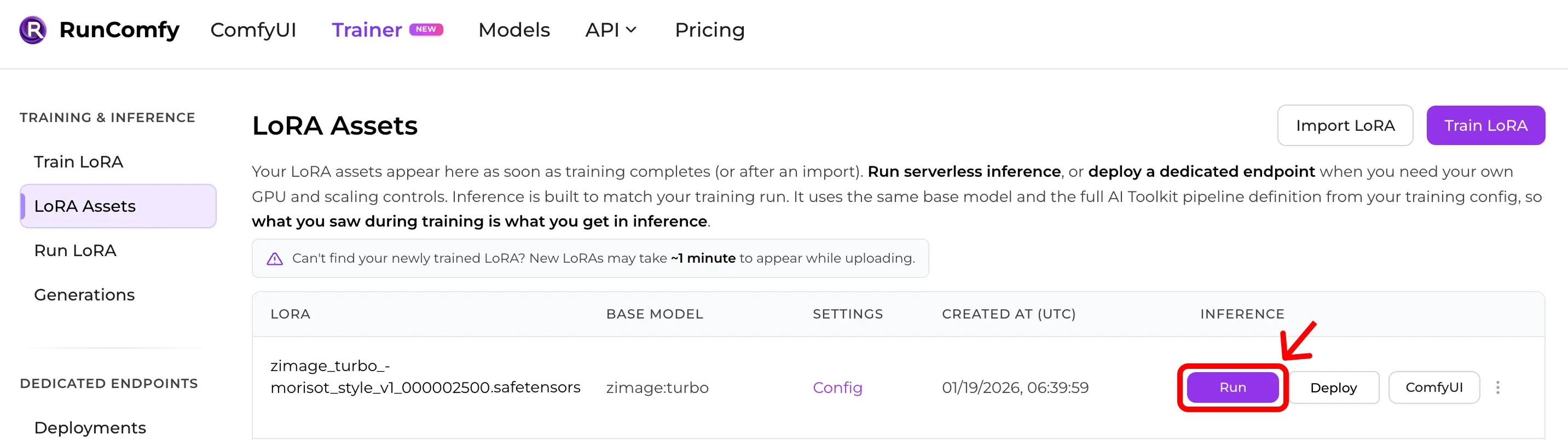

Step 3 — Ejecuta inferencia al instante (Run LoRA)

En LoRA Assets encuentra tu LoRA y pulsa Run.

Esto inicia Run LoRA: inferencia on‑demand que usa el mismo base model y la misma definición de pipeline del YAML de entrenamiento, para conseguir preview‑parity sin reconstruir todo a mano.

Puedes testear en el Playground o usar la misma configuración vía API.

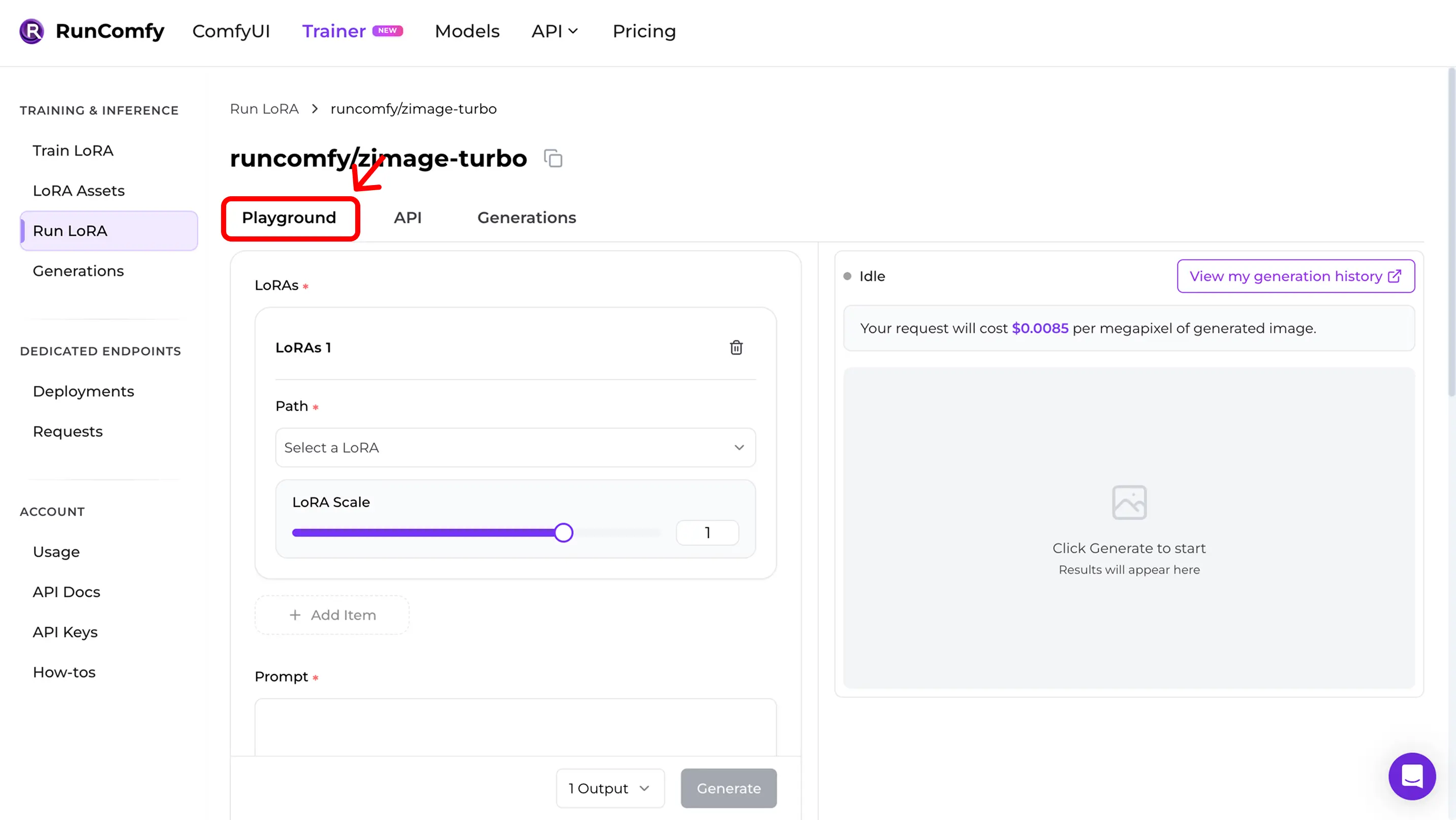

Step 4 — Reproduce training samples en el Playground

Después de Run entras en el Run LoRA Playground.

Aquí validas la paridad:

- usa los mismos settings del sample (prompt, seed, resolución, steps, guidance, LoRA scale)

- si los resultados se ven muy parecidos a los samples, ok

- si hay drift, usa el checklist rápido de abajo

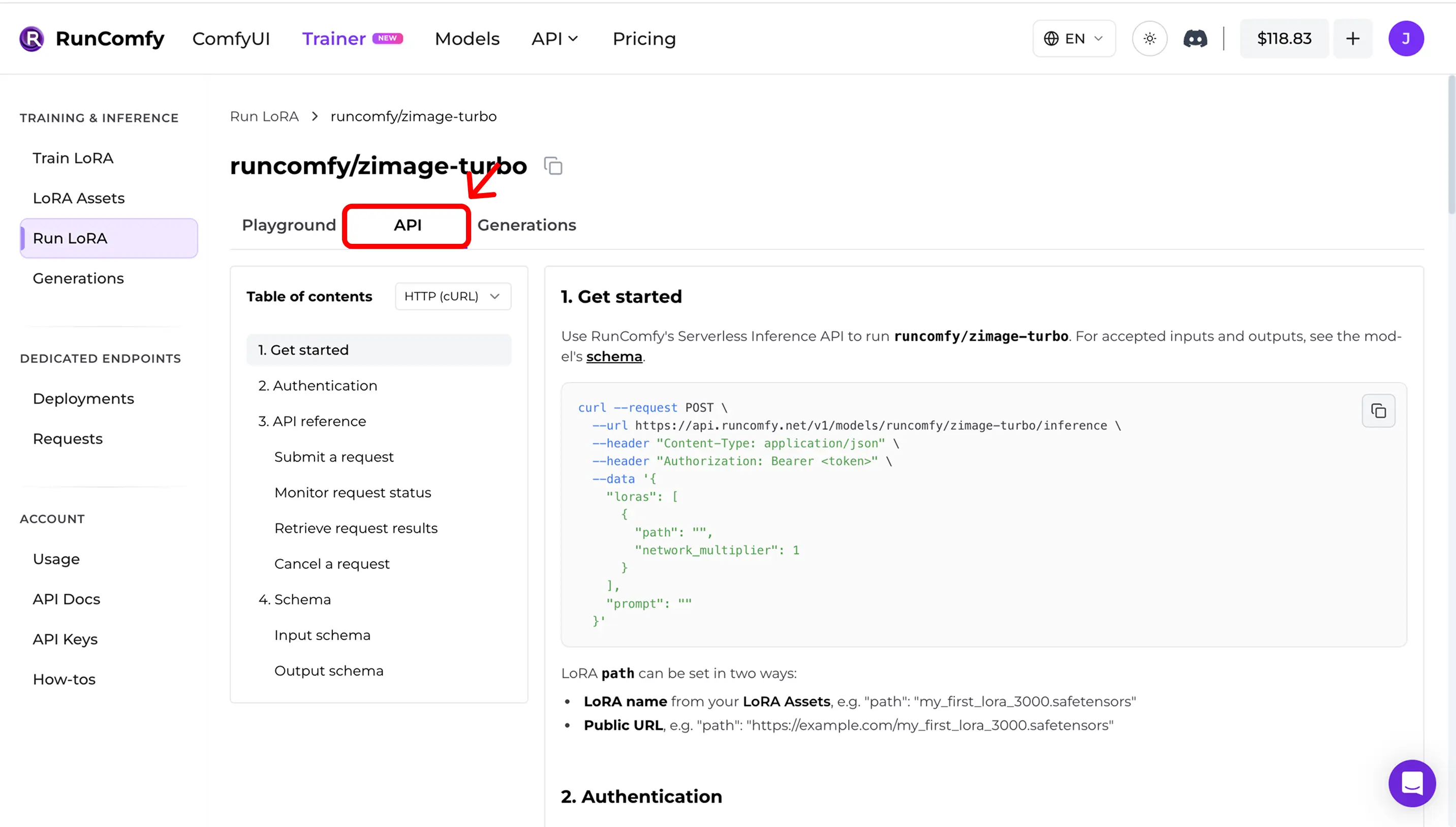

Step 5 — Usa la API en producción (async inference)

En Run LoRA abre la pestaña API. La API es asíncrona:

- envías el request

- monitoreas el estado

- recuperas resultados

Copia las URLs y el request schema desde el dashboard.

Ejemplo (ilustrativo — usa tu propio model_id, ruta LoRA y API key):

curl --request POST \

--url "https://model-api.runcomfy.net/v1/models/<MODEL_ID>" \

--header "Authorization: Bearer <YOUR_API_KEY>" \

--header "Content-Type: application/json" \

--data '{

"prompt": "a studio portrait photo, cinematic lighting",

"lora": {

"path": "<YOUR_LORA_NAME_OR_URL>"

}

}'API docs: RunComfy Model API (see also LoRA inputs (Trainer))

Checklist rápido de mismatch

Si la inferencia no coincide, revisa:

1) Exact base model (repo + variant)

2) Width/height after snapping al divisor del modelo

3) Steps + guidance + scheduler semantics

4) LoRA application mode (adapter vs fuse/merge)

5) Para edit / I2V: correctos control image inputs

6) Drift de runtime (Diffusers / ComfyUI versions)

Implementación de referencia open source

¿Quieres inferencia en ComfyUI y resultados coherentes con training samples / previews?

Ver: AI Toolkit LoRA in ComfyUI: Parity Workflows

Si quieres auditar o self‑hostear: Open-source AI Toolkit inference code: runcomfy-com/ai-toolkit-inference

FAQ

¿Necesito el training config file (YAML) para importar?

Muy recomendable. Sin YAML puedes elegir un base model manualmente, pero pierdes el matching automático de defaults por modelo.

¿Puedo importar una LoRA entrenada fuera de RunComfy?

Sí. Si fue entrenada con AI Toolkit, importa *.safetensors y el YAML, y luego ejecuta inferencia con Run LoRA.

¿Qué significa “Run LoRA” aquí?

Run LoRA es inferencia on‑demand (Playground + API) que ejecuta una LoRA en su base model sin desplegar un endpoint dedicado. Billing por request.

¿Listo para comenzar el entrenamiento?