FLUX LoRA hat in der KI-Community immense Popularität erlangt, insbesondere bei denen, die KI-Modelle mit ihren eigenen Datensätzen feinabstimmen möchten. Dieser Ansatz ermöglicht es Ihnen, bestehende FLUX-Modelle mühelos an Ihre einzigartigen Datensätze anzupassen, was sie hochgradig anpassbar und effizient für eine breite Palette kreativer Bestrebungen macht. Wenn Sie bereits mit ComfyUI vertraut sind, wird die Verwendung des ComfyUI FLUX LoRA Training-Workflows zum Trainieren Ihres FLUX LoRA-Modells ein Kinderspiel sein. Der Workflow und die zugehörigen Knoten wurden von Kijai erstellt, also ein großes Dankeschön an ihn für seinen Beitrag! Weitere Informationen finden Sie auf Kijai's GitHub.

ComfyUI FLUX LoRA Training Tutorial

Der ComfyUI FLUX LoRA Training-Workflow ist ein leistungsstarker Prozess, der für das Training von FLUX LoRA-Modellen entwickelt wurde. Das Training mit ComfyUI bietet mehrere Vorteile, insbesondere für Benutzer, die bereits mit der Benutzeroberfläche vertraut sind. Mit FLUX LoRA Training können Sie die gleichen Modelle verwenden, die für Inferenz verwendet werden, um sicherzustellen, dass es bei der Arbeit innerhalb derselben Python-Umgebung keine Kompatibilitätsprobleme gibt. Darüber hinaus können Sie Workflows erstellen, um verschiedene Einstellungen zu vergleichen und Ihren Trainingsprozess zu verbessern. Dieses Tutorial führt Sie durch die Schritte zur Einrichtung und Verwendung von FLUX LoRA Training in ComfyUI.

Wir werden behandeln:

- Vorbereiten Ihres Datensatzes für FLUX LoRA Training

- Der FLUX LoRA Trainingsprozess

- Ausführen des FLUX LoRA Trainings

- Wie und wo man die FLUX- und FLUX LoRA-Modelle verwendet

1. Vorbereiten Ihres Datensatzes für FLUX LoRA Training

Beim Vorbereiten Ihrer Trainingsdaten für FLUX LoRA Training ist es wichtig, qualitativ hochwertige Bilder für Ihr Zielobjekt zu haben.

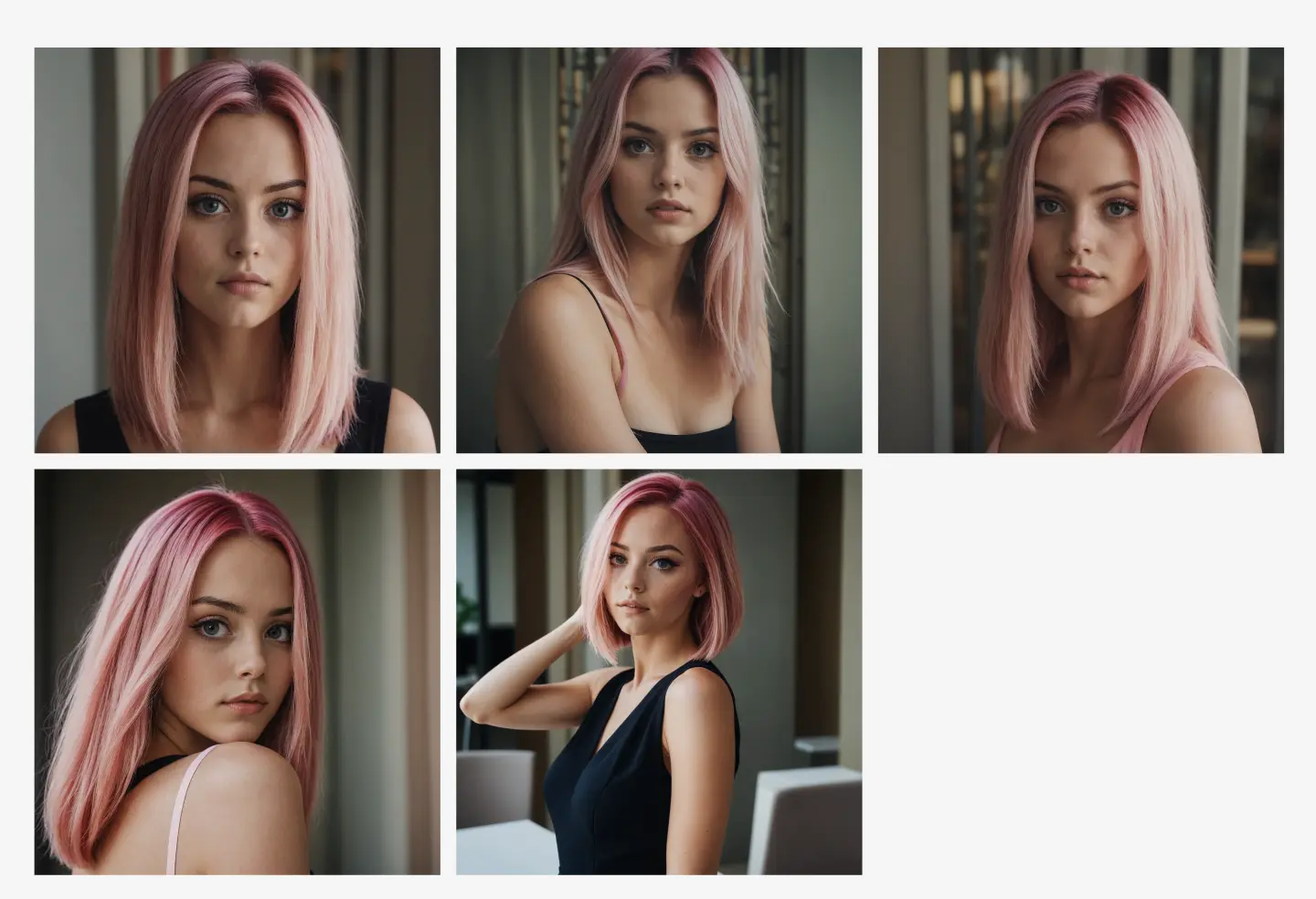

In diesem Beispiel trainieren wir ein FLUX LoRA-Modell, um Bilder eines bestimmten Influencers zu generieren. Dafür benötigen Sie eine Reihe hochwertiger Bilder des Influencers in verschiedenen Posen und Einstellungen. Eine bequeme Möglichkeit, diese Bilder zu sammeln, ist die Verwendung des ComfyUI Consistent Character Workflow, der es einfach macht, eine Sammlung von Bildern zu erstellen, die denselben Charakter in unterschiedlichen Posen zeigen, während ihr Aussehen konsistent bleibt. Für unseren Trainingsdatensatz haben wir fünf hochwertige Bilder des Influencers in verschiedenen Posen und Einstellungen ausgewählt, um sicherzustellen, dass der Datensatz robust genug ist, damit FLUX LoRA Training die komplexen Details lernt, die erforderlich sind, um konsistente und genaue Ausgaben zu produzieren.

Prozess zur Beschaffung von Trainingsdaten

Beispiel für Trainingsdaten

Sie können auch Ihren eigenen Datensatz basierend auf Ihren spezifischen Bedürfnissen sammeln——FLUX LoRA Training ist flexibel und funktioniert mit verschiedenen Arten von Daten.

2. Der FLUX LoRA Trainingsprozess

Der FLUX LoRA Trainings-Workflow besteht aus mehreren Schlüssel-Knoten, die zusammenarbeiten, um Ihr Modell zu trainieren und zu validieren. Hier ist eine detaillierte Übersicht über die Hauptknoten, unterteilt in drei Teile: Datensatz, Einstellungen und Init und Training.

2.1. Datensätze für FLUX LoRA Training festlegen

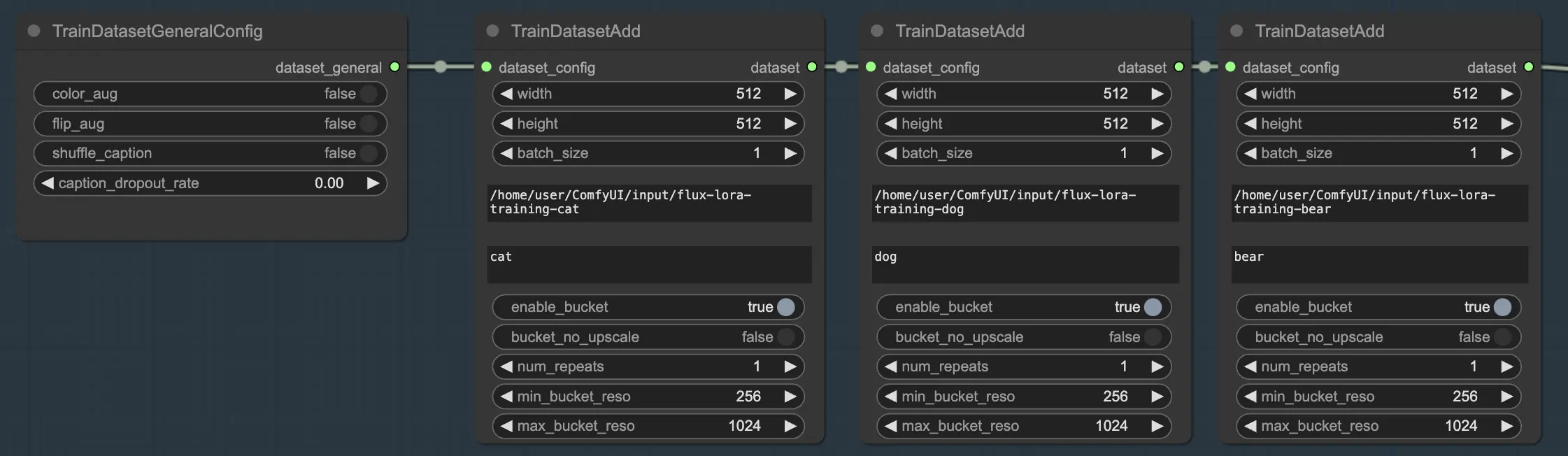

Der Datensatzabschnitt besteht aus zwei wesentlichen Knoten, die Ihnen helfen, Ihre Trainingsdaten zu konfigurieren und anzupassen: TrainDatasetGeneralConfig und TrainDatasetAdd.

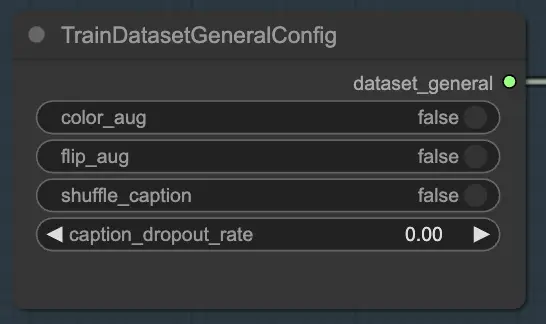

2.1.1. TrainDatasetGeneralConfig

Der TrainDatasetGeneralConfig-Knoten ist der Ort, an dem Sie die allgemeinen Einstellungen für Ihren Trainingsdatensatz in FLUX LoRA Training definieren. Dieser Knoten gibt Ihnen Kontrolle über verschiedene Aspekte der Datenaugmentation und -vorverarbeitung. Beispielsweise können Sie die Farbaugmentation aktivieren oder deaktivieren, was die Fähigkeit des Modells verbessern kann, über verschiedene Farbvariationen hinweg zu generalisieren. Ebenso können Sie die Flip-Augmentation umschalten, um Bilder zufällig horizontal zu spiegeln und vielfältigere Trainingsproben bereitzustellen. Zusätzlich haben Sie die Möglichkeit, die Beschriftungen zu mischen, was Zufälligkeit einführt und Überanpassung reduziert. Die Beschriftungs-Ausfallrate ermöglicht es Ihnen, während des Trainings Beschriftungen zufällig wegzulassen, was das Modell robuster gegenüber fehlenden oder unvollständigen Beschriftungen machen kann.

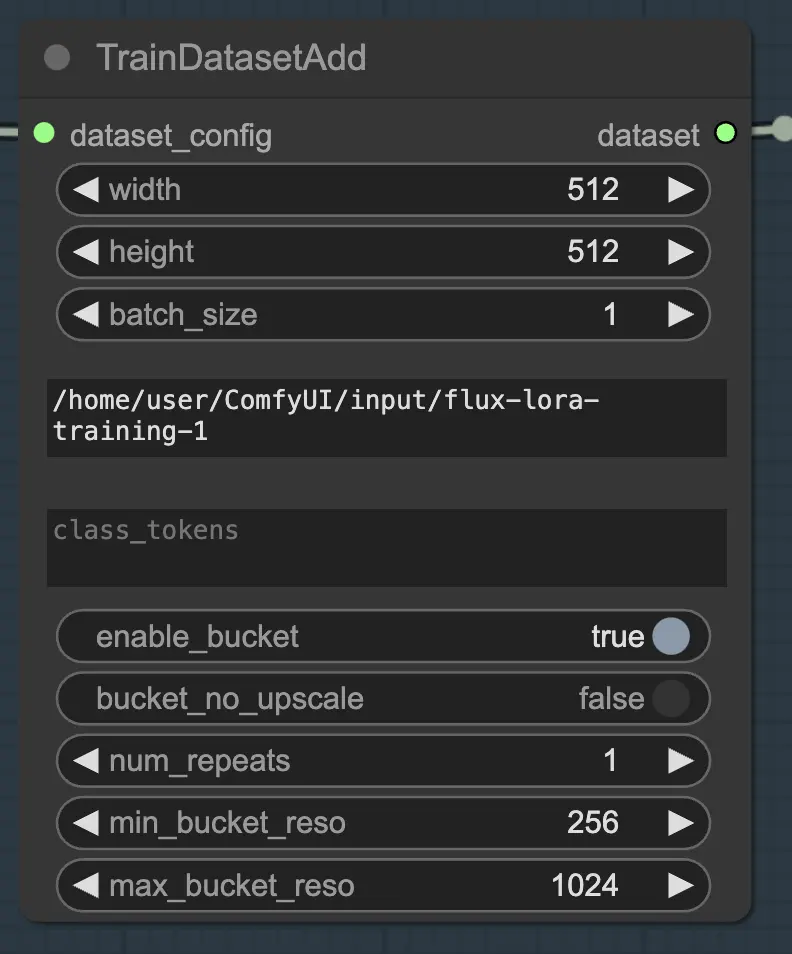

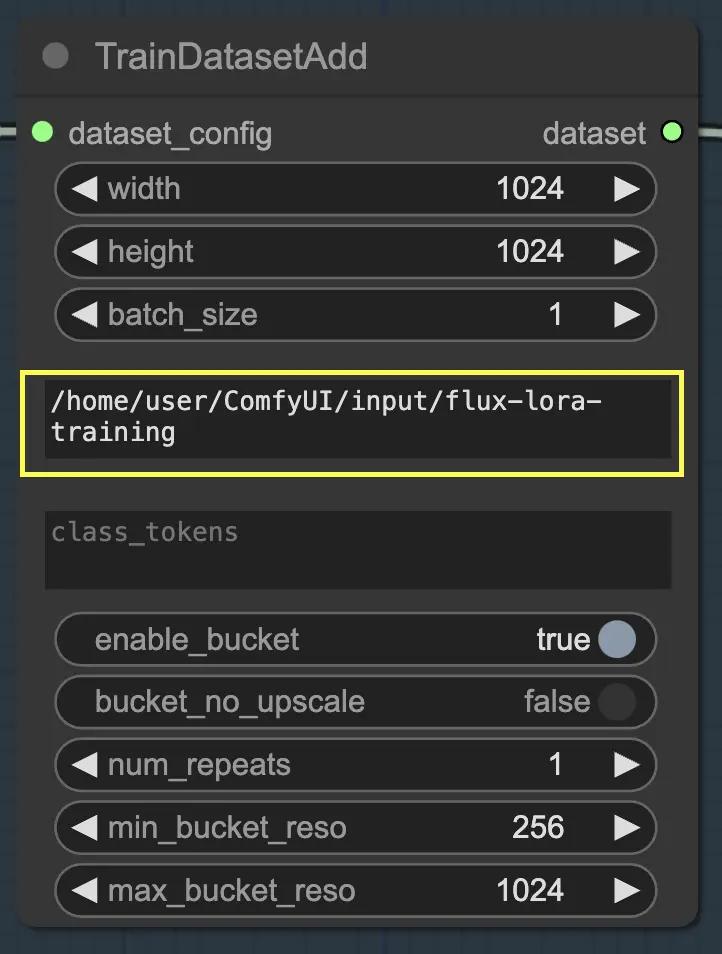

2.1.2. TrainDatasetAdd

Der TrainDatasetAdd-Knoten ist der Ort, an dem Sie die Details jedes einzelnen Datensatzes angeben, der in Ihr FLUX LoRA Training aufgenommen werden soll.

Eingabeverzeichnis: Trainingsdatensatzpfad

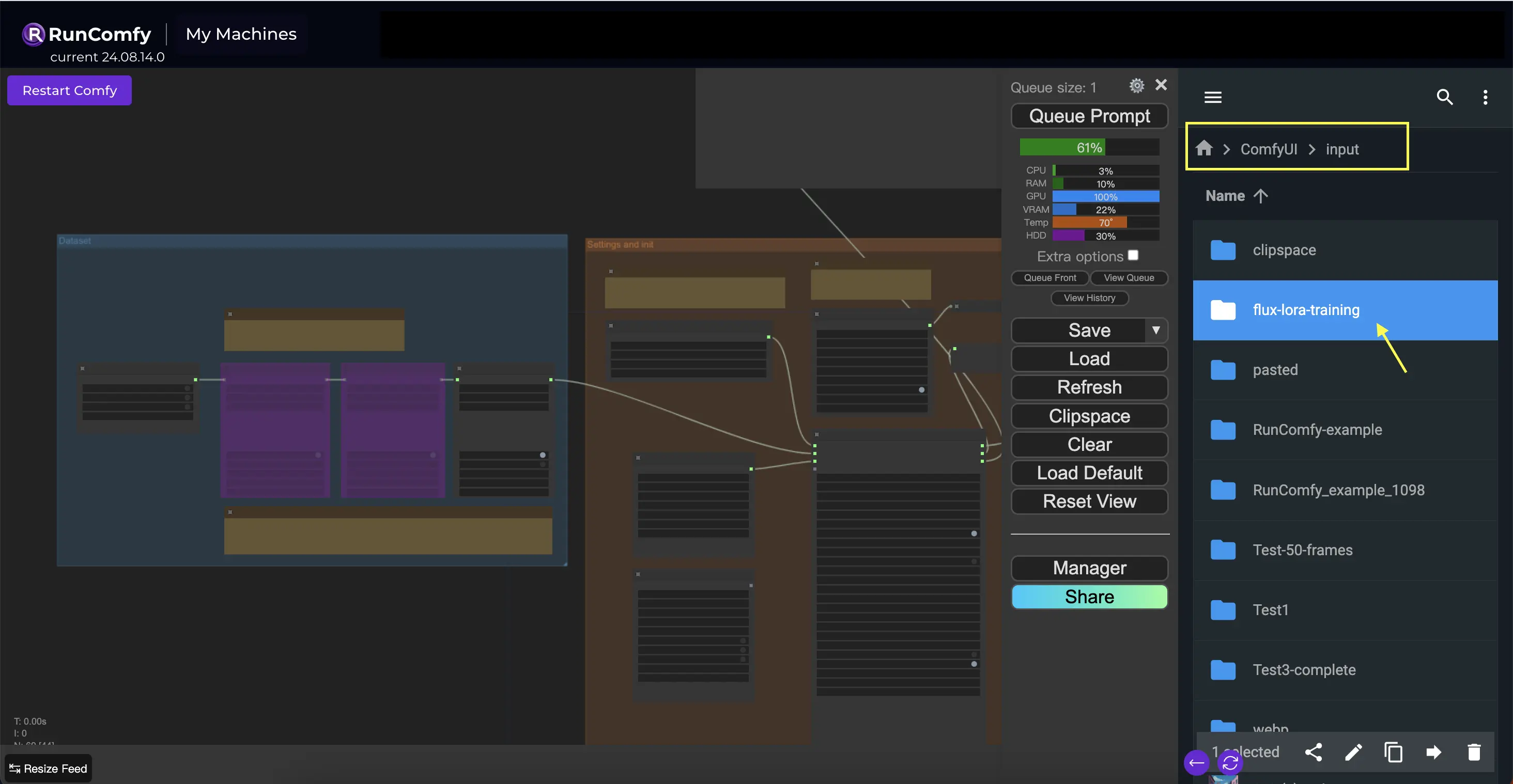

Um das Beste aus diesem Knoten herauszuholen, ist es wichtig, Ihre Trainingsdaten ordnungsgemäß zu organisieren. Wenn Sie den Dateibrowser von RunComfy verwenden, platzieren Sie die Trainingsdaten im Verzeichnis /home/user/ComfyUI/input/{file-name}, wobei {file-name} ein aussagekräftiger Name ist, den Sie Ihrem Datensatz zuweisen.

Sobald Sie Ihre Trainingsdaten im entsprechenden Verzeichnis platziert haben, müssen Sie den Pfad zu diesem Verzeichnis im image_dir-Parameter des TrainDatasetAdd-Knotens angeben. Dies teilt dem Knoten mit, wo er Ihre Trainingsbilder finden kann.

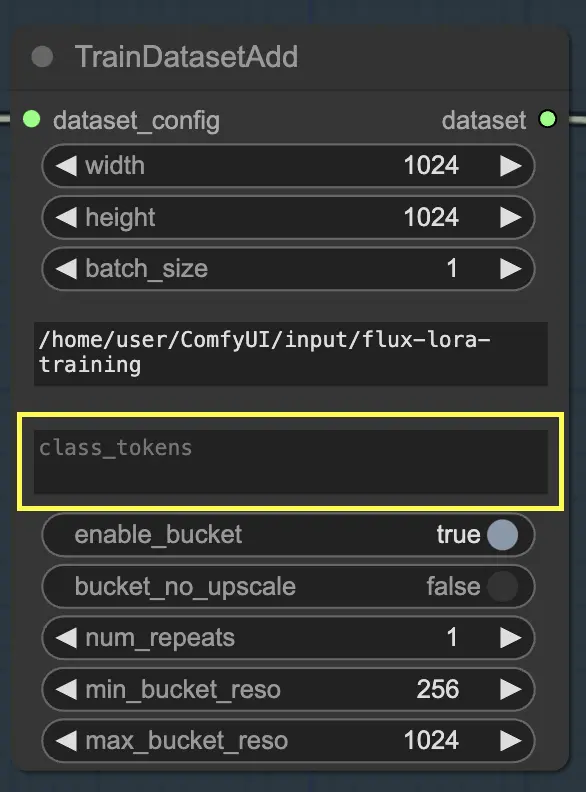

Klassentoken

Wenn Ihr Datensatz von der Verwendung spezifischer Klassentoken oder Auslösewörter profitiert, können Sie diese im class_tokens-Parameter eingeben. Klassentoken sind spezielle Wörter oder Phrasen, die jeder Beschriftung vorangestellt werden und den Generierungsprozess des Modells leiten. Wenn Sie beispielsweise an einem Datensatz verschiedener Tierarten trainieren, könnten Sie Klassentoken wie "dog", "cat" oder "bird" verwenden, um das gewünschte Tier in den generierten Bildern anzugeben. Wenn Sie diese Klassentoken später in Ihren Aufforderungen verwenden, können Sie steuern, welche spezifischen Aspekte Sie vom Modell generieren lassen möchten.

Auflösung (Breite und Höhe), Batch-Größe festlegen

Zusätzlich zu den Parametern image_dir und class_tokens bietet der TrainDatasetAdd-Knoten mehrere weitere Optionen, um Ihren Datensatz fein abzustimmen. Sie können die Auflösung (Breite und Höhe) der Bilder festlegen, die Batch-Größe für das Training angeben und bestimmen, wie oft der Datensatz pro Epoche wiederholt werden soll.

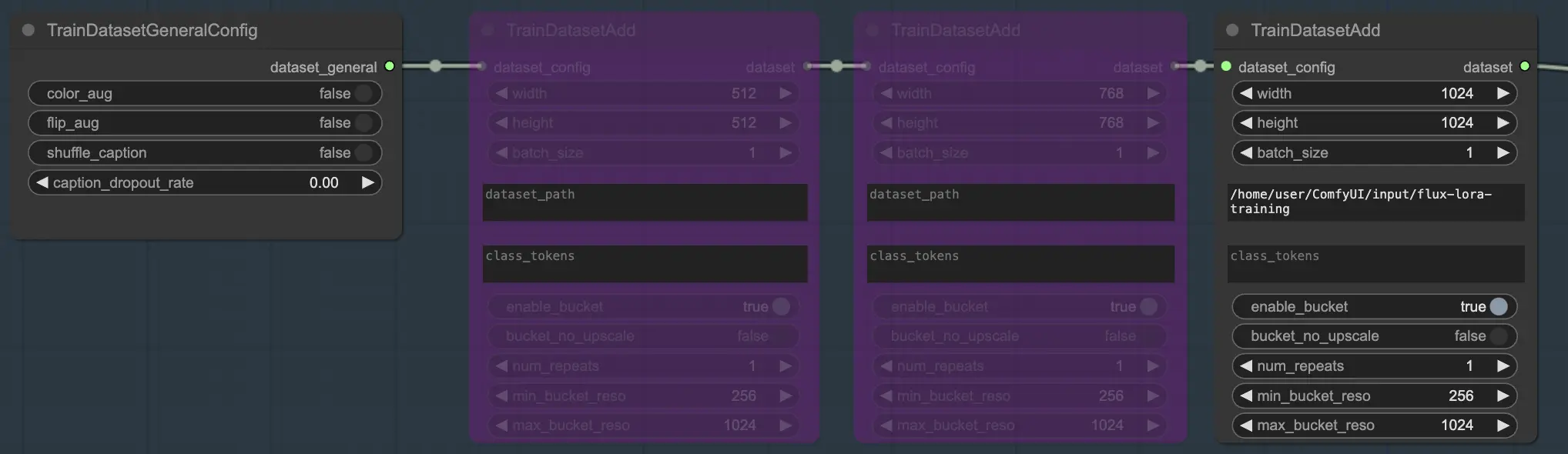

Mehrere Datensätze

Eine der leistungsstarken Funktionen von FLUX LoRA Training ist die Fähigkeit, mehrere Datensätze nahtlos zu kombinieren. Im FLUX LoRA Training-Workflow sind drei TrainDatasetAdd-Knoten in Reihe verbunden. Jeder Knoten stellt einen eigenen Datensatz mit seinen eigenen einzigartigen Einstellungen dar. Durch das Verknüpfen dieser Knoten können Sie einen reichhaltigen und vielfältigen Trainingssatz erstellen, der Bilder und Beschriftungen aus verschiedenen Quellen integriert.

Um dies zu veranschaulichen, betrachten wir ein Szenario, in dem Sie drei separate Datensätze haben: einen für Katzen, einen für Hunde und einen weiteren für Bären. Sie können drei TrainDatasetAdd-Knoten einrichten, die jeweils einem dieser Datensätze gewidmet sind. Im ersten Knoten würden Sie den Pfad zum "cats"-Datensatz im image_dir-Parameter angeben, das class token auf "cat" setzen und andere Parameter wie Auflösung und Batch-Größe nach Ihren Bedürfnissen anpassen. Ebenso würden Sie den zweiten und dritten Knoten für die "dogs"- und "bears"-Datensätze konfigurieren.

Dieser Ansatz ermöglicht es dem FLUX LoRA Trainingsprozess, eine Vielzahl von Bildern zu nutzen, wodurch die Fähigkeit des Modells verbessert wird, über verschiedene Kategorien hinweg zu generalisieren.

Beispiel

In unserem Beispiel verwenden wir nur einen Datensatz, um das Modell zu trainieren, daher aktivieren wir einen TrainDatasetAdd-Knoten und umgehen die anderen beiden. So können Sie es einrichten:

2.2. Einstellungen und Initialisierung

Der Abschnitt Einstellungen und Initialisierung ist der Ort, an dem Sie die Schlüsselkomponenten und Parameter für FLUX LoRA Training konfigurieren. Dieser Abschnitt umfasst mehrere wesentliche Knoten, die zusammenarbeiten, um Ihre Trainingsumgebung einzurichten.

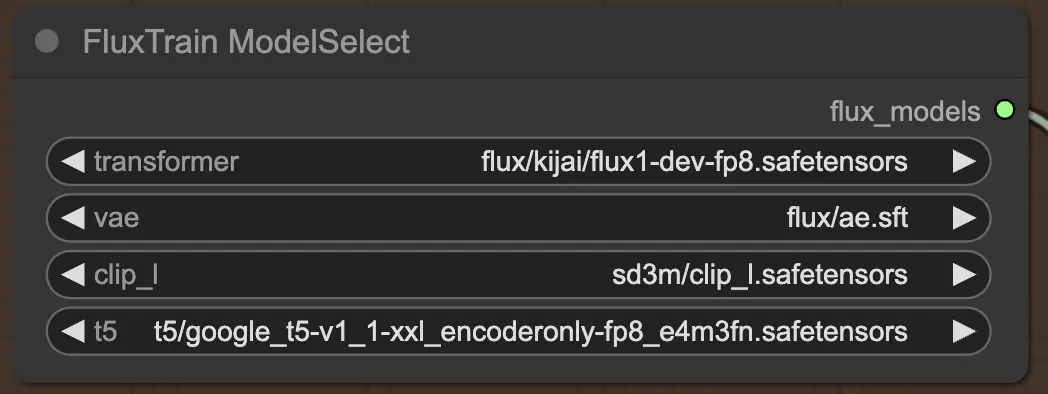

2.2.1. FluxTrainModelSelect

Zuerst haben Sie den FluxTrainModelSelect-Knoten, der für die Auswahl der FLUX-Modelle verantwortlich ist, die während des FLUX LoRA Trainings verwendet werden. Dieser Knoten ermöglicht es Ihnen, die Pfade zu vier kritischen Modellen anzugeben: dem Transformer, VAE (Variational Autoencoder), CLIP_L (Contrastive Language-Image Pre-training) und T5 (Text-to-Text Transfer Transformer). Diese Modelle bilden das Rückgrat des FLUX Trainingsprozesses und wurden alle auf der RunComfy-Plattform eingerichtet.

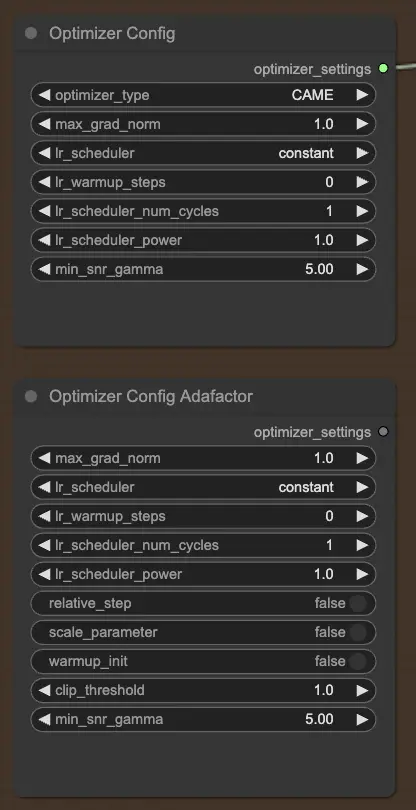

2.2.2. OptimizerConfig

Der OptimizerConfig-Knoten ist entscheidend für die Einrichtung des Optimierers innerhalb von FLUX LoRA Training, der bestimmt, wie die Parameter des Modells während des Trainings aktualisiert werden. Sie können den Optimierertyp (z.B. AdamW, CAME) auswählen, die maximale Gradienten-Norm für das Gradient-Clipping festlegen, um explodierende Gradienten zu verhindern, und den Lernraten-Planer (z.B. konstant, cosine annealing) auswählen. Zusätzlich können Sie optimizerspezifische Parameter wie Aufwärmschritte und Planer-Power feinabstimmen und zusätzliche Argumente für weitere Anpassungen bereitstellen.

Wenn Sie den Adafactor-Optimizer bevorzugen, der für seine Speichereffizienz und die Fähigkeit, große Modelle zu handhaben, bekannt ist, können Sie stattdessen den OptimizerConfigAdafactor-Knoten verwenden.

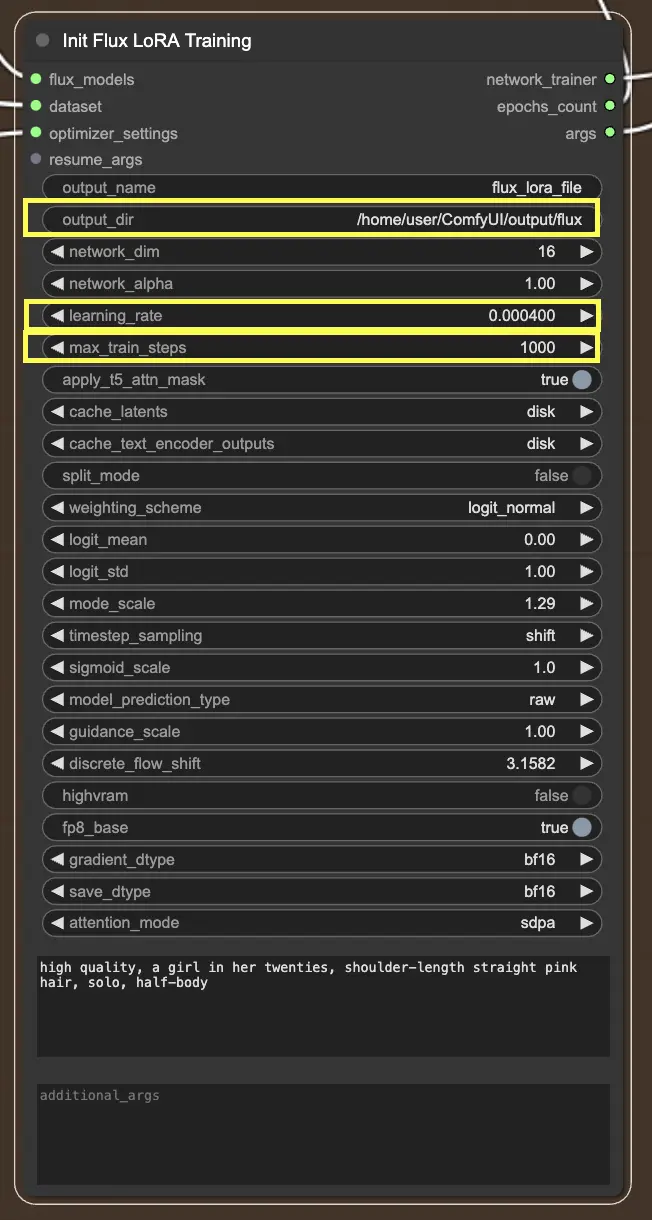

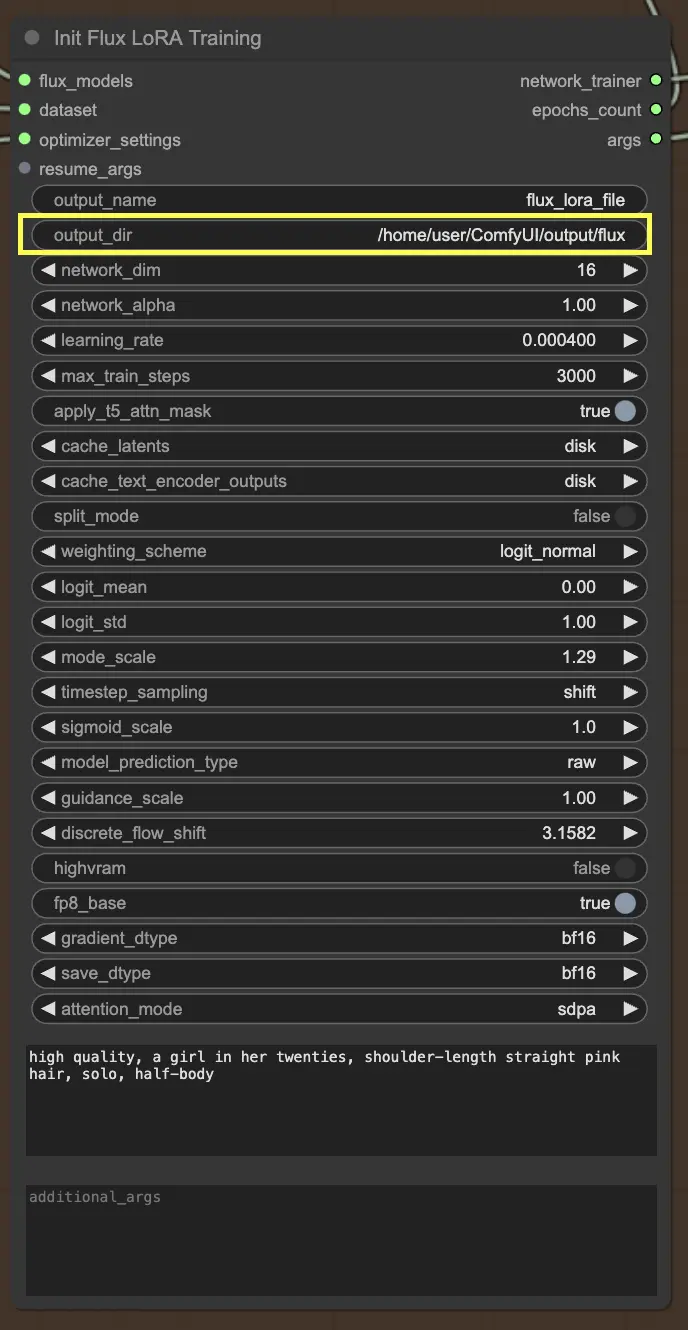

2.2.3. InitFluxLoRATraining

Der InitFluxLoRATraining-Knoten ist das zentrale Zentrum, in dem alle wesentlichen Komponenten zusammenlaufen, um den FLUX LoRA Trainingsprozess zu starten.

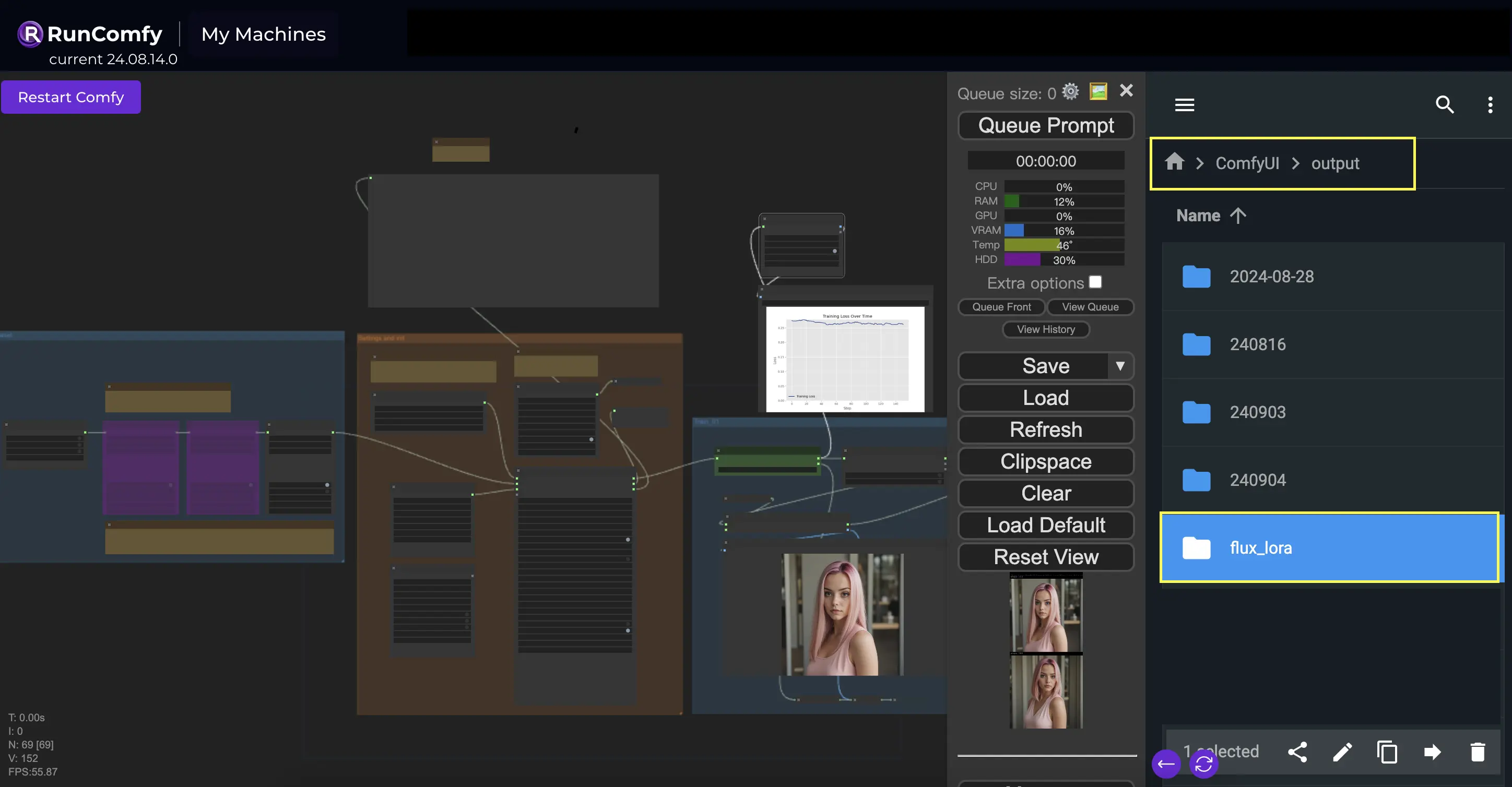

Ausgabeverzeichnis: FLUX LoRA Pfad

Einer der wichtigsten Punkte, die Sie im InitFluxLoRATraining-Knoten angeben müssen, ist das Ausgabeverzeichnis, in dem Ihr trainiertes Modell gespeichert wird. Auf der RunComfy-Plattform können Sie /home/user/ComfyUI/output/{file_name} als Speicherort für Ihre Ausgabe wählen. Sobald das Training abgeschlossen ist, können Sie es im Dateibrowser anzeigen.

Netzwerkdimensionen und Lernraten

Als nächstes möchten Sie die Netzwerkdimensionen und Lernraten festlegen. Die Netzwerkdimensionen bestimmen die Größe und Komplexität Ihres LoRA-Netzwerks, während die Lernraten steuern, wie schnell Ihr Modell lernt und sich anpasst.

Maximale Trainingsschritte

Ein weiterer wichtiger Parameter, den es zu berücksichtigen gilt, ist max_train_steps. Er bestimmt, wie lange Sie den Trainingsprozess laufen lassen möchten, oder mit anderen Worten, wie viele Schritte Ihr Modell machen soll, bevor es vollständig gebacken ist. Sie können diesen Wert basierend auf Ihren spezifischen Bedürfnissen und der Größe Ihres Datensatzes anpassen. Es geht darum, den richtigen Punkt zu finden, an dem Ihr Modell genug gelernt hat, um köstliche Ausgaben zu produzieren!

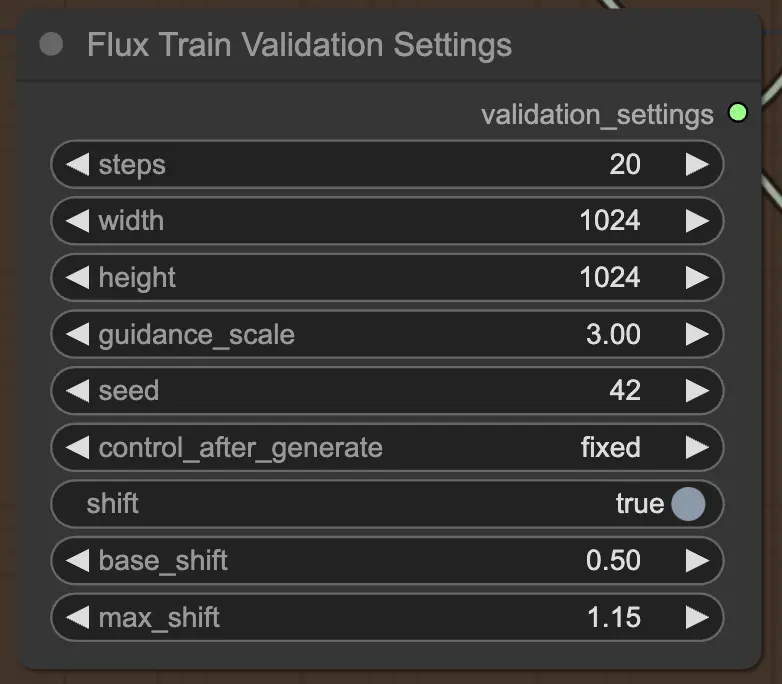

2.3.4. FluxTrainValidationSettings

Schließlich ermöglicht Ihnen der FluxTrainValidationSettings-Knoten, die Validierungseinstellungen zur Bewertung der Leistung Ihres Modells während des FLUX LoRA Trainingsprozesses zu konfigurieren. Sie können die Anzahl der Validierungsschritte, die Bildgröße, die Führungsskala und den Seed für die Reproduzierbarkeit festlegen. Zusätzlich können Sie die Timestep-Sampling-Methode auswählen und die Sigmoid-Skala- und Shift-Parameter anpassen, um die Timestep-Planung zu steuern und die Qualität der generierten Bilder zu verbessern.

3. Trainieren

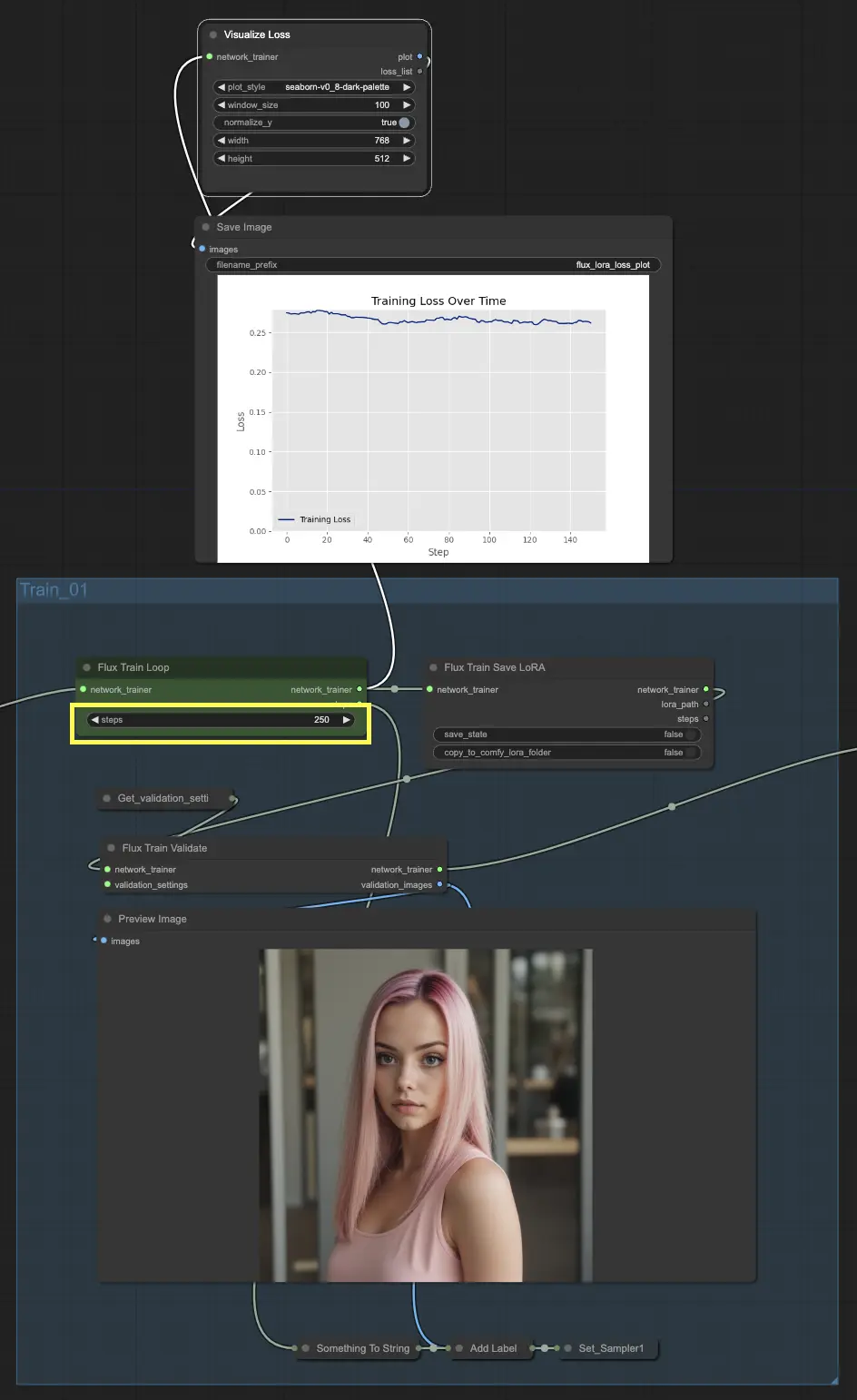

Der Trainingsabschnitt von FLUX LoRA Training ist der Ort, an dem die Magie passiert. Er ist in vier Teile unterteilt: Train_01, Train_02, Train_03 und Train_04. Jeder dieser Teile stellt eine andere Phase im FLUX LoRA Trainingsprozess dar, die es Ihnen ermöglicht, Ihr Modell schrittweise zu verfeinern und zu verbessern.

3.1. Train_01

Beginnen wir mit Train_01. Dies ist der Ort, an dem die initiale Trainingsschleife stattfindet. Der Star dieses Abschnitts ist der FluxTrainLoop-Knoten, der für das Ausführen der Trainingsschleife für eine bestimmte Anzahl von Schritten verantwortlich ist. In diesem Beispiel haben wir es auf 250 Schritte eingestellt, aber Sie können dies nach Ihren Bedürfnissen anpassen. Sobald die Trainingsschleife abgeschlossen ist, wird das trainierte Modell an den FluxTrainSave-Knoten übergeben, der das Modell in regelmäßigen Abständen speichert. Dies stellt sicher, dass Sie Checkpoints Ihres Modells in verschiedenen Trainingsphasen haben, was nützlich sein kann, um den Fortschritt zu verfolgen und sich von unerwarteten Unterbrechungen zu erholen.

Aber Training bedeutet nicht nur, das Modell zu speichern. Wir müssen auch seine Leistung validieren, um zu sehen, wie gut es abschneidet. Hier kommt der FluxTrainValidate-Knoten ins Spiel. Er nimmt das trainierte Modell und stellt es mit einem Validierungsdatensatz auf die Probe. Dieser Datensatz ist vom Trainingsdatensatz getrennt und hilft dabei, zu beurteilen, wie gut das Modell auf ungesehene Beispiele generalisiert. Der FluxTrainValidate-Knoten generiert Beispielbilder basierend auf den Validierungsdaten, die Ihnen eine visuelle Darstellung der Modellausgabe injson diesem Stadium geben.

Um den Trainingsfortschritt im Auge zu behalten, haben wir den VisualizeLoss-Knoten. Dieser praktische Knoten visualisiert den Trainingsverlust im Zeitverlauf und ermöglicht es Ihnen zu sehen, wie gut das Modell lernt und ob es sich einer guten Lösung annähert. Es ist, als hätten Sie einen persönlichen Trainer, der Ihre Fortschritte verfolgt und Ihnen hilft, auf Kurs zu bleiben.

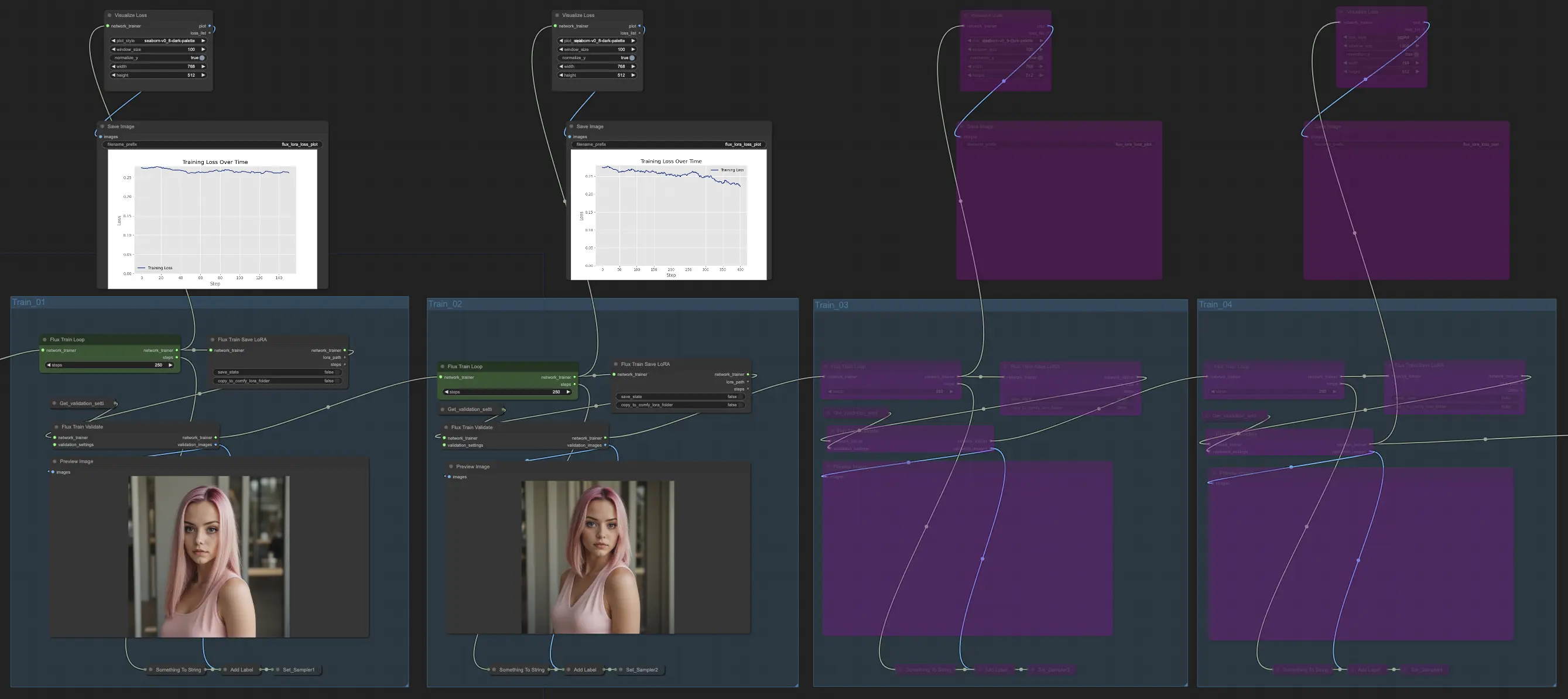

3.2. Train_02, Train_03, Train_04

In Train_02, fortsetzend von Train_01 im FLUX LoRA Training, wird der Output für eine weitere festgelegte Anzahl von Schritten (z.B. 250 Schritte) weiter trainiert. Train_03 und Train_04 folgen einem ähnlichen Muster und erweitern das Training mit aktualisierten Verbindungen für einen reibungslosen Ablauf. Jede Stufe gibt ein FLUX LoRA-Modell aus, das es Ihnen ermöglicht, die Leistung zu testen und zu vergleichen.

Beispiel

In unserem Beispiel haben wir uns entschieden, nur Train_01 und Train_02 zu verwenden, die jeweils für 250 Schritte laufen. Wir haben Train_03 und Train_04 vorerst umgangen. Aber fühlen Sie sich frei zu experimentieren und die Anzahl der Trainingsabschnitte und Schritte basierend auf Ihren spezifischen Bedürfnissen und Ressourcen anzupassen.

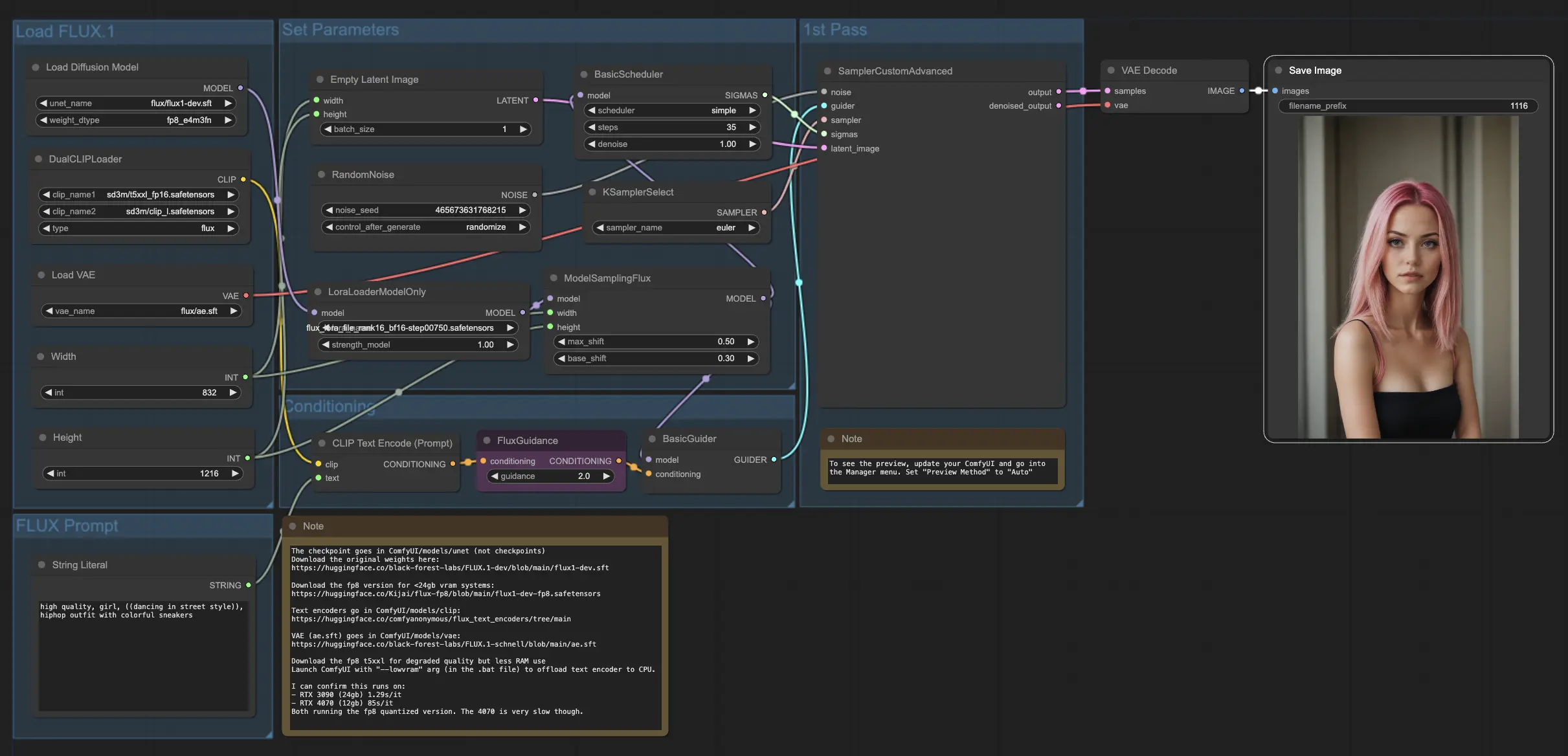

4. Wie und wo man die FLUX- und FLUX LoRA-Modelle verwendet

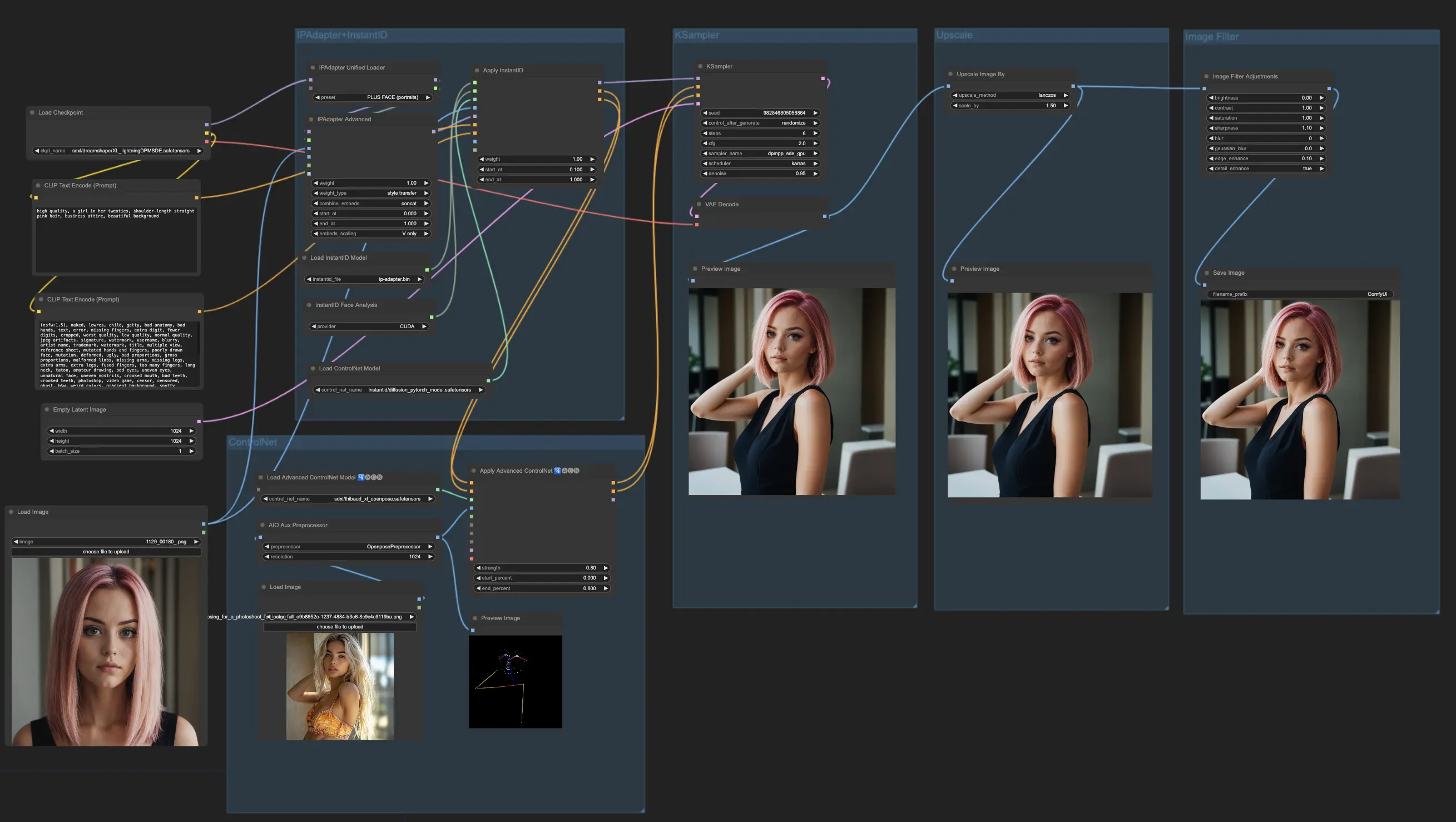

Sobald Sie das FLUX LoRA-Modell haben, können Sie es in den FLUX LoRA Workflow integrieren. Ersetzen Sie das vorhandene LoRA-Modell durch Ihr trainiertes Modell und testen Sie dann die Ergebnisse, um seine Leistung zu bewerten.

Beispiel

In unserem Beispiel verwenden wir den FLUX LoRA Workflow, um mehr Influencer-Bilder zu generieren, indem wir das FLUX LoRA-Modell anwenden und seine Leistung beobachten.

Lizenz

Lizenzdateien anzeigen:

flux/model_licenses/LICENSE-FLUX1-dev

flux/model_licenses/LICENSE-FLUX1-schnell

Das FLUX.1 [dev] Modell ist lizenziert von Black Forest Labs. Inc. unter der FLUX.1 [dev] Non-Commercial License. Copyright Black Forest Labs. Inc.

IN KEINEM FALL HAFTET BLACK FOREST LABS, INC. FÜR ANSPRÜCHE, SCHÄDEN ODER ANDERE HAFTUNG, OB AUS VERTRAG, UNERLAUBTER HANDLUNG ODER ANDERWEITIG, DIE AUS DER NUTZUNG DIESES MODELLS ENTSTEHEN ODER DAMIT IN VERBINDUNG STEHEN.