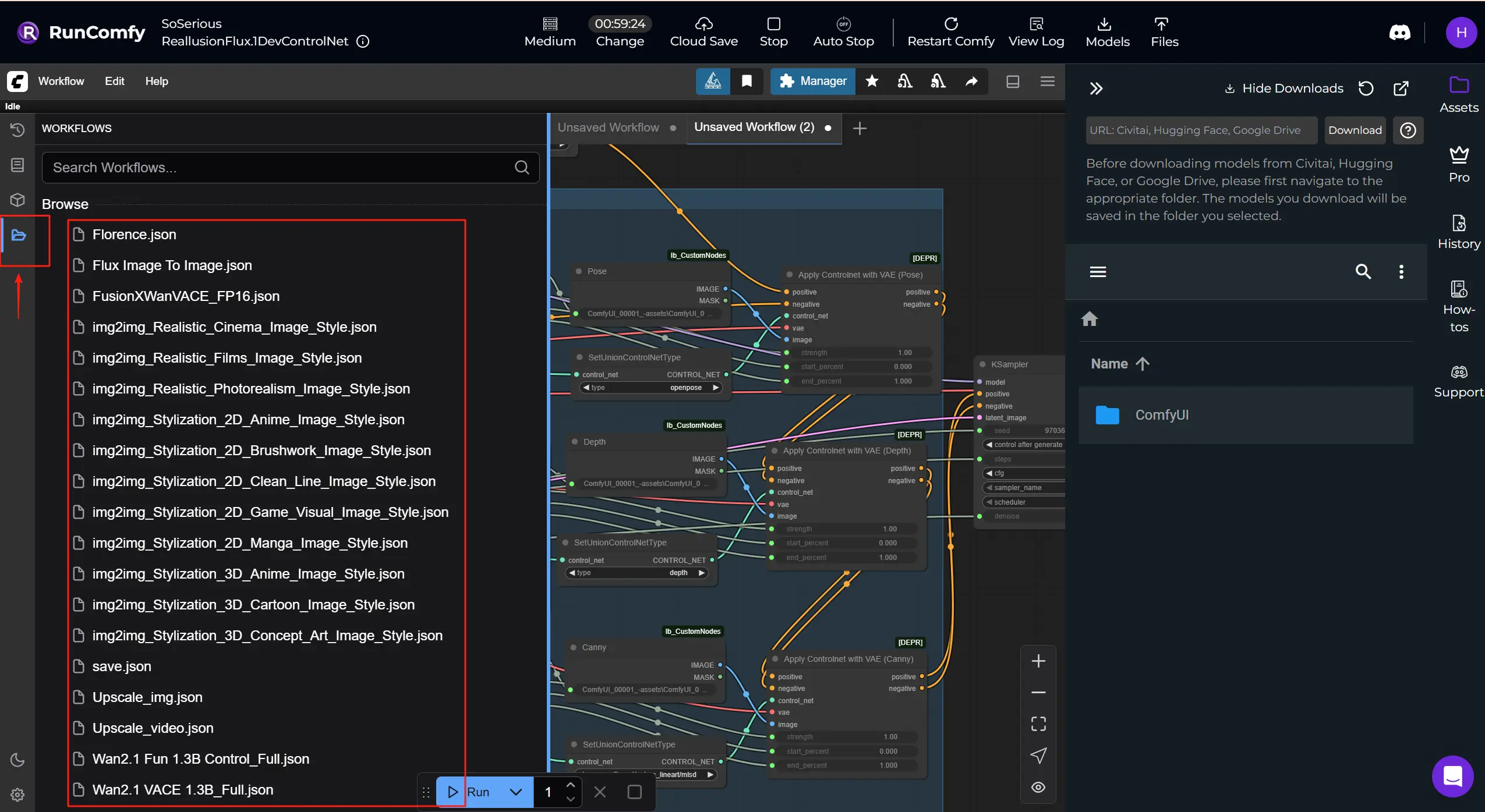

RunComfy 的云不限于 Reallusion AI Render 的 FLUX.1-dev ControlNet。您可以交换检查点、ControlNets、LoRAs、VAEs 和相关节点来运行下面列出的额外 Reallusion 工作流程 和 模型。

获取更多 Reallusion ComfyUI 工作流程:获取更多工作流程模板,您可以在 RunComfy 中下载并运行。点击 "Workflows" 按钮并尝试更多。

Reallusion 是实时 2D/3D 角色创建和动画软件的开发商,以 iClone 和 Character Creator 而闻名,广泛应用于电影/电视、游戏、建筑可视化、数字孪生和 AI 模拟。

Reallusion AI Render 是 3D 动画软件与 AI 驱动的内容生成工作流程之间的无缝桥梁。 将其视为一个 AI 渲染助手,直接从 iClone 或 Character Creator 接收到布局、姿势、摄像机或照明数据,然后利用这些上下文自动在 ComfyUI 中制作出丰富细节的图像或视频。这一集成将 Reallusion 的实时 3D 创建工具与 ComfyUI 的灵活、基于节点的 AI 处理架构结合在一起,使基于图像和视频的故事讲述既由艺术家驱动又受到 3D 数据的严格引导。Reallusion AI Render 支持多模式输入,如深度图、法线图、边缘检测(Canny)、3D 姿势数据和通过 IPAdapter 提供的风格图像。由于其自定义核心、ControlNet、附加图像和 Upscale 节点,它使动画师和开发者能够在插件控制下完全渲染一致的、风格化的、高质量的输出,而无需手动导航 ComfyUI。

通过解释结构化指令并将其与内部参数预设相结合,Reallusion AI Render 将基于提示的生成转变为精确、可复制的生产过程。 它为需要一致角色、细致风格控制和帧准确 AI 辅助序列渲染的电影、游戏或商业故事创作者量身定制。

直接插件集成:Reallusion AI Render 通过专用插件与 iClone 和 Character Creator 原生工作,实现实时反馈和控制,而无需离开您的生产工具。

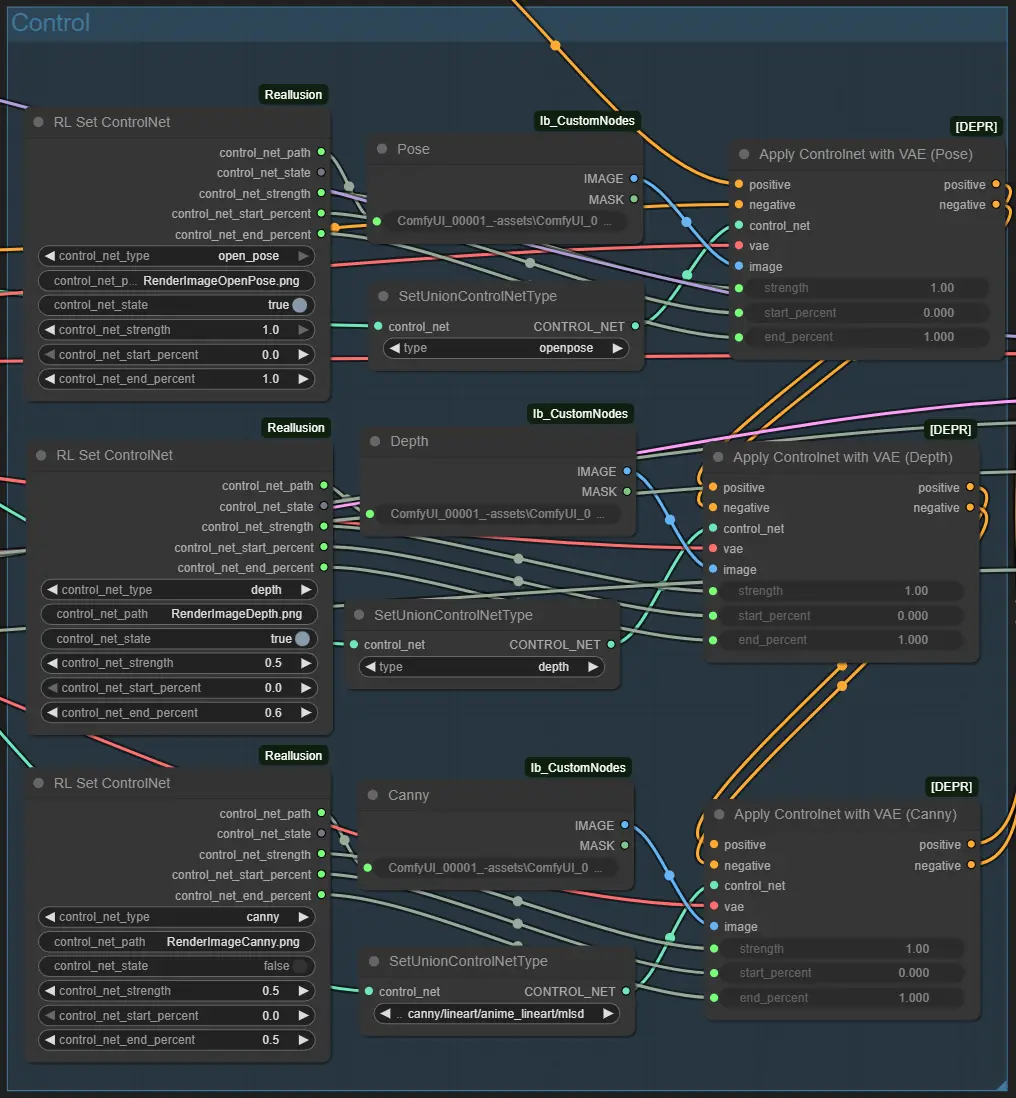

3D 引导 ControlNet:通过 Reallusion AI Render 的 ControlNet 节点,无缝将深度、姿势、法线和边缘数据从您的 3D 场景映射到 ComfyUI,实现电影级一致性和镜头级控制。

多图像风格支持:Reallusion AI Render 工作流程包括支持灵活风格混合和基于参考方向的附加图像节点,轻松重用外观或执行高级 IP 自适应渲染。

智能放大工作流程:专用的 UpscaleData 节点允许创作者在 Reallusion AI Render 插件中定义输出分辨率,确保最终渲染符合项目规格而无需猜测。

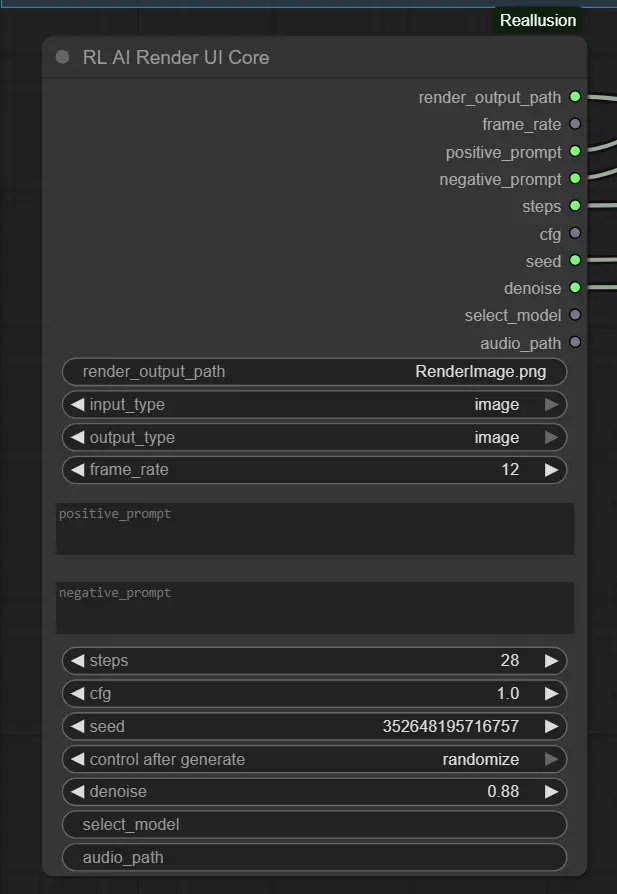

全工作流程自动化:与通用 ComfyUI 工作流程不同,Reallusion AI Render 设计用于自动化,模型、采样步骤、CFG 和音频同步等参数通过编程方式传递,准备好批量渲染或自定义预设。

生产就绪的角色一致性:与 LoRA 训练和 IP 创建工具配对,Reallusion AI Render 在视频序列中保持面部完整性和视觉保真度,使其成为 AI 驱动的故事讲述的理想选择。

Reallusion AI Render 基本工作流程

1.准备好您的图像

使用 Reallusion iClone 或 Character Creator 的 AI Render 插件导出任何图像。确保图像使用默认插件路径结构保存。这可确保所有指导/控制图像(例如,姿势、深度)自动生成并正确链接。

请将图像上传到 ComfyUI -> input 文件夹。确保文件名与 Node 中指定的 render_output_path 一致。

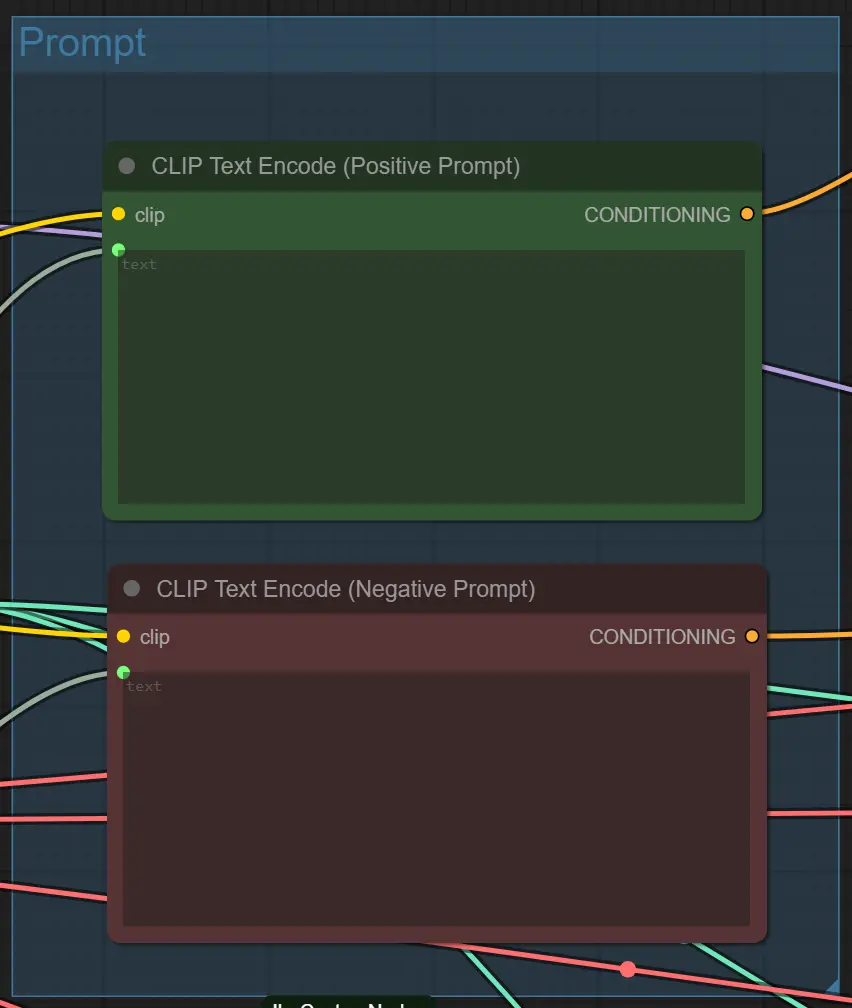

2.设置提示和风格

在 iClone 或 Character Creator AI Render 插件 UI 中编写明确的正面提示(您想要的)和负面提示(要避免的)。工作流程将使用这些来指导输出的外观和细节。

3.连接机器并使用 AI Render-⭐重要

要开始,请在 iClone 或 Character Creator 中启动 AI Render 插件,并通过从 RunComfy URL 复制粘贴 id 来连接 ComfyUI 云到 AI Render。一旦连接,插件将自动从 ComfyUI 管道发送您预览的图像或视频。

此设置确保 AI Render 与您的机器无缝通信,让您实时预览、调整和完善结果。通过保持连接稳定,您的 姿势、深度和风格指导 将在每次渲染中保持准确。

👉 在此观看完整的分步视频指南:YouTube 教程

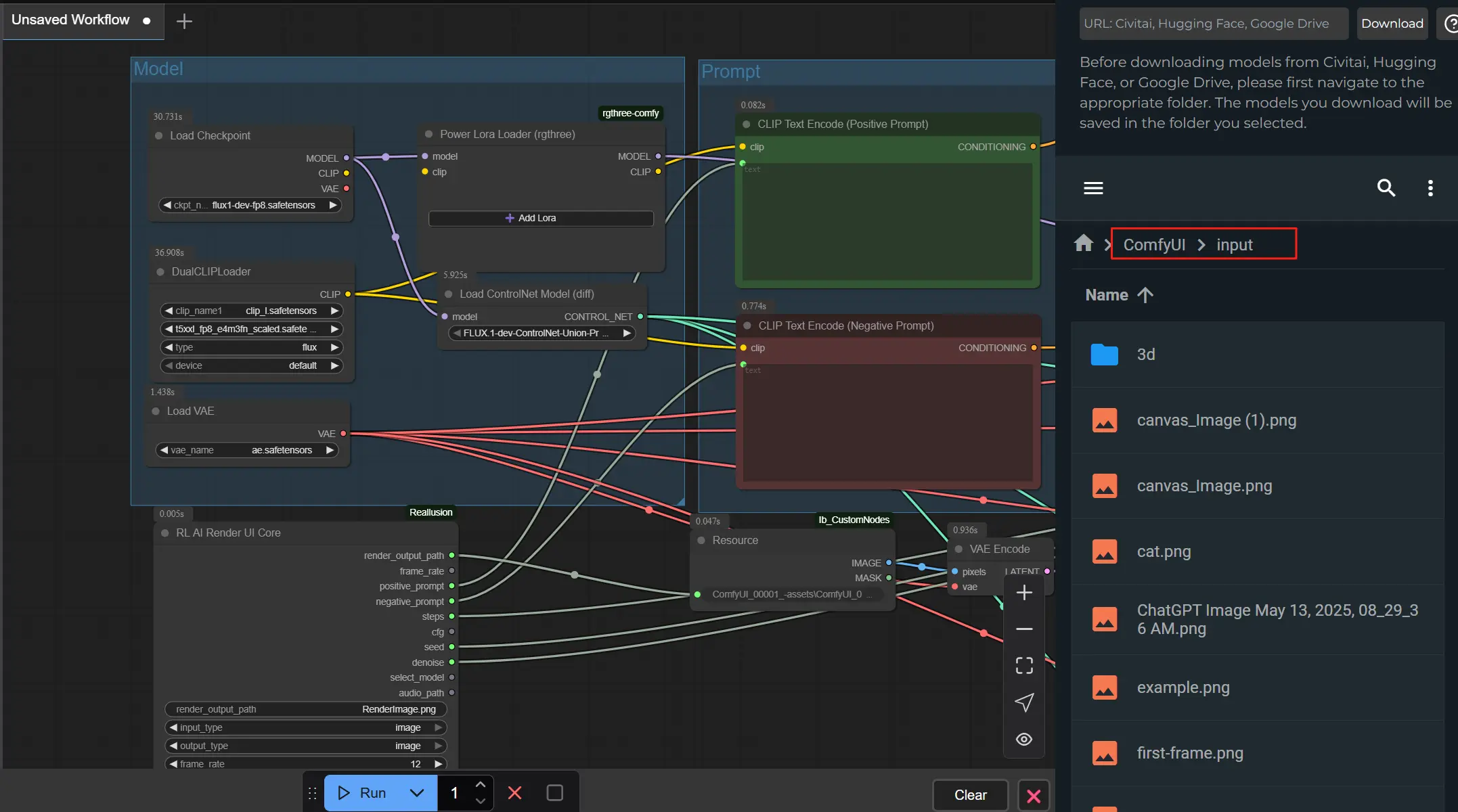

节点基本设置

1. 提示和质量设置 – RL AI Render UI 核心节点 此节点收集来自 AI Render 插件的主要参数。

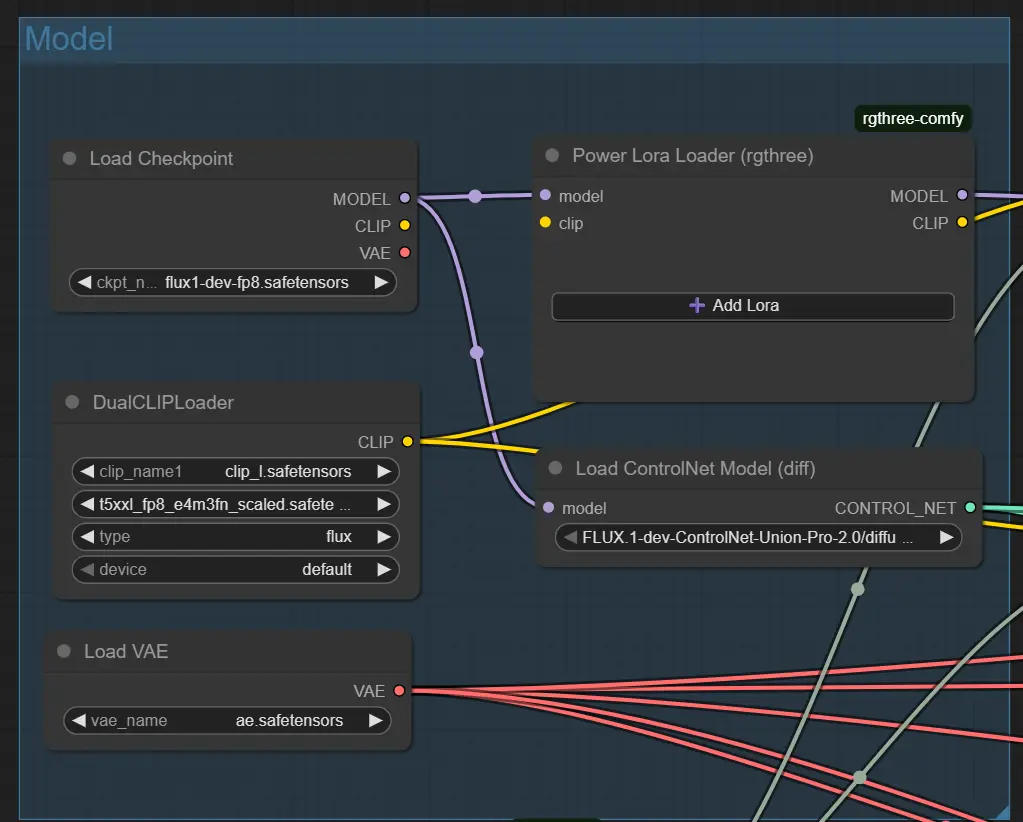

2. 基础模型设置 – 加载检查点节点

此节点加载您选择的模型(例如,Flux 1 Dev ControlNet)。

ckpt_name:必须匹配您的风格期望的模型(默认:flux1-dev-fp8.safetensors)。

使用支持 IPAdapter 或 ControlNet 的模型以获得最佳效果。

3. 结构指导 – ControlNet 节点(姿势、深度、Canny) 每个 ControlNet 节点加载一个特定的输入文件(例如,姿势图像);只有在启用控制时才激活。

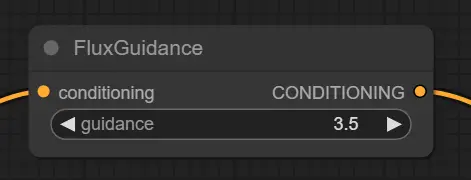

4. 提示条件 – Flux 指导节点 调整提示如何塑造图像生成。

5. 文本提示编码 – CLIP 文本编码节点 从您的提示生成向量指导。

高级节点提示

提示清晰度

避免过于复杂或模糊的提示。使用直接风格如 cinematic lighting、anime 或 cyberpunk alley。具体说明以获得更可控的结果。

平衡去噪和结构 如果启用了 ControlNet(例如深度 + 姿势),高去噪如 0.88 可能会扰乱结构。当保留布局优先时,尝试 0.6–0.75。

将输入与 ControlNet 匹配

只有在存在匹配的指导图像时才启用 ControlNet(例如,RenderImageDepth.png 用于深度)。不匹配可能导致提示失败或结果为空。

此工作流程集成了由 Kijai 开发的 Flux-FP8 模型,并结合了 Reallusion 团队在其官方 AI 渲染 工作流程指南 中概述的性能优化技术。特别感谢 Kijai 为模型开发做出的贡献,以及 Reallusion 分享的宝贵见解,提升了 ComfyUI 工作流程中的 AI 渲染效率。

探索与 Reallusion AI Render 相关的技术资源和文档。

RunComfy 是首选的 ComfyUI 平台,提供 ComfyUI 在线 环境和服务,以及 ComfyUI 工作流 具有惊艳的视觉效果。 RunComfy还提供 AI Playground, 帮助艺术家利用最新的AI工具创作出令人惊叹的艺术作品。