Ostris AI Toolkit으로 LoRA를 학습했다면(예: FLUX / FLUX.2, Wan 2.2/2.1, Qwen Image, Z‑Image, LTX‑2, SDXL 등) 이런 문제를 겪기 쉽습니다: AI Toolkit의 training samples는 좋은데, Diffusers / ComfyUI / 다른 스택에서 추론하면 결과가 드리프트합니다.

이 가이드는 AI Toolkit 학습 프리뷰(샘플)와 일치하는 추론을 빠르고 안정적으로 얻는 방법을 설명합니다.

왜 AI Toolkit 프리뷰가 추론과 잘 안 맞을까?

AI Toolkit의 “Samples”는 특정 추론 설정으로 생성됩니다:

- 정확한 베이스 모델 변형(버전)

- 모델별 scheduler/steps 의미

- 모델별 LoRA 적용(어댑터 vs fuse/merge)

- 해상도 스냅(가로/세로 배수 규칙)

- 일부 파이프라인에서 필요한 입력(예: edit / I2V의 control image)

추론 스택이 이 중 하나라도 바꾸면, 같은 prompt + seed라도 결과가 달라질 수 있습니다. 즉, 프리뷰를 맞추려면 추론 파이프라인 전체를 맞춰야 합니다.

RunComfy에서 training samples와 같은 결과를 만들 수 있는 이유

RunComfy는 AI Toolkit이 해당 모델의 프리뷰를 생성할 때 사용하는 것과 동일한 베이스 모델별 Diffusers 추론 파이프라인을 실행합니다. 또한 Training config file (YAML)을 읽어 같은 베이스 모델 변형과 중요한 추론 기본값을 고정하기 때문에, Run LoRA inference가 training samples와 1:1에 가깝게 맞출 수 있습니다. 게다가 추론은 관리형 클라우드 런타임에서 실행되므로 CUDA/PyTorch/Diffusers 버전 차이로 인한 드리프트도 줄어듭니다.

패리티 테스트 예시:

| AI Toolkit training sample | RunComfy inference (Playground/API) | ||

|---|---|---|---|

|

|

|

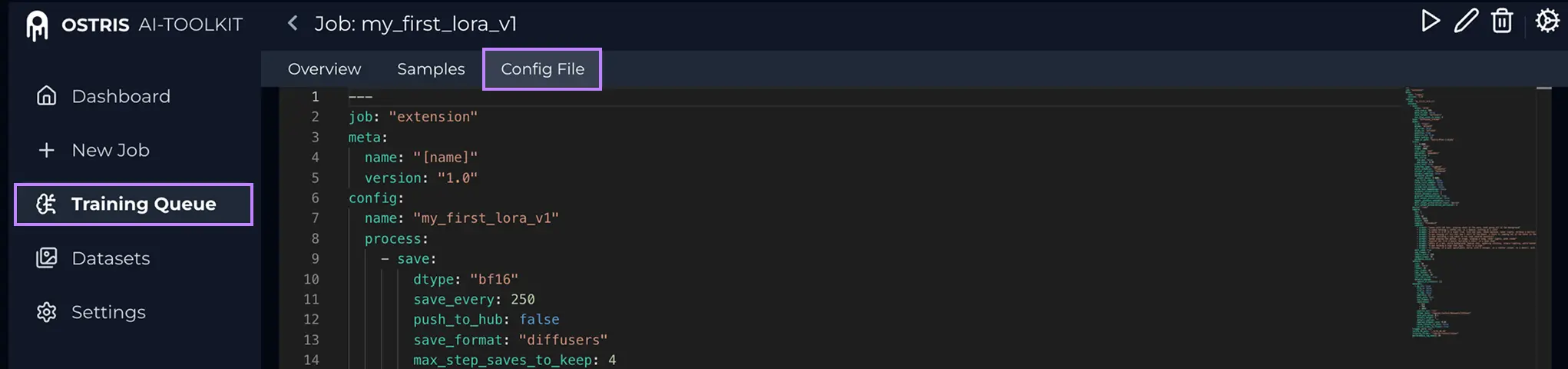

Step 0 — AI Toolkit job에서 두 파일 준비보통 필요: 1) LoRA weights: 2) Training config file (YAML) ( Config File (YAML)이란? AI Toolkit에서 Training Job을 열고 상단의 Config File을 눌러 YAML을 확인합니다. 전체를 복사해 .yaml로 저장한 뒤 업로드하세요.

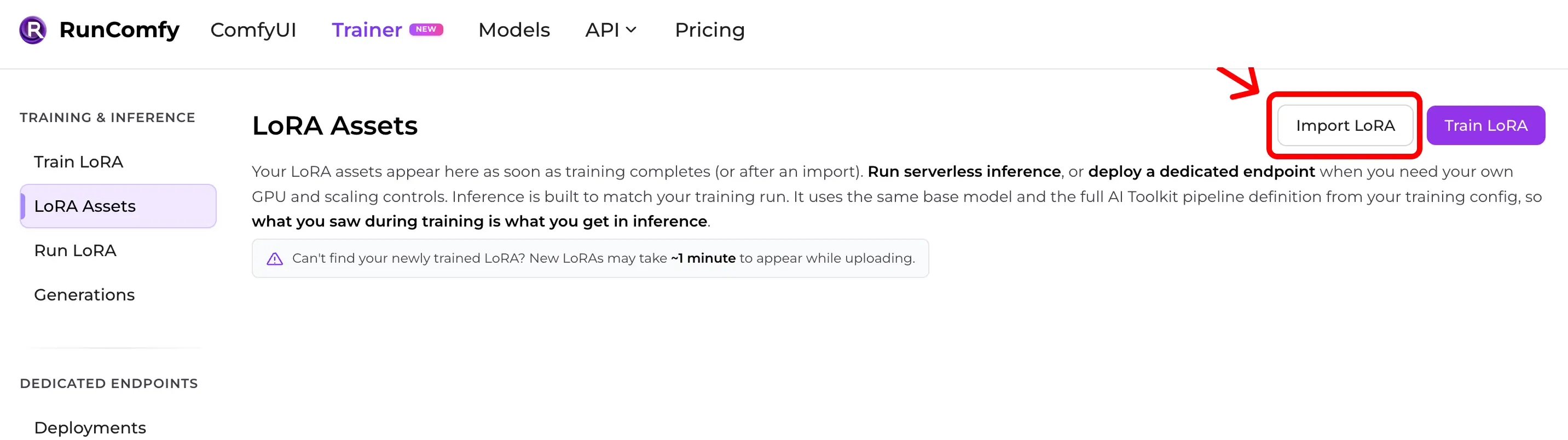

YAML이 중요한 이유: training samples를 만든 정확한 base model과 추론 기본값을 RunComfy가 맞출 수 있습니다. Step 1 — RunComfy로 AI Toolkit LoRA 임포트경로: Trainer → LoRA Assets → Import LoRA 업로드:

YAML이 없으면 Base Model을 수동 선택해도 되지만, defaults가 달라지면 패리티가 깨질 수 있습니다.

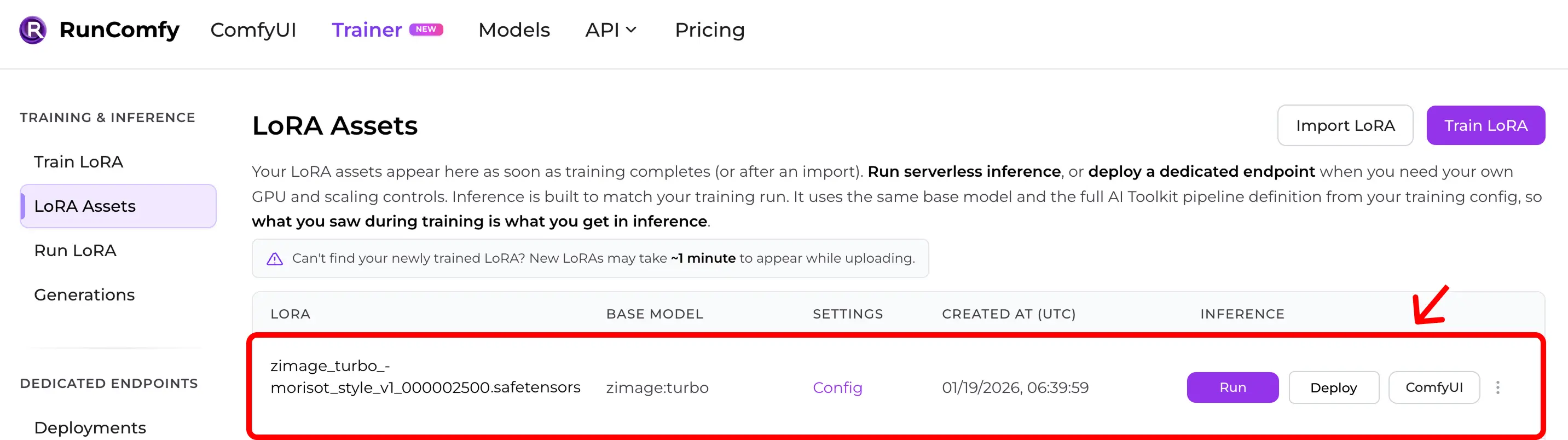

Step 2 — LoRA Assets에 표시되는지 확인임포트 후(또는 클라우드 학습 완료 후) LoRA는 LoRA Assets에 나타납니다. 여기서 Run (Run LoRA)을 눌러 추론(Playground + API)을 시작할 수 있습니다.

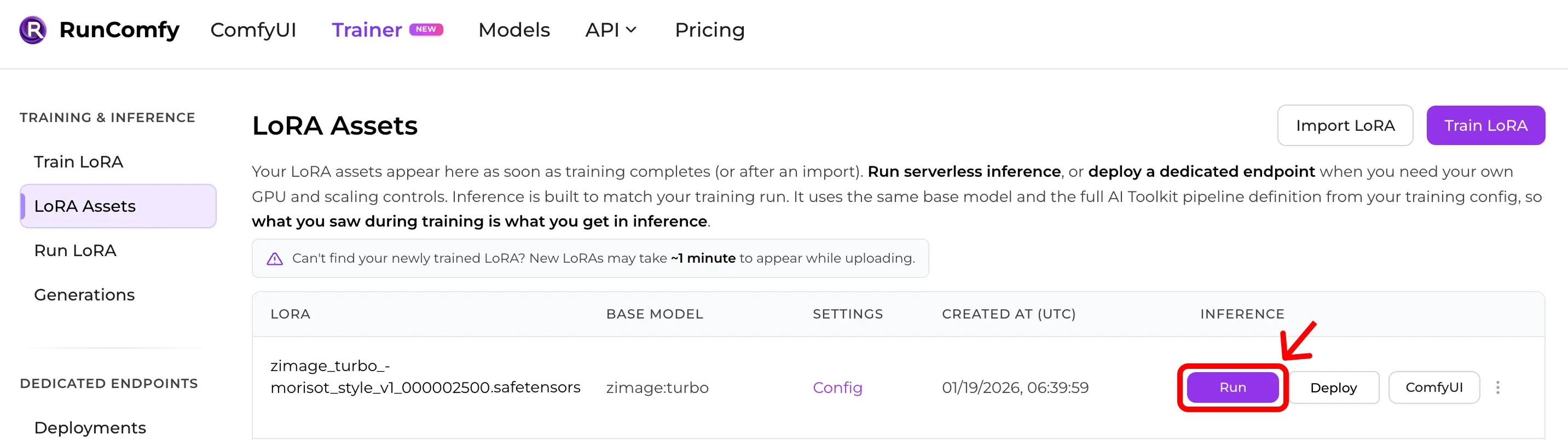

Step 3 — Run LoRA로 즉시 추론LoRA Assets에서 LoRA를 찾아 Run 클릭. Run LoRA는 training YAML의 pipeline 정의와 동일한 base model을 사용하는 on‑demand 추론입니다. 수동으로 재구성하지 않고도 preview‑parity를 얻을 수 있습니다. Playground에서 테스트하거나 API로 통합할 수 있습니다.

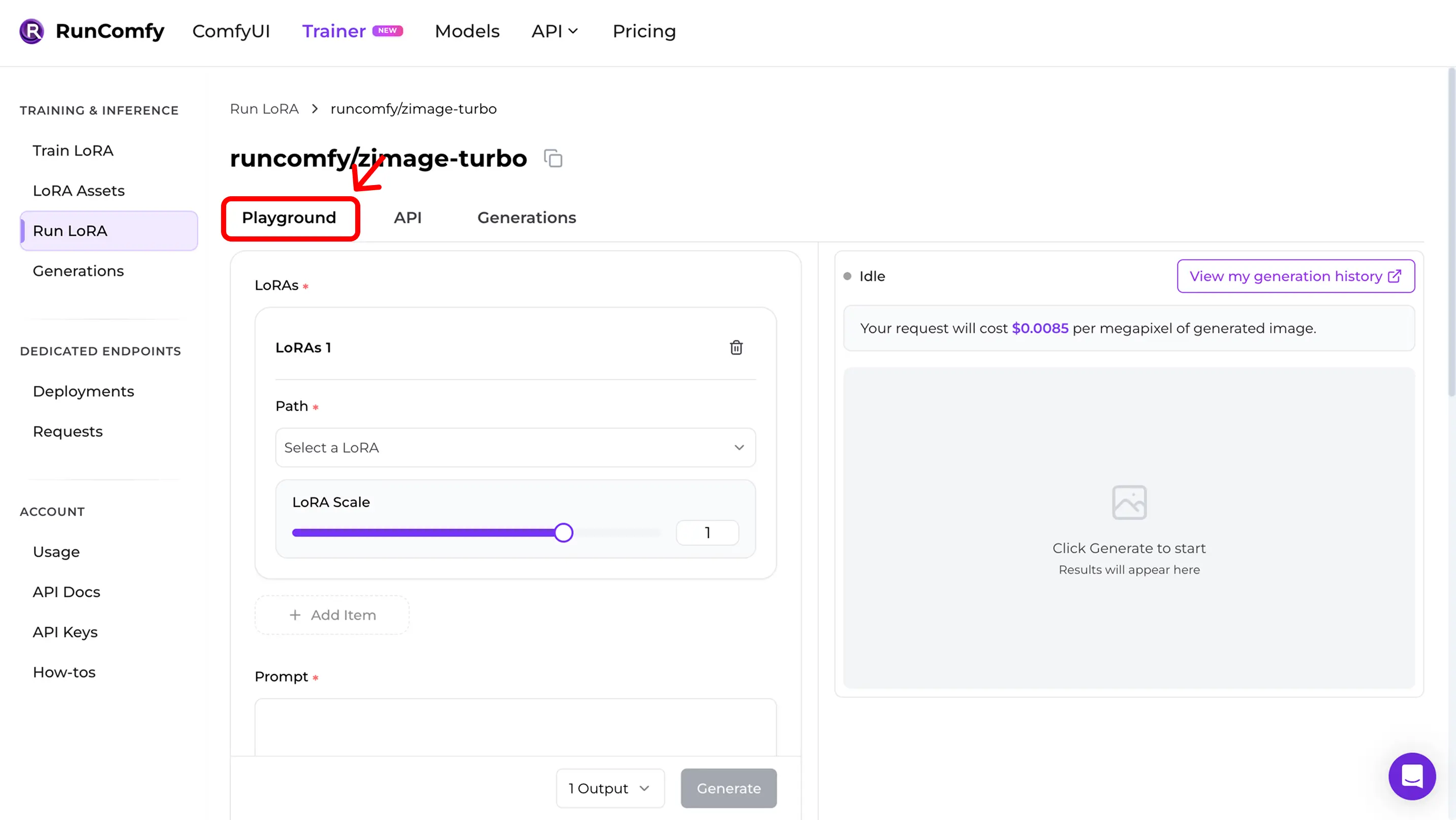

Step 4 — Playground에서 training samples 재현Run 후 Run LoRA Playground로 이동합니다. 여기서 패리티를 확인하세요:

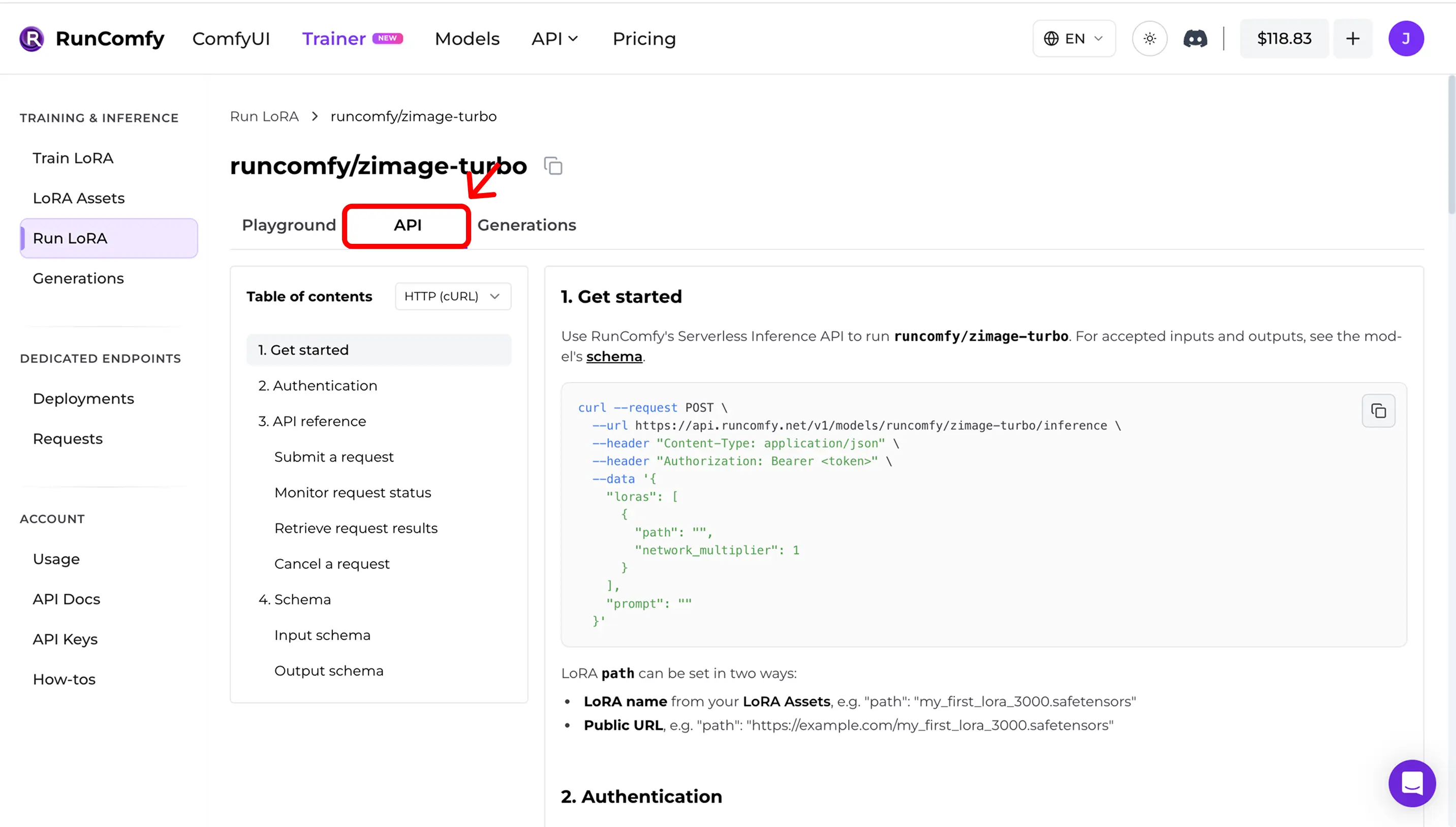

Step 5 — 프로덕션에서 API 사용 (async inference)Run LoRA의 API 탭을 여세요. API는 비동기입니다:

대시보드에서 URL과 request schema를 그대로 복사하세요. 예시(설명용): API docs: RunComfy Model API (see also LoRA inputs (Trainer)) Quick mismatch checklist안 맞을 때는 다음을 확인하세요: 1) Exact base model (repo + variant) 2) Width/height after snapping to the model’s divisor 3) Steps + guidance + scheduler semantics 4) LoRA application mode (adapter vs fuse/merge) 5) For edit / I2V: correct control image inputs 6) Runtime drift (Diffusers / ComfyUI versions) Open-source reference implementationComfyUI에서 추론하면서 training samples / previews와 맞추고 싶나요? 참고: AI Toolkit LoRA in ComfyUI: Parity Workflows 검토/셀프호스팅: Open-source AI Toolkit inference code → runcomfy-com/ai-toolkit-inference FAQ임포트에 YAML이 꼭 필요한가요?강력 추천입니다. YAML 없이 base model을 수동 선택할 수 있지만, 모델별 defaults 매칭이 깨지기 쉽습니다. RunComfy 밖에서 학습한 LoRA도 임포트할 수 있나요?네. AI Toolkit으로 학습했다면 “Run LoRA”는 무슨 뜻인가요?전용 endpoint를 배포하지 않고 base model 위에서 LoRA를 실행하는 on‑demand 추론(Playground + API)입니다. 요청 단위로 과금됩니다. Ready to start training? |