Se hai addestrato una LoRA con Ostris AI Toolkit (per FLUX / FLUX.2, Wan 2.2/2.1, Qwen Image, Z‑Image, LTX‑2, SDXL, ecc.), probabilmente hai già visto questo problema: i training samples di AI Toolkit sono ottimi, ma quando fai inferenza in Diffusers / ComfyUI / un altro stack l’output deriva.

Questa guida mostra un percorso rapido e affidabile per ottenere inferenzia che combacia con i preview di training di AI Toolkit, così quello che rilasci è coerente con ciò che hai addestrato.

Perché i preview AI Toolkit spesso non combaciano con l’inferenza

I “Samples” di AI Toolkit vengono generati con un setup di inferenza specifico:

- variante esatta del modello base

- semantica scheduler/steps specifica del modello

- modalità di applicare LoRA specifica del modello (adapter vs fuse/merge)

- regole di snapping della risoluzione (multipli di larghezza/altezza)

- input richiesti per alcune pipeline (es. control image per edit / I2V)

Se il tuo stack di inferenza cambia anche solo uno di questi punti, anche con stesso prompt + seed, il risultato può cambiare. In breve: per matchare il preview devi matchare l’intero pipeline di inferenza (non solo qualche setting).

Perché RunComfy può far combaciare inferenza e training samples

RunComfy esegue una pipeline Diffusers specifica per modello base che corrisponde a quella usata da AI Toolkit per generare i preview di quel modello. Inoltre legge il tuo Training config file (YAML) per fissare la stessa variante di base e i defaults di inferenza critici, così Run LoRA inference può combaciare 1:1 con i training samples. E dato che l’inferenza gira in un runtime cloud gestito, eviti drift silenzioso di versioni CUDA/PyTorch/Diffusers che cambia i risultati.

Esempio dal nostro test di parità:

| AI Toolkit training sample | RunComfy inference (Playground/API) | ||

|---|---|---|---|

|

|

|

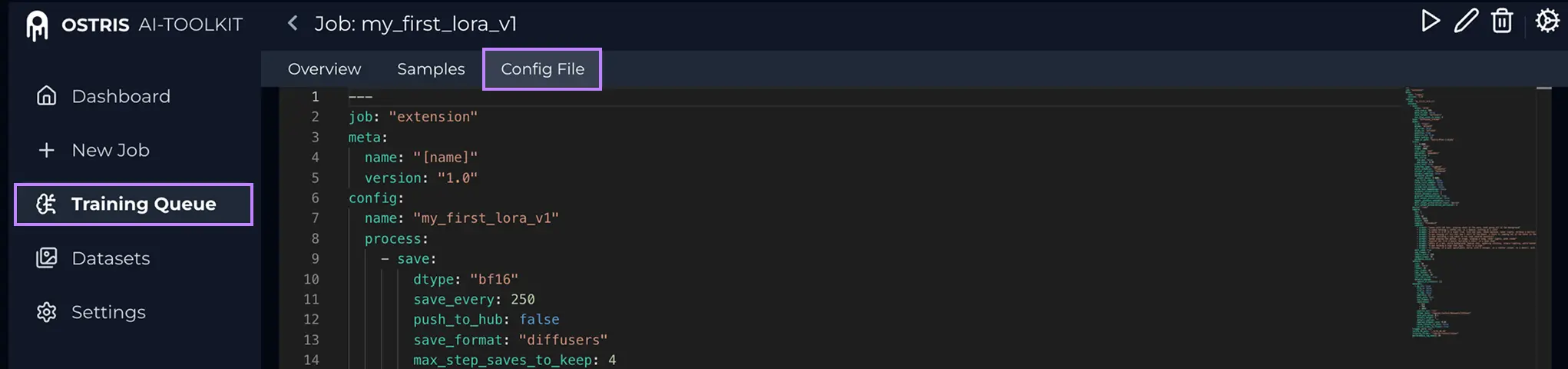

Step 0 — Prepara due file dal tuo job AI ToolkitDi solito servono: 1) LoRA weights: 2) Training config file (YAML) del job (spesso Cos’è il Config File (YAML)? In AI Toolkit, apri il Training Job e clicca Config File per vedere il YAML esatto. Copia tutto e salvalo come .yaml per caricarlo qui.

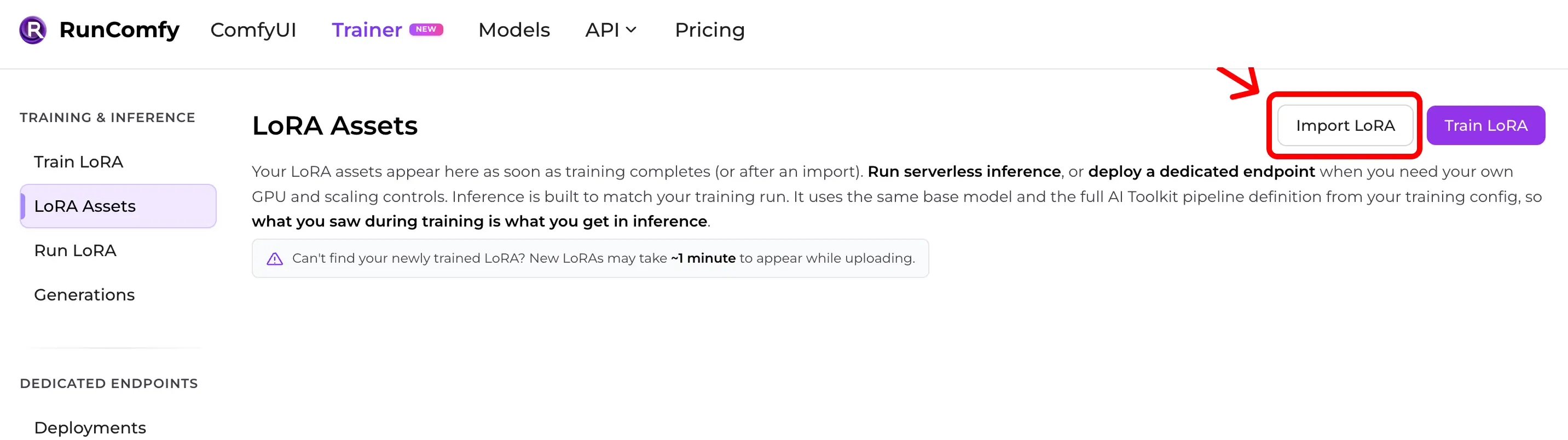

Perché il YAML è importante: consente a RunComfy di matchare base model e defaults di inferenza che hanno prodotto i samples. Step 1 — Importa una LoRA AI Toolkit in RunComfyPercorso: Trainer → LoRA Assets → Import LoRA Carica:

Senza YAML puoi importare scegliendo il Base Model, ma la parità può peggiorare se i defaults sono diversi.

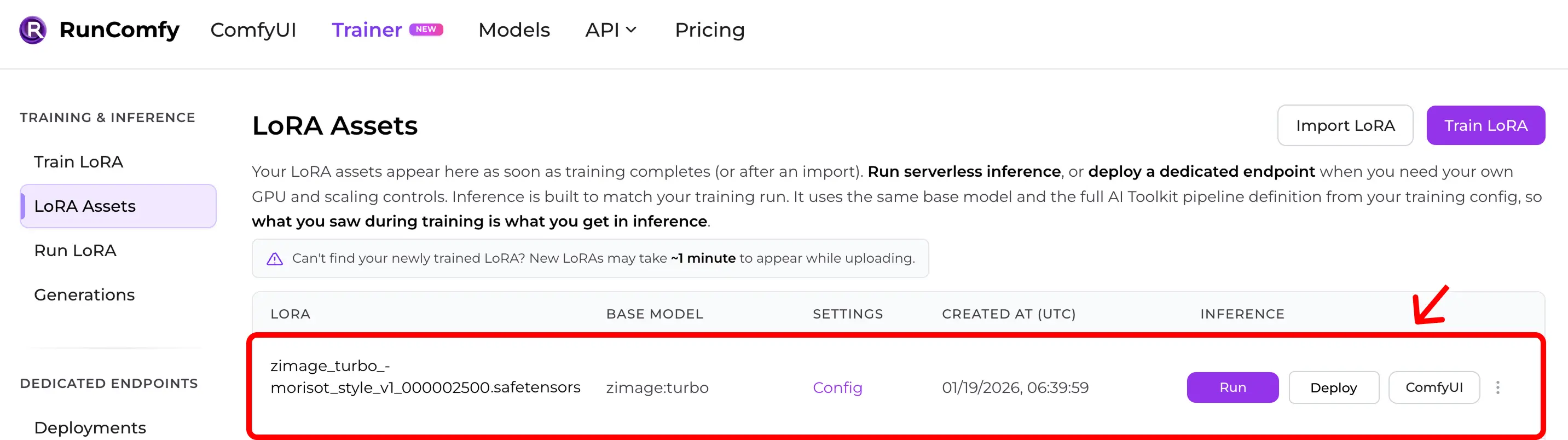

Step 2 — Verifica che appaia in LoRA AssetsDopo l’import (o fine training cloud), la LoRA appare in LoRA Assets. Da lì clicca Run (Run LoRA) per iniziare inferenza (Playground + API).

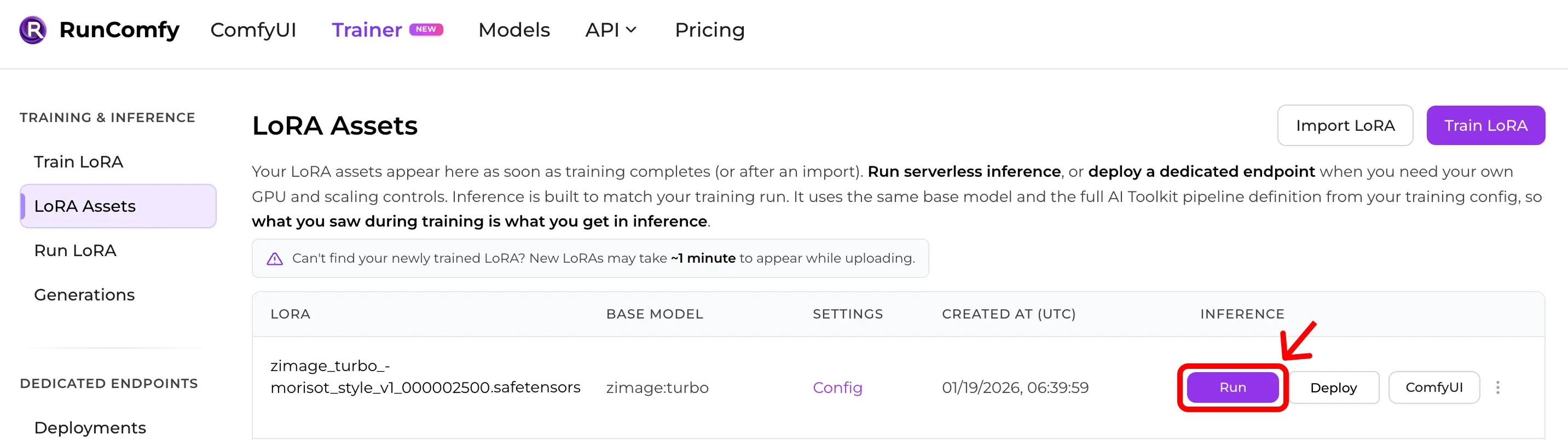

Step 3 — Avvia inferenza subito (Run LoRA)In LoRA Assets trova la LoRA e clicca Run. Questo avvia Run LoRA: inferenza on‑demand che usa lo stesso base model e la stessa definizione di pipeline dal YAML di training, per ottenere preview‑parity senza ricostruire tutto. Puoi testare nel Playground o usare la stessa configurazione via API.

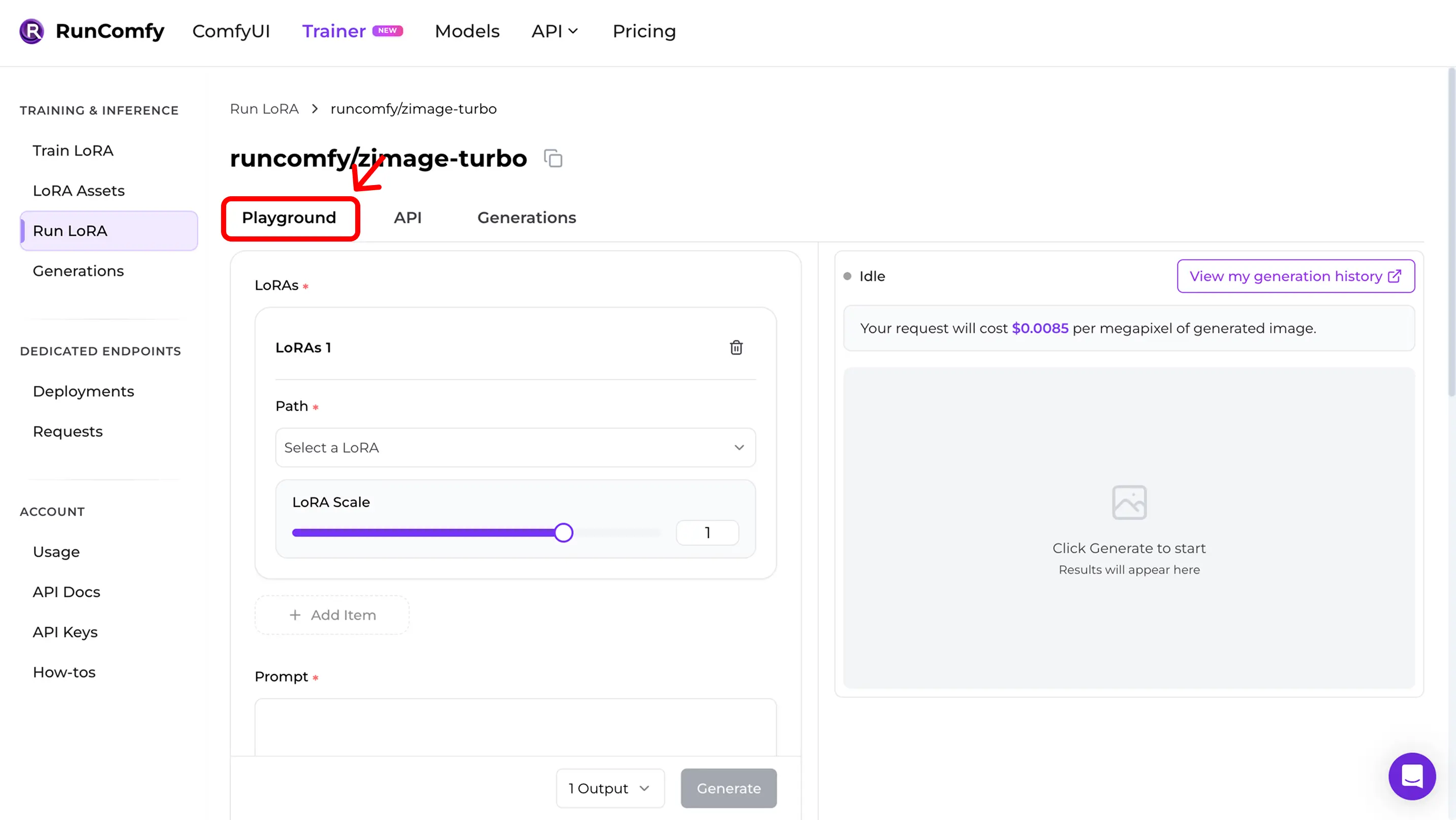

Step 4 — Riproduci training samples nel PlaygroundDopo Run, entri nel Run LoRA Playground. Qui validi la parità:

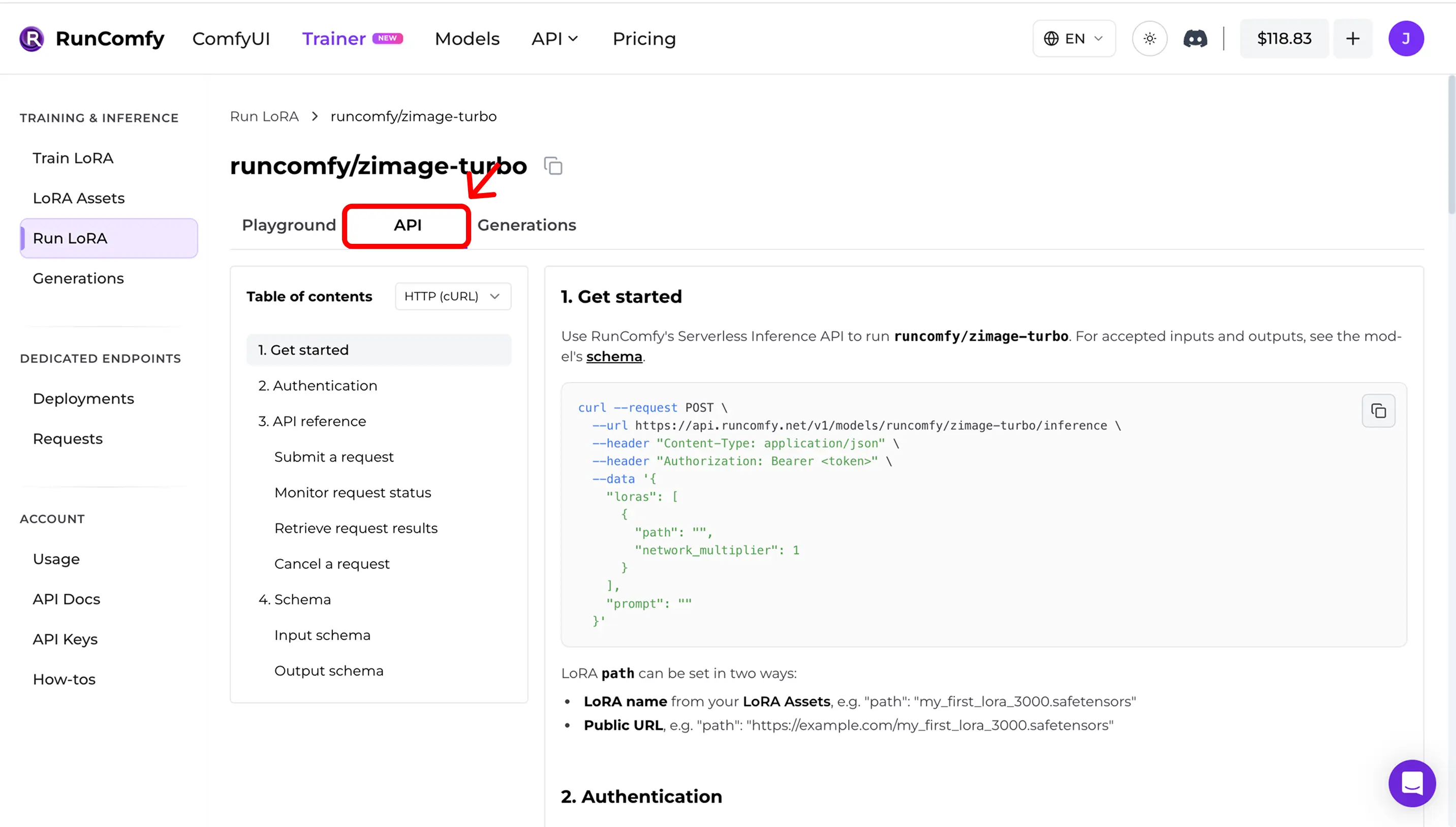

Step 5 — Usa l’API in produzione (async inference)In Run LoRA, apri la tab API. L’API è asincrona:

Copia URL e request schema dal dashboard. Esempio (illustrativo — usa API docs: RunComfy Model API (see also LoRA inputs (Trainer)) Quick mismatch checklistSe non coincide, controlla: 1) Exact base model (repo + variant) 2) Width/height after snapping al divisore del modello 3) Steps + guidance + scheduler semantics 4) LoRA application mode (adapter vs fuse/merge) 5) Per edit / I2V: corretti control image inputs 6) Drift runtime (Diffusers / ComfyUI versions) Riferimento open sourceVuoi fare inferenza in ComfyUI e rimanere coerente con training samples / previews? Vedi: AI Toolkit LoRA in ComfyUI: Parity Workflows Per audit / self‑host: Open-source AI Toolkit inference code: runcomfy-com/ai-toolkit-inference FAQServe il YAML per importare?Consigliatissimo. Senza YAML puoi scegliere un base model manualmente, ma perdi il matching automatico dei defaults specifici del modello. Posso importare una LoRA addestrata fuori RunComfy?Sì. Se è addestrata con AI Toolkit, importa Cosa significa “Run LoRA” qui?Run LoRA è inferenza on‑demand (Playground + API) che esegue una LoRA sul suo base model senza deployare un endpoint dedicato. Billing per request. Pronto per iniziare l'addestramento? |