Si vous avez entraîné une LoRA avec Ostris AI Toolkit (pour FLUX / FLUX.2, Wan 2.2/2.1, Qwen Image, Z‑Image, LTX‑2, SDXL, etc.), vous avez probablement déjà vu ce problème : vos training samples AI Toolkit sont super, mais en inférence dans Diffusers / ComfyUI / un autre stack, le rendu dérive.

Ce guide montre une méthode rapide et fiable pour obtenir une inférence qui match vos previews d’entraînement AI Toolkit, afin que ce que vous déployez ressemble à ce que vous avez entraîné.

Pourquoi les previews AI Toolkit ne matchent pas l’inférence

Les “Samples” d’AI Toolkit sont générés avec une configuration d’inférence précise :

- variante exacte du modèle de base

- sémantique scheduler/steps spécifique au modèle

- mode d’application LoRA spécifique au modèle (adapter vs fuse/merge)

- règles de snapping de résolution (multiples largeur/hauteur)

- inputs requis pour certaines pipelines (ex. control image pour edit / I2V)

Si votre stack d’inférence change l’un de ces points, même avec le même prompt + seed, le résultat peut dériver. En bref : pour matcher le preview, il faut matcher tout le pipeline d’inférence (pas seulement quelques réglages).

Pourquoi RunComfy peut matcher l’inférence avec vos training samples

RunComfy exécute une pipeline Diffusers spécifique au modèle de base, alignée sur celle utilisée par AI Toolkit pour générer les previews de ce modèle. RunComfy lit aussi votre Training config file (YAML) pour fixer la même variante de base et les defaults d’inférence importants, ce qui permet à Run LoRA inference de matcher 1:1 vos training samples. Et comme l’inférence tourne dans un runtime cloud managé, vous évitez aussi les dérives silencieuses de versions CUDA/PyTorch/Diffusers qui modifient les outputs.

Exemple de notre test de parité (AI Toolkit training samples vs Run LoRA inference, mêmes settings) :

| AI Toolkit training sample | RunComfy inference (Playground/API) | ||

|---|---|---|---|

|

|

|

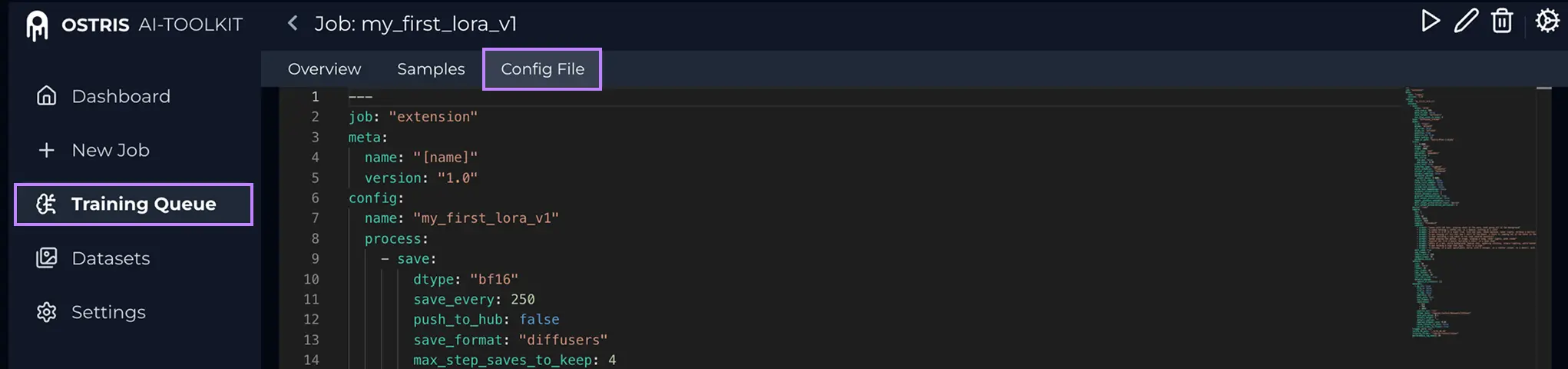

Step 0 — Préparer deux fichiers depuis votre job AI ToolkitVous avez généralement besoin : 1) LoRA weights : 2) Training config file (YAML) du job (souvent Qu’est‑ce que le Config File (YAML) ? Dans AI Toolkit, ouvrez votre Training Job et cliquez sur Config File pour voir le YAML exact. Copiez tout et sauvegardez en .yaml pour l’uploader ici.

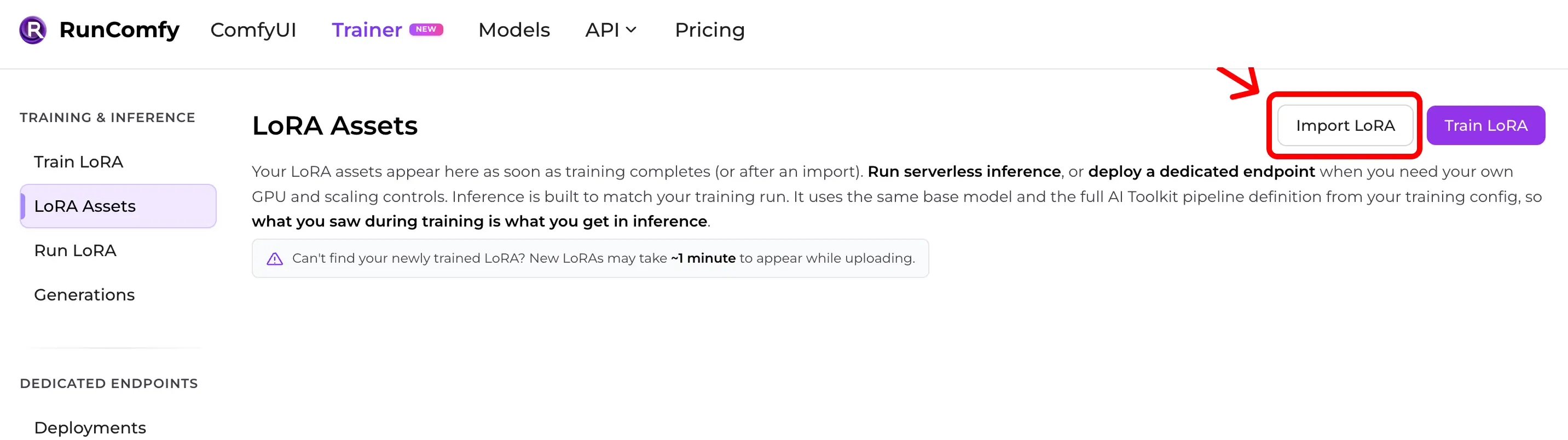

Pourquoi le YAML compte : il permet à RunComfy de matcher le base model exact et les defaults d’inférence qui ont produit vos samples. Step 1 — Importer une LoRA AI Toolkit dans RunComfyChemin : Trainer → LoRA Assets → Import LoRA Uploader :

Sans YAML, vous pouvez importer en choisissant le Base Model, mais la parité peut se dégrader si les defaults diffèrent.

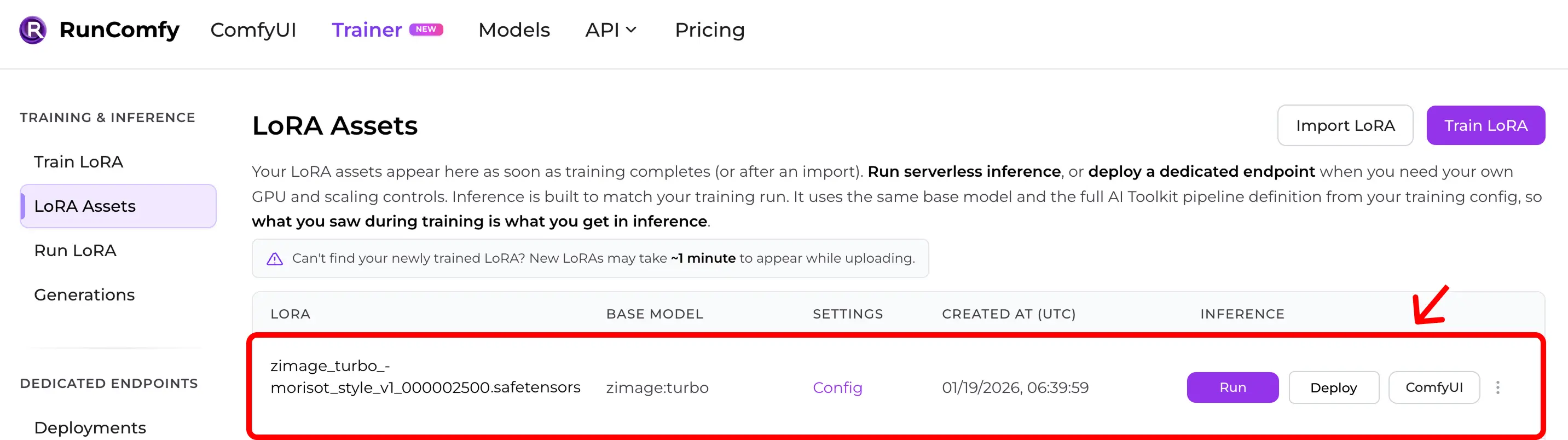

Step 2 — Vérifier que la LoRA apparaît dans LoRA AssetsAprès import (ou fin d’un entraînement cloud), la LoRA apparaît dans LoRA Assets. Depuis là, cliquez Run (Run LoRA) pour démarrer l’inférence (Playground + API).

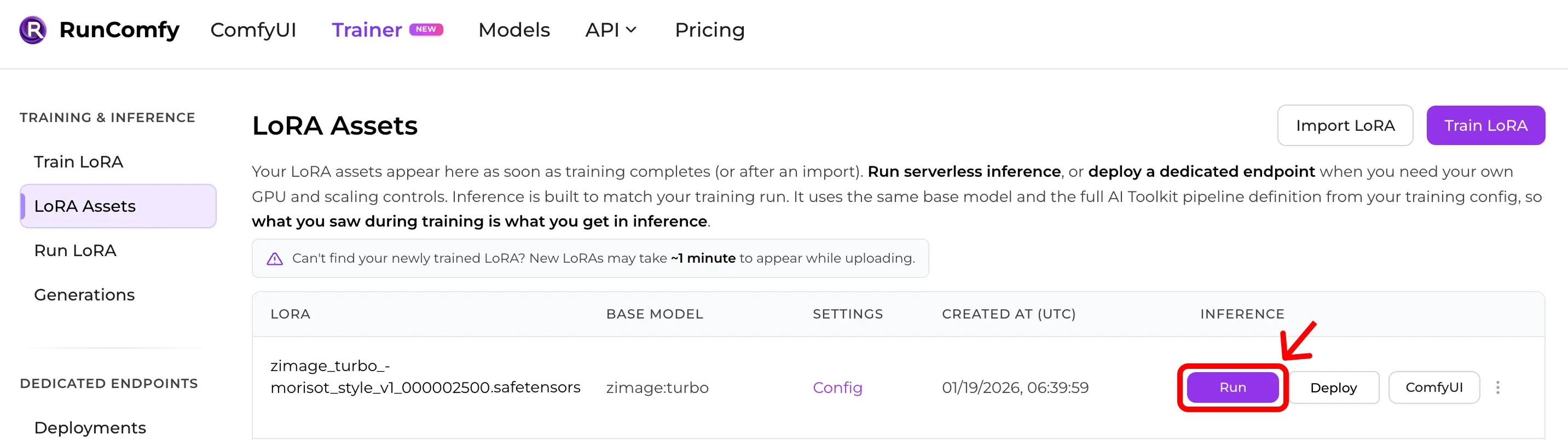

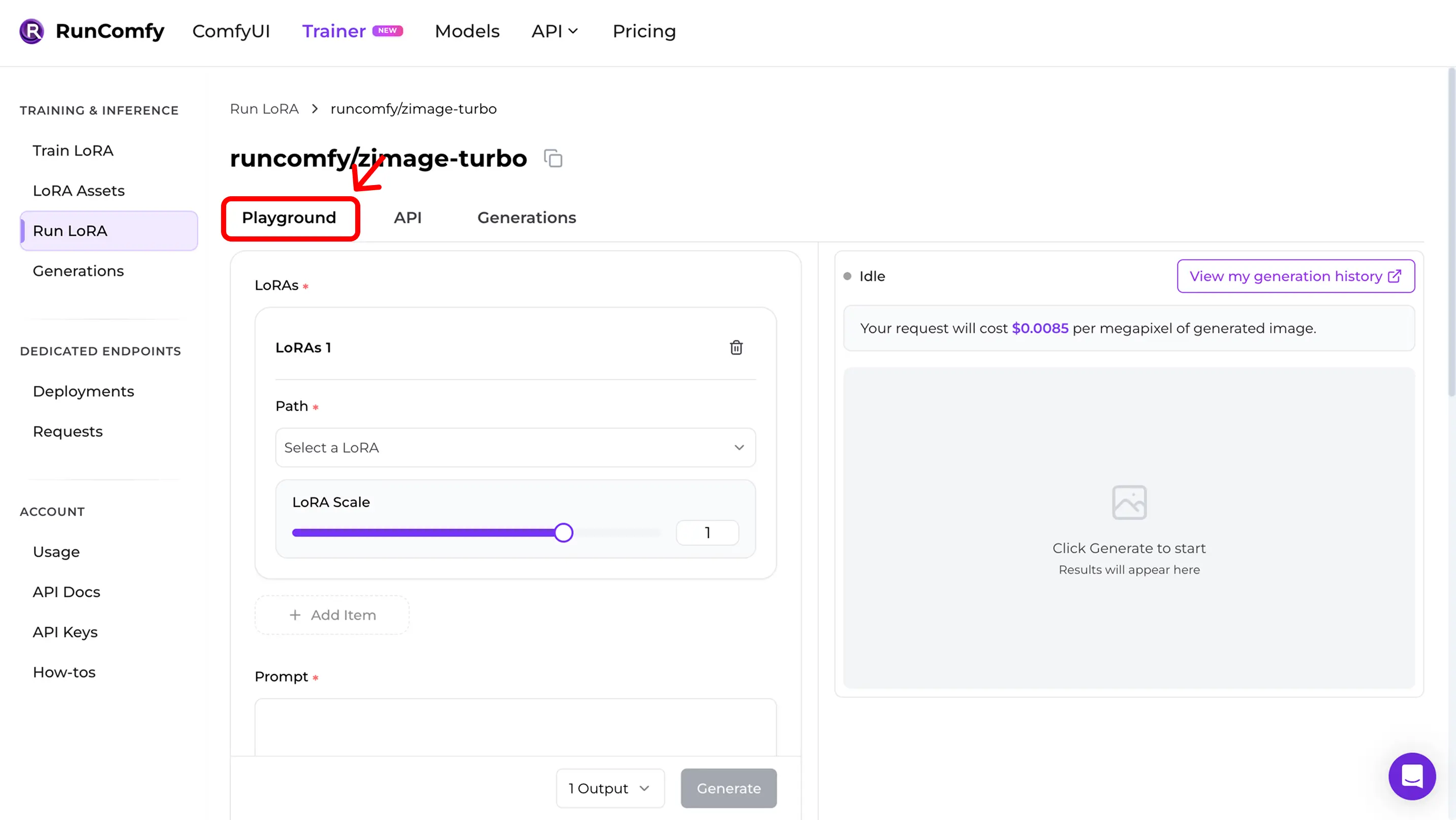

Step 3 — Lancer l’inférence immédiatement (Run LoRA)Dans LoRA Assets, trouvez la LoRA et cliquez Run. Cela démarre Run LoRA : inférence on‑demand qui utilise le même base model et la même définition de pipeline du YAML, pour obtenir la preview‑parity sans tout reconstruire à la main. Vous pouvez tester dans le Playground ou utiliser la même config via API.

Step 4 — Reproduire les training samples dans le PlaygroundAprès Run, vous arrivez dans le Run LoRA Playground. Vérifiez la parité :

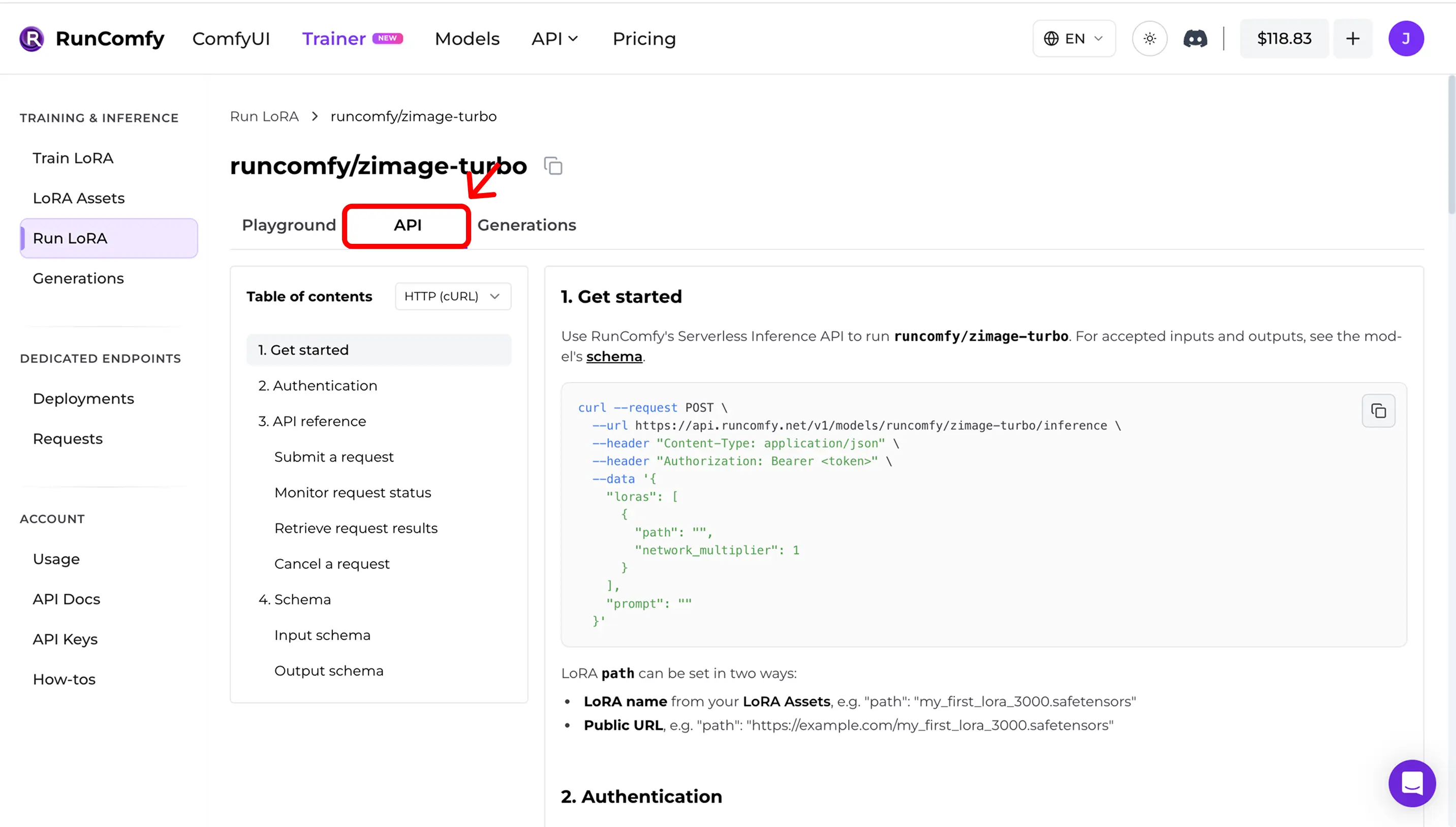

Step 5 — Utiliser l’API en production (async inference)Dans Run LoRA, ouvrez l’onglet API. L’API est asynchrone :

Copiez les URLs et le schema de requête depuis le dashboard. Exemple (illustratif — utilisez votre API docs: RunComfy Model API (see also LoRA inputs (Trainer)) Quick mismatch checklistSi ça ne match pas, vérifiez : 1) Exact base model (repo + variant) 2) Width/height after snapping au diviseur du modèle 3) Steps + guidance + scheduler semantics 4) LoRA application mode (adapter vs fuse/merge) 5) Pour edit / I2V : bons control image inputs 6) Drift runtime (Diffusers / ComfyUI versions) Référence open sourceVous voulez faire l’inférence dans ComfyUI et rester cohérent avec vos training samples / previews ? Voir : AI Toolkit LoRA in ComfyUI: Parity Workflows Pour auditer / self‑hoster : Open-source AI Toolkit inference code : runcomfy-com/ai-toolkit-inference FAQAi‑je besoin du YAML pour importer ?Fortement recommandé. Sans YAML, vous pouvez choisir un base model à la main, mais vous perdez le matching automatique des defaults spécifiques au modèle. Puis‑je importer une LoRA entraînée hors RunComfy ?Oui. Si elle est entraînée avec AI Toolkit, importez “Run LoRA”, ça veut dire quoi ?Run LoRA = inférence on‑demand (Playground + API) qui exécute une LoRA sur son base model sans déployer un endpoint dédié. Facturation par requête. Prêt à commencer l'entraînement ? |