Wenn du eine LoRA mit Ostris AI Toolkit trainiert hast (für FLUX / FLUX.2, Wan 2.2/2.1, Qwen Image, Z‑Image, LTX‑2, SDXL usw.), kennst du das Problem vermutlich: Deine AI‑Toolkit‑Trainings‑Samples sehen großartig aus, aber bei der Inferenz in Diffusers / ComfyUI / einem anderen Stack driftet das Ergebnis.

Dieser Guide zeigt einen schnellen, zuverlässigen Weg zu Inference, die deine AI‑Toolkit‑Training‑Previews matcht, damit das, was du auslieferst, so aussieht wie das, was du trainiert hast.

Warum AI‑Toolkit‑Previews oft nicht zu Inferenz passen

AI‑Toolkit‑„Samples“ werden mit einem konkreten Inferenz‑Setup erzeugt:

- exakte Basismodell‑Variante

- modell‑spezifische Scheduler-/Step‑Semantik

- modell‑spezifische LoRA‑Anwendung (Adapter vs. Fuse/Merge)

- Resolution‑Snapping‑Regeln (Breite/Höhe‑Vielfache)

- erforderliche Inputs für bestimmte Pipelines (z. B. Control‑Image für Edit / I2V)

Wenn dein Inferenz‑Stack davon abweicht, kann selbst bei gleichem Prompt + Seed das Ergebnis driften. Kurz: Um AI‑Toolkit‑Previews zu matchen, musst du die gesamte Inferenz‑Pipeline matchen (nicht nur ein paar Settings).

Warum RunComfy LoRA‑Inference an Trainings‑Samples angleichen kann

RunComfy führt eine basismodell‑spezifische Diffusers‑Inference‑Pipeline aus, die der Pipeline entspricht, mit der AI Toolkit für dieses Modell Trainings‑Previews erzeugt. Zusätzlich liest RunComfy deine Training config file (YAML) ein, um dieselbe Basismodell‑Variante und dieselben Inferenz‑Settings zu fixieren – so kann Run LoRA inference deine Trainings‑Samples 1:1 matchen. Da die Inferenz in einer gemanagten Cloud‑Runtime läuft, vermeidest du außerdem stille CUDA/PyTorch/Diffusers‑Versionsunterschiede, die Outputs verändern können.

Unten ein Beispiel aus unserem Parity‑Experiment (AI‑Toolkit‑Trainings‑Samples vs Run‑LoRA‑Inference, gleiche Settings):

| AI Toolkit training sample | RunComfy inference (Playground/API) |

|---|---|

|

|

|

|

|

|

Schritt‑für‑Schritt: Import → Run LoRA → Inference (Playground + API)

In wenigen Minuten kannst du den Flow end‑to‑end durchlaufen und LoRA‑Inference bekommen, die deine AI‑Toolkit‑Trainings‑Samples matcht.

Wenn du bereits mit RunComfy’s AI Toolkit trainiert hast, erscheint deine LoRA nach Job‑Ende automatisch in LoRA Assets – dann kannst du direkt zu Step 3 (Run LoRA) springen. Hier: AI Toolkit on RunComfy.

Step 0 — Zwei Dateien aus deinem AI‑Toolkit‑Job vorbereiten

Du brauchst typischerweise:

1) LoRA weights: *.safetensors

2) Training config file (YAML) aus dem AI‑Toolkit‑Job (oft config.yml oder *.yaml)

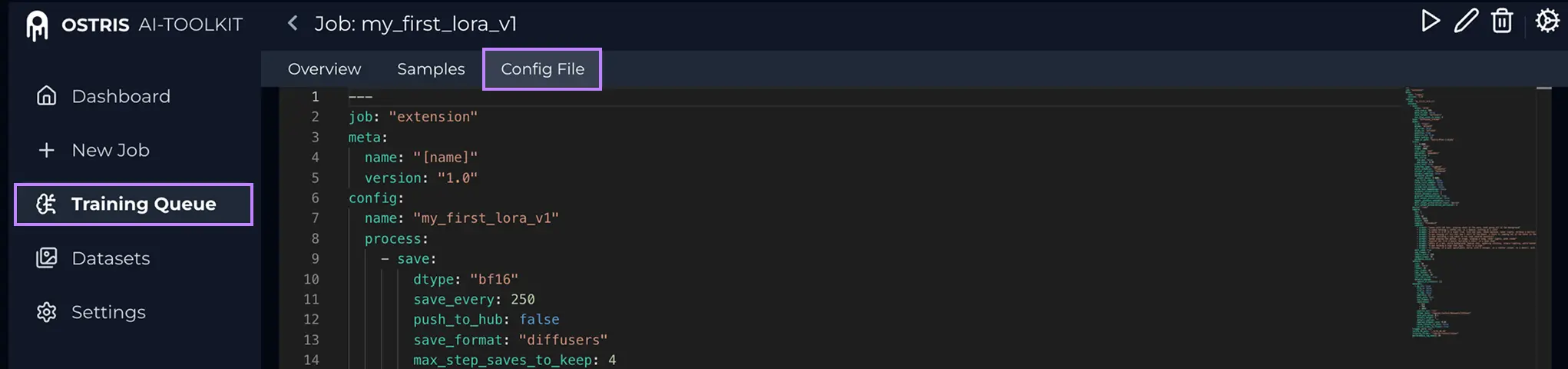

Was ist die Config File (YAML)?

Öffne in AI Toolkit deinen Training Job und klicke oben auf Config File, um die exakte Trainings‑Config zu sehen. Kopiere den gesamten Inhalt und speichere ihn lokal als .yaml, dann lade diese Datei hier hoch.

Warum das YAML wichtig ist: Es lässt RunComfy die exakte Basismodell‑Variante und Inferenz‑Settings matchen, die deine AI‑Toolkit‑Samples erzeugt haben.

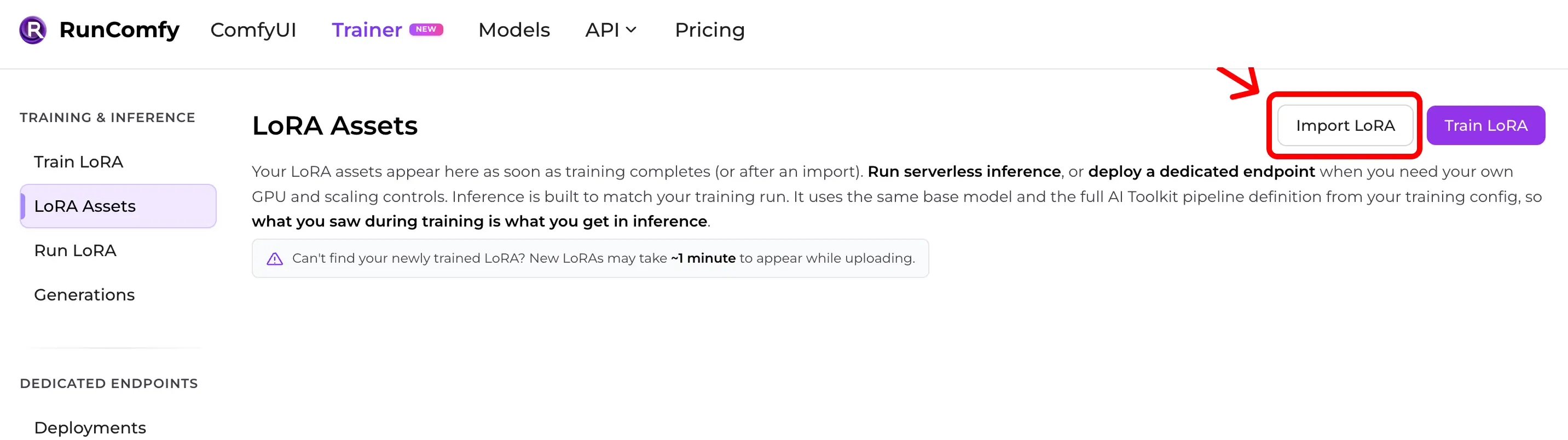

Step 1 — AI‑Toolkit‑LoRA in RunComfy importieren

Gehe zu: Trainer → LoRA Assets → Import LoRA

Upload:

- deine

*.safetensorsLoRA weights - deine training config file (YAML) (empfohlen)

Wenn du die Config nicht hast, kannst du trotzdem importieren, indem du ein Base Model auswählst – Parity kann aber leiden, wenn Defaults abweichen.

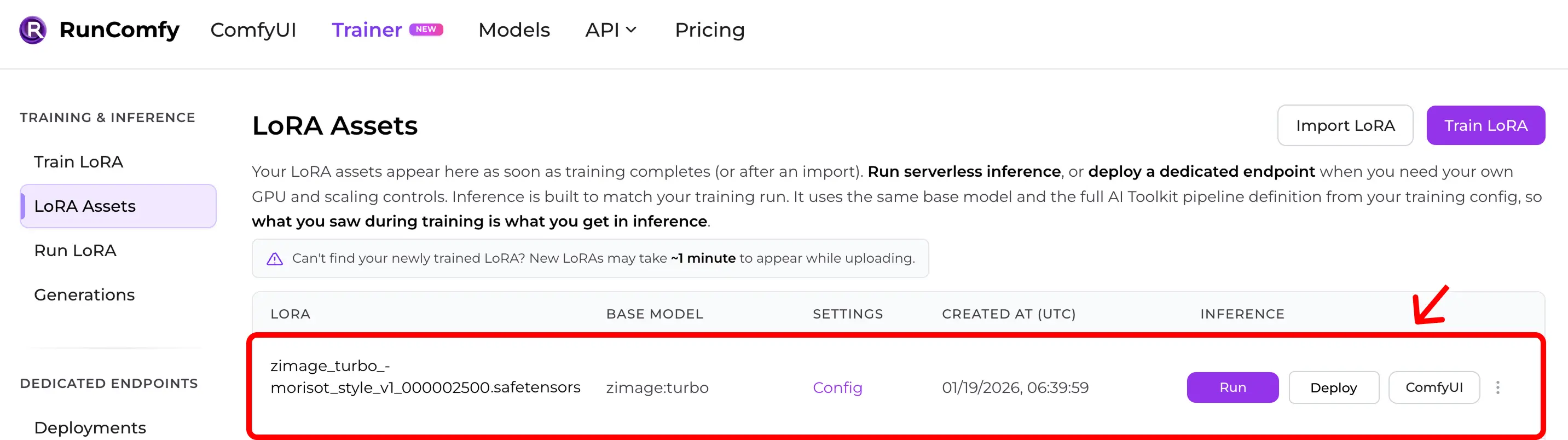

Step 2 — Prüfen, ob die LoRA in LoRA Assets erscheint

Nach dem Import (oder nach einem Cloud‑Training) taucht die LoRA unter LoRA Assets auf.

Von dort kannst du Run (Run LoRA) klicken, um sofort Inferenz zu starten (Playground + API).

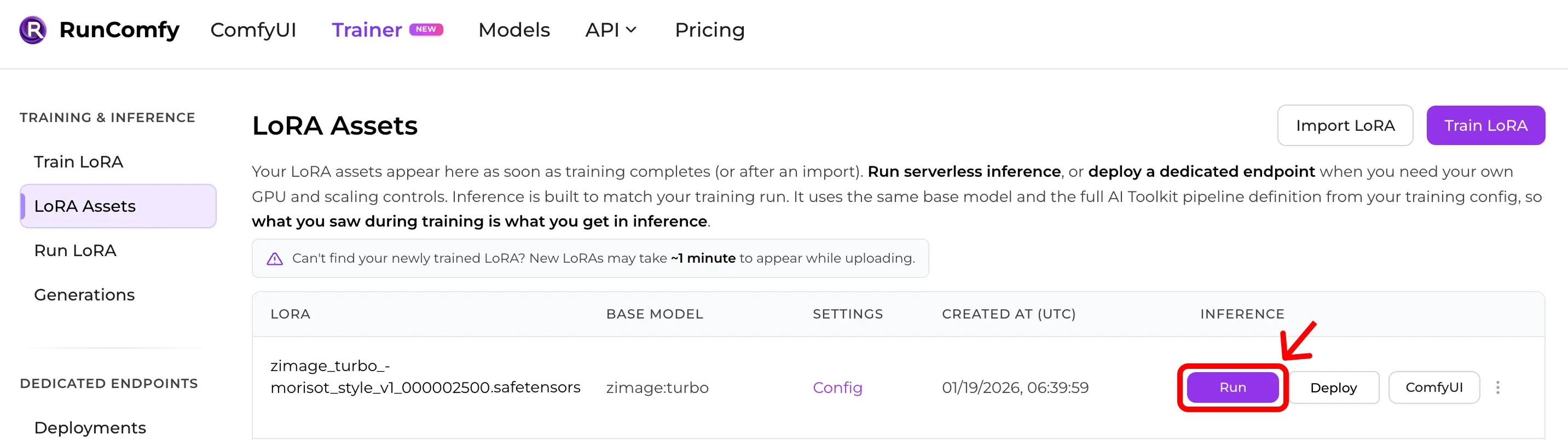

Step 3 — LoRA‑Inference sofort starten

Finde in LoRA Assets deine LoRA und klicke Run.

Das startet Run LoRA — On‑Demand‑Inference, die dasselbe Base Model und dieselbe AI‑Toolkit‑Pipeline‑Definition aus deiner Trainings‑Config verwendet, sodass du Preview‑Parity bekommst, ohne irgendetwas von Hand nachzubauen.

Du kannst sofort im Playground testen oder dieselbe Konfiguration via API nutzen.

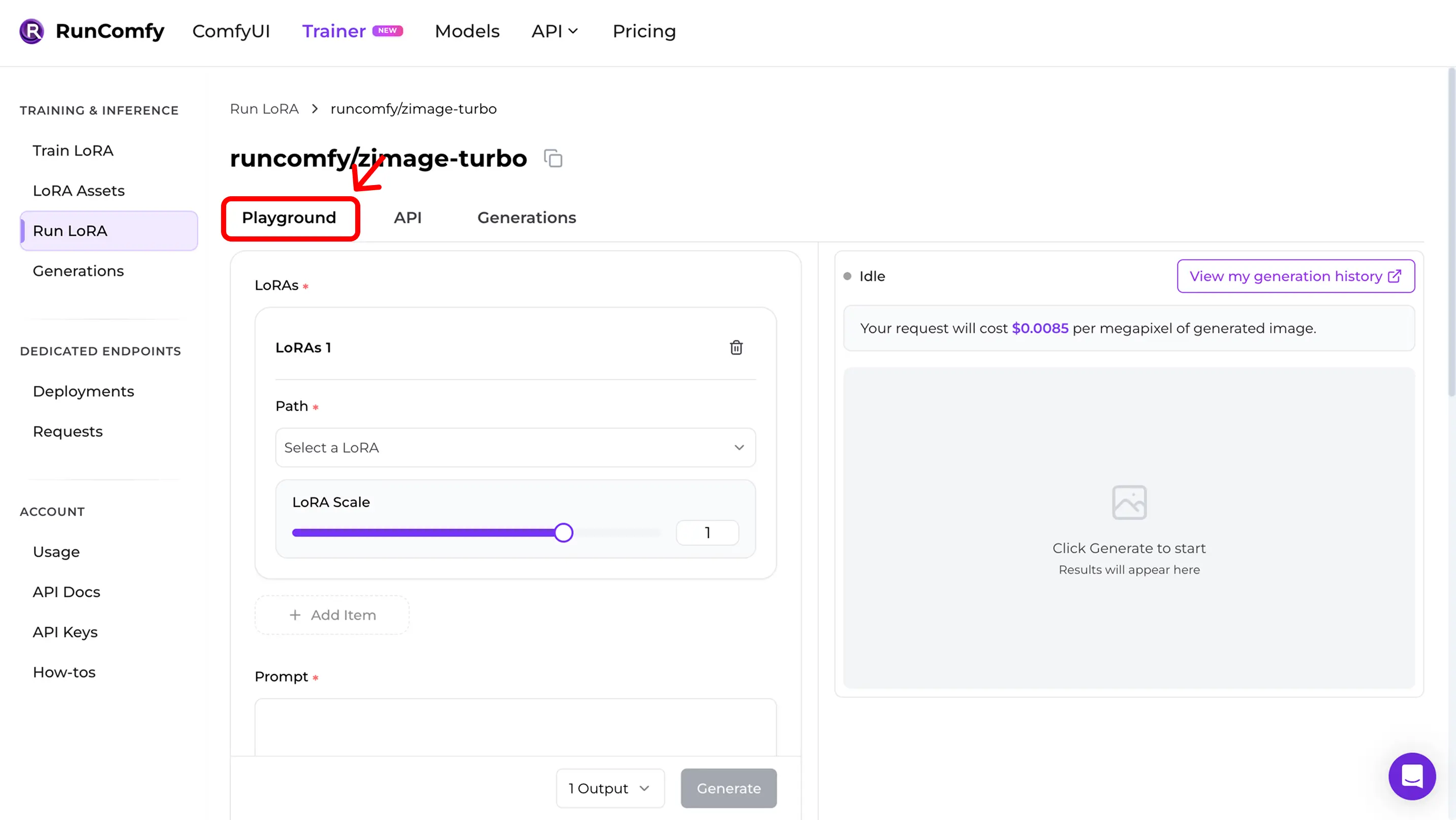

Step 4 — Trainings‑Samples im Playground reproduzieren

Nach Run landest du direkt im Run LoRA Playground.

Hier validierst du Training–Inference‑Parity:

- Nutze dieselben Settings wie bei den Trainings‑Samples (Prompt, Seed, Auflösung, Steps, Guidance, LoRA‑Scale).

- Wenn die Ergebnisse deinen AI‑Toolkit‑Trainings‑Samples sehr nahe kommen, hast du Parity.

- Wenn sie driften, nutze die Quick mismatch checklist unten und prüfe Base Model + Settings.

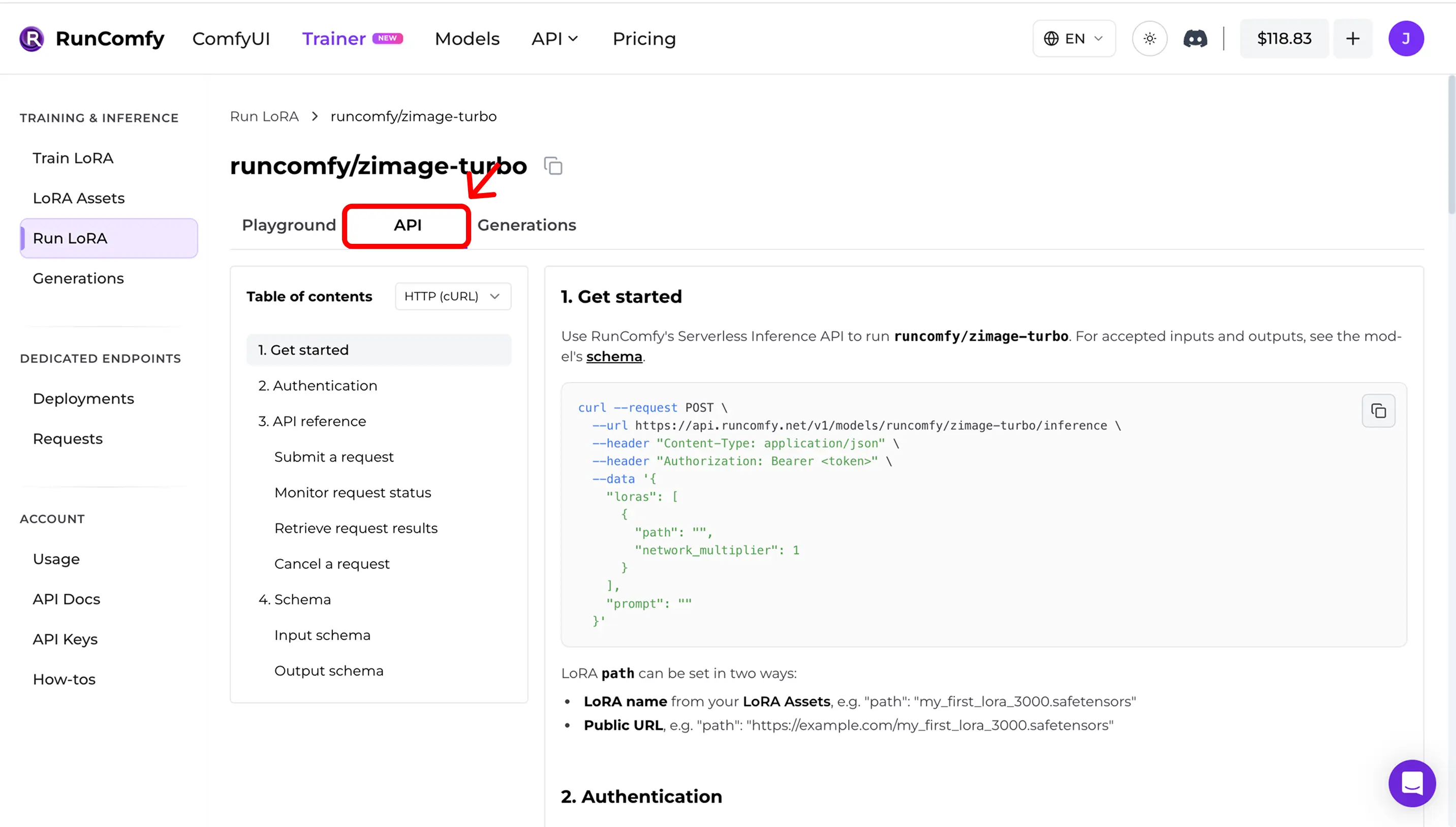

Step 5 — API in Produktion nutzen (async inference)

Öffne in Run LoRA den Tab API. Die API ist asynchron:

- Inferenz‑Request abschicken

- Status monitoren

- Ergebnisse abrufen

Kopiere die exakten URLs und Request‑Form aus dem Dashboard (inkl. Request‑schema‑Link).

Example (illustrative — use your own model_id, LoRA path, and API key):

curl --request POST \

--url "https://model-api.runcomfy.net/v1/models/<MODEL_ID>" \

--header "Authorization: Bearer <YOUR_API_KEY>" \

--header "Content-Type: application/json" \

--data '{

"prompt": "a studio portrait photo, cinematic lighting",

"lora": {

"path": "<YOUR_LORA_NAME_OR_URL>"

}

}'API docs: RunComfy Model API (see also LoRA inputs (Trainer))

Quick mismatch checklist

Wenn Inferenz nicht zu Trainings‑Samples passt, prüfe:

1) Exact base model (repo + variant)

2) Width/height after snapping to the model’s divisor

3) Steps + guidance + scheduler semantics

4) LoRA application mode (adapter vs fuse/merge)

5) For edit / I2V: correct control image inputs

6) Runtime drift (Diffusers / ComfyUI versions)

Open‑Source Referenz‑Implementierung

Möchtest du in ComfyUI inferieren und die Ergebnisse konsistent zu deinen AI‑Toolkit training samples / previews halten?

Siehe: AI Toolkit LoRA in ComfyUI: Parity Workflows

Wenn du die Inferenz‑Logik auditieren oder self‑hosten willst: Open-source AI Toolkit inference code: runcomfy-com/ai-toolkit-inference

FAQ

Brauche ich die AI‑Toolkit training config file (YAML) zum Import?

Stark empfohlen. Ohne Config kannst du zwar ein Base Model manuell wählen, verlierst aber das automatische Matching modell‑spezifischer Defaults.

Kann ich eine LoRA importieren, die außerhalb von RunComfy trainiert wurde?

Ja. Wenn sie mit AI Toolkit trainiert wurde, importiere *.safetensors und die training config file (YAML) und starte Inferenz wie gewohnt (Run LoRA).

Was bedeutet „Run LoRA“ hier?

Run LoRA ist On‑Demand‑Inference (Playground + API), die eine LoRA auf ihrem Base Model ausführt ohne einen dedizierten Endpoint zu deployen. Billing pro Request.

Ready to start training?